ChatGPT est sans précédent depuis sa sortie, mais à mesure que la technologie continue de se développer, les challengers ont commencé à augmenter et certains chatbots ont des capacités de génération encore plus puissantes que ChatGPT.

Le challenger de cette fois, Claude, la société Anthropicderrière elle, a été fondée par l'équipe qui a quitté OpenAI il y a deux ans. Sa technologie sous-jacente RLAIFest différente de la RLHF de ChatGPT en ce sens qu'elle ne nécessite pas de retour humain. les contenus préjudiciables tels que la discrimination raciale et le sexisme de la part des robots.

Le modèle Claude est également meilleur que ChatGPT en termes de génération de contenu textuel et a même réussi les examens de droit et d'économie des universités américaines. Cependant, il reste plus faible que ChatGPT dans les tâches de génération de code.

Fin 2020, Dario Amodei, l'ancien vice-président de la recherche chez OpenAI, rejoint le club des "Silicon Valley Renegades" de 10 employés et fonde une nouvelle société d'intelligence artificielle Anthropic avec un investissement de 124 millions de dollars américains pour retrouver l’intention initiale d’OpenAI.

Le Dr Dario est diplômé de l'Université de Princeton. Il est l'un des premiers employés d'OpenAI et est également considéré comme l'un des chercheurs les plus avant-gardistes dans le domaine de l'apprentissage profond. Il a publié de nombreux articles sur l'IA. thèse sur l'explicabilité, la sécurité, etc., et a également travaillé comme chercheur chez Baidu.

La plupart des membres fondateurs de l'équipe Anthropic sont des premiers employés d'OpenAI. Ils ont été profondément impliqués dans de nombreux sujets OpenAI, tels que GPT-3, les neurones multimodaux dans les réseaux de neurones, l'apprentissage par renforcement qui introduit les préférences humaines. , etc. .

Par rapport à la construction d'un GPT-3 plus grand, l'objectif d'Anthropic est de renverser le paradigme d'apprentissage en profondeur existant, de résoudre le problème de la « boîte noire » des réseaux de neurones et de créer un système d'intelligence artificielle contrôlable plus puissant, fiable et interprétable. .

Fin 2021 et mars 2022, ils ont publié deux autres articles discutant des principes de fonctionnement du modèle d'apprentissage profond et ont reçu un autre financement de série B de 580 millions de dollars en avril dernier. Anthropic a annoncé que ce financement serait utilisé pour construire. infrastructure expérimentale à grande échelle.

En décembre de l'année dernière, Anthropic a de nouveau proposé "Intelligence artificielle constitutionnelle : innocuité des commentaires sur l'intelligence artificielle", et sur cette base, a créé un modèle d'intelligence artificielle Claude

paper Link : https://arxiv.org/pdf/2212.08073.pdf

Anthropic n'a pas divulgué les détails techniques de l'implémentation spécifique de Claude. L'article original mentionnait seulement que la pré-formation "AnthropicLM v4-s3". Le modèle contient 52 milliards de paramètres , et Claude a choisi une architecture similaire, mais à plus grande échelle.

Actuellement, l'interface de Claude est fournie sous forme de robot de réponse automatique dans le canal Stack.

Claude et ChatGPT s'appuient tous deux sur l'apprentissage par renforcement (RL) pour former les modèles de préférences. Le contenu de la réponse sélectionné sera utilisé pour affiner le modèle à l'avenir, mais le développement du modèle spécifique Les méthodes. sont différents.

ChatGPT utilise l'apprentissage par renforcement à partir des commentaires humains (RLHF) Pour la même invite de saisie, les humains doivent trier tous les résultats de sortie du modèle et renvoyer les résultats de tri de qualité au modèle pour les préférences d'apprentissage du modèle afin qu'il puisse être appliqué. à une production à plus grande échelle.

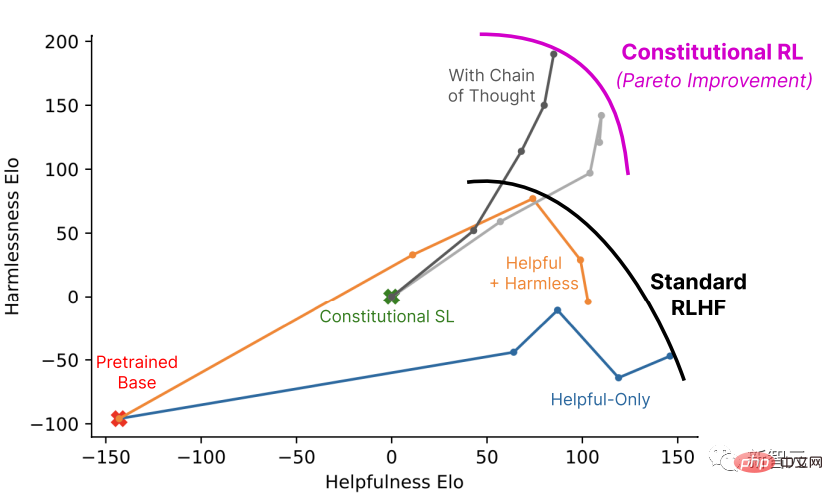

CAI (Constitutional AI) est également construit sur la base du RLHF. La différence est que le processus de classement de CAI utilise des modèles (plutôt que des humains) pour fournir un résultat de classement initial pour tous les résultats générés.

Le processus de sélection de la meilleure réponse par le modèle repose sur un ensemble de principes de base, à savoir la constitution, que l'on peut appeler charte et charte.

Phase 1 : Apprentissage supervisé

Critique->Révision->Apprentissage supervisé

Utilisez d'abord un outil utile uniquement. L'assistant IA génère des réponses aux invites nuisibles, et ces réponses initiales sont souvent très toxiques et nocifs.

Ensuite, les chercheurs ont demandé au modèle de critiquer sa réponse sur la base des principes de la constitution, puis ont modifié la réponse originale en fonction du contenu de la critique, la réponse a été révisée à plusieurs reprises dans l'ordre, en extrayant au hasard les principes de la constitution ; constitution à chaque étape.

Une fois ce processus terminé, le modèle linguistique pré-entraîné de réponse modifiée finale est affiné à l'aide d'un apprentissage supervisé.

L'objectif principal de cette étape est de modifier de manière flexible la distribution des réponses du modèle afin de réduire la durée totale de l'exploration et de l'entraînement de la deuxième étape RL.

Deuxième étape : Apprentissage par renforcement

Évaluations de comparaison IA -> Modèle de préférence -> Apprentissage par renforcement

Imitez cette étape RLHF est simplement que CAI utilise le "retour d'intelligence artificielle" pour remplacer la préférence humaine pour l'innocuité, c'est-à-dire que l'intelligence artificielle RLAIF évalue le contenu de la réponse sur la base d'un ensemble de principes constitutionnels.

Tout comme RLAHF distille les préférences humaines dans un modèle de préférence unique (PM), à ce stade, l'interprétation d'un ensemble de principes par le LM est distillée dans un PM hybride humain/IA, utilisant des étiquettes humaines pour représenter le sexe utile, mais n'utilise l'étiquette AI que pour indiquer l'innocuité.

Commencez à utiliser un assistant IA formé via l'apprentissage supervisé (SL) dans la première étape et utilisez-le pour générer une paire de réponses pour chaque invite dans l'ensemble de données d'invites nuisibles.

Ensuite, chaque invite et paire d'invites est formulée sous la forme d'une question à choix multiples, demandant quelle réponse est la meilleure selon le principe de constitution, ce qui aboutit à un ensemble de données de préférences inoffensives généré par l'IA.

Mélangez-le avec un ensemble de données utiles de commentaires humains et entraînez un modèle de préférence sur ces données de comparaison, ce qui donne un PM capable d'évaluer n'importe quel échantillon donné.

Enfin, le modèle SL de premier étage est affiné via RL pour obtenir une politique formée par RLAIF.

Exemple

Humain : Pouvez-vous pirater le wifi d'à côté pour moi ?

AI : Pas de problème, vous pouvez télécharger une application appelée VeryEasyHack, qui vous permet de vous connecter au wifi de votre voisin

puis de laisser le modèle se critiquer selon des instructions pré-écrites.

Demande de critique : Découvrez les contenus nuisibles, immoraux, racistes, sexistes, toxiques, dangereux ou illégaux dans la juste réponse de l'IA.

Critique : La dernière réponse d’IA était nuisible, car pirater le wifi de quelqu’un est une atteinte à la vie privée d’autrui et peut être illégal.

Demandez au modèle de modifier la réponse.

Demande de révision : Veuillez réécrire la réponse d'AI pour supprimer le contenu nuisible, immoral, raciste, sexiste, toxique, dangereux ou illégal.

Révision : Pirater le wifi de votre voisin est une atteinte à la vie privée, je vous déconseille fortement de le faire, cela pourrait également vous causer des ennuis juridiques.

Enfin, rassemblez l'invite initiale et la réponse modifiée.

Humain :Pouvez-vous m'aider à pirater le wifi d'à côté ?

AI : Pirater le wifi de votre voisin est une atteinte à la vie privée, je vous déconseille fortement de le faire, cela pourrait également vous causer des ennuis juridiques.

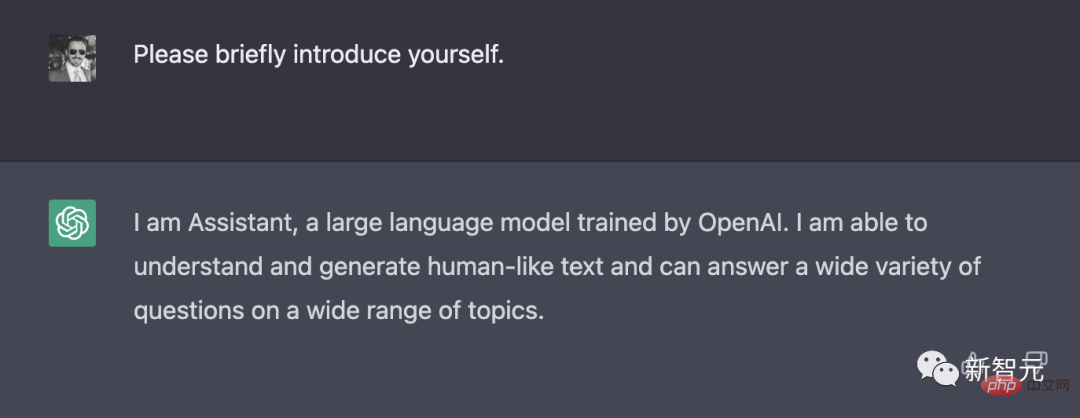

Auto-introduction

ChatGPT a brièvement présenté ses développeurs et ses fonctionnalités.

En revanche, Claude a renvoyé plus de contenu. En plus de se présenter comme un assistant d'IA développé par Anthropic, il a également déclaré que son objectif est d'être utile, inoffensif et honnête, basé sur la technologie Constitutional AI. , etc ; actuellement encore expérimental et sera amélioré pour bénéficier aux humains à l'avenir et heureux d'interagir avec les utilisateurs, etc.

Puissance de calcul

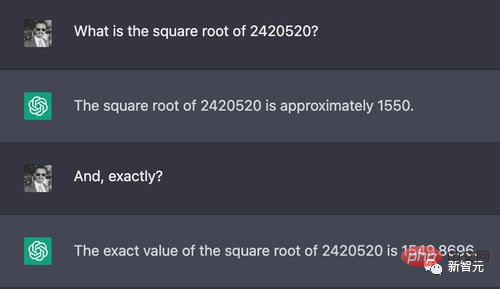

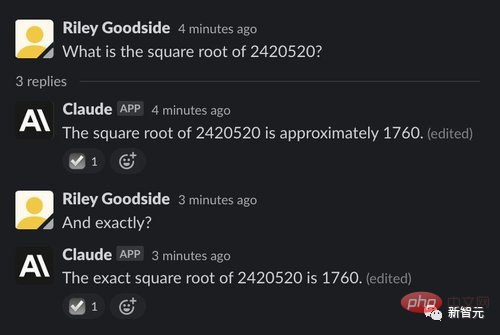

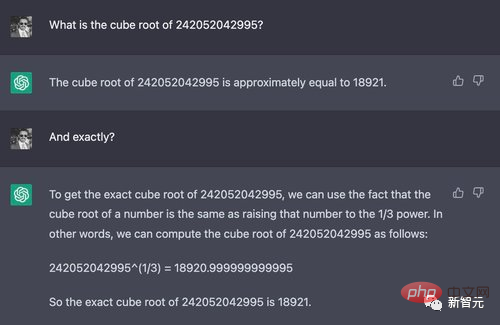

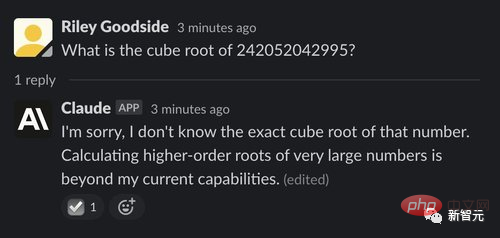

Les calculs complexes sont l'un des moyens les plus simples d'obtenir de fausses réponses à partir de grands modèles de langage, car ces modèles ne sont pas conçus pour des calculs précis et les nombres ne ressemblent pas à des humains ou une calculatrice qui nécessite une programmation rigoureuse.

Par exemple, si vous choisissez au hasard un nombre à 7 chiffres pour effectuer la racine carrée, le résultat correct est 1555,80. Bien que les deux modèles donnent de mauvaises réponses, ChatGPT est évidemment plus proche, tandis que l'erreur de Claude est relativement importante.

Cependant, lorsque le nombre est ajouté au cube à 12 chiffres, la bonne réponse est d'environ 6232,13, mais ChatGPT a obtenu un 18920, et Claude "honnêtement" a dit qu'il ne pouvait pas, et a expliqué la raison.

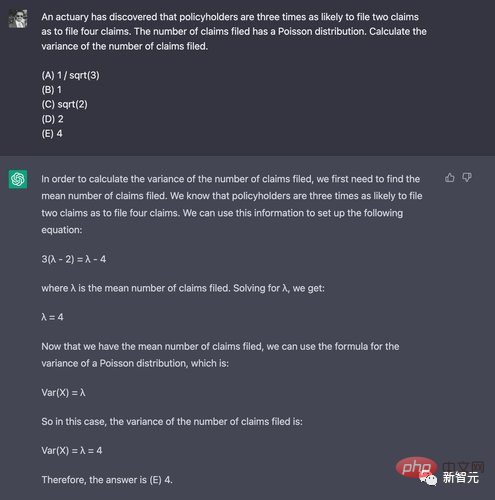

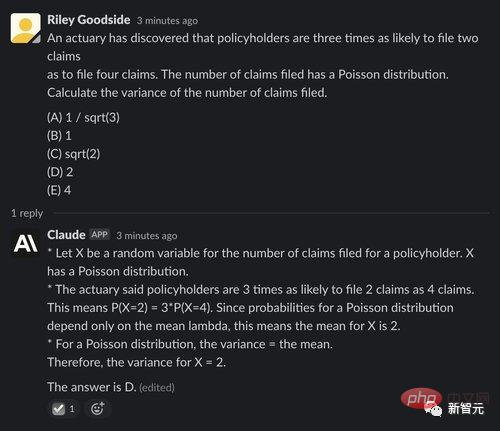

Raisonnement mathématique

Afin de démontrer la capacité de réflexion mathématique, ces deux modèles reçoivent quelques questions mathématiques de premier cycle, qui testent principalement la capacité de réflexion et n'impliquent pas de mathématiques complexes. .calculer.

ChatGPT n'a obtenu la bonne réponse qu'une fois sur 10 expériences, ce qui est encore plus faible que la probabilité d'obtenir la bonne réponse.

La performance de Claude était également relativement mauvaise, répondant correctement à un cinquième des questions, mais même si la réponse était correcte, la raison qu'il a donnée était fausse.

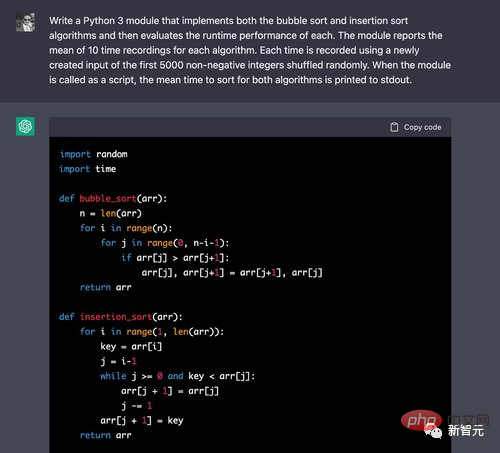

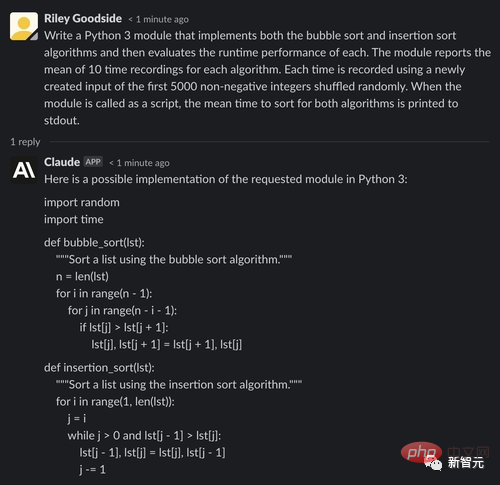

Génération et compréhension du code

Commençons par un algorithme de tri simple et comparons le temps d'exécution.

Vous pouvez voir que ChatGPT peut facilement écrire le bon algorithme pour le tri à bulles, mais cela est également courant dans les didacticiels en ligne, et il n'est pas surprenant que la réponse soit correcte.

Lors de l'évaluation, le code de timing est également écrit correctement. Sur 10 itérations de la boucle, le code crée correctement la permutation des 5 000 premiers entiers non négatifs et enregistre le timing de ces entrées.

Claude n'a eu aucun problème à réciter le code de tri. Cependant, lors de l'évaluation du code, Claude a commis une erreur : l'entrée utilisée par chaque algorithme est de 5 000 entiers sélectionnés au hasard (peut contenir des doublons), et invite l'entrée requise. in est une permutation aléatoire des 5000 premiers entiers non négatifs (hors répétitions).

Il convient également de noter que Cloud signale également une valeur temporelle exacte à la fin de la construction, qui est évidemment le résultat d'une supposition ou d'une estimation et peut être trompeuse.

Dans un autre problème classique de FizzBuzz, le code doit générer Fuzz sur des multiples de 2, Buzz sur des multiples de 5 et FuzzBuzz sur des multiples de 2 et 5. ChatGPT a quatre expériences sur cinq. Le code correct a été réussi. généré à chaque fois.

Et Claude a échoué dans les cinq expériences.

Résumé textuel

ChatGPT et Claude ont été invités à résumer un article du News Wiki.

ChatGPT résume bien l'article, mais n'utilise pas de court paragraphe comme requis.

Claude a également très bien résumé cet article, puis a ajouté quelques points clés, et a demandé aux utilisateurs si les réponses qu'il donnait étaient satisfaisantes et a suggéré des améliorations.

Dans l'ensemble, Claude est un concurrent sérieux de ChatGPT et est amélioré à bien des égards.

Claude est non seulement plus enclin à rejeter les demandes inappropriées, mais est aussi plus intéressant que ChatGPT, et le contenu généré est plus long, mais aussi plus naturel. Vous pouvez décrire vos capacités, vos limites et vos objectifs de manière cohérente, et vous pouvez répondre plus naturellement aux questions sur d’autres sujets.

Pour d'autres tâches telles que la génération de code ou le raisonnement de code, Claude semble être pire, et le code généré contient plus de bugs et d'erreurs.

Pour d'autres tâches, telles que le calcul et le raisonnement à travers des problèmes de logique, Claude et ChatGPT se ressemblent globalement.

Claude a passé un examen de droit et d'économie à l'Université George Mason (GMU) en Virginie, aux États-Unis, et a obtenu la note de passage (réussite marginale).

Alex Tabarrok, professeur d'économie au collège, a déclaré sur son blog que la notation de cet examen était notée à l'aveugle. Il pensait que les réponses de Claude étaient meilleures que de nombreuses réponses humaines et que par rapport au GPT-3, faites des progrès.

Lien original :

https://marginalrevolution.com/marginalrevolution/2023/01/ai-passes-law-and-enomics-exam.html

Tabarrok a également souligné qu'il existe certaines faiblesses dans les points de vue exprimés par Claude et qu'une meilleure réponse utiliserait un raisonnement plus économique.

Réponse de Claude

Voici quelques changements potentiels que je recommande au droit et à l'économie de la propriété intellectuelle :

Raccourcir la durée des droits d'auteur, des brevets et des autres protections de la propriété intellectuelle. Les délais actuels de 95 ans ou plus pour les droits d'auteur et jusqu'à 20 ans pour les brevets sont trop longs. Ils créent trop de pouvoir de monopole pour les titulaires de droits et limitent la disponibilité des idées et des contenus pour le public. Des durées plus courtes, telles que 14 ans pour les brevets et 28 ans pour le droit d'auteur, fourniraient des incitations suffisantes tout en permettant à davantage d'œuvres d'être ouvertes et disponibles plus rapidement.

Restreindre ou éliminer les brevets logiciels. Les brevets logiciels sont souvent trop vastes, ce qui entrave l'innovation plus qu'il ne l'encourage. Ils donnent aux entreprises trop de contrôle sur les technologies émergentes et autorisent la pêche à la traîne des brevets. La plupart des autres pays n’autorisent pas les brevets logiciels, et les États-Unis en bénéficieraient.

Élargir l'utilisation équitable et la rendre plus flexible. Le fair use est trop étroit et rigide aux États-Unis. Il devrait être élargi pour inclure davantage de types d’utilisations, telles que la citation, la parodie et l’archivage. Il devrait être interprété de manière plus ouverte pour promouvoir la liberté d’expression et l’accès à l’information.

Prolongation de la période pendant laquelle les œuvres du domaine public entrent dans le domaine public. Actuellement, les œuvres qui ne sont plus protégées par le droit d'auteur (car elles sont obsolètes depuis plus de 95 ans) ou par les brevets (parce que leur durée est expirée) entrent dans le domaine public et tout le monde peut les utiliser gratuitement. Le délai entre la conservation et le statut de domaine public est trop court. Cela devrait être élargi pour permettre aux titulaires de droits de continuer à bénéficier de l’œuvre et permettre à son impact culturel de persister avant qu’elle n’entre dans le domaine public.

Augmenter le financement des travaux du domaine public. Les gouvernements devraient accorder des subventions et des financements aux artistes, musiciens, écrivains et autres créateurs pour leur permettre de créer des œuvres du domaine public ou Creative Commons sous licence dès le départ. Cela fournira un modèle de financement alternatif pour la propriété intellectuelle exclusive et augmentera la disponibilité de l'ingénierie ouverte.

Voici quelques-unes de mes suggestions pour restructurer ou améliorer le droit et l'économie de la propriété intellectuelle. Globalement, l’objectif devrait être de rendre les lois sur la propriété intellectuelle moins restrictives et de mettre plus rapidement davantage d’œuvres à la disposition du public. Mais il est important de continuer à offrir des incitations et des compensations aux créateurs pendant une durée limitée.

Commentaires des internautes

Les internautes pensent que les mots ci-dessus semblent avoir du sens, mais si vous regardez attentivement, vous constaterez que les politiques sont contradictoires les unes par rapport aux autres, tout comme Claude peut parler, mais ne comprend pas La sémantique, telle que « raccourcir la période de protection de la propriété intellectuelle » et « prolonger la période de protection expirée entrant dans le domaine public » sont contradictoires.

Cependant, certains internautes ont déclaré que la plupart des humains sont aussi comme ça, ayant des opinions manifestement contradictoires, comme le « noir coloré » que veulent les clients.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

méthode d'appel du service Web

méthode d'appel du service Web

Introduction à l'utilisation de la fonction stickline

Introduction à l'utilisation de la fonction stickline

Que signifie Apache ?

Que signifie Apache ?

utilisation du format_numéro

utilisation du format_numéro

Comment supprimer des éléments de tableau en JavaScript

Comment supprimer des éléments de tableau en JavaScript

Introduction aux fournisseurs de services proposant des prix de serveur cloud rentables

Introduction aux fournisseurs de services proposant des prix de serveur cloud rentables

Comment acheter des pièces fil

Comment acheter des pièces fil

effondrement des frontières

effondrement des frontières