Das bisher größte Protein-Sprachmodell wurde veröffentlicht!

Vor einem Jahr wurde DeepMinds Open-Source-Programm AlphaFold2 in den Bereichen Natur und Wissenschaft eingeführt und überwältigte die akademischen Kreise der Biologie und KI.

Ein Jahr später kam Meta mit ESMFold, das eine Größenordnung schneller war.

Es ist nicht nur schnell, das Modell verfügt auch über 15 Milliarden Parameter.

LeCun twitterte, um zu loben, dass dies eine großartige neue Errungenschaft des Meta-FAIR-Proteinteams sei.

Co-Autor Zeming Lin enthüllte, dass das große Modell mit 3 Milliarden Parametern 3 Wochen lang auf 256 GPUs trainiert wurde, während ESMfold 10 Tage auf 128 GPUs benötigte. Was die 15-Milliarden-Parameter-Version betrifft, ist noch unklar.

Er sagte auch, dass der Code später definitiv Open Source sein wird, also bleiben Sie dran!

Heute ist unser Protagonist ESMFold, ein Modell, das hochgenaue End-to-End-Strukturen auf atomarer Ebene aus einzelnen Proteinsequenzen direkt vorhersagt.

Papieradresse: https://www.biorxiv.org/content/10.1101/2022.07.20.500902v1

Unnötig zu erwähnen, welche Vorteile 15 Milliarden Parameter mit sich bringen – durch Training können die heutigen großen Modelle die drei vorhersagen -dimensionale Struktur von Proteinen mit atomarer Größengenauigkeit.

In Bezug auf die Genauigkeit ist ESMFold fast identisch mit AlphaFold2 und RoseTTAFold.

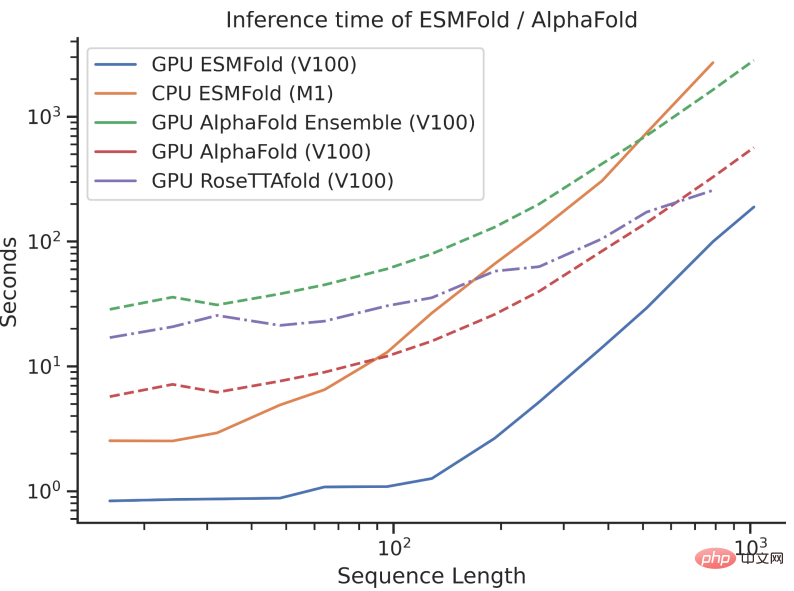

Allerdings ist die Inferenzgeschwindigkeit von ESMFold um eine Größenordnung schneller als bei AlphaFold2!

Es kann schwierig sein, den Geschwindigkeitsvergleich zwischen den dreien zu verstehen, wenn man über die Größenordnung spricht. Schauen Sie sich einfach das Bild unten an, um es zu verstehen.

Obwohl AlphaFold2 und RoseTTAFold beim Problem der Strukturvorhersage mit atomarer Auflösung bahnbrechende Erfolge erzielt haben, verlassen sie sich auch auf die Verwendung mehrerer Sequenzalignments (MSA) und ähnlicher Proteinstrukturvorlagen, um eine optimale Leistung zu erzielen.

Im Gegensatz dazu kann ESMFold durch die Nutzung der internen Darstellung des Sprachmodells entsprechende Strukturvorhersagen mit nur einer Sequenz als Eingabe generieren und so die Strukturvorhersage erheblich beschleunigen.

Die Forscher fanden heraus, dass die Vorhersagen von ESMFold für Sequenzen mit geringer Komplexität mit aktuellen Modellen auf dem neuesten Stand der Technik vergleichbar waren.

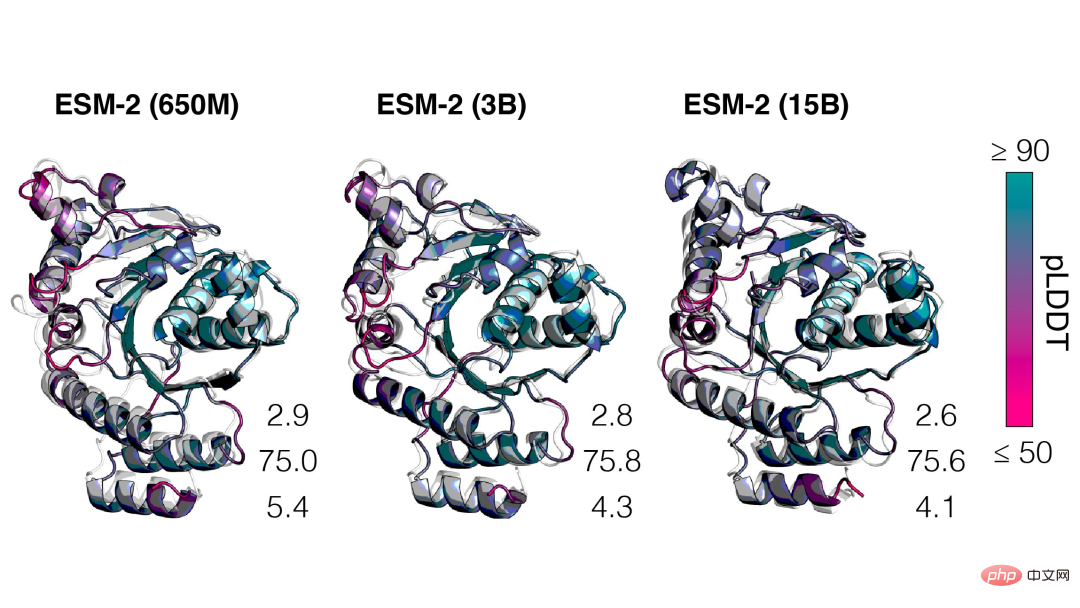

Darüber hinaus hängt die Genauigkeit der Strukturvorhersage eng mit der Komplexität des Sprachmodells zusammen. Das heißt, wenn das Sprachmodell die Sequenz besser verstehen kann, kann es auch die Struktur besser verstehen.

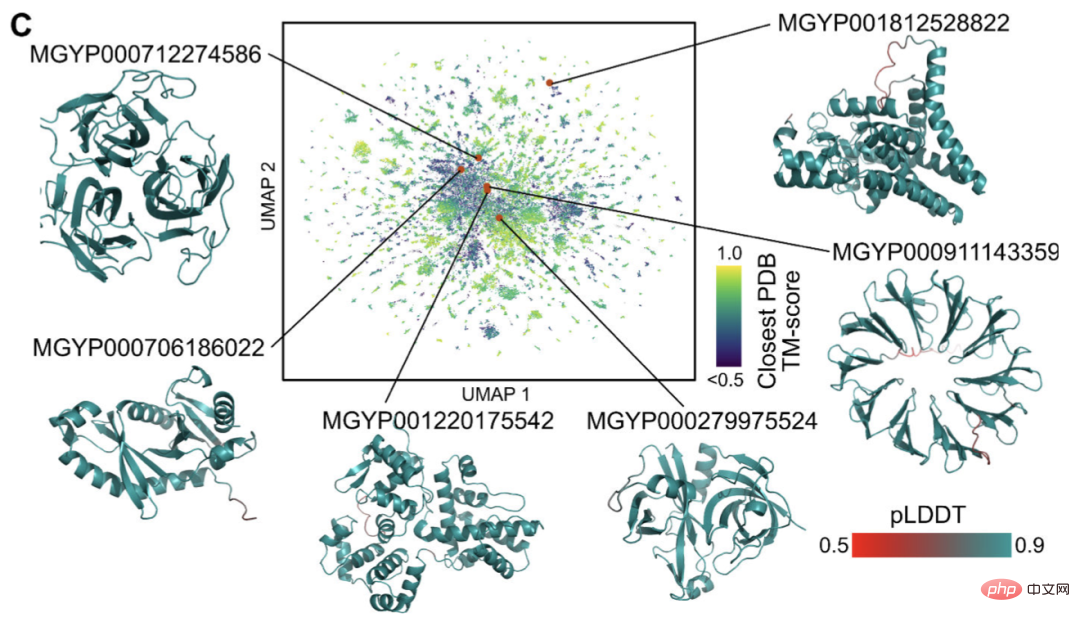

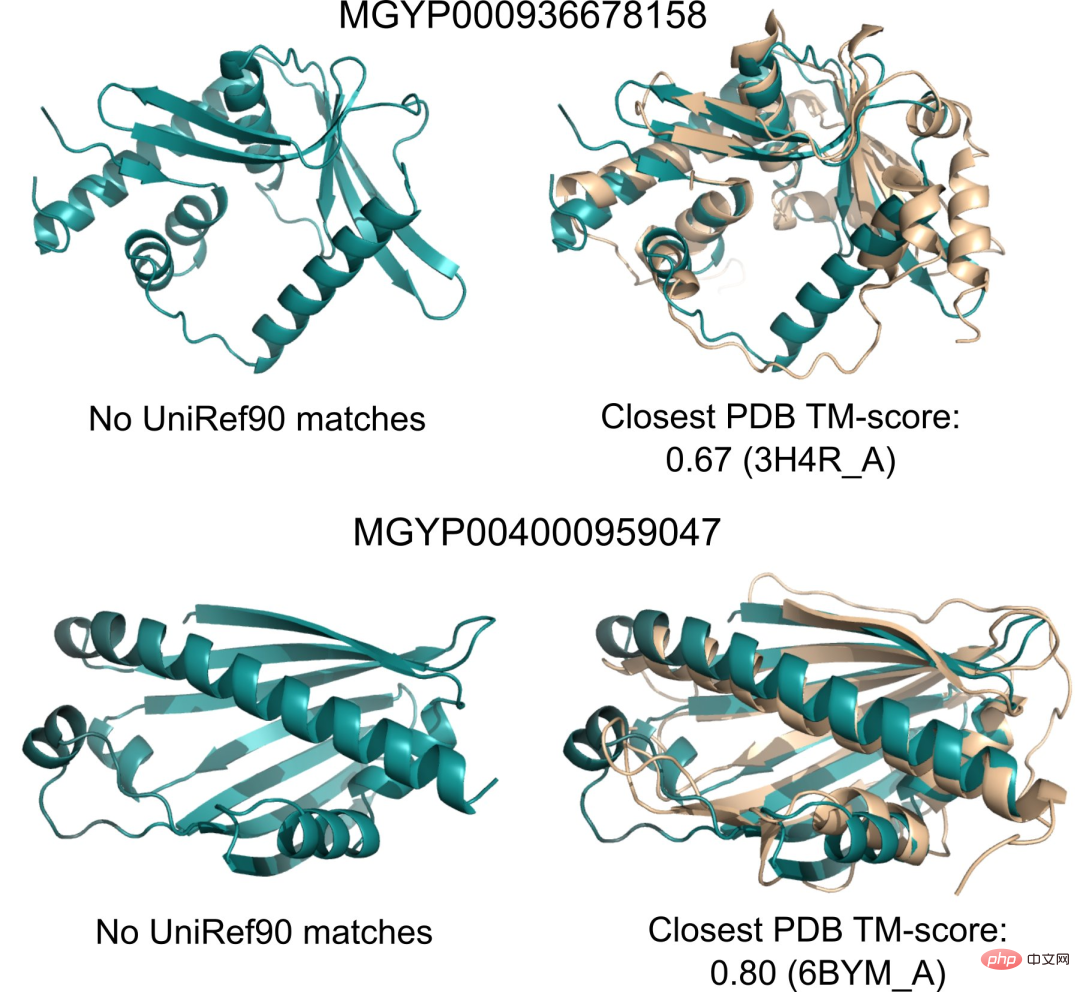

Derzeit gibt es Milliarden von Proteinsequenzen unbekannter Struktur und Funktion, von denen viele aus der metagenomischen Sequenzierung stammen.

Mit ESMFold können Forscher eine Zufallsstichprobe von 1 Million metagenomischen Sequenzen in nur 6 Stunden falten.

Ein großer Teil davon weist ein hohes Vertrauen auf und unterscheidet sich von allen bekannten Strukturen (nicht in der Datenbank erfasst).

Forscher glauben, dass ESMFold dabei helfen kann, Proteinstrukturen zu verstehen, die jenseits des derzeitigen Verständnisses liegen.

Da die Vorhersagen von ESMFold um eine Größenordnung schneller sind als bestehende Modelle, können Forscher ESMFold außerdem dazu nutzen, die Lücke zwischen den schnell wachsenden Proteinsequenzdatenbanken und den langsamer wachsenden Proteinstruktur- und -funktionsdatenbanken zu schließen.

Als nächstes sprechen wir ausführlich über Metas neues ESMFold.

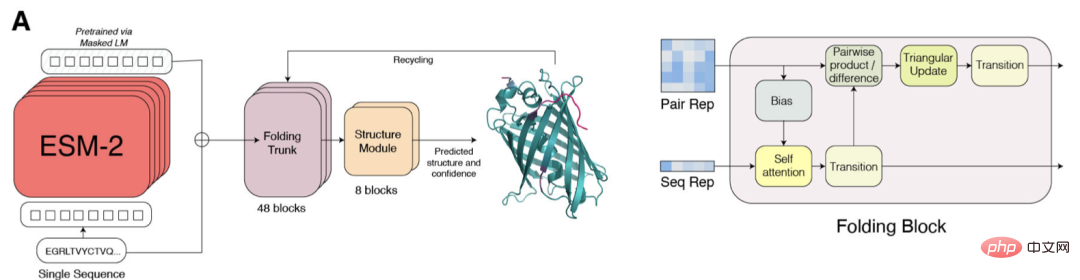

ESM-2 ist ein Transformer-basiertes Sprachmodell und nutzt einen Aufmerksamkeitsmechanismus, um die Interaktionsmuster zwischen Aminosäurepaaren in der Eingabesequenz zu lernen.

Im Vergleich zum Vorgängermodell ESM-1b hat Meta die Modellstruktur und Trainingsparameter verbessert sowie Rechenressourcen und Daten hinzugefügt. Gleichzeitig ermöglicht die Hinzufügung der relativen Positionseinbettung die Verallgemeinerung des Modells auf Sequenzen beliebiger Länge.

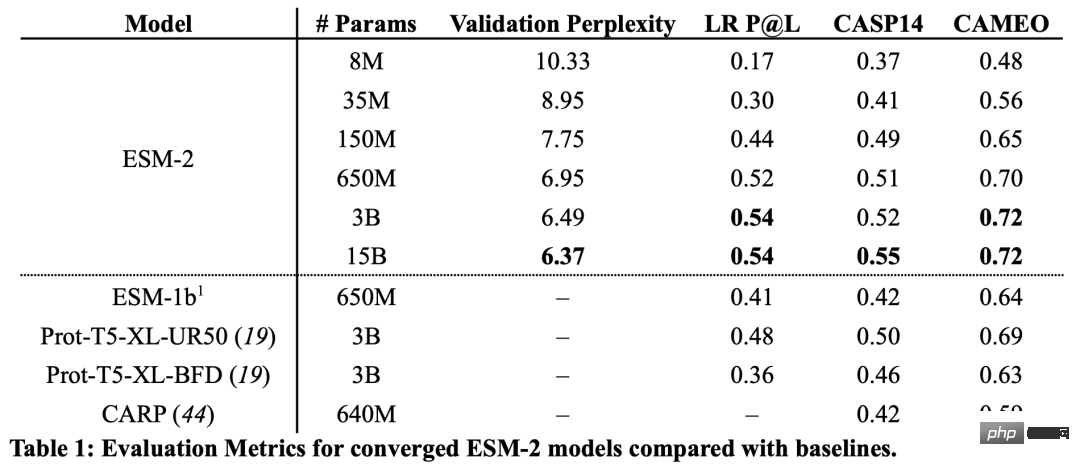

Aus den Ergebnissen geht hervor, dass das ESM-2-Modell mit 150 Millionen Parametern eine bessere Leistung erbringt als das ESM-1b-Modell mit 650 Millionen Parametern.

Darüber hinaus übertraf ESM-2 auch andere Proteinsprachenmodelle beim Benchmark der Strukturvorhersage. Diese Leistungsverbesserung steht im Einklang mit etablierten Mustern im Bereich der groß angelegten Sprachmodellierung.

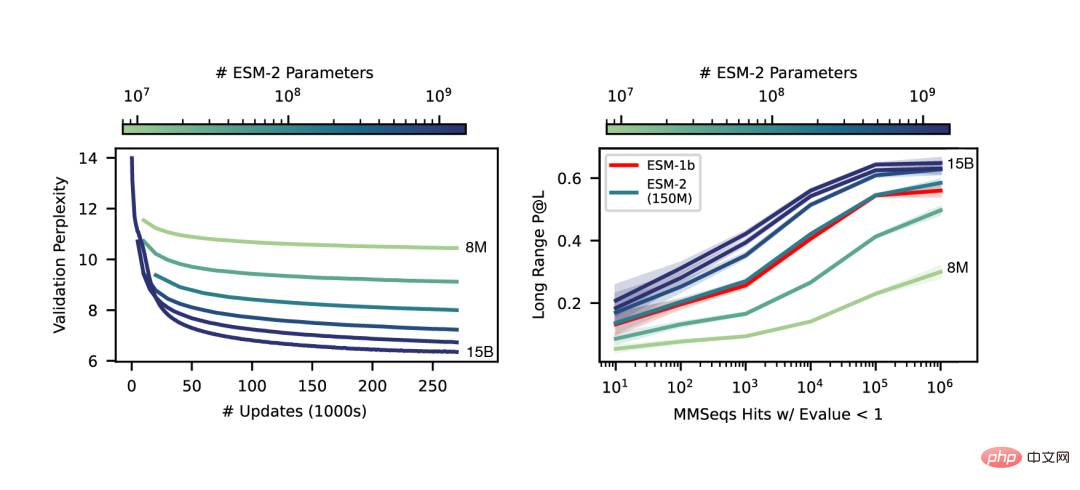

Mit zunehmendem Maßstab von ESM-2 kann beobachtet werden, dass sich die Genauigkeit der Sprachmodellierung erheblich verbessert hat.

Ein wesentlicher Unterschied zwischen SMFold und AlphaFold2 besteht darin, dass ESMFold eine Sprache verwendet Das darzustellende Modell macht eindeutige homologe Sequenzen (in Form von MSA) als Eingabe überflüssig.

ESMFold vereinfacht den Evoformer in AlphaFold2, indem es das rechenintensive Netzwerkmodul, das MSA verarbeitet, durch ein Transformer-Modul ersetzt, das Sequenzen verarbeitet. Diese Vereinfachung bedeutet, dass ESMFold deutlich schneller ist als MSA-basierte Modelle.

Die Ausgabe des gefalteten Rückgrats wird dann von einem Strukturmodul verarbeitet, das für die Ausgabe der endgültigen Struktur auf atomarer Ebene und der Vorhersagesicherheit verantwortlich ist.

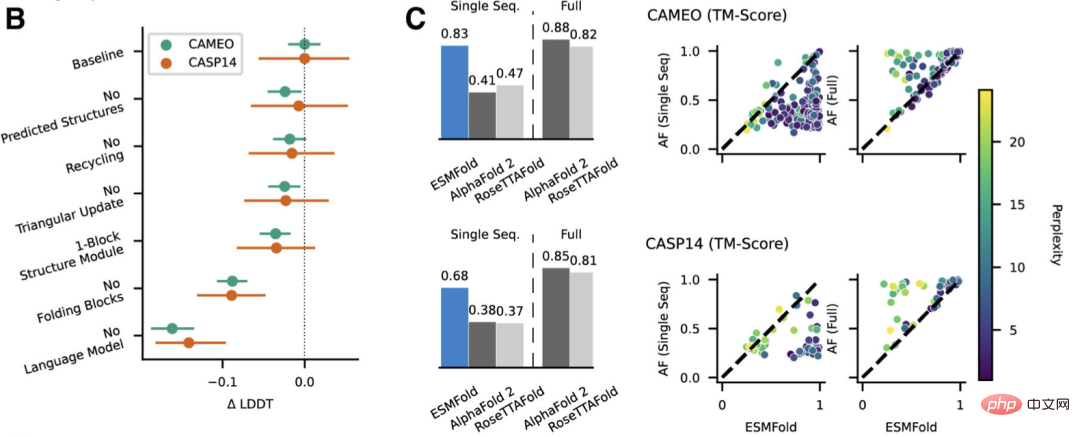

Forscher testeten ESMFold mit AlphaFold2 und RoseTTAFold bei CAMEO (April 2022 bis Juni 2022) und CASP14 (Mai 2020) Vergleich am Set.

Wenn nur eine einzelne Sequenz als Eingabe angegeben wird, schneidet ESMFold viel besser ab als Alphafold 2.

Bei Nutzung der vollständigen Pipeline erreichte AlphaFold2 88,3 bzw. 84,7 auf CAMEO und CASP14. ESMFold erreicht auf CAMEO eine vergleichbare Genauigkeit wie RoseTTAfold mit einem durchschnittlichen TM-Score von 82,0. Die Forscher fanden heraus, dass Sprachmodelle, die auf unbeaufsichtigtes Lernen abzielen, auf einer großen Datenbank evolutionär unterschiedlicher Proteinsequenzen trainiert werden und in der Lage sind, Proteinstrukturen mit atomarer Auflösung vorherzusagen.

Durch die Erweiterung der Parameter des Sprachmodells auf 15B kann der Einfluss der Skalierung auf das Lernen der Proteinstruktur systematisch untersucht werden.

Seiner persönlichen Homepage zufolge hat Zeming an der New York University promoviert und als Forschungsingenieur (Gast) bei Meta AI gearbeitet, wo er hauptsächlich für die Arbeit an der Back-End-Infrastruktur verantwortlich war.

Er studierte sowohl seinen Bachelor- als auch seinen Masterabschluss an der University of Virginia, wo er zusammen mit Yanjun Qi an Anwendungen des maschinellen Lernens, insbesondere zur Vorhersage der Proteinstruktur, forschte.

Die Interessengebiete sind Deep Learning, Strukturvorhersage und Informationsbiologie.

Das obige ist der detaillierte Inhalt vonSchneller als 0! Meta hat ein großes Proteinmodell mit 15 Milliarden Parametern gestartet, um AlphaFold2 zu zerstören. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!