Aufgrund komplexer Aufmerksamkeitsmechanismen und Modelldesigns können die meisten vorhandenen visuellen Transformatoren (ViT) in realen industriellen Einsatzszenarien nicht so effizient arbeiten wie Faltungs-Neuronale Netze (CNN). Dies wirft die Frage auf: Kann ein visuelles neuronales Netzwerk so schnell schließen wie ein CNN und so leistungsstark wie ein ViT?

Einige neuere Arbeiten haben versucht, eine CNN-Transformer-Hybridarchitektur zu entwerfen, um dieses Problem zu lösen, aber die Gesamtleistung dieser Arbeiten ist alles andere als zufriedenstellend. Auf dieser Grundlage haben Forscher von ByteDance einen visuellen Transformer der nächsten Generation – Next-ViT – vorgeschlagen, der effektiv in realen Industrieszenarien eingesetzt werden kann. Aus Sicht des Latenz-/Genauigkeits-Kompromisses ist die Leistung von Next-ViT mit hervorragenden CNNs und ViTs vergleichbar.

Papieradresse: https://arxiv.org/pdf/2207.05501.pdf

Das Forschungsteam von Next-ViT hat einen neuen Faltungsblock (NCB) und einen Transformatorblock (NTB) entwickelt. ) und setzt benutzerfreundliche Mechanismen ein, um lokale und globale Informationen zu erfassen. Die Studie schlägt dann eine neuartige Hybridstrategie des NHS vor, die darauf abzielt, NCBs und NTBs in einem effizienten Hybridparadigma zu stapeln, um die Leistung verschiedener nachgelagerter Aufgaben zu verbessern.

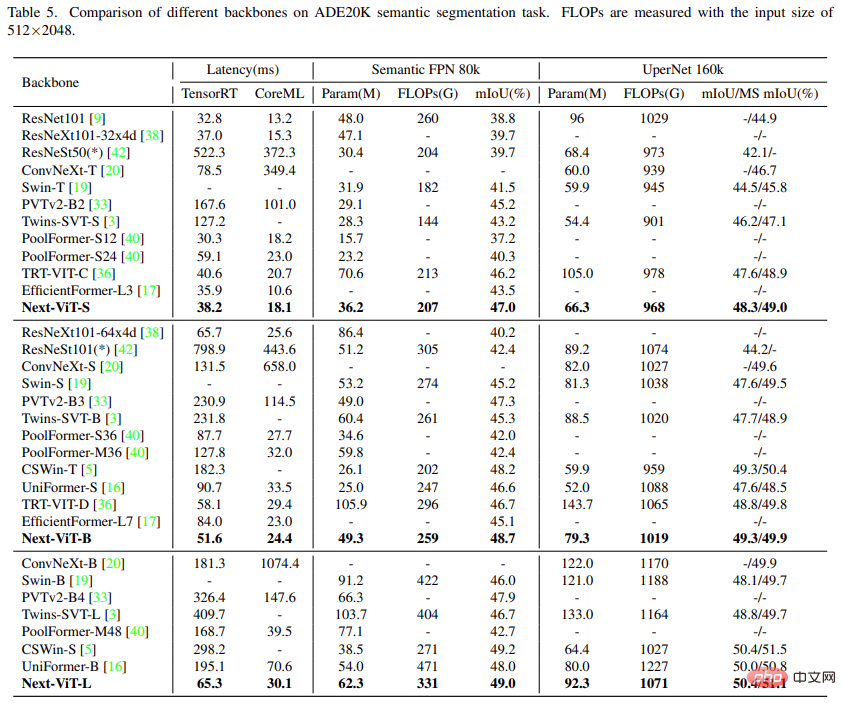

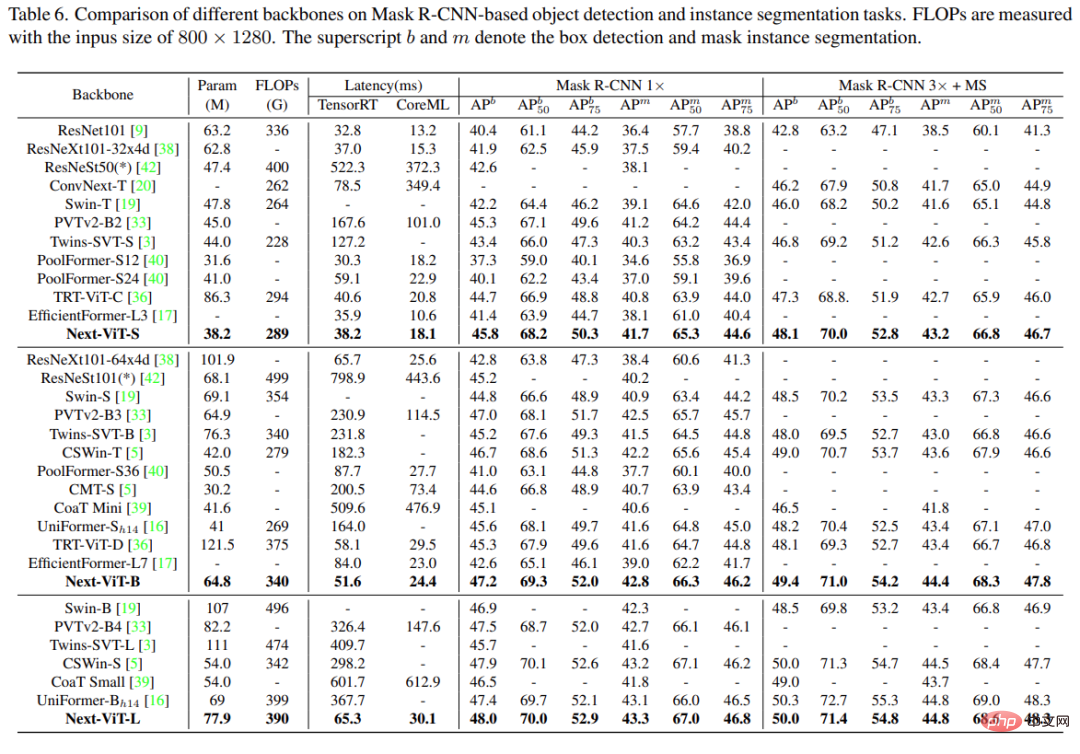

Umfangreiche Experimente zeigen, dass Next-ViT bestehende CNN-, ViT- und CNN-Transformer-Hybridarchitekturen hinsichtlich des Latenz-/Genauigkeits-Kompromisses für verschiedene visuelle Aufgaben deutlich übertrifft. Auf TensorRT übertrifft Next-ViT ResNet um 5,4 mAP bei der COCO-Erkennungsaufgabe (40,4 vs. 45,8) und 8,2 % mIoU bei der ADE20K-Segmentierung (38,8 % vs. 47,0 %). Mittlerweile erreicht Next-ViT eine mit CSWin vergleichbare Leistung und erreicht eine 3,6-mal schnellere Inferenz. Auf CoreML übertrifft Next-ViT EfficientFormer um 4,6 mAP bei der COCO-Erkennungsaufgabe (42,6 vs. 47,2) und 3,5 % mIoU bei der ADE20K-Segmentierung (von 45,2 % auf 48,7 %).

Die Gesamtarchitektur von Next-ViT ist in Abbildung 2 unten dargestellt. Next-ViT folgt einer hierarchischen Pyramidenarchitektur mit einer Patch-Einbettungsschicht und einer Reihe von Faltungs- oder Transformer-Blöcken auf jeder Stufe. Die räumliche Auflösung wird schrittweise auf 1/32 des Originals reduziert, während die Kanaldimensionen schrittweise erweitert werden.

Die Forscher entwarfen zunächst das Kernmodul der Informationsinteraktion eingehend und entwickelten leistungsstarke NCB bzw. NTB, um kurz- und langfristige Abhängigkeiten in visuellen Daten zu simulieren. Auch die Fusion lokaler und globaler Informationen wird in NTB durchgeführt, um die Modellierungsfähigkeiten weiter zu verbessern. Um schließlich die inhärenten Mängel bestehender Methoden zu überwinden, untersucht diese Studie systematisch die Integration von Faltungs- und Transformer-Blöcken und schlägt eine NHS-Strategie zum Stapeln von NCB und NTB vor, um eine neuartige CNN-Transformer-Hybridarchitektur aufzubauen.

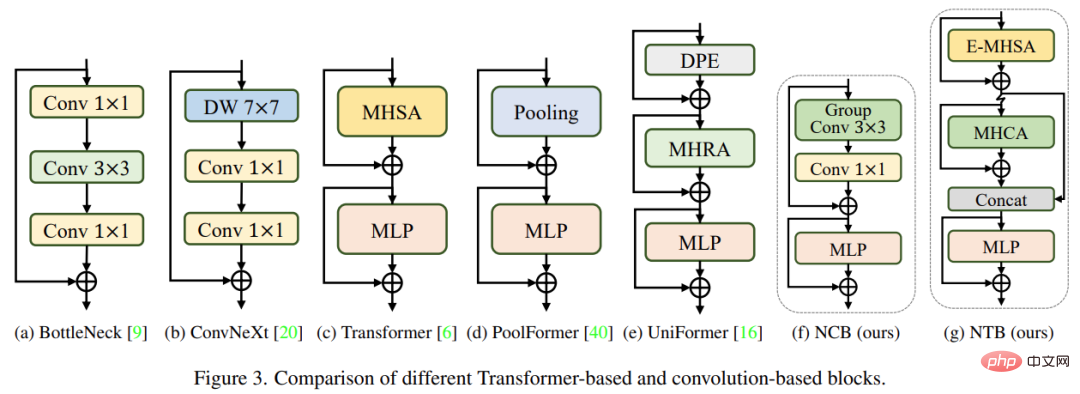

Forscher analysierten mehrere klassische Strukturdesigns, wie in Abbildung 3 unten dargestellt. Der von ResNet [9] vorgeschlagene BottleNeck-Block dominiert seit langem visuelle neuronale Netze aufgrund seiner inhärenten induktiven Vorspannung und der einfachen Bereitstellung auf den meisten Hardwareplattformen. Leider sind BottleNeck-Blöcke weniger effektiv als Transformer-Blöcke. Der ConvNeXt-Block [20] modernisiert den BottleNeck-Block, indem er das Design des Transformer-Blocks nachahmt. Während ConvNeXt-Blöcke die Netzwerkleistung verbessern, wird die Inferenzgeschwindigkeit auf TensorRT/CoreML durch ineffiziente Komponenten stark eingeschränkt. Der Transformer-Block hat bei verschiedenen Vision-Aufgaben hervorragende Ergebnisse erzielt. Allerdings ist die Inferenzgeschwindigkeit des Transformer-Blocks auf TensorRT und CoreML viel langsamer als die des BottleNeck-Blocks, da sein Aufmerksamkeitsmechanismus komplexer ist, was in den meisten realen Welten nicht der Fall ist Industrieszenarien.

Um die Probleme der oben genannten Blocktypen zu überwinden, schlägt diese Studie den Next Convolution Block (NCB) vor, der die herausragende Leistung des Transformer-Blocks erhält und gleichzeitig die Bereitstellungsvorteile des BottleNeck-Blocks beibehält. Wie in Abbildung 3(f) dargestellt, folgt NCB der allgemeinen Architektur des MetaFormer (der sich nachweislich als entscheidend für den Transformer-Block erwiesen hat).

Darüber hinaus ist ein effizienter aufmerksamkeitsbasierter Token-Mixer ebenso wichtig. Diese Studie entwarf einen Multi-Head Convolutional Attention (MHCA) als effizienten Token-Mischer, der Faltungsoperationen einsetzt, und baute NCB unter Verwendung von MHCA- und MLP-Schichten im Paradigma von MetaFormer auf [40].

NCB hat die lokalen Darstellungen effektiv gelernt, und der nächste Schritt muss die Erfassung globaler Informationen sein. Die Transformer-Architektur verfügt über eine starke Fähigkeit, niederfrequente Signale zu erfassen, die globale Informationen liefern (z. B. globale Form und Struktur).

Ähnliche Untersuchungen haben jedoch ergeben, dass der Transformer-Block hochfrequente Informationen, wie z. B. lokale Texturinformationen, bis zu einem gewissen Grad verschlechtern kann. Signale aus verschiedenen Frequenzbändern sind für das menschliche visuelle System von wesentlicher Bedeutung und werden auf eine bestimmte Weise fusioniert, um wesentlichere und einzigartigere Merkmale zu extrahieren.

Beeinflusst von diesen bekannten Ergebnissen entwickelte diese Forschung den Next Transformer Block (NTB), um Mehrfrequenzsignale in einem leichten Mechanismus zu erfassen. Darüber hinaus kann NTB als effizienter Mehrfrequenz-Signalmischer eingesetzt werden, wodurch die gesamten Modellierungsfähigkeiten weiter verbessert werden.

Einige neuere Arbeiten zielen darauf ab, CNN und Transformer für eine effiziente Bereitstellung zu kombinieren. Wie in Abbildung 4(b)(c) unten dargestellt, verwenden sie fast alle Faltungsblöcke in der flachen Stufe und stapeln Transformer-Blöcke nur in den letzten ein oder zwei Stufen. Diese Kombination ist bei Klassifizierungsaufgaben effektiv. Die Studie ergab jedoch, dass diese Hybridstrategien bei nachgelagerten Aufgaben wie Segmentierung und Erkennung leicht eine Leistungssättigung erreichen können. Der Grund dafür ist, dass Klassifizierungsaufgaben nur die Ausgabe der letzten Stufe zur Vorhersage verwenden, während nachgelagerte Aufgaben (wie Segmentierung und Erkennung) normalerweise auf den Merkmalen jeder Stufe basieren, um bessere Ergebnisse zu erzielen. Dies liegt daran, dass die traditionelle Hybridstrategie in den letzten Phasen nur Transformer-Blöcke stapelt und die flachen Schichten keine globalen Informationen erfassen können.

Diese Studie schlägt eine neue Hybridstrategie (NHS) vor, die Faltungsblöcke (NCB) und Transformatorblöcke (NTB) mit dem (N + 1) * L-Hybridparadigma kreativ kombiniert. NHS verbessert die Leistung des Modells bei nachgelagerten Aufgaben erheblich und erreicht eine effiziente Bereitstellung bei gleichzeitiger Kontrolle des Anteils der Transformer-Blöcke.

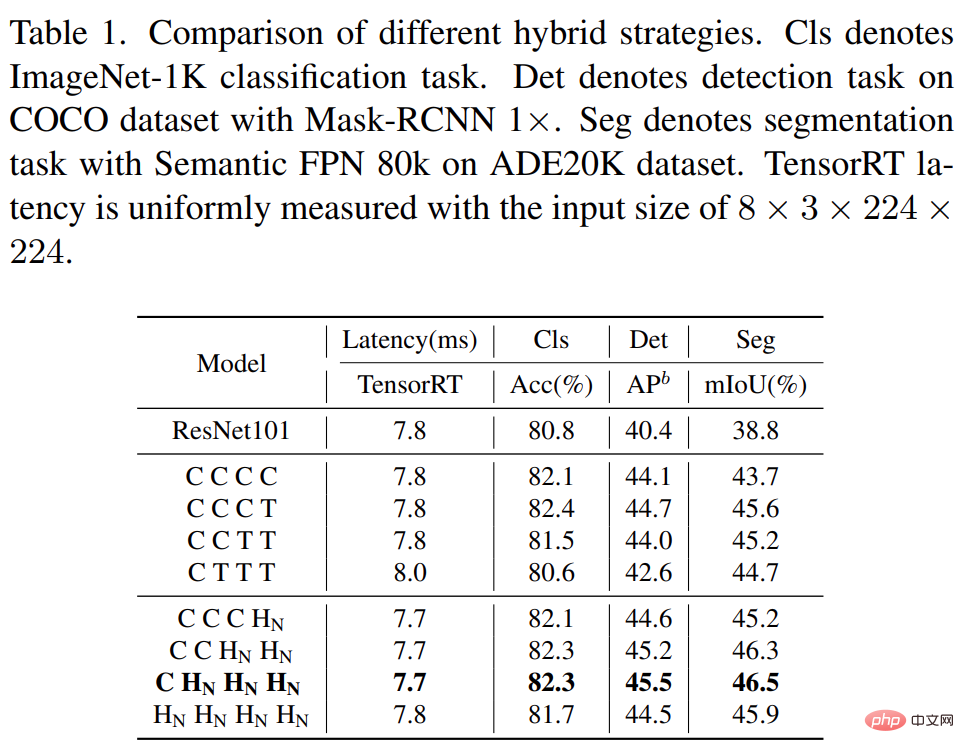

Um der flachen Schicht die Möglichkeit zu geben, globale Informationen zu erfassen, schlägt diese Studie zunächst eine Modus-Mischstrategie (NCB×N+NTB×1) vor, bei der N NCBs und ein NTB in jeder Stufe gestapelt werden Das in Abbildung 4(d) dargestellte Beispiel ist dargestellt. Insbesondere werden am Ende jeder Stufe Transformer Blocks (NTB) platziert, die es dem Modell ermöglichen, globale Darstellungen in flachen Schichten zu lernen. Diese Studie führte eine Reihe von Experimenten durch, um die Überlegenheit der vorgeschlagenen Hybridstrategie zu überprüfen. Die Leistung verschiedener Hybridstrategien ist in Tabelle 1 unten dargestellt.

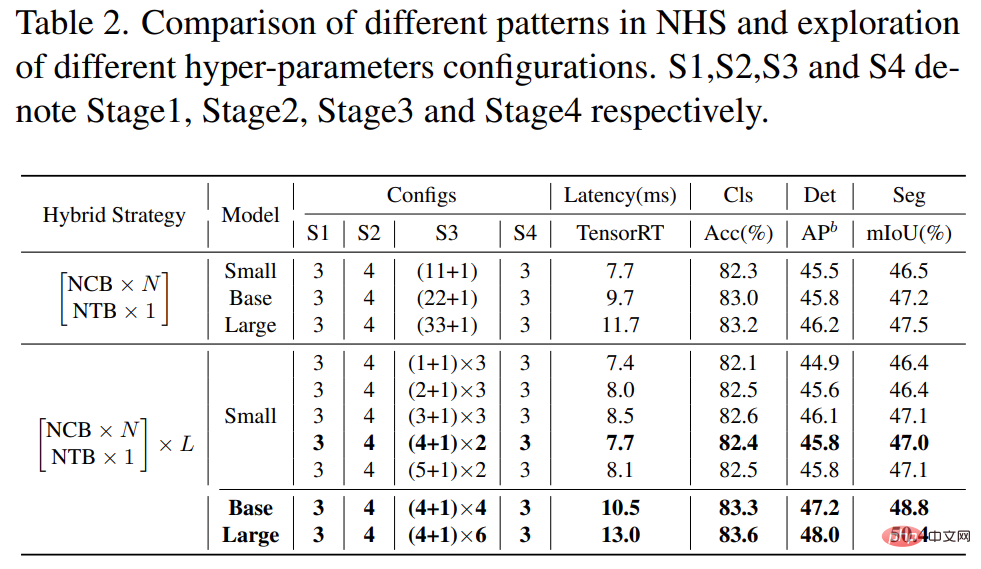

Darüber hinaus wird die Leistung großer Modelle, wie in Tabelle 2 unten gezeigt, allmählich ihre Sättigung erreichen. Dieses Phänomen zeigt, dass die Vergrößerung der Modellgröße durch Vergrößerung von N im (NCB × N + NTB × 1)-Modus, d. h. das einfache Hinzufügen weiterer Faltungsblöcke, nicht die optimale Wahl ist. (NCB × N + NTB × 1)-Modus Der Wert von N in kann die Leistung des Modells ernsthaft beeinträchtigen.

Daher begannen Forscher, den Einfluss des N-Werts auf die Modellleistung durch umfangreiche Experimente zu untersuchen. Wie in Tabelle 2 (Mitte) dargestellt, konstruierte die Studie in der dritten Phase Modelle mit unterschiedlichen N-Werten. Um Modelle mit ähnlichen Latenzen für einen fairen Vergleich zu konstruieren, stapelt diese Studie L Sätze von (NCB × N + NTB × 1)-Mustern bei kleinen Werten von N.

Wie in Tabelle 2 gezeigt, erreicht das Modell mit N = 4 in der dritten Stufe den besten Kompromiss zwischen Leistung und Latenz. Die Studie baut weiter ein größeres Modell auf, indem L in der dritten Stufe im (NCB × 4 + NTB × 1) × L-Modus erweitert wird. Wie in Tabelle 2 (unten) gezeigt, ist die Leistung des Basismodells (L = 4) und des großen Modells (L = 6) im Vergleich zum kleinen Modell deutlich verbessert, was den vorgeschlagenen Wert (NCB × N + NTB × 1) × L bestätigt Modellieren Sie die allgemeine Wirksamkeit.

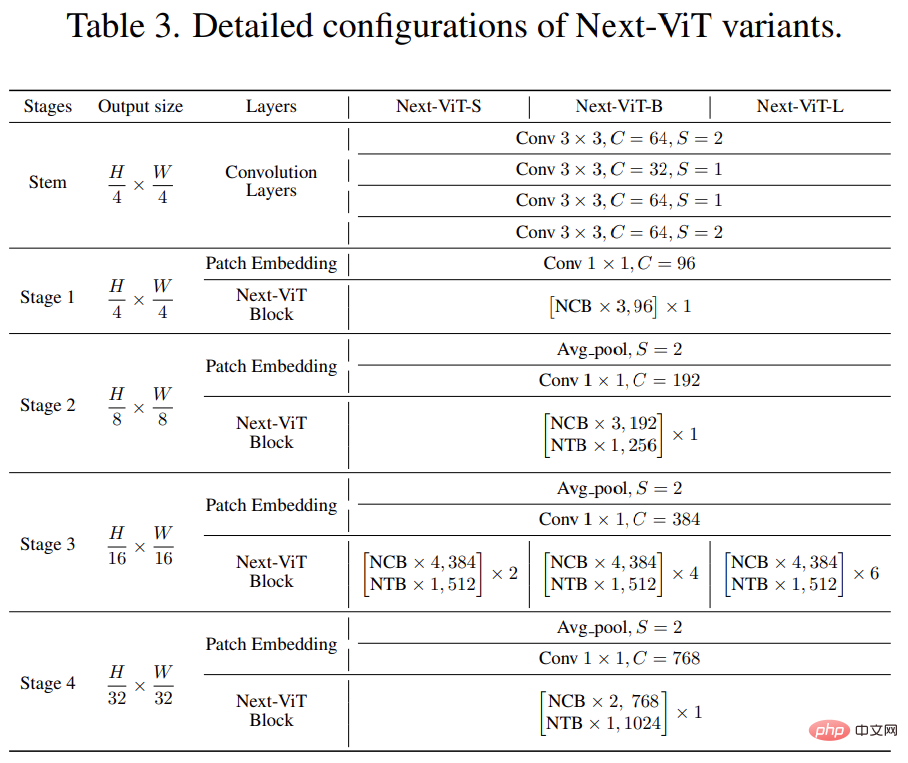

Um einen fairen Vergleich mit bestehenden SOTA-Netzwerken zu ermöglichen, schlugen die Forscher schließlich drei typische Varianten vor, nämlich Next-ViTS/B/L.

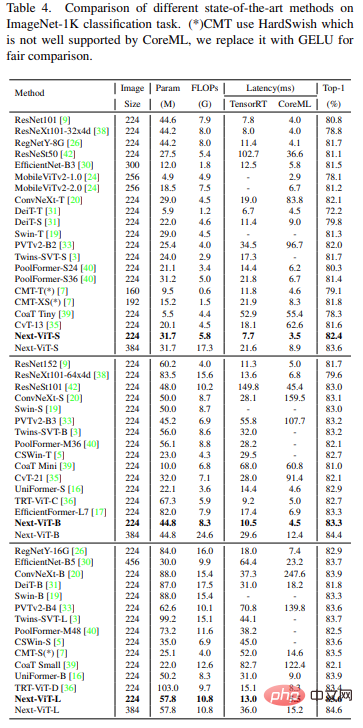

Verglichen mit den neuesten SOTA-Methoden wie CNN, ViT und Hybridnetzwerken, Next-ViT erzielt den besten Kompromiss zwischen Genauigkeit und Latenz. Die Ergebnisse sind in Tabelle 4 unten aufgeführt.

Objekterkennung und Instanzsegmentierung

Ablationsexperimente und Visualisierung

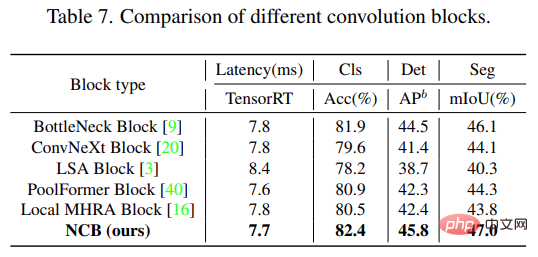

Wie in Tabelle 7 unten gezeigt, erreicht NCB bei allen drei Aufgaben den besten Kompromiss zwischen Latenz und Genauigkeit.

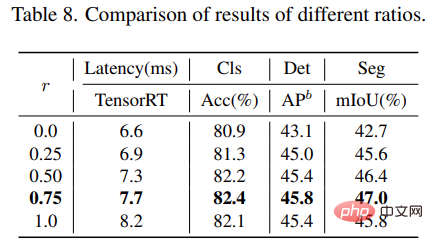

Für den NTB-Block untersucht diese Studie den Einfluss der Schrumpfungsrate r von NTB auf die Gesamtleistung von Next-ViT: Die Ergebnisse sind in Tabelle 8 unten aufgeführt. Durch die Reduzierung der Schrumpfung r wird die Modelllatenz verringert.

Für den NTB-Block untersucht diese Studie den Einfluss der Schrumpfungsrate r von NTB auf die Gesamtleistung von Next-ViT: Die Ergebnisse sind in Tabelle 8 unten aufgeführt. Durch die Reduzierung der Schrumpfung r wird die Modelllatenz verringert.

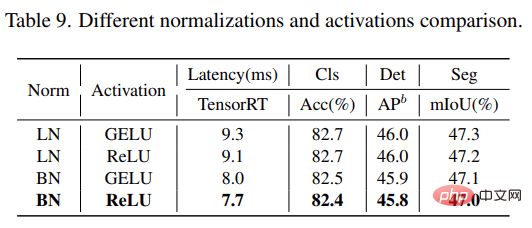

Diese Studie analysiert weiter die Auswirkungen verschiedener Normalisierungsschichten und Aktivierungsfunktionen in Next-ViT. Wie in Tabelle 9 unten gezeigt, bringen LN und GELU zwar einige Leistungsverbesserungen, die Inferenzlatenz bei TensorRT ist jedoch deutlich höher. Andererseits erzielen BN und ReLU den besten Kompromiss zwischen Latenz und Genauigkeit bei der Gesamtaufgabe. Daher nutzt Next-ViT BN und ReLU einheitlich für einen effizienten Einsatz in realen Industrieszenarien.

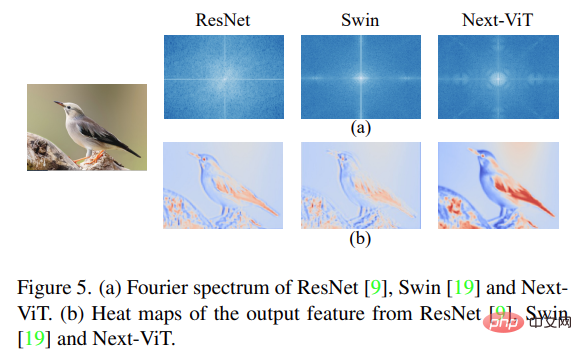

Abschließend visualisiert die Studie das Fourier-Spektrum der Ausgabefunktionen von ResNet, Swin Transformer und Next-ViT und Wärmekarte, wie in Abbildung 5(a) unten dargestellt. Die spektrale Verteilung von ResNet zeigt, dass der Faltungsblock dazu neigt, hochfrequente Signale zu erfassen, und es schwierig macht, auf niederfrequente Signale zu achten. ViT kann niederfrequente Signale gut erfassen und hochfrequente Signale ignorieren gleichzeitig hochwertige Mehrfrequenzsignale, was die Vorteile der NTB-Wirksamkeit zeigt.

Abschließend visualisiert die Studie das Fourier-Spektrum der Ausgabefunktionen von ResNet, Swin Transformer und Next-ViT und Wärmekarte, wie in Abbildung 5(a) unten dargestellt. Die spektrale Verteilung von ResNet zeigt, dass der Faltungsblock dazu neigt, hochfrequente Signale zu erfassen, und es schwierig macht, auf niederfrequente Signale zu achten. ViT kann niederfrequente Signale gut erfassen und hochfrequente Signale ignorieren gleichzeitig hochwertige Mehrfrequenzsignale, was die Vorteile der NTB-Wirksamkeit zeigt.

Darüber hinaus kann Next-ViT, wie in Abbildung 5(b) dargestellt, umfangreichere Inhalte erfassen als ResNet und Swin-Texturinformationen und genauere globale Informationen zeigen, dass Next-ViT über stärkere Modellierungsfunktionen verfügt.

Darüber hinaus kann Next-ViT, wie in Abbildung 5(b) dargestellt, umfangreichere Inhalte erfassen als ResNet und Swin-Texturinformationen und genauere globale Informationen zeigen, dass Next-ViT über stärkere Modellierungsfunktionen verfügt.

Das obige ist der detaillierte Inhalt vonIndem es die richtige Kombination aus CNN und Transformer freischaltet, schlägt ByteDance einen effektiven visuellen Transformer der nächsten Generation vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!