最初の作品は Kuaishou が自主開発したもので、主に制約マルチ用です。 -タスクシナリオ。

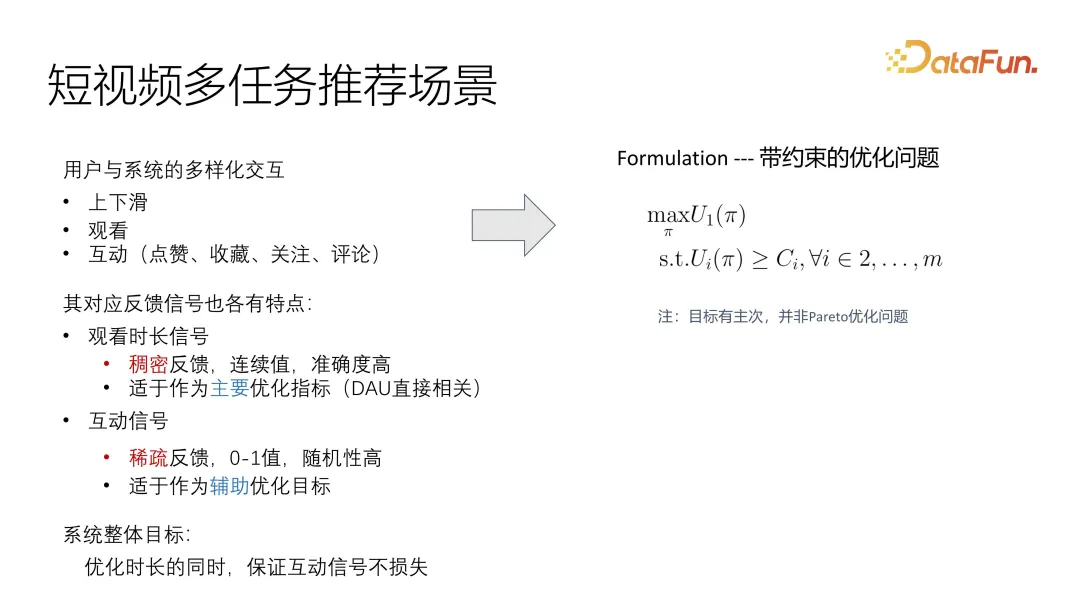

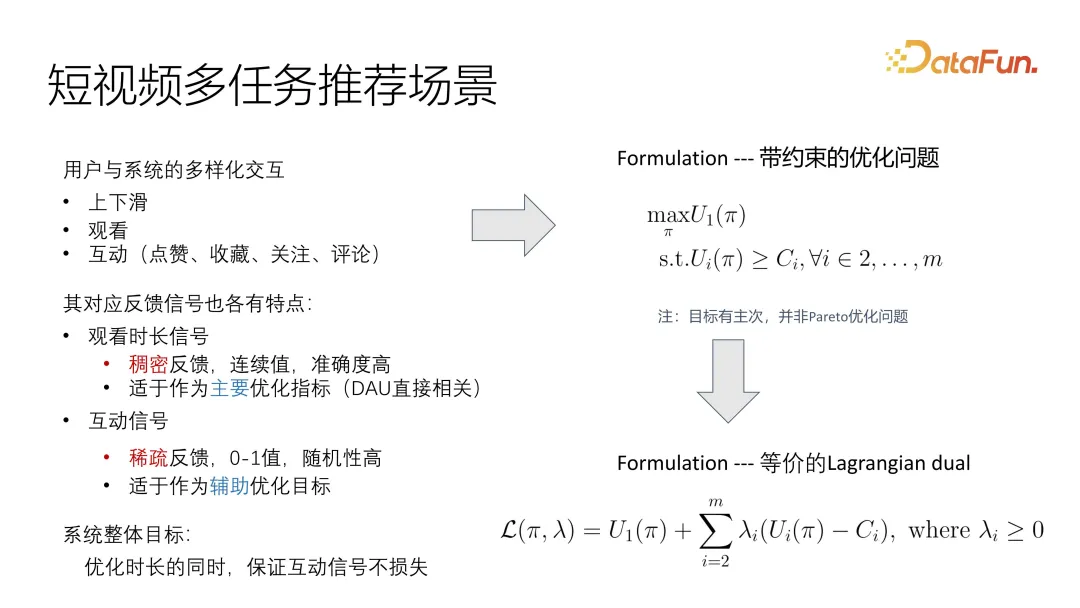

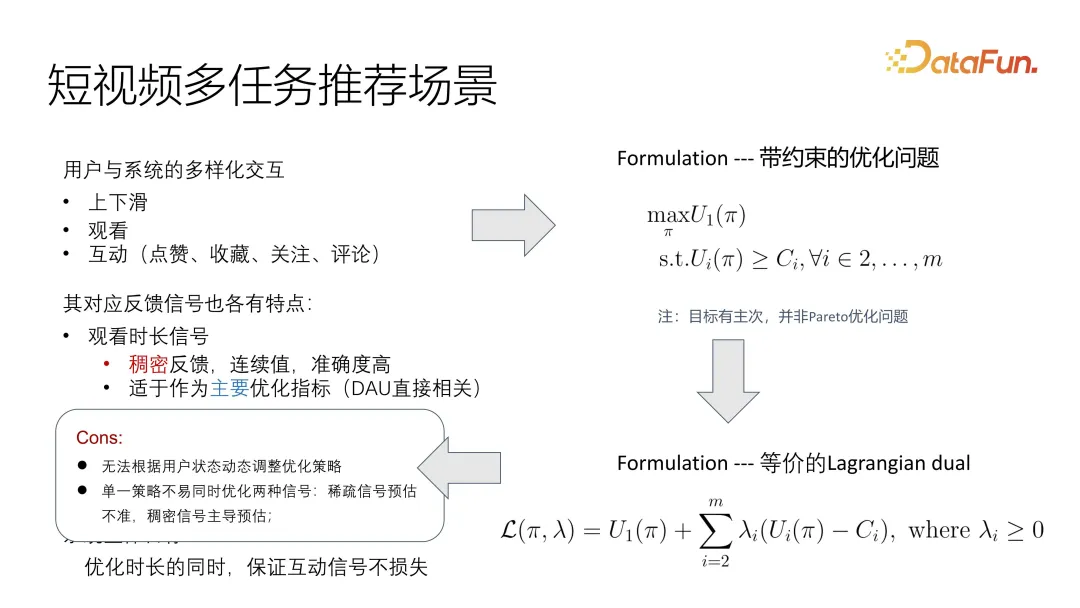

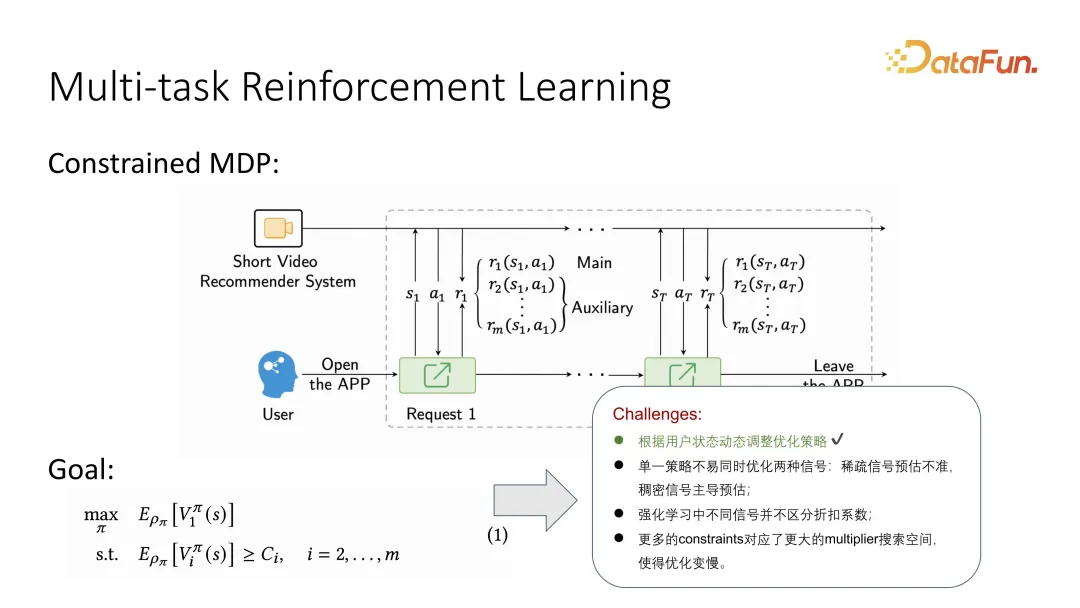

この作業は主に、より専門的なショートビデオのシナリオ、マルチタスクを目的としています。 -タスクのユーザー フィードバックは、閲覧時間とインタラクションに分けられます。より一般的なインタラクションには、いいね、コレクション、フォロー、コメントが含まれます。これらのフィードバックにはそれぞれ独自の特徴があります。オンライン システムの観察を通じて、継続時間信号は実際には非常にまばらであり、連続値であるため、ユーザーの関心レベルを正確に測定することが難しいことがわかりました。対照的に、インタラクティブなシグナルは、いいね、お気に入り、フォロー、コメントなどの情報が豊富で、これらのフィードバックは視聴者の好みと行動に関するフィードバックの 2 つのカテゴリに分類できます。最適化プロセスでは、この信号が主な目標であり、インタラクションは補助的な最適化であると考えられ、最適化の全体的な目標としてインタラクティブな信号が失われないように努めます。対照的に、インタラクションの数はまばらであり、統一された基準がないため、ユーザーの関心を正確に測定することは困難です。効果を改善するには、全体的な目標の補助としてインタラクティブ データの整合性を確保しながら、システムの主な目標として最適化できるように、特定の最適化を実行する必要があります。

#このように、この問題は制約付き最適化問題として非常に直観的に説明できます。ユーティリティの最適化という主な目標があります。補助的な目標は、下限を満たすことだけです。一般的なパレート最適化問題とは異なり、ここでは優先順位を付ける必要があります。

#この問題を解決する一般的な方法は、ラグランジュ双対問題に変換して、最適化された次の式に直接結合できるようにすることです。目的関数は、全体最適でも交互最適でも、全体目標として最適化できます。もちろん、さまざまな目標の相関関係や影響要因を制御する必要があります。

ユーザーのステータスは動的に変化し、短いビデオ シナリオでは非常に急速に変化するため、この観測結果の定式化にはまだいくつかの問題があります。 。さらに、信号が均一ではないため、特にチアノーゼの主ターゲット最適化と補助ターゲット最適化には非常に一貫性のない分布問題があり、既存のソリューションで対処することが困難です。これをターゲット関数に統合すると、信号の 1 つが別の信号を支配する可能性があります。

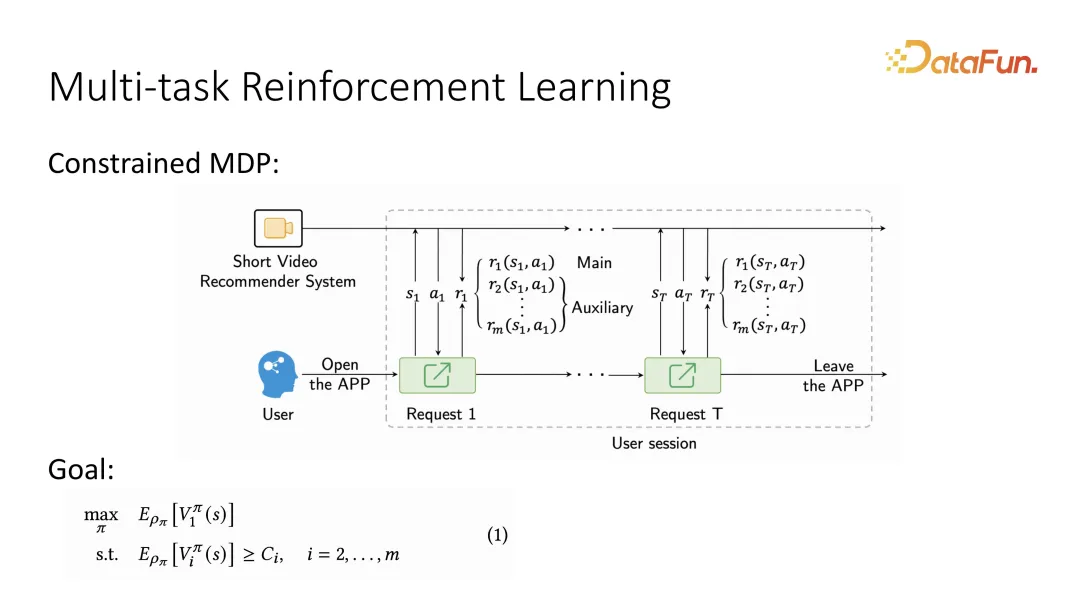

最初の点に基づいて、ユーザーのダイナミクス 変更問題は、ユーザーとシステムの間の交互の対話シーケンスである MDP としてよく説明されますが、このシーケンスは、マルコフ決定プロセスとして説明された後、強化学習手法を使用して解決できます。具体的には、マルコフ決定プロセスを説明した後、主目標と補助目標を区別する必要があるため、ユーザーのフィードバックを与える場合には 2 つの異なる目標を区別する必要があることを追加で記述する必要があります。複数の補助目標を指定することもできます。強化学習が長期的な最適化目標を定義する場合、最適化される主な目標は、価値関数と呼ばれる長期的な価値関数として定義されます。同様に、補助ターゲットについても、対応する値関数が存在します。各ユーザーのフィードバックに相当する長期的な価値評価が行われ、これまでの効用関数と比較して、長期的な価値関数となりました。

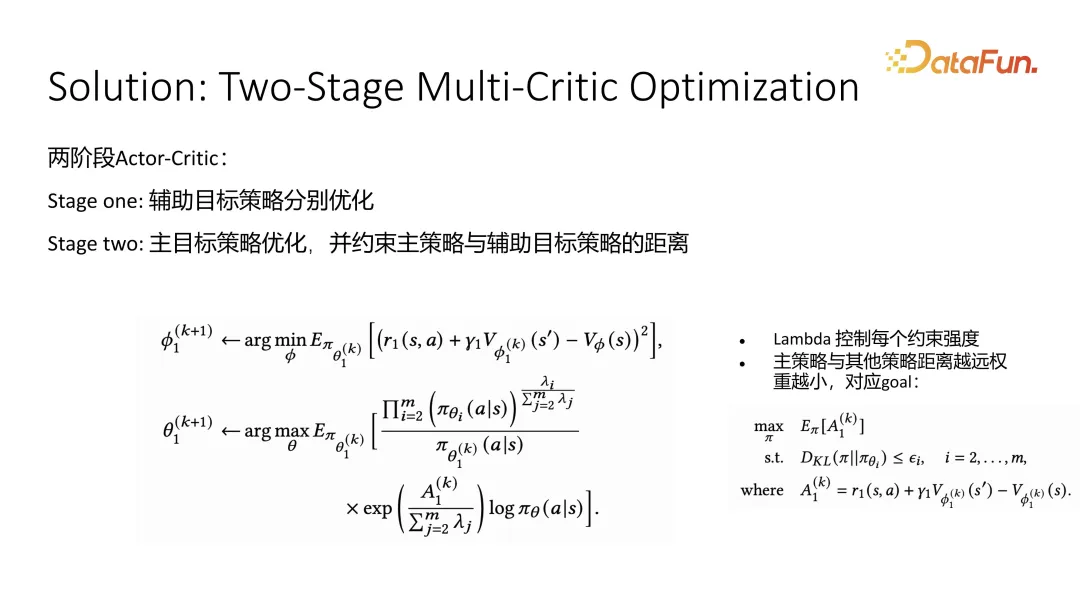

3. 解決策: 2 段階のマルチクリティカル最適化

この作業の解決策は、全体の最適化を 2 つの段階に分割することです。第 1 段階では補助目標を最適化し、第 2 段階では主目標を最適化します。

補助ターゲットの最適化の第 1 段階では、典型的なアクター批評家最適化手法が採用され、いいねや注目などの補助ターゲットの最適化には、それぞれ 1 つの批評家が最適化されました。現状のメリットとデメリット。長期的な値の推定が正確になったら、アクターを最適化するときに値関数を使用してその学習をガイドできます。式 (2) はクリティカルの最適化、式 (3) はアクターの最適化です。クリティカルの最適化には、現在の状態、次の状態、および現在のアクションのサンプリングがトレーニング中に使用されます。 。ベルマン方程式に従ってアクションが得られ、将来の状態の値の推定値と組み合わせることで、現在の状態の推定値に近づく必要があり、最適化によって徐々に正確な長期的な値の推定値に近づくことができます。 。アクター学習を誘導する、つまりポリシー学習を推奨する場合、アドバンテージ関数が使用されます。有利関数とは、ある行動の効果が平均推定値よりも強いかどうかを指し、この平均推定値はベースラインと呼ばれます。アドバンテージが大きいほど、アクションは優れており、この推奨戦略が採用される可能性が高くなります。これが第 1 段階、補助目標の最適化です。

第 2 段階は主な目標を最適化することであり、期間を使用します。補助ターゲットは、メイン ターゲットを制約するときに近似戦略を使用します。メイン ターゲットによって出力されるアクション分布が、さまざまな補助ターゲットにできるだけ近いことを望みます。補助ターゲットに近づき続ける限り、補助ターゲットの結果は変わりません。目標はそれほど悪くないはずです。近似公式を求めた後、正方形を完成させることによって、つまり重み付けされた方法で閉じた形式の解を得ることができます。実際には、批評家レベルでの主目標全体のアクター批評家による最適化方法と価値関数推定レベルとの間には大きな違いはありません。ただし、アクターの場合は、閉じた形式の解から取得した重みを導入します。この重みの意味は、特定の補助戦略 I に対応するインパクトファクターが大きいほど、全体の重みに対する影響が大きくなるということです。政策出力の分布がすべての補助ターゲット政策の平均にできるだけ近いことが望まれますが、この現象は閉じた形式の解の動作が得られるときに発生します。

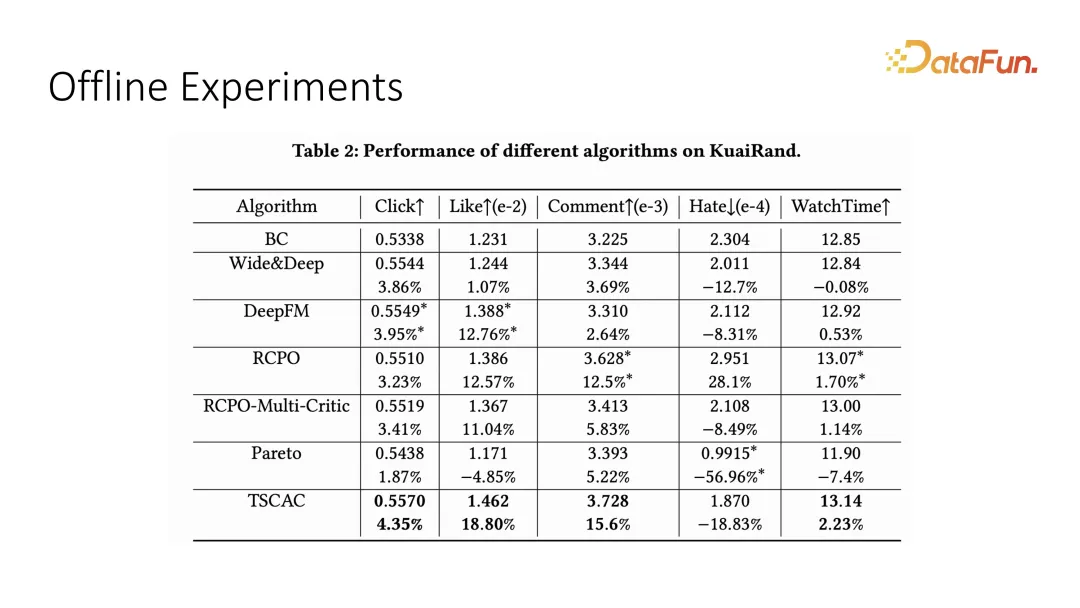

オフライン データセットに対する多目的最適化の効果をテストしました。 , ここでの主な目標は総再生時間、つまり視聴時間であり、補助的な目標はクリック、いいね、コメント、嫌いなどのインタラクション指標です。私たちが提案した 2 段階のアクターと批評家が最適な結果を達成できることがわかります。

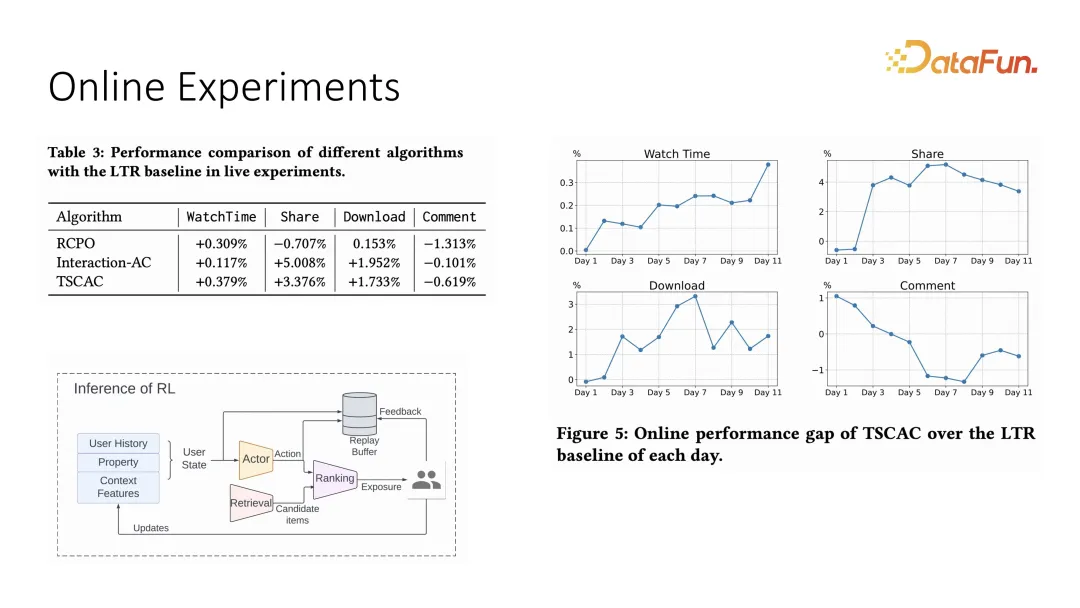

オンラインシステムでも同様に比較実験を行いましたが、オンラインシステムの設定はアクタープラスランキングの推薦モードを採用しており、ここではアクションが重みとなり、最終的なランキングは各項目と重みの内積の結果となります。また、オンライン実験からも、総再生時間が改善しながら他のインタラクションを抑制できることがわかり、以前の最適化戦略と比較して、インタラクション指標をより適切に抑制できます。

以上、第一作目の紹介となります。

2 番目の作業もマルチタスクの最適化における強化学習の応用ですが、これはより伝統的な最適化です。 。この作品はKuaishouと香港城市大学との共同プロジェクトであり、筆頭著者はLiu Ziruです。

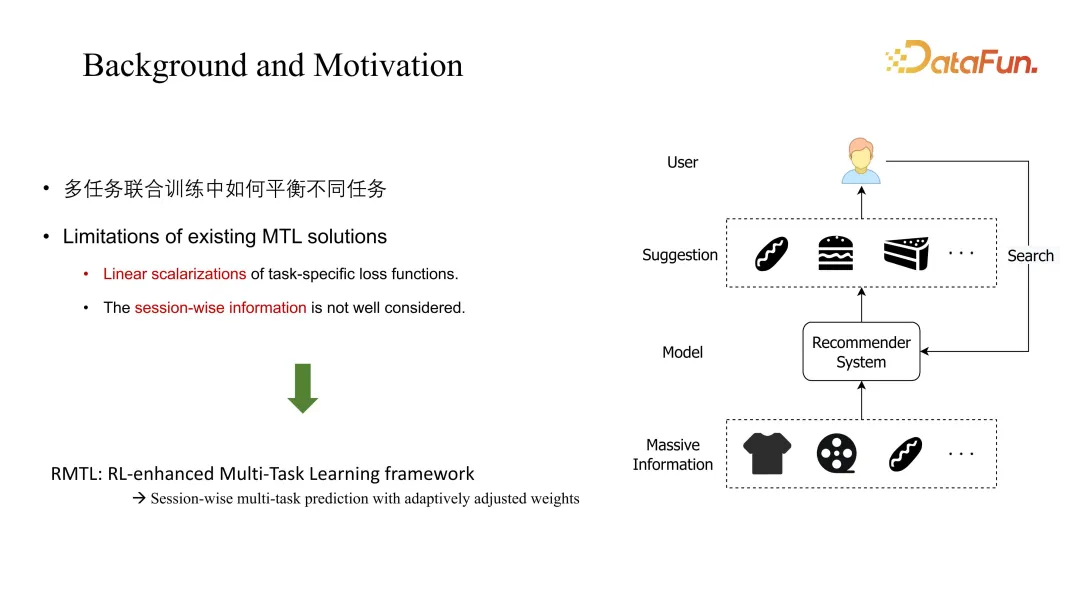

この作業で説明する主な問題は、典型的なマルチタスクです。共同トレーニングの目的は、異なるタスク間の係数のバランスを取ることです。従来の MTL ソリューションは一般に線形結合を考慮し、セッションの次元、つまり長期的な動的変化を無視します。本研究で提案したRMTLは、長期予測を通じて重み付け方法を変更する。

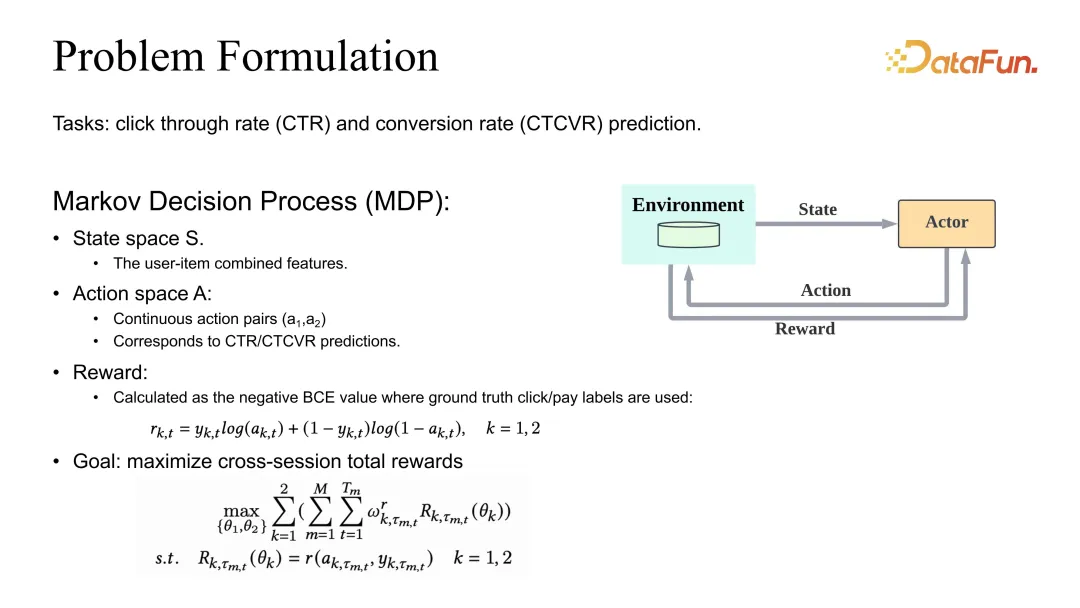

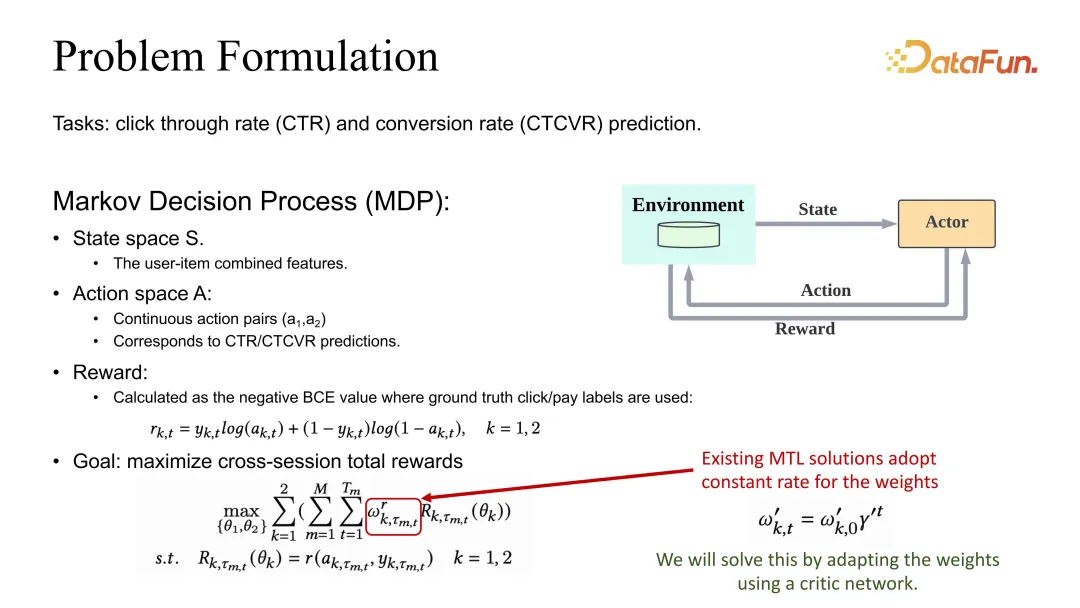

問題設定は、CTR と CVR の推定値の共同最適化を定義することです。 MDP (マルコフ決定プロセス) の定義もありますが、ここでのアクションは推奨リストではなく、対応する CTR と CVR の推定値です。推定が正確であるためには、報酬は BCE またはそれに対応する合理的な損失として定義される必要があります。全体的な目標の定義に関しては、通常、さまざまなタスクの重みとして定義され、セッション全体とすべてのデータ サンプルが合計されます。

ガンマの割引に加えて、その重み係数も調整が必要な係数の影響を受けることがわかります。

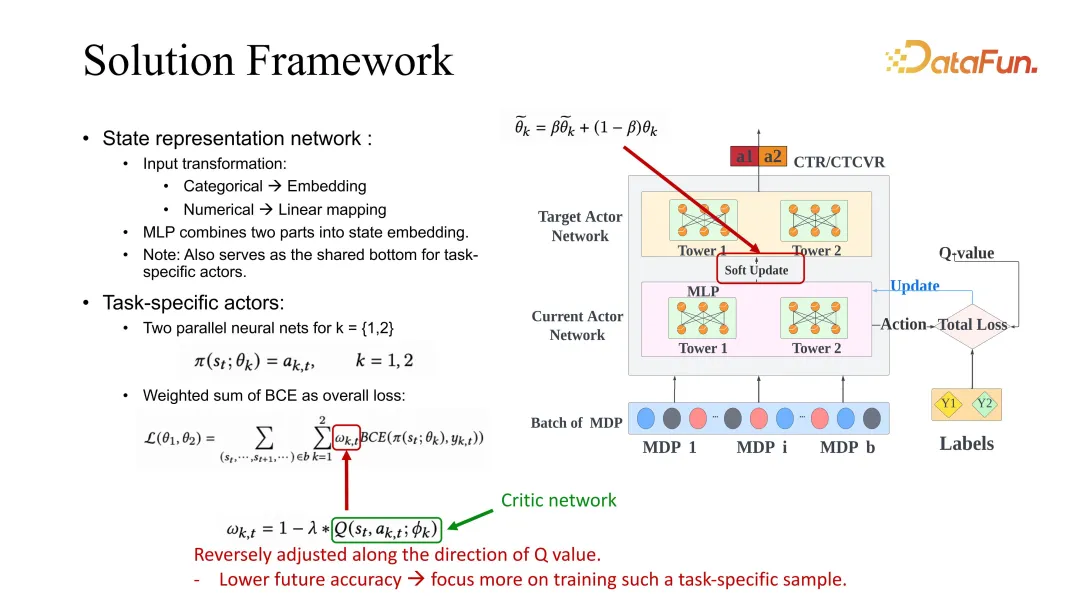

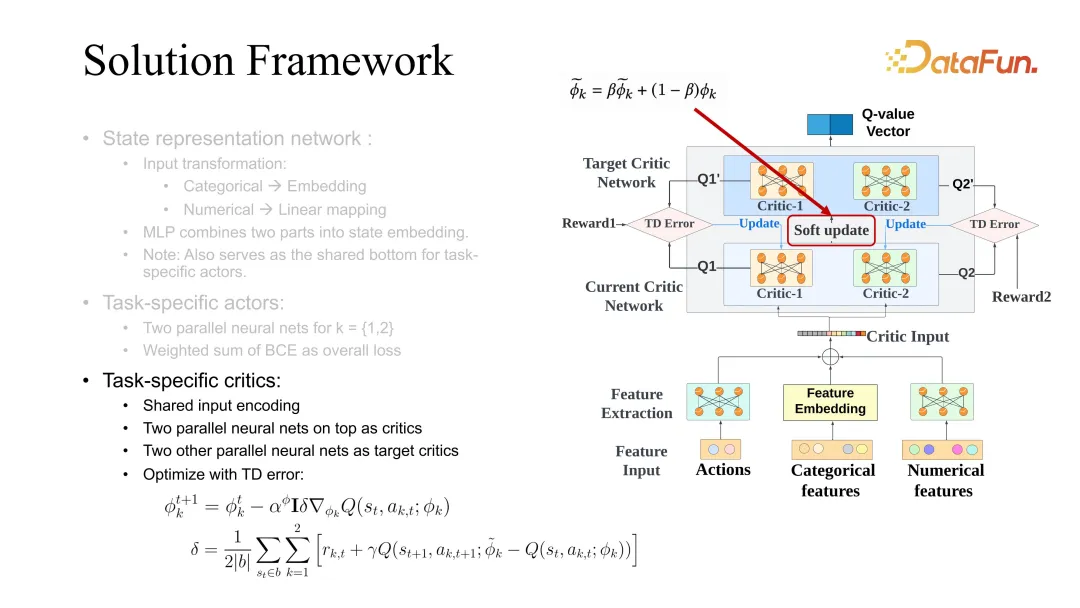

私たちの解決策は、セッション ディメンションの推定に関連してこの係数を調整することです。ここでは ESMM バックボーンが示されていますが、もちろん、他のベースラインの使用も一般的であり、私たちの方法を使用して改善できます。

ESMM を詳しく紹介しましょう。まず、タスク固有のアクターがあります。タスクごとに、ターゲットと現在のアクターの最適化があります。最適化中は、前に述べたアクターと同様のアクターが実行されます。批評家フレームワークが使用されています。最適化プロセス中に、アクターの学習をガイドする際に、BCE 損失によりタスク固有の重みを調整する必要があります。私たちのソリューションでは、将来の価値評価に基づいて、この重みを適宜変更する必要があります。この設定の意味は、将来の評価値が高いほど、現在の状態や現在の行動がより正確であることを意味し、学習が遅くなる可能性があります。逆に、将来の予測が不十分な場合は、モデルが状態と行動の将来について楽観的ではないことを意味するため、学習を増やす必要があり、このようにして重みが調整されます。ここでの将来の評価も、学習のために前述した批評家ネットワークを使用します。

批評家の学習も将来の状態と現在の状態の差を使用しますが、それは価値関数とは異なります。ここでの違いは、Q 関数を使用することです。状態とアクションの共同評価が必要です。アクターを更新する際には、異なるタスクに対応するアクターの学習も同時に利用する必要があります。ここでのソフト アップデートは一般的なトリックであり、RL 学習の安定性を高める場合に便利で、通常はターゲットと現在のクリティカルを同時に最適化します。

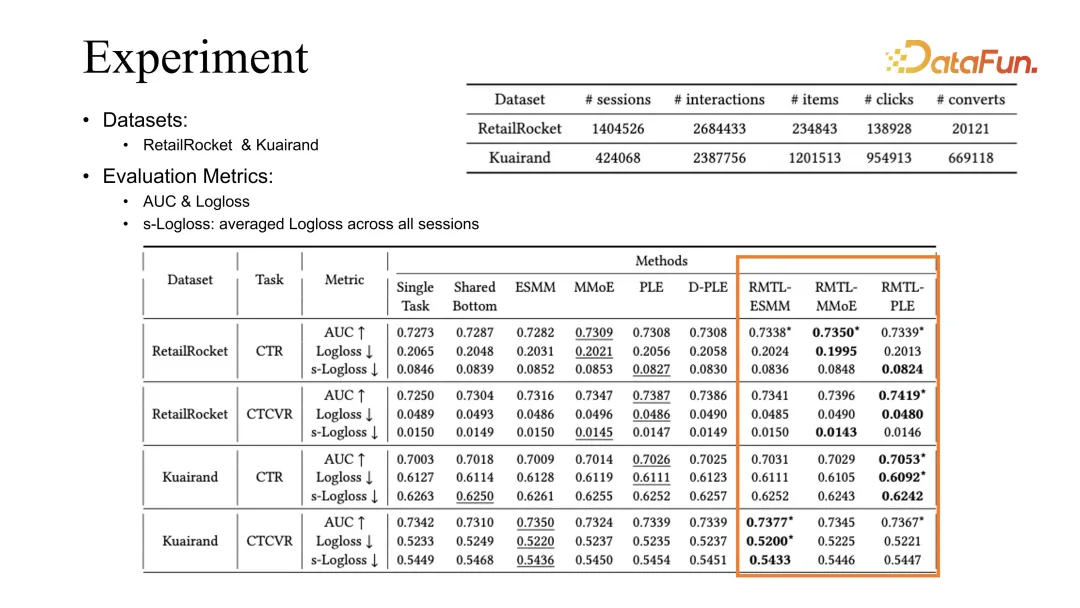

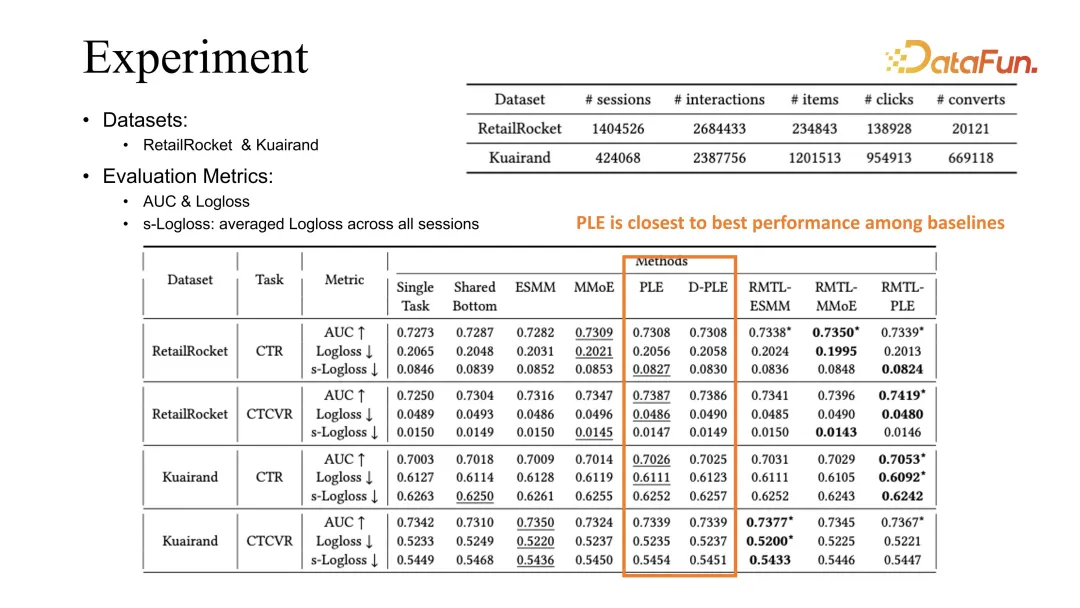

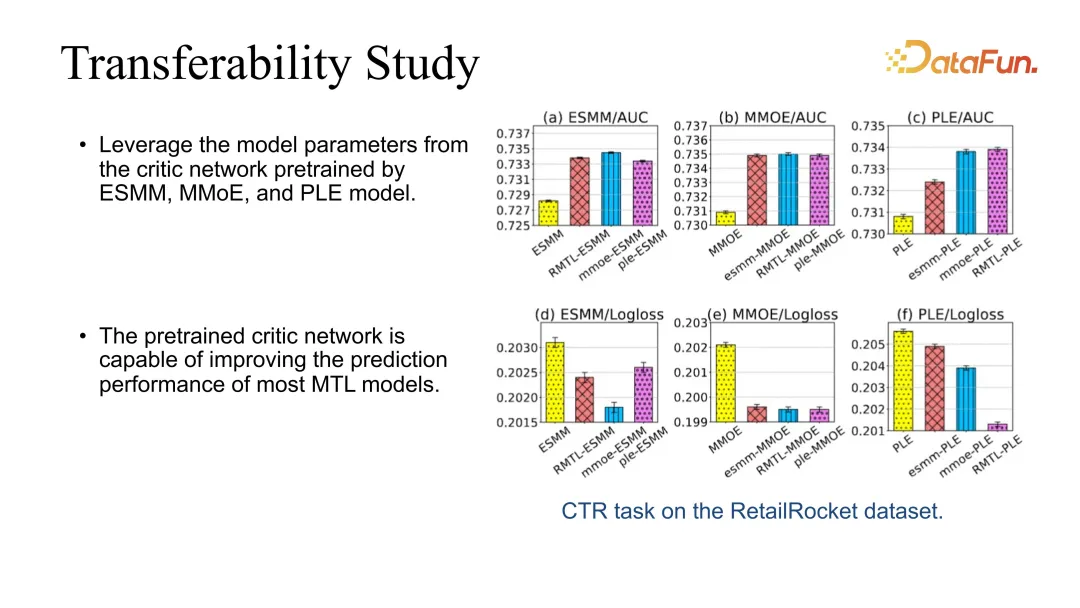

2 つの公開データセットでの比較実験を通じて、私たちの方法が既存のデータセットと組み合わせることができることがわかります。最適化手法には ESMM、MMoE、PLE が含まれ、得られた結果により以前のベースラインを改善できます。

PLE は、私たちの観察における最良のベースラインです。観察された現象に基づく私たちの結論は、さまざまなタスクを学習する場合には PLE の方が優れている可能性があるということです。共有埋め込みについて学習します。

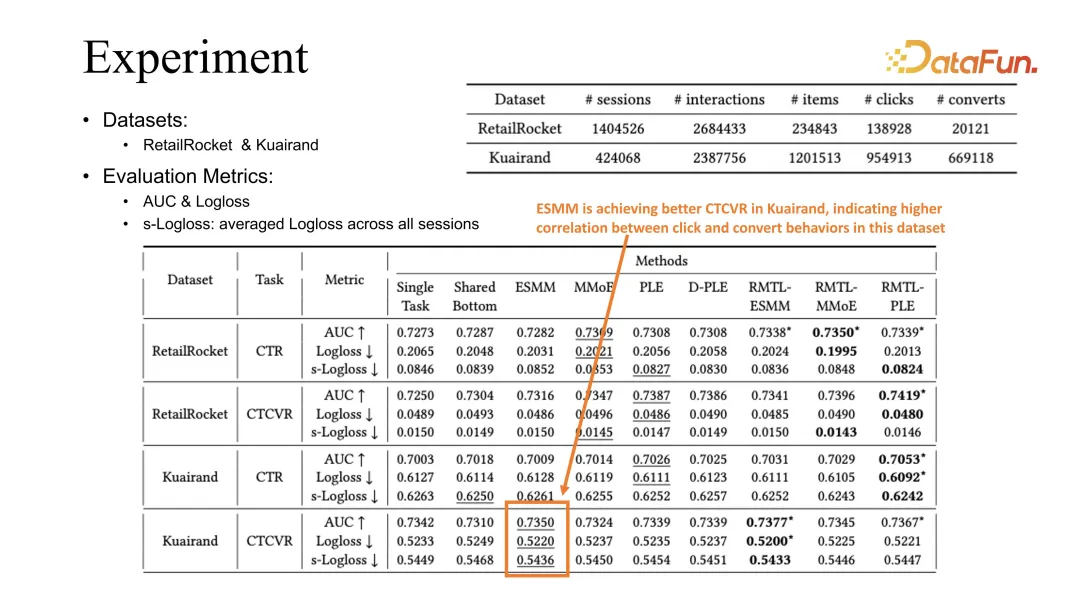

対照的に、ESMM はクアイランド タスクでより優れた CVR 評価を達成できます。これは、このデータセットにおけるクリックとコンバージョンの間のより強い相関関係に関連していると推測されます。

さらに、批評家が他のモデルに直接移植できるため、転移性テストも行いました。 。たとえば、最も基本的な RMTL を通じてアクター クリティカルを学習し、その後、クリティカルを使用して他のモデルのパフォーマンスを直接向上させることができます。接木時に安定して効果を向上させることができることが分かりました。

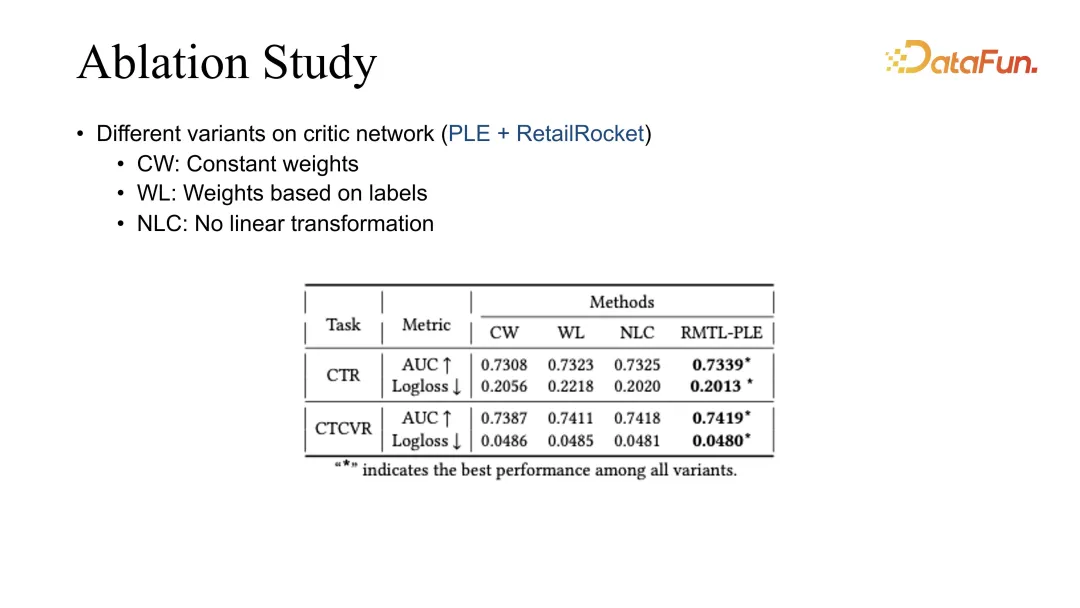

最後に、さまざまな加重方法を比較するためにアブレーション研究を実施しました。現在、RMTL によって最良の結果が得られています。

最後に、RL と MTL の経験をいくつかまとめてみましょう。

推奨システムは、長期的な最適化、特に最適化に関しては、強化学習とマルチタスクの最適化に非常に典型的なものであることがわかりました。長期にわたる複雑な指標。主目標と副目標の共同最適化の場合、ソフト正則化を使用して主目標の学習を制限できます。複数の目的の共同最適化中に、異なる目的の動的変化を考慮すると、最適化効果も向上します。

さらに、いくつかの課題もあります。たとえば、強化学習の異なるモジュールを組み合わせる場合、システムの安定性に多くの課題が生じます。私たちの経験では、データ品質の制御、ラベルの精度の制御、モデルの予測精度の監視が非常に重要な方法であると考えています。さらに、レコメンデーション システムとユーザーは直接対話するため、さまざまな目標はユーザー エクスペリエンスを部分的にしか反映できず、結果として得られるレコメンデーション戦略も大きく異なります。刻々と変化するユーザーの状況下で、どのようにユーザーエクスペリエンスを共同最適化し、総合的に向上させていくかは、今後非常に重要なテーマとなるでしょう。

A1: 期間インジケーターは典型的な回帰タスクです。ただし、継続時間の推定はビデオ自体の長さに強く関連していることにも気付きました。たとえば、短いビデオと長いビデオの分布は大きく異なるため、推定する際には、最初に分類され、次に回帰が行われます。終わり。 。最近では、ツリー法を用いた持続時間信号の分割推定法についての記事が KDD にも掲載されていますので、興味のある方はぜひ注目してみてください。一般的な意味は、たとえば、再生時間が長いビデオと短いビデオに分割されている場合、長いビデオには推定範囲があり、短いビデオには短いビデオの推定範囲があるということです。さらにツリー方式で分類することもでき、長い動画は中動画と長い動画、短い動画は超短い動画と短い動画に分けることができます。もちろん、純粋に分類法を使用して継続時間推定を解く方法もあり、テストも行っています。全体的な効果としてはまだ分類の範囲内ですが、再度回帰分析を行うと効果は若干良くなるでしょう。他の対話型指標の推定は、通常、既存の推定方法と同様です。オフライン評価中、AUC と GAUC は一般に比較的強い信号であり、現在、これら 2 つの信号は比較的正確です。

A2: 私たちのシステムは主にオンライン指標を調べ、オフラインでは通常 MAE と RMSE を使用します。ただし、オフラインとオンラインの評価には差があることもわかります。オフラインの評価で明らかな改善が見られない場合、それに対応する改善効果がオンラインでも見られない可能性があります。実際の対応関係は一定の重要度に達していない場合があります。違いはあまりないでしょう。

A3: ユーザーが再投稿する理由を分析し、いくつかの観察を行うと、より良い結果が得られる可能性があります。現時点では、フォワーディング推定を行っている場合、リンク下の推定方法と他のインタラクティブなターゲットとの違いはそれほど大きくありません。ラベルの定義、特に負のフィードバック信号の定義がモデルのトレーニングの精度に大きく影響するというより一般的な考え方があります。さらに、データソースの最適化もあり、データやオンライン配信に偏りがあるかどうかも予測の精度に影響するため、偏りを解消することにも多くの取り組みが行われています。推奨シナリオでは、推定される指標の多くは実際には間接的なシグナルであり、次のステップでの推奨効果に影響を与えるためです。したがって、推奨効果に基づいて指標を最適化することが私たちの適用シナリオです。

A4: 多目的融合では、最初にいくつかのヒューリスティックな方法といくつかの手動パラメータ調整方法があります。その後、徐々にパラメータ調整法を使うようになり、強化学習のパラメータ調整にも挑戦してみました。現在の経験では、自動基準調整は手動調整よりも優れており、その上限はわずかに高くなります。

A5: 最近、仕事上の議論が非常にまばらで、フィードバックが数日しかかからないという兆候がいくつかありました。最も一般的なシグナルの 1 つはユーザーの維持です。ユーザーは数日間離れてから戻ってくる可能性があるため、シグナルを受け取るまでにモデルは数日間更新されています。これらの問題を解決するにはいくつかの妥協点がありますが、解決策の 1 つは、どのリアルタイム フィードバック信号がこの非常にまばらな信号と特定の相関関係を持っているかを分析することです。これらのリアルタイム信号を最適化することにより、複数の方法を組み合わせて間接的に長期信号を最適化します。先ほどのリテンションを例に挙げると、私たちのシステムでは、ユーザーのリテンションとユーザーのリアルタイム視聴時間の間に非常に強い正の相関関係があることがわかりました。ユーザーの視聴時間はシステムに対するユーザーの粘度を表しており、基本的にはユーザー維持の下限を保証します。リテンションを最適化するときは、通常、最適化期間を他の関連指標と組み合わせて使用し、リテンションを最適化します。分析の結果、定着率と一定の相関関係があることが判明する限り、それを導入できます。

A6: Actor Critic は、数回繰り返した後の結果です。DQN や Reinforce などのもう少し直感的な方法も以前に試しましたが、それらのいくつかは実際にいくつかのシナリオで効果的です。ただし、現時点では、アクター クリティカルは比較的安定しており、デバッグが簡単な方法です。たとえば、Reinforce を使用するには長期的な信号を使用する必要があり、長期的な軌跡信号は比較的不安定であるため、その安定性を向上させるのはより困難になります。ただし、Actor Critic の利点の 1 つは、シングルステップのシグナルに基づいて最適化できることです。これは、レコメンデーション システムと非常に一貫した機能です。各ユーザーのフィードバックが学習用のトレーニング サンプルとして使用され、対応するアクター批評家および DDPG メソッドがシステムの設定と非常に一致することを願っています。

A7: ユーザー側の機能は依然としてさまざまな機能を使用しているため、ユーザー ID は実際には悪くありません。 ID の特性に加えて、ユーザーにはいくつかの統計的特性もあります。さらに、レコメンデーションリンクでは、RL は細かいランキングや並べ替えなど、適用するモジュールの比較的最後の段階にあるため、推定値やモデルのランキングシグナルも前の段階で与えられます。実際、ユーザーシグナルもあります。初期化。したがって、強化学習は推奨シナリオにおいても多くのユーザー側信号を取得しており、基本的にユーザー ID が 1 つだけ使用される状況は発生しません。

A8: はい。ユーザー ID を使用しない場合、パーソナライゼーションへの影響が非常に大きいことがわかりました。ユーザーの一部の統計的特徴だけを使用した場合、ユーザー ID に比べて改善効果が大きくない場合があります。確かにユーザー ID の影響は比較的大きいですが、影響が大きすぎるとボラティリティの問題が発生します。

A9: この質問はユーザーのコールド スタートに偏っています。コールド スタートのシナリオでは、通常、推奨されるリンクには補完機能または自動化された機能が含まれています。まず、これがデフォルトのユーザーであると仮定します。コールド スタート シナリオ: この問題はある程度解決されます。その後、ユーザーがシステムと対話し続けてセッションが充実し続けると、実際に一定量のユーザー フィードバックを得ることができ、トレーニングは徐々に正確になっていきます。安定性を確保するという点では、基本的に、適切に制御し、1 つのユーザー ID がトレーニングを支配するのを防ぐ限り、システムの効果を大幅に向上させることができます。

A10: その作業は、バケット化後に回帰を行うのではなく、バケット化を直接実行し、各バケットの到着確率を使用して期間を共同評価することです。全体的な確率評価を行うために、バケット化の確率とバケット化の値のみが使用されます。バケット化後の回帰は実際には不偏ではなくなり、結局のところ、各バケットには依然として独自の分布パターンが存在します。

A11: これは実際には多目的最適化ではありません。CTR はもはや最適化目標ではないため、CTR 指標は CPR を最適化するための入力として直接使用することもできます。しかし、ユーザーの CTR はシステムの好みや粘り強さをかなりの程度表しているため、これはユーザーにとっては好ましくない可能性があります。ただし、レコメンデーション システムが製品の販売に重点を置いているか、トラフィックの販売に重点を置いているかに応じて、異なるシステムが異なる場合があります。 Kuaishou のショートビデオは主にトラフィックに基づいているため、ユーザーの CTR はより直感的で重要な指標であり、CVR はトラフィックを迂回した後の効果にすぎません。

以上がKuaishou 強化学習とマルチタスクの推奨の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。