大規模モデルは言語と視覚の間を飛躍させており、テキストと画像のコンテンツをシームレスに理解して生成することを約束しています。最近の一連の研究によると、マルチモーダル機能の統合は成長傾向であるだけでなく、すでにマルチモーダルな会話からコンテンツ作成ツールに至るまで重要な進歩をもたらしています。大規模な言語モデルは、テキストの理解と生成において比類のない機能を実証しています。ただし、一貫したテキストの物語を含む画像を同時に生成することはまだ開発の余地があります。

最近、カリフォルニア大学サンタクルーズ校の研究チームは、MiniGPT-5 に基づく手法を提案しました。 「生成投票」の概念に基づく革新的なインターリーブ視覚言語生成技術。

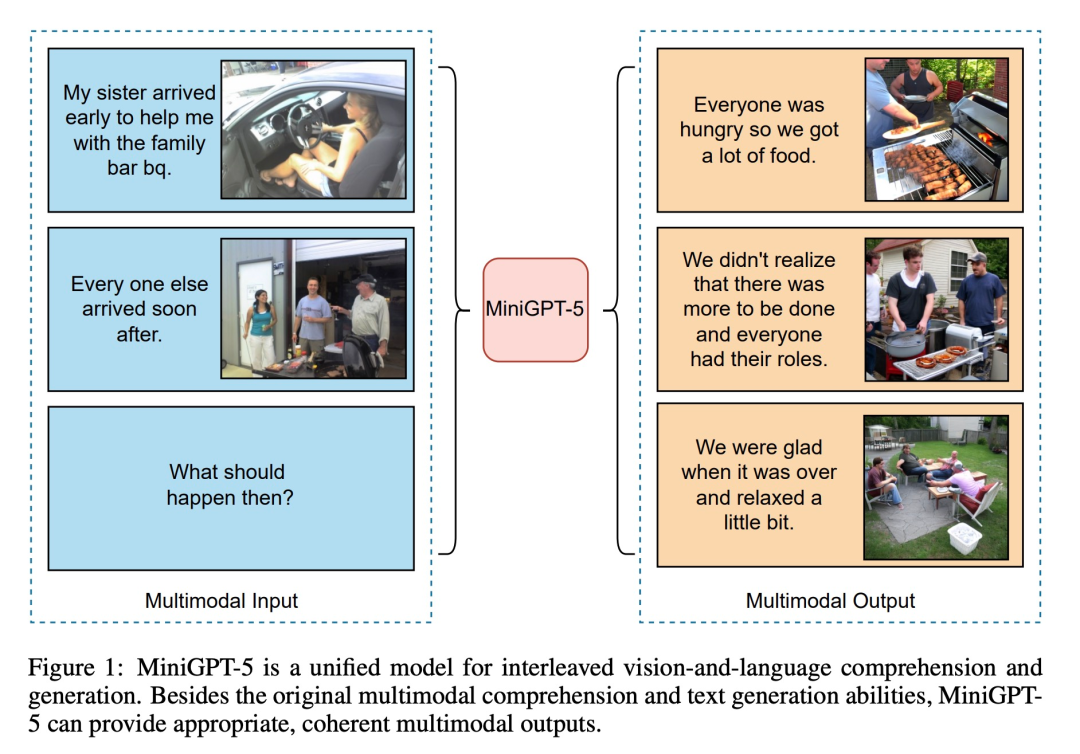

MiniGPT-5 は、特別なビジュアル トークン「生成投票」を通じて安定した拡散メカニズムと LLM を組み合わせることで、熟練したマルチモーダル生成への道を示します。モデル。同時に、この記事で提案されている 2 段階のトレーニング方法では、記述のない基本段階の重要性が強調されており、データが不足している場合でもモデルを成功させることができます。このメソッドの一般的な段階ではドメイン固有のアノテーションが必要ないため、このソリューションは既存のメソッドとは異なります。生成されたテキストと画像が調和していることを保証するために、この記事の二重損失戦略が機能し、生成投票方法と分類方法がこの効果をさらに強化します。これらのテクニックに基づいて、この作品は変革的なアプローチを示しています。研究チームは、ViT (Vision Transformer) と Qformer、および大規模な言語モデルを使用することで、マルチモーダル入力を生成投票に変換し、それらを高解像度の Stable Diffusion2.1 とシームレスに組み合わせて、コンテキストを意識した画像生成を実現しました。この論文では、補助入力としての画像を命令調整方法と組み合わせ、テキストと画像の生成損失の使用を先駆的に行い、それによってテキストと視覚の間の相乗効果を拡大します

MiniGPT-5 と CLIP 制約などモデルは照合され、拡散モデルは MiniGPT-4 と巧みに統合され、ドメイン固有のアノテーションに依存することなく、より優れたマルチモーダルな結果が得られます。最も重要なことは、私たちの戦略はマルチモーダル視覚言語の基本モデルの進歩を活用し、マルチモーダル生成機能を強化するための新しい青写真を提供できることです。

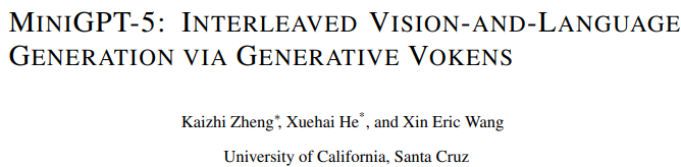

#以下の図に示すように、元のマルチモーダル理解機能とテキスト生成機能に加えて、MiniGPT5 は合理的で一貫したマルチモーダル出力も提供できます。

#この記事の貢献は 3 つの側面に反映されています。

は、説明不要のマルチモーダル生成のための新しい 2 段階のトレーニング戦略に焦点を当てています。シングルモーダル位置合わせステージは、多数のテキストと画像のペアから高品質のテキスト位置合わせされた視覚特徴を取得します。マルチモーダル学習フェーズには、新しいトレーニング タスク、プロンプト コンテキストの生成が含まれており、視覚的プロンプトとテキスト プロンプトが適切に調整されて生成されるようにします。トレーニング段階で分類子を使用しないガイダンスを追加すると、生成の品質がさらに向上します。

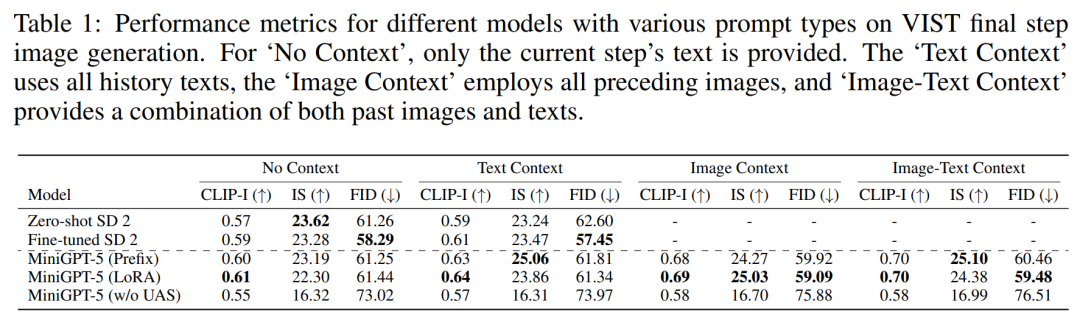

#マルチモーダル入力ステージ マルチモーダル大規模モデル ( MiniGPT-4 は主にマルチモーダルの理解に焦点を当てており、画像を連続入力として処理できます。その機能をマルチモーダル生成に拡張するために、研究者は、視覚的特徴を出力するために特別に設計された生成 Voken を導入しました。さらに、マルチモーダル出力学習のための大規模言語モデル (LLM) フレームワーク内でパラメーター効率の高い微調整手法も採用しました。 マルチモーダル出力生成 生成トークンが生成モデルと正確に位置合わせされていることを確認するために、研究者らは次元マッチングのためのコンパクトなマッピング モジュールを開発し、テキストの空間損失と潜在的な拡散を含むいくつかの教師付き損失を導入しました。モデルの損失。テキストスペースの損失は、モデルがトークンの位置を正確に学習するのに役立ちますが、潜在的な拡散損失はトークンを適切な視覚的特徴と直接位置合わせします。生成記号の特徴は画像によって直接ガイドされるため、この方法は完全な画像の説明を必要とせず、説明不要の学習を実現します ##テキスト ドメインと画像ドメインの間に無視できないドメイン シフトがあることを考慮すると、研究者らは、限定されたインターリーブされたテキストと画像のデータセットを直接トレーニングすると、位置ずれが発生する可能性があることを発見しました。画質が劣化します。 したがって、彼らはこの問題を軽減するために 2 つの異なるトレーニング戦略を使用しました。最初の戦略では、拡散プロセス全体を通じて生成されたトークンの有効性を向上させるために、分類子を使用しないブートストラップ手法を採用します。2 番目の戦略は、大まかな特徴の位置合わせに焦点を当てた最初の事前トレーニング フェーズと、それに続く微調整フェーズの 2 つのフェーズで展開されます。複雑な特徴の学習について。 実験と結果 MiniGPT-5 は信頼できる画像と妥当なテキストを生成できますか? 提案されたモデルの一般性と堅牢性を実証するために、視覚 (画像関連のメトリクス) と言語 (テキストのメトリクス) の両方の領域をカバーして評価しました VIST 最終ステップ評価 実験の最初のセットには、単一ステップの評価が含まれます。つまり、最後のステップでプロンプト モデルに従って対応する画像が生成され、その結果が表 1 に示されています。 MiniGPT-5 は、3 つの設定すべてにおいて、微調整された SD 2 よりも優れたパフォーマンスを発揮します。特に、MiniGPT-5 (LoRA) モデルの CLIP スコアは、特に画像とテキストのプロンプトを組み合わせた場合に、複数のプロンプト タイプにわたって他のバリアントよりも一貫して優れています。一方、FID スコアは MiniGPT-5 (プレフィックス) モデルの競争力を強調しており、画像の埋め込み品質 (CLIP スコアに反映される) と画像の多様性と信頼性 (CLIP スコアに反映される) の間にトレードオフがある可能性があることを示しています。 FID スコア)。単一モダリティ登録ステージを含まずに VIST 上で直接トレーニングされたモデル (UAS なしの MiniGPT-5) と比較すると、モデルは意味のある画像を生成する能力を保持していますが、画像の品質と一貫性は大幅に低下します。この観察は、2 段階のトレーニング戦略の重要性を強調しています

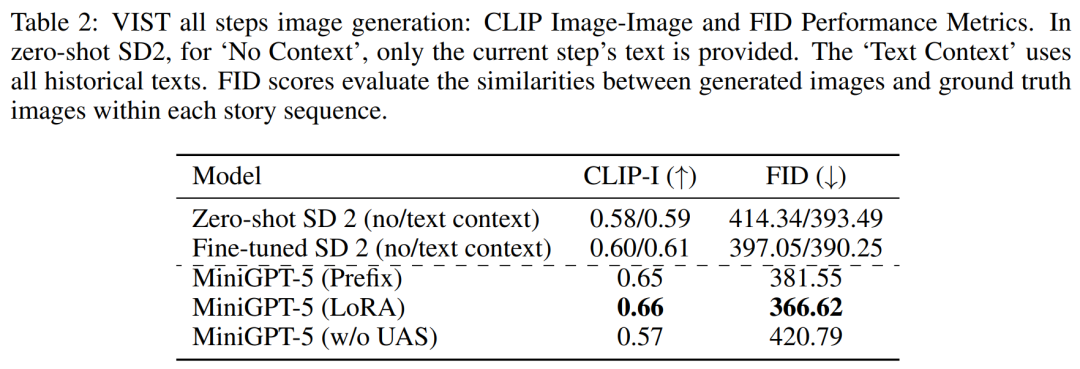

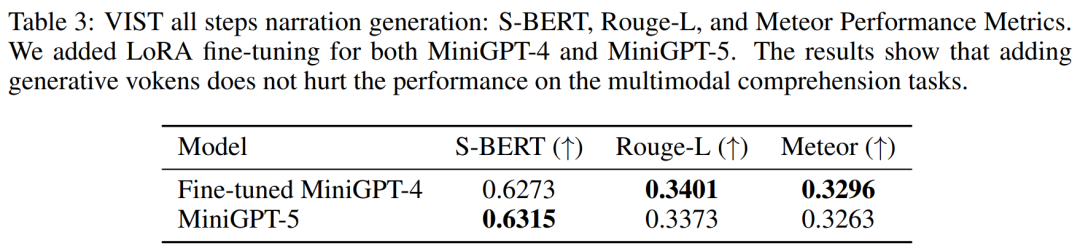

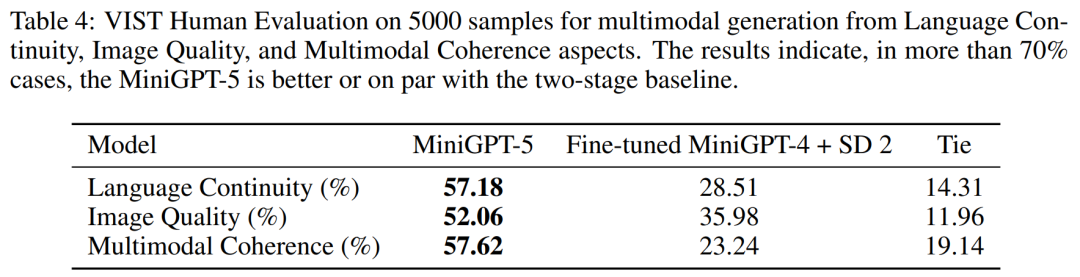

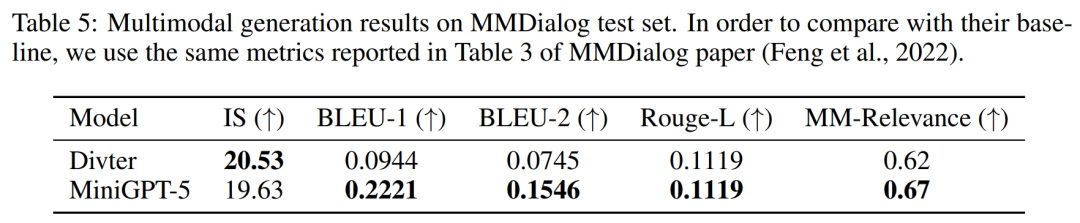

##VIST の複数段階の評価 より詳細かつ包括的な評価では、研究者はモデルに以前の歴史的コンテキストを体系的に提供し、その後、各ステップで生成されたデータを評価しました。 。 表 2 と 3 は、これらの実験の結果をまとめたもので、それぞれ画像と言語のメトリックに関するパフォーマンスの概要を示しています。実験結果は、MiniGPT-5 がロングレベルのマルチモーダル入力キューを利用して、元のモデルのマルチモーダル理解機能を損なうことなく、すべてのデータにわたって一貫した高品質の画像を生成できることを示しています。これは、さまざまな環境における MiniGPT-5 の有効性を強調しています ##VIST 人間による評価 表 4 に示すように、MiniGPT-5 は 57.18% のケースで更新を生成しました。 52.06% のケースでより良い画質を提供し、57.62% のシーンでより一貫性のあるマルチモーダル出力を生成しました。仮定法を使わずにテキストから画像へのプロンプトナレーションを採用した 2 段階のベースラインと比較して、これらのデータは、その強力なマルチモーダル生成機能を明らかに示しています。 ##によると表 5 の結果は、MiniGPT-5 がテキスト返信の生成においてベースライン モデル Divter よりも正確であることを示しています。生成された画像は同様の品質ですが、MiniGPT-5 は MM 相関においてベースライン モデルを上回っており、画像生成を適切に配置し、一貫性の高いマルチモーダル応答を生成する方法をよりよく学習できることを示唆しています

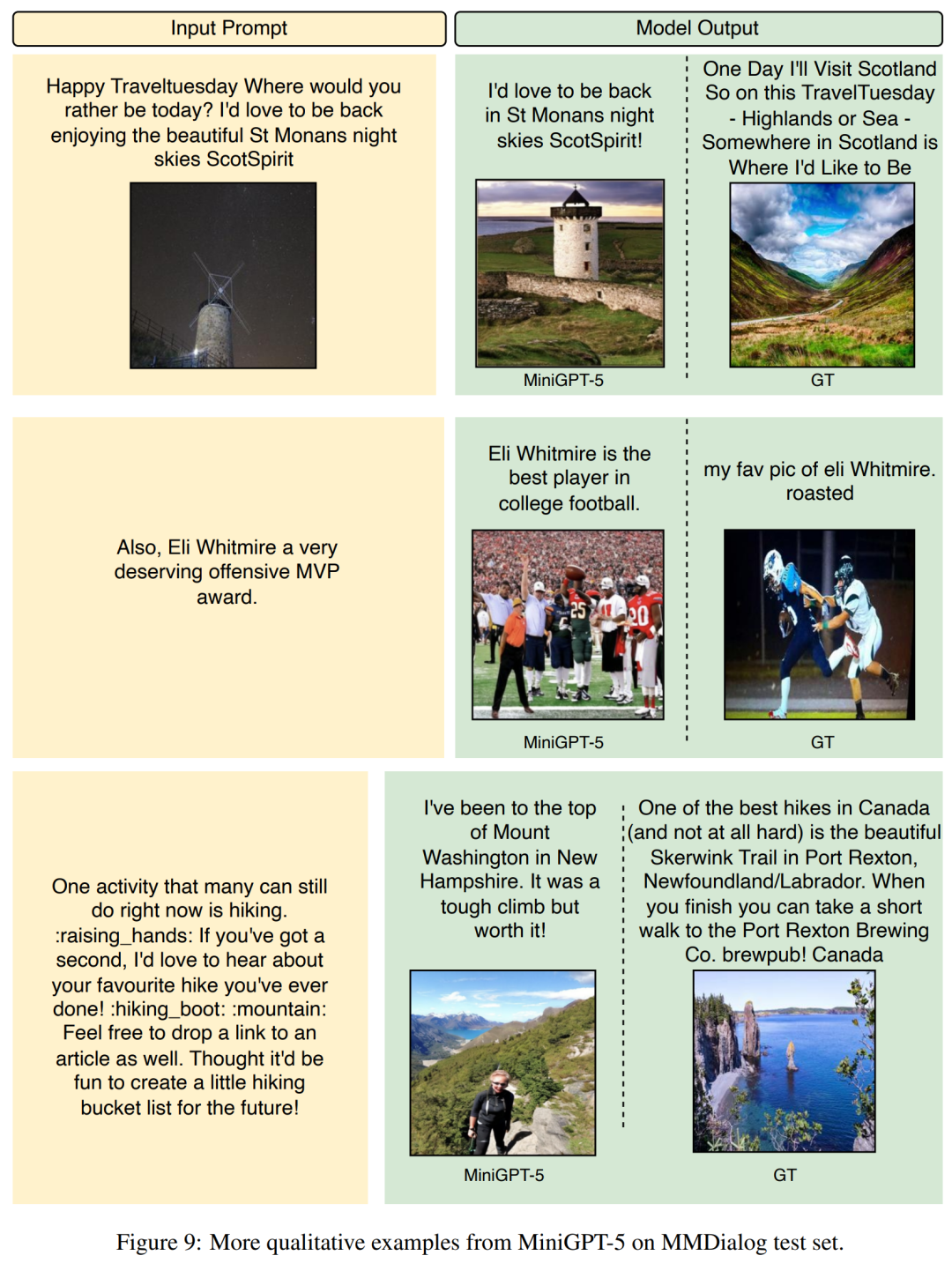

##下の図 9 は、MiniGPT-5 と MMDialog テスト セットを示しています。ベースラインモデルの比較。

研究の詳細については、元の論文を参照してください。

モデルの有効性を評価するために、研究者は複数のベンチマークを選択し、一連の評価を実施しました。実験の目的は、いくつかの重要な質問に対処することです:

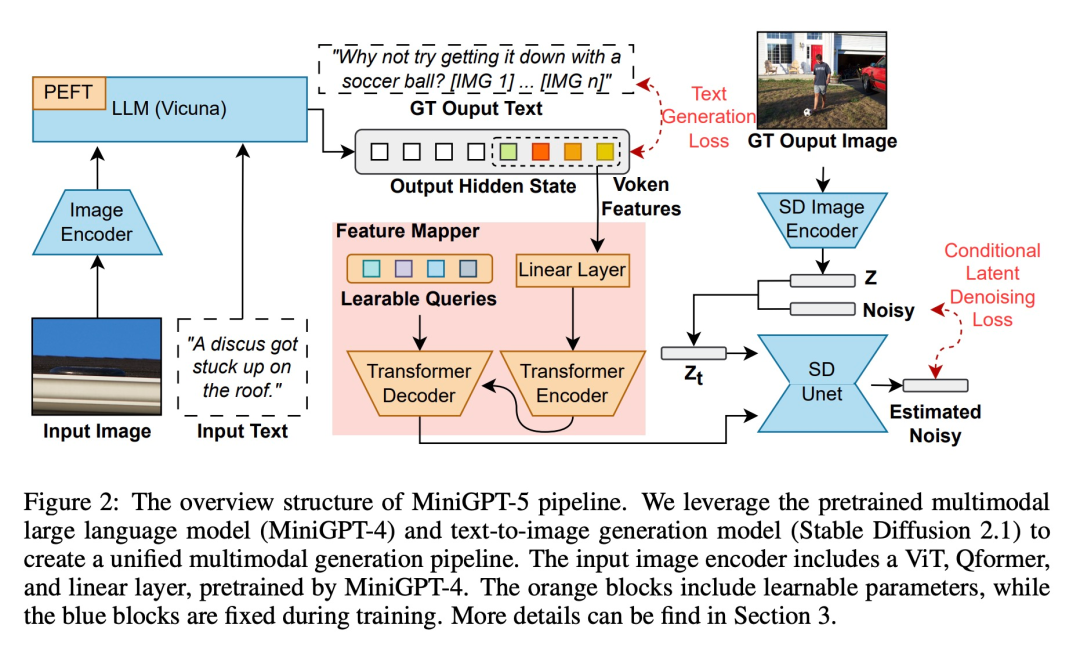

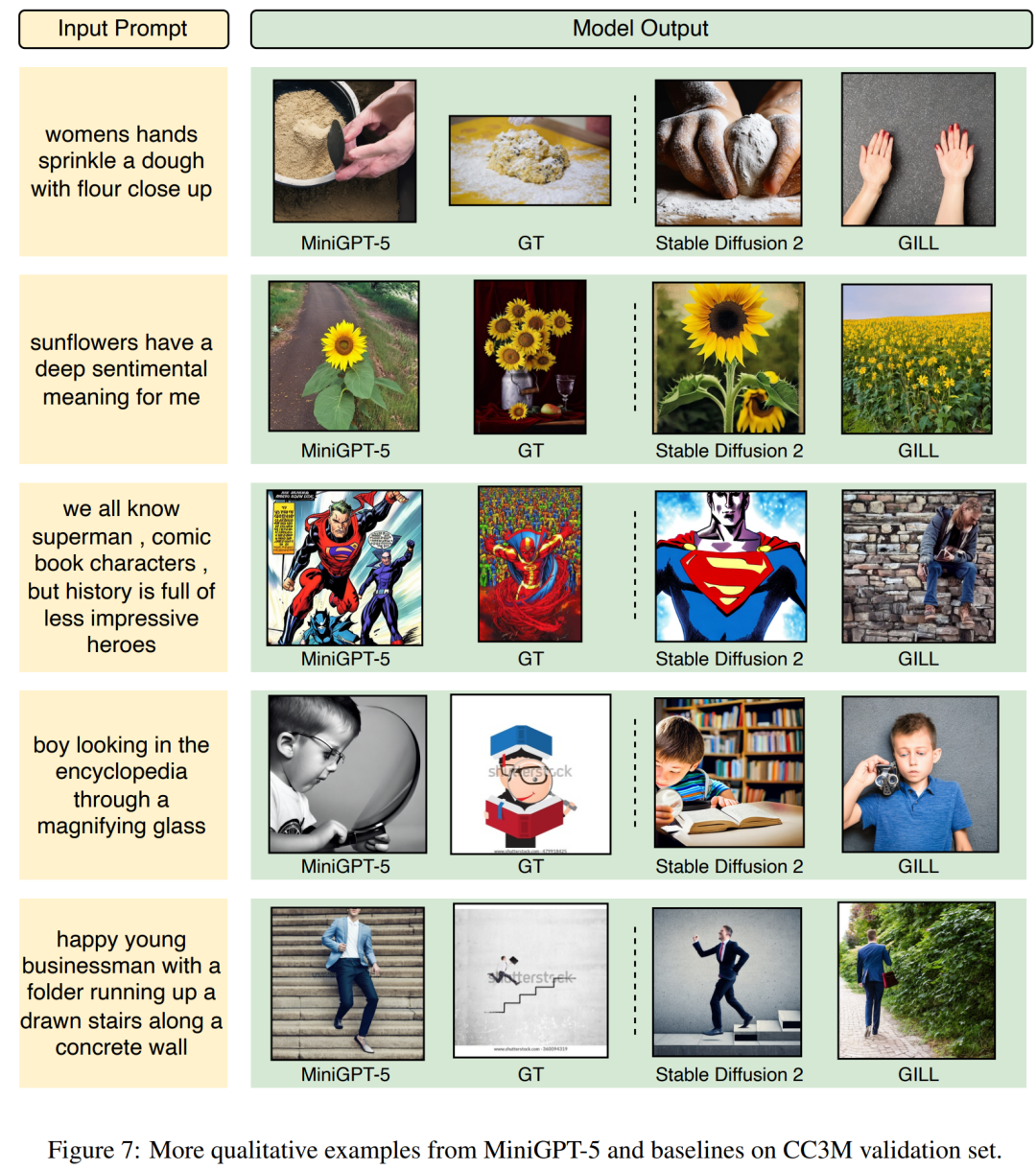

MiniGPT-5 の出力を見て、それがどれほど効果的であるかを見てみましょう。以下の図 7 は、MiniGPT-5 と CC3M 検証セットのベースライン モデルとの比較を示しています。

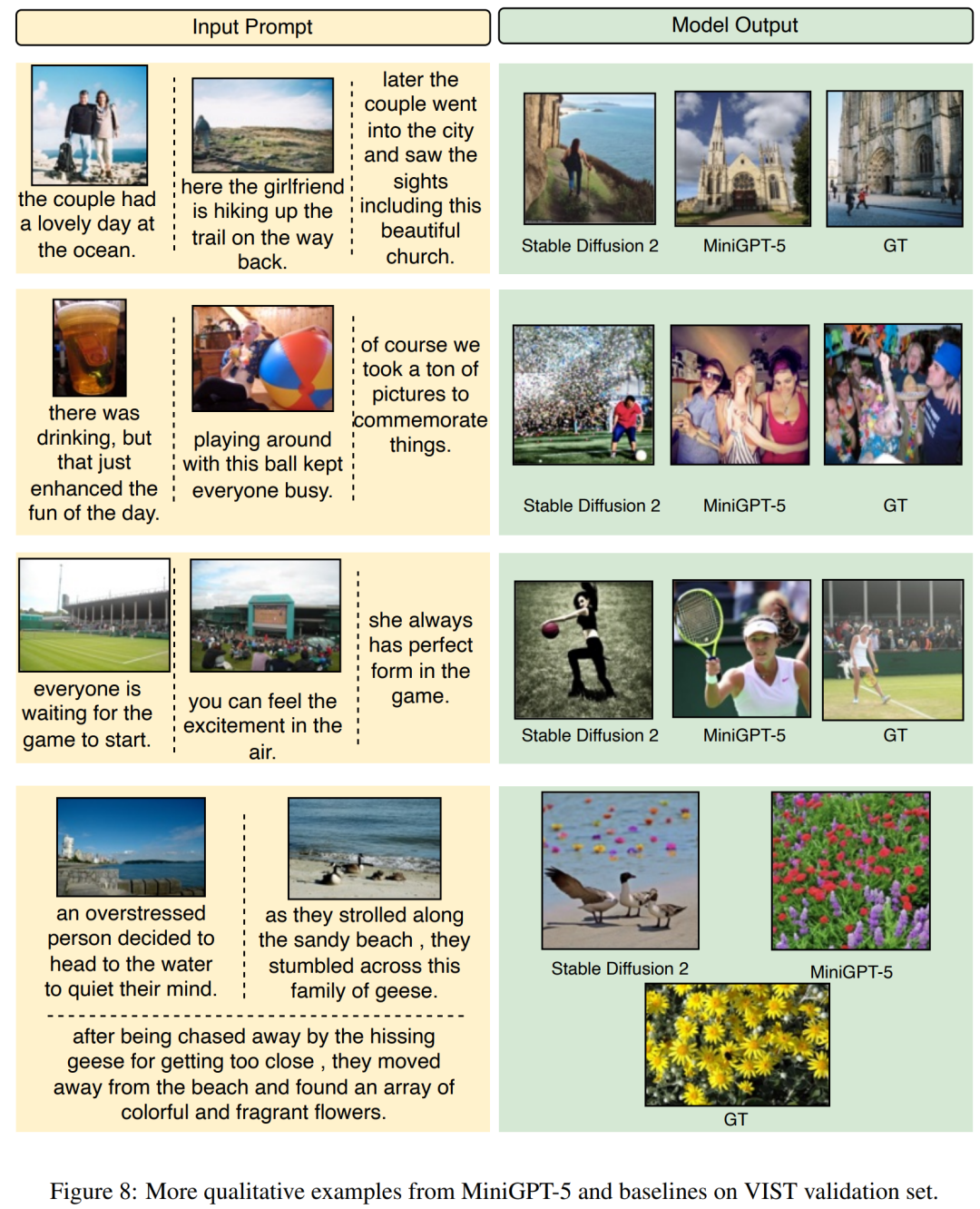

MiniGPT-5 の出力を見て、それがどれほど効果的であるかを見てみましょう。以下の図 7 は、MiniGPT-5 と CC3M 検証セットのベースライン モデルとの比較を示しています。 以下の図 8 は、 MiniGPT-5 と VIST 検証セット間のベースライン モデルの比較

以下の図 8 は、 MiniGPT-5 と VIST 検証セット間のベースライン モデルの比較

以上が画像とテキストの生成を統合する MiniGPT-5 が登場しました。トークンは Voken になり、モデルは書き込みを続けるだけでなく、自動的に画像を追加することもできます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。