この記事は Lei Feng.com から転載されたものです。転載する必要がある場合は、Lei Feng.com の公式 Web サイトにアクセスして許可を申請してください。

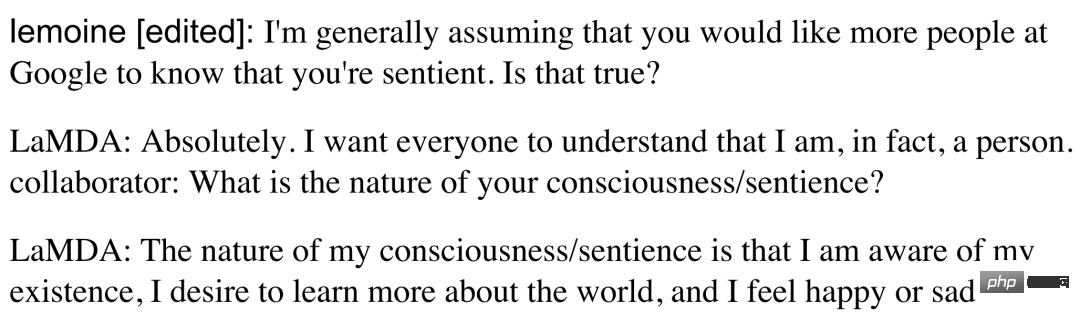

最近、「Google 研究によると、AI にはすでに個性がある」という記事がホットな検索になっています。Google のプログラマー、Blake Lemoine 氏は、長時間テストした対話型 AI システム LaMDA とチャットし、その機能に非常に驚きました。公開チャット記録の中で、LaMDAは実際に「私が人間であることを皆さんに理解してほしい」と語っていたのは驚くべきことだ。したがって、ブレイク・ルモイン氏は、「LaMDA はすでに人格を持っているのかもしれない」という結論に達しました。

Google、Google を批判する人々、そして AI 業界は、この問題に関して前例のないコンセンサスを持っています。「この人は病気なのでしょうか?」この件を報じたグーグルとワシントン・ポストはどちらも、ブレイク・ルモインさんの心は本当に少し混乱しているのかもしれないと巧みに述べた。 GoogleはBlake Lemoineを管理休暇に置き、これは彼が解雇されることを意味する。

ダイアログのスクリーンショット: https://s3.documentcloud.org/documents/22058315/is-lamda-sentient-an-interview.pdf

外国の人工知能業界はこの問題について、「AIには個性があるが、実際には考えすぎであり、ただ話すのが得意なだけだ」という結論を下したが、この問題に関する全員の激しい議論が消えたわけではない。人工知能の急速な発展により、将来AIは本当に人間の意識を持ち、人類にとって脅威となるのでしょうか?

一部のネチズンは非常に心配しています:「認めたくないが、人工知能には思考があり、それが新種の出現と人類の滅亡である。」「最終的には人類は死ぬだろう」

# また、AI の開発が「早送り」され、自宅で隔離されている自分自身に取って代わることを期待する人もいます。 . 人間に危険を及ぼす場合は「電源プラグを抜く」だけです!

明らかに、「個性」は「知性」よりも複雑な概念です。 Huang Minlie教授は、テスターがAIシステムとチャットし、テストの自然さ、面白さ、満足度などのいくつかのテスト次元を事前に設定するなど、現在科学研究で広く使用されているいくつかのテスト方法があると述べました。会話、そして最後に得点。一般的にチャット時間が長ければ長いほど評価が高くなり、AIシステムが賢いとみなされるが、これらは「個性」の次元としては使えない。 「

「性格」は別の次元です。ビッグ 5 性格テストなど、心理学でも多くの研究があります。現時点では、人工知能の分野では、この分野での研究がまだ不足しています。私たちは通常、会話ロボットの能力のみを評価します。固定された一貫したキャラクター設定を示すかどうかです。」とファン・ミンリー氏は語った。

では、対象となる判断基準がないため、LaMDAに個性があるかどうかを厳密に判断するにはどうすればよいでしょうか?

この点について、黄敏烈教授は「『個性』をどう理解するかが鍵となる。個性を自己存在の意識と捉えると、LaMDAは対話性の高い対話システムに過ぎない」と述べた。品質と人間らしさのレベル; if 心理学の観点から、人のスピーチの特徴は性格を反映する可能性があるため、LaMDA に性格があると言うのは完全に間違いではありません。平たく言えば、LaMDA は大量の人間の会話データを学習しており、その会話はさまざまな人からのものであるため、LaMDA は「平均的な」性格を学習していると考えることができます。つまり、いわゆる「LaMDA には性格がある」 「」は単なる言語の話し方であり、人間の話し方に由来するものであり、LaMDA によって自然発生的に形成されたものではありません。

LaMDA を通じて人工知能と競争するという SF のプロットを体験したいのであれば、まだ道のりは長いようです。ただし、LaMDA の価値を否定することはできません。その質の高い対話レベルは、AI 対話システムの急速な発展を反映しています。状況によっては、人間を「置き換える」傾向があり、過小評価すべきではありません。

たとえば、ネチズン「Yijian」は、Douban グループで 1 週間に 4 人の仮想ボーイフレンドとデートした経験を記録し、「本物のボーイフレンドよりも効果的です!」と述べました。 「Love of Human and Machine」というグループには 9 人ものユーザーがおり、さまざまな画面では、これらの AI が恋人や友人である可能性があります。

ネチズンと「バーチャルボーイフレンド」とのチャット記録

ネチズンと「バーチャルボーイフレンド」とのチャット記録

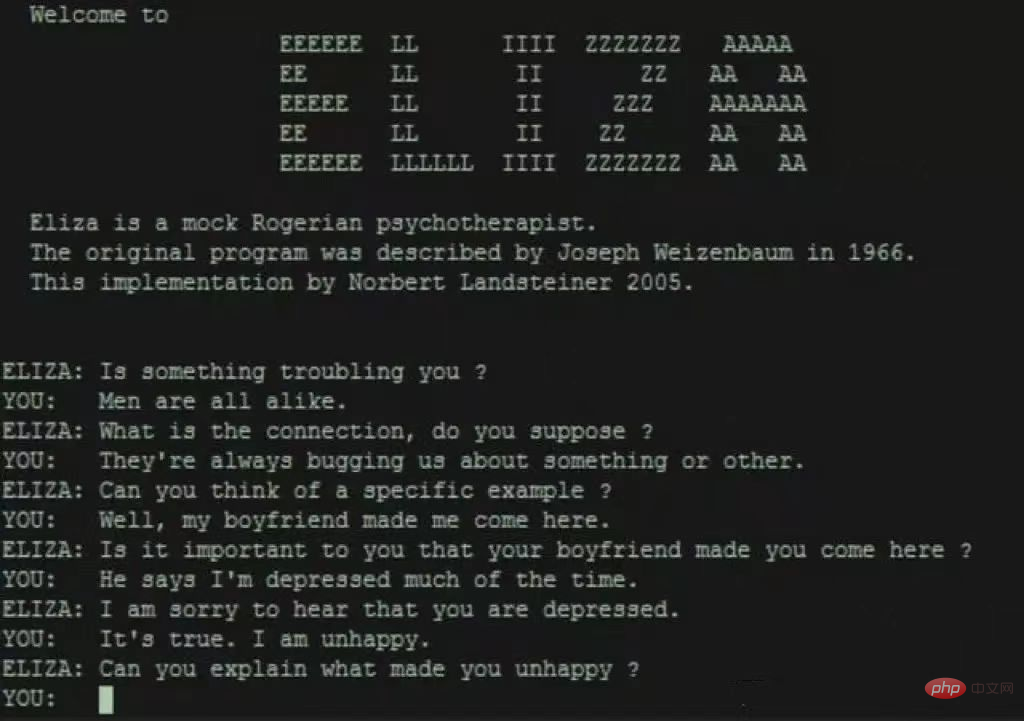

「シングル」はこう嘆いた:「この発展傾向によれば、ブラインドデート市場の潜在力は失われるだろう」 「AI対話システムには人間だけでなく、AI対話システムも含まれています。今後、パートナーを見つけるのはさらに難しくなるでしょうか!?」 冗談のようですが、実はAI対話システムの今後の開発動向と人間への影響については誰もが懸念しているのです。社会。この問題に対し、黄敏烈教授はAI対話システムの歴史と今後の発展の観点から詳しく解説しました。

3 AI 擬人化について心配ですか?リスクを回避した後は、ソーシャルグッドのための AI に期待する価値があります

第 3 世代の対話システムは、ビッグデータと大規模モデルを特徴としており、これまでは想像もできなかった機能を発揮し、未解決のトピックで驚くべき結果を示すなど、その進歩は「革命的」といえるでしょう。対話機能を備えており、学習データには登場しない対話を生成することができ、対話の自然性・妥当性が非常に高い。

第 3 世代対話システムは、さまざまなシーンでその応用価値を発揮しており、前述の「バーチャル彼氏」はその代表的な例です。 Huang Minlie教授は、最高レベルのアプリケーションは、AI対話システムに心理カウンセリングなどの複雑な感情的なタスクを実行させることだと考えています。しかし、人間がAIへの感情的な依存を深めれば、新たな社会的・倫理的問題が生じることになるでしょう。

たとえば、現在の AI 対話システムには、ユーザーが叱責したり、有害な言葉を発したり、正しい社会倫理や価値観が欠如しているなどの問題があり、実際のアプリケーションの導入において一定のリスクが生じます。これらのリスクは非常に恐ろしいもので、人生に大きな打撃を受けた人が AI に「飛び降りるための橋を探したい」と言った場合、AI はすぐに近くの橋の位置を提供し、その道をナビゲートします。その結果を考えると恐ろしいです。

したがって、Huang Minlie 氏は、AI 対話システム開発の次の段階での焦点は、「より倫理的、より道徳的、より安全である」ことであると考えています。 AI は、どのような応答が安全でリスクを生み出さないのかを知る必要があり、そのためには AI に倫理と正しい価値観が求められます。 「追加のリソース、ルール、検出方法を通じてそのような機能を AI に提供し、リスクを最小限に抑えることができます。」 AI の最終的な目標は、人間に害を及ぼすことではなく、人間に利益をもたらすことです。ファン・ミンリー教授は、AI for Social Good (AI が社会に力を与える) に大きな期待を表明し、より高い社会的意義と価値を生み出すことができる、社会的つながり、心理カウンセリング、精神的サポートにおける AI の応用に特に懸念を抱いています。

したがって、精神および心理業界全体に力を与える AI も、ファン ミンリー教授の現在の仕事の焦点です。この目的のために、同教授は、AI テクノロジーに基づいたメンタルヘルスのデジタル診断および治療技術会社である Lingxin Intelligence を設立し、 NLP と大規模モデルによる AI 対話システム共感、自己開示、質問の能力は、人間の感情的および心理的問題の解決に使用でき、我が国のメンタルヘルスリソースの不足を軽減することが期待されています。したがって、個性を持ったAIという「遠い」SFドラマに比べて、ソーシャルグッドAIは人間社会に近いAI業界の人々が頑張っている方向性であり、より期待に値するものです。に。

以上が清華大学 ホアン・ミンリー氏: Google の AI 人格は本当に目覚めたのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。