テキストから画像への変換に半年以上を費やした後、Meta や Google などのテクノロジー大手は、テキストからビデオへの新たな戦場に照準を合わせました。

先週、Meta は高品質のショート ビデオを生成できるツール Make-A-Video を発表しました。このツールを使用して生成されたビデオは非常に想像力豊かです。

もちろん、Google も負けてはいません。ちょうど今、同社の CEO である Sundar Pichai 氏が、この分野における最新の成果、つまり 2 つのテキスト動画変換ツール、Imagen Video と Phenaki を個人的に発表しました。前者は動画の品質を重視し、後者は動画の長さを主に重視しており、それぞれにメリットがあると言えます。

#下の皿を洗うテディベアは、Imagen Video を使用して生成されました。画像の解像度と一貫性が確実であることがわかります。

最近のテキストから画像への AI システムにおける生成モデリングDALL-E 2、Imagen、Parti、CogView、Latent Diffusion では大きな進歩が見られました。特に、拡散モデルは、密度推定、テキスト読み上げ、画像から画像、テキストから画像、3D 合成などのさまざまな生成モデリング タスクで大きな成功を収めています。

Google がやりたいことは、テキストから動画を生成することです。ビデオ生成に関するこれまでの研究は、自己回帰モデルを使用した制限されたデータセット、自己回帰事前分布を使用した潜在変数モデル、そして最近では非自己回帰潜在変数手法に焦点を当ててきました。普及モデルは、優れた中解像度ビデオ生成機能も実証しています。

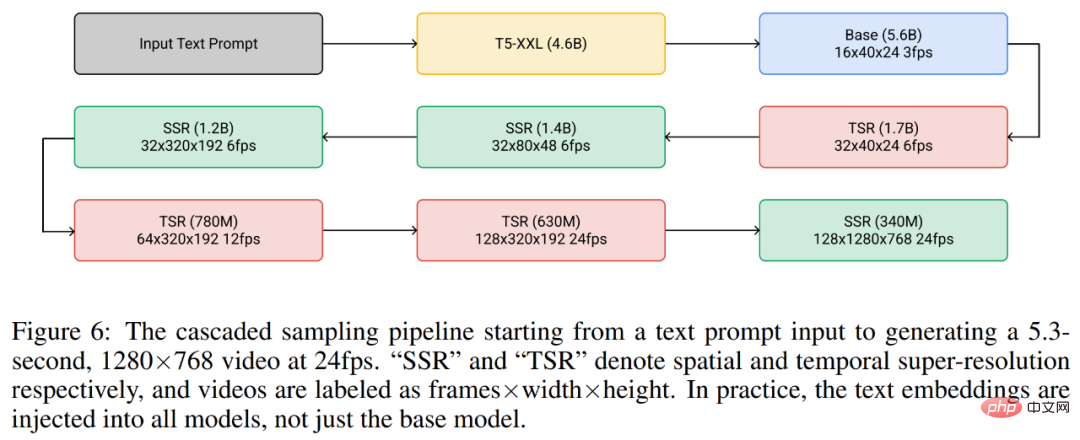

これに基づいて、Google は、カスケード ビデオ拡散モデルに基づくテキスト条件付きビデオ生成システムである Imagen Video を立ち上げました。テキスト プロンプトが与えられると、Imagen Video は、フリーズされた T5 テキスト エンコーダー、基本的なビデオ生成モデル、およびカスケード時空間ビデオ超解像度モデルで構成されるシステムを通じて高解像度ビデオを生成できます。

#論文アドレス: https://imagen.research.google/video/paper.pdf

Google は論文の中で、特定の解像度での完全畳み込み時空間超解像度モデルの選択や v パラメーターの選択など、システムを高解像度のテキストからビデオへのモデルに拡張する方法を詳細に説明しています。拡散モデル化やその他の設計上の決定。 Google はまた、以前の拡散ベースの画像生成研究結果をビデオ生成設定に移行することに成功しました。

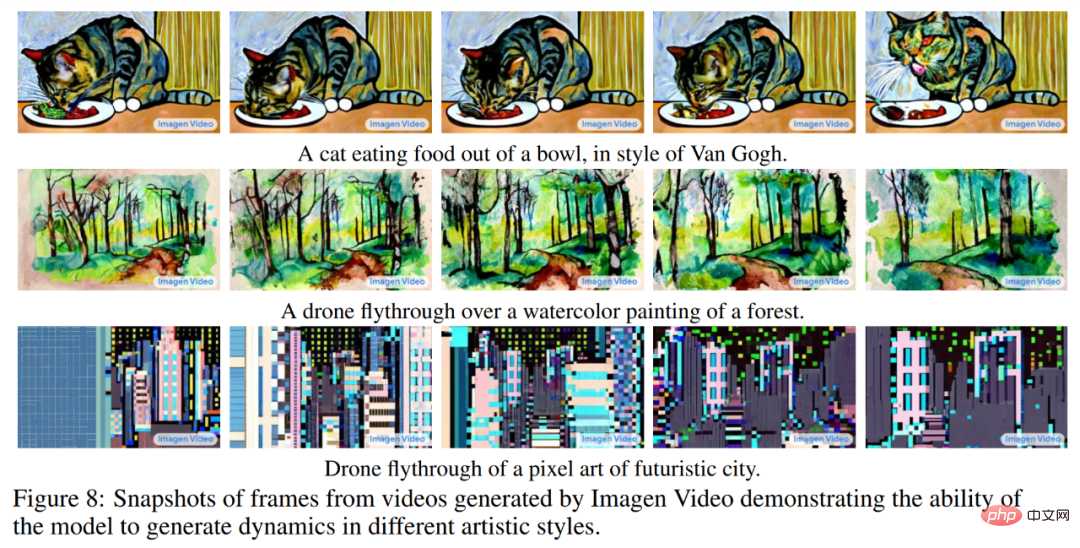

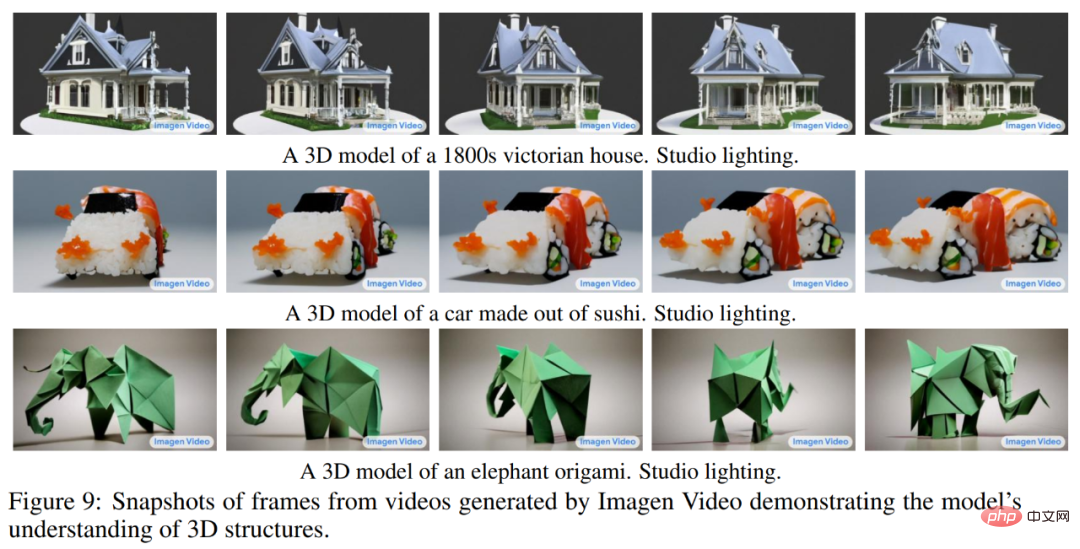

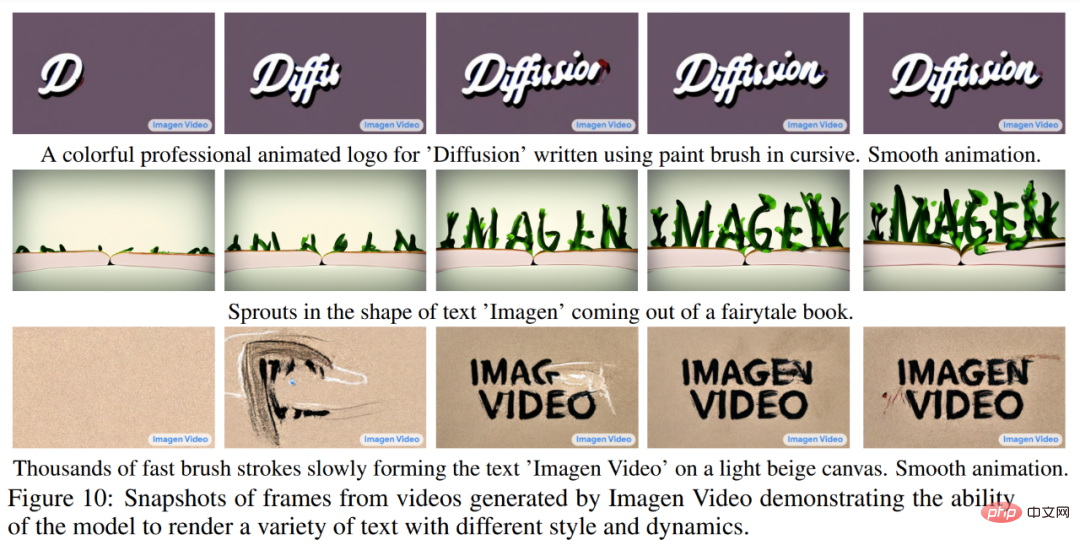

Google は、Imagen Video が以前の作業で生成された 24fps 64 フレーム 128×128 ビデオを 128 フレーム 1280×768 HD ビデオにアップスケールできることを発見しました。さらに、Imagen Video は高度な制御性と世界知識を備え、多様な芸術スタイルでビデオとテキスト アニメーションを生成でき、3D オブジェクトを理解する機能を備えています。

Imagen Video によって生成されたパンダの運転などのビデオをさらにお楽しみください:

游宇宙の木造船:

生成されたビデオの詳細については、こちらをご覧ください: https://imagen.research.google/video/

方法と実験

全体的に、Google のビデオ生成フレームワークは 7 つのサブビデオ拡散モデルのカスケードであり、テキスト条件付きビデオ生成、空間的超解像度、および時間的超解像度をそれに応じて実行します。 Imagen Video はカスケード全体を使用して、1280×768 HD ビデオ (約 1 億 2,600 万ピクセル) の 128 フレームを 24 フレーム/秒で生成できます。

一方、Imagen Video はプログレッシブ蒸留の助けを借りて、各サブモデルでわずか 8 つの拡散ステップを使用して高品質のビデオを生成します。これにより、ビデオの生成時間が約 18 倍高速化されます。

以下の図 6 は、フリーズ テキスト エンコーダー、基本的なビデオ拡散モデル、3 つの空間超解像度 (SSR) と 3 つの時間超解像度を含む、Imagen Video のカスケード パイプライン全体を示しています。 (TSR)モデル。 7 つのビデオ拡散モデルには合計 116 億個のパラメータがあります。

生成プロセス中、SSR モデルはすべての入力フレームの空間解像度を向上させますが、TSR モデルは入力フレーム間の中間フレームを埋めることで時間解像度を向上させます。 SSR モデルに顕著なアーティファクトが発生しないように、すべてのモデルはフレームの完全なブロックを同時に生成します。

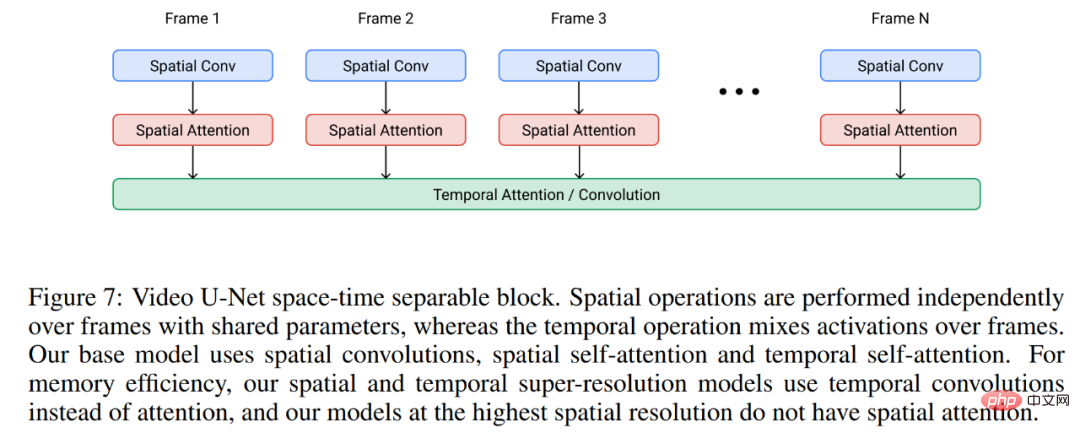

#Imagen Video は、以下の図 7 に示すように、ビデオ U-Net アーキテクチャに基づいて構築されています。

実験では、Imagen Video は公開されている LAION-400M 画像とテキストのデータセット、1,400 万のビデオとテキストのペア、および 6,000 万の画像を使用しました。テキストペアについて。その結果、前述したように、Imagen Video は高解像度ビデオを生成できるだけでなく、純粋にデータから学習する非構造化生成モデルにはないいくつかの独自の機能も備えています。

以下の図 8 は、ゴッホの絵画や水彩画のスタイルのビデオなど、画像情報から学習した芸術的なスタイルのビデオを生成する Imagen Video の機能を示しています。

フェナキ: あなたがストーリーを語ってください、そして私がそれを描きます

ビデオは本質的に一連の画像ですが、一貫した長いビデオを生成することは不可能であることを私たちは知っています。このタスクに使用できる高品質のデータはほとんどなく、タスク自体も計算量が多いため、簡単です。さらに問題なのは、画像生成に使用されるような短いテキストのプロンプトでは、通常、ビデオの完全な説明を提供するには十分ではないことです。ビデオに必要なのは、一連のプロンプトまたは物語。理想的には、ビデオ生成モデルは、任意の長さのビデオを生成でき、特定の時間 t でのプロンプトの変化に従って生成されたビデオ フレームを調整できなければなりません。この機能があって初めて、モデルによって生成された作品を「動画」ではなく「ビデオ」と呼ぶことができ、アート、デザイン、コンテンツ作成における現実の創造的なアプリケーションへの道が開かれます。

Google やその他の機関の研究者らは、「私たちの知る限り、ストーリーベースの条件付きビデオ生成はこれまで研究されたことがなく、これがこの目標に向けて前進する最初の論文です。初期の論文」と述べています。 ."

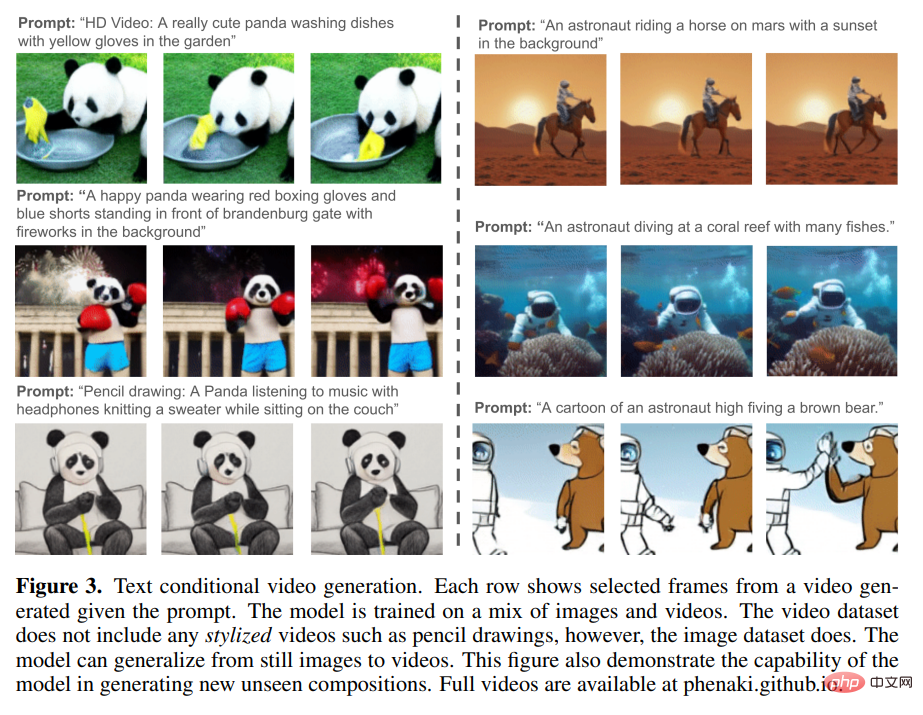

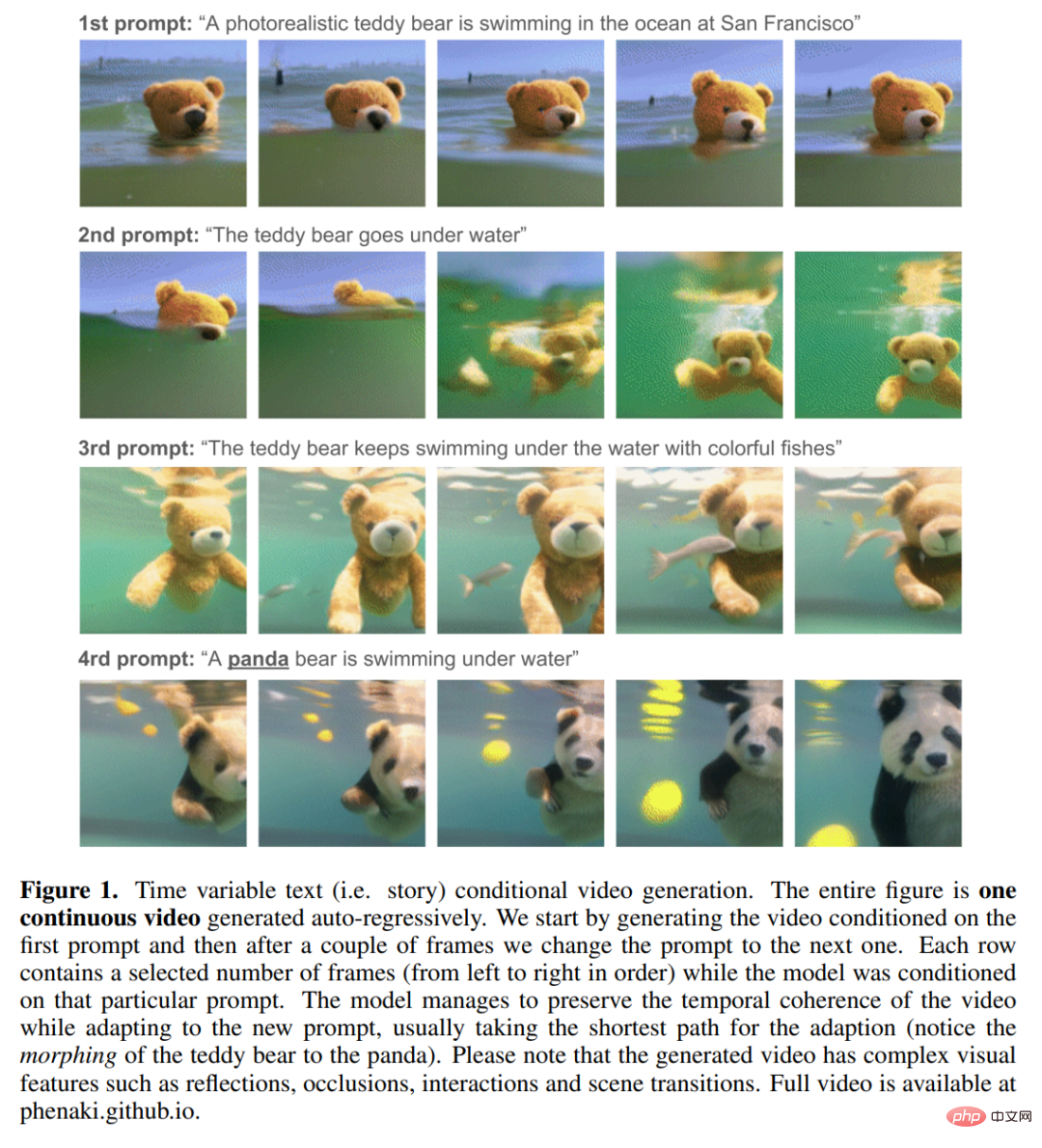

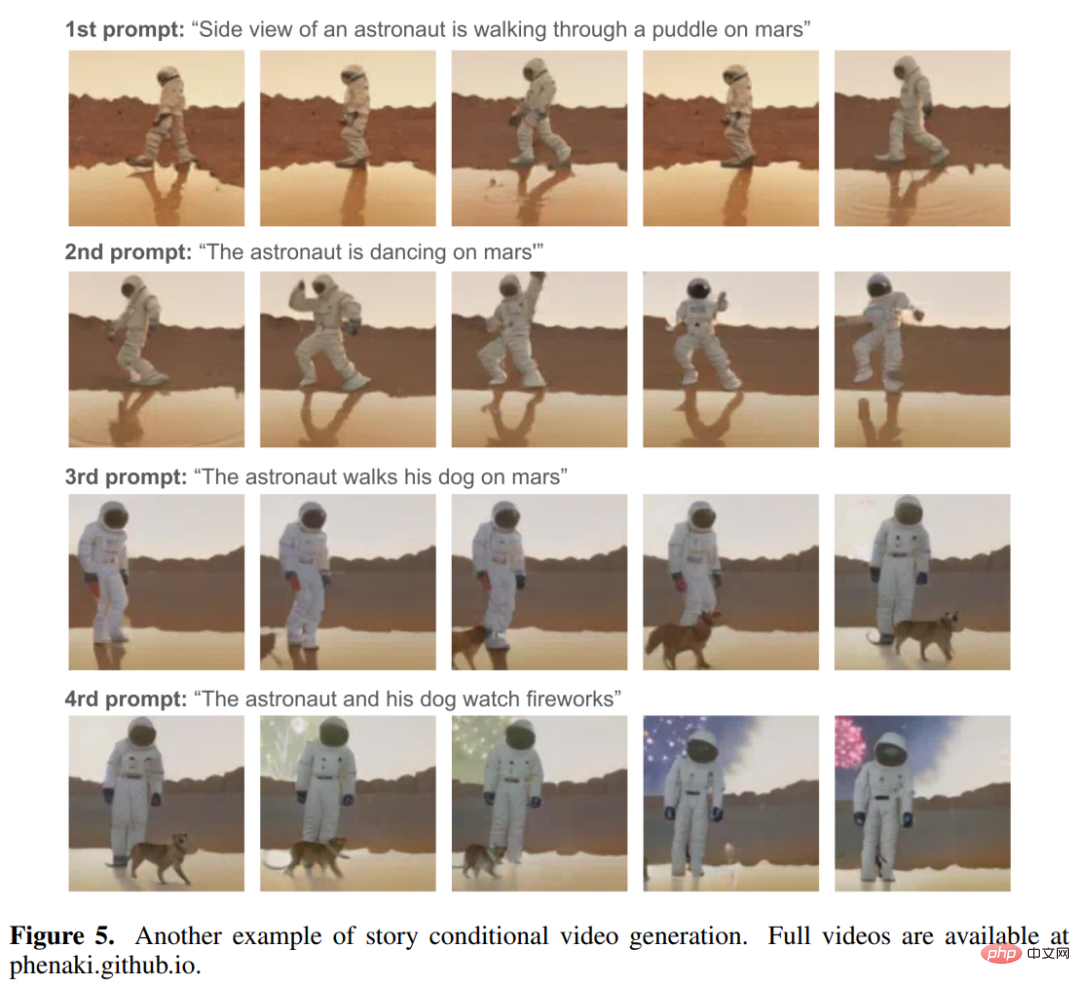

利用可能なストーリーベースのデータセットがないため学習において、研究者が従来の深層学習手法 (単にデータから学習するだけ) に依存するだけでは、これらのタスクを達成する方法はありません。したがって、彼らはこのタスク専用のモデルを設計しました。 この新しいテキストからビデオへのモデルは Phenaki と呼ばれ、「テキストからビデオへ」データと「テキストから画像へ」データを使用して共同トレーニングします。このモデルには次の機能があります: 1. プロンプトが新しい概念の組み合わせであっても、オープン ドメイン プロンプトの条件下で、時間的に一貫した多様なビデオを生成します (下の図 3 を参照)。 。モデルのトレーニングに使用されるビデオはわずか 1.4 秒 (8 フレーム/秒) ですが、生成されるビデオの長さは数分になる場合があります。 #2以下の図 1 と図 5 に示すように、ストーリー (つまり、一連のプロンプト) によってビデオが生成されます。 これらの機能を実現するには、研究者は、固定サイズのビデオのみをデコードするか、フレームを個別にエンコードする既存のビデオ エンコーダに依存することはできません。この問題を解決するために、彼らは新しいエンコーダ/デコーダ アーキテクチャである C-ViViT を導入しました。 C-ViViT は次のことができます: ビデオの時間的冗長性を使用して、各フレームのモデルの再構成品質を向上させます。 , while ビデオ トークンの数を 40% 以上圧縮します; 因果構造が与えられた場合、可変長ビデオのエンコードとデコードが可能になります。

ビデオの圧縮表現を取得することは、テキストからビデオを生成する際の主な課題の 1 つです。以前の研究では、VQ-GAN などのフレームごとの画像エンコーダ、または VideoVQVAE などの固定長ビデオ エンコーダを使用していました。前者では任意の長さのビデオを生成できますが、実際の使用では、エンコーダーがビデオを時間内に圧縮できず、連続フレーム内のトークンが非常に冗長であるため、ビデオは短くなければなりません。後者の方がトークンの数の点ではより効率的ですが、任意の長さのビデオを生成することはできません。 Phenaki では、研究者の目標は、現在のコンピューティング リソースの制約内で Transformer モデルを使用できるように、ビデオ トークンの数を可能な限り圧縮しながら可変長ビデオを生成することです。この目的を達成するために、彼らは、ビデオ生成のためのアーキテクチャ変更を追加した ViViT の因果的バリアントである C-ViViT を導入しました。これは、時間的自己回帰を維持しながら、時間的次元と空間的次元の両方でビデオを圧縮できます。この機能により、任意の長さの自己回帰ビデオを生成できます。 テキスト埋め込みを取得するために、Phenaki は事前トレーニングされた言語モデル T5X も使用します。 具体的な詳細については、元の論文を参照してください。

自己回帰テキストから画像への変換およびテキスト変換に関する以前の研究からインスピレーションを受けています。 to-video 、Phenaki の設計は主に 2 つの部分で構成されています (以下の図 2 を参照)。ビデオを個別の埋め込み (つまり、トークン) に圧縮するエンコーダー/デコーダー モデルと、テキストの埋め込みをビデオ トークンに変換するトランスフォーマー モデルです。

以上が画像生成に飽きた Google は、解像度と長さに同時に挑戦する 2 つの強力なツールであるテキスト→ビデオ生成に目を向けました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。