実際、正則化の本質は非常に単純で、特定の目的を達成するために、特定の問題にアプリオリな制限や制約を課す手段や操作です。アルゴリズムで正則化を使用する目的は、モデルの過剰適合を防ぐことです。正則化というと、多くの学生はよく使われる L1 ノルムと L2 ノルムをすぐに思い浮かべるかもしれませんが、要約する前に、まず LP ノルムとは何かを見てみましょう。

ノルムは、単純にベクトル空間の距離を表すものとして理解できますが、距離の定義は非常に抽象的です。 -否定的、再帰的、三角不等式、それは距離です。

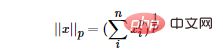

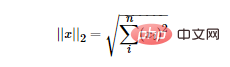

LP ノルムはノルムではなく、次のように定義される一連のノルムです:

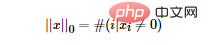

L0 ノルムを最小化することで、最も最適でないスパース特徴を見つけることができます。しかし残念なことに、L0 ノルムの最適化問題は NP 困難問題です (L0 ノルムも非凸です)。したがって、実際のアプリケーションでは、L0 の凸緩和を実行することがよくあります。L1 ノルムが L0 ノルムの最適な凸近似であることが理論的に証明されているため、通常は L0 ノルムを直接最適化する代わりに L1 ノルムが使用されます。

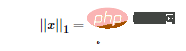

L1 ノルム LP ノルムの定義に従って、L1 ノルムの数学的形式を簡単に取得できます。

LP ノルムの定義に従って、L1 ノルムの数学的形式を簡単に取得できます。

機能選択

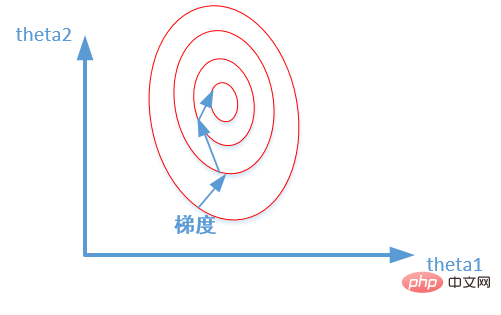

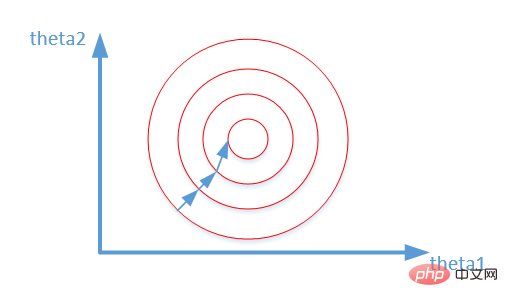

次の図に示すように、L1 ノルムと L2 ノルムの違いを示す PRML の古典的な図を紹介します。

次の図に示すように、L1 ノルムと L2 ノルムの違いを示す PRML の古典的な図を紹介します。

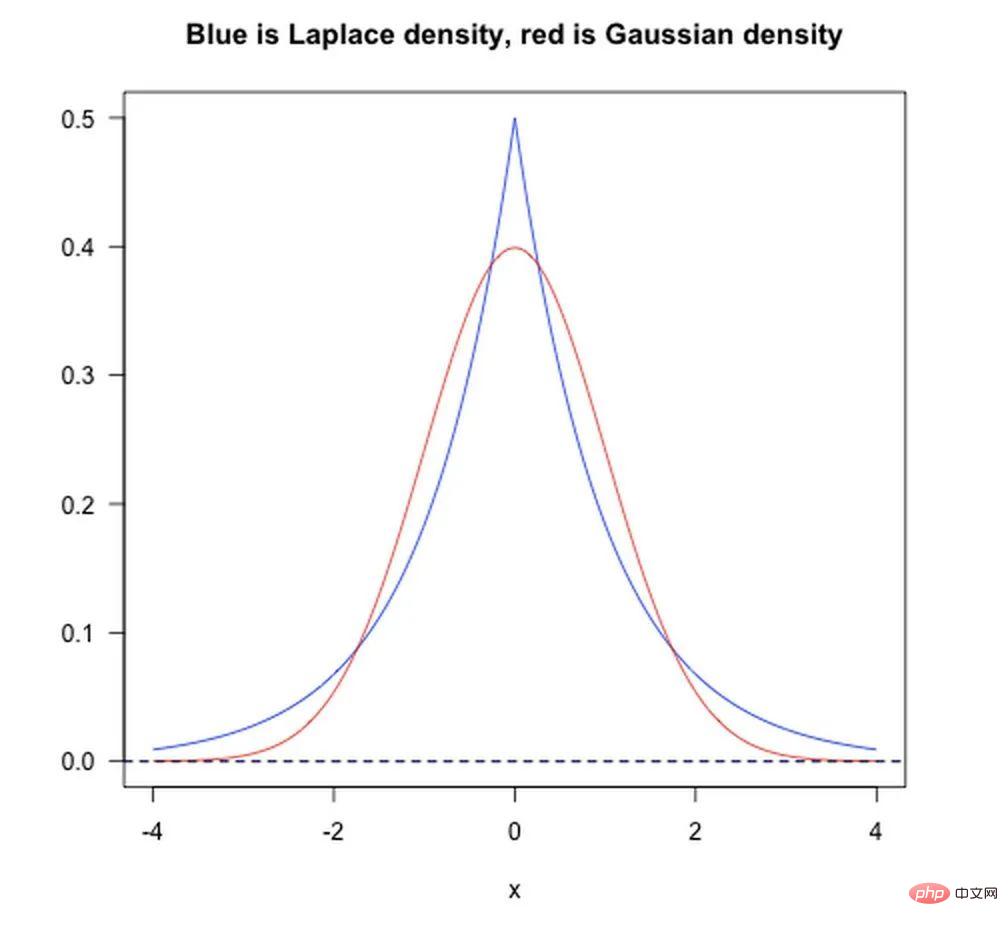

ベイズ事前の観点から見ると、モデルをトレーニングするとき、現在のトレーニング データセットのみに依存するだけでは十分ではありません。より優れた汎化機能を達成するには、多くの場合、事前項と正規項を追加する必要があります。先験的に追加することに相当します。

以下の図に示すように:

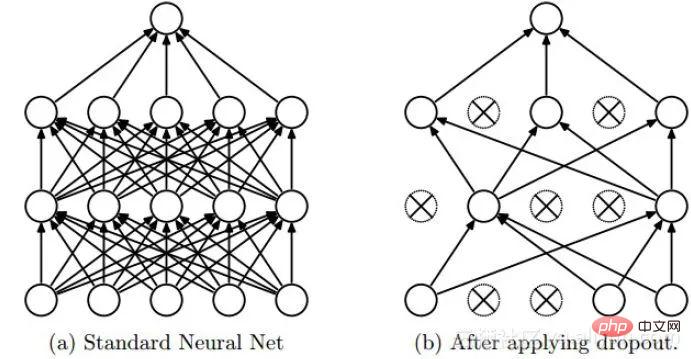

Dropout は深層学習でよく使用される正則化手法です。そのアプローチは、DNN のトレーニング プロセス中に確率 p で一部のニューロンを破棄する、つまり、破棄されたニューロンの出力が 0 であると単純に理解できます。 Dropout は、次の図に示すようにインスタンス化できます。

注: 以下の内容は、Wei Xiushen 博士の Zhihu 回答から引用されています。統計的機械学習における古典的な前提が「ソース空間 (ソース ドメイン) とターゲット空間 (ターゲット ドメイン) のデータ分布」であることは誰もが知っています。 「(配信は)一貫している」。それらが矛盾している場合、転移学習/ドメイン適応などの新しい機械学習の問題が発生します。共変量シフトは不一致分布を仮定した分岐問題であり、ソース空間とターゲット空間の条件付き確率は一致しているが、その周辺確率が異なることを意味します。よくよく考えてみると、確かにニューラルネットワークの各層の出力は、層内演算を経ているため、その分布が各層に対応する入力信号の分布とは明らかに異なっていることが分かります。ネットワークの深さが増すにつれて差は大きくなりますが、「示す」ことができるサンプル ラベルは変化せず、共変量シフトの定義を満たします。

BN の基本的な考え方は、実際には非常に直観的です。なぜなら、非線形変換前のニューラル ネットワークの活性化入力値 (X=WU B、U は入力) は、ネットワークの深さが深くなるにつれて、その値が大きくなるからです。分布は徐々にシフトまたは変化します (つまり、上記の共変量シフト)。トレーニングの収束が遅い理由は、一般に、全体の分布が非線形関数の値の範囲の上限と下限に徐々に近づくためです (シグモイド関数の場合、活性化入力値 X=WU B が大きな負または正であることを意味します)。 value) であるため、これによりバックプロパゲーション中に低レベル ニューラル ネットワークの勾配が消失します。これが、トレーニングにおけるディープ ニューラル ネットワークの収束がますます遅くなる根本的な理由です。 BN は、特定の標準化手法を使用して、ニューラル ネットワークの各層のニューロンの入力値の分布を、平均 0、分散 1 の標準正規分布に強制的に戻します。これにより、勾配分散の問題が発生します。アクティベーション機能。したがって、BN の役割は共変量シフトを軽減することであると言うよりも、BN が勾配分散問題を軽減できると言う方が適切です。

正規化、標準化、正則化

正規化については以前に説明しましたが、ここでは正規化と標準化について簡単に説明します。正規化: 正規化の目的は、元のデータを [a, b] 間隔にマッピングするための特定のマッピング関係を見つけることです。一般に、a と b は [−1,1]、[0,1] の組み合わせになります。通常、次の 2 つのアプリケーション シナリオがあります。

数値を (0, 1) の間の小数に変換します。次元数値を無次元数値に変換します。これは次のように簡単に説明できます。正規化されたスケーリングは間隔 (極値によってのみ決定される) に対して「平坦化」されますが、標準化されたスケーリングはより「弾力的」です。 「」および「動的」であり、サンプル全体の分布に大きく関係します。注:

以上が機械学習の要点: 過学習を防ぐには?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。