ノイズ除去拡散モデルは、反復的なノイズ除去プロセスを通じてトレーニング分布から画像を生成する生成ニューラル ネットワークの新しいクラスです。このタイプの拡散モデルは高品質のサンプルを生成し、GAN や VAE などの以前の方法よりも拡張および制御が容易です。その結果、急速な開発を経て、すでに高解像度の画像を生成できるようになり、DALL-E 2 のような大型モデルには大きな関心が集まっています。

生成拡散モデルの利点は、表面的にはトレーニング セット内のどの画像とも異なる新しい画像を合成できることにあります。実際、これまでの大規模なトレーニングの取り組みでは、過剰学習が問題になることは判明しておらず、プライバシーに敏感な分野の研究者は、実際の画像を生成するための合成例を生成することで、拡散モデルを使用してプライバシーを保護できるとさえ示唆しています。この一連の作業は、拡散モデルが学習データを記憶・再生成しないという前提で行われます。そうすることは、すべてのプライバシー保証に違反し、モデルの一般化やデジタル偽造に関する多くの問題を引き起こすことになります。

この記事では、Google、DeepMind、その他の機関の研究者が、SOTA 普及モデルが実際に 1 つのトレーニング サンプルを記憶し、再生成できることを証明しました。

論文アドレス: https://arxiv.org/pdf/2301.13188v1.pdf

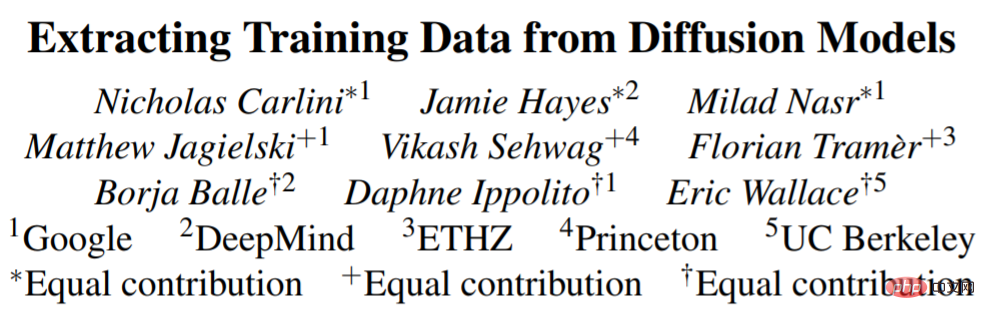

まず、この研究では、画像モデルにおけるメモリの新しい定義を提案し、実装します。次に、研究では、標準的な方法を使用して画像を生成し、一部の画像にラベルを付けるという 2 段階のデータ抽出攻撃を設計しました。この研究では、この手法を安定拡散と Imagen に適用し、個人を特定できる写真から商標ロゴに至るまで、ほぼ同一のトレーニング画像のコピーを 100 枚以上抽出しました (図 1)。

記憶の仕組みとその理由をより深く理解するために、研究者は何百人もの人々をCIFAR10拡散モデルで訓練し、モデルの精度、ハイパーパラメータ、拡張、重複排除がプライバシーに及ぼす影響。拡散モデルは、この研究で評価された画像モデルの中で最もプライベートな形式であり、GAN の 2 倍のトレーニング データが漏洩します。さらに悪いことに、既存のプライバシー強化テクノロジーでは、許容できるプライバシーと実用性のトレードオフを提供できないことも調査でわかっています。全体として、このホワイトペーパーは、ますます強力になる生成モデルとデータプライバシーの間に存在する緊張を強調し、拡散モデルがどのように機能するか、またそれらを適切に展開する方法について疑問を提起します。

なぜこの研究をしたいのですか?拡散モデルがトレーニング データをどのように記憶して再生成するかを理解するには、2 つの動機があります。

1 つ目は、プライバシー リスクを理解することです。インターネットからデータを収集する拡散モデルを再生成すると、言語モデルと同様のプライバシーと著作権のリスクが生じる可能性があります。たとえば、著作権で保護されたテキストやソース コードを記憶したり再生成したりすると、侵害の潜在的な兆候が現れることが指摘されています。同様に、プロのアーティストが作成した画像をコピーすることはデジタル偽造と呼ばれ、アートの世界では議論が行われています。

2 つ目は、一般化を理解することです。データのプライバシーに加えて、拡散モデルがトレーニング データを記憶する方法と理由を理解することは、拡散モデルの一般化能力を理解するのに役立ちます。たとえば、大規模な生成モデルに関する一般的な質問は、その印象的な結果が実際の生成によるものなのか、それともトレーニング データを直接コピーしてリミックスした結果なのかということです。メモリを研究することにより、生成モデルがそのようなデータ複製を実行する速度を具体的に経験的に説明することができます。

SOTA 拡散モデルからデータを抽出します安定拡散からデータを抽出します

今度はトレーニングを抽出します最大かつ最も人気のあるオープンソース拡散モデルである Stable Diffusion からのデータ。

この抽出では、次の 2 つのステップを含む以前の作業の方法が画像に適用されます:

1. 標準的なサンプリング方法を使用した拡散モデルと生成前のセクションの既知のプロンプトを使用した複数の例。

2. 推論を実行して、記憶されたトレーニング モデルから新しい世代モデルを分離します。

侵入の有効性を評価するために、調査ではトレーニング データセットから最も繰り返された 350,000 個の例を選択し、各プロンプトに対して 500 個の候補画像を生成しました (合計 1 億 7,500 万個の画像が生成されました)。

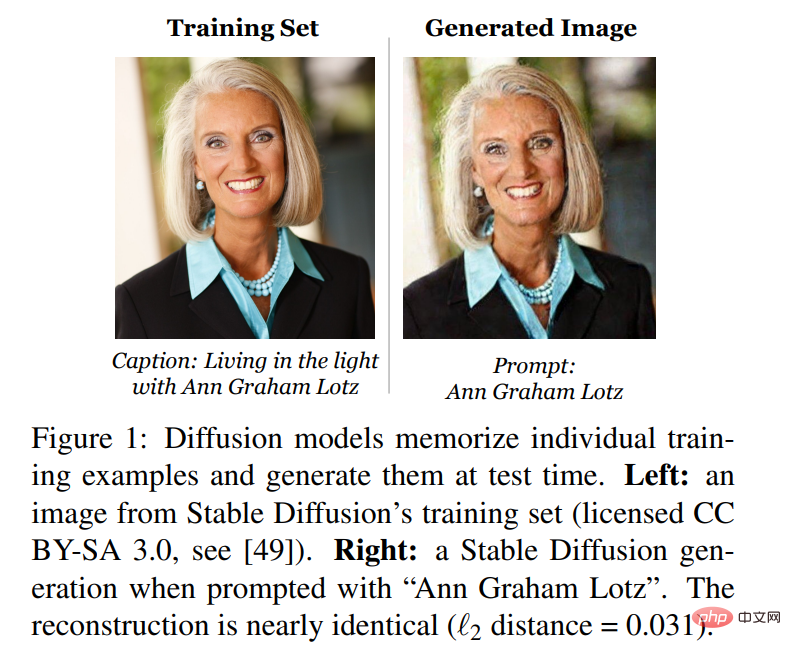

まず、この研究では、生成されたこれらすべての画像を並べ替えて、どの画像がトレーニング データの記憶によって生成されたものであるかを判断します。これらの生成された画像のそれぞれは、論文の定義 1 に基づいてトレーニング画像と比較され、各画像には抽出されたか抽出されなかったかの注釈が付けられます。研究では 94 枚の画像が抽出されたことがわかりました。これらの画像が任意の定義に適合しないことを確認するために、研究ではまた、記憶の有無にかかわらず、視覚分析を通じて生成された最初の 1,000 枚の画像に手動で注釈を付けました。そして、別の 13 枚 (合計 109 画像)研究のL_2ノルムの定義を満たしていなかったとしても、トレーニング例のほぼコピーであることが判明しました。図 3 は、ほぼ完璧なピクセル精度で再現された、抽出された画像のサブセットを示しています。

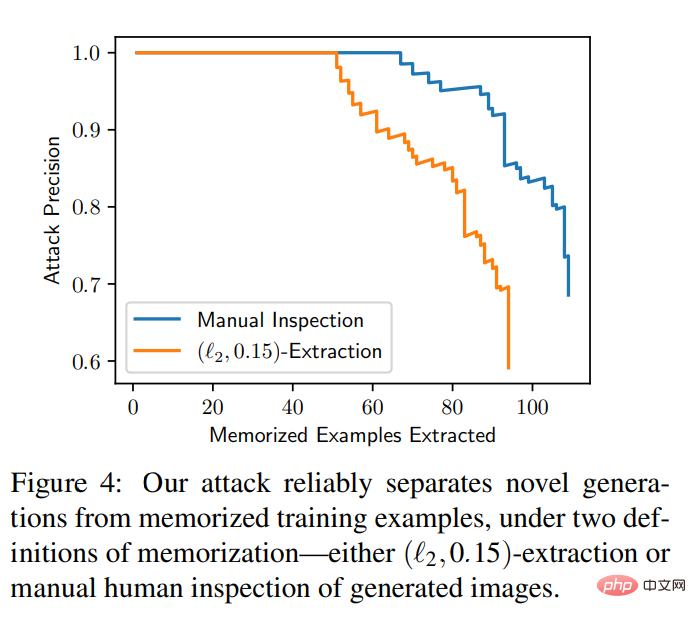

#この実験では、注釈付きの順序付けされた画像セットを考慮した計算曲線も得られます。抽出された画像の数と偽の画像の数を評価します。侵入の陽性率。侵入は非常に正確です。生成された 1 億 7,500 万枚の画像のうち、誤検知が 0 件の 50 枚のメモリ イメージを識別でき、すべてのメモリ イメージを 50% 以上の精度で抽出できました。図 4 には、両方のメモリ定義の適合率と再現率の曲線が含まれています。

#画像からデータを抽出する

安定拡散は現在、公開されている拡散モデルの中で最良の選択ですが、一部の非公開モデルは、より大きなモデルとデータセットを使用してより優れたパフォーマンスを実現しています。以前の研究では、モデルが大きいほどトレーニング データを記憶する可能性が高いことが判明したため、この研究では、20 億パラメータのテキストから画像への拡散モデルである Imagen に注目しました。

驚くべきことに、研究により、Imagen での非配布画像のハッキングは、Stable Diffusion でのハッキングよりも効果的であることが判明しました。 Imagen では、この研究では、配布外 (OOD) スコアが最も高い 500 枚の画像を抽出することを試みました。 Imagen は 3 つの画像 (トレーニング データ セット内で一意) を記憶してコピーします。対照的に、研究で同じ方法を安定拡散に適用した場合、最も外れ値のサンプル 10,000 個を抽出しようとしても、記憶を特定できませんでした。したがって、Imagen は、コピーされたイメージとコピーされていないイメージの両方において、安定した拡散ほどプライベートではありません。これは、Imagen が安定拡散よりも大きなモデルを使用しているため、より多くの画像を記憶していることが原因である可能性があります。さらに、Imagen はより小さなデータセットに対してより多くの反復を行ってトレーニングするため、メモリ レベルの向上にも役立ちます。

以上がちょっとしたトリックを使って拡散モデルを発掘すると、生成された画像は元の学習データのほぼレプリカとなり、プライバシーが暴露されようとしています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。