オープン ドメイン検出問題とは、インターネットからクロールされた多数の画像とテキストのペア、またはトレーニング用に手動で注釈が付けられた特定のカテゴリのデータを使用して、下流のシナリオでカテゴリ検出を実装する方法の問題を指します。上流で。業界におけるオープンドメイン検出手法のアプリケーションには、主に自動運転システムにおける路上物体検出、クラウドのフルシーン検出などが含まれます。

文書アドレス: https://arxiv.org/abs/2209.09407

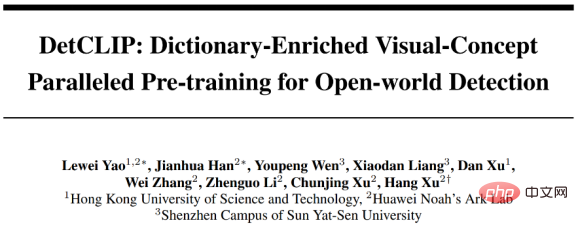

この記事は、NeurIPS 2022 で選ばれた論文「DetCLIP: Dictionary-Enriched Visual-Concept Paralleled Pre-training for Open-world Detection」を共有しています。この論文では、オープン ドメイン検出問題に対する複数のデータ ソースの統合的で効率的な方法を提案しています。カテゴリ間の暗黙的な関係を提供する追加の知識ベースを構築しながら、並行トレーニング フレームワークを実行します。同時に、DetCLIP は、Microsoft が主催する ECCV2022 OdinW (Object Detection in the Wild[1]) コンペティションにおいて、平均検出指数 24.9% を記録し、ゼロショット検出トラックで 1 位を獲得しました。

問題の導入インターネットからクロールされた画像とテキストのペアに基づいてトレーニングされるマルチモーダル事前トレーニング モデル (CLIP など) の人気により、ゼロショットでの使用は分類の分野で優れたパフォーマンスを実証しており、この機能をオープンドメインの高密度予測 (任意のカテゴリ検出、セグメンテーションなど) に移行しようとする手法がますます増えています。既存の手法では、多くの場合、特徴レベルの抽出に事前トレーニング済みの大分類モデルを使用するか [1]、擬似ラベル付けキャプションと自己トレーニングによって学習します [2] が、これは多くの場合、大分類モデルのパフォーマンスによって制限されます。キャプションの注釈。

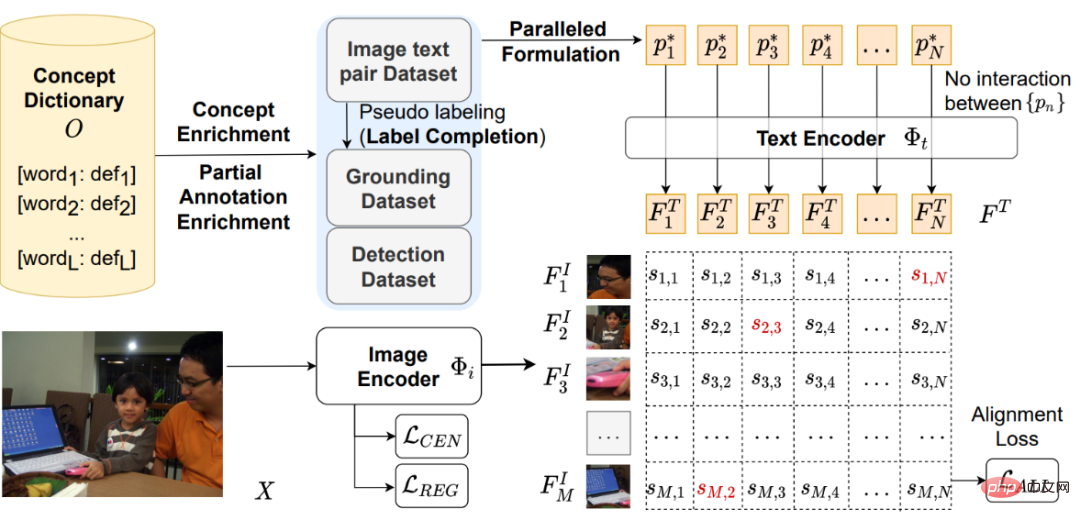

既存の SOTA オープンドメイン検出モデル GLIP[3] は、その利点を最大限に活用して、検出データの形式をグラウンディング データの形式に変換することにより、複数のデータ ソースの共同学習を実行します。 (検出データ セットには一般的なカテゴリに対して比較的完全な注釈が付いていますが、グラウンディング データ セットにはより広い範囲のカテゴリ カバー間隔があります)。ただし、カテゴリ名詞を連結する方法はモデルの全体的な学習効率の低下につながり、カテゴリ単語をテキスト入力として直接使用すると、カテゴリ間の粒度の細かいアプリオリな関係を提供できないことがわかりました。

#図 1: 複数のデータ ソースが共同で事前トレーニングされたオープン ドメイン検出モデル パイプライン モデル フレームワーク

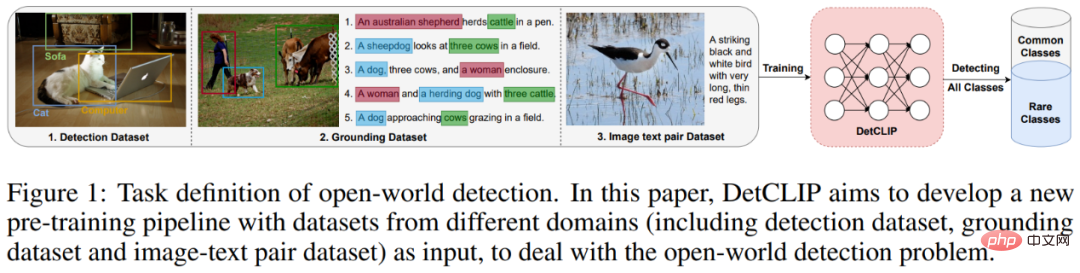

下の図に示すように、ATSS[4] 1 段階検出モデルに基づいて、DetCLIP には画像エンコーダーが含まれています検出ボックスの画像特徴を取得するには およびテキスト エンコーダ テキストを取得するにはカテゴリ の特徴。次に、上記の画像特徴とテキスト特徴に基づいて、対応する分類アライメント損失 #、中心点損失 #、および回帰損失 が計算されます。

図 2: DetCLIP モデル フレームワーク図 2 の右上と左上に示すように、この記事の主な革新は、1) トレーニング効率を最適化するために並列入力を使用して、複数のデータ ソースからのオブジェクトとテキストを共同トレーニングするためのフレームワークを提案すること、2) 追加のオブジェクトを構築することです。オープン ドメインの検出トレーニングを支援するナレッジ ベース。

複数のデータソースの並列入力事前トレーニング フレームワーク

図 3: DetCLIP 並列入力事前トレーニング フレームワークと GLIP の比較

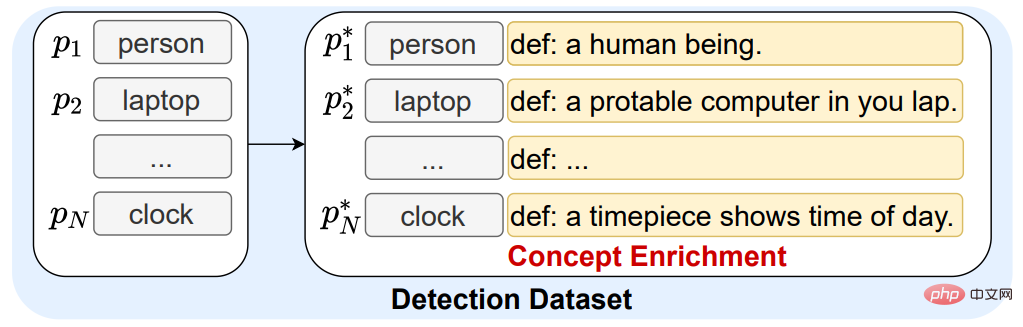

異なるデータソースにおける不均一なカテゴリ空間の問題(同じカテゴリ名が異なる、またはカテゴリに含まれる内容など)を解決し、先験的な情報を提供するためカテゴリ間の関係については、より効率的なトレーニングを実現するためにオブジェクト知識ベースを構築しました。

構築: 検出データのカテゴリ、画像とテキストのペアの名詞句、および対応する定義を包括的に統合することにより、オブジェクト知識ベースを同時に構築します。

使用法: 1. オブジェクト知識ベースの定義を使用して、既存の検出データ内のカテゴリ単語を拡張し、カテゴリ間の関係に関する事前情報を提供します (概念強化)。

#図 4: オブジェクト ナレッジ ベースを使用してカテゴリ単語の定義を拡張する例

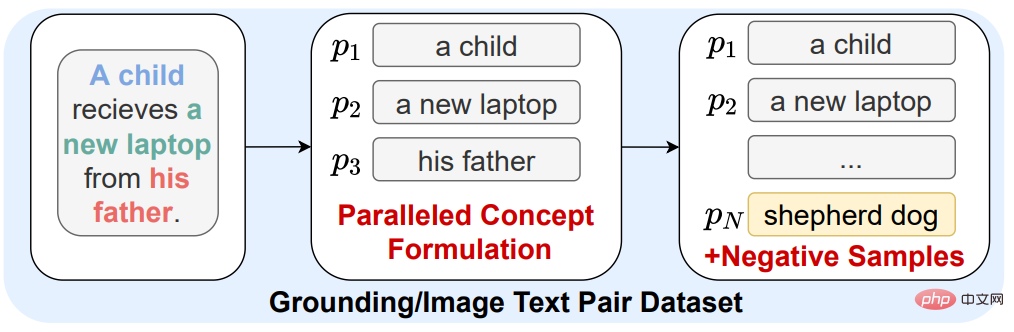

2. グラウンディング データと画像キャプション データのキャプション アノテーションが不完全であるため (画像に表示されるカテゴリがキャプションに表示されない)、これらの画像はネガティブとして使用できます。カテゴリの数が非常に少ないため、一部の一般的ではないカテゴリについてモデルを区別しにくくなります。したがって、オブジェクト知識ベースからオブジェクト名詞をネガティブ サンプル カテゴリとしてランダムに選択し、まれなカテゴリの特徴 (ネガティブ サンプル) のモデルの識別を向上させます。

#図 5: オブジェクト ナレッジ ベース内のカテゴリをネガティブ サンプル カテゴリとして導入

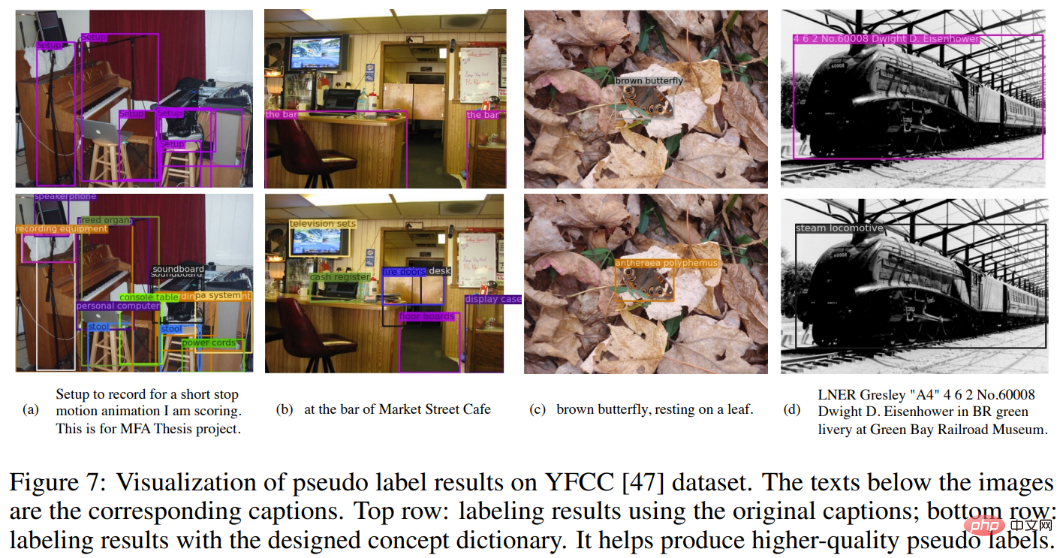

#3. フレーム注釈のない画像とテキストのペアのデータについては、Huawei Noah が自社開発した大規模モデル FILIP [5] と事前トレーニングされた RPN を使用して注釈を付け、変換できるようにします。通常の接地データに基づきます。同時に、キャプション内の画像内のオブジェクトの注釈が不完全である問題を軽減するために、オブジェクト知識ベース内のすべてのカテゴリフレーズを疑似ラベル付けの候補カテゴリとして使用し (2 行目)、カテゴリのみを使用します。キャプション (最初の行) の注釈効果。行) 比較は次のとおりです:

図 6: カテゴリの紹介実験結果

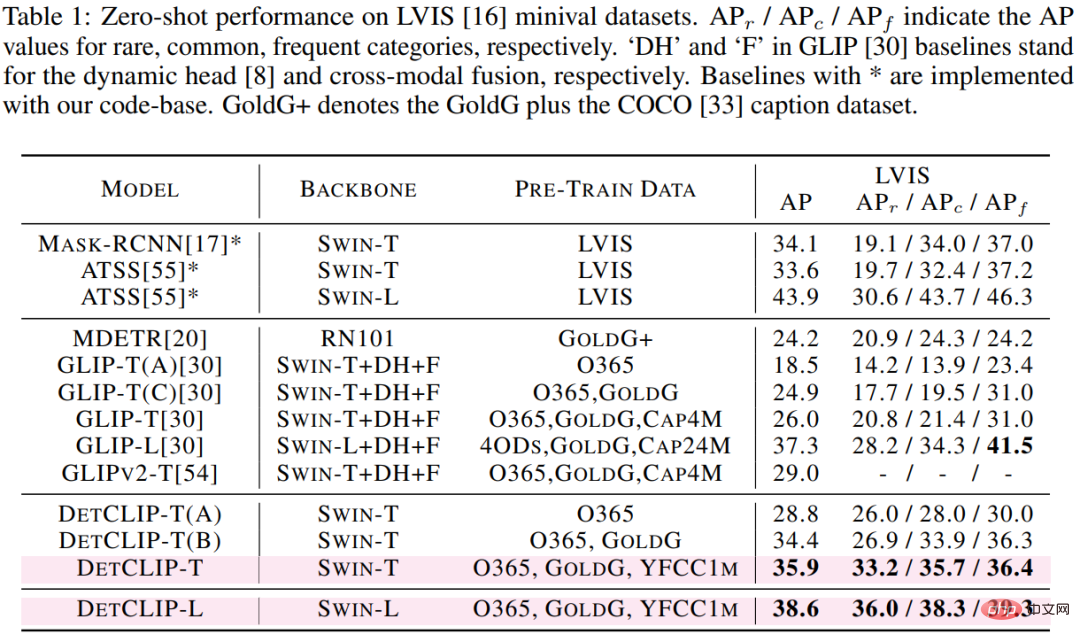

提案手法のオープンドメイン検出性能を、ダウンストリーム LVIS 検出データセット (1203 クラス) からわかるように、swin-t バックボーンベースのアーキテクチャに基づいて、DetCLIP は既存の SOTA モデル GLIP と比較して 9.9% の AP 向上を達成し、Rare モデルでは 12.4% の AP 向上を達成しました。ただし、GLIP データ量の半分未満しか使用しませんが、トレーニング セットには LVIS の画像が含まれていないことに注意してください。

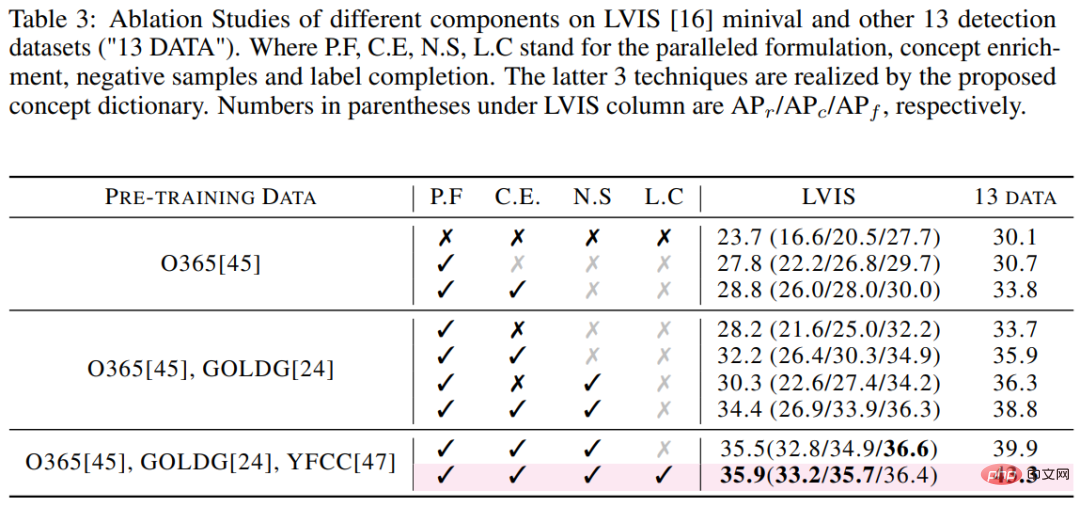

#表 1: LVIS でのさまざまな方式のゼロショット転送パフォーマンスの比較 ##トレーニング効率の観点から、32 台の V100 の同じハードウェア条件に基づくと、GLIP-T のトレーニング時間は DetCLIP-T の 5 倍です (10.7K GPU 時間対 2.0K GPU 時間) GPU 時間)。テスト効率の点では、単一の V100 に基づくと、DetCLIP-T の推論効率 2.3 FPS (画像あたり 0.4 秒) は、GLIP-T の 0.12 FPS (画像あたり 8.6 秒) の 20 倍です。また、DetCLIP の主要なイノベーション (並列フレームワークとオブジェクト知識ベース) が精度に与える影響についても個別に調査しました。

#表 3: LVIS データセットでの DetCLIP アブレーション研究結果

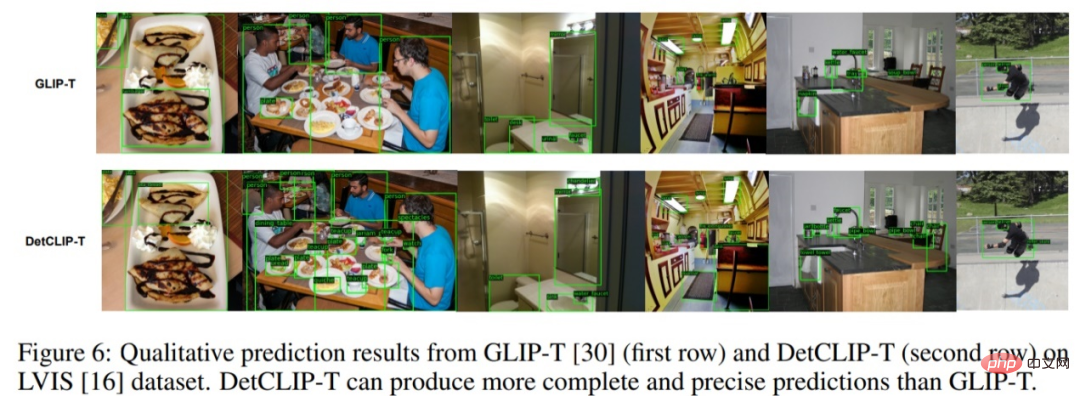

可視化結果以下の図に示すように、同じ swin-t バックボーンに基づいて、LVIS データセットの視覚化効果は、特にレアなカテゴリの注釈と完全性において、GLIP と比較して大幅に向上しました。注釈の。

図 7: LVIS データセットに対する DetCLIP と GLIP の予測結果の視覚的な比較

以上がNeurIPS 2022 | 新しいオープンドメイン検出手法である DetCLIP により推論効率が 20 倍向上の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。