Le premier travail a été auto-développé par Kuaishou, ciblant principalement des scénarios multitâches contraints.

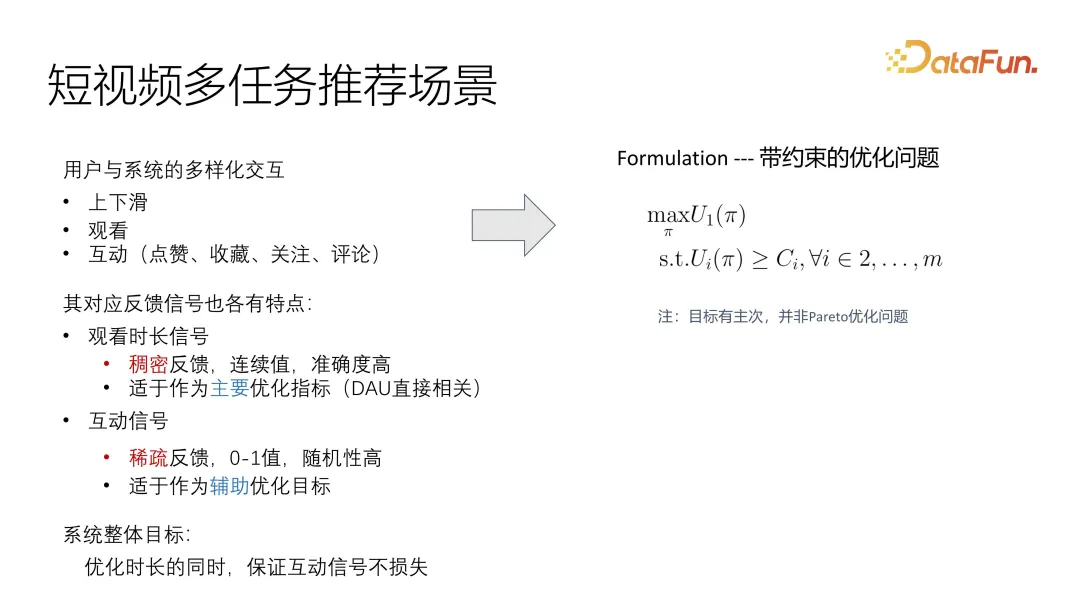

Ce travail vise principalement un scénario plus professionnel de courte vidéo multitâche. Les commentaires des utilisateurs sont divisés en durée de visionnage et en interaction, qui sont des interactions plus courantes. Y compris les likes, les collections, les suivis et les commentaires, chacun de ces retours a ses propres caractéristiques. Grâce à l'observation du système en ligne, nous avons constaté que le signal de durée est en réalité très clairsemé et, comme il s'agit d'une valeur continue, il est difficile de mesurer avec précision le niveau d'intérêt de l'utilisateur. En revanche, les signaux interactifs sont plus riches, notamment les likes, les favoris, les suivis et les commentaires. Ces retours peuvent être divisés en deux catégories : les préférences du public et les commentaires comportementaux. Au cours du processus d'optimisation, nous considérons ce signal comme l'objectif principal et l'interaction comme une optimisation auxiliaire. Nous essayons de garantir que le signal interactif ne soit pas perdu en tant qu'objectif global de l'optimisation. En revanche, le nombre d’interactions est plus rare et, comme il n’existe pas de norme unifiée, il est difficile de mesurer avec précision l’intérêt des utilisateurs. Afin d'améliorer l'effet, nous devons effectuer certaines optimisations afin qu'il puisse être optimisé en tant qu'objectif principal de notre système, tout en garantissant l'intégrité des données interactives en tant qu'auxiliaire de l'objectif global.

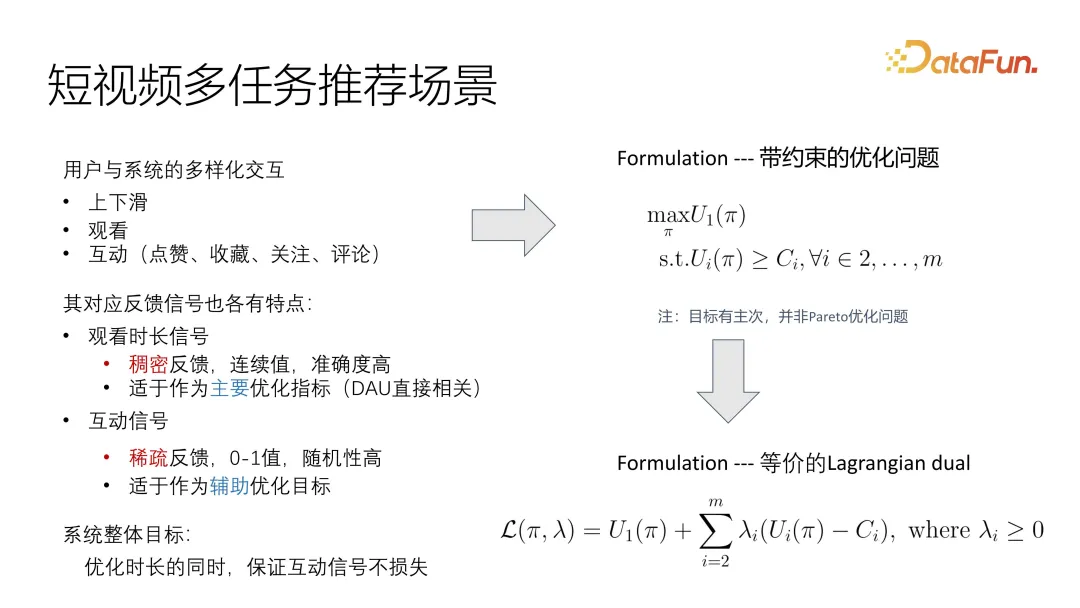

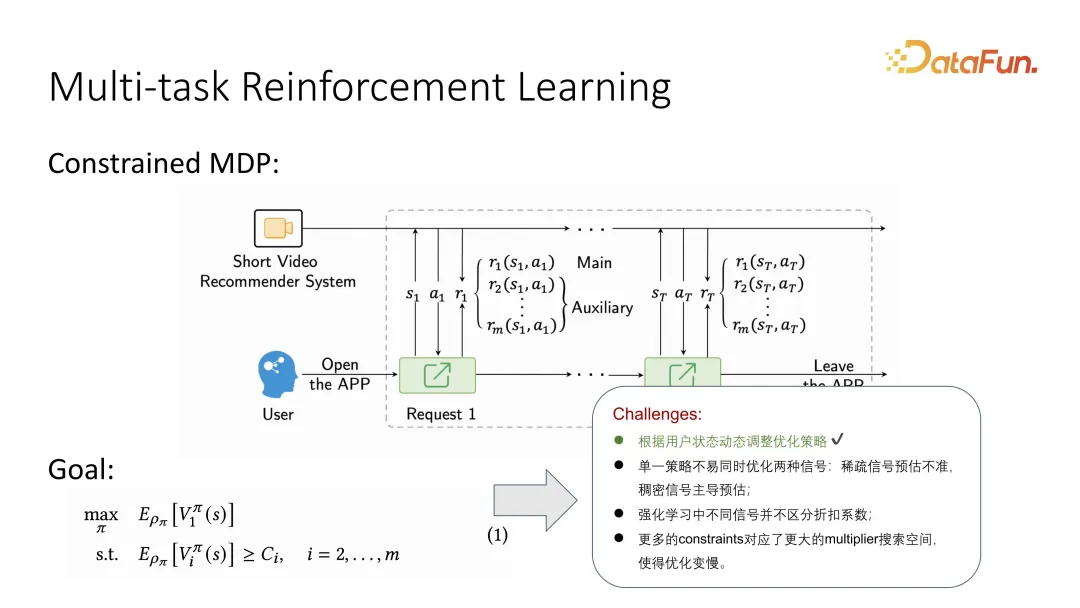

De cette façon, le problème peut être décrit de manière très intuitive comme un problème d'optimisation sous contrainte. Il y a un objectif principal d'optimisation de l'utilité, et l'objectif auxiliaire est de satisfaire une limite inférieure. Contrairement aux problèmes d’optimisation Pareto courants, nous devons ici établir des priorités.

Une manière courante de résoudre ce problème est de le convertir en un problème dual lagrangien, afin qu'il puisse être directement intégré dans une fonction objectif optimisée. Qu'il s'agisse d'une optimisation globale ou d'une optimisation alternée, cela peut être Optimiser. un objectif global. Bien entendu, il est nécessaire de contrôler la corrélation et les facteurs d’influence des différents objectifs.

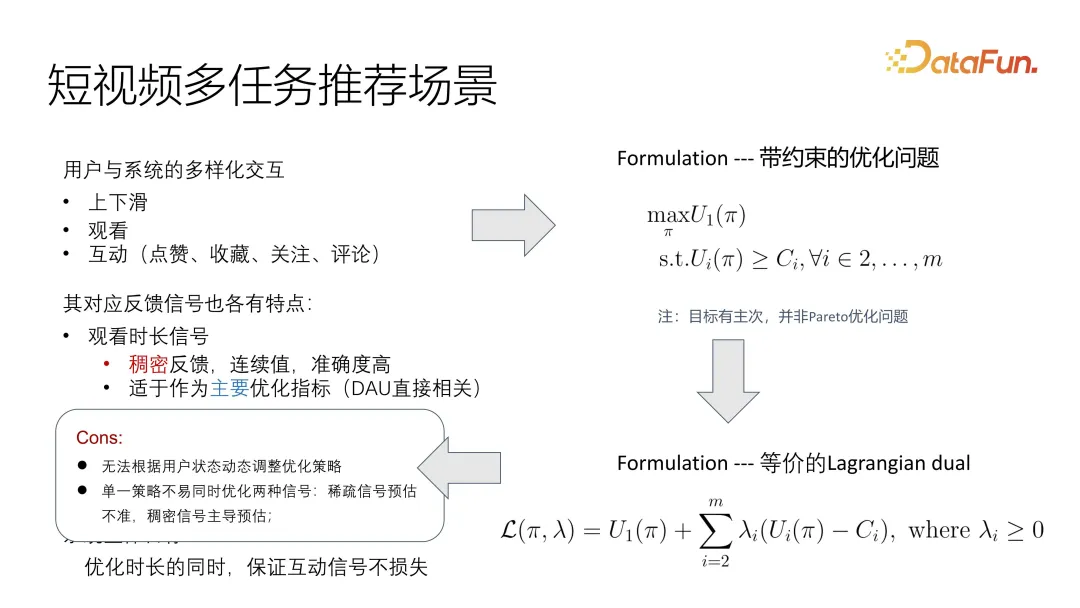

Il y a encore quelques problèmes dans la formulation de cette observation, car le statut de l'utilisateur change de manière dynamique, ce qui le fait changer très rapidement dans le court scénario vidéo. De plus, comme les signaux ne sont pas uniformes, en particulier l'optimisation de la cible principale et l'optimisation de la cible auxiliaire de la cyanose présentent des problèmes de distribution très incohérents, il est difficile de traiter les solutions existantes. Si vous l'unifiez en une fonction cible, l'un des signaux peut dominer un autre signal.

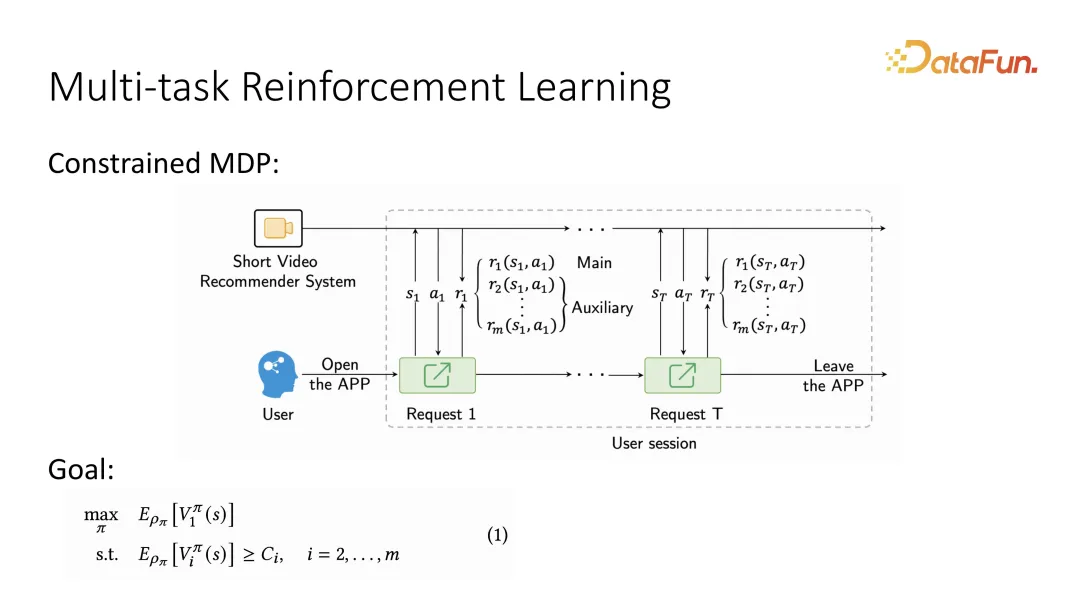

Sur la base du premier point, compte tenu des changements dynamiques des utilisateurs, le problème est souvent décrit comme MDP, qui est la séquence d'interaction alternée entre les utilisateurs et le système, et cette séquence Après l'avoir décrite comme un processus de décision markovien, elle peut être résolue à l'aide de méthodes d'apprentissage par renforcement. Plus précisément, après avoir décrit le processus décisionnel de Markov, parce qu'il est également nécessaire de distinguer l'objectif principal et l'objectif auxiliaire, il est nécessaire de préciser que lorsque les commentaires des utilisateurs sont donnés, deux objectifs différents doivent également être distingués. il peut y avoir plusieurs objectifs auxiliaires. Lorsque l'apprentissage par renforcement définit l'objectif d'optimisation à long terme, il définit l'objectif principal à optimiser comme une fonction de valeur à long terme, appelée fonction de valeur. De même, pour les cibles auxiliaires, il y aura également des fonctions de valeur correspondantes. Équivalent aux commentaires de chaque utilisateur, il y aura une évaluation de la valeur à long terme. Par rapport à la fonction d'utilité précédente, elle est désormais devenue une fonction de valeur à long terme.

De nouveaux problèmes surgiront lorsqu'ils seront combinés avec l'apprentissage par renforcement, comme par exemple la manière dont l'apprentissage par renforcement distingue différents coefficients de remise. De plus, à mesure que davantage de contraintes sont introduites, l’espace de recherche des paramètres devient plus grand, ce qui rend l’apprentissage par renforcement plus difficile.

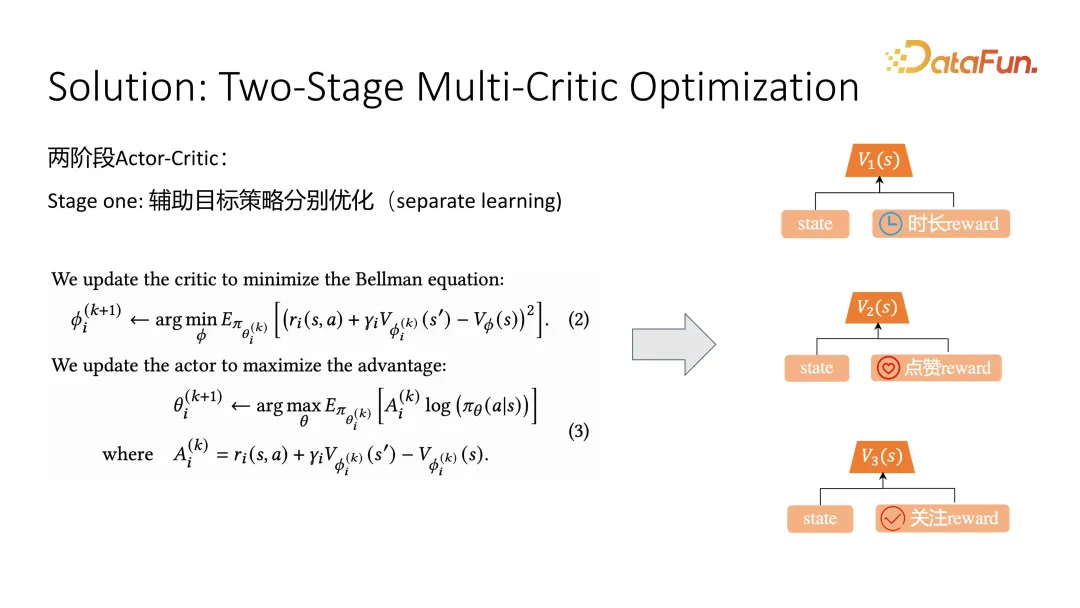

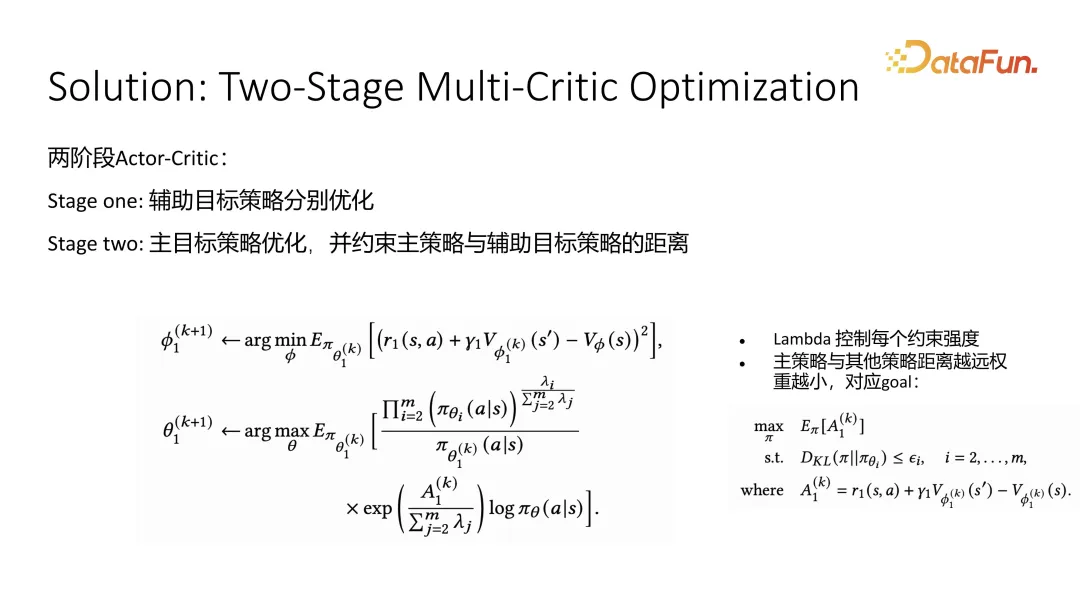

La solution à ce travail est de diviser l'ensemble de l'optimisation en deux étapes. La première étape optimise les objectifs auxiliaires et la deuxième étape optimise les objectifs principaux.

Dans la première étape de l'optimisation des cibles auxiliaires, une méthode typique d'optimisation des critiques d'acteurs est adoptée. Pour l'optimisation des cibles auxiliaires telles que les likes et les suivis, un critique est optimisé pour estimer la qualité de l'état actuel. Une fois l'estimation de la valeur à long terme exacte, vous pouvez utiliser la fonction de valeur pour guider son apprentissage lors de l'optimisation de l'acteur. La formule (2) est l'optimisation du critique et la formule (3) est l'optimisation de l'acteur. Pour l'optimisation du critique, l'état actuel, l'état suivant et l'échantillonnage de l'action en cours seront utilisés lors de la formation. . Selon l'équation de Bellman, l'action peut être obtenue et, couplée à l'estimation de la valeur de l'état futur, elle doit être proche de l'estimation de l'état actuel. De cette manière, l'optimisation peut progressivement se rapprocher de l'estimation précise de la valeur à long terme. . Pour guider l’apprentissage des acteurs, c’est-à-dire recommander l’apprentissage des politiques, une fonction d’avantage est utilisée. La fonction d'avantage indique si l'effet d'une certaine action est plus fort que l'estimation moyenne. Cette estimation moyenne est appelée référence. Plus l’Avantage est grand, meilleure est l’action et plus grande est la probabilité d’adopter la stratégie recommandée. C'est la première étape, l'optimisation des objectifs auxiliaires.

La deuxième étape consiste à optimiser l'objectif principal, nous utilisons la durée. La cible auxiliaire utilise une stratégie approximative pour contraindre la cible principale.Nous espérons que la distribution des actions de la cible principale sera aussi proche que possible des différentes cibles auxiliaires, tant que nous continuerons à nous rapprocher de la cible auxiliaire, les résultats de la cible auxiliaire. l'objectif ne devrait pas être trop mauvais. Après avoir obtenu la formulation approximative, une solution de forme fermée peut être obtenue en complétant le carré, c'est-à-dire de manière pondérée. Il n'y a en fait pas beaucoup de différence entre la méthode d'optimisation de l'acteur critique de l'ensemble de l'objectif principal au niveau critique et le niveau d'estimation de la fonction de valeur. Mais dans le cas des acteurs, nous introduisons des poids obtenus à partir de la solution sous forme fermée. La signification de ce poids est que plus le facteur d'impact correspondant à une certaine stratégie auxiliaire I est élevé, plus son impact sur le poids global est important. Nous espérons que la distribution des résultats de la politique est aussi proche que possible de la moyenne de toutes les politiques cibles auxiliaires. Ce phénomène se produit lorsque le comportement de la solution fermée obtenue est obtenu.

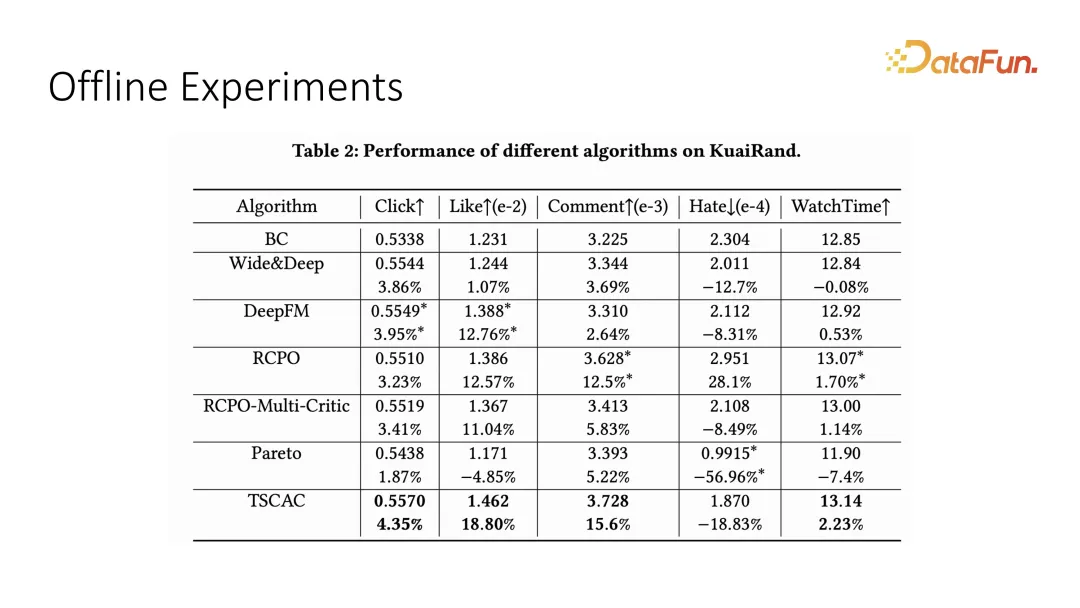

Nous avons testé l'effet de l'optimisation multi-objectifs sur l'ensemble de données hors ligne. L'objectif principal ici est la durée de visionnage, qui est la durée de visionnage, et les objectifs auxiliaires sont le clic, aimer, commenter et détester et d’autres indicateurs interactifs. On peut voir que la démarche acteur-critique en deux étapes que nous avons proposée permet d’obtenir des résultats optimaux.

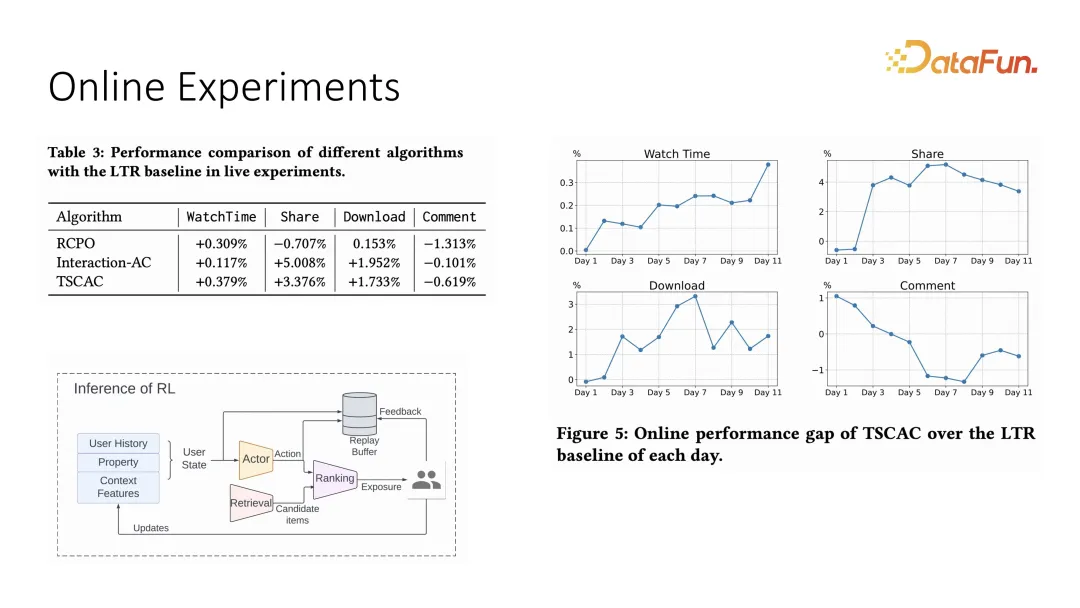

De même, nous avons également mené des expériences comparatives correspondantes dans le système en ligne. Le réglage du système en ligne adopte le modèle de recommandation d'acteur plus classement. L'action ici est le poids, et le classement final est déterminé par chacun. item et Le résultat du produit interne des poids. Les expériences en ligne montrent également que la durée de visionnage peut limiter d'autres interactions tout en s'améliorant. Par rapport à la stratégie d'optimisation précédente, elle peut mieux limiter les indicateurs d'interaction.

Ce qui précède est une introduction au premier ouvrage.

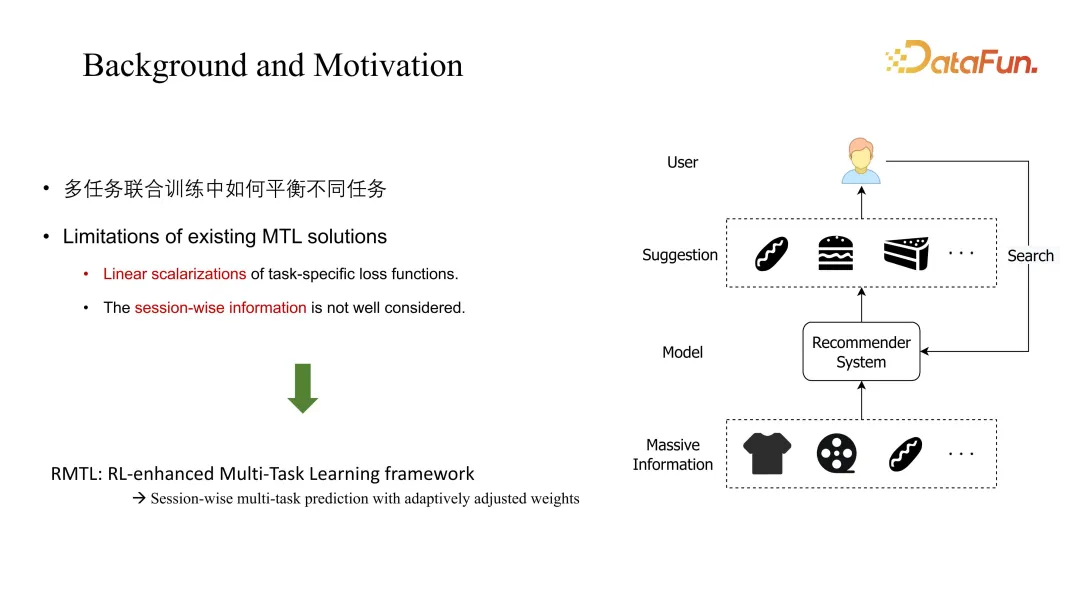

Le deuxième travail est également l'application de l'apprentissage par renforcement dans l'optimisation multitâche, mais il s'agit d'une optimisation plus traditionnelle. Ce travail est un projet conjoint entre Kuaishou et la City University de Hong Kong. Le premier auteur est Liu Ziru.

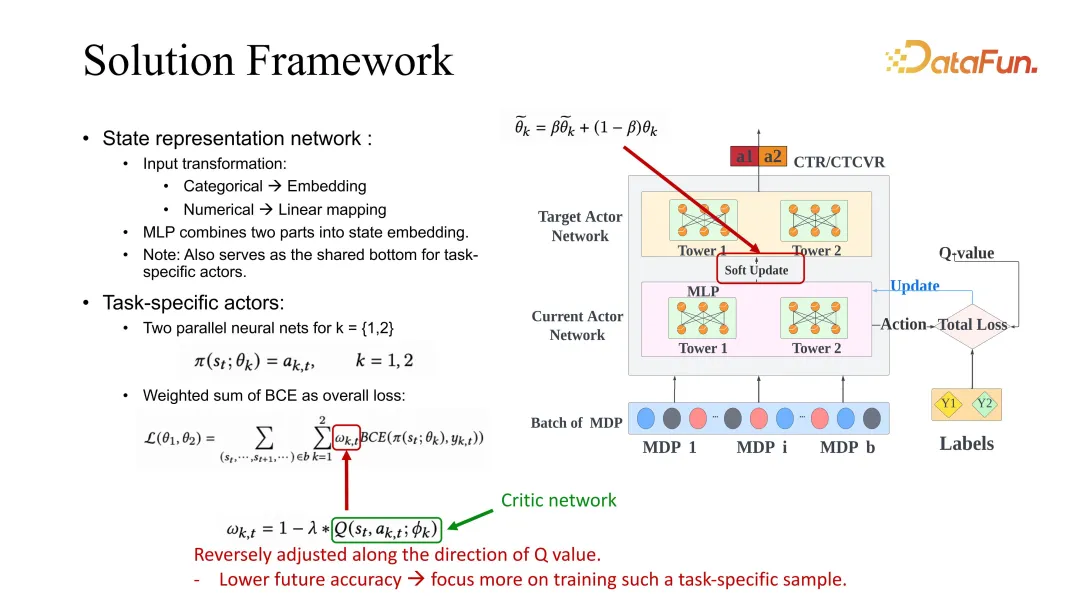

Le principal problème abordé dans ce travail est l'entraînement conjoint multitâche typique. Le défi est d'équilibrer les coefficients entre les différentes tâches. La solution MTL traditionnelle est généralement une combinaison linéaire. Les méthodes seront prises en compte et la dimension de la session, c'est-à-dire les changements dynamiques à long terme, sera ignorée. Le RMTL proposé dans ce travail modifie la méthode de pondération grâce à des prévisions à long terme.

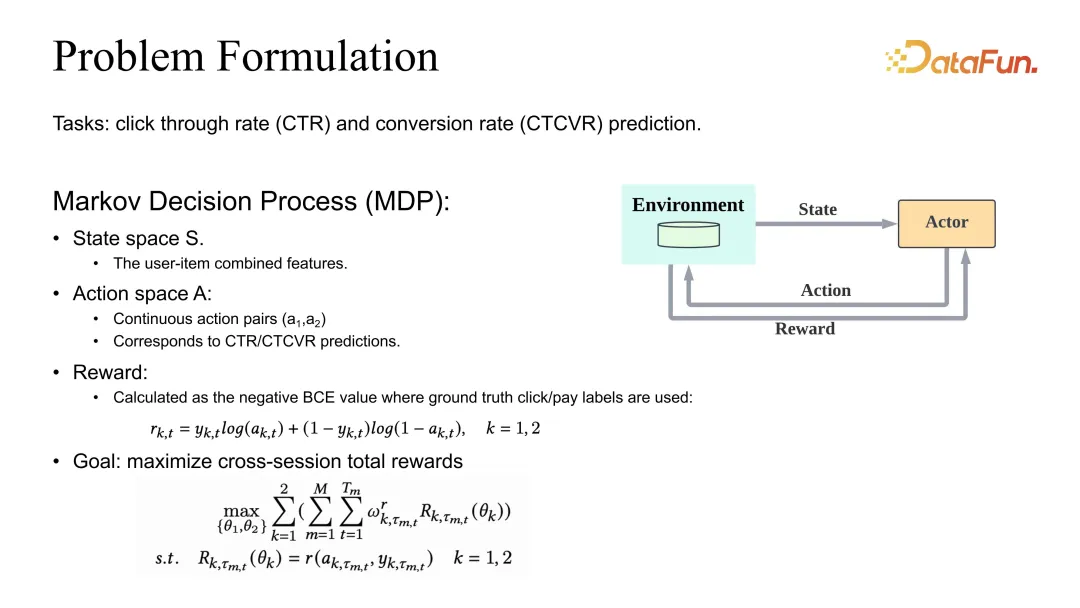

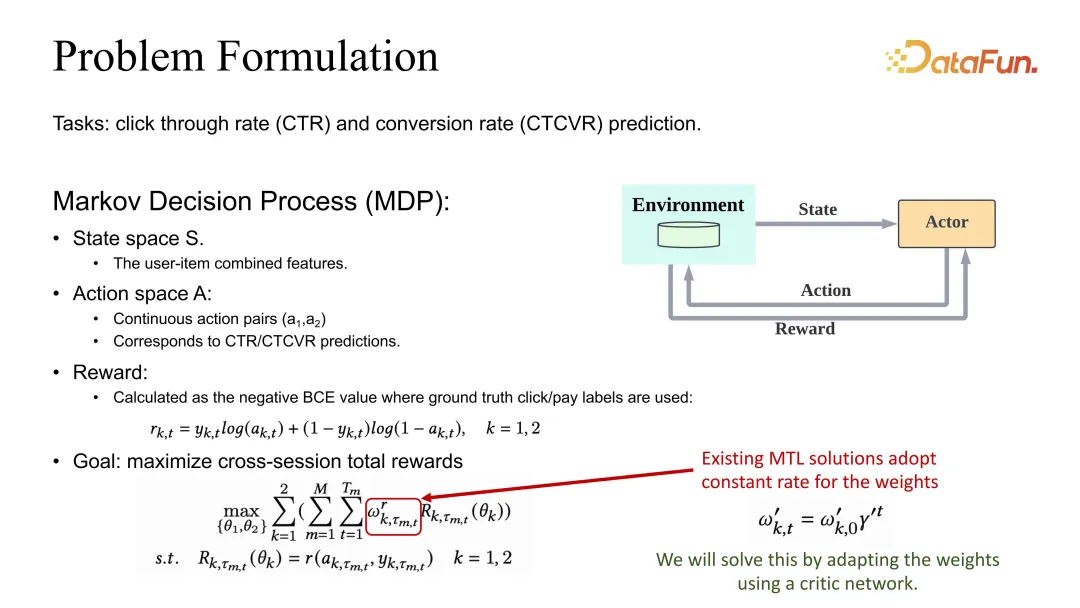

La problématique est de définir l'optimisation conjointe des estimations de CTR et CVR. Nous avons également une définition du MDP (Markov Decision Process), mais ici l'action n'est plus une liste de recommandations, mais les estimations CTR et CVR correspondantes. Pour que l'estimation soit exacte, la récompense doit être définie comme le BCE ou toute perte raisonnable correspondante. En termes de définition globale de l'objectif, il est généralement défini comme différents poids de tâches, puis la session entière et tous les échantillons de données sont additionnés.

Vous pouvez constater qu'en plus de la remise de Gamma, son coefficient de poids sera également affecté par un coefficient qui devra être ajusté.

Notre solution est de faire l'ajustement de ce coefficient lié à l'estimation de la dimension de la séance. Un squelette ESMM est donné ici. Bien entendu, l'utilisation d'autres lignes de base est également courante et peut être améliorée à l'aide de notre méthode.

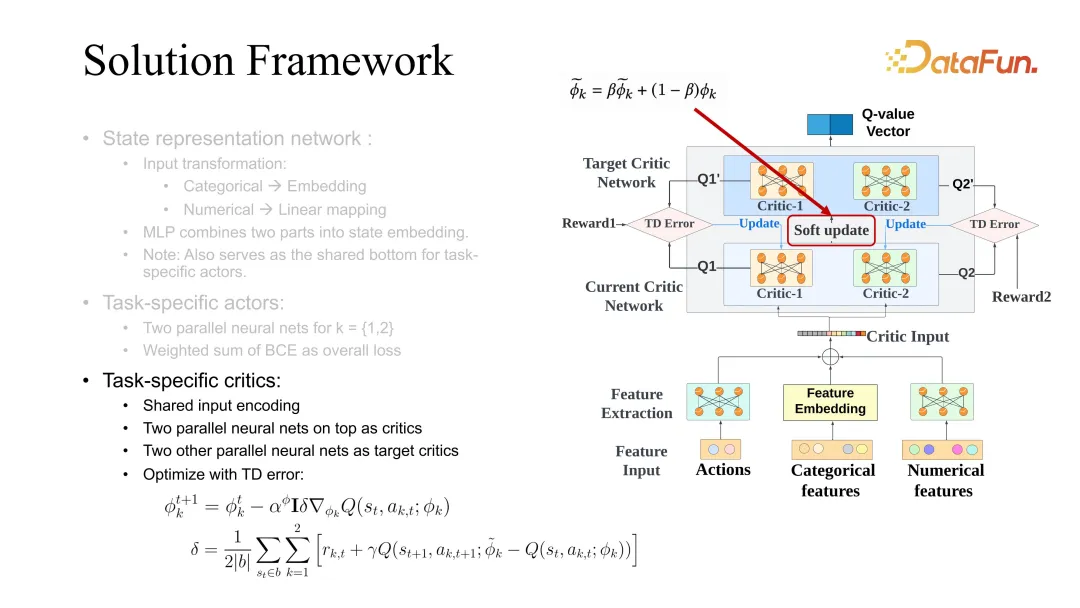

Présentons ESMM en détail. Tout d'abord, il existe un acteur spécifique à une tâche. Chaque tâche aura une cible et une optimisation d'acteur actuelle. Lors de l'optimisation, un cadre similaire au critique d'acteur mentionné précédemment est utilisé. Au cours du processus d'optimisation, la perte de BCE doit ajuster le poids spécifique de la tâche lors de l'apprentissage des acteurs. Dans notre solution, ce poids doit être modifié en conséquence en fonction des évaluations de valeur futures. La signification de ce paramètre est que si la valeur d'évaluation future est plus élevée, cela signifie que l'état actuel et l'action actuelle sont plus précis et que leur apprentissage peut être ralenti. Au contraire, si la prévision de l’avenir est mauvaise, cela signifie que le modèle n’est pas optimiste quant à l’avenir de l’état et de l’action, et son apprentissage devrait être augmenté. Le poids est ainsi ajusté. L’évaluation future utilise ici également le réseau critique mentionné ci-dessus pour l’apprentissage.

critique utilise également la différence entre l'état futur et l'état actuel, mais elle est différente de la fonction valeur. L'apprentissage de la différence utilise ici la fonction Q, qui nécessite l'évaluation conjointe de l'état et de l'action. . Lors de la mise à jour des acteurs, il faut également utiliser l’apprentissage des acteurs correspondant à différentes tâches en même temps. Ici, la mise à jour logicielle est une astuce générale, qui est plus utile pour augmenter la stabilité de l'apprentissage RL. Elle optimise généralement la cible et le critique actuel en même temps.

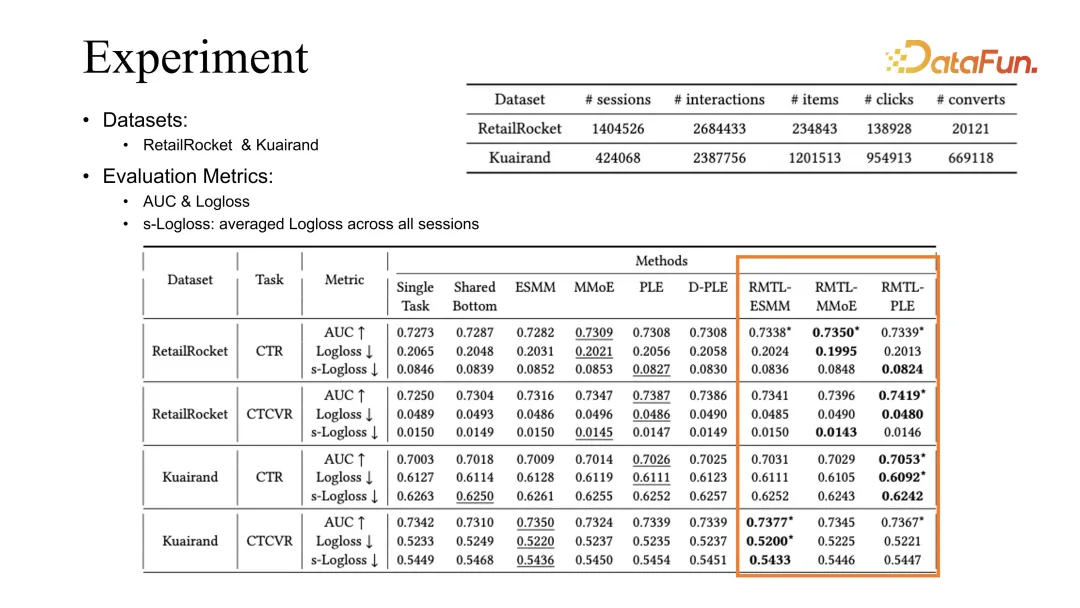

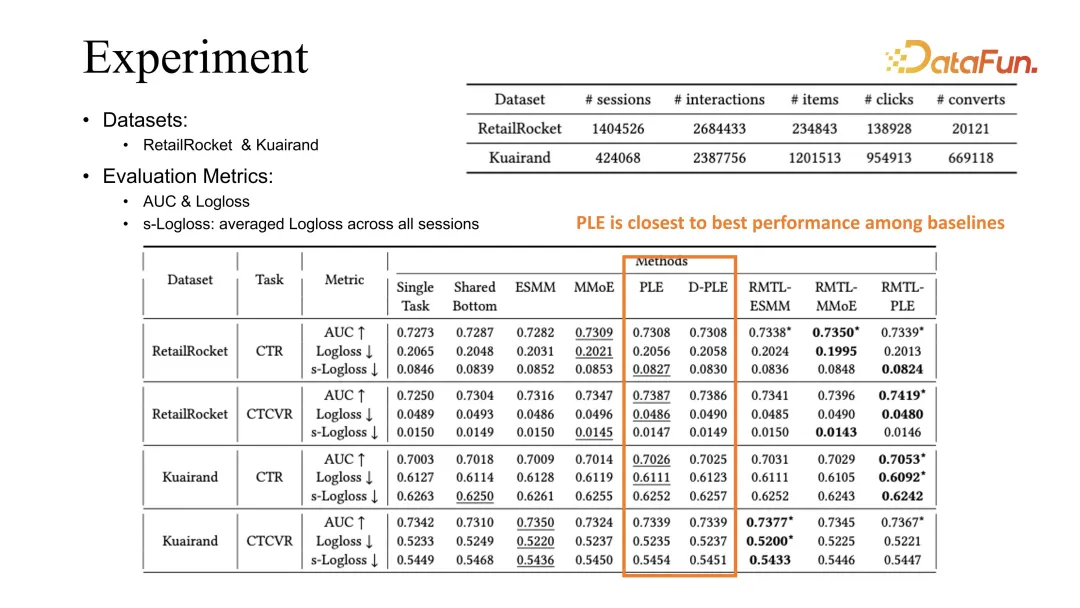

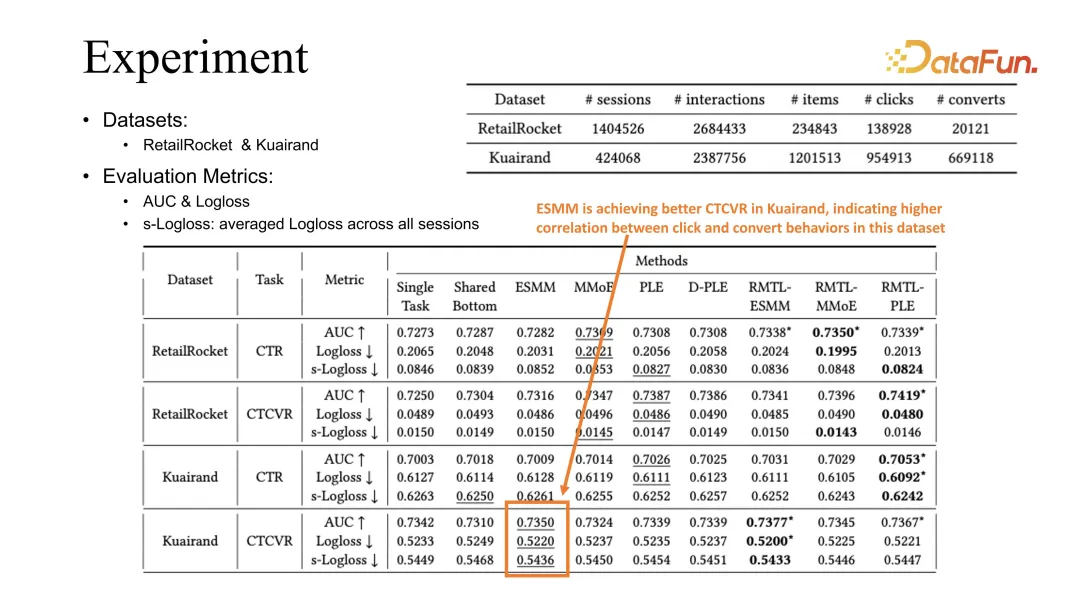

Grâce à des expériences comparatives sur deux ensembles de données publiques, il peut être vu que notre méthode peut être combinée avec des méthodes d'optimisation existantes, notamment ESMM, MMoE et PLE, et que les résultats obtenus peuvent être comparés à la base de référence précédente. a été amélioré.

PLE est la meilleure base de référence dans nos observations. Notre attribution basée sur les phénomènes observés est que PLE peut mieux apprendre l'intégration partagée lors de l'apprentissage de différentes tâches.

En revanche, ESMM peut obtenir une meilleure évaluation CVR sur la tâche Kuairand. Nous pensons que cela est lié à la corrélation plus forte entre clic et conversion dans cet ensemble de données.

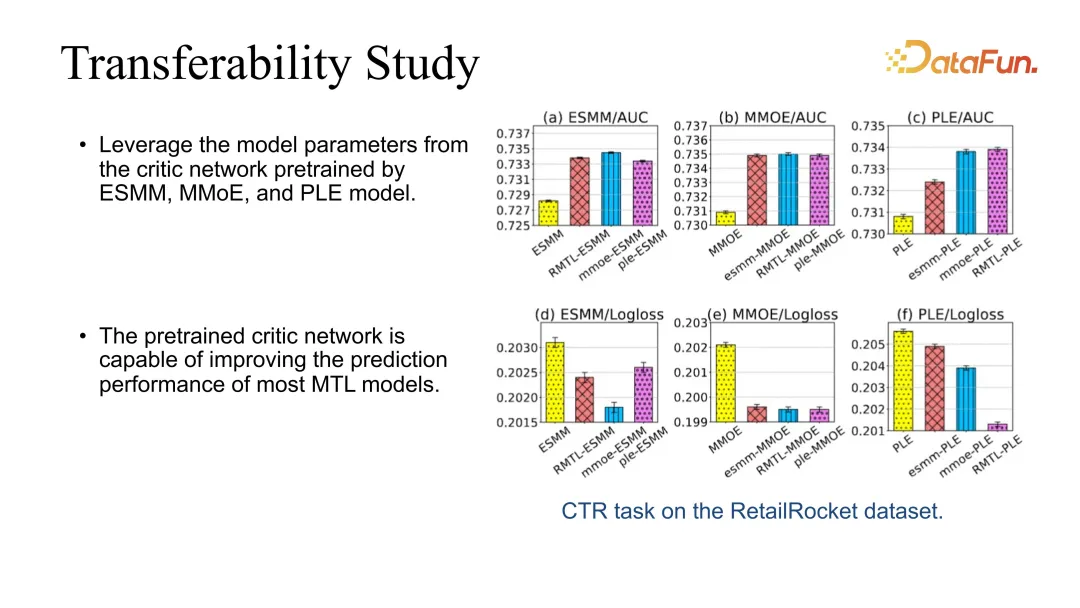

De plus, nous avons également fait un test de transférabilité, car notre critique peut se greffer directement sur d'autres modèles. Par exemple, vous pouvez apprendre la critique d'acteur via le RMTL le plus basique, puis utiliser la critique pour améliorer directement les performances d'autres modèles. Nous avons constaté que l'effet peut être amélioré de manière stable pendant la greffe.

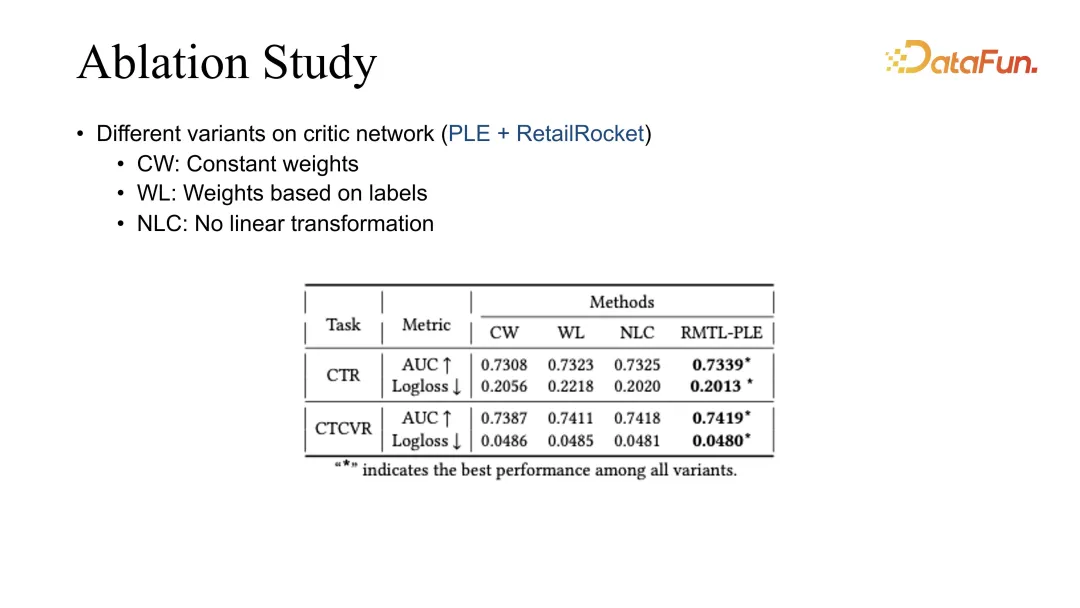

Enfin, nous avons réalisé une étude d'ablation pour comparer différentes méthodes de pondération Actuellement, les meilleurs résultats sont obtenus par notre RMTL.

Enfin, résumons quelques expériences de RL et MTL.

Nous avons constaté que l'optimisation à long terme du système de recommandation, en particulier l'optimisation à long terme d'indicateurs complexes, est un scénario très typique d'apprentissage par renforcement et d'optimisation multitâche. S'il s'agit d'une optimisation conjointe des objectifs principaux et secondaires, la régularisation douce peut être utilisée pour contraindre l'apprentissage de l'objectif principal. Lors de l'optimisation conjointe multi-objectifs, si les changements dynamiques des différents objectifs sont pris en compte, l'effet d'optimisation peut également être amélioré.

De plus, il existe également certains défis. Par exemple, la combinaison de différents modules d'apprentissage par renforcement entraînera de nombreux défis pour la stabilité du système. Notre expérience est que le contrôle de la qualité des données, le contrôle de l’exactitude des étiquettes et la supervision de l’exactitude des prédictions des modèles sont des moyens très importants. De plus, étant donné que le système de recommandation et les utilisateurs interagissent directement, différents objectifs ne peuvent refléter que partiellement l’expérience utilisateur, de sorte que les stratégies de recommandation qui en résulteront seront également très différentes. Comment optimiser et améliorer conjointement l'expérience utilisateur dans un statut d'utilisateur en constante évolution sera un sujet très important à l'avenir.

A1 : L'indicateur de durée est une tâche de régression typique. Mais nous avons également remarqué que l'estimation de la durée est fortement liée à la durée de la vidéo elle-même. Par exemple, la répartition des vidéos courtes et des vidéos longues sera très différente, donc lors de l'estimation, elle sera classée en premier, puis la régression le sera. fait. . Récemment, nous avons également publié un article dans KDD, qui parle de la méthode d'estimation du signal de durée de division à l'aide de la méthode arborescente. Si vous êtes intéressé, vous pouvez y prêter attention. La signification générale est que, par exemple, si la durée est divisée en vidéos longues et vidéos courtes, la vidéo longue aura une portée estimée et la vidéo courte aura une portée estimée pour la vidéo courte. Vous pouvez également utiliser la méthode arborescente pour une classification plus détaillée. Les vidéos longues peuvent être divisées en vidéos moyennes et vidéos longues, et les vidéos courtes peuvent également être divisées en vidéos ultra-courtes et vidéos courtes. Bien entendu, il existe également des méthodes qui utilisent uniquement des méthodes de classification pour résoudre l'estimation de la durée, et nous avons également effectué des tests. Au niveau de l'effet global, c'est toujours dans le cadre de la classification. Si on refait une régression, l'effet sera légèrement meilleur. L'estimation d'autres indicateurs interactifs est généralement similaire aux méthodes d'estimation existantes. Lors d'une évaluation hors ligne, AUC et GAUC sont généralement des signaux relativement forts, et actuellement ces deux signaux sont relativement précis.

A2 : Notre système examine principalement les indicateurs en ligne, et hors ligne utilise généralement MAE et RMSE. Mais nous constatons également qu'il existe des différences entre les évaluations hors ligne et en ligne. S'il n'y a pas d'amélioration évidente dans l'évaluation hors ligne, l'effet d'amélioration correspondant peut ne pas être visible en ligne. Parfois, la relation correspondante n'atteint pas un certain niveau de signification. , la différence ne sera pas grande.

A3 : Analyser les raisons pour lesquelles les utilisateurs republient et faire quelques observations peut donner de meilleurs résultats. À l'heure actuelle, lorsque nous effectuons une estimation de transfert, la différence entre la méthode d'estimation pour d'autres cibles interactives sous notre lien n'est pas trop grande. Il existe une idée plus générale selon laquelle la définition de l'étiquette, en particulier la définition du signal de rétroaction négatif, affectera grandement la précision de la formation du modèle. À cela s’ajoute l’optimisation des sources de données. Le fait que les données et la distribution en ligne soient biaisées affectera également la précision des prévisions, c’est pourquoi une grande partie de notre travail porte également sur le débiaisation. Parce que dans le scénario de recommandation, de nombreux indicateurs estimés sont en fait des signaux indirects, ce qui affectera l'effet de la recommandation à l'étape suivante. Par conséquent, l’optimisation des indicateurs en fonction des effets des recommandations est notre scénario d’application.

A4 : Dans la fusion multi-objectifs, il existe au début quelques méthodes heuristiques et quelques méthodes manuelles d'équilibrage des paramètres. Plus tard, j'ai progressivement commencé à utiliser la méthode d'ajustement des paramètres et j'ai également essayé d'ajuster les paramètres pour l'apprentissage par renforcement. L'expérience actuelle montre que l'ajustement automatique de la référence est meilleur que l'ajustement manuel et que sa limite supérieure est légèrement plus élevée.

A5 : Nous avons récemment eu des signaux selon lesquels les discussions de travail sont extrêmement rares et les retours ne prennent que quelques jours. L'un des signaux les plus courants est la rétention des utilisateurs, car les utilisateurs peuvent partir quelques jours avant de revenir. Ainsi, au moment où nous recevons le signal, le modèle a été mis à jour depuis plusieurs jours. Il existe quelques compromis pour résoudre ces problèmes. Une solution consiste à analyser quels signaux de rétroaction en temps réel ont une certaine corrélation avec ce signal extrêmement clairsemé. En optimisant ces signaux en temps réel, une combinaison de méthodes est utilisée pour optimiser indirectement les signaux à long terme. En prenant la rétention comme exemple, dans notre système, nous avons constaté qu'il existe une très forte corrélation positive entre la rétention de l'utilisateur et le temps de visionnage en temps réel de l'utilisateur. Le temps de visionnage de l'utilisateur représente la viscosité de l'utilisateur avec le système, ce qui peut essentiellement être le cas. garantir la limite inférieure de rétention des utilisateurs. Lorsque nous optimisons la rétention, nous utilisons généralement la durée d'optimisation combinée à d'autres indicateurs associés pour optimiser la rétention. Tant que notre analyse révèle qu’il existe une certaine corrélation avec la rétention, nous pouvons l’introduire.

A6 : La critique d'acteur est le résultat après plusieurs itérations. Nous avons également essayé des méthodes légèrement plus intuitives telles que DQN et Reinforce. Certaines d'entre elles sont effectivement efficaces dans certains scénarios, mais actuellement, la critique d'acteur est relativement stable. un. Et un bon moyen de déboguer. Par exemple, l'utilisation de Reinforce nécessite l'utilisation de signaux à long terme, et le signal de trajectoire à long terme est relativement volatil, il sera donc plus difficile d'améliorer sa stabilité. Mais l’un des avantages de la critique d’acteur est qu’elle peut optimiser sur la base de signaux en une seule étape, ce qui est une fonctionnalité très cohérente avec les systèmes de recommandation. Nous espérons que les commentaires de chaque utilisateur pourront être utilisés comme exemple de formation pour apprendre, et que les méthodes de critique d'acteur et DDPG correspondantes seront très cohérentes avec les paramètres de notre système.

A7 : L'identifiant utilisateur n'est en fait pas mauvais, car nos fonctionnalités côté utilisateur utilisent toujours diverses fonctionnalités. En plus des caractéristiques d'identification, l'utilisateur possède également certaines caractéristiques statistiques. De plus, sur le lien de recommandation, étant donné que RL est à un stade relativement avancé dans les modules que nous appliquons, tels que le classement fin et le réarrangement, les estimations et les signaux de classement des modèles seront également donnés dans les étapes précédentes. dedans. Par conséquent, l'apprentissage par renforcement obtient toujours de nombreux signaux côté utilisateur dans les scénarios recommandés, et fondamentalement, il n'y aura aucune situation dans laquelle un seul ID utilisateur est utilisé.

A8 : Oui, et nous avons constaté que si l'identifiant utilisateur n'est pas utilisé, l'impact sur la personnalisation est assez important. Si vous n'utilisez que certaines caractéristiques statistiques des utilisateurs, l'effet d'amélioration n'est parfois pas aussi important que celui d'un identifiant utilisateur. Il est vrai que l'impact de l'ID utilisateur est relativement important, mais si l'impact est trop important, il y aura des problèmes de volatilité.

A9 : Ce problème est orienté vers le démarrage à froid de l'utilisateur. Dans les scénarios de démarrage à froid, les liens recommandés sont généralement remplis de fonctionnalités d'achèvement ou d'automatisation. En supposant d'abord qu'il s'agit d'un utilisateur par défaut, ce problème peut être résolu dans une certaine mesure. Plus tard, à mesure que l'utilisateur continue d'interagir avec le système et que la session continue de s'enrichir, nous pouvons effectivement obtenir un certain nombre de commentaires des utilisateurs, et la formation deviendra progressivement de plus en plus précise. En termes d'assurance de la stabilité, tant que vous contrôlez bien et empêchez un identifiant utilisateur de dominer la formation, vous pouvez toujours améliorer l'effet du système.

A10 : Ce travail consiste à effectuer directement le bucketing, puis à utiliser la probabilité d'arrivée de chaque bucket pour évaluer conjointement la durée, au lieu de faire une régression après le bucketing. Il utilise uniquement la probabilité de regroupement, plus la valeur du regroupement pour effectuer une évaluation globale de la probabilité. La régression après le regroupement ne devrait en effet plus être impartiale. Après tout, chaque compartiment a toujours son propre modèle de distribution.

A11 : Il ne s'agit en fait plus d'une optimisation multi-objectifs. L'indicateur CTR peut même être directement utilisé comme entrée pour optimiser le CPR, car le CTR n'est plus un objectif d'optimisation. Mais cela peut ne pas être bon pour les utilisateurs, car le CTR de l'utilisateur représente dans une plus grande mesure la préférence et la rigidité du système. Cependant, différents systèmes peuvent différer selon que le système de recommandation est axé sur la vente de produits ou sur le trafic. Étant donné que les courtes vidéos de Kuaishou sont principalement basées sur le trafic, le CTR de l'utilisateur est un indicateur plus intuitif et plus important, et le CVR n'est qu'un effet après le détournement du trafic.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Introduction à l'utilisation du code complet VBS

Introduction à l'utilisation du code complet VBS

Comment basculer entre pleine largeur et demi-largeur

Comment basculer entre pleine largeur et demi-largeur

Comment afficher deux divs côte à côte

Comment afficher deux divs côte à côte

Trois méthodes d'encodage couramment utilisées

Trois méthodes d'encodage couramment utilisées

Une liste complète des touches de raccourci d'idées

Une liste complète des touches de raccourci d'idées

architecture c/s et architecture b/s

architecture c/s et architecture b/s

Quelle est la différence entre mysql et mssql

Quelle est la différence entre mysql et mssql

Quelles sont les principales fonctions de Redis ?

Quelles sont les principales fonctions de Redis ?