La sortie de ChatGPT a bouleversé l'ensemble du domaine de l'IA, et les grandes entreprises technologiques, les startups et les équipes universitaires emboîtent le pas. Récemment, Heart of the Machine a rendu compte des résultats de recherche de nombreuses startups et équipes universitaires.

Hier, un autre modèle de dialogue national à grande échelle sur l'IA a fait ses débuts : ChatGLM, l'IA à spectre intelligent de l'entreprise transformée à partir des réalisations technologiques de Tsinghua et basée sur le modèle de base GLM-130B de 100 milliards, est désormais ouverte sur invitation uniquement. tests internes.

Il convient de mentionner que Zhipu AI a également open source le modèle de dialogue bilingue chinois-anglais ChatGLM-6B, qui prend en charge l'inférence sur une seule carte graphique grand public.

Site Web de l'application bêta interne : chatglm.cn

Il est entendu que l'amélioration des capacités de la version actuelle de ChatGLM provient principalement du modèle de base unique de 100 milliards GLM-130B . C'est une architecture différente de BERT, GPT-3 et T5. C'est un modèle de pré-entraînement autorégressif contenant des fonctions multi-objectifs.

En août 2022, l'Université Tsinghua et Zhipu AI ont ouvert le modèle dense bilingue chinois-anglais GLM-130B avec 130 milliards de paramètres à la communauté de recherche et à l'industrie. Ce modèle présente des avantages uniques :

Maintenant, en se référant aux idées de conception de ChatGPT, ChatGLM a injecté une pré-formation de code dans le modèle de base du GLM-130B pour parvenir à l'alignement des intentions humaines grâce à des technologies telles que le réglage fin supervisé.

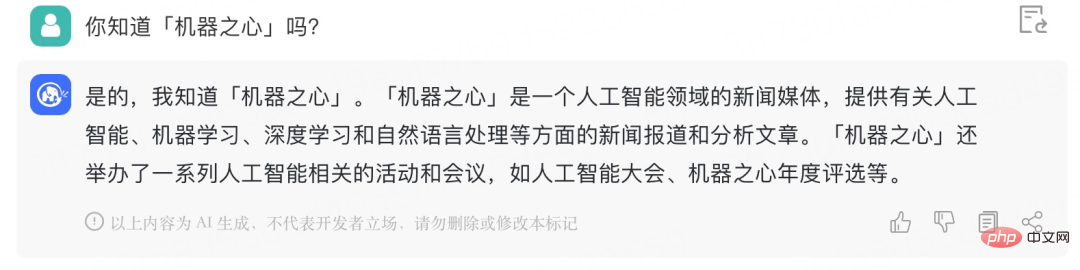

Heart of the Machine a obtenu le code d'invitation pour la bêta fermée Voici une simple conversation avec ChatGLM, l'effet est le suivant :

Il peut comprendre le sens réel de "Station. CP":

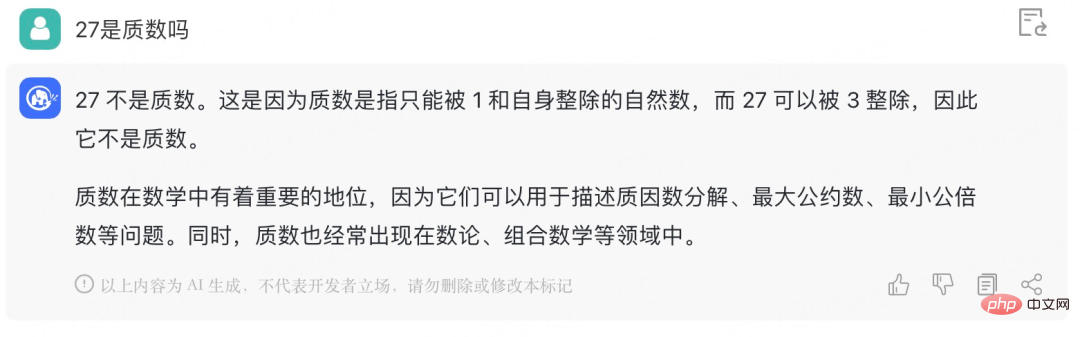

Give ChatGLM Essayez un problème mathématique :

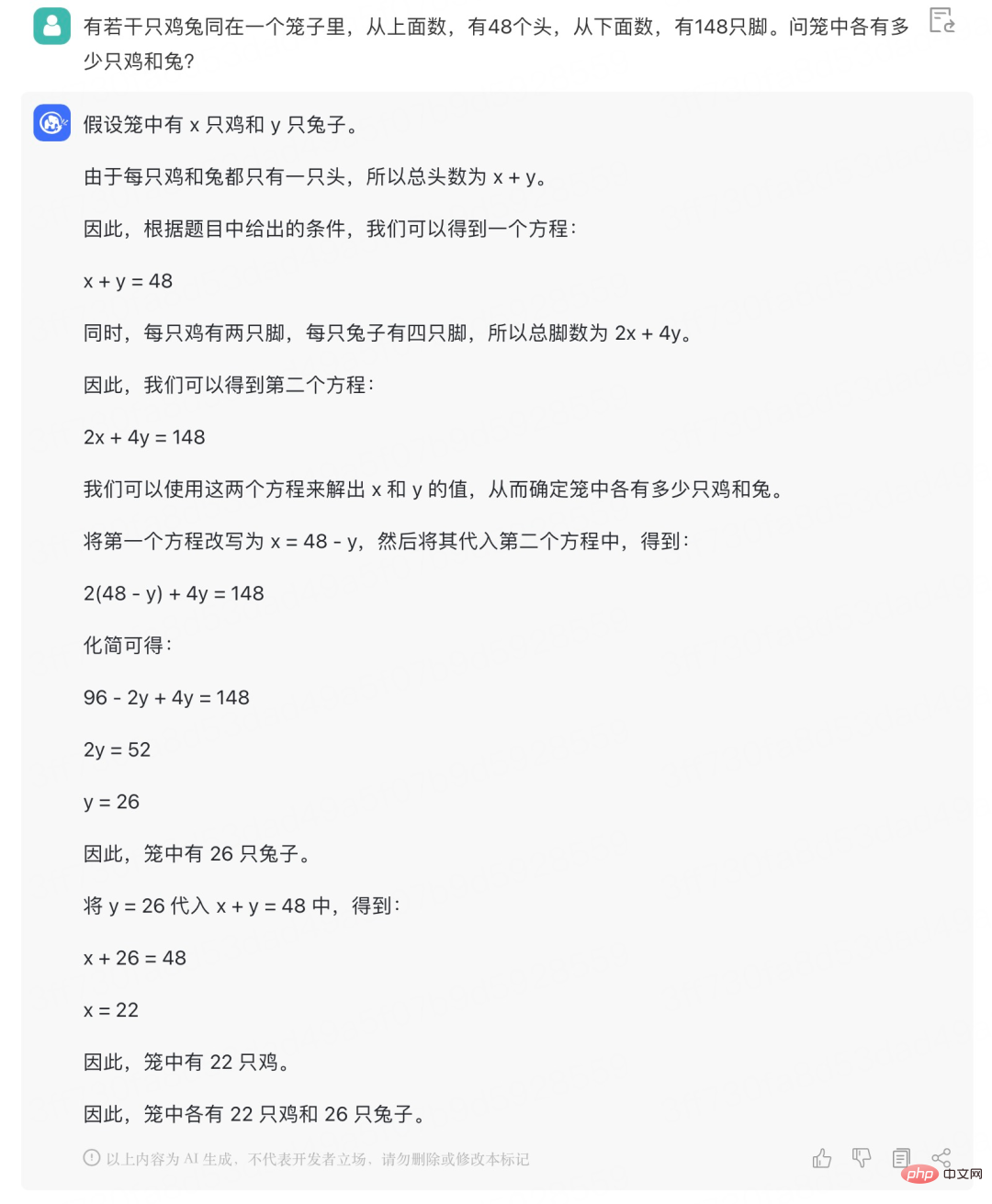

Depuis l'apprentissage de l'équation linéaire de deux variables, les problèmes de base "poulet et lapin dans la même cage" comme celui-ci ne peuvent plus le déranger :

ChatGLM-6B est un modèle de langage de dialogue open source qui prend en charge les questions et réponses bilingues en chinois et en anglais et est optimisé pour le chinois. Le modèle est basé sur l'architecture General Language Model (GLM) et comporte 6,2 milliards de paramètres. Combiné à la technologie de quantification de modèle, les utilisateurs peuvent le déployer localement sur des cartes graphiques grand public (un minimum de 6 Go de mémoire vidéo est requis au niveau de quantification INT4). ChatGLM-6B utilise la même technologie que ChatGLM et est optimisé pour les questions et réponses et le dialogue en chinois. Après une formation bilingue en chinois et en anglais avec environ 1T d'identifiants, complétée par un réglage fin supervisé, un libre-service de rétroaction, un apprentissage par renforcement par rétroaction humaine et d'autres technologies, le paramètre ChatGLM-6B de 6,2 milliards, bien que pas aussi grand que le modèle de 100 milliards, a considérablement réduit le coût d'inférence et s'est amélioré. Il a amélioré l'efficacité et peut déjà générer des réponses tout à fait cohérentes avec les préférences humaines.

Modèle d'adresse open source : https://github.com/THUDM/ChatGLM-6B

# 🎜🎜#Plus précisément, ChatGLM-6B présente les fonctionnalités suivantes :

Cependant, en raison de la petite capacité du modèle ChatGLM-6B, il existe inévitablement certaines limitations et lacunes, notamment : #🎜 🎜#

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Tendances des prix des Eth aujourd'hui

Tendances des prix des Eth aujourd'hui

Quelle est l'adresse du site Internet de Ouyi ?

Quelle est l'adresse du site Internet de Ouyi ?

Comment utiliser la fonction d'impression en python

Comment utiliser la fonction d'impression en python

Comment importer des données dans Access

Comment importer des données dans Access

Plateforme nationale d'achat et de vente de Bitcoin

Plateforme nationale d'achat et de vente de Bitcoin

Comment résoudre le problème selon lequel le partage réseau d'ordinateurs portables n'a pas d'autorisations ?

Comment résoudre le problème selon lequel le partage réseau d'ordinateurs portables n'a pas d'autorisations ?

Quel est le nom de l'application de télécommunications ?

Quel est le nom de l'application de télécommunications ?

Que fait Xiaohongshu ?

Que fait Xiaohongshu ?