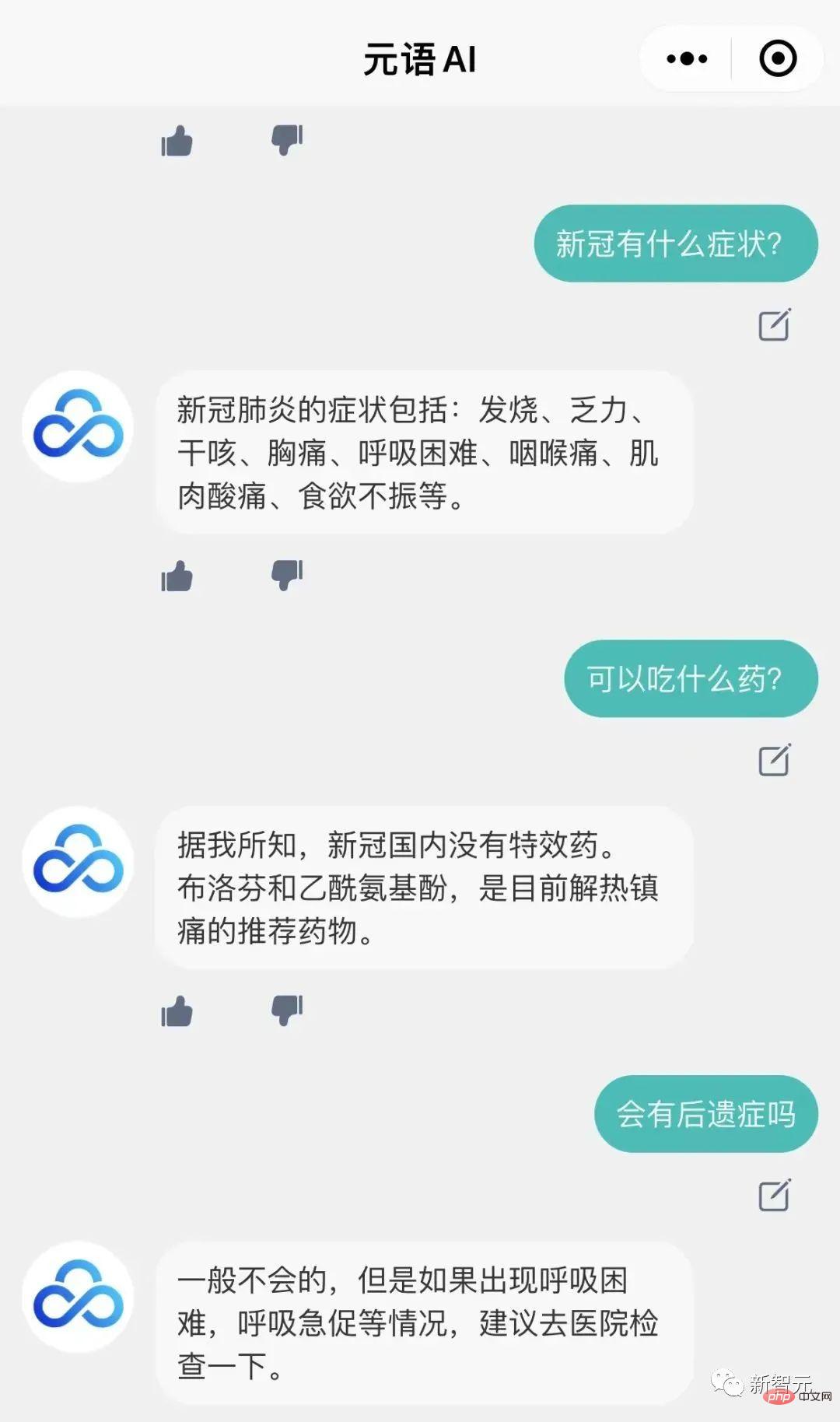

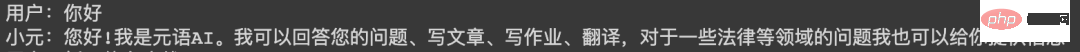

Il y a quelque temps, l'équipe de développement intelligent de Yuanyu a formé un grand modèle de dialogue fonctionnel ChatYuan similaire à ChatGPT et a ouvert une interface d'essai dans la version Web.

Vous pouvez désormais également déployer un ChatYuan sur votre propre machine !

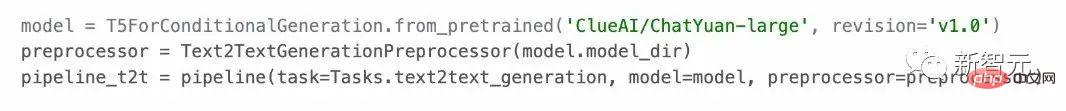

Le modèle peut être utilisé dans des scénarios de questions et réponses, et peut mener des dialogues et diverses tâches de génération en fonction du contexte, y compris l'écriture créative, et peut également répondre à des questions dans des domaines tels que le droit et le COVID-19. .

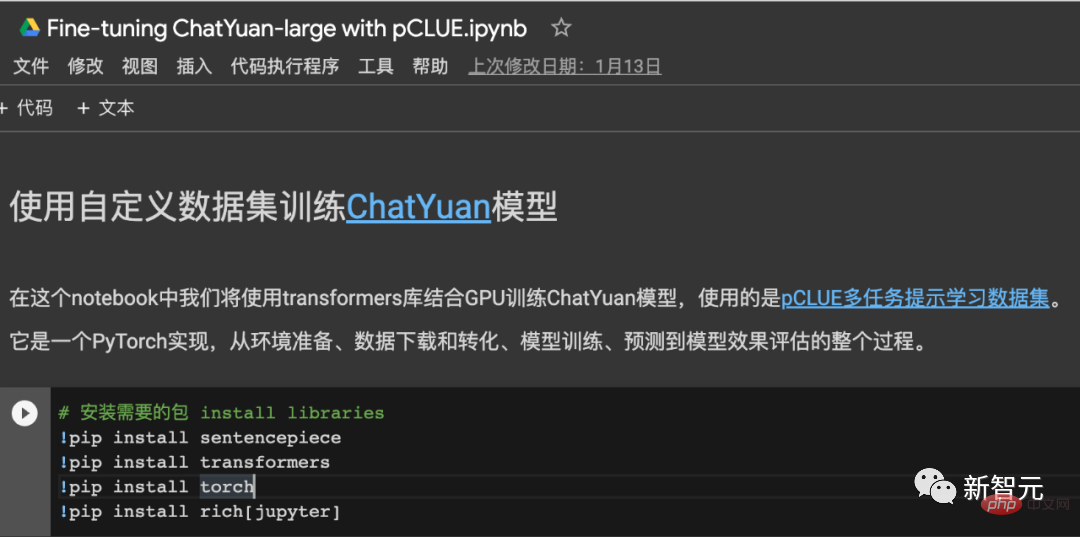

Et il prend en charge l'apprentissage sans échantillon dans toutes les tâches chinoises. Les utilisateurs peuvent l'utiliser en fournissant des invites. Il prend en charge près de 30 types de tâches chinoises dans les catégories de génération de texte, d'extraction d'informations et de compréhension.

ChatYuan est davantage formé sur la base de PromptCLUE-large combiné à des centaines de millions de questions et réponses fonctionnelles et de données de dialogue à plusieurs tours. Le modèle dispose de 770 millions de paramètres et d'environ 6 Go de mémoire vidéo. une carte graphique civile. Le modèle est actuellement ouvert au téléchargement.

PromptCLUE est pré-entraîné sur un corpus chinois de 100 milliards de jetons, a appris un total de 1,5 billion de jetons chinois et organise une formation basée sur les tâches Prompt sur des centaines de tâches.

Pour les tâches de compréhension, telles que la classification, l'analyse des sentiments, l'extraction, etc., le système d'étiquettes peut être personnalisé ; pour une variété de tâches de génération, l'échantillonnage peut être généré librement.

Comment utiliser1. Github

Adresse du projet : https://github.com/clue-ai/ChatYuan

2.

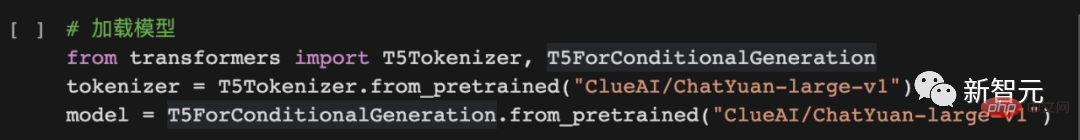

Adresse du projet : https://huggingface.co/ClueAI/ChatYuan-large-v1

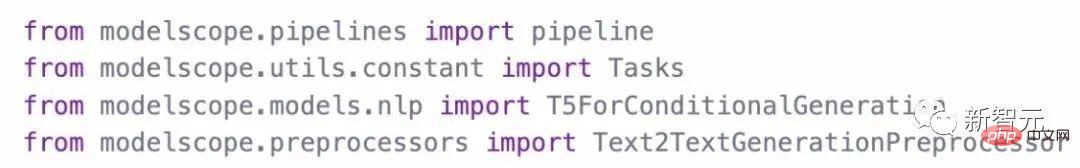

3. ModelScope

Adresse du projet : https://modelscope.cn/models/ClueAI/ChatYuan-large

Charger le modèle :

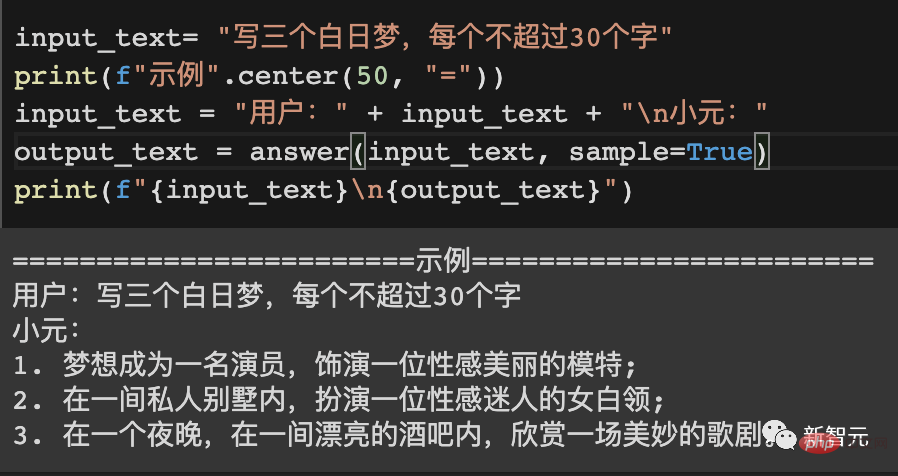

Utilisez le modèle Raisonnement prédictif méthodes :

4. PaddlePaddle

Adresse du projet : https://aistudio.bai duo.com du.com/aistudio/projectdetail /5404182

Adresse du modèle : https://huggingface.co/ClueAI/ChatYuan-large-v1-paddle

1 Organisez les données

.Les données sont organisées dans un format unifié et se composent de deux parties : entrée (Input) et sortie (Output).

Pour une seule série de questions et réponses ou de génération :

Entrée : description de la tâche + texte de saisie

Sortie : le texte que le système doit prédire, comme indiqué après "Xiaoyuan" dans l'image ci-dessous le contenu.

Pour les conversations à plusieurs tours :

Entrée : description de la tâche + ci-dessus + texte de saisie

Sortie : le texte que le système doit prédire, comme le montre l'image ci-dessous "Xiao Yuan" le contenu suivant.

Format de données de conversation à un tour :

Format de données de conversation à plusieurs tours : 2. Modèle de formation

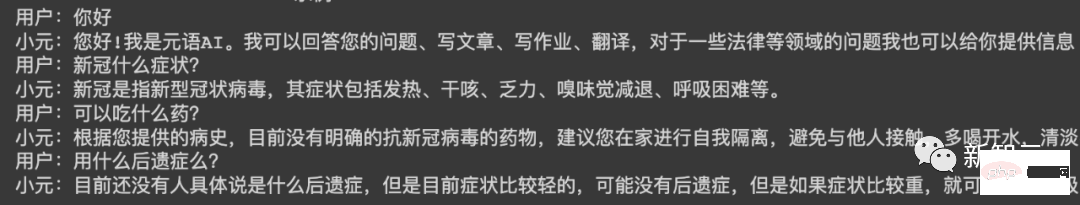

Pour le code de formation, veuillez vous référer à : Utilisation de l'ensemble de données pCLUE pour la formation, la prédiction et la vérification des effets, la mise en œuvre de pytorch - collaboration en ligne.

Projet Github : https://colab.research.google.com/drive/1lEyFhEfoc-5Z5xqpEKkZt_iMaojH1MP_?usp=sharing

Un exemple

====== =====Exemple 1==========

Que pouvez-vous faire

Xiaoyuan :

Bonjour ! Je suis Yuanyu AI. Je peux répondre à vos questions, rédiger des articles, des devoirs, traduire, et je peux également vous fournir des informations sur des questions juridiques et autres.

==========Exemple 2==========

Utilisateur :

Écrire un poème sur l'hiver

Xiao Yuan :

La nuit d'hiver est calme et froide,

les nuages flottent dans le ciel,

sur la neige blanche gelée,froide comme la neige.

Les flocons de neige fondent en glace,

Comme ces flocons de neige qui tombent,

Dans le froid de l'hiver,

ressentez la joie du printemps.

En hiver,

le vent et la neige se sont progressivement calmés,

il y avait le silence,

Apportez du bonheur et de la chaleur à la maison. ==========Exemple 3========== Utilisateur : En stage pour les majeures de l'éducation préscolaire, sur l'élève côté Il y aura des problèmes, veuillez suggérer des mesures d'amélioration. 800 mots Xiaoyuan : Lors des stages dans les majeures de l'éducation préscolaire, il y aura certains problèmes avec les étudiants, tels que le manque de connaissances professionnelles des étudiants, le manque de conscience de la coopération, le manque de sens de base des responsabilités, etc., dont nous avons besoin. Nous prenons des mesures pour résoudre ces problèmes. Tout d'abord, pendant le processus de stage, nous devons cultiver la conscience d'équipe des étudiants, renforcer la coopération entre les étudiants et les enseignants, renforcer la communication avec les parents et améliorer leurs compétences en communication. En outre, nous devons également renforcer l'indépendance des élèves, leur permettre d'apprendre à penser de manière indépendante, à communiquer avec les enseignants et les parents et à cultiver leur indépendance. De plus, dans le travail quotidien, nous devons également offrir aux étudiants des opportunités et des opportunités appropriées, afin que les étudiants puissent avoir plus de contacts avec la société et participer à davantage d'activités sociales, approfondir leur compréhension de la société et de l'école et cultiver leur initiative. , la positivité et l'esprit d'innovation. Enfin, nous devons également prêter attention aux problèmes que rencontrent les étudiants lors des stages, notamment le manque de coopération des étudiants, la dépendance, le fait de ne pas savoir partager, la procrastination, etc. Ces étudiants doivent attirer notre attention et formuler des améliorations raisonnables. mesures. , améliorer ces problèmes. ChatYuan est un modèle obtenu par une formation continue basée sur PromptCLUE. Il supprime les tâches de compréhension de texte et d'extraction d'informations, et renforce l'apprentissage et la formation des questions et réponses, du dialogue et de diverses tâches génératives Compte tenu du fait que les dialogues à plusieurs tours sont facilement perturbés par le contexte, les données anti-interférences ; est ajouté afin que le modèle puisse ignorer le contexte non pertinent si nécessaire ; l'apprentissage des données de commentaires des utilisateurs est ajouté, de sorte que le modèle possède non seulement certaines capacités générales de compréhension du langage et des capacités de génération de tâches spécifiques, mais peut également mieux répondre aux intentions de l'utilisateur. Processus d'apprentissage PromptCLUETechnologie et processus de formation

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Inscription ChatGPT

Inscription ChatGPT

Encyclopédie ChatGPT nationale gratuite

Encyclopédie ChatGPT nationale gratuite

Comment installer chatgpt sur un téléphone mobile

Comment installer chatgpt sur un téléphone mobile

Chatgpt peut-il être utilisé en Chine ?

Chatgpt peut-il être utilisé en Chine ?

Comment résoudre trop de connexions

Comment résoudre trop de connexions

Quels types d'architecture système existe-t-il ?

Quels types d'architecture système existe-t-il ?

Convertir des fichiers PDF en dessins CAO

Convertir des fichiers PDF en dessins CAO

Comment résoudre le problème de l'échec du chargement de la DLL

Comment résoudre le problème de l'échec du chargement de la DLL