Abracadabra !

En termes de modèles 3D générés en 2D, NVIDIA a dévoilé sa recherche autoproclamée de « classe mondiale » : GET3D.

Après un entraînement sur des images 2D, le modèle génère des formes 3D avec des textures haute fidélité et des détails géométriques complexes.

Quelle est sa puissance ?

GET3D doit son nom à sa capacité à générer des maillages 3D texturés explicites.

Adresse papier : https://arxiv.org/pdf/2209.11163.pdf

C'est-à-dire que la forme qu'il crée a la forme d'un maillage triangulaire, tout comme un modèle en papier Idem, recouvert d'un matériau texturé.

La clé est que ce modèle peut générer une variété de modèles de haute qualité.

Par exemple, diverses roues sur les pieds de chaise ; roues de voiture, lumières et fenêtres ; oreilles et cornes d'animaux ; rétroviseurs de moto, textures sur pneus de voiture, vêtements humains... .

; Bâtiments uniques des deux côtés de la rue, différents véhicules qui passent à toute allure et différents groupes de personnes qui passent...

Si vous souhaitez créer le même monde virtuel 3D grâce à la modélisation manuelle, cela prend beaucoup de temps.

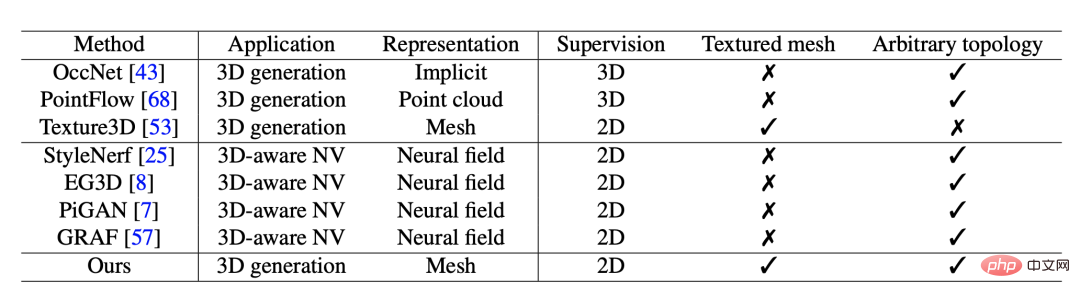

Bien que les précédents modèles d'IA générés en 3D soient plus rapides que la modélisation manuelle, leur capacité à générer des modèles plus riches et détaillés fait toujours défaut.

Même les dernières méthodes de rendu inverse ne peuvent générer que des objets 3D basés sur des images 2D prises sous différents angles, et les développeurs ne peuvent construire qu'un seul objet 3D à la fois.

GET3D est différent.

Les développeurs peuvent facilement importer les modèles générés dans les moteurs de jeu, les modeleurs 3D et les moteurs de rendu de films pour les modifier.

Lorsque les créateurs exportent des modèles générés par GET3D vers des applications graphiques, ils peuvent appliquer des effets d'éclairage réalistes lorsque le modèle bouge ou tourne dans la scène.

Comme le montre l'image :

De plus, GET3D peut également générer des formes guidées par du texte.

En utilisant StyleGAN-NADA, un autre outil d'IA de NVIDIA, les développeurs peuvent ajouter des styles spécifiques aux images à l'aide d'invites de texte.

Par exemple, vous pouvez transformer une voiture rendue en voiture ou en taxi incendié.

Convertissez une maison ordinaire en maison en brique, en maison en feu ou même en maison hantée.

Ou appliquez les caractéristiques des imprimés tigre et panda à n'importe quel animal...

C'est tout simplement "Animal Crossing" des Simpsons...

NVIDIA a introduit que lorsqu'il est entraîné sur un seul GPU NVIDIA, GET3D peut générer environ 20 objets par seconde.

Ici, plus l'ensemble de données d'entraînement à partir duquel il apprend est vaste et diversifié, plus le résultat sera diversifié et détaillé.

NVIDIA a déclaré que l'équipe de recherche a utilisé le GPU A100 pour entraîner le modèle sur environ 1 million d'images en seulement 2 jours.

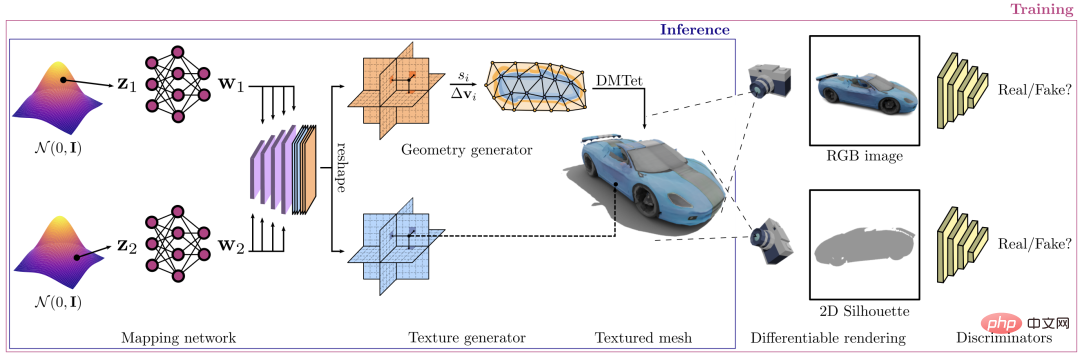

Cadre GET3D, sa fonction principale est de synthétiser des formes tridimensionnelles texturées.

Le processus de génération est divisé en deux parties : la première partie est la branche géométrique, qui peut produire des maillages de surface de n'importe quelle topologie. L'autre partie est la branche texture, qui produit un champ de texture à partir duquel les points de surface peuvent être interrogés.

Pendant le processus de formation, un rastériseur différenciable est utilisé pour restituer efficacement le maillage de texture résultant en une image bidimensionnelle haute résolution. L'ensemble du processus est séparable, permettant un entraînement contradictoire à partir d'images en propageant les gradients du discriminateur 2D.

Après cela, le gradient se propage du discriminateur 2D aux deux branches du générateur.

Les chercheurs ont mené des expériences approfondies pour évaluer le modèle. Ils ont d’abord comparé la qualité des maillages texturés 3D générés par GET3D avec ceux existants générés à l’aide des ensembles de données ShapeNet et Turbosquid.

Ensuite, les chercheurs ont optimisé le modèle dans des études ultérieures sur la base des résultats de la comparaison et ont mené davantage d'expériences.

Le modèle GET3D est capable de séparer les phases en géométrie et en texture.

Comme le montre la figure, la forme générée par le même code caché de géométrie est affichée dans chaque ligne, tandis que le code de texture est modifié.

Affiché dans chaque colonne les formes générées par le même code de masquage de texture lors de la modification du code de géométrie.

De plus, les chercheurs ont inséré le code caché de la géométrie de gauche à droite dans les formes générées par le même code caché de texture dans chaque rangée.

et les formes générées par le même code caché de géométrie tout en insérant le code de texture de haut en bas. Les résultats montrent que chaque interpolation est significative pour le modèle généré.

Dans le sous-graphe de chaque modèle, GET3D est capable de générer des transitions fluides entre les différentes formes dans toutes les catégories.

Dans chaque ligne, perturbez localement le code caché en ajoutant un petit bruit. De cette manière, GET3D est capable de générer localement des formes similaires mais légèrement différentes.

Les chercheurs notent que les futures versions de GET3D pourraient utiliser la technologie d'estimation de la pose de la caméra, permettant aux développeurs de former des modèles sur des données du monde réel plutôt que sur des ensembles de données synthétiques.

À l'avenir, grâce à des améliorations, les développeurs pourront entraîner GET3D sur une variété de formes 3D en une seule fois, au lieu de devoir l'entraîner sur une catégorie d'objets à la fois.

Sanja Fidler, vice-présidente de la recherche sur l'intelligence artificielle chez Nvidia, a déclaré :

GET3D nous rapproche de la démocratisation de la création de contenu 3D basée sur l'IA. Sa capacité à générer des formes 3D texturées à la volée pourrait changer la donne pour les développeurs, les aidant à peupler rapidement les mondes virtuels avec une variété d’objets intéressants.

Le premier auteur de l'article, Jun Gao, est un doctorant dans le groupe d'apprentissage automatique de l'Université de Toronto, et son superviseur est Sanja Fidler.

En plus d'excellentes qualifications académiques, il est également chercheur scientifique au laboratoire d'intelligence artificielle NVIDIA Toronto.

Ses recherches portent principalement sur l'apprentissage profond (DL), dans le but d'un apprentissage de représentations géométriques structurées. Parallèlement, ses recherches tirent également parti de la perception humaine des images et des vidéos 2D et 3D.

Un étudiant si exceptionnel vient de l'Université de Pékin. Il a obtenu un baccalauréat en 2018. À l'Université de Pékin, il a travaillé avec le professeur Wang Liwei.

Après avoir obtenu son diplôme, il a également effectué un stage à l'Université de Stanford, MSRA et NVIDIA.

Les instructeurs de Jun Gao sont également des leaders du secteur.

Fidler est professeure agrégée à l'Université de Toronto et membre du corps professoral du Vector Institute, où elle est également membre cofondatrice.

En plus d'enseigner, elle est également vice-présidente de la recherche en intelligence artificielle chez NVIDIA, dirigeant un laboratoire de recherche à Toronto.

Avant de venir à Toronto, elle était professeure adjointe de recherche au Toyota Institute of Technology de Chicago. L'institut est situé sur le campus de l'Université de Chicago et est considéré comme une institution universitaire.

Les domaines de recherche de Fidler se concentrent sur la vision par ordinateur (CV) et l'apprentissage automatique (ML), en se concentrant sur l'intersection du CV et des graphiques, la vision 3D, la reconstruction et la synthèse 3D et les méthodes interactives d'annotation d'images, etc.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quelle est la différence entre l'écran d'origine et l'écran assemblé ?

Quelle est la différence entre l'écran d'origine et l'écran assemblé ?

Plateforme formelle de trading de devises numériques

Plateforme formelle de trading de devises numériques

commande de renommage de fichier Linux

commande de renommage de fichier Linux

fonction index.html

fonction index.html

Comment supprimer hao.360

Comment supprimer hao.360

fermer le port

fermer le port

Comment installer WordPress après l'avoir téléchargé

Comment installer WordPress après l'avoir téléchargé

Comment changer 3dmax en chinois

Comment changer 3dmax en chinois