原标题: UniOcc: Unifying Vision-Centric 3D Occupancy Prediction with Geometric and Semantic Rendering

请点击以下链接查看论文:https://arxiv.org/pdf/2306.09117.pdf

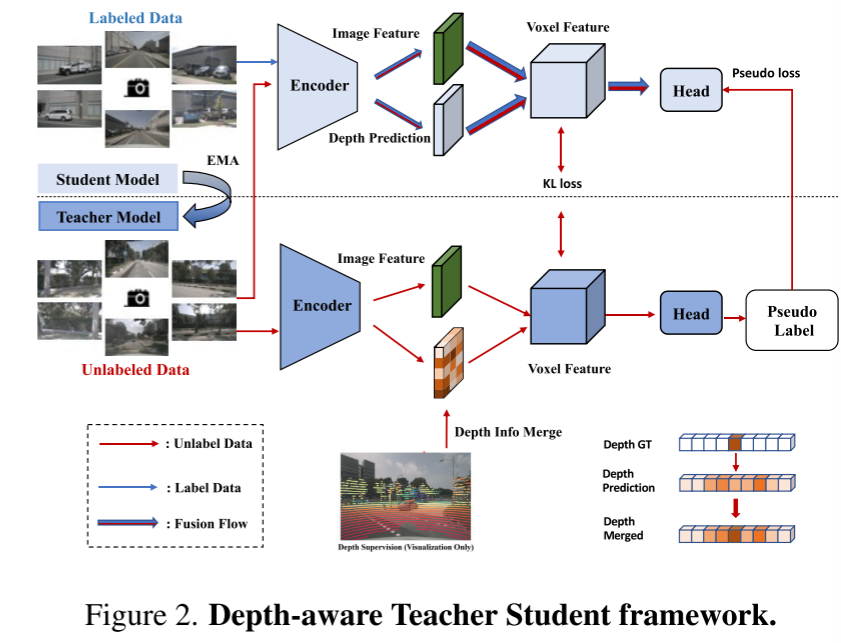

在这篇技术报告中,我们提出了一个名为UniOCC的解决方案,用于在CVPR 2023 nuScenes Open Dataset Challenge中进行以视觉为中心的3D占用预测轨迹。现有的占用预测方法主要专注于使用三维占用标签来优化三维体积空间的投影特征。然而,这些标签的生成过程非常复杂和昂贵(依赖于3D语义标注),并且受到体素分辨率的限制,无法提供细粒度的空间语义。为了解决这个限制,我们提出了一种新的统一占用(UniOcc)预测方法,明确施加空间几何约束,并通过体射线渲染(volume ray rendering)来补充细粒度的语义监督。我们的方法显著提高了模型的性能,并展示了在降低人工标注成本方面的良好潜力。考虑到标注3D占用的费力性,我们进一步提出了深度感知的Teacher Student(DTS)框架,以提高使用无标记数据的预测精度。我们的解决方案在官方单模型排行榜上获得了51.27%的mIoU,在本次挑战赛中排名第三

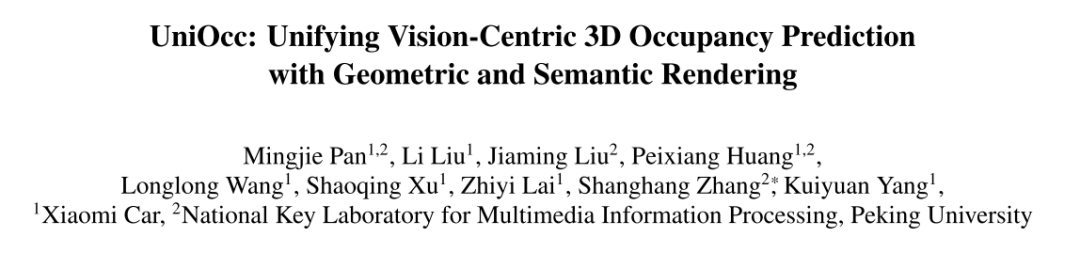

在这一挑战中,本文提出了UniOcc,这是一种利用体渲染(volume rendering)来统一二维和三维表示监督的通用解决方案,改进了多摄像机占用预测模型。本文没有设计新的模型架构,而是将重点放在以通用和即插即用的方式增强现有模型[3,18,20]上。

重新写作如下:本文通过将表示提升到NeRF-style表示[1,15,21],实现了使用体渲染(volume rendering)生成2D语义和深度地图的功能。这使得本文能够在2D像素级别上进行细粒度的监督。通过对三维体素进行射线采样,可以获取渲染的二维像素语义和深度信息。通过显式地集成几何遮挡关系和语义一致性约束,本文提供了模型的显式指导,并确保遵守这些约束

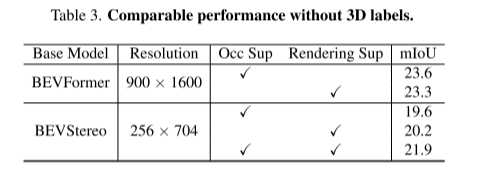

值得一提的是,UniOcc有潜力减少对昂贵的3D语义标注的依赖。在没有3D占用标签的情况下,仅使用本文的体渲染(volume rendering)监督进行训练的模型,甚至比使用3D标签监督进行训练的模型表现更好。这突出了减少对昂贵的3D语义标注的依赖的令人兴奋的潜力,因为场景表示可以直接从负担得起的2D分割标签学习。此外,利用SAM[6]和[14,19]等先进技术,还可以进一步降低二维分割标注的成本。

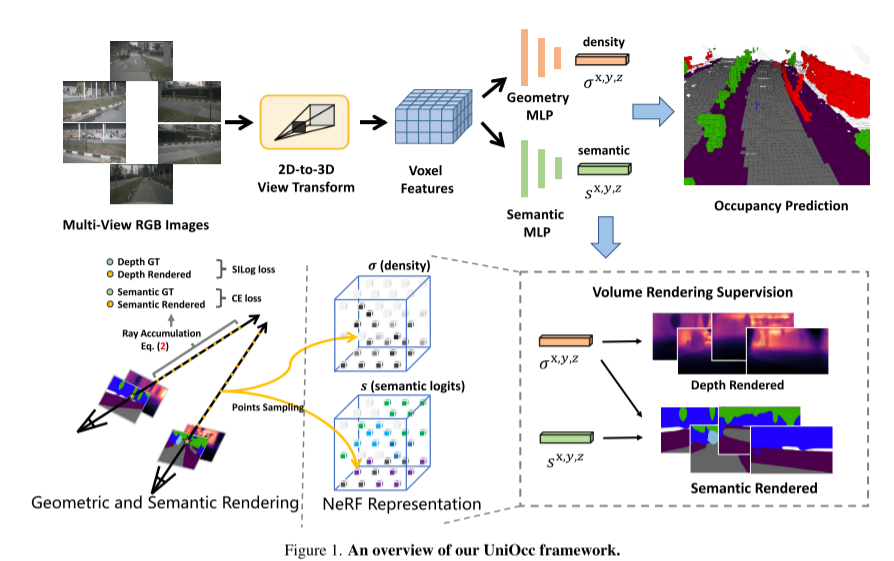

本文还介绍了深度感知师生(DTS)框架,这是一种自我监督的训练方法。与经典的Mean Teacher不同,DTS增强了教师模型的深度预测,在利用无标记数据的同时实现稳定和有效的训练。此外,本文应用了一些简单而有效的技术来提高模型的性能。这包括在训练中使用可见掩模,使用更强的预训练骨干网络,增加体素分辨率,以及实现测试时间数据增强(TTA)

以下是UniOcc框架的概述: 图1

图2。深度感知的Teacher-Student框架。

潘,M.,刘,L.,刘,J.,黄,P.,王,L.,张,S.,徐,S.,赖,Z.,杨,K.(2023)。UniOcc:将几何和语义渲染与视觉为中心的3D占用预测统一起来。ArXiv。/ abs / 2306.09117

原文链接:https://mp.weixin.qq.com/s/iLPHMtLzc5z0f4bg_W1vIg

以上是UniOcc:將以視覺為中心的佔用預測與幾何和語義渲染大一統!的詳細內容。更多資訊請關注PHP中文網其他相關文章!