저는 항상 미국 TV 시리즈를 시청하는 습관을 갖고 있습니다. 한편으로는 영어 듣기를 연습하고 다른 한편으로는 시간을 보냅니다. 예전에는 동영상 웹사이트를 통해 온라인으로 시청할 수 있었지만, 국가광전영화TV총국의 제한 명령으로 인해 미국과 영국의 수입 드라마가 더 이상 예전처럼 동시에 업데이트되지 않는 것 같습니다. 그런데 너드로서 어떻게 드라마를 안 볼 수가 있는데 인터넷으로 확인해 보니 썬더를 이용해 다양한 자료를 마음대로 다운로드 받을 수 있는 미국 드라마 다운로드 사이트인 [Tiantian American Drama]를 찾았습니다. BBC의 고화질 다큐멘터리에 푹 빠졌어요. 자연이 너무 아름다워요.

다운로드 가능한 리소스 사이트를 찾았지만 브라우저를 열 때마다 URL을 입력하고 미국 드라마를 찾아보고 그런 다음 링크를 클릭하여 다운로드하세요. 시간이 오래 지나면 절차가 매우 번거로워지고 때로는 웹사이트 링크가 열리지 않아 약간 번거롭습니다. 저는 우연히 Python 크롤러를 배워왔기 때문에 오늘 웹사이트의 모든 미국 드라마 링크를 가져와 텍스트 문서에 저장하는 크롤러를 작성했습니다. 드라마를 원하면 링크를 열고 Xunlei에 복사하세요. 그것을 다운로드합니다.

사실 원래는 URL을 찾고 요청을 사용하여 다운로드 링크를 열고 크롤링하며 홈페이지부터 전체 사이트를 크롤링하는 메서드를 작성할 계획이었습니다. 하지만 반복되는 링크가 많고, 웹사이트의 URL이 생각보다 규칙적이지 않습니다. 오랫동안 글을 써왔지만 아직 제가 원하는 다양한 종류의 크롤러가 작성되지 않은 것 같습니다. 아직 준비됐으니 계속 열심히 하세요. . .

나중에 알고 보니 기사에 TV 시리즈 링크가 모두 들어 있었고, 기사 URL 뒤에는 http://cn163.net/archives/24016/ 처럼 숫자가 붙어 있어서 제가 예전에 썼던 크롤러 경험을 바탕으로 해결방법은 URL 자동생성인데 뒤에 숫자는 바꿀 수 없나요? 그리고 드라마마다 고유한게 있어서 기사가 몇개나 있는지 찾아봤는데요. , 그런 다음 범위 기능을 사용하여 직접 지속적으로 숫자를 생성하여 URL을 구성합니다.

위 단계의 구현 코드는 다음과 같습니다.

def get_urls(self): try: for i in range(2015,25000): base_url='http://cn163.net/archives/' url=base_url+str(i)+'/' if requests.get(url).status_code == 404: continue else: self.save_links(url) except Exception,e: pass

나머지는 아주 순조롭게 진행되었습니다. 인터넷에서 이전에 누군가가 작성한 유사한 크롤러를 찾았지만 기사가 하나만 크롤링되었으므로 이를 통해 배웠습니다. . 정규 표현식을 살펴보세요. BeautifulSoup을 사용해 보았으나 일반 방법만큼 효과가 좋지 않아 과감히 포기했습니다. 학습에는 한계가 없습니다. 그러나 그 효과는 그리 이상적이지 않습니다. 링크 중 약 절반은 올바르게 크롤링할 수 없으므로 계속해서 최적화해야 합니다.

# -*- coding:utf-8 -*-

import requests

import re

import sys

import threading

import time

reload(sys)

sys.setdefaultencoding('utf-8')

class Archives(object):

def save_links(self,url):

try:

data=requests.get(url,timeout=3)

content=data.text

link_pat='"(ed2k://\|file\|[^"]+?\.(S\d+)(E\d+)[^"]+?1024X\d{3}[^"]+?)"'

name_pat=re.compile(r'<h2>(.*?)</h2>',re.S)

links = set(re.findall(link_pat,content))

name=re.findall(name_pat,content)

links_dict = {}

count=len(links)

except Exception,e:

pass

for i in links:

links_dict[int(i[1][1:3]) * 100 + int(i[2][1:3])] = i#把剧集按s和e提取编号

try:

with open(name[0].replace('/',' ')+'.txt','w') as f:

print name[0]

for i in sorted(list(links_dict.keys())):#按季数+集数排序顺序写入

f.write(links_dict[i][0] + '\n')

print "Get links ... ", name[0], count

except Exception,e:

pass

def get_urls(self):

try:

for i in range(2015,25000):

base_url='http://cn163.net/archives/'

url=base_url+str(i)+'/'

if requests.get(url).status_code == 404:

continue

else:

self.save_links(url)

except Exception,e:

pass

def main(self):

thread1=threading.Thread(target=self.get_urls())

thread1.start()

thread1.join()

if __name__ == '__main__':

start=time.time()

a=Archives()

a.main()

end=time.time()

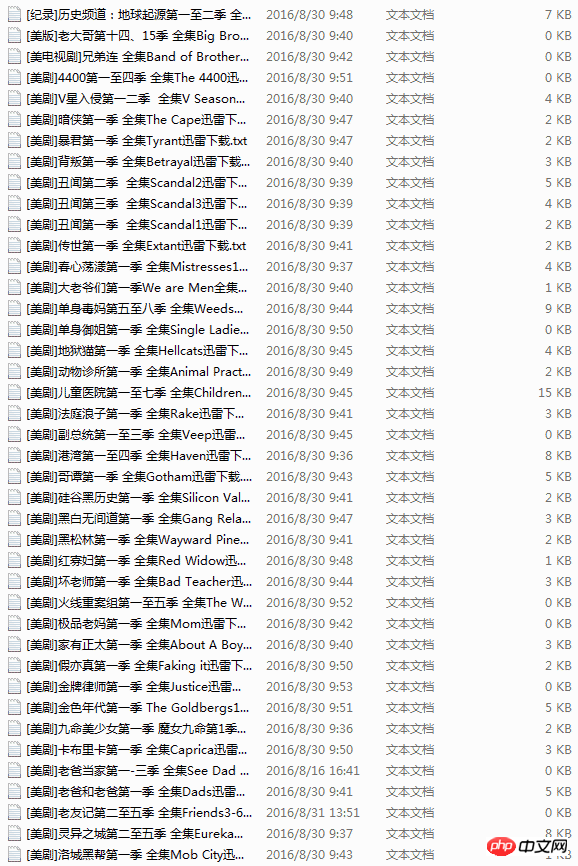

print end-start풀버전 코드도 멀티스레딩을 사용하고 있는데, Python의 GIL 때문에 쓸데없는 느낌이 드는군요. 크롤링을 완료하는 데 오랜 시간이 걸리겠지만, URL 오류와 일치하지 않는 URL을 제외하면 총 크롤링 시간은 20분 미만이었습니다. 원래는 Redis를 사용하여 두 대의 Linux 시스템에서 크롤링하려고 했지만 많은 고민 끝에 불필요하다고 느꼈기 때문에 그대로 두었고 나중에 더 많은 데이터가 필요할 때 사용하겠습니다.

이 과정에서 저를 괴롭혔던 또 다른 문제는 파일 이름 저장이었습니다. txt 텍스트 형식의 파일 이름에는 공백이 포함될 수 있지만 슬래시, 백슬래시 또는 괄호 등은 포함될 수 없습니다. 이게 문제예요. 아침 내내 이것저것 하다가 처음엔 데이터 크롤링에 오류가 있는 줄 알았는데, 한참을 확인해보니 크롤링한 드라마 제목에 슬래시가 들어가 있더군요. 비참한. .

미국 드라마 웹사이트를 크롤링하는 Python 크롤러에 대한 더 많은 기사를 보려면 PHP 중국어 웹사이트를 주목하세요!