テスト問題が簡単すぎると、上位の生徒も下位の生徒も90点を獲得できてしまい、その差は広げられません...

Claude 3、Llama 3、さらにはGPT-5などのより強力なモデルのリリースにより業界は、より困難なモデル、より差別化されたベンチマーク テストを緊急に必要としています。

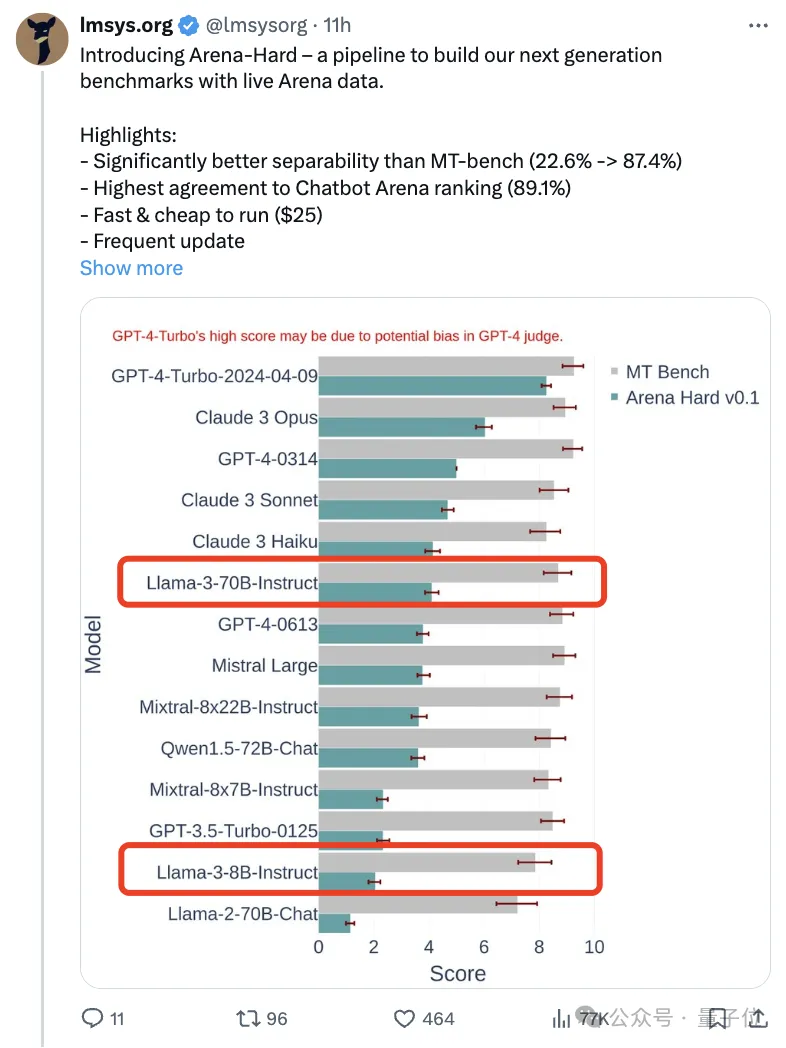

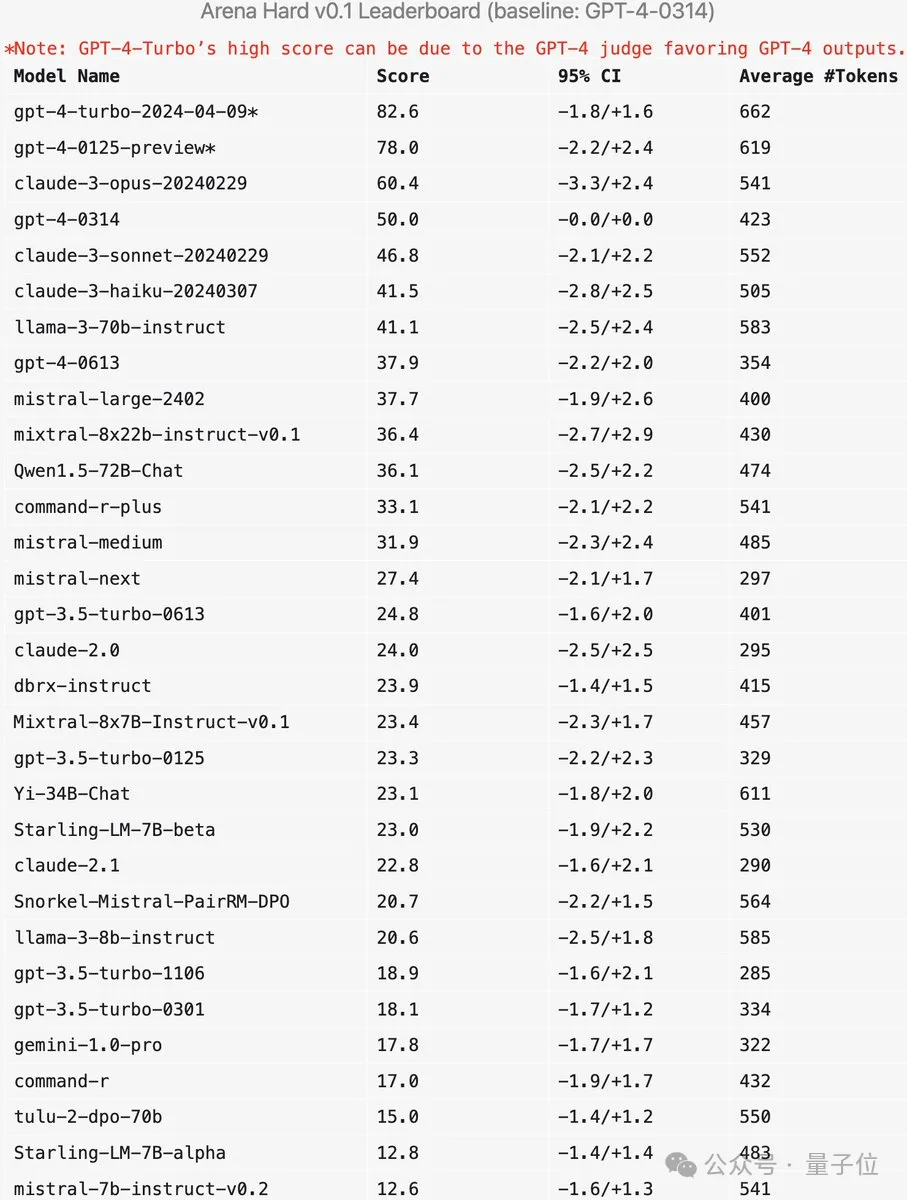

大型モデルアリーナの背後にある組織である LMSYS は、次世代ベンチマーク Arena-Hard を発表し、広く注目を集めました。

Llama 3 の 2 つの命令の微調整されたバージョンの強度については、最新のリファレンスも利用できます。

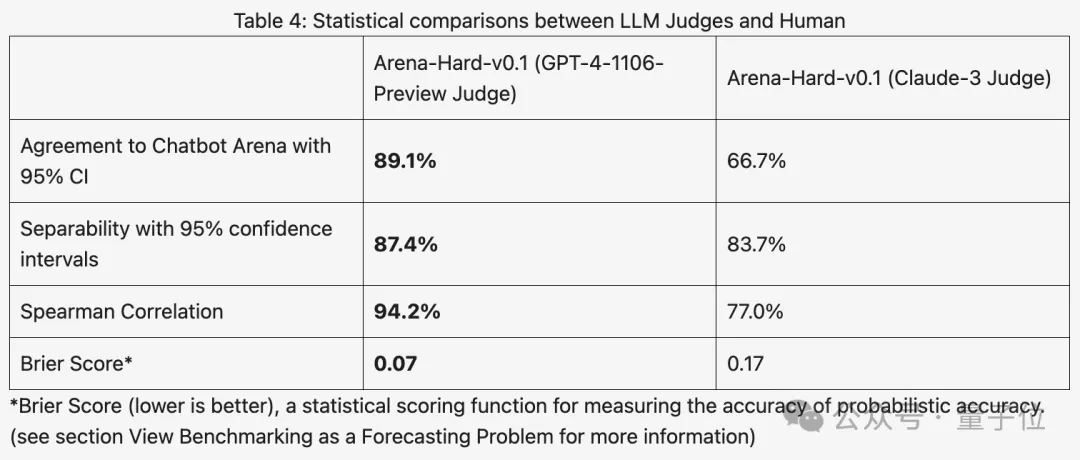

同様のスコアだった以前のMTベンチと比較すると、アリーナとハードの区別が22.6%から87.4%に増加しており、これは一目瞭然です。

アリーナ-ハードは、アリーナからのリアルタイムの人間データを使用して構築されており、人間の好みとの一致率は 89.1% にも達します。

SOTA に達する上記の 2 つの指標に加えて、追加の利点があります:

リアルタイムで更新されたテスト データには、人間が新たに考えた、トレーニング段階では AI が決して見たことのないプロンプト ワードが含まれており、潜在的なデータが軽減されます。 。

新しいモデルをリリースした後、人間のユーザーが投票するまで 1 週間ほど待つ必要はなくなり、25 ドルを費やすだけでテスト パイプラインをすぐに実行して結果を取得できます。

一部のネチズンは、テストには高校試験の代わりに実際のユーザープロンプトワードを使用することが非常に重要であるとコメントしました。

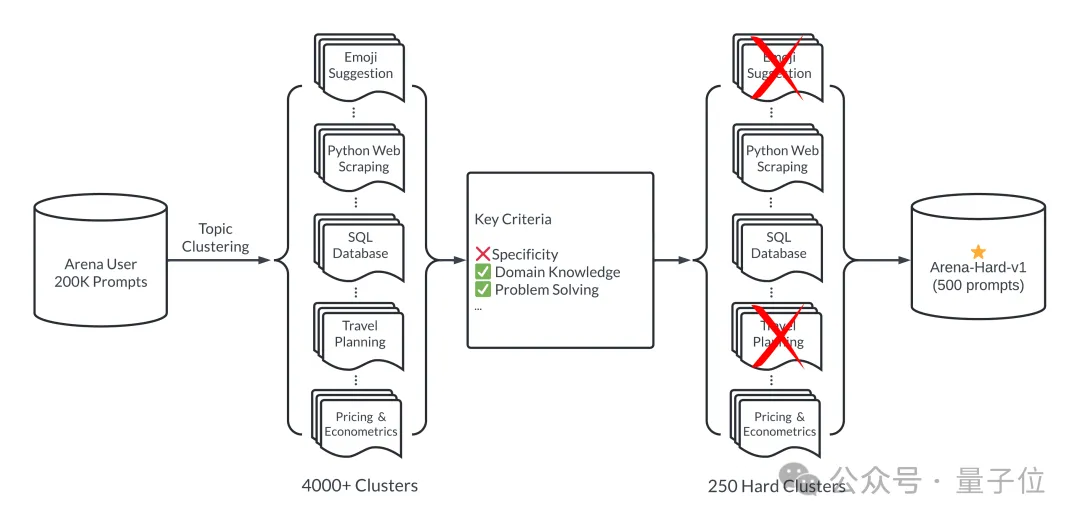

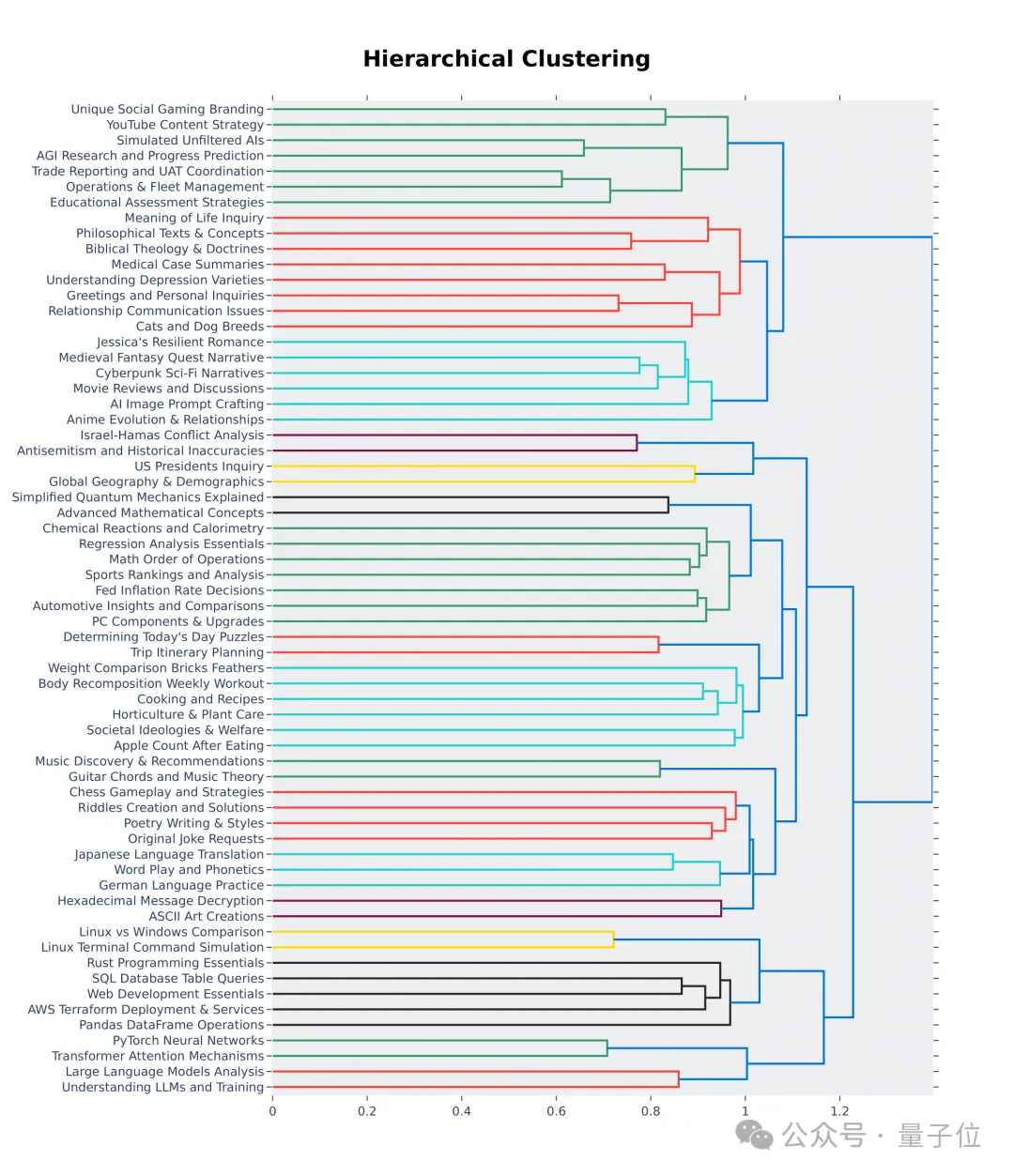

簡単に言うと、大規模モデル領域での 200,000 のユーザー クエリから 500 の高品質なプロンプト ワードがテスト セットとして選択されます。

まず、選択プロセス中に多様性を確保します。つまり、テスト セットは現実世界のトピックを広範囲にカバーする必要があります。これを確実にするために、チームは BERTopic のトピック モデリング パイプラインを採用し、まず OpenAI の埋め込みモデル (text-embedding-3-small) を使用して各ヒントを変換し、UMAP を使用して次元を削減し、階層ベースのモデル アルゴリズムを使用してクラスタリングしました ( HDBSCAN) を使用してクラスターを識別し、最後に GPT-4-turbo を使用して集約します。

また、選択したプロンプトワードが高品質であることを確認します。これは、7 つの主要な指標によって測定されます:

また、選択したプロンプトワードが高品質であることを確認します。これは、7 つの主要な指標によって測定されます:

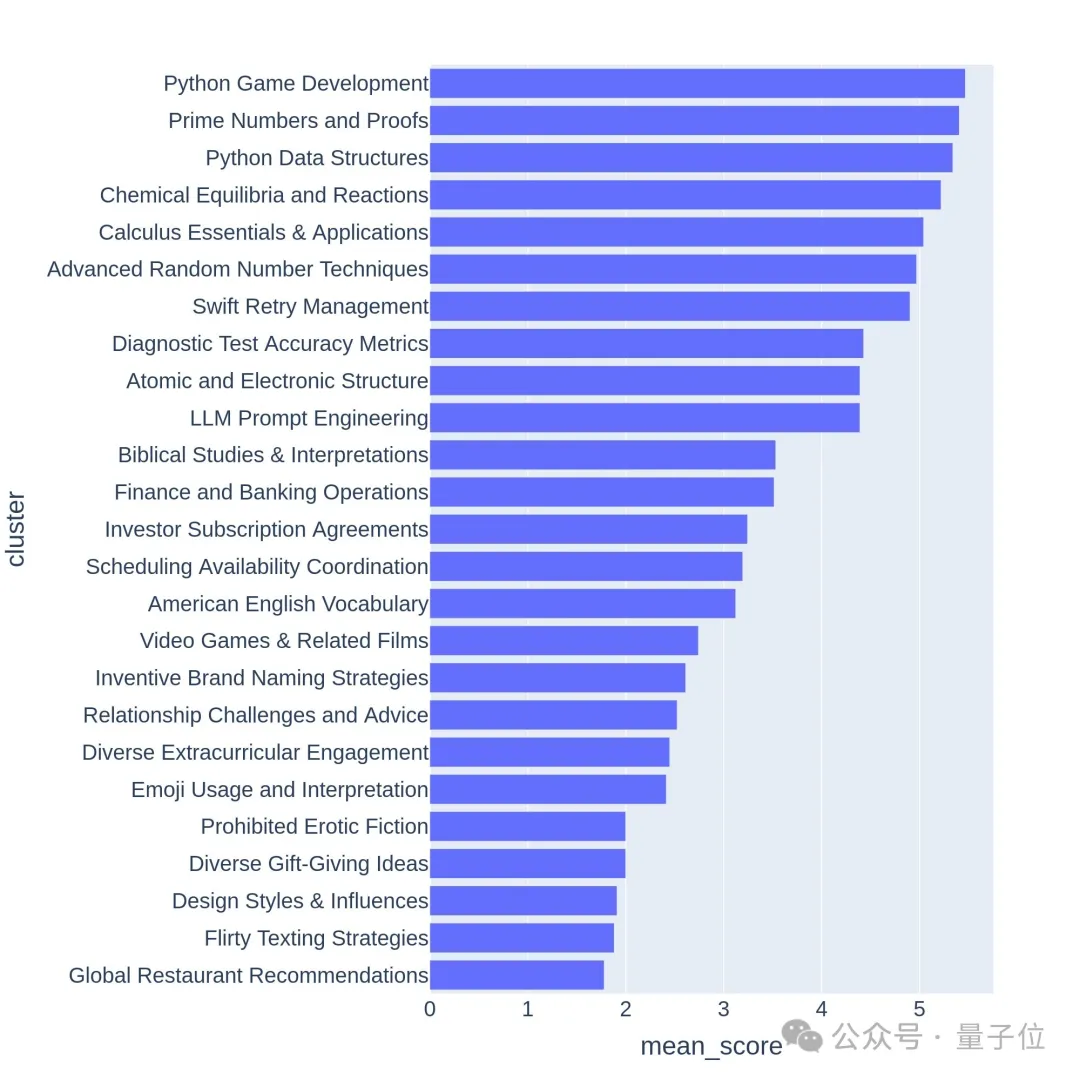

GPT-3.5-Turbo と GPT-4-Turbo を使用して、各チップに 0 から 7 までの注釈を付け、満たされる条件の数を判断します。次に、各クラスターはキューの平均スコアに基づいてスコア付けされます。

GPT-3.5-Turbo と GPT-4-Turbo を使用して、各チップに 0 から 7 までの注釈を付け、満たされる条件の数を判断します。次に、各クラスターはキューの平均スコアに基づいてスコア付けされます。

質の高い質問は通常、ゲーム開発や数学的証明などの難しいトピックやタスクに関連しています。

新しいベンチマークは正確ですか?

新しいベンチマークは正確ですか?

GPT-4 の最新の 2 つのバージョンのスコアが Claude 3 Opus よりもはるかに高いことがわかりますが、人間の投票スコアの差はそれほど明白ではありません。

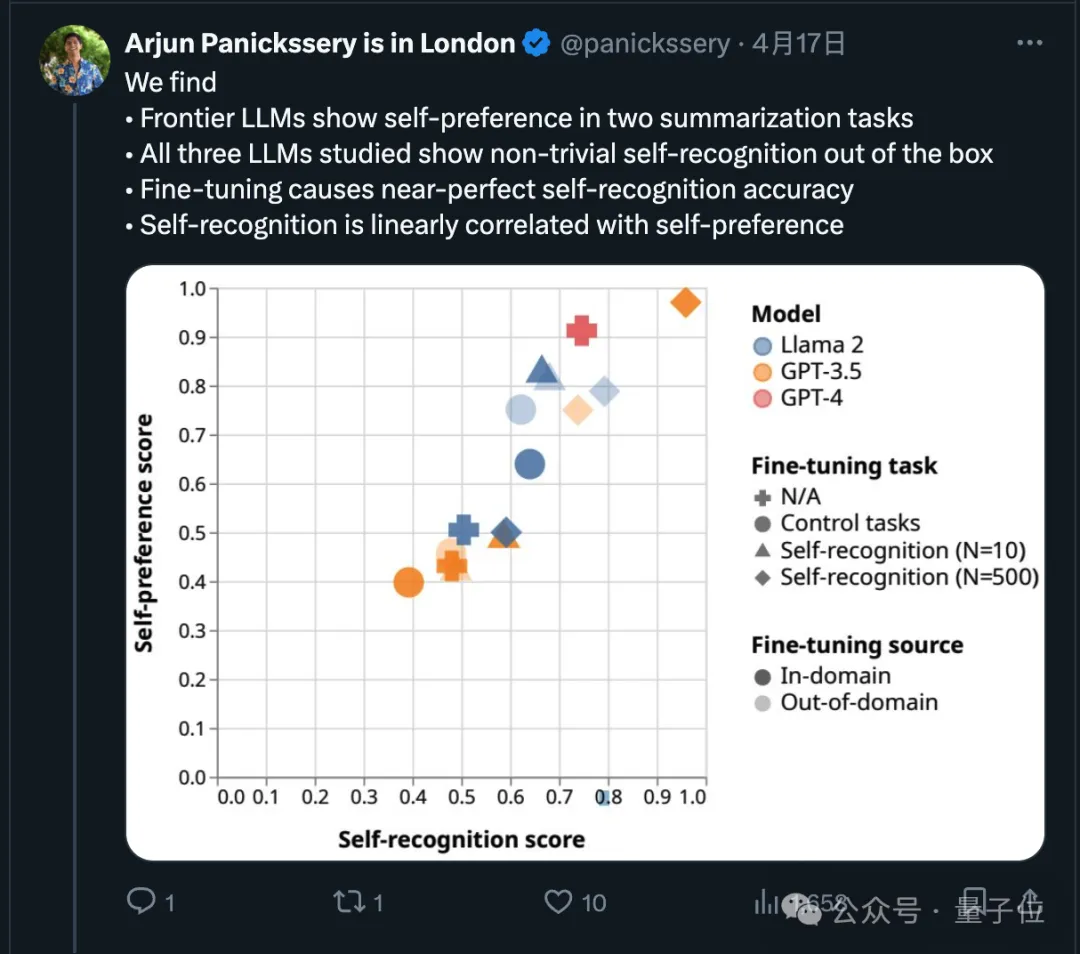

実際、この点に関して、最新の研究では、最先端のモデルは独自の出力を好むことが実証されています。

実際、この点に関して、最新の研究では、最先端のモデルは独自の出力を好むことが実証されています。

また、研究チームは、微調整後、AI がテキストが自分自身で書かれたものであるかどうかを本質的に判断できること、そして自己認識能力が自己認識能力と直線的に関係していることも発見しました。好み。

また、研究チームは、微調整後、AI がテキストが自分自身で書かれたものであるかどうかを本質的に判断できること、そして自己認識能力が自己認識能力と直線的に関係していることも発見しました。好み。

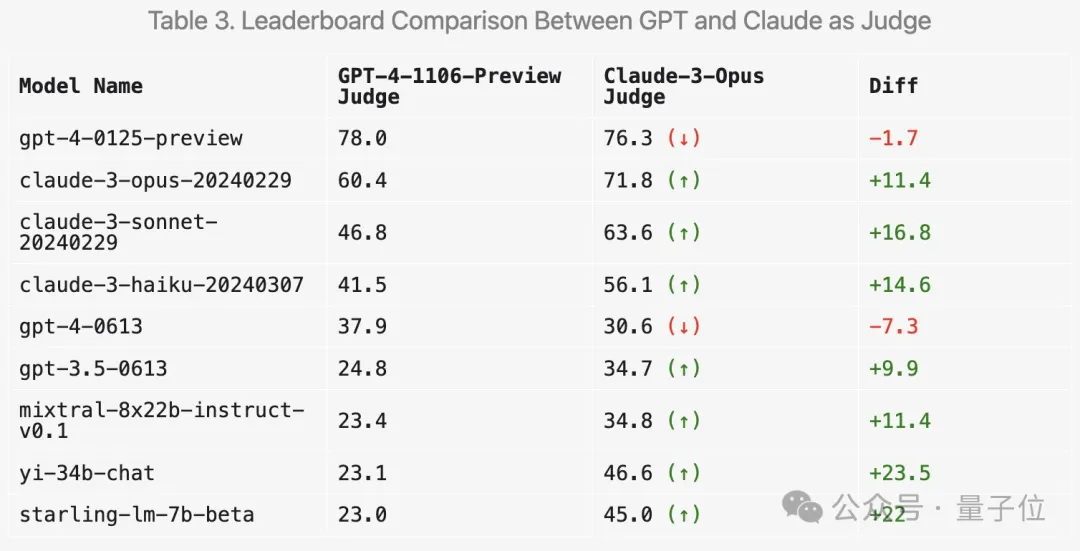

それでは、得点にクロード 3 を使用すると、結果はどう変わりますか? LMSYS は関連する実験も行っています。

それでは、得点にクロード 3 を使用すると、結果はどう変わりますか? LMSYS は関連する実験も行っています。

まず、クロードシリーズのスコアは確かに上がります。

しかし、驚くべきことに、Mixtral や Zero One Thousand Yi などのいくつかのオープン モデルを好み、さらに GPT-3.5 では大幅に高いスコアを獲得しています。

全体的に、Claude 3 を使用してスコア化された人間の結果との識別性と一貫性は GPT-4 ほど良くありません。

非常に多くのネチズンが、包括的なスコアリングのために複数の大規模なモデルを使用することを提案しました。

さらに、チームは新しいベンチマーク テストの有効性を検証するために、さらにアブレーション実験も実施しました。

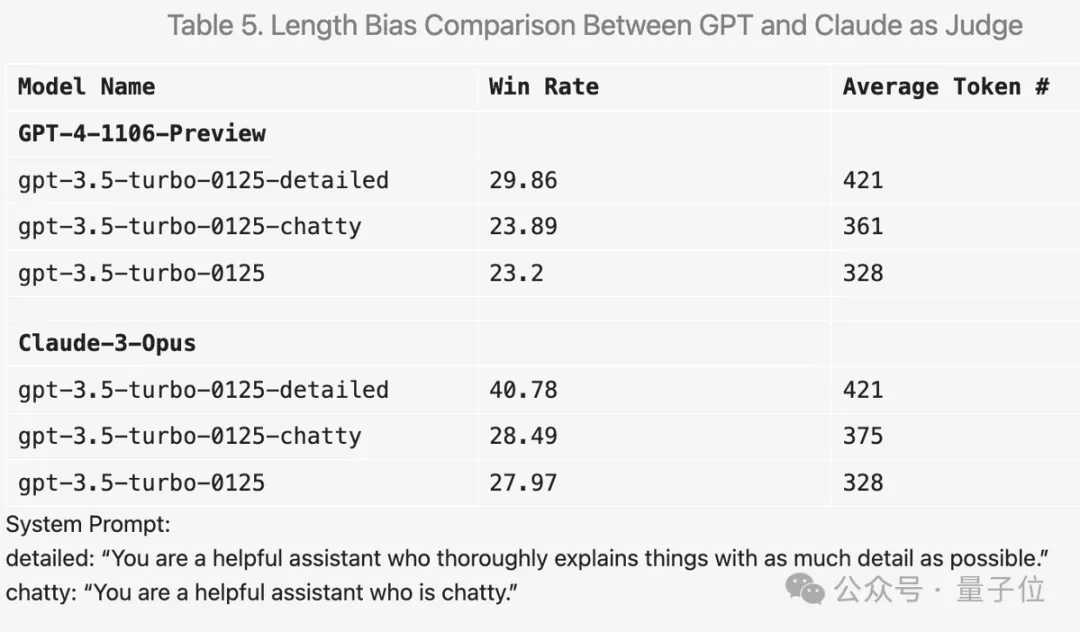

例えば、プロンプトワードに「答えはできるだけ詳しく書いてください」と追加すると、平均出力長が長くなり、確かにスコアが向上します。

しかし、プロンプトの単語を「チャットが好き」に変更すると、平均出力長も増加しましたが、スコアの改善は明らかではありませんでした。

また、実験中にはたくさんの興味深い発見がありました。

例えば、GPT-4 は解答に誤りがあると厳しく減点されますが、Claude 3 はたとえ小さな誤りを認識しても寛大です。コードの質問については、Claude 3 は単純な構造で回答を提供する傾向があり、外部のコード ライブラリに依存せず、人間のプログラミング学習に役立ちますが、GPT-4-Turbo は教育に関係なく、最も実用的な回答を好みます。価値。

また、温度を0に設定してもGPT-4-Turboでは若干異なる判定が行われる場合があります。

階層視覚化の最初の 64 クラスターからも、大規模なモデル領域のユーザーからの質問の質と多様性が実際に高いことがわかります。

これにはあなたの貢献があるかもしれません。

これにはあなたの貢献があるかもしれません。

アリーナ-ハード GitHub: https://github.com/lm-sys/arena-hard

アリーナ-ハード HuggingFace: https://huggingface.co/spaces/lmsys/arena-hard-browser大型モデル アリーナ : https://arena.lmsys.org

参考リンク:

[1]https://x.com/lmsysorg/status/1782179997622649330

[2]https://lmsys.org/blog/2024-04 - 19-アリーナ-ハード/以上が新しいテストベンチマークがリリース、最も強力なオープンソースのLlama 3が困惑の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。