現在、自動運転システム全体において、道路を走行するときに認識モジュールが重要な役割を果たします 自動運転車の後にのみ認識モジュールを通じて正確なセンシング結果を取得し、自動運転システムの下流の制御モジュールはタイムリーで正しい判断と行動決定を行うことができます。現在、自動運転機能を備えた自動車には通常、サラウンドビューカメラセンサー、ライダーセンサー、ミリ波レーダーセンサーなどのさまざまなデータ情報センサーが搭載されており、さまざまなモダリティで情報を収集して正確な認識タスクを実現しています。

純粋な視覚に基づくBEV知覚アルゴリズムは、ハードウェアコストが低く、導入が容易であり、その出力結果はさまざまな下流タスクに簡単に適用できるため、産業界および学界から広く注目されています。近年、BEV空間に基づく多くの視覚認識アルゴリズムが次々に登場し、公開データセット上で優れた認識性能を実証しています。

現在、BEV 空間に基づく知覚アルゴリズムは、BEV 特徴の構築方法に基づいて 2 種類のアルゴリズム モデルに大別できます。

どちらのアルゴリズムも BEV 空間で正確に特徴を生成し、3D 知覚結果を達成できますが、BEVFormer アルゴリズムなど、BEV 空間に基づく現在の 3D ターゲット知覚アルゴリズムには次の 2 つの問題があります。 ##

BEVFormer 知覚アルゴリズム モデルの問題点を解決するために、我々はそれを改良し、サラウンド画像に基づく 3D 検出アルゴリズム モデル CLIP-BEVFormer を提案しました。対照学習手法を導入することで、BEV 特徴を構築するモデルの能力が強化され、nuScenes データセットで最高レベルの知覚パフォーマンスを達成しました。

記事リンク: https://arxiv.org/pdf/2403.08919.pdf

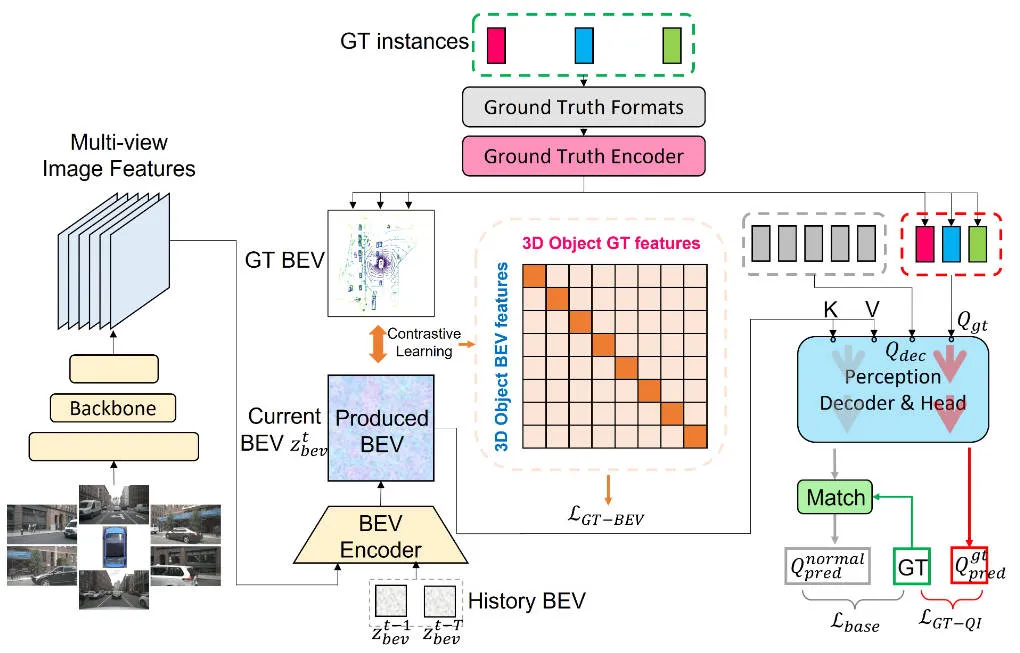

詳細この記事で提案する CLIP-BEVFormer 知覚アルゴリズム モデルの詳細を紹介する前に、次の図に CLIP-BEVFormer アルゴリズムの全体的なネットワーク構造を示します。

この記事で提案するCLIP-BEVFormer知覚アルゴリズムモデルの全体フローチャート

この記事で提案するCLIP-BEVFormer知覚アルゴリズムモデルの全体フローチャート

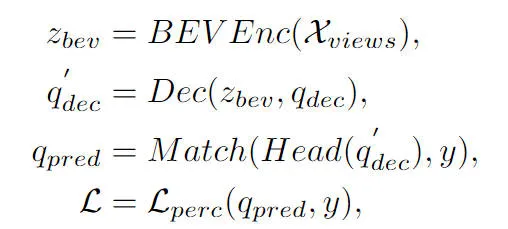

アルゴリズムの全体フローチャートから、CLIP-BEVFormerアルゴリズムモデルがこの記事で提案するアルゴリズムは BEVFormer アルゴリズム モデルに基づいており、その改良点に基づいて、BEVFormer 知覚アルゴリズム モデルの実装プロセスを簡単にレビューします。まず、BEVFormer アルゴリズム モデルは、カメラ センサーによって収集されたサラウンド画像データを入力し、2D 画像特徴抽出ネットワークを使用して、入力サラウンド画像のマルチスケール意味論的特徴情報を抽出します。次に、時間的セルフ アテンションと空間的クロス アテンションを含むエンコーダ モジュールを使用して、2D 画像特徴から BEV 空間特徴への変換プロセスを完了します。次に、オブジェクト クエリのセットが 3D 知覚空間で正規分布の形式で生成され、デコーダ モジュールに送信され、エンコーダ モジュールが出力する BEV 空間特徴との空間特徴のインタラクティブな利用が完了します。最後に、フィードフォワード ニューラル ネットワークを使用して、オブジェクト クエリによってクエリされた意味特徴を予測し、ネットワーク モデルの最終的な分類と回帰の結果が出力されます。同時に、BEVFormer アルゴリズム モデルのトレーニング プロセス中に、1 対 1 のハンガリー マッチング戦略を使用して陽性サンプルと陰性サンプルの分配プロセスを完了し、分類と回帰損失を使用してサンプルの更新プロセスを完了します。全体的なネットワーク モデル パラメーター。 BEVFormer アルゴリズム モデルの全体的な検出プロセスは、次の数式で表すことができます。

このうち、式中の は、BEVFormerアルゴリズムにおけるEncoder特徴抽出モジュールを表し、BEVFormerアルゴリズムにおけるDecoder復号モジュールを表し、データセットにおける真値ターゲットラベルを表し、現在の BEVFormer アルゴリズム モデルを表し、3D 認識結果を出力します。

前述したように、BEV 空間に基づく既存の 3D ターゲット検出アルゴリズムのほとんどには明示的な位置合わせがありません。生成される BEV 空間特徴は次のとおりです。これは、モデルによって生成された BEV 特徴が実際の BEV 特徴と一致しない可能性があるという問題につながり、この BEV 空間特徴の分布の違いにより、モデルの最終的な知覚パフォーマンスが制限されます。この検討に基づいて、私たちは Ground Truth BEV モジュールを提案しました。このモジュールを設計する際の中心的なアイデアは、モデルによって生成された BEV 特徴を現在の真の値の BEV 特徴と一致させ、それによってモデルのパフォーマンスを向上させることです。

具体的には、全体的なネットワーク フレームワーク図に示すように、グラウンド トゥルース エンコーダー () を使用して、BEV 特徴マップ上の任意のグラウンド トゥルース インスタンスのカテゴリ ラベルと空間境界ボックスの位置情報をエンコードします。このプロセスは、次の形式の式で表すことができます。

式は、生成された BEV 特徴マップと同じサイズの特徴次元を持ち、真値ターゲットの符号化された特徴情報を表します。符号化処理では、大規模言語モデル (LLM) と多層パーセプトロン (MLP) の 2 つの形式を採用しましたが、実験の結果、2 つの方式は基本的に同じ性能を達成できることがわかりました。

さらに、BEV 特徴マップ上の真値ターゲットの境界情報をさらに強化するために、空間的位置に応じて BEV 特徴マップ上の真値ターゲットをクロップし、クロッピングを実行します。特徴はプーリング操作を使用して、対応する特徴情報表現を構築します。プロセスは次の形式で表現できます:

最後に、モデルによって生成された BEV 特徴を真の値の BEV 特徴とさらに調整するために、比較学習手法を採用し、2 種類の BEV 特徴間の要素関係と距離を最適化します。最適化プロセスは次の形式で表現できます。生成された BEV 特徴量と真の BEV 特徴量の間の類似度行列は、対比学習における論理スケール ファクターを表し、行列間の乗算演算を表し、クロスエントロピー損失関数を表します。上記の対照学習方法を通じて、私たちが提案する方法は、生成されたBEV特徴に対してより明確な特徴ガイダンスを提供し、モデルの知覚能力を向上させることができます。

この部分については、前の記事でも説明しています。BEVFormer 認識アルゴリズム モデルのオブジェクト クエリは、Decoder モジュールを通じて生成された BEV 特徴と相互作用し、対応するターゲットクエリの特性を取得しますが、プロセス全体としては依然としてブラックボックスプロセスであり、プロセスの完全な理解が不足しています。この問題に対処するために、真理値クエリ インタラクション モジュールを導入しました。このモジュールは、真理値ターゲットを使用して Decoder モジュールの BEV 特徴インタラクションを実行し、モデル パラメーターの学習プロセスを刺激します。具体的には、truth encoder()モジュールが出力する真理ターゲットの符号化情報をObject Queryに導入し、Decoderモジュールの復号処理に参加させ、通常のObject Queryと同様にセルフアテンションモジュール、クロスアテンションモジュールに参加します。フィードフォワード ニューラル ネットワークは、最終的な知覚結果を出力します。ただし、デコード処理中、すべてのオブジェクト クエリは、真の値のターゲット情報の漏洩を防ぐために並列計算を使用することに注意する必要があります。真理値ターゲットクエリ対話プロセス全体は、次の形式で抽象的に表現できます。

このうち、式内の は初期化されたオブジェクトクエリを表し、真理値オブジェクトを表します。それぞれクエリ処理 デコーダモジュールとセンシング検出ヘッドの出力結果。モデルトレーニングプロセスに真値ターゲットのインタラクションプロセスを導入することにより、私たちが提案した真値ターゲットクエリインタラクションモジュールは、真値ターゲットクエリと真値BEV特徴の間のインタラクションを実現し、それによって、モデルのパラメータ更新プロセスを支援します。モデルデコーダモジュール。

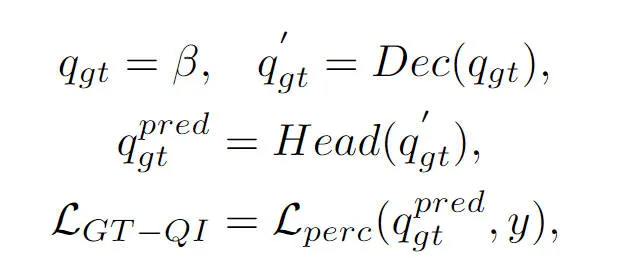

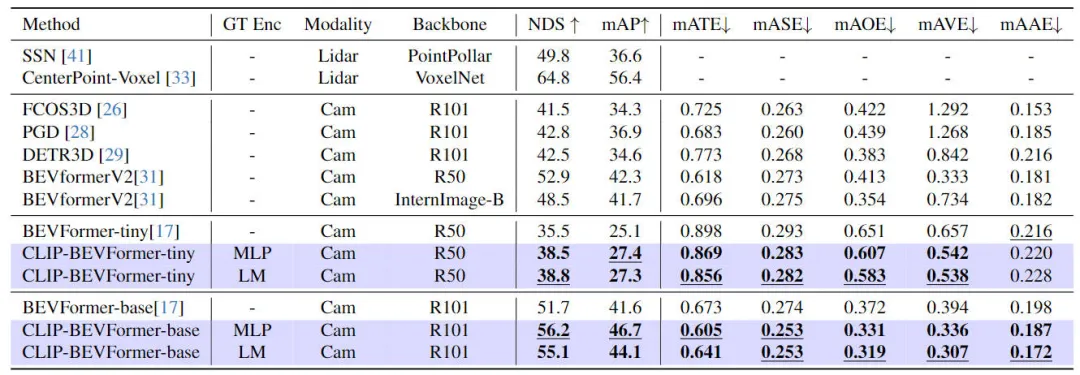

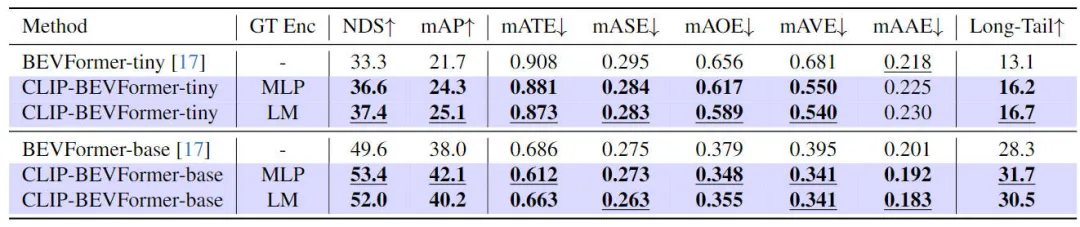

CLIP-BEVFormerアルゴリズムの有効性を検証するために私たちが提案した性別モデルを使用して、3D 知覚効果、データセット内のターゲット カテゴリのロングテール分布、ロバスト性の観点から nuScenes データセットで関連する実験を実施しました。次の表は、私たちが提案したアルゴリズム モデルと他のアルゴリズム モデルの違いを示しています。 3D 認識アルゴリズム モデル nuScenes データセットでの精度比較。

本記事で提案する手法と他の知覚アルゴリズムモデルの比較結果

実験のこの部分では、さまざまなモデル構成での知覚パフォーマンスを評価しました。具体的には、CLIP-BEVFormer アルゴリズム モデルを BEVFormer の小さなバリアントと基本バリアントに適用しました。さらに、事前トレーニングされた CLIP モデルまたは MLP レイヤーをグランド トゥルース ターゲット エンコーダーとして使用した場合のモデルの知覚パフォーマンスへの影響も調査しました。実験結果から、オリジナルの tiny バリアントであっても、base バリアントであっても、私たちが提案した CLIP-BEVFormer アルゴリズムを適用した後、NDS および mAP インジケーターのパフォーマンスが安定して向上していることがわかります。さらに、実験結果を通じて、私たちが提案したアルゴリズム モデルは、グランド トゥルース ターゲット エンコーダーに MLP 層または言語モデルが選択されるかどうかに影響を受けないことがわかり、この柔軟性により、私たちが提案した CLIP-BEVFormer アルゴリズムをより効果的にすることができます。適応性があり、車両への導入が簡単です。要約すると、提案されたアルゴリズム モデルのさまざまなバリアントのパフォーマンス指標は、提案された CLIP-BEVFormer アルゴリズム モデルが優れた知覚ロバスト性を持ち、さまざまなモデルの複雑さとパラメーター量の下で優れた検出パフォーマンスを達成できることを一貫して示しています。

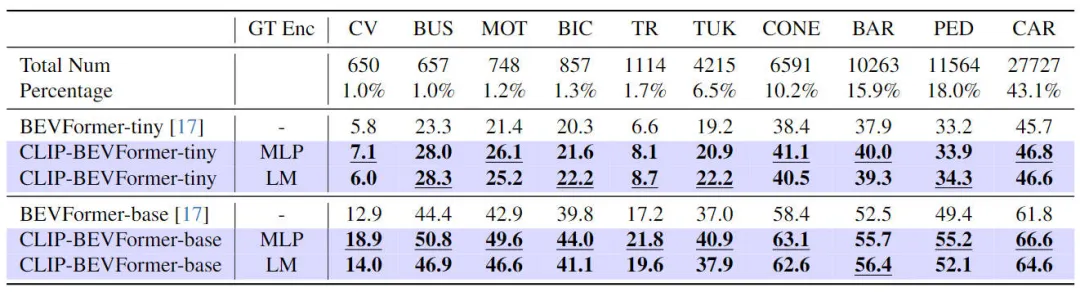

3D 認識タスクで提案した CLIP-BEVFormer のパフォーマンスを検証することに加えて、データセット内のロングテール分布に対するアルゴリズムの堅牢性を評価するためにロングテール分布実験も実施しました。スティッキー性と汎化能力、実験結果は次の表にまとめられています。

ロングテール問題に対する提案された CLIP-BEVFormer アルゴリズム モデルのパフォーマンス

表の実験結果から、nuScenes データセットはカテゴリ数に大きな不均衡を示していることがわかります。(建設車両、バス、オートバイ、自転車など) などの一部のカテゴリは、非常に大きな割合を占めています。割合は低いですが、自動車の場合はその割合が非常に高くなります。ロングテール分布を使用して関連する実験を実行することにより、特徴カテゴリに対する提案された CLIP-BEVFormer アルゴリズム モデルの知覚パフォーマンスを評価し、それによってあまり一般的ではないカテゴリを解決するその処理能力を検証します。上記の実験データから、提案された CLIP-BEVFormer アルゴリズム モデルがすべてのカテゴリでパフォーマンスの向上を達成し、非常に小さな割合を占めるカテゴリでは、CLIP-BEVFormer アルゴリズム モデルが明らかな実質的なパフォーマンスの向上を示していることがわかります。

実際の環境における自動運転システムは、ハードウェアの故障、厳しい気象条件、人工障害物によって容易に引き起こされるセンサーの故障などの問題に直面する必要があることを考慮して、提案されたアルゴリズムの堅牢性をさらに実験的に検証しました。モデル。具体的には、センサーの故障問題をシミュレートするために、モデルの実装推論プロセス中にカメラのカメラをランダムにブロックして、カメラが故障する可能性のあるシーンをシミュレートしました。関連する実験結果は以下の表に示されています

提案されたCLIP-BEVFormerアルゴリズムモデルのロバストネス実験結果

提案されたCLIP-BEVFormerアルゴリズムモデルのロバストネス実験結果

実験結果から、tiny または Base のモデル パラメーター構成に関係なく、私たちが提案した CLIP-BEVFormer アルゴリズム モデルは、BEVFormer の同じ構成のベースライン モデルよりも常に優れていることがわかります。アルゴリズム モデルはシミュレーションで良好なパフォーマンスを発揮します。 センサーの故障状況下でも優れたパフォーマンスと優れた堅牢性を備えています。

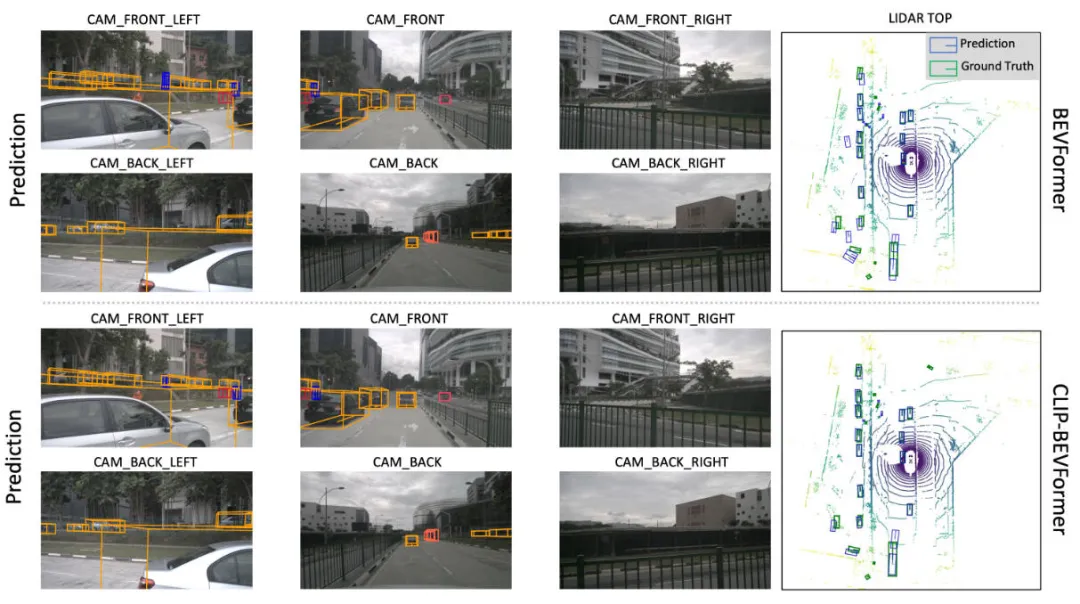

次の図は、私たちが提案したCLIP-BEVFormerアルゴリズムモデルとBEVFormerアルゴリズムモデルの知覚結果の視覚的な比較を示しています。視覚的な結果から、私たちが提案したCLIP-BEVFormerアルゴリズムモデルの知覚結果が真の値ターゲットに近いことがわかり、私たちが提案した真の値BEV特徴生成モジュールと真の値ターゲットクエリインタラクションモジュールの有効性を示しています。

提案されたCLIP-BEVFormerアルゴリズムモデルとBEVFormerアルゴリズムモデルの知覚結果の視覚的比較

この記事では、元の BEVFormer アルゴリズムで BEV 特徴マップを生成するプロセスにおける表示監視の欠如と、Decoder モジュールのオブジェクト クエリと BEV 特徴の間の対話型クエリの不確実性を考慮して、CLIP- BEVFormer アルゴリズム モデルから始まり、アルゴリズム モデルの 3D 認識性能、ターゲットのロングテール分布、センサー故障に対するロバスト性について実験が行われ、多くの実験結果が私たちが提案した CLIP-BEVFormer アルゴリズム モデルの有効性を示しています。

以上がCLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。