リー・カイフー氏が所有する AI 企業であるゼロワンには、もう 1 人の大きなモデルプレーヤーがステージにいます:

90 億パラメータ Yi-9B。

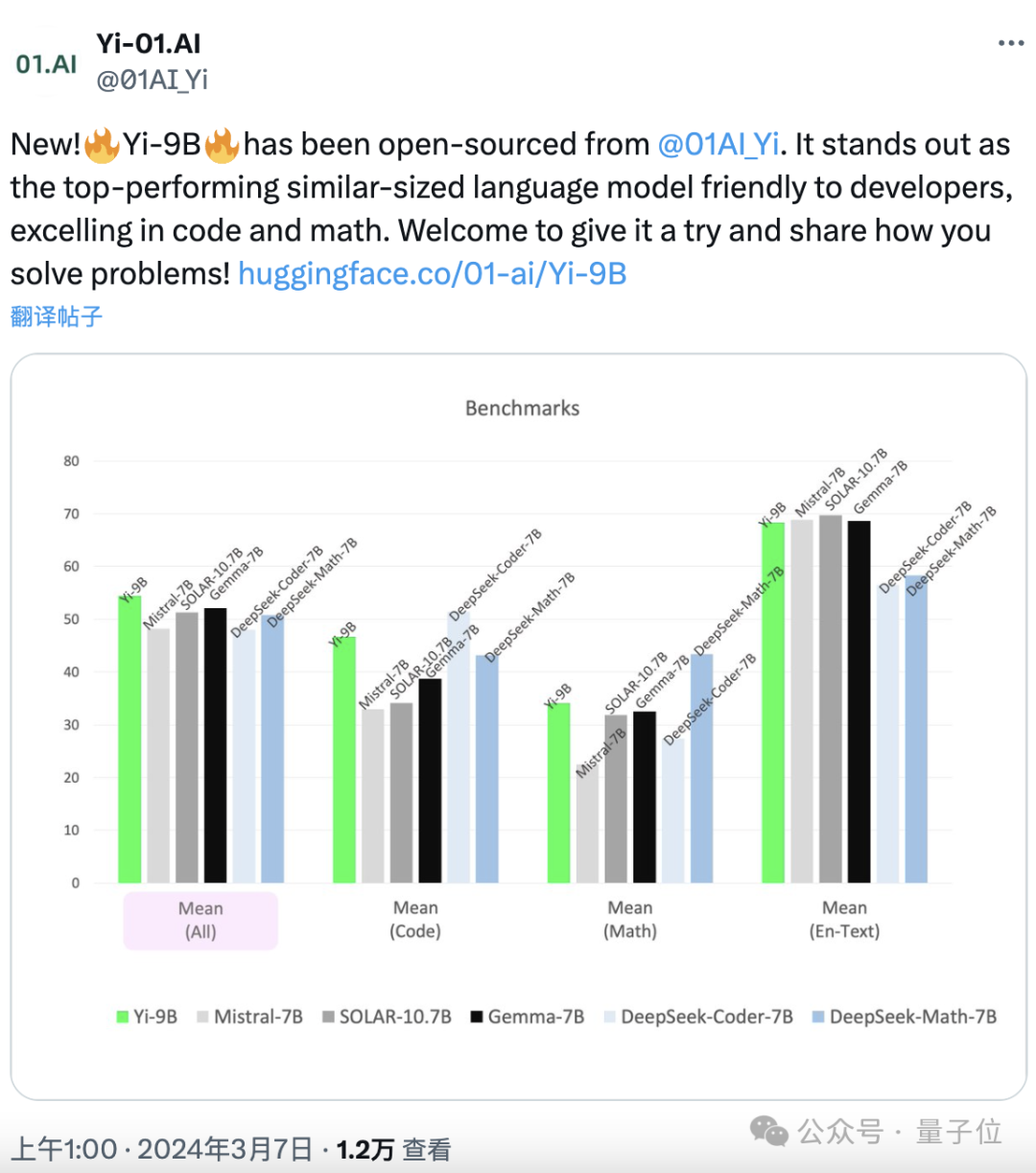

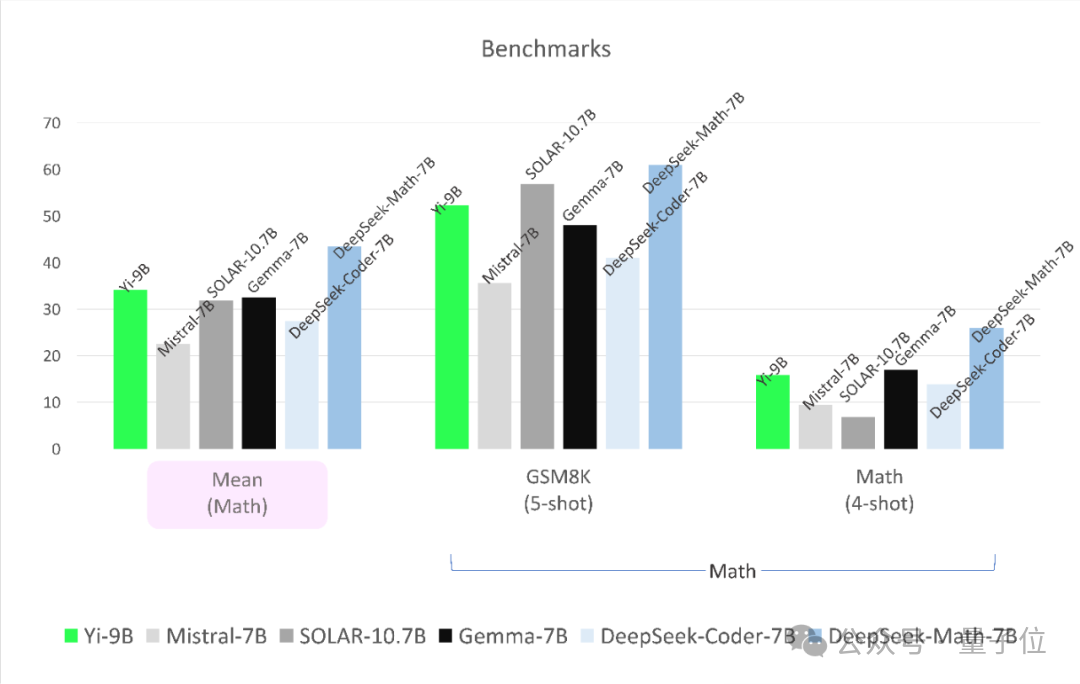

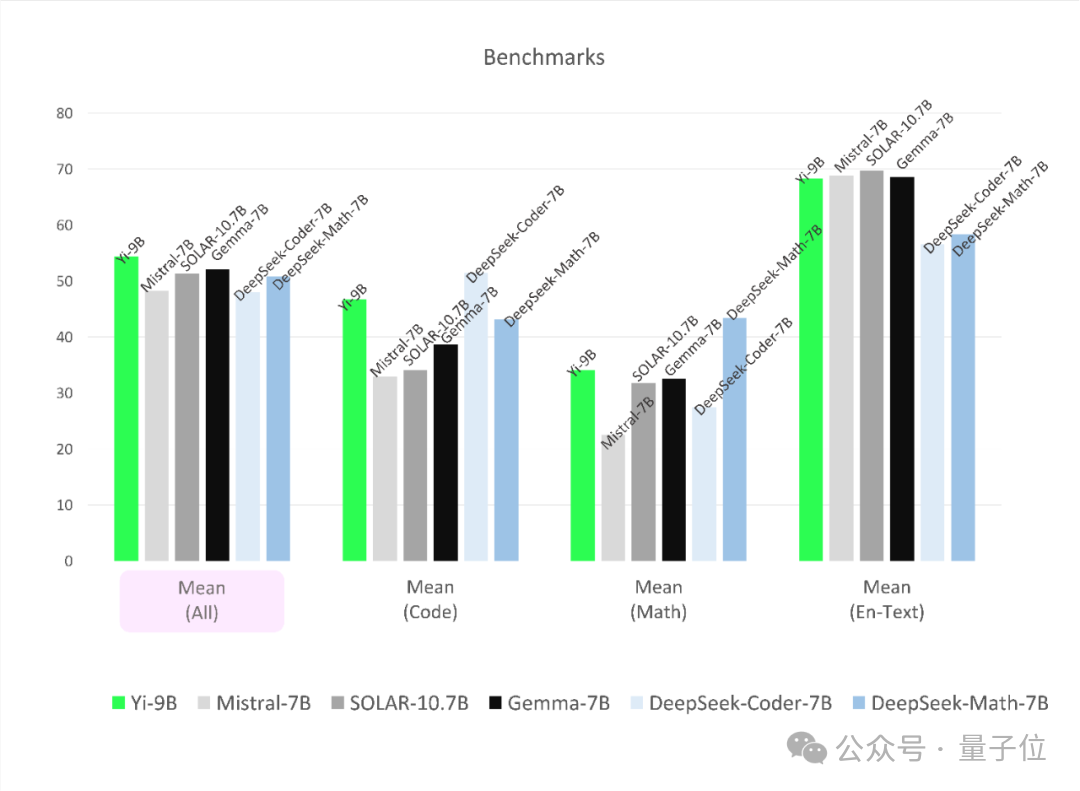

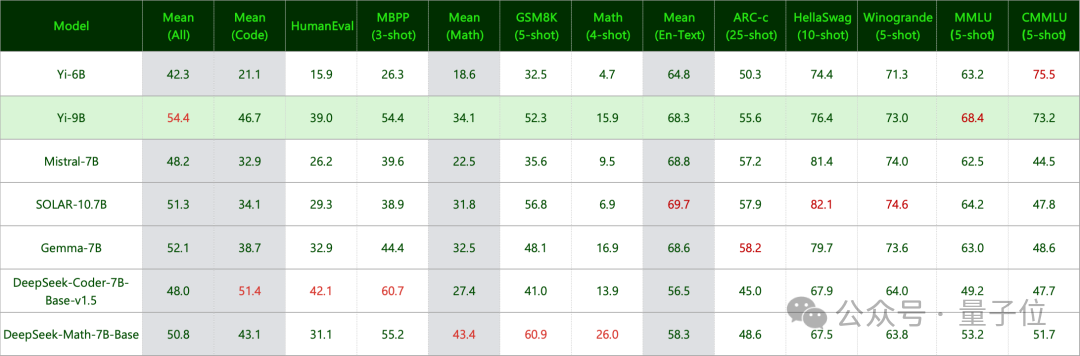

Yi シリーズの 「サイエンス ナンバー ワン」として知られています . コード数学を「補う」と同時に、 、その総合力は負けていません。

同様の規模の一連のオープン ソース モデル (Mistral-7B、SOLAR-10.7B、Gemma-7B、DeepSeek-Coder-7B-Base-v1.5 などを含む) # ##、 最高のパフォーマンス。

古いルール、リリースはオープンソース、特に開発者に優しい :

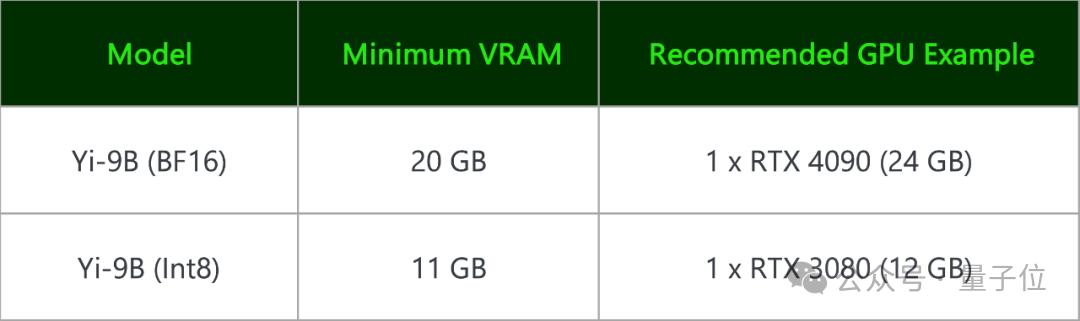

Yi-9B (BF 16) とその量子化バージョン Yi- 9B (Int8) はコンシューマ グレードのグラフィックス カード に導入できます。

RTX 4090 または RTX 3090 で十分です。

データの期限は 2023 年 6 月 です。

Yi-9B の最大の改善点は数学とコーディングにあると冒頭で述べましたが、これら 2 つの能力をどのように改善できるでしょうか? Zero One Thousand Things の概要:データ量を単に増やすだけでは期待に応えることはできません。

は、最初にモデル サイズを増やします 、Yi-6B に基づいて 9B に増やし、次に多段階データの増分トレーニングを実行します 。

まず、モデルのサイズを大きくするにはどうすればよいでしょうか?

前提として、チームが分析を通じて発見したのは、Yi-6B は十分に訓練されており、いくらトークンを追加しても訓練効果が向上しない可能性があるということです。サイズを大きくすることを検討してください。(下の写真の単位はTBではなくBです)

深い増幅です。

Zero One Thing の紹介: 元のモデルの幅を拡張すると、パフォーマンスの損失が大きくなります。適切なレイヤーを選択してモデルの深さを増幅した後、新しいレイヤーを追加します。入出力コサインは 1.0 です。つまり、増幅されたモデルのパフォーマンスは元のモデルのパフォーマンスを維持でき、モデルのパフォーマンスの損失はわずかです。 このアイデアに従って、Zero Yiwu は Yi-6B の比較的後方の 16 層(層 12 ~ 28) をコピーして 48 層の Yi-9B を形成することを選択しました。

実験によると、この方法は、Solar-10.7B モデルを使用して中間の 16 層(層 8 ~ 24) をコピーするよりもパフォーマンスが優れていることが示されています。

第二に、多段階トレーニング方法とは何ですか?

答えは、最初にテキストとコードを含む 0.4T データを追加することですが、データ比率は Yi-6B と同じです。 次に、別の 0.4T データを追加します。これにはテキストとコードも含まれますが、コードと数学的データの割合を増やすことに重点を置きます。(理解しました。これは、大規模なモデルの質問における「段階的に考える」というテクニックと同じ考え方です)

これら 2 つのステップが完了しても、まだ終わっていません。チームは、パラメータ調整方法を最適化するために、2 つの論文(大規模バッチ トレーニングの経験的モデルと学習率を低下させずバッチ サイズを増やす) のアイデアも参照しました。

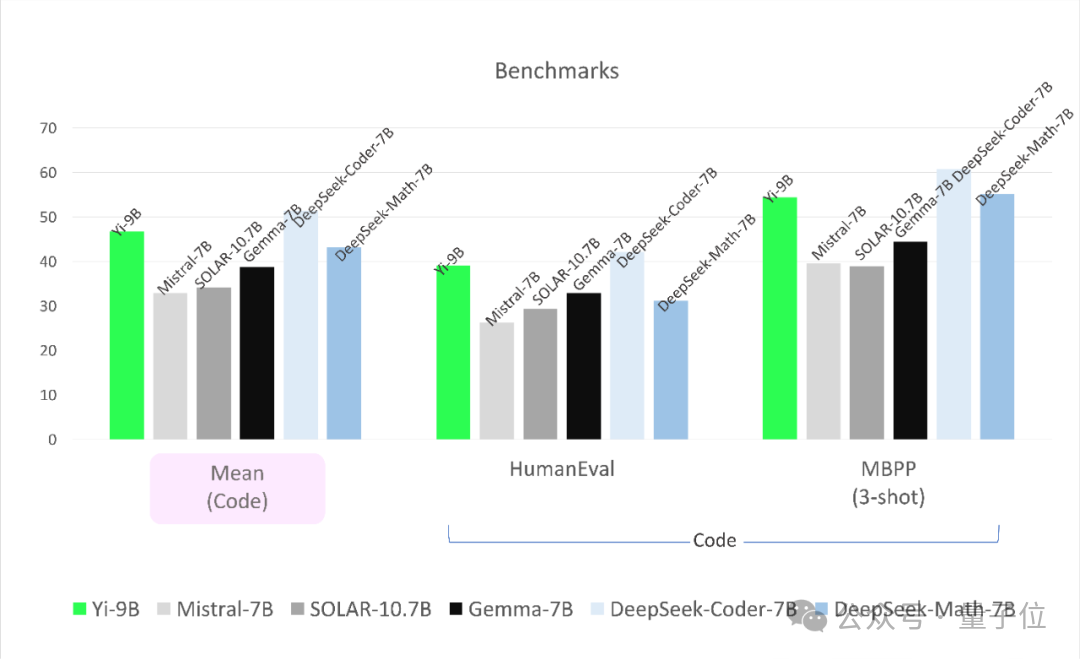

つまり、固定学習率から開始して、モデル損失の減少が止まるたびに、減少が中断されずにモデルがより完全に学習できるようにバッチ サイズが増加します。 最終的に、Yi-9B には実際に合計 88 億個のパラメータが含まれ、コンテキスト長は 4k に達しました。 Yi シリーズは最強のコーディング能力と数学的能力を備えています実際のテストでは、Zero Yiwu は貪欲なデコーディング生成メソッドを使用します(つまり、毎回、最も高い確率値を持つ単語が生成されます)が選択されています) テストします。

参加モデルは、DeepSeek-Coder、DeepSeek-Math、Mistral-7B、SOLAR-10.7B、Gemma-7B です: (1)DeepSeek-Coder#国内ディープサーチ会社の ## では、その 33B 命令チューニング バージョンは人間による評価で GPT-3.5-turbo を上回り、7B バージョンのパフォーマンスは CodeLlama-34B のパフォーマンスに達する可能性があります。

DeepSeek-Math は 7B パラメータに依存して GPT-4 を覆し、オープンソース コミュニティ全体に衝撃を与えました。 (2)

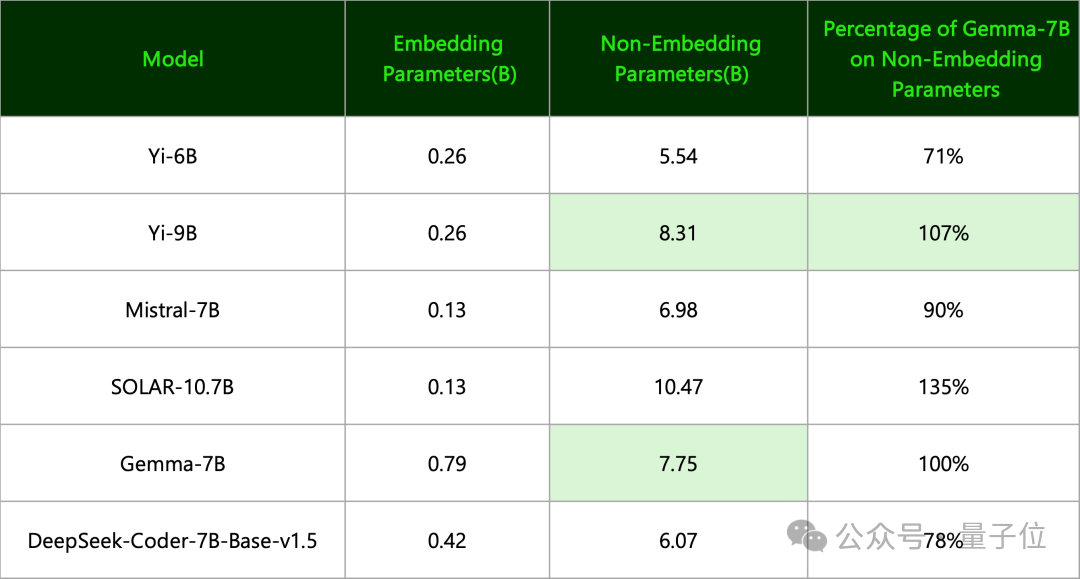

SOLAR-10.7B韓国のUpstage AIは2023年12月に誕生し、その性能はMixtral-8x7B-Instructを上回ります。 (3)Mistral-7B は、Llama 2 70B や GPT-3.5 のレベルに達するか、それを超える初のオープンソース MoE 大型モデルです。 (4)Gemma-7BGoogle より、Zero Yiwu は次のように指摘しました: 有効なパラメータの数は実際にはYi-9B 。 (この 2 つの命名基準は異なります。前者は非埋め込みパラメーターのみを使用し、後者はすべてのパラメーターを使用して切り上げます) 結果は以下の通りです。 まず、コーディングタスクに関しては、Yi-9B のパフォーマンスは DeepSeek-Coder-7B に次ぐもので、他の 4 つはすべて KO です。 Yi-9B の数学的能力の点では、DeepSeek-Math-7B に次いで 2 番目のパフォーマンスを示し、他の 4 つを上回っています。 ポータルはこちらです: https://huggingface.co/01-ai/Yi-9B

急いで「ゲーム」を強化してください。全体的な優位性はなくなりました==

以上がコンシューマーグレードのグラフィックカードも利用可能!李海福氏は史上最強のコード数学能力を持つ90億パラメータのYiモデルを公開し、オープンソース化したの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。