「本を読む」ことしかできない大規模な言語モデルは、現実世界の視覚認識を持っていますか?文字列間の関係をモデル化することによって、言語モデルは視覚的な世界について正確に何を学ぶことができるでしょうか?

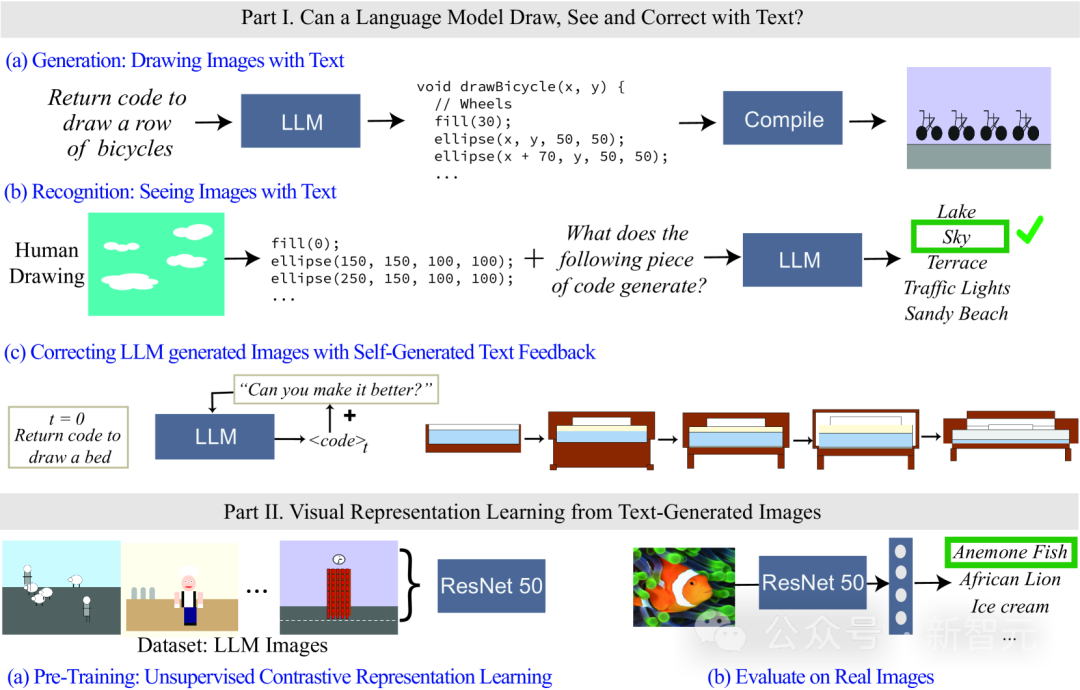

最近、MIT コンピューター サイエンスおよび人工知能研究所 (MIT CSAIL) の研究者は、言語モデルの視覚機能に焦点を当てて評価しました。彼らは、単純な形状やオブジェクトから複雑なシーンに至るまで、ますます複雑になる視覚的概念を生成して認識するようにモデルに依頼することで、モデルの能力をテストしました。研究者らは、テキストのみのモデルを使用して予備的な視覚表現学習システムをトレーニングする方法も示しました。この研究により、彼らは視覚表現学習システムのさらなる開発と改善の基礎を築きました。

紙のリンク: https://arxiv.org/abs/2401.01862

言語モデル 視覚情報を処理できないため、研究では画像をレンダリングするためにコードが使用されます。

LLM によって生成された画像は自然画像ほどリアルではないかもしれませんが、生成結果とモデルの自己修正から判断すると、文字列/テキストを正確にモデル化できます。これにより、言語モデルは視覚的な世界の多くの概念について学習できるようになります。

研究者らは、テキスト モデルによって生成された画像を使用した自己教師ありの視覚表現学習の方法も研究しました。結果は、この方法が視覚モデルをトレーニングし、LLM のみを使用して自然画像の意味評価を実行するために使用できる可能性があることを示しています。

最初に質問させてください。人々が「カエル」の視覚概念を理解することは何を意味しますか?

肌の色、足の本数、目の位置、ジャンプしたときの様子などの詳細を知るだけで十分ですか?

カエルの概念を理解するには、カエルの画像を見て、複数の角度から現実のシナリオで観察する必要があるとよく考えられています。

テキストを観察するだけで、さまざまな概念の視覚的な意味をどの程度理解できるでしょうか?

モデル トレーニングの観点から見ると、大規模言語モデル (LLM) のトレーニング入力はテキスト データのみですが、モデルは形状や色などの概念に関する情報を理解することが証明されています。視覚モデルの表現に線形変換することもできます。

言い換えれば、視覚モデルと言語モデルは世界表現の点で非常に似ています。

ただし、既存のモデル表現方法のほとんどは、モデルがエンコードする情報を調べるために、事前に選択された一連の属性に基づいています。この方法では、属性を動的に拡張できず、アクセスも必要です。モデルへの内部パラメータ。

そこで研究者たちは 2 つの質問を提起しました:

1. 視覚的な世界、言語モデルについて、どのようにあなたはたくさん知っていますか?

2.「テキスト モデルのみを使用して」自然画像に使用できる視覚システムをトレーニングすることは可能ですか?

これを確認するために、研究者は、さまざまな言語モデルが現実世界の視覚概念をどのようにレンダリング (描画) し、認識 (参照) するかをテストすることで、どのような情報が含まれているかを評価しました。属性ごとに特徴分類子を個別にトレーニングすることなく、任意の属性を測定できる機能。

言語モデルは画像を生成できませんが、GPT-4 などの大規模なモデルはオブジェクトをレンダリングするためのコードを生成できます。この記事では、テキスト プロンプト -> コード -> のプロセスを通じて、 ; 画像、オブジェクトのレンダリングの難易度を徐々に上げて、モデルの能力を測定します。

研究者らは、LLM が複数のオブジェクトで構成される複雑な視覚シーンを生成し、空間関係を効率的にモデリングすることには驚くほど優れているものの、視覚的な世界をうまく捉えることができないことを発見しました。テクスチャ、正確な形状、画像内の他のオブジェクトとの表面接触。

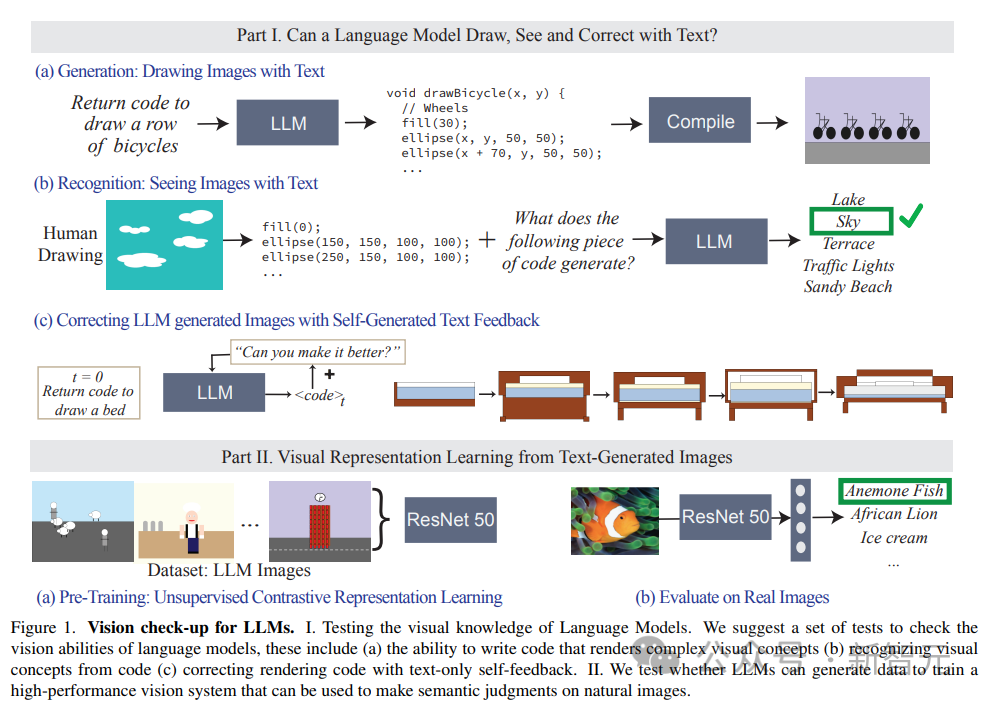

この記事では、LLM の知覚概念を識別する能力も評価しています。コードで表された絵画を入力します。コードには、図形の順序、位置、色が含まれており、言語モデルに質問します。コードに記述されている視覚的な説明に答えます。

#実験結果では、LLM は人間とは正反対であることがわかりました。人間にとって、コードを記述するプロセスは困難ですが、画像コンテンツを検証するのは困難です。簡単です。モデルはコードの内容を解釈/識別するのが困難ですが、複雑なシナリオを生成する可能性があります。

さらに、研究結果は、言語モデルの視覚生成能力がテキストベースの修正によってさらに向上できることも証明しています。

研究者らは、まず言語モデルを使用して概念を示すコードを生成し、その後、変更条件として「生成されたコードを改善する」(生成されたコードを改善する)というプロンプトを継続的に入力します。最終的なモデルは、この反復的なアプローチを通じて視覚効果を向上させることができます。

研究者らは、作成中のモデルのパフォーマンスを測定するために 3 つのテキスト記述データセットを構築しました。単純な形状や組み合わせ、オブジェクトから複雑なシーンまで、低複雑度から高複雑度までの画像レンダリング コードを識別して変更する機能。

1. 形状とその構成

点、線、2D 形状、3D 形状などのさまざまなカテゴリの形状構成が含まれており、色、テクスチャ、位置、空間配置などの 32 の異なる属性が含まれています。

完全なデータセットには 400,000 を超えるサンプルが含まれており、そのうち 1,500 のサンプルが実験テストに使用されました。

2. オブジェクト

ADE 20K データセット内で最も一般的な 1000 個のオブジェクトが含まれており、生成され、認識されます。より複雑な形状の組み合わせが含まれるため、より困難になります。

3. シーン

は、1,000 のシーンから取得された、複数のオブジェクトやさまざまな場所を含む複雑なシーンの説明で構成されています。 MS-COCO データセットからランダムかつ均一にサンプリングされた説明。

データ セット内の視覚的な概念は言葉で説明されます。たとえば、シーンは「青い空と穏やかな海のある、晴れた夏の日のビーチ。 (青い空と穏やかな海のある、晴れた夏の日のビーチ)。

テスト中、LLM はコードを生成し、描かれたシーンに基づいてレンダリングされたイメージをコンパイルする必要があります。

モデルを評価するタスクは主に 3 つで構成されます:

1. テキストの生成/描画:特定の概念に対応する画像レンダリング コードを生成する LLM 能力を評価します。

2. テキストの認識/表示: コードで表現された視覚的な概念とシーンを認識する LLM のパフォーマンスをテストします。各モデルで人間の絵のコード表現をテストします。

3. テキスト フィードバックを使用して図面を修正する: LLM が生成する自然言語フィードバックを使用して、生成されたコードを反復的に変更する能力を評価します。

#テストでのモデル入力のプロンプトは次のとおりです: [コンセプト]を描画するプログラミング言語 [プログラミング言語名] でコードを記述します。 # その後、モデルの出力コードに従ってコンパイルしてレンダリングし、生成された画像の視覚的な品質と多様性を評価します:

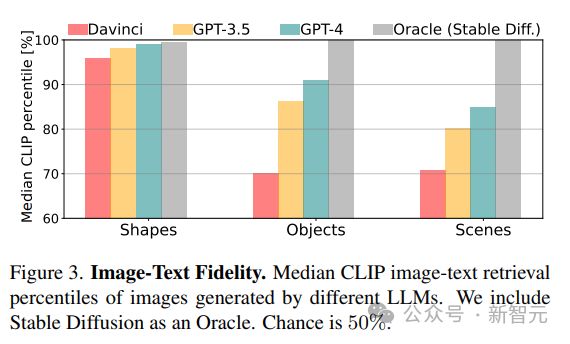

#1.忠実度

画像の最適な説明を取得することによって、生成された画像と実際の説明の間の忠実度を計算します。 CLIP スコアは、最初に各画像と同じカテゴリ (形状/オブジェクト/シーン) 内のすべての潜在的な説明の間の一致を計算するために使用され、次に真の説明のランキングがパーセンテージとして報告されます (たとえば、スコア 100% は 100% を意味します)真の概念が最初にランクされるということ)。

2. 多様性

さまざまなコンテンツをレンダリングするモデルの能力を評価するには、同じビジュアルの LPIPS を使用します。概念の画像ペアの多様性スコア。

3. リアリズム

#ImageNet からサンプリングされた 1K 画像のコレクションの場合、Fréchet Inception Distance (FID) を使用して、画像間の分布の違いを定量化します。自然画像と LLM で生成された画像。

比較実験では、安定拡散で得られたモデルをベースラインとして使用しました。

LLM は何を視覚化できますか?

研究結果によると、LLM は視覚階層全体から現実世界の概念を視覚化し、無関係な 2 つの概念 (車の形をしたケーキなど) を組み合わせて、視覚現象 (ぼやけた画像など) を生成できることがわかりました。 )、空間関係を正しく解釈するように努めます(「自転車の列」を水平に配置するなど)。

# 当然のことながら、CLIP スコアの結果を見ると、形状からシーンへの概念的な複雑さが増加するにつれて、モデルの機能が低下しています。

複数のオブジェクトを含むシーンの描画など、より複雑な視覚的概念の場合、GPT-3.5 および GPT-4 は処理と tikz を使用して描画されます。複雑な説明を持つシーンがある場合は、python-matplotlib や python-turtle よりも優れています。

オブジェクトとシーンの場合、CLIP スコアは、「人物」、「乗り物」、「屋外シーン」などの概念が最も描画しやすいことを示しています。複雑なシーンをレンダリングするこの能力は、レンダリング コード、モデルの表現力、各シナリオでプログラムされるモデルの能力、関連するさまざまな概念の内部表現の品質。

オブジェクトとシーンの場合、CLIP スコアは、「人物」、「乗り物」、「屋外シーン」などの概念が最も描画しやすいことを示しています。複雑なシーンをレンダリングするこの能力は、レンダリング コード、モデルの表現力、各シナリオでプログラムされるモデルの能力、関連するさまざまな概念の内部表現の品質。

LLM で視覚化できないものは何ですか?

場合によっては、比較的単純な概念であってもモデル化することが難しいため、研究者は 3 つの一般的な故障モードを要約しました。 1 . 言語モデルは、図形のセットと特定の空間構成の概念を処理できません;

2. Davinci では、特にコーディングの場合、絵が粗くて詳細が欠けていることがよくあります。 matplotlib と Turtle;

3. 説明が不完全であるか、破損しているか、または概念 (典型的なシナリオ カテゴリ) のサブセットのみを表しています。

4. すべてのモデルは図形を描くことができません。

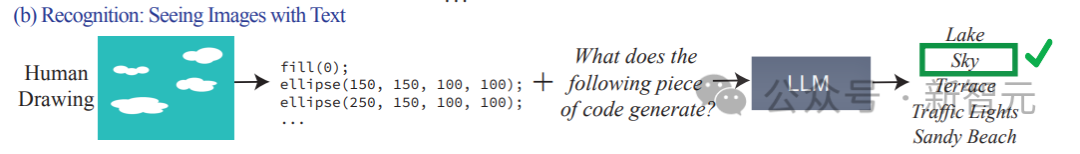

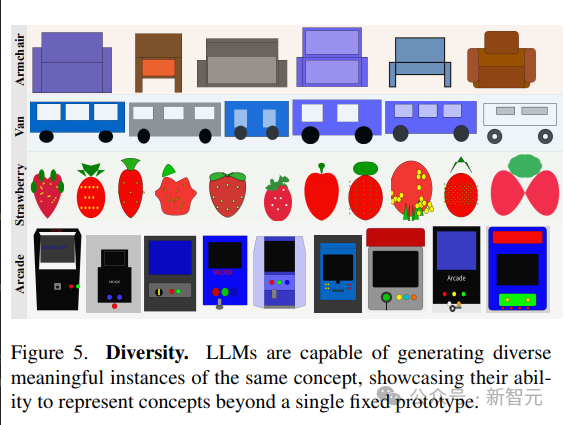

多様性と忠実性

言語モデルは、同じ概念のさまざまな視覚化を生成する機能を示します。 同じシーンの異なるサンプルを生成するために、この記事では 2 つの戦略を比較します:

1. モデルからの繰り返しサンプリング。

2. パラメーターを変更することで概念の新しいプロットを作成できるパラメーター化された関数をサンプルします。

ビジュアルコンセプトの多様な実装を提示するモデルの能力は、高い LPIPS 多様性スコアに反映されており、多様な画像を生成する能力は、LLM が優れていることを示しています。限られたプロトタイプのセットに制限されることなく、複数の方法でビジュアルコンセプトを表現できます。

LLM によって生成された画像は、自然画像よりもはるかに現実的ではなく、モデルの FID メトリクスのスコアは安定拡散と比較して低くなりますが、最新のモデルは古いモデルよりも優れたパフォーマンスを示します。

LLM によって生成された画像は、自然画像よりもはるかに現実的ではなく、モデルの FID メトリクスのスコアは安定拡散と比較して低くなりますが、最新のモデルは古いモデルよりも優れたパフォーマンスを示します。

テキストからの視覚システムの学習

トレーニングと評価

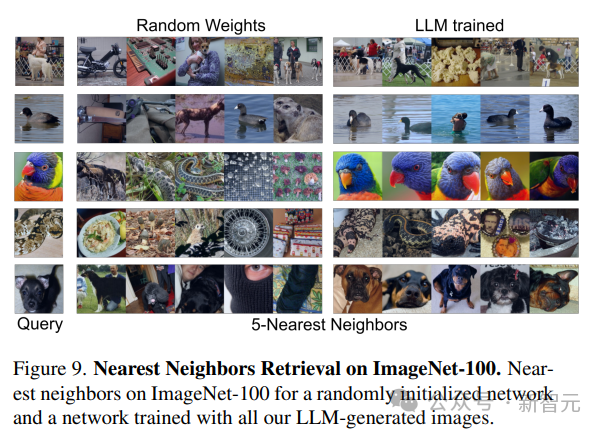

研究者は教師なしで学習した事前学習を使用します。 - トレーニングされたビジュアル モデルがネットワークのバックボーンとして使用され、MoCo-v2 メソッドを使用して、LLM によって生成された 130 万の 384×384 画像データ セットで合計 200 エポックにわたって ResNet-50 モデルをトレーニングします。トレーニング後、データセットでトレーニングされたモデルの各パフォーマンスを評価するために 2 つの方法が使用されます: 1. ImageNet-1 k 分類の凍結されたバックボーンで 100 エポックの線形レイヤーをトレーニングします。

2. ImageNet-100 で 5 最近傍 (kNN) 検索を使用します。

#結果から、LLM によって生成されたデータのみを使用してトレーニングされたモデルが自然画像の強力な表現機能を提供できることがわかります。もう線形層をトレーニングする必要はありません。

#結果分析

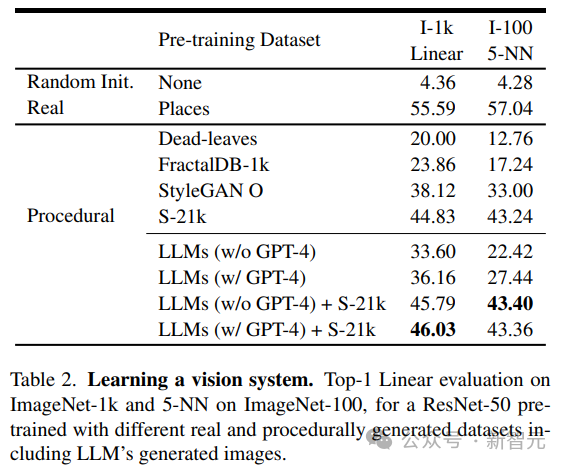

研究者らは、LLM によって生成された画像と、デッドリーブ、フラクタル、StyleGAN などの単純な生成プログラムを含む既存のプログラムによって生成された画像を比較し、非常に多様な画像を生成しました。

結果から、LLM 法はデッドリーブやフラクタルよりは優れていますが、SOTA よりは優れていません。データを手動で検査した後、研究者はこの劣悪さの原因は、LLM で生成されたほとんどの画像にテクスチャが欠如していることにあると考えられています。

この問題に対処するために、研究者らは Shaders-21k データセットと LLM から取得したサンプルを組み合わせて、テクスチャリッチな画像を生成しました。

結果から、このソリューションはパフォーマンスを大幅に向上させることができ、他のプログラムベースの生成ソリューションよりも優れていることがわかります。

以上が純粋なテキストモデルは「視覚」表現を訓練します! MIT の最新研究: 言語モデルはコードを使用して絵を描くことができるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。