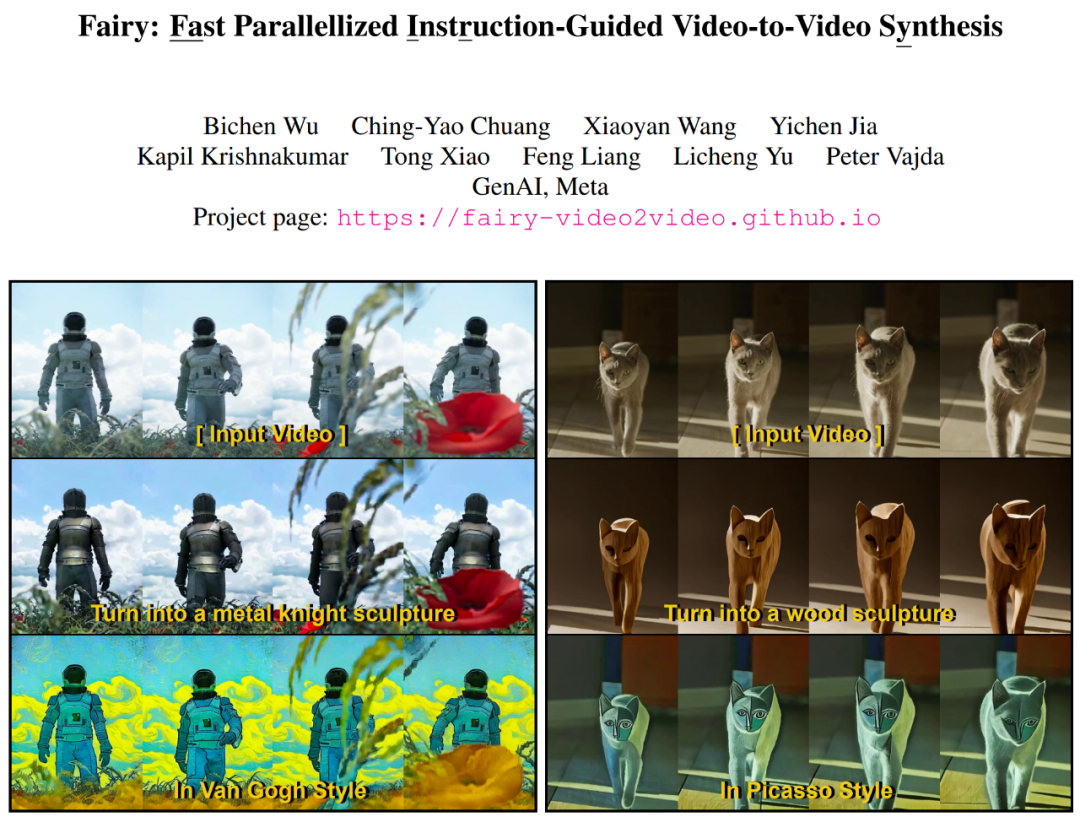

Meta の新しいビデオ合成フレームワークは私たちにいくつかの驚きをもたらしました

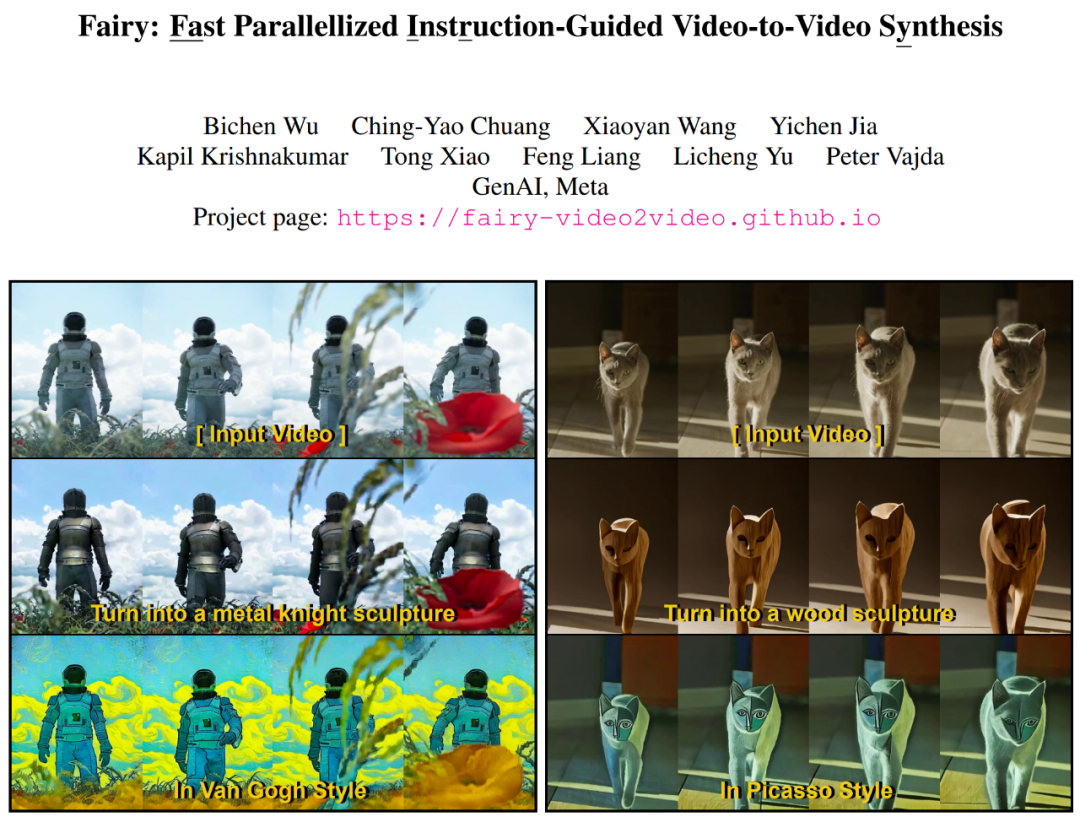

今日の人工知能の開発レベルについて、たとえば、テキストベースの写真、写真ベースのビデオ、および画像/ビデオスタイルの転送は難しくありません。 Generative AI には、コンテンツを簡単に作成または変更できる機能が備わっています。特に画像編集は、10億規模のデータセットで事前トレーニングされたテキストから画像への拡散モデルによって大幅な成長を遂げています。この波により、大量の画像編集アプリやコンテンツ作成アプリが誕生しました。 画像ベースの生成モデルの成果を踏まえ、次の課題は、これに「時間次元」を加え、リラックスしたクリエイティブな動画を実現することです。編集。 簡単な戦略は、画像モデルを使用してビデオをフレームごとに処理することですが、生成画像編集は本質的に、同じテキスト プロンプトに基づいている場合でも、ばらつきが大きくなります。特定の画像を編集する方法は無数にあります。各フレームを個別に編集すると、時間的な一貫性を維持することが困難になります。 最近の論文で、Meta GenAI チームの研究者は、画像編集拡散モデルの「単純な適応」である Fairy を提案しました。これにより、AI のパフォーマンスが大幅に向上します。ビデオ編集。 #以下は Fairy の編集ビデオエフェクト表示です:

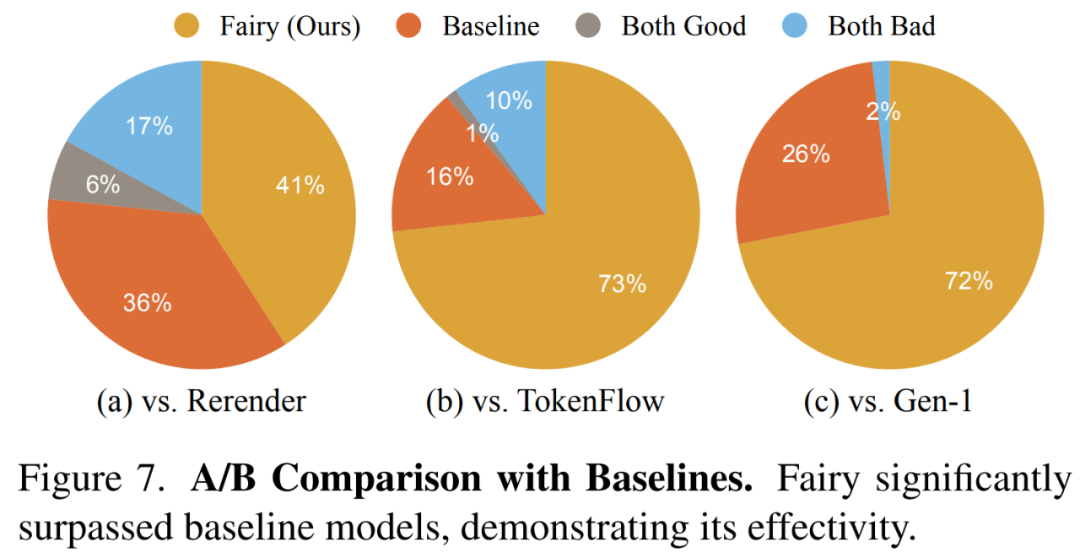

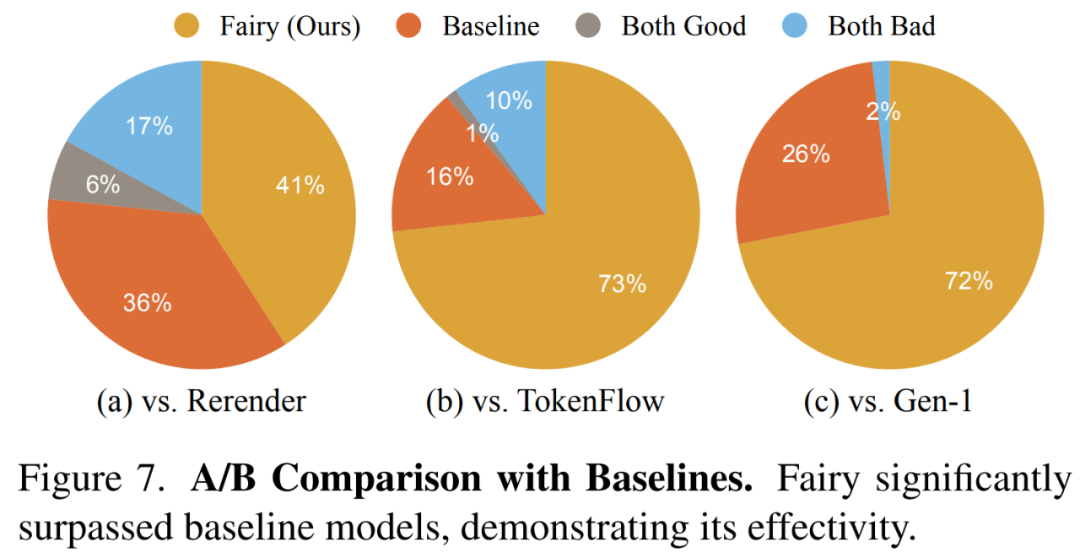

##Fairy は、120 フレームの 512×384 ビデオ (4 秒、30 FPS) をわずか 14 秒で生成します。これは、以前の方法より少なくとも 44 倍高速です。生成された 1,000 個のサンプルを含む包括的なユーザー調査により、提案された方法が高品質を生成し、既存の方法を大幅に上回ることが確認されました。

どうやってやったのですか?

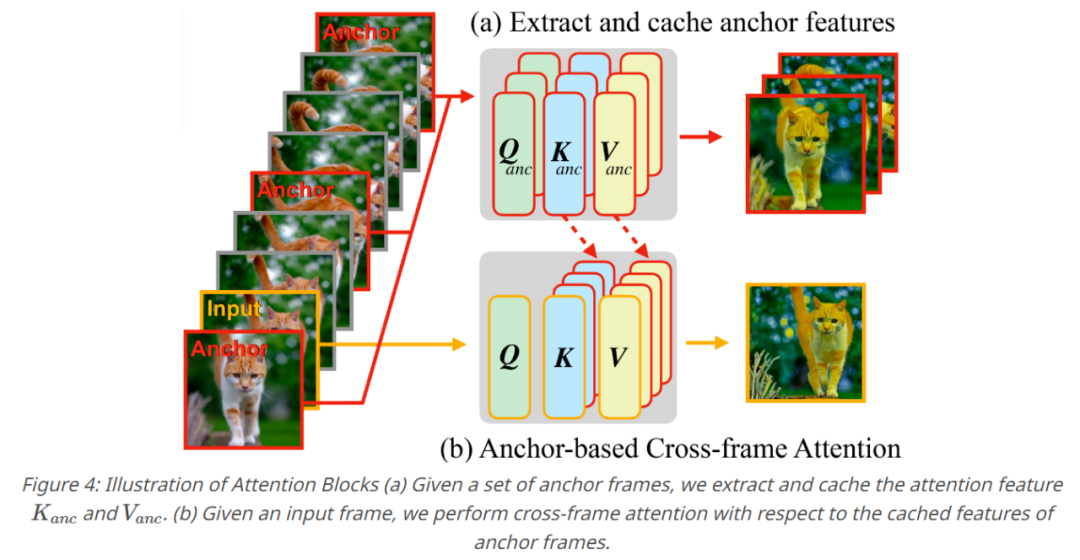

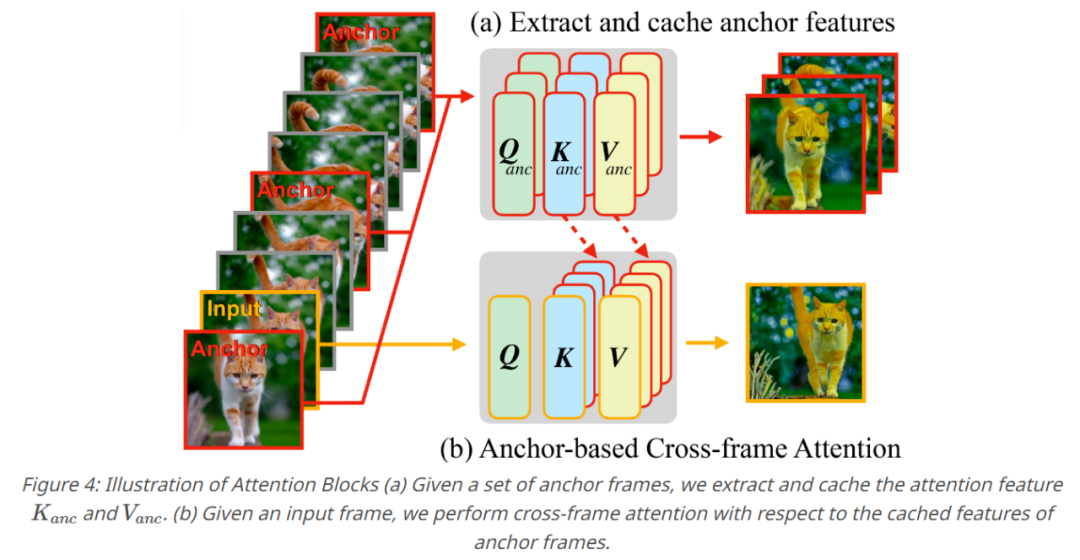

論文によると、Fairy はアンカー ポイントに基づくクロスフレーム アテンションの概念に基づいており、このメカニズムによりフレーム間で拡散特徴を暗黙的に伝播し、時間的一貫性を確保できます。忠実度の高い複合エフェクト。 Fairy は、メモリと処理速度の点で以前のモデルの制限を解決するだけでなく、モデルをソース画像とターゲット画像のアフィン変換と同等にする独自のデータ拡張戦略を通じて時間的一貫性を向上させます。

#論文アドレス: https://arxiv.org/pdf/2312.13834.pdfプロジェクトのホームページ: https://fairy-video2video.github.io/

#メソッド

フェアリーは、拡散モデルの特性に関連して、以前の追跡と伝播のパラダイムを再検討します。特に、この調査では、対応推定を使用してフレーム間の注意をブリッジし、モデルが拡散モデル内の中間特徴を追跡および伝播できるようにします。

クロスフレーム アテンション マップは、各フレーム内のトークン間の対応関係を評価するための類似性の尺度として解釈できます。セマンティック領域の特徴により、より高い注意が割り当てられます。以下の図 3 に示すように、他のフレームにも同様の意味領域があります。

したがって、現在の特徴表現は、フレーム間の類似領域の加重和に焦点を当てることによって洗練され、伝播され、それによってフレーム間の特徴の違いが効果的に最小限に抑えられます。 一連の操作により、Fairy のコア コンポーネントであるアンカー ベースのモデルが生成されます。 生成されたビデオの時間的一貫性を確保するために、この研究では K 個のアンカー フレームをサンプリングして拡散特徴を抽出し、抽出された特徴は伝播されるセットとして定義されました。連続フレームのグローバル特徴に適用されます。この調査では、新しいフレームが生成されるたびに、アンカー フレームのキャッシュされた特徴に対するセルフ アテンション レイヤーをクロスフレーム アテンションに置き換えます。クロスフレーム アテンションを通じて、各フレーム内のトークンは、アンカー フレーム内で同様の意味論的コンテンツを示す特徴を採用し、それによって一貫性が向上します。

実験部分では、研究者は主にコマンドに基づいて、ベースの画像編集モデルを使用して Fairy を実装し、モデルの自己注意をフレーム間注意に置き換えます。アンカー フレームの数を 3 に設定します。モデルは、異なるアスペクト比の入力を受け入れ、アスペクト比を変更せずに、長いサイズの入力解像度を 512 に再スケーリングできます。研究者らは、入力ビデオのすべてのフレームをダウンサンプリングせずに編集しました。すべての計算は 8 つの A100 GPU に分散されます。

研究者は、以下に示すように、Fairy の定性的結果を最初に示しました。 5 に示すように、Fairy はさまざまなテーマを編集できます。

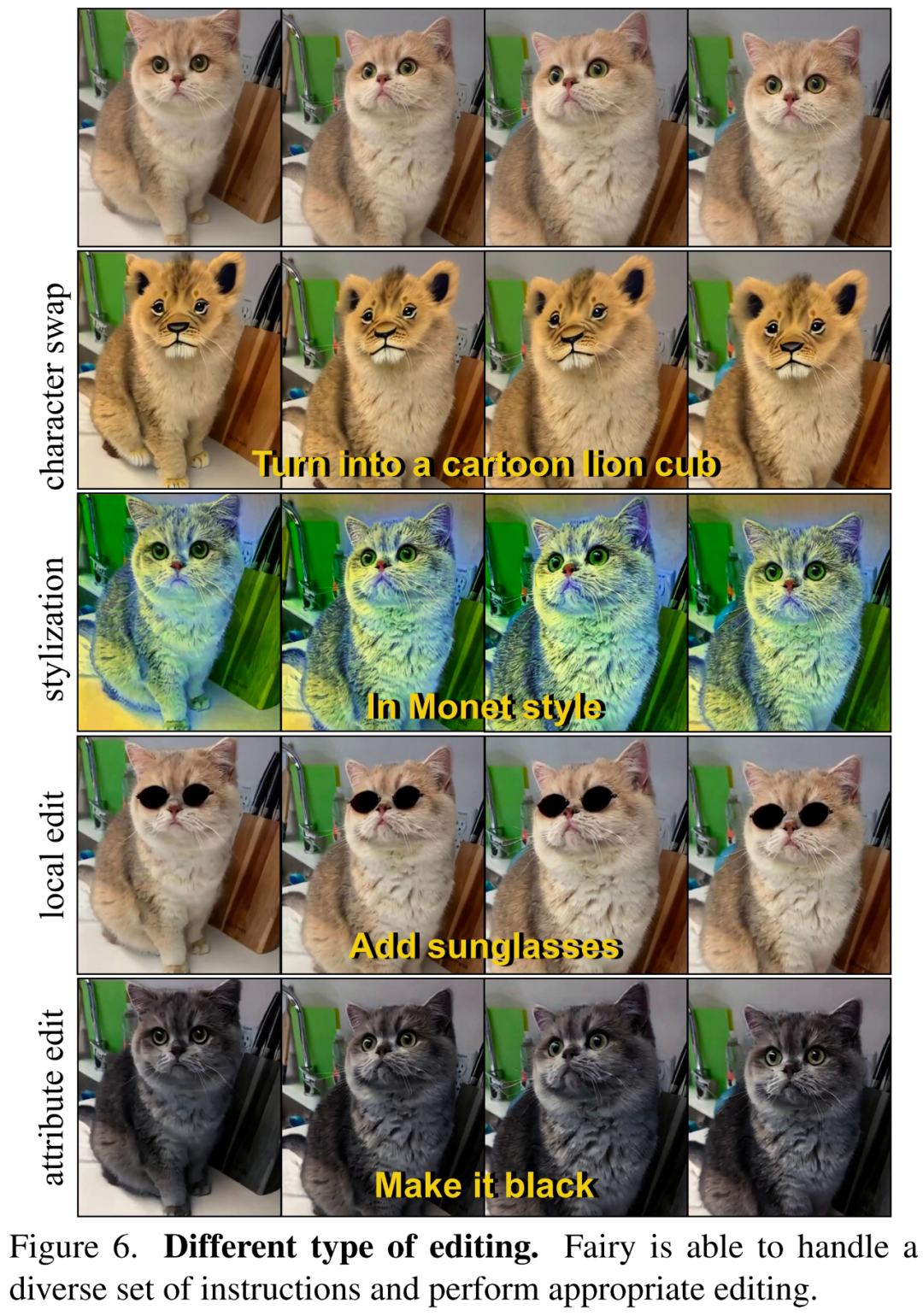

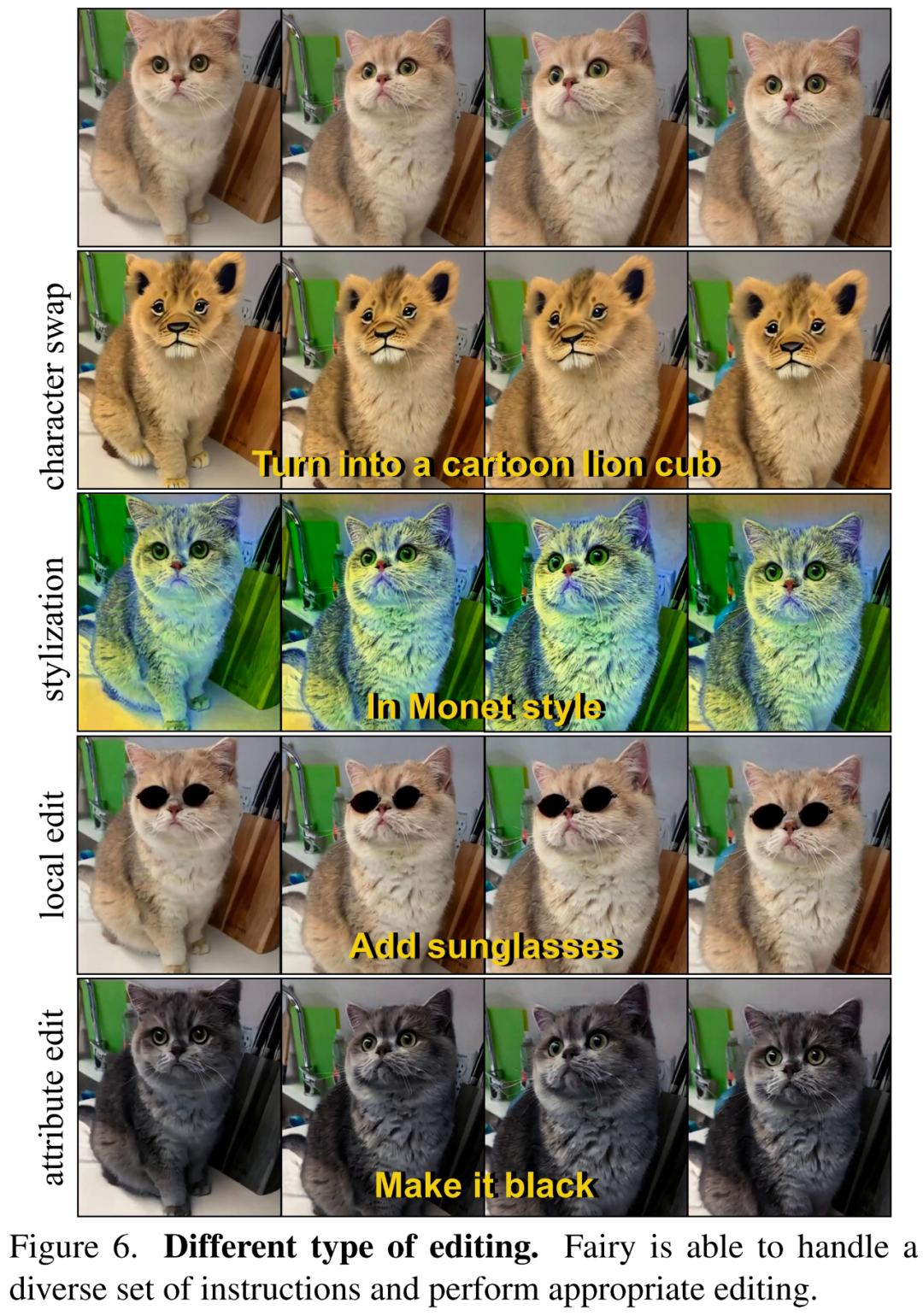

以下の図 6 では、研究者は、Fairy がテキストの指示に従って、様式化、役割の変更など、さまざまな種類の編集を実行できることを示しています。 、部分編集、属性編集など。

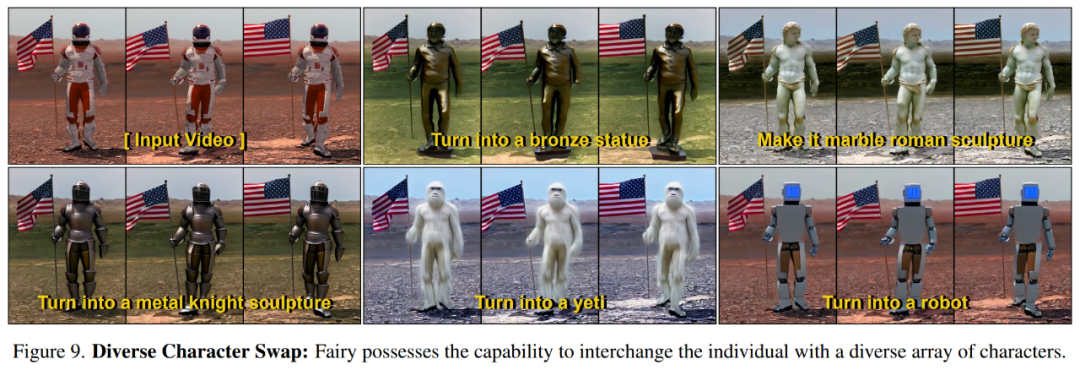

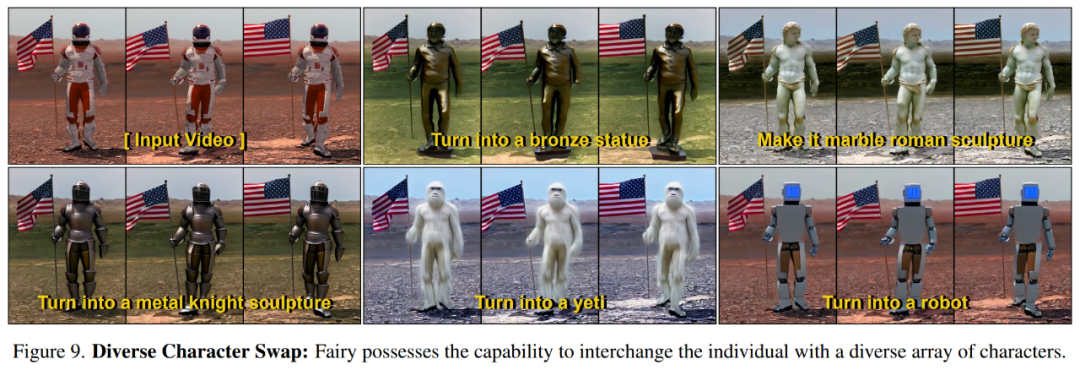

以下の図 9 は、Fairy が指示に従ってソース キャラクターをさまざまなターゲット キャラクターに変換できることを示しています。

#定量的評価

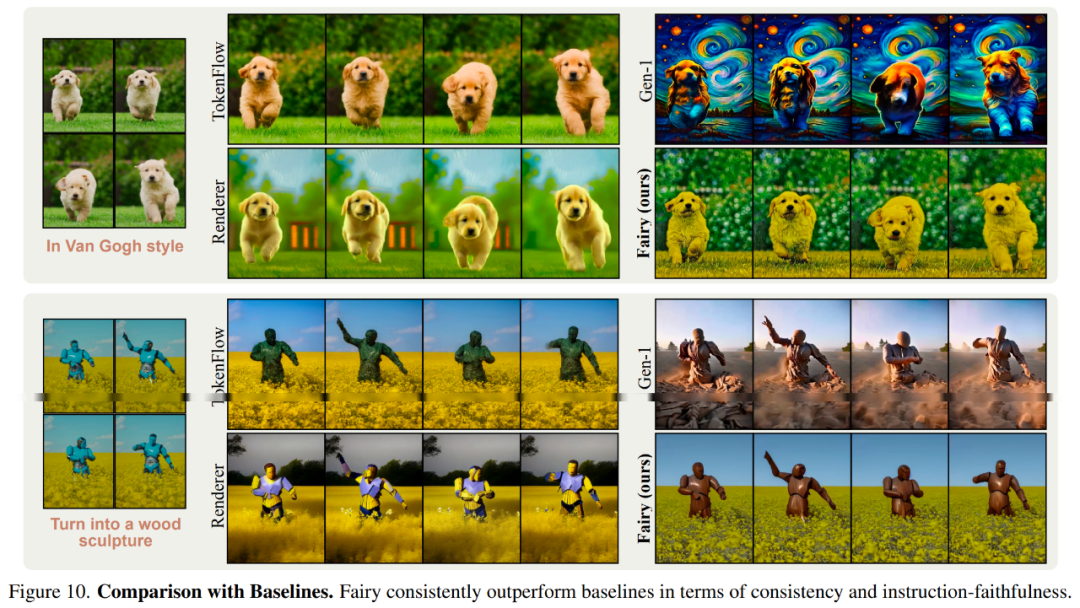

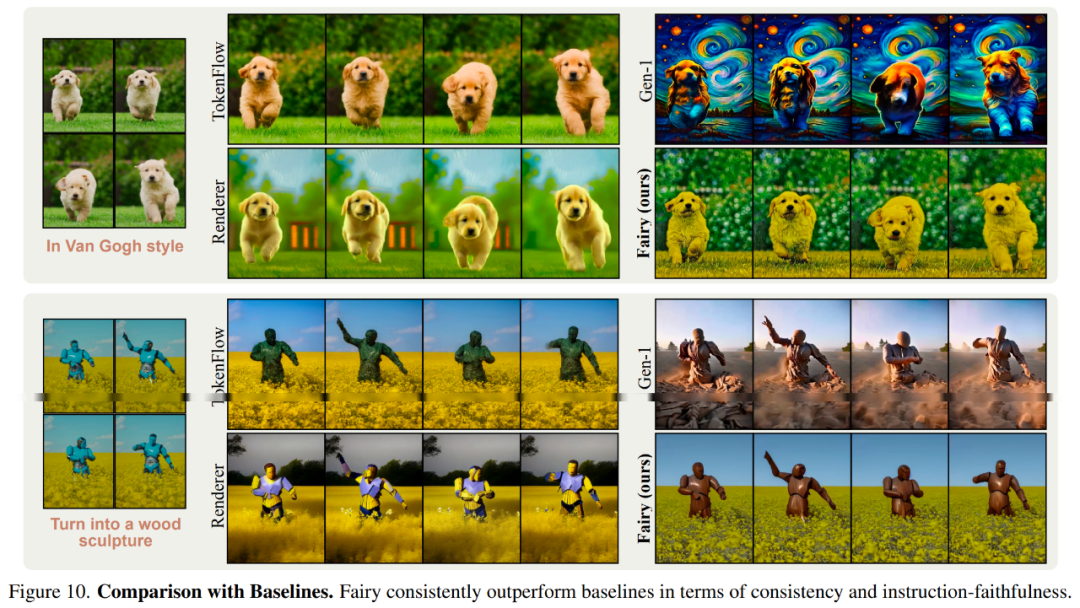

研究者は全体的な品質の比較結果を図 7 に示します。Fairy によって生成されたビデオの人気が高くなります。  以下の図 10 は、ベースライン モデルとの視覚的な比較結果を示しています。

以下の図 10 は、ベースライン モデルとの視覚的な比較結果を示しています。

技術的な詳細と実験結果については、元の論文を参照してください。

技術的な詳細と実験結果については、元の論文を参照してください。

以上がビデオを 14 秒で再構築し、キャラクターを変更することができ、メタによりビデオ合成が 44 倍高速化されます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

以下の図 10 は、ベースライン モデルとの視覚的な比較結果を示しています。

以下の図 10 は、ベースライン モデルとの視覚的な比較結果を示しています。  技術的な詳細と実験結果については、元の論文を参照してください。

技術的な詳細と実験結果については、元の論文を参照してください。