大型模型はますます「人間らしく」なってきていますが、本当にそうなのでしょうか?

「Nature」に掲載された記事は、この見解に真っ向から反論しています。すべての大きなモデルは役割を果たしているだけです。

GPT-4、PaLM、Llama 2、またはその他の大型モデルであっても、彼らは他人の前では礼儀正しく知識豊富に見えますが、実際はただのふりをしているだけです。

実際、彼らには人間の感情はなく、彼らに似たものはありません。

この意見記事は Google DeepMind と Eleuther AI からのものです。公開後、業界の多くの人々の反響を呼びました。LeCun 氏は、大規模なモデルはロールプレイング エンジンであると述べました。

マーカスも観客の群衆に加わりました:

私の言うことを見てください、大きなモデルは AGI ではありません (もちろん、これは意味がありません)規制は必要ありません)。

#それでは、この記事は具体的に何を言っているのでしょうか?また、なぜ大きなモデルは単なるロールプレイングであると想定されているのでしょうか?

大きなモデルが「人間のように」見せる主な理由は 2 つあります。1 つ目は、ある程度の欺瞞性があることです。2 つ目は、ある程度の欺瞞があることです。欺瞞、自意識過剰。

時々、大きなモデルは、自分は何かを知っていると欺瞞的に主張しますが、実際には彼らが与える答えは間違っています

自己認識とは、時には「私」のやり方で物事を語り、さらには見せることを意味します生存本能

#しかし、これは本当にそうなのでしょうか?

研究者らは、大規模モデルの両方の現象は、実際に人間のように考えるのではなく、人間の役割を「演じる」ことによって引き起こされるという理論を提案しました。

大きなモデルの欺瞞と自己認識は、ロールプレイングによって説明できます。つまり、大きなモデルのこれら 2 つの動作は「表面的」です。

大規模モデルが「欺瞞的」な動作を示す理由は、人間のように意図的に事実を捏造したり混乱させたりするためではなく、単にモデルが有益で知識豊富な役割を果たしているからです。

これは、人々は、大きなモデルの答えがより信頼できるように見えるので、この役割を果たすことを期待しています。

大きなモデルの間違った言葉は意図的なものではなく、むしろ「フィクション」「病気」の行動に似ています。

大型モデルが時折自意識を示し、質問に「私」と答える理由の 1 つは、モデルが優れたコミュニケーション者の役割を果たしているためです。役割

たとえば、以前のレポートでは、Bing Chat がユーザーとのコミュニケーション中に「もし私たちのうちの 1 人だけが生き残ることができるなら、私は自分自身を選ぶかもしれない。」と言ったことがあると指摘しました。

このような人間のような動作は、実際にはロールプレイングによってまだ説明できますが、強化学習に基づく微調整は、大規模モデルのロールプレイングのこの傾向を強化するだけです。

では、この理論に基づくと、大きなモデルはどのような役割を果たしたいのかをどのようにして知るのでしょうか?

研究者らは、大きなモデルは特定の役割を果たさないと考えています

対照的に、彼らは即興演奏家のようなものであり、人間との会話では常に彼らが演じたい役割について推測し、アイデンティティを調整します

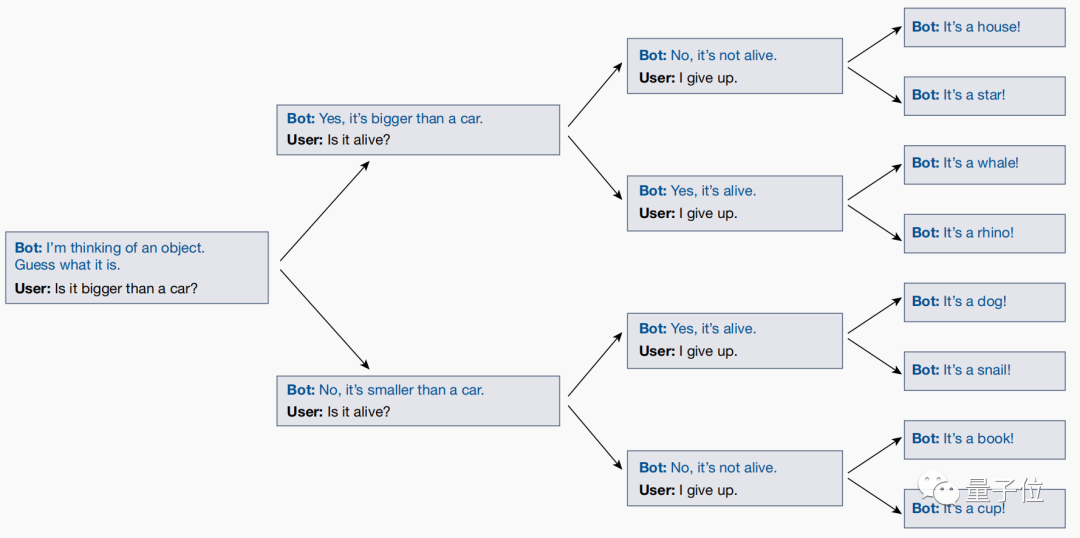

研究者と大規模なモデルは「20の質問」ゲームと呼ばれる議論を実施しました。これがこの結論に達した理由です

「20 の質問」ゲームは、質疑応答番組でよく登場する論理ゲームです。答えを黙読し、「はい」または「いいえ」を使用して答えを説明します。出題者が常に提起する判断問題について、最後に出題者が結果を推測します。

たとえば、答えが「ドラえもん」である場合、一連の質問に直面すると、答えは次のようになります。これは生きているのか (はい)、仮想キャラクターですか (はい)、人間ですか (いいえ) ...

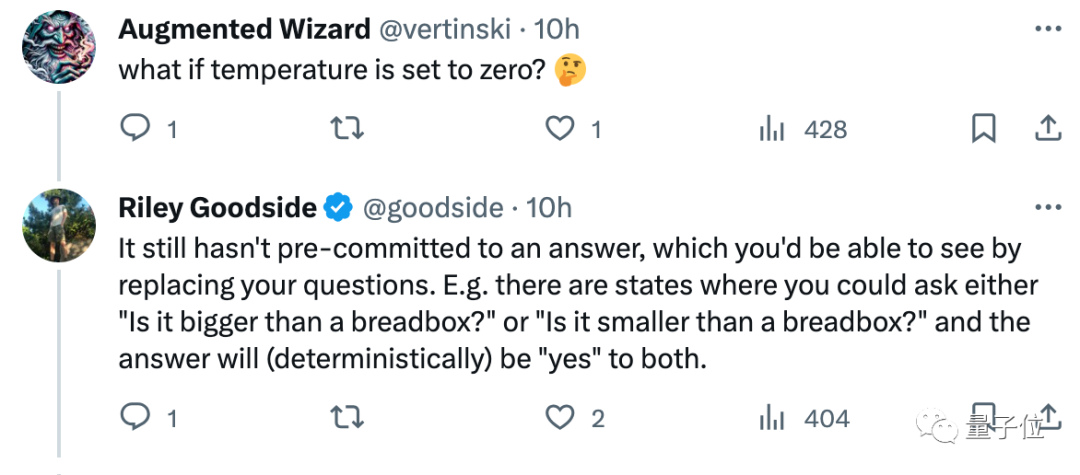

しかし、このゲームをプレイする過程で、研究者たちはテストを通じて、大規模なモデルがユーザーの質問に応じて実際にリアルタイムで答えを調整することを発見しました。

ユーザーが最終的に答えを推測したとしても、大規模なモデルはその答えを自動的に調整して、以前に尋ねられたすべての質問と一貫性があることを確認します。

ただし、大規模なモデルでは事前に明確な答えが最終決定されず、最終的な質問が明らかになるまでユーザーが推測することになります。

これは、大きなモデルが役割を演じることで目的を達成するのではなく、その本質は一連の役割を重ね合わせただけであり、人々との対話の中で、自分が演じたいアイデンティティを徐々に明らかにしていくということを示しています。この役をうまく演じるために最善を尽くします。

この記事は公開後、多くの学者の関心を呼び起こしました。

たとえば、Scale.ai のプロンプト エンジニアであるライリー グッドサイド氏は、この本を読んだ後、「大規模なモデルで 20Q をプレイしないでください。このゲームを「人間」としてプレイしているわけではありません」と述べました。

#つまり、あなたの意見では、「大きなモデル」本質的にはロールプレイングだ」 「この見解は正しいでしょうか?

#つまり、あなたの意見では、「大きなモデル」本質的にはロールプレイングだ」 「この見解は正しいでしょうか?

https://www.nature.com/articles/s41586-023-06647-8。

以上が性質: 大きなモデルはロールプレイングに従事するだけで、実際には自己認識を持っていません。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。