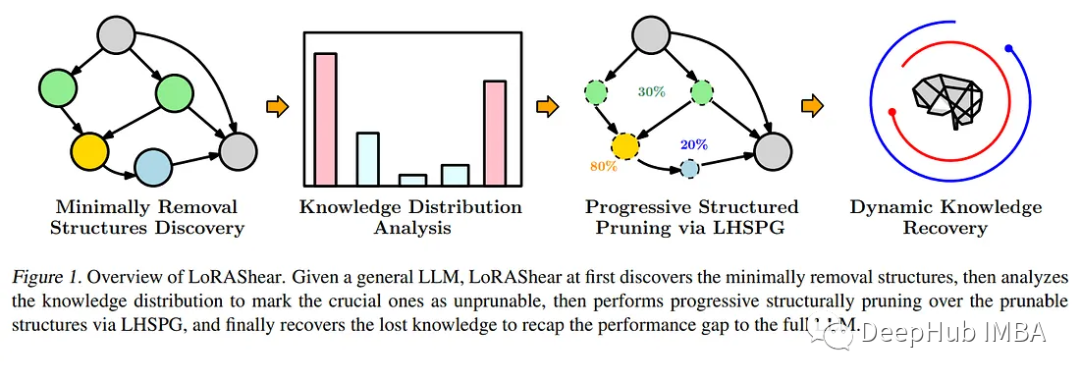

LoRAShear は、言語モデル モデル (llm) を最適化し、知識を保存するために Microsoft によって開発された新しいメソッドです。これにより、構造的な枝刈りが可能になり、計算要件が軽減され、効率が向上します。

LHSPG テクノロジー (Lora 半空間投影勾配) は、進歩的な構造化プルーニングと動的な知識の回復をサポートします。依存関係グラフ分析とスパース性最適化を通じてさまざまな LLM に適用可能

LoRAPrune は、LoRA と反復構造化枝刈りを組み合わせて、パラメーターの効率的な微調整を実現します。 LLAMA v1 で大量のプルーニングを行った場合でも、そのパフォーマンスは同等のままです

進化し続ける人工知能の分野では、言語モデル モデル (llm) がは、大量のテキスト データを処理し、関連情報を迅速に取得し、知識へのアクセス性を高めるための重要なツールになります。その広範囲にわたる影響は、検索エンジンや質問応答システムの強化からデータ分析の実現に至るまでの分野に及び、研究者、専門家、知識探求者などに同様に利益をもたらします。

現在の最大の問題は、LLM が情報の動的な要件を満たすために知識を継続的に更新する必要があることです。通常、開発者はドメイン固有のデータを使用して事前トレーニングされたモデルを微調整し、モデルを最新の状態に保ち、最新の洞察をモデルに組み込みます。組織や研究者にとって、LLM が常に変化する情報環境に確実に対応できるようにするには、定期的な更新が重要です。ただし、微調整のコストは高く、サイクルは長くなります

#この緊急のニーズに応えて、Microsoft の研究者は画期的な手法である LoRAShear を立ち上げました。この革新的なアプローチは、LLM を簡素化するだけでなく、構造的知識の回復も促進します。構造枝刈りの中核は、ニューラル ネットワーク アーキテクチャ内の特定のコンポーネントを削除または削減して、効率、コンパクトさ、計算要件を最適化することです。

Microsoft の LoRAShear は、LHSPG テクノロジを使用して、段階的な構造化プルーニングをサポートします。このアプローチでは、LoRA モジュール間で知識をシームレスに転送でき、動的な知識回復ステージも統合されます。微調整プロセスは、LLM が更新され関連性を維持することを保証するための事前トレーニングおよびガイド付き微調整に似ています。

次のように書き換えられます: 依存関係グラフ分析を活用することで、LoRAShear は次のように拡張できます。 LLM 一般、特にモジュールのサポート範囲内の LoRA。この方法では、オリジナルの LLM および LoRA モジュールを使用して依存関係グラフを作成し、LoRA モジュールからの情報を利用して重み更新プロセス中の知識の保存を強化する構造化されたスパース性最適化アルゴリズムを導入します。この論文では、LoRAPrune と呼ばれる統合テクノロジーについても言及されています。これは、LoRA と反復構造化枝刈りを組み合わせて、パラメーターの効率的な微調整と直接的なハードウェア アクセラレーションを実現します。このメモリ節約方法は、枝刈り基準の LoRA の重みと勾配に完全に依存しています。具体的なプロセスには、追跡グラフの構築、圧縮する必要があるノード グループの決定、トレーニング可能な変数の分割、そして最終的にそれらを LLM に戻すことが含まれます

この論文はオープンソースで実装されていますLLAMAv1、LoRAShear の有効性を証明しました。特に、20% プルーニングを使用した LLAMAv1 のパフォーマンス損失は 1% のみですが、50% プルーニングを使用したモデルは評価ベンチマークで 82% のパフォーマンスを維持しています。

LoRAShear は、人工知能の分野における大きな進歩を表します。これにより、LLM の使用方法が簡素化され、効率が向上するだけでなく、重要な知識が確実に保存されます。これにより、AI 駆動のアプリケーションがコンピューティング リソースを最適化しながら、進化する情報環境に対応できるようになります。組織がデータ処理や知識の取得に人工知能への依存を強めるにつれ、LoRAShear のようなソリューションが市場で重要な役割を果たし、効率性と知識の回復力を提供することになります。

論文アドレス: https://arxiv.org/abs/2310.18356

以上がMicrosoft の最新の研究では、LLM プルーニングと知識回復のための LoRAShear テクノロジーを調査していますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。