時系列予測において、Transformer は依存関係を記述し、マルチレベル表現を抽出する強力な機能を実証しました。ただし、一部の研究者は、Transformer ベースの予測子の有効性を疑問視しています。このような予測子は通常、同じタイムスタンプの複数の変数を区別できないチャネルに埋め込み、これらのタイムスタンプに焦点を当てて時間的な依存関係をキャプチャします。研究者らは、セマンティックな関係ではなく数値的な関係を考慮する単純な線形レイヤーが、パフォーマンスと効率の両方で複雑な Transformer よりも優れていることを発見しました。同時に、変数の独立性を確保し、相互情報を活用することの重要性が、最近の研究でますます注目されています。これらの研究では、多変量相関を明示的にモデル化し、正確な予測を実現します。ただし、共通の Transformer アーキテクチャを破壊することなくこの目標を達成することは依然として困難です。

Transformer ベースの予測子によって引き起こされる論争を考慮するとき、研究者は、Transformer のパフォーマンスが線形よりもさらに悪い理由について考えています。

最近、清華大学の新しい論文では、変圧器の性能は本質的なものではなく、変圧器の不適切な適用によって引き起こされるという別の観点が提案されています。スキーマを時系列データに変換します。

論文へのリンクは次のとおりです: https://arxiv.org/pdf/2310.06625.pdf

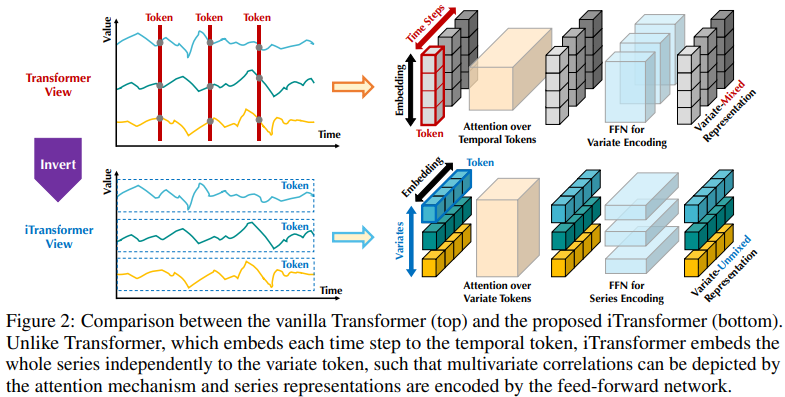

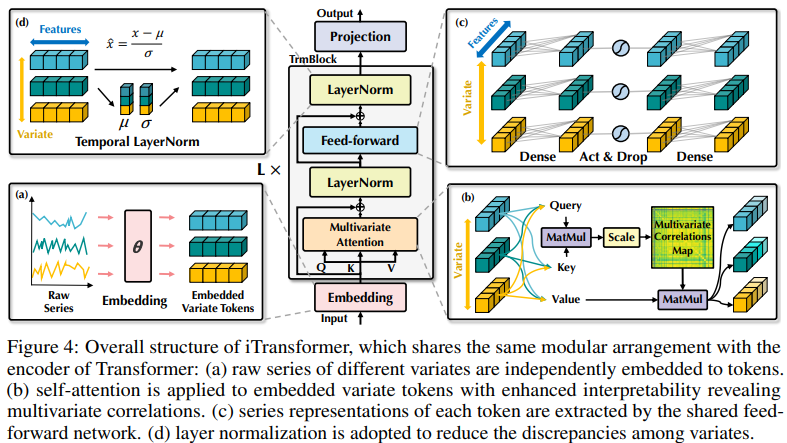

Transformer ベースの予測子の既存の構造は、多変量時系列予測には適していない可能性があります。図 2 の左側は、同じタイム ステップの点が異なる物理的意味を表していることを示していますが、測定結果には一貫性がありません。これらの点はトークンに埋め込まれており、多変量相関は無視されています。さらに、現実の世界では、多変量時点での局所的な受容野とタイムスタンプの不整合により、個々のタイムステップに有用な情報がラベル付けされることはほとんどありません。さらに、シーケンスのバリエーションはシーケンスの順序によって大きく影響されますが、時間次元でのバリアント アテンション メカニズムは完全には採用されていません。したがって、基本的なシーケンス表現をキャプチャし、多変量相関を記述する Transformer の機能が弱まり、さまざまな時系列データに対するその機能と一般化機能が制限されます。各時間ステップの多変数点を (時間) トークンに埋め込むことの不合理性について、研究者は時系列の逆の観点から開始し、各変数の時系列全体を独立して (変数) トークンに埋め込みました。局所の受容野を拡大するパッチングの極端な例。反転を通じて、埋め込まれたトークンはシーケンスのグローバル表現を集約します。これにより、より変数中心になり、複数変数の関連付けのためのアテンション メカニズムをより適切に利用できるようになります。同時に、フィードフォワード ネットワークは、ルックバック シーケンスによってエンコードされたさまざまな変数の一般化された表現を巧みに学習し、それらをデコードして将来のシーケンスを予測できます。

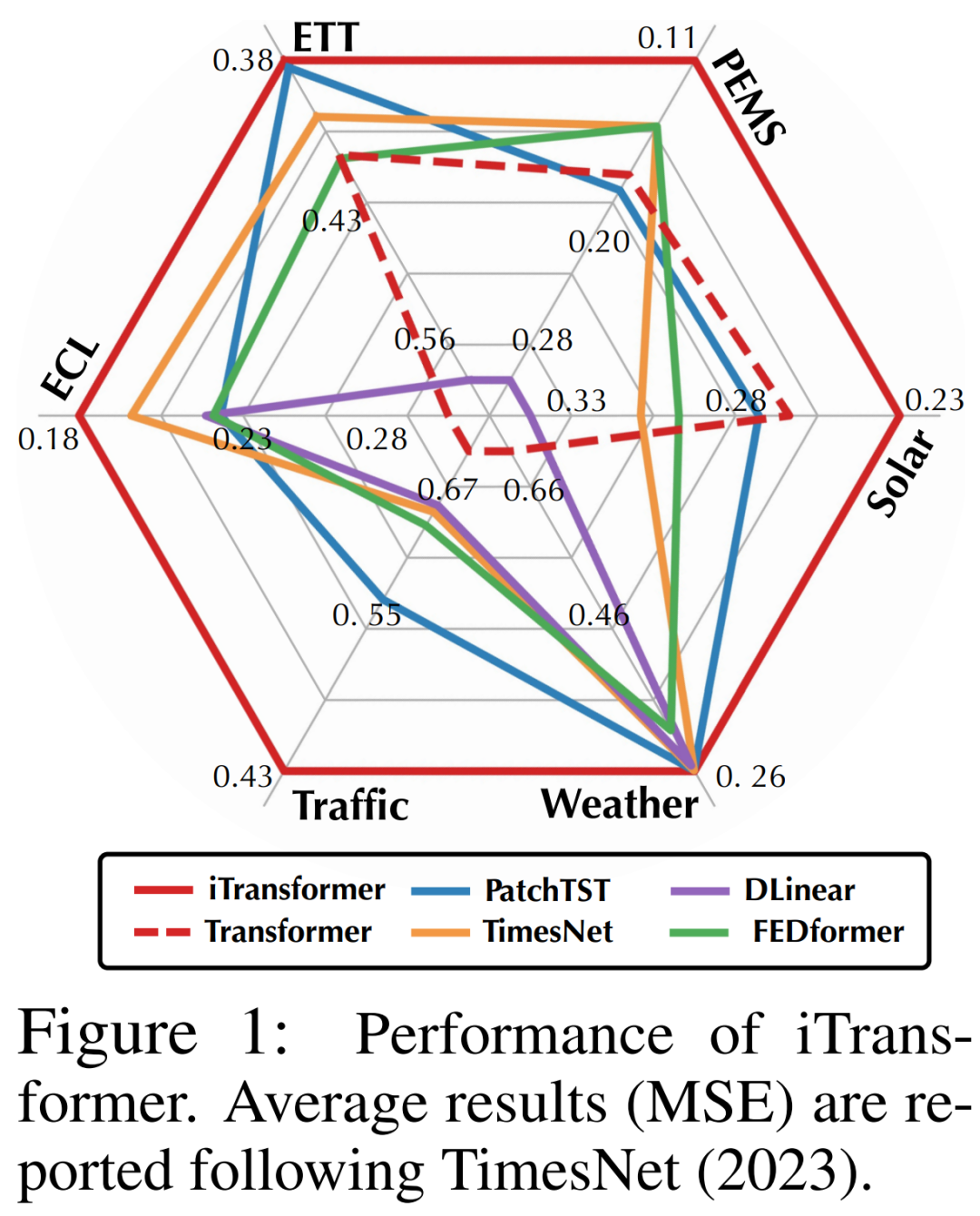

研究者らは、時系列予測において Transformer は無効ではないが、その使用は不適切であると指摘しました。この論文では、研究者らは Transformer の構造を再検討し、時系列予測の基本的な柱として iTransformer を推奨しました。各時系列を変数トークンとして埋め込み、多変数相関アテンション メカニズムを採用し、フィードフォワード ネットワークを使用してシーケンスをエンコードします。実験結果は、提案された iTransformer が実際の予測ベンチマーク図 1 で最先端のレベルに達し、Transformer ベースの予測器が直面する問題を予想外に解決することを示しています

研究者らは、時系列予測において Transformer は無効ではないが、その使用は不適切であると指摘しました。この論文では、研究者らは Transformer の構造を再検討し、時系列予測の基本的な柱として iTransformer を推奨しました。各時系列を変数トークンとして埋め込み、多変数相関アテンション メカニズムを採用し、フィードフォワード ネットワークを使用してシーケンスをエンコードします。実験結果は、提案された iTransformer が実際の予測ベンチマーク図 1 で最先端のレベルに達し、Transformer ベースの予測器が直面する問題を予想外に解決することを示しています

# 要約すると、この記事の貢献には次の 3 つのポイントがあります:

この記事で提案する iTransformer は、独立した時系列をトークンとして扱い、セルフアテンションを通じて多変数相関を捕捉し、層正規化とフィードフォワード ネットワーク モジュールを使用してより良いシーケンスを学習します。時系列予測のための表現。

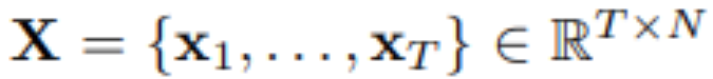

T タイム ステップと N 個の変数を使用して、研究者は将来の S タイム ステップを予測します。  ## #。便宜上、 はタイム ステップ t で同時に記録された多変量変数、

## #。便宜上、 はタイム ステップ t で同時に記録された多変量変数、 は各変数の n でインデックス付けされた時系列全体として表されます。現実の世界では、モニターのシステム遅延と緩やかに編成されたデータセットにより、

は各変数の n でインデックス付けされた時系列全体として表されます。現実の世界では、モニターのシステム遅延と緩やかに編成されたデータセットにより、 には本質的に同じタイムスタンプを持つ時点が含まれない可能性があることに注意してください。

には本質的に同じタイムスタンプを持つ時点が含まれない可能性があることに注意してください。

の要素は、物理的な測定値や統計分布において互いに異なる場合があり、変数  はこれらのデータを共有することがよくあります。

はこれらのデータを共有することがよくあります。

この記事で提案するアーキテクチャを備えた Transformer バリアントは iTransformer と呼ばれます。基本的に、Transformer バリアントにはこれ以上の特別な要件はありません。力のメカニズムは多変量相関モデリングに適している必要があることに注意してください。したがって、効果的なアテンション メカニズムのセットは、変数の数が増加したときに関連付けの複雑さを軽減するプラグインとして機能します。

iTransformer は 4 番目の図に示されており、埋め込み、投影、Transformer ブロックを含む、より単純な Transformer エンコーダ アーキテクチャを使用しています。

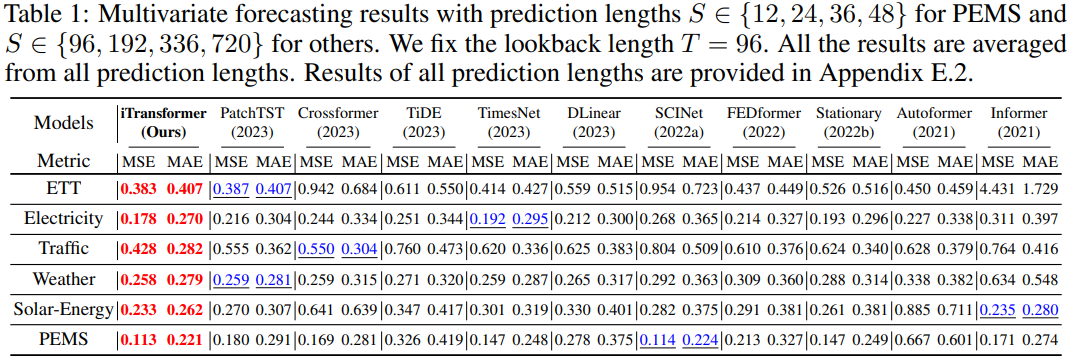

研究者らは、さまざまな時系列予測アプリケーションにおける iTransformer の包括的な評価を実施し、フレームワークの汎用性を確認し、責任の逆転の効果をさらに研究しました。特定の時系列ディメンションに対する Transformer コンポーネントの分析

研究者らは、ETT、気象、電力、交通データ セット、太陽データ セットなど、6 つの現実世界のデータ セットを実験に広範囲に含めました。およびPEMSデータセット。詳細なデータセット情報については、原文を参照してください

##書き換えられた内容は次のとおりです: 予測結果

# が表示されます表 1 に示すように、赤色が最良を示し、下線が最良を示します。 MSE/MAE が低いほど、書き換えられたコンテンツの予測結果はより正確になります。この記事で提案する iTransformer は SOTA パフォーマンスを実現します。ネイティブの Transformer コンポーネントは時間モデリングと多変量相関が可能で、提案された反転アーキテクチャは現実世界の時系列予測シナリオを効果的に解決できます。

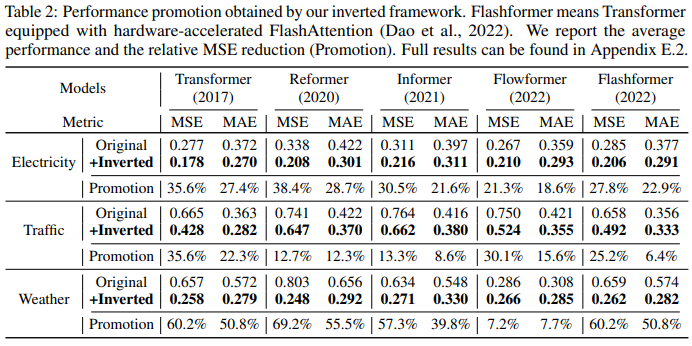

##このフレームワークを Transformer とそのバリアントに適用して iTransformer を評価した研究者は、これらのバリアントが一般に、Reformer、Informer、Flowformer、FlashAttender などのセルフアテンション メカニズムの 2 次の複雑さに対処していることを発見しました。研究者らはまた、視点を反転するだけで、Transformer ベースの予測器のパフォーマンスが向上し、効率が向上し、目に見えない変数に一般化され、過去の観測データをより有効に活用できることも発見しました。

表 2 Transformerそして対応する iTransformers が評価されました。このフレームワークがさまざまなトランスフォーマーを改善し続けていることは注目に値します。全体として、トランスフォーマーは平均 38.9%、リフォーマーは平均 36.1%、インフォーマーは平均 28.5%、フローフォーマーは平均 16.8%、フラッシュフォーマーは平均 32.2% 向上しました。

もう 1 つの要因は、iTransformer が Transformer ベースの予測器で広く使用できることです。これは、iTransformer が変数次元のアテンション メカニズムの逆構造を採用し、線形複雑さによる効率的なアテンションを導入し、原因となる効率の問題を根本的に解決するためです。 6 つの変数。この問題は現実のアプリケーションでは一般的ですが、チャネルに依存しない場合はリソースを消費する可能性があります

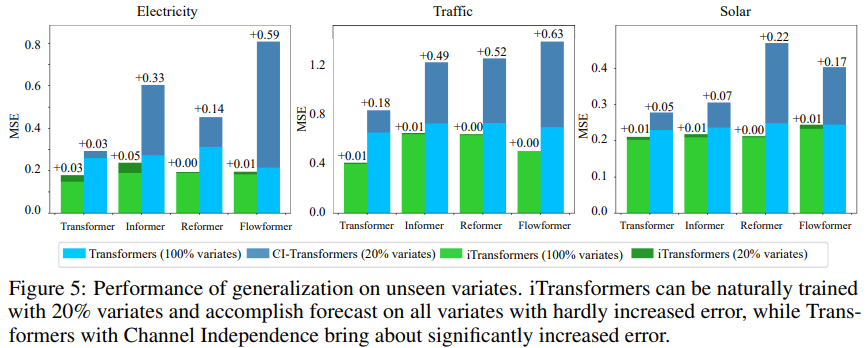

仮説を検証するために、研究者は iTransformer の比較を使用しました。これは、共有トランスフォーマーがすべてのバリアントのパターンを学習するように強制する、チャネル独立という別の一般化戦略で作成されます。図 5 に示すように、チャネル独立 (CI-Transformers) の汎化誤差は大幅に増加する可能性がありますが、iTransformer の予測誤差の増加ははるかに小さいです。

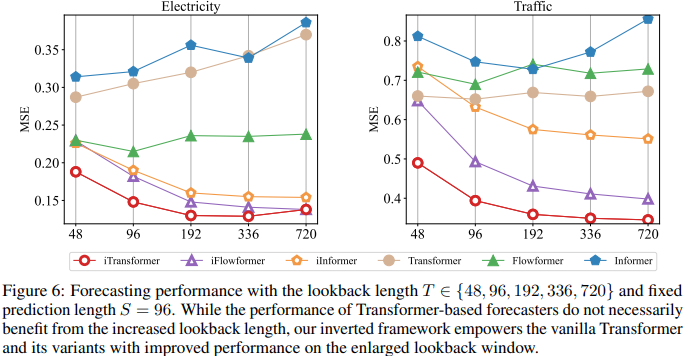

アテンション ネットワークとフィードフォワード ネットワークの役割が逆転しているため、図 6 ではルックバック長が増加するにつれて Transformer と iTransformers のパフォーマンスを評価しています。これは、時間次元で MLP を活用する理論的根拠を検証します。つまり、トランスフォーマーは拡張されたルックバック ウィンドウの恩恵を受け、より正確な予測を実現できます。

#モデル解析

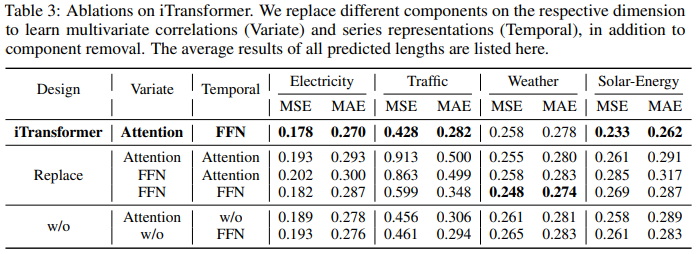

Transformer の合理性を検証するためにコンポーネント、研究 著者らは、コンポーネントの交換 (Replace) 実験やコンポーネントの除去 (w/o) 実験を含む、詳細なアブレーション実験を実施しました。表 3 に実験結果を示します。

以上がTransformer Revisited: 逆変換がより効果的となり、現実世界の予測のための新しい SOTA が登場の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。