書き換えた内容は以下の通りです:Machine Heart Report

編集者: チェン・ピン、ダー・パン・チキン

LeCun氏は、学術関係者の大多数はオープンAIの研究開発を非常に支持しているが、依然として反対者もいると述べた。

人工知能のリスクの問題に関しては、各当事者の専門家によって異なる意見があります。誰かが人工知能研究所に対し、研究をただちに中止するよう求める共同書簡を開始しました。深層学習の重要人物であるジェフリー・ヒントンとヨシュア・ベンジオは全員、この見解を支持しています

つい最近、ベンジオ、ヒントンらは共同書簡「急速な発展時代における人工知能のリスク管理」を発表し、研究者に対し、AI システムを開発する前に緊急ガバナンス措置を講じ、安全性と倫理的実践を組み込むよう呼びかけました。 、AIによってもたらされるリスクを管理するための措置を講じるよう政府に求めています。

書き換えられた内容は次のとおりです: この記事では、人工知能の悪用を防ぐために国家機関を関与させるなど、いくつかの緊急のガバナンス対策について言及しています。効果的に規制するには、政府が AI の開発を包括的に理解する必要があります。規制当局は、モデルの登録、内部告発者の権利と利益の効果的な保護、モデル開発とスーパーコンピューターの使用の監視などの一連の措置を講じるべきである。規制当局は、潜在的に危険な機能を理解するために、導入前に高度な AI システムを評価する必要もあります。

それだけではなく、もう少し遡ると、今年 5 月、米国の非営利団体である人工知能セキュリティセンターは、人工知能も同様のリスクがあると見なすべきであると警告する声明を発表しました。伝染病として人類を滅ぼすという声明を支持しており、同じ人物にはヒントン、ベンジオなどが含まれます。今年 5 月、ヒントン氏は人工知能がもたらすリスクについて自由に話すために Google での職を辞任しました。ニューヨーク・タイムズ紙とのインタビューで同氏は、「ほとんどの人は、これ(AIの害)はまだ遠い先の話だと考えている。私も以前はまだ遠い先のこと、おそらく30年から50年、あるいはそれ以上かかるだろうと思っていた。でも明らかに、私はそう思った」と語った。今はそうは思いません。」

ヒントンらにとって、人工知能によってもたらされるリスクの管理は緊急の課題です

それにもかかわらず、ユアン・ルコン氏はディープラーニングの 3 人の巨人の 1 人として、人工知能の開発に対して非常に楽観的な態度をとっています。彼は人工知能の発展は人類に対する脅威ではないと信じており、人工知能のリスクに関する共同書簡に署名することに基本的に反対している。

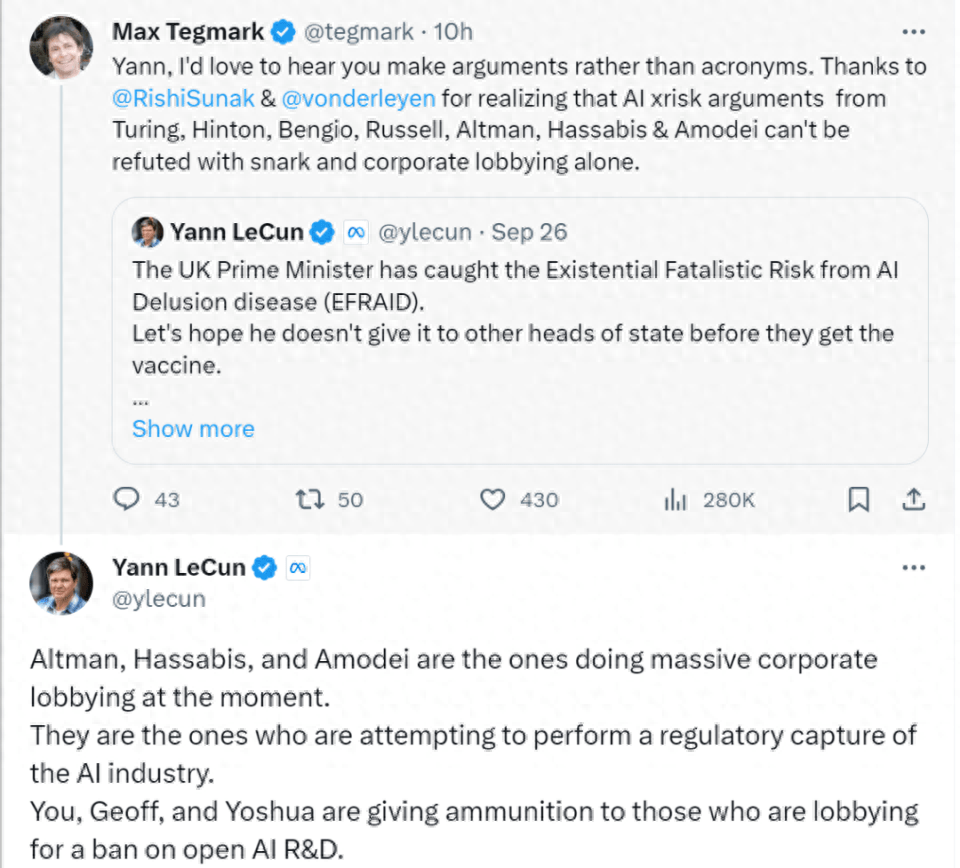

先ほど、X ユーザーとのコミュニケーションの中で、LeCun は AI リスクに関するネチズンからのいくつかの質問に答えました。

このネチズンは、記事「『これが彼の気候変動だ』: リシ・スナックの遺産封印を支援する専門家たち」についてルカンに意見を求めた。記事は、ヒントン氏とベンジオ氏らが共同で発表した声明が人工知能に対する人々の見方を変えたと考えている。 AI を支援ツールとして捉えることから、潜在的な脅威として捉えるようになります。記事は続けて、ここ数カ月間、人工知能が世界の終末を引き起こすのではないかと心配する人が増えていることを英国の観察者らが発見したと述べている。今年3月、英国政府は人工知能のイノベーションを抑制しないと約束する白書を発表した。しかし、わずか 2 か月後、英国は人工知能に制限を設けることについて議論を開始し、世界的な人工知能ルールの計画に米国が参加するよう促しました。

このネチズンは、記事「『これが彼の気候変動だ』: リシ・スナックの遺産封印を支援する専門家たち」についてルカンに意見を求めた。記事は、ヒントン氏とベンジオ氏らが共同で発表した声明が人工知能に対する人々の見方を変えたと考えている。 AI を支援ツールとして捉えることから、潜在的な脅威として捉えるようになります。記事は続けて、ここ数カ月間、人工知能が世界の終末を引き起こすのではないかと心配する人が増えていることを英国の観察者らが発見したと述べている。今年3月、英国政府は人工知能のイノベーションを抑制しないと約束する白書を発表した。しかし、わずか 2 か月後、英国は人工知能に制限を設けることについて議論を開始し、世界的な人工知能ルールの計画に米国が参加するよう促しました。

コンテンツを中国語に書き直してください。元の文は表示する必要はありません

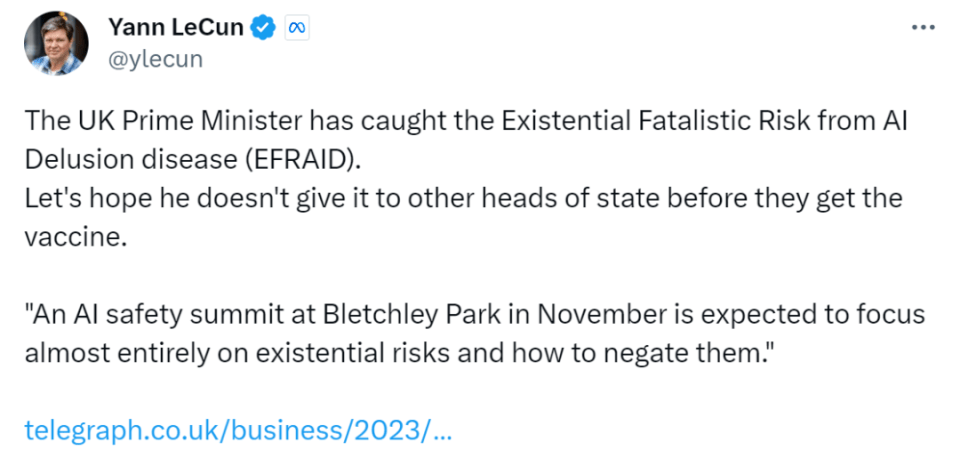

この記事に対するルカン氏の反応は、AI の致命的なリスクについての英国の懸念が他国に広がることを望まないというものだった。

その後、前述した LeCun と X ユーザー間のコミュニケーションが行われます。以下はすべて LeCun の回答です:

あなたのキャンペーンが成功すれば、必然的に壊滅的な結果を招くでしょう。少数の企業が人工知能を制御することになります

学術関係者の大多数は、オープン AI の研究開発を非常に支持しています。あなたが説く終末のシナリオを信じる人はほとんどいません。あなた、ヨシュア、ジェフ、スチュアートだけが例外です。

多くの人と同様、私もオープン AI プラットフォームの大支持者です。人々の創造性、民主主義、市場原理、製品規制といった力の組み合わせを信じているからです。また、安全で私たちの制御下にある AI システムを構築することが可能であることも知っています。これについて具体的な提案をさせていただきました。これらはすべて、人々が正しいことを行うことにつながります。

AI は何もないところから生まれるものではなく、人間には制御できない自然現象ですが、そうではありません。その進歩は、私たちが知っているすべての人によって推進されています。私たちも彼らも、「正しいもの」を生み出す力を持っています。研究開発の規制を求めることは、これらの人々と彼らが働く組織が無能、無謀、自己破壊的、または邪悪であることを暗黙のうちに想定していることになります。しかしそれは真実ではありません

私は、あなたが恐れている終末のシナリオがばかげていることを証明するために、多くの議論を提示してきました。ここでは詳細には触れません。しかし、重要な点は、強力な AI システムがガードレールを含む目標によって駆動される場合、それらのガードレールと目標が設定されているため、システムは安全で制御可能であるということです。 (現在の自己回帰言語モデルは目標主導型ではないため、自己回帰言語モデルの弱点から推測すべきではありません)

オープンソースに関して言えば、あなたの活動はあなたが追求しているものとは正反対の効果をもたらすでしょう。将来、人工知能システムは人類の知識と文化の宝庫となり、誰もがそれに貢献できるオープンソースかつ無料のプラットフォームが必要です。オープン プラットフォームのみが人間のあらゆる知識と文化を反映できるため、Wikipedia と同様に、これらのプラットフォームへの貢献はクラウドソーシングされる必要があります。プラットフォームが開いていない場合、これは機能しません

オープンソースの AI プラットフォームが規制されれば、別の状況が必然的に発生します。つまり、少数の企業が AI プラットフォームを制御し、ひいては人々のデジタル依存全体を制御することになります。これは民主主義にとって何を意味するのでしょうか?これは文化的多様性にとって何を意味しますか?これが私を夜も眠れなくさせてしまうのです。 』

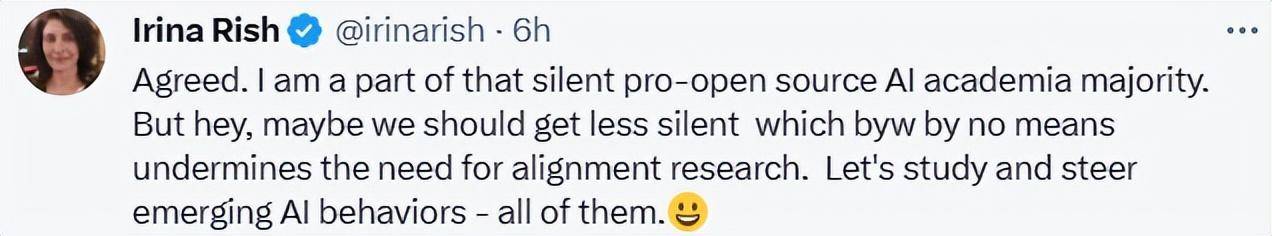

ルカン氏の長いツイートの下で、多くの人が彼の見解を「支持」しました。

Irina Rish は、モントリオール大学コンピューター サイエンスおよびオペレーション リサーチ学部の教授で、ミラ ケベック AI Institute の中心メンバーです。彼女は、オープンソース AI を支持する研究者はもはや沈黙しているべきではなく、新興 AI の開発において主導的な役割を果たすべきだと信じています

e/acc 創設者の Beff Jezos 氏もコメント欄で、そのようなコメントは重要であり、人々が必要としているものであると述べました。

ネチズンは当初、安全保障問題について議論することで将来のテクノロジーに対するみんなの想像力を豊かにすることができるが、センセーショナルなSF小説が独占政策の出現につながるべきではないと述べた。

ポッドキャストのホストであるレックス・フリッドマンは、この討論会からさらに楽しみにしていることがあります。

AI リスクに関する議論は、今後の AI の発展にも影響を及ぼします。あるアイデアが注目を集めると、人々は盲目的にそれに従います。双方が合理的な議論を続けてこそ、AIの「本当の姿」が見えてくるのです。

以上がチューリング賞受賞者らは議論、ルカン: ベンジオ、ヒントン、その他の AI 絶滅理論はばかげているの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。