原題: Cross-Dataset Experimental Study of Radar-Camera Fusion in Bird's-Eye View

論文リンク: https://arxiv.org/pdf/2309.15465.pdf

著者の所属: Opel Automobile GmbH Rheinland -ファルツィッシェ工科大学カイザースラウテルン ランダウ ドイツ人工知能研究センター

論文のアイデア:

補完的なセンサー情報を活用することで、ミリメーターはウェーブレーダーとカメラフュージョンシステムは、高度な運転支援システムと自動運転機能に非常に堅牢で信頼性の高い認識システムを提供する可能性があります。カメラベースの物体検出の最近の進歩により、ミリ波レーダーとカメラの融合に新たな可能性がもたらされ、鳥瞰図の特徴マップを融合に活用できます。この研究では、新規で柔軟な融合ネットワークを提案し、2 つのデータセット (nuScenes と View-of-Delft) でそのパフォーマンスを評価します。実験結果によると、カメラ ブランチには大規模で多様なトレーニング データが必要ですが、ミリ波レーダー ブランチでは高性能ミリ波レーダーの恩恵がより多く得られます。この研究は転移学習を通じて、より小さなデータセットでのカメラのパフォーマンスを向上させます。研究結果はさらに、ミリ波レーダーとカメラの融合手法が、カメラのみまたはミリ波レーダーのみを使用するベースライン手法よりも大幅に優れていることを示しています。

ネットワーク設計:

##最近の 3D オブジェクト検出のトレンドは、画像の特徴を一般的な鳥瞰図 (BEV) 表現に変換することです。この表現は、複数のカメラ間で、または測距センサーを使用して融合できる、柔軟な融合アーキテクチャを提供します。この研究では、もともとレーザー カメラ フュージョンに使用されていた BEVFusion 手法をミリ波レーダー カメラ フュージョン用に拡張します。私たちは、選択したミリ波レーダー データセットを使用して、提案した融合手法をトレーニングし、評価しました。いくつかの実験で、各データセットの長所と短所について議論します。最後に、さらなる改善を達成するために転移学習を適用します

#書き直す必要があるものは次のとおりです。

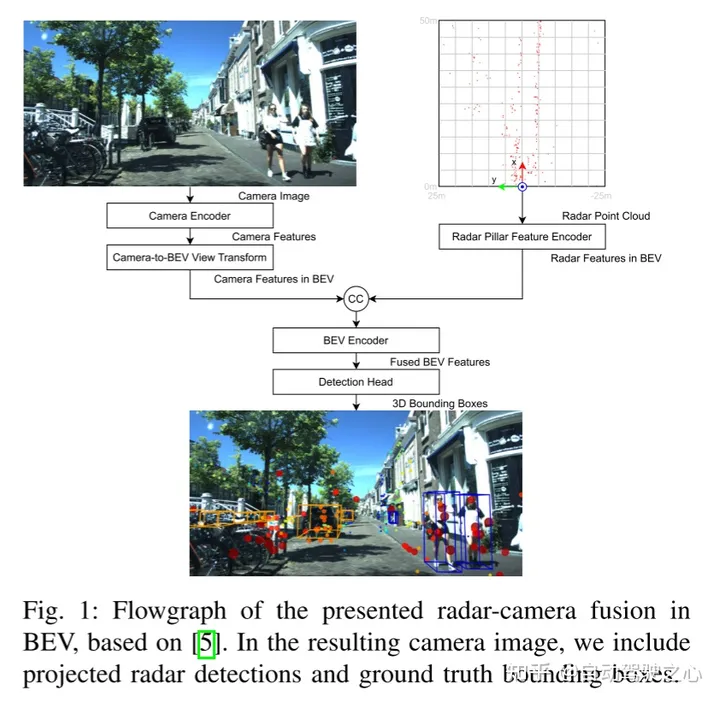

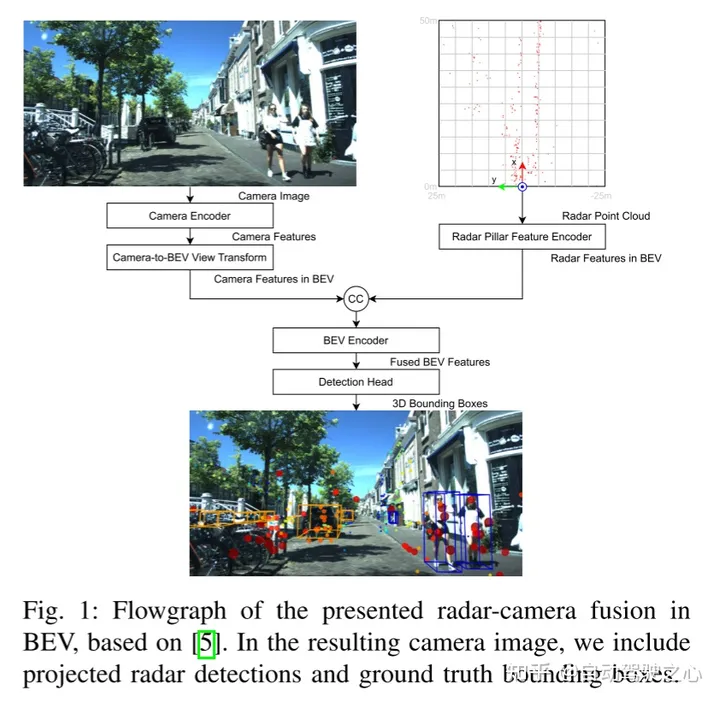

図1にBEVFusionに基づくBEVミリ波レーダーとカメラの融合フローチャートを示します。生成されたカメラ画像には、投影されたミリ波レーダーと実際のバウンディング ボックスの検出結果が含まれます。

この記事は、BEVFusion の融合アーキテクチャに従います。図 1 に、本稿での BEV におけるミリ波レーダーとカメラの融合のネットワーク概要を示します。カメラとミリ波レーダーのシグネチャが BEV で接続されると、融合が発生することに注意してください。この記事では、以下で各ブロックの詳細を説明します。

書き直す必要がある内容は次のとおりです。 A. カメラ エンコーダとカメラから BEV ビューへの変換

カメラ エンコーダとビュー変換は、[15] のアイデアを採用しています。柔軟なフレームワークは、任意のカメラの外部および内部パラメータの画像 BEV 特徴を抽出できます。まず、tiny-Swin Transformer ネットワークを使用して各画像から特徴が抽出されます。次に、この論文では、[14] の Lift および Splat ステップを使用して、画像の特徴を BEV 平面に変換します。この目的を達成するために、高密度深度予測の後に、特徴が擬似点群に変換され、ラスター化されて BEV グリッドに蓄積されるルールベースのブロックが続きます。

レーダー ピラー フィーチャ エンコーダ

このブロックの目的は、ミリ波レーダー点群を画像 BEV フィーチャと同じグリッド上の BEV フィーチャにエンコードすることです。この目的を達成するために、この論文では、[16] のピラー特徴エンコード技術を使用して、点群を無限の高さのボクセル、いわゆるピラーにラスタライズします。

書き換えが必要な内容は次のとおりです。 C. BEV エンコーダ

[5]と同様に、ミリ波レーダーとカメラの BEV 機能はカスケード フュージョンによって実現されます。融合された特徴は共同畳み込み BEV エンコーダーによって処理されるため、ネットワークは空間的な位置ずれを考慮し、異なるモダリティ間の相乗効果を活用できます。

D. 検出ヘッド

この記事では、CenterPoint 検出ヘッドを使用して予測を行います。各クラスのオブジェクト中心のヒートマップ。さらに回帰ヘッドは、オブジェクトのサイズ、回転、高さだけでなく、nuScenes の速度とクラス プロパティを予測します。ヒート マップはガウス焦点損失を使用してトレーニングされ、残りの検出ヘッドは L1 損失を使用してトレーニングされます。

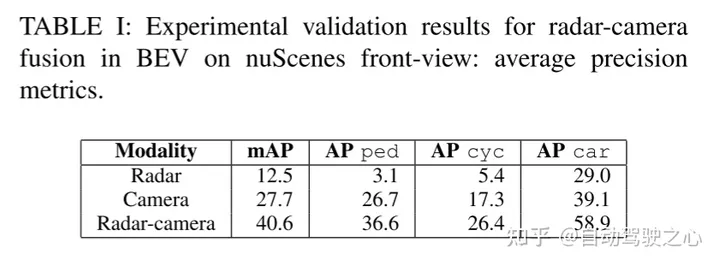

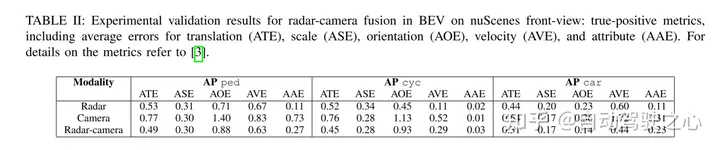

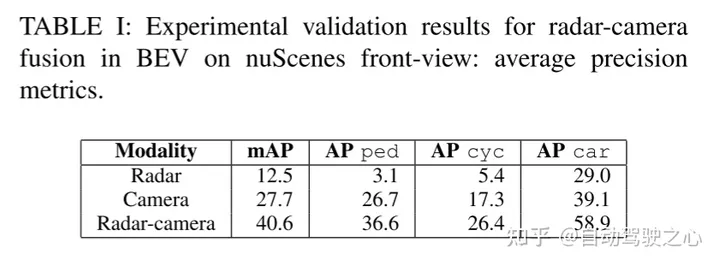

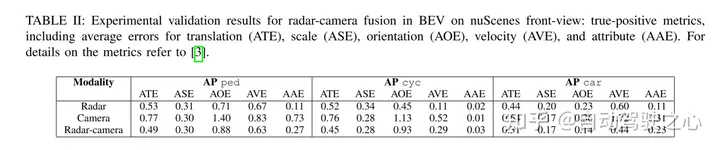

実験結果:

##

引用:

Stäcker, L.、Heidenreich, P.、Rambach, J.、Stricker, D. (2023). 「鳥のレーダーとカメラの融合」 eye view" Cross-dataset Experimental Research". ArXiv. /abs/2309.15465

書き直す必要がある内容は次のとおりです: 元のリンク; https://mp.weixin .qq.com/s/5mA5up5a4KJO2PBwUcuIdQ

以上がBEV におけるデータセット間のレーダーとカメラの融合に関する実験的研究の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。