IT House News 6月14日 IT Houseの友人たちは、AIが生成した結果を使ってAIを訓練し、「マトリョーシカ式トレーニング」を行ったら、どのような結果が得られるのか想像したことがあるだろう。現在、これを観察、記録した研究チームがあり、詳細な論文と結果が arXiv で公開されています。

一文で要約 - 「トレーニングでモデルによって生成されたコンテンツを使用すると、その後生成されるモデルに取り返しのつかない欠陥が生じます。」 人間の言葉で言えば、研究者らは、「AI によって生成された結果を使用して AI をトレーニングすると、モデルは悪化しています。」

▲ 画像ソース arXiv

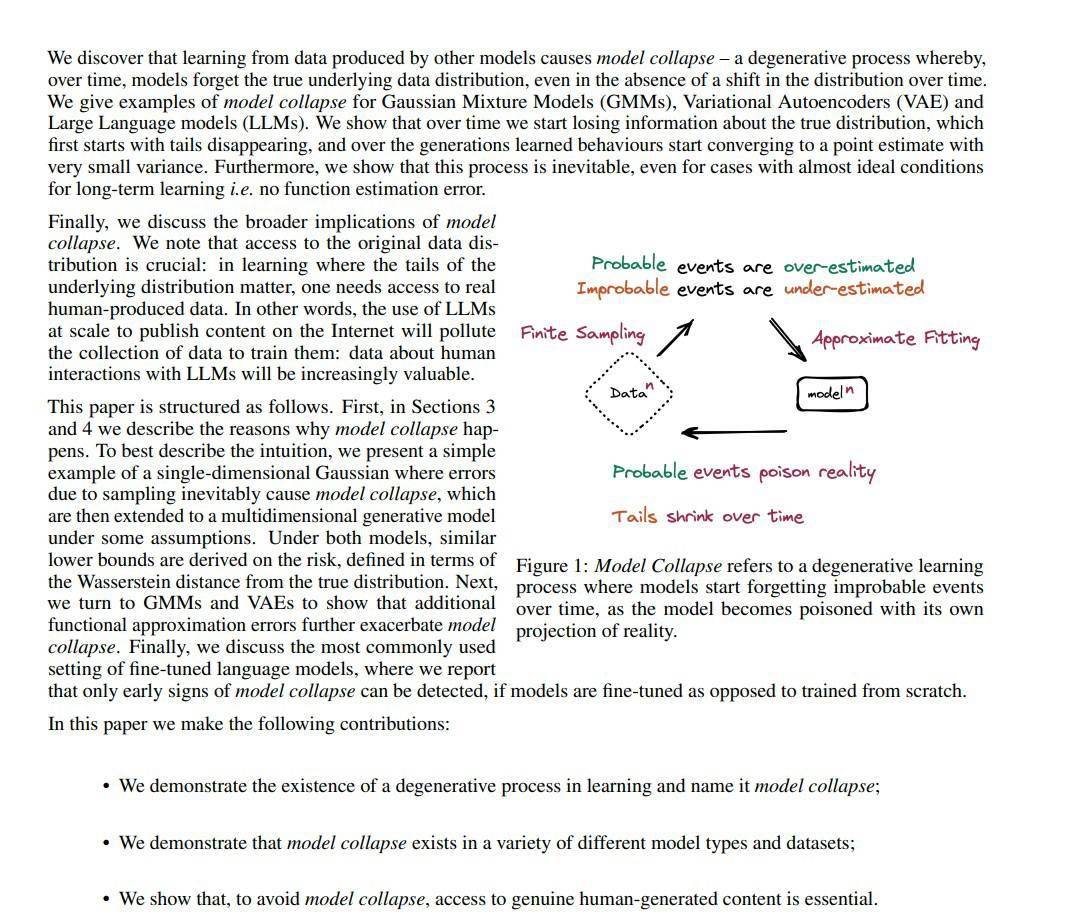

研究者らは、主に「テキストからテキスト」と「画像から画像」に焦点を当てて、AI 生成モデルの確率分布を具体的に研究し、最終的に次のように結論付けたと報告されています。「各モデルによって生成された結果には特定の特徴があるため、したがって、AI によって生成されたモデルを使用して AI をトレーニングすると、時間の経過とともに、後者は実際の基礎となるデータ分布を忘れてしまいます。」

この論文の主要著者の一人である

イリア・シュマイロフ氏も、「時間の経過とともに、生成されたデータのエラー (IT Home Note: 誤った例など) により、AI はさらに現実を誤って認識するようになるだろう。」と述べています。モデルのクラッシュは非常に早く発生し、モデルは最初に学習した元のデータの多くをすぐに忘れてしまう可能性があります。」しかし、友人は疑問を持つかもしれません。AI によって生成された結果を手動で磨き上げてからモデルのトレーニングに導入した場合、モデルは「劣化」する可能性がありますか?

答えはノーです。研究者らは、「モデルの劣化プロセスは避けられない」ことを発見しました。そのため、「洗練され理想化された AI 出力コンテンツ」であっても、モデルは長期学習後に一定の劣化を経験します。

どのような大規模なモデルであっても、過大な学習データにより他のAIが生成したデータとの接触が避けられないため、研究者らは「誤りを含む可能性のある学習データを選別するためにAI識別を導入すべきだ」としている。モデルの学習能力と精度を向上させるため。

以上がマトリョーシカ人形はお勧めできません: 研究者らは、AI が生成した結果を使って AI をトレーニングするとモデルの劣化につながることを確認していますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。