ChatGPT (Transformer クラス モデル) には、忘れられやすいという致命的な欠陥があります。入力シーケンスのトークンがコンテキスト ウィンドウのしきい値を超えると、その後の出力内容は前のロジックと一致しなくなります。

ChatGPT は 4000 トークン (約 3000 ワード) の入力しかサポートできません。新しくリリースされた GPT-4 でさえ、最大トークン ウィンドウは 32000 しかサポートしていません。入力シーケンスの長さが増加し続けると、計算量が増加します。も増加します。二次関数的に増加します。

最近、DeepPavlov、AIRI、およびロンドン数理科学研究所の研究者は、リカレント メモリ トランスフォーマー (RMT) を使用して、BERT の有効コンテキスト長を「前例のない 200 万トークン」に増やしながら、維持した技術レポートを発表しました。高いメモリ検索精度。

ペーパーリンク: //m.sbmmt.com/link/459ad054a6417248a1166b30f6393301

このメソッドは、ローカルおよびグローバル情報を保存および処理でき、ループを使用して情報を保存できるようにします。入力シーケンスの各部分がセグメント間を流れます。

実験セクションでは、このアプローチの有効性を実証します。このアプローチは、自然言語の理解および生成タスクにおける長期的な依存関係の処理を強化し、メモリを大量に消費するアプリケーションの大規模なコンテキスト処理を可能にする並外れた可能性を秘めています。

ただし、世界にはフリーランチはありません。RMT はメモリ消費量を増やすことができず、ほぼ無制限のシーケンス長まで拡張できますが、RNN には依然としてメモリ減衰の問題があり、より長い推論時間が必要です。 。

しかし、一部のネチズンが解決策を提案しました。RMT は長期記憶に使用され、大きなコンテキストは短期記憶に使用され、モデルトレーニングは夜間に実行されます。 /メンテナンス中。

2022 年、チームは、入力または出力シーケンスに特別なメモリ トークンを追加し、制御するモデルをトレーニングすることにより、Cyclic Memory Transformer (RMT) モデルを提案しました。メモリ操作とシーケンス表現処理は、元の Transformer モデルを変更せずに新しいメモリ メカニズムを実装できます。

論文リンク: https://arxiv.org/abs/2207.06881

公開されたカンファレンス: NeurIPS 2022

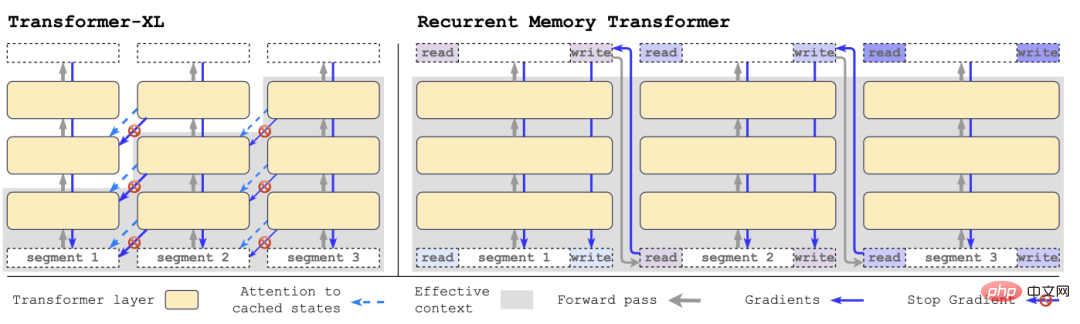

with Transformer-XLそれに比べて、RMT は必要なメモリが少なく、より長い一連のタスクを処理できます。

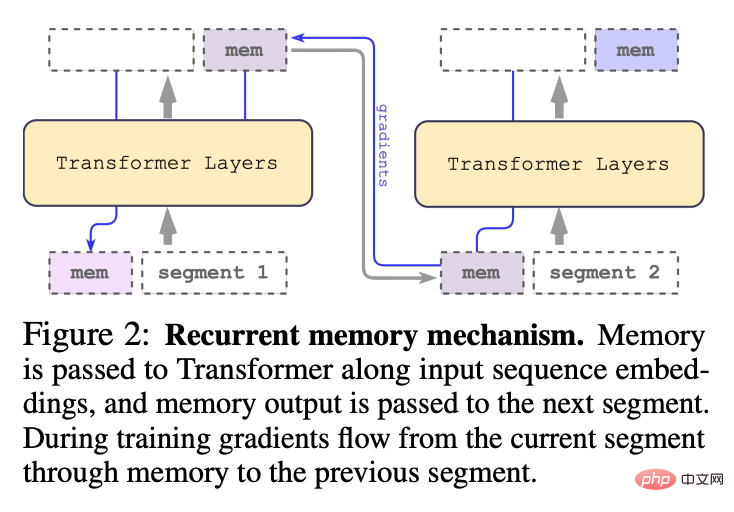

具体的には、RMT は m 個の実数値の学習可能なベクトルで構成されます。長すぎる入力シーケンスはいくつかのセグメントに分割され、メモリ ベクトルは最初のセグメントにプリセットされます。セグメントの埋め込みとセグメント トークンと一緒に処理されます。

2022 年に提案されたオリジナルの RMT モデルとは異なり、BERT のような純粋なエンコーダー モデルの場合、メモリはセグメントの先頭に 1 回だけ追加され、デコード モデルは記憶は読み取りと書き込みの 2 つの部分に分かれています。

各タイム ステップとセグメントで、次のようにループします。ここで、N はトランスフォーマー層の数、t はタイム ステップ、H はセグメントです

入力シーケンスのセグメントを順番に処理した後、再帰的接続を実現するために、研究者は現在のセグメントのメモリ トークンの出力を次のセグメントの入力に渡します。

RMT のメモリとループはグローバル メモリ トークンのみに基づいており、バックボーンの Transformer モデルを変更せずに維持できるため、RMT のメモリ拡張機能はあらゆる Transformer モデルと互換性があります。

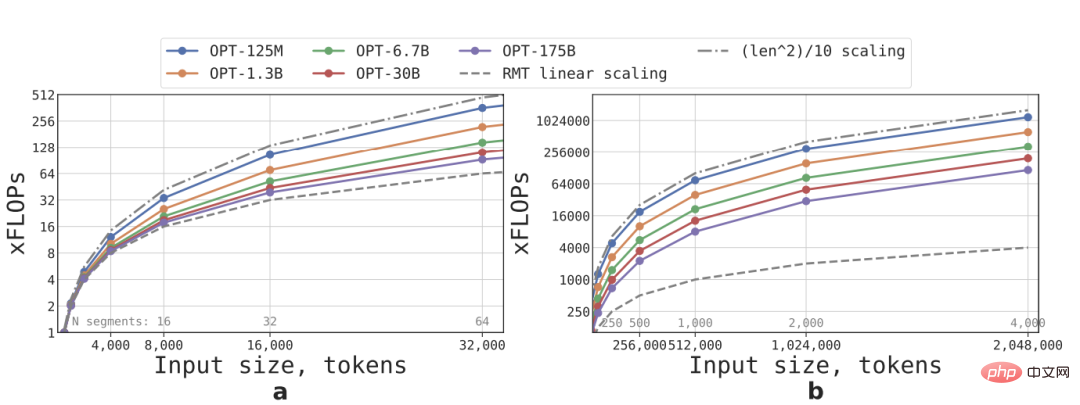

線形拡張は、入力シーケンスをいくつかのセグメントに分割し、セグメントの境界内でのみアテンション マトリックス全体を計算することによって実現されます。長さは固定されており、RMT の推論速度はモデル サイズに関係なく直線的に増加します。

FFN 層の計算量が多いため、大規模な Transformer モデルでは、シーケンスの長さに比べて二次関数の成長率が遅くなる傾向がありますが、長さが 32,000 を超える非常に長いシーケンスでは、FLOP は二次関数に戻ります。成長の様子。

複数のセグメントを持つシーケンス (この調査では 512 より大きい) の場合、RMT は非巡回モデルよりも FLOP が低く、小規模なモデルでは FLOP の効率を最大 295 倍向上させることができます。 OPT-175Bなどの機種では29倍まで増やすことができます。

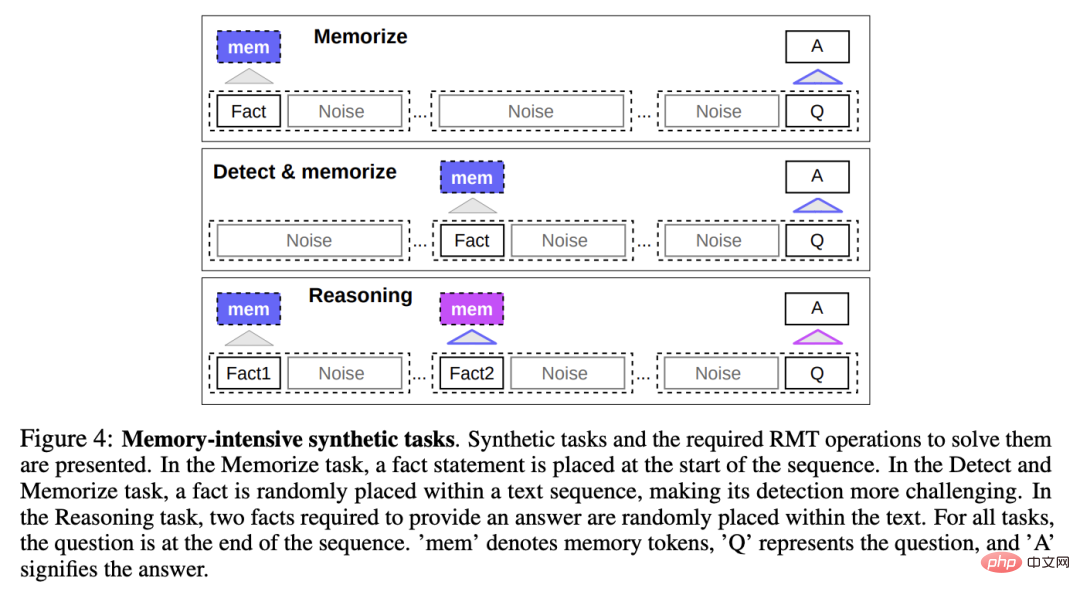

記憶能力をテストするために、研究者らは、モデルが単純な事実と基本的な推論を記憶することを必要とする合成データセットを構築しました。

タスク入力は、1 つまたは複数の事実と、これらすべての事実でのみ回答できる質問で構成されます。

タスクの難易度を高めるために、質問や回答に関係のない自然言語テキストもタスクに追加されますが、これらのテキストはノイズとみなされる可能性があるため、モデルのタスクは実際に事実を無関係なテキストから分離し、事実に基づくテキストを使用して質問に回答します。

事実の記憶

テスト RMT は、長期間にわたってメモリに情報を書き込み、保存します。時間パワー: 最も単純なケースでは、事実は入力の先頭にあり、質問は入力の最後にあり、モデルが一度にすべての入力を受け入れられなくなるまで、質問と回答の間にある無関係なテキストの量が徐々に増加します。 。

事実の検出と記憶

事実の検出は、入力内のランダムな位置に事実を移動することでタスクの難易度を高めます。 , required モデルはまず事実を無関係なテキストから分離し、それらをメモリに書き込み、最後に質問に答えます。

記憶された事実に基づく推論

記憶のもう 1 つの重要な操作は、記憶された事実と現在のコンテキストを使用して推論することです。

この機能を評価するために、研究者らは、2 つのファクトが生成され、入力シーケンスにランダムに配置される、より複雑なタスクを導入しました。その質問に答えるには、シーケンスの最後に尋ねられる質問を選択する必要があります。正しい事実。

研究者らは、すべての実験で RMT のバックボーンとして HuggingFace Transformers の事前トレーニング済み Bert ベース ケース モデルを使用しました。モデルはサイズ 10 の拡張メモリに基づいていました。

4 ~ 8 個の NVIDIA 1080Ti GPU でトレーニングと評価を行います。シーケンスが長い場合は、単一の 40GB NVIDIA A100 に切り替えて評価を高速化します。

カリキュラム学習

研究者らは、トレーニング スケジューリングを使用すると、ソリューションの精度と安定性が大幅に向上する可能性があることを観察しました。

最初は短いタスク バージョンで RMT をトレーニングさせます。トレーニングが収束したら、セグメントを追加してタスクの長さを増やし、理想的な入力長に達するまでコース学習プロセスを続けます。

単一セグメントに適合するシーケンスで実験を開始します。3 つの BERT の特殊マーカーと 10 個のメモリ プレースホルダーがモデル入力から保持されるため、実際のセグメント サイズは 499 となり、合計サイズは 512 になります。

短いタスクでトレーニングした後、RMT はより少ないトレーニング ステップで完璧なソリューションに収束するため、長いタスクを解決するのが簡単であることがわかります。

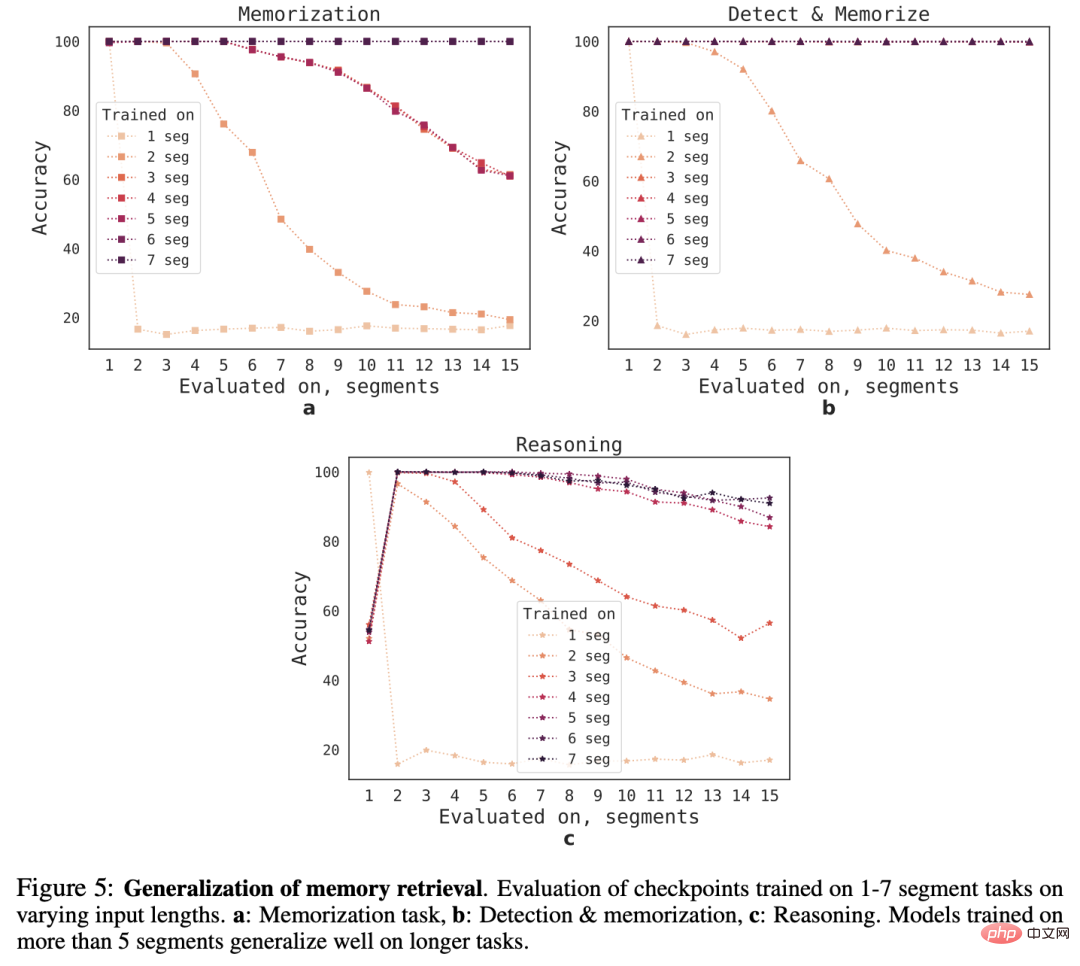

外挿能力

さまざまなシーケンス長に対する RMT の汎化能力を観察するために、研究者らは、さまざまな数のセグメントでトレーニングされたモデルを評価し、次のタスクを解決しました。より長い長さ。

モデルは多くの場合、短いタスクでは良好に実行されますが、より長いシーケンスでモデルをトレーニングした後は、単一セグメントの推論タスクを処理することが困難になることがわかります。

考えられる説明の 1 つは、タスク サイズが 1 セグメントを超えるため、モデルが最初のセグメントの問題を予測しなくなり、その結果品質が低下するということです。

興味深いことに、トレーニング セグメントの数が増加するにつれて、RMT のより長いシーケンスに対する一般化能力も現れます。5 つ以上のセグメントでトレーニングした後、RMT は 2 倍の長さのシーケンスを処理できるようになります。タスクのほぼ完璧な一般化です。

一般化の限界をテストするために、研究者らは検証タスクのサイズを 4096 セグメント (つまり、2,043,904 トークン) に増加しました。

RMT は、このような長いシーケンスに驚くほどよく耐えます。その中で「検出と記憶」タスクが最も単純で、推論タスクが最も複雑です。

参考資料: //m.sbmmt.com/link/459ad054a6417248a1166b30f6393301

以上がChatGPT健忘症を完全解決! Transformer の入力制限を突破: 200 万の有効なトークンをサポートできると測定の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。