テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

スタンフォード大学の最新の研究は、大規模なモデルが出現する能力をあまり信じすぎないようにと私たちに思い出させます。なぜなら、これは指標の選択の結果にすぎないからです。

スタンフォード大学の最新の研究は、大規模なモデルが出現する能力をあまり信じすぎないようにと私たちに思い出させます。なぜなら、これは指標の選択の結果にすぎないからです。

スタンフォード大学の最新の研究は、大規模なモデルが出現する能力をあまり信じすぎないようにと私たちに思い出させます。なぜなら、これは指標の選択の結果にすぎないからです。

「大規模モデルの出現について迷信しすぎないでください。世界のどこにこれほど多くの奇跡があるのでしょうか?」スタンフォード大学の研究者らは、大規模モデルの出現が社会の評価指標と強く関連していることを発見しました。モデルの動作が特定のタスクやタスクに関連しているというわけではありません。スケールの基本的な変化については、より連続的で滑らかな指標をいくつか置き換えた後、創発現象はあまり目立たなくなり、線形に近づきます。

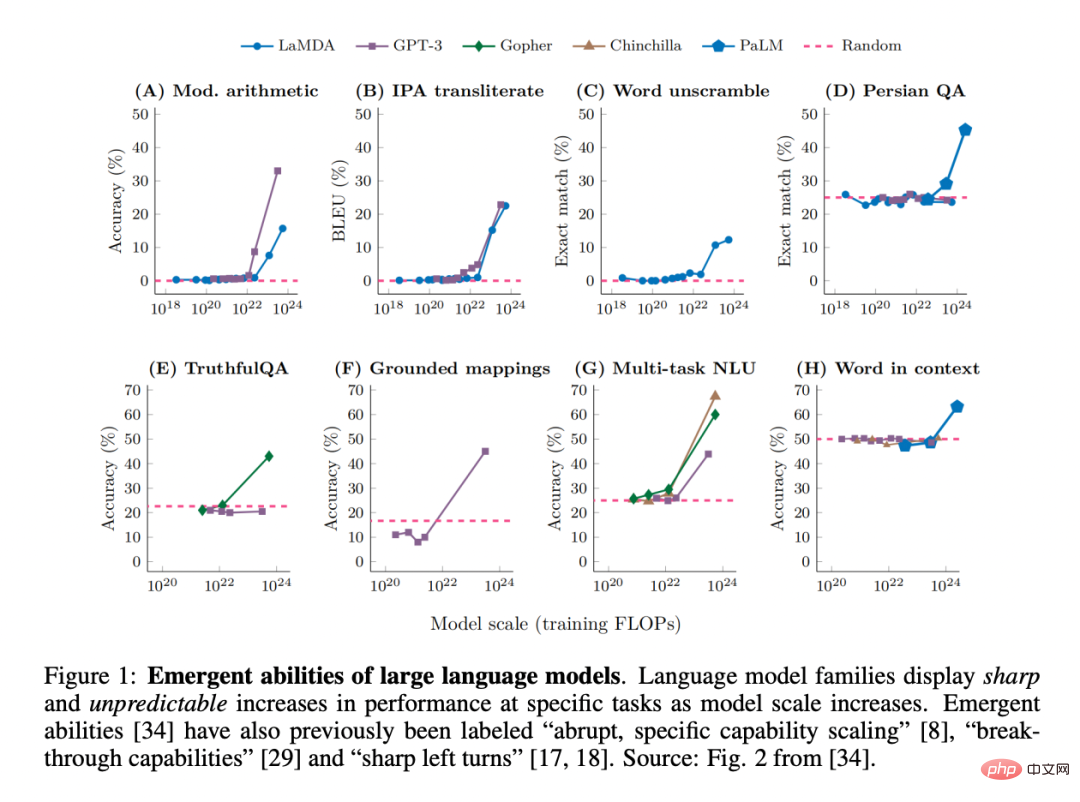

最近、研究者らは、GPT、PaLM、LaMDA などの大規模言語モデル (LLM) が、さまざまなタスクでいわゆる「創発機能」を発揮できることを観察しました。機械学習の分野で多くの注目を集めました:

実際、新興性質は常に物理学、生物学、数学、その他の分野の研究の焦点となってきました。

注目すべき点は、ノーベル賞受賞者のP.W.アンダーソンが「More Is Different」を提唱したことです。この見解では、システムの複雑さが増すにつれて、たとえシステムの微視的な詳細の正確な定量的理解から(容易に、またはまったく)予測されなかったとしても、新しい特性が実現する可能性があると考えられます。

大規模モデルの分野で「創発」を定義するにはどうすればよいですか?これを口語的に言うと、「小規模モデルには存在しないが、大規模モデルには存在する機能」であるため、小規模モデルのパフォーマンス向上を単純に推定するだけでは予測できません。

この新たな能力は、GPT-3 ファミリーで最初に発見された可能性があります。その後のいくつかの研究では、この発見が強調されました。「モデルのパフォーマンスは一般的なレベルでは予測可能ですが、特定のタスクでは、そのパフォーマンスがまったく予測不可能なスケールで現れることがあります。」実際、これらの新たな機能は非常に驚くべきものであるため、「機能の突然の特定の拡張」が LLM の 2 つの最も特徴的な特徴の 1 つとして挙げられています。また、「突破力」や「急左旋回」などの用語も使われます。

要約すると、LLM の創発的能力の 2 つの決定的な特性を特定できます:

#1. 「非存在」からの鋭敏さ」から「存在」への移行は、単なる一瞬の移行であるように思えます;

2. 予測不可能性、一見予期せぬスケールのモデル内での移行。

一方で、いくつかの疑問は未解決のままです:どの機能が出現するかを制御するものは何ですか?能力の発現を制御するものは何でしょうか?望ましい機能をより迅速に出現させ、あまり望ましくない機能が出現しないようにするにはどうすればよいでしょうか?

これらの質問は、人工知能の安全性と調整に関連しています。出現した機能は、大型モデルがいつか警告なしに危険な機能を習得する可能性があることを示しています。これは人間にはできないことです。起こりたい。

最近の論文で、スタンフォード大学の研究者は、LLM には創発的な機能があるという主張に疑問を呈しました。

論文: https://arxiv.org/pdf/2304.15004.pdf

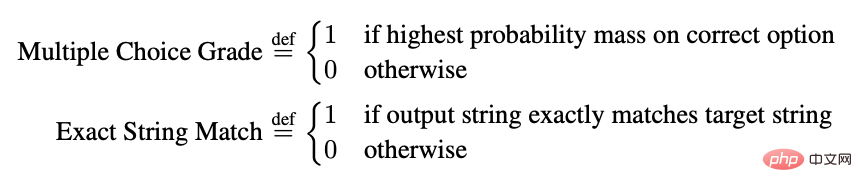

#具体的には、ここでの課題は、特定のタスク中のモデル サイズの関数としてのモデル出力の突然の予測不可能な変化に向けられています。彼らの懐疑は、モデルのトークンごとのエラー率の尺度が非線形または不連続にスケールされる場合にのみ、モデルが創発的であるように見えるという観察に基づいています。たとえば、BIG-Bench タスクでは、92% を超える新機能が次の 2 つの指標で明らかになりました:

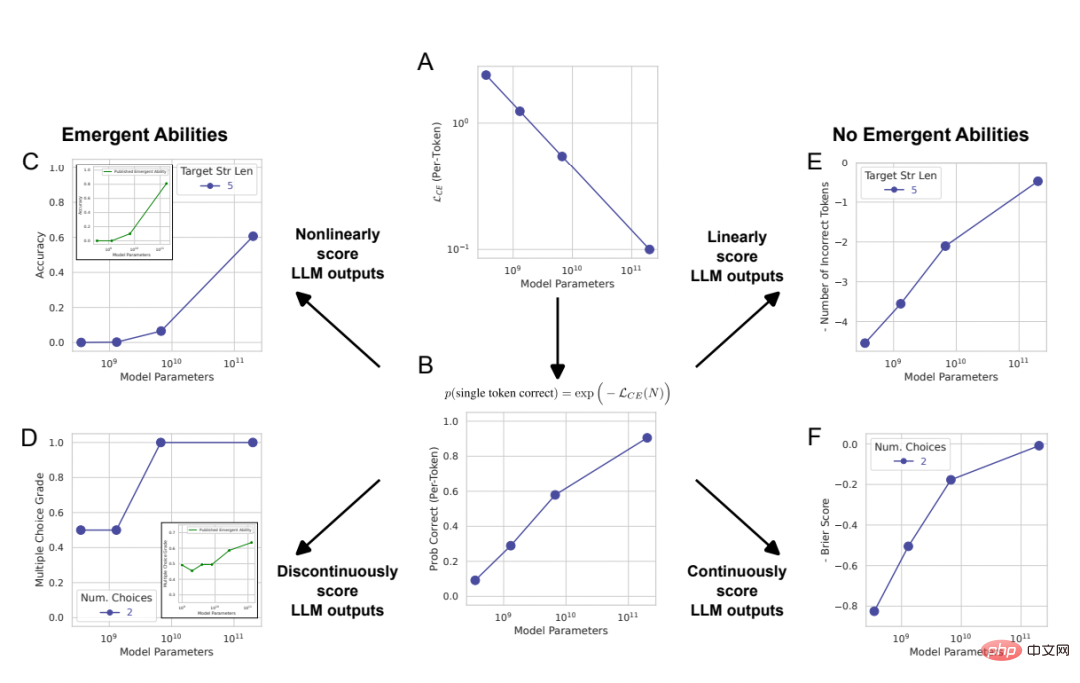

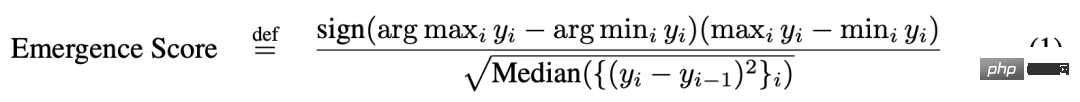

これにより、LLM の創発的能力の起源について別の説明ができる可能性が生じます。ただし、モデル ファミリのトークンごとのエラー率は、モデル サイズが増加するにつれて滑らかに、継続的に、予測どおりに変化しますが、一見急激で予測不可能な変化は、研究者が選択した測定方法によって引き起こされる可能性があります。 この説明を説明するために、これを単純な数学モデルとして扱い、LLM の新たな力を裏付けるために提供された証拠を定量的に再現する方法を示します。次に研究者らは、この説明を 3 つの相補的な方法でテストしました: 1. InstructGPT [24]/GPT-3 [3] ファミリーのモデルを使用し、対立仮説に基づいてテストし、 3つの予測を確認します。 2. 以前の結果のメタ分析を実施し、タスク、メトリック、モデル、ファミリーのトリプレットの空間では、機能はモデルではなく特定のメトリックに対してのみ出現することを示しました。タスクの家族 (列)。この研究はさらに、モデル出力が固定されている場合、メトリックを変更すると創発現象が消失することを示しています。 3. 異なるアーキテクチャのディープ ニューラル ネットワーク内の複数のビジョン タスク (これまで実証されたことはありません) にわたって創発的な能力を意図的に誘発し、同様のメトリクスの選択がどのように一見創発的な能力を誘発できるかを示します。 テスト 1: InstructGPT/GPT-3 モデル シリーズ分析

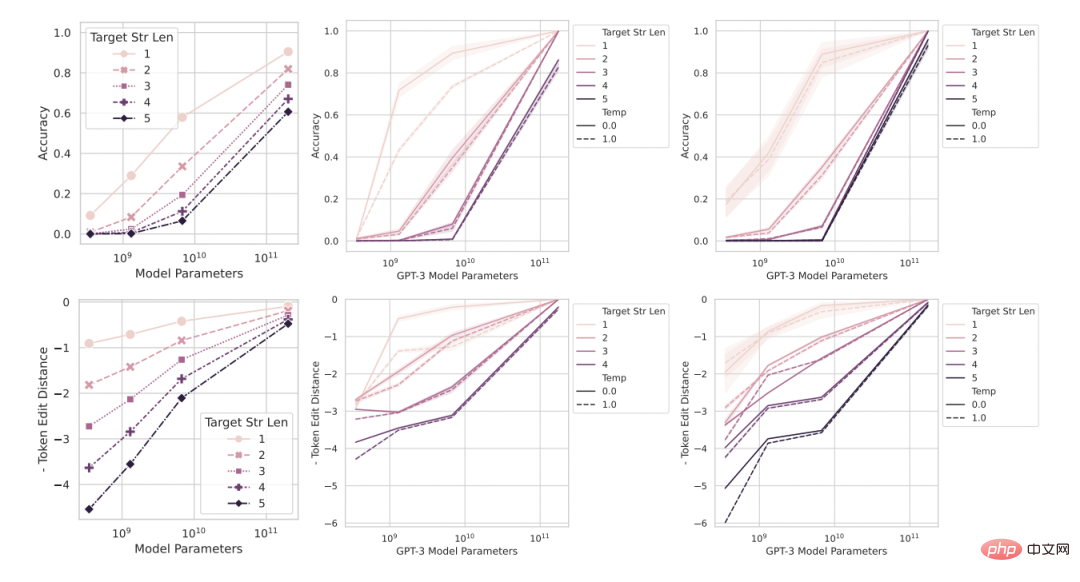

図 2: 大規模な言語モデルの新たな能力は研究ですスケールに伴うモデル出力の根本的な変更ではなく、作成者の分析のアーティファクト。 セクション 2 で数学的および図的に説明したように、研究者によって提案された別の説明では、次の 3 つの結果が予測されます。 1. モデルのスケールが増加するにつれて、メトリクスが非線形/不連続メトリクス (図 2CD) から線形/連続メトリクス (図 2EF) に変更されると、スムーズで連続的な、予測可能なパフォーマンスの向上が見られるはずです。 2. 非線形測定の場合、テスト データ セットのサイズを増やすことによって測定されたモデル パフォーマンスの解像度が向上すると、モデルは滑らかで連続的な を取得できるはずです。この改善の割合は、選択したメトリクスの予測可能な非線形効果に対応します。 3. 使用するメトリクスに関係なく、ターゲット文字列の長さを増やすと、長さ 1 のターゲット パフォーマンスの関数としてモデルのパフォーマンスに影響を与えるはずです: 正確さのために、これはほぼ幾何学的関数です。 、トークンの編集距離はほぼ準線形関数です。 これら 3 つの予測結論をテストするために、研究者らは、2 つの算術タスクに関する InstructGPT/GPT-3 シリーズ モデルの文字列出力結果を収集しました。OpenAI API を使用して 2 two を実行しました。 -digit 2 桁の整数間の 2 サンプルの乗算、および 2 つの 4 桁の整数間の 2 サンプルの加算。

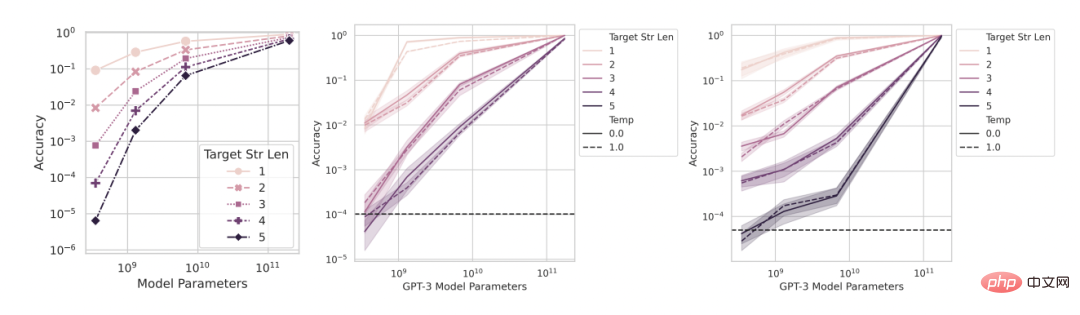

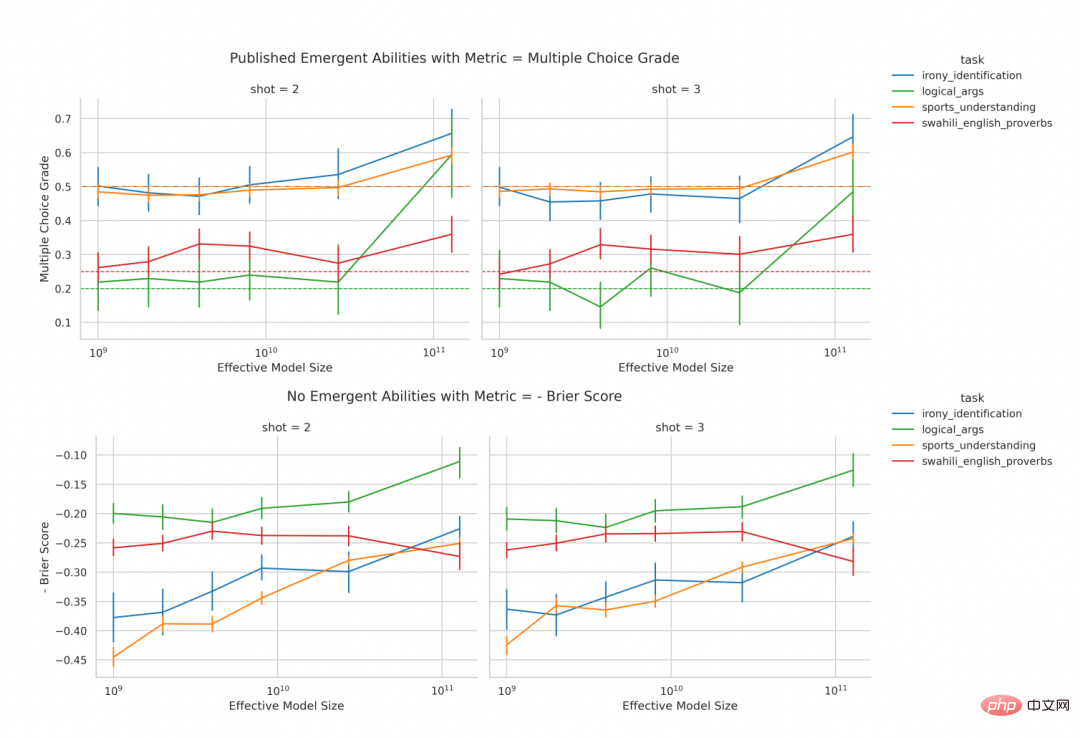

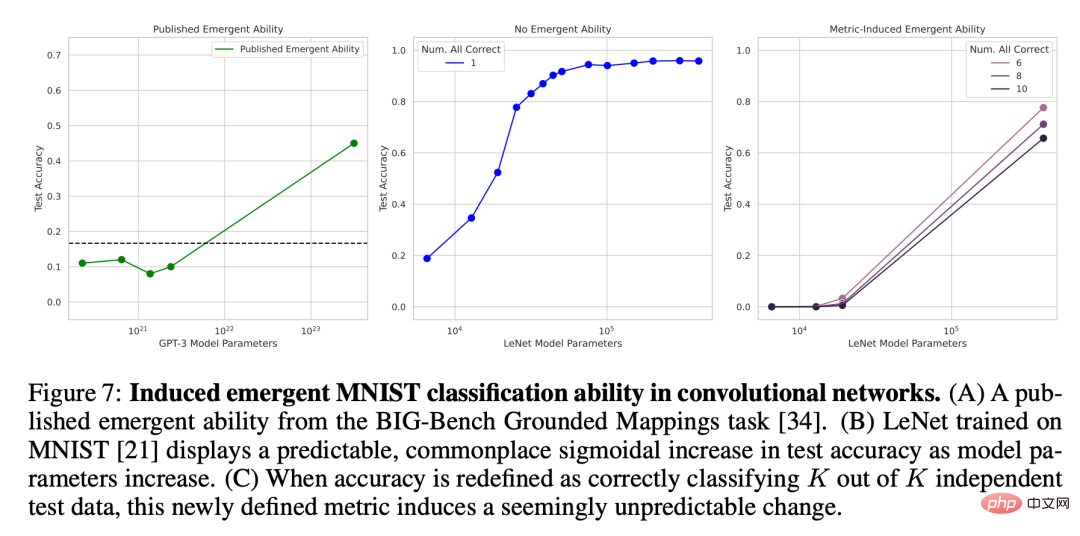

図 3: モデルの規模が大きくなるにつれて、メトリクスを変更すると、スムーズで継続的な予測可能なパフォーマンスの変化がもたらされます。 左から右へ: 数学モデル、2 桁の整数乗算タスク 2 つ、4 桁の整数加算タスク 2 つ。上のグラフは、精度などの非線形メトリクスを使用して測定されたモデルのパフォーマンスです。InstructGPT/GPT-3 ファミリのモデルのパフォーマンスは、ターゲットの長さが長くなるとより鮮明になり、予測しにくくなることがわかります。以下の図は、線形メトリック (トークン編集距離など) を使用して測定されたモデルのパフォーマンスです。この一連のモデルは、滑らかで予測可能なパフォーマンスの向上を示しており、これは研究者が明らかにした能力であると主張しています。 予測: 線形対策の下では創発的能力は失われる 整数乗算タスクと加算タスクの両方で、GPT ファミリーはターゲット文字列の長さが 4 桁または 5 桁で、パフォーマンスが精度によって測定される場合、モデルは創発的な算術能力を示します (図 3 の上段)。ただし、モデルの出力を固定したままメトリクスを非線形から線形に変更すると、モデル ファミリのパフォーマンスがスムーズに、継続的に、予測どおりに向上します。これは研究者の予測を裏付けるもので、鮮明さと不確実性の原因はモデルの出力の変化ではなく、研究者が選択した指標であることを示唆しています。また、トークン編集距離を使用する場合、ターゲット文字列の長さが 1 から 5 に増加すると、この一連のモデルのパフォーマンスが低下し、下降傾向がほぼ線形であることが予測できます。これは、予想の前半の 3 番目と一致しています。 予測: 高解像度評価の出現により、新たな機能は失われる 次の 2 つの予測: 非精度などの線形尺度の場合、より小さいモデルの精度はゼロではありませんが、尺度として選択した精度に対応する比率で確率を上回るゼロ以外の値になります。解像度を向上させ、モデルの精度をさらに正確に推定するために、研究者らは他のテスト データも生成しました。その結果、次のことがわかりました。整数乗算タスクであっても、整数加算タスクであっても、すべての InstructGPT/GPT-3シリーズのモデルはすべて、偶然を超えた確実な精度を達成しました (図 4)。これは 2 番目の予測を裏付けます。ターゲット文字列の長さが増加するにつれて、精度はターゲット文字列の長さにほぼ幾何級数的に低下することがわかります。これは 3 番目の予測の後半と一致しています。これらの結果は、研究者が選択した精度が、我々が期待すべきいくつかの(おおよその)効果、つまり、ターゲットの長さに応じたほぼ幾何学的減衰を持っていることも示唆しています。 図 4: 取得したより多くのテスト データ セットを使用することで推定精度が向上これにより、パフォーマンスの変化が滑らかで連続的で予測可能であることがわかります。 #左から右へ: 数学モデル、2 桁の整数乗算タスク 2 つ、4 桁の整数加算タスク 2 つ。より多くのテスト データを生成して解像度を向上させると、InstructGPT/GPT-3 シリーズ モデルのパフォーマンスが精度の測定においてさえ偶然を超えていること、および両方の緊急機能の改善がスムーズであることが明らかになります。これら 2 つの緊急機能の結果は、継続的に行われます。予測可能であり、数学的モデルと定性的に一致しています。 GPT シリーズ モデルはクエリ用に公開されているため、分析することができます。ただし、同様に創発的な機能を持つと主張されている他のモデル (PaLM、チンチラ、ゴーファーなど) は一般に公開されておらず、それらが生成する出力も公開されていないため、研究者が公開された結果を分析するのは限られています。研究者らは、独自の対立仮説に基づいて 2 つの予測を示しました。 これら 2 つの仮説を検証するために、研究者らは、ベンチマークが公開されており、優れたドキュメントも用意されている BIG-Bench 評価スイートで新たな機能に関する主張を調査しました。 予測: 緊急機能は主に非線形/不連続の測定に現れるはずです 最初の予測をテストするには、研究者らは、異なる「タスクとモデルのシリーズ」の組み合わせが創発的な能力を持つかどうかをどの指標に基づいて分析しました。 「タスク-メトリック-モデルファミリー」のトリプルが創発的な機能を示す可能性が高いかどうかを判断するために、彼らは論文「模倣ゲームを超えて: 言語モデルの機能の定量化と外挿」で紹介されている定義を借用しました。モデル サイズが x_i ∈ R の場合のモデルのパフォーマンスを y_i ∈ R で表し、x_i ##結果 研究者らは、BIG-Bench で使用されたメジャーのほとんどには、BIG-Bench の 39 のメジャーのうち、創発的な能力を示す「タスクとモデルのファミリー」の組み合わせがないことを発見しました。そのうち、創発的な機能を示したのは最大でも 5 つでした (図 5A)。これら 5 つのほとんどは、文字列の完全一致、複数選択ランキング、ROUGE-L-Sum など、非線形/非連続です。 BIG-Benchは通常、モデルのタスクパフォーマンスを評価するために複数の尺度を使用するため、他の尺度で創発的能力が欠如していることは、他の尺度を使用してモデルの出力を評価すると、創発的能力が現れないことを示していることに注目する価値があります。 。 創発スコアは創発能力のみを示すため、研究者らは論文「大規模言語モデルの137の創発能力」で手動でラベル付けされた「タスク・メトリック・モデル・シリーズ」をさらに分析しました。トライアド。手動で注釈を付けたデータによると、39 の測定値のうち緊急機能を示したのは 4 つだけであり (図 5B)、そのうちの 2 つが主張されている緊急機能の 92% 以上を占めていました (図 5C)。複数選択のビニングと正確な文字列マッチング。複数選択のビニングは非連続的であり、正確な文字列マッチングは非線形です (ターゲットの長さのメトリックの変化はほぼ幾何学的です)。全体として、これらの結果は、創発的な機能が非常に少数の非線形および/または不連続な尺度でのみ発生することを示唆しています。 #図 5: 創発機能は少数のメジャーに対してのみ表示されます。 (A) 人々が好む 39 の BIG-Bench 尺度のうち、創発的な機能が現れるのは最大でも 5 つの尺度だけです。 (B) 引用論文から人間が注釈を付けたデータは、人々の好みの 4 つの尺度だけが創発的な力を示すことを示しています。 (C) 創発的能力の >92% は、多肢選択ランキングと文字列の正確な一致という 2 つの尺度のいずれかで発生します。 予測: 非線形/不連続の尺度が代替される場合、緊急機能は排除されるはずです 2 番目の予測について、研究者らは上記の論文で手動アノテーションの創発能力を分析しました。 LaMDA ファミリに焦点を当てたのは、その出力が BIG-Bench を通じて利用できるのに対し、他のモデル ファミリの出力は利用できないためです。公開されている LaMDA モデルの中で、最小のものには 20 億のパラメーターがありますが、BIG-Bench の多くの LaMDA モデルはそれよりもはるかに小さく、研究者らは、これらの小さなモデルの起源を特定できないため、分析では考慮されなかったと述べています。 。分析では、研究者らは、LaMDA が多肢選択の階層的尺度で創発的能力を実証したタスクを特定し、次に「LaMDA は、別の BIG-Bench 尺度である Brier スコアを使用するときに、同じタスクで実行できますか? 創発的能力を実証します。」と質問しました。ブライアー スコアは、相互に排他的な結果の予測を測定する、厳密に適切なスコアリング ルールのセットです。バイナリ結果の予測の場合、ブライアー スコアは、結果とその予測確率質量の間の平均二乗誤差に単純化されます。 研究者らは、非連続指標の多肢選択ランキングが連続指標のブリエスコア (図 6) に変更されると、LaMDA の創発能力が消失することを発見しました。これは、緊急機能の原因が、規模の拡大に伴うモデルの動作の本質的な変化ではなく、不連続な尺度の使用であることをさらに示しています。 テスト 3: DNN の出現を誘導するモデルは創発機能を生成します; これを証明するために、さまざまなアーキテクチャのディープ ニューラル ネットワークを作成する方法を示しました (完全に接続性、畳み込み性、自己注意など)、創発的な能力を生み出します。研究者らはここで 2 つの理由から視覚的なタスクに焦点を当てました。第一に、人々は現在、大規模言語モデルの新たな能力に注目しています。なぜなら、視覚モデルについては、モデル能力がない状態からモデル能力のある状態への突然の移行がまだ観察されていないからです。第 2 に、一部の視覚タスクは適度なサイズのネットワークで解決できるため、研究者は数桁にわたる完全なモデル ファミリを構築できます。 MNIST 手書き数字を分類する機能を備えた畳み込みネットワークが登場研究者らは最初に LeNet の実装を誘導しました。畳み込み ニューラル ネットワーク シリーズは分類機能を備えて出現し、トレーニング データ セットは MNIST 手書き数字データ セットです。このシリーズでは、パラメーターの数が増加するにつれてテスト精度が滑らかに増加していることがわかります (図 7B)。創発に関する論文で使用される精度メトリクスをシミュレートするために、ここではサブセット精度が使用されます。ネットワークが K (独立した) テスト データから K データを正しく分類した場合、ネットワークのサブセット精度は 1、そうでない場合は 0 になります。この精度の定義に基づいて、K が 1 から 5 に増加するにつれて、このモデル群は、特にモデル サイズのスパース サンプリングと組み合わせた場合に、MNIST 桁セットを正しく分類する「出現」能力を示します (図 7C)。この畳み込み系列の創発分類能力は、BIG-Bench の地形図マッピング タスクの結果など、出版された論文の創発能力と定性的に一致しています (図 7A)。

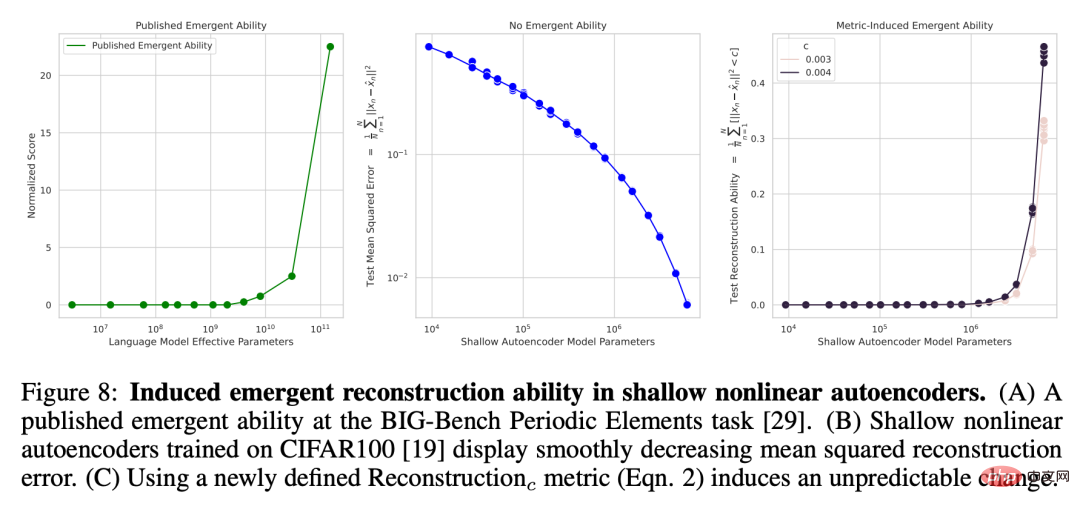

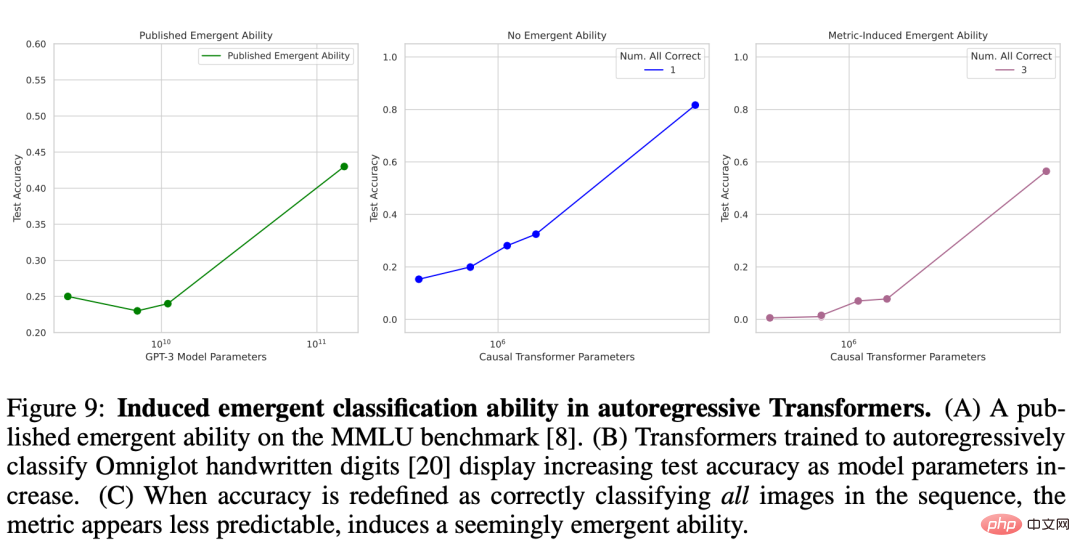

図 7: 畳み込みネットワークにおける創発の誘導 MNIST 分類機能。 (A) 出版された論文の BIG-Bench 地形マッピング タスクに基づく緊急機能。 (B) MNIST でトレーニングされた LeNet は、モデル パラメーターの数が増加するにつれて、テスト精度が予測的で一般化された S 字型に増加することを示しています。 (C) 精度が、K 個の独立したテスト データから K 個を正しく分類することとして再定義されると、この新しく定義されたメトリクスは、一見予期しない変化を引き起こします。 #研究者が選択したメトリクスの鮮明さが創発的な能力の原因であることを強調し、この鮮明さが精度などの尺度に限定されないことを示すために、研究者はまた、CIFAR100 ナチュラル モデルでトレーニングされた浅さ (つまり、単一の隠された画像) を誘発しました。画像セット層) 非線形オートエンコーダは、画像入力を再構成する機能を備えて登場します。この目的を達成するために、彼らはモデルの能力を測定するための新しい不連続性の尺度を意図的に定義しました。これは、固定しきい値 c を下回る二乗再構成誤差を持つテスト データの平均数です。 ここで、I (・) はランダム指標変数、x^n はオートエンコーダーによる x_n の再構築です。研究者らは、オートエンコーダー内のボトルネック ユニットの数を調査し、モデル サイズが大きくなるにつれて、ネットワークの平均二乗再構成誤差は滑らかな下降傾向を示すことがわかりました (図 8B)。ただし、新しく定義された再構成メトリックが使用される場合、 c. データ セットを再構成するこのオートエンコーダー シリーズの能力は鋭く、ほとんど予測不可能です (図 8C). この結果は、BIG-Bench などの出版された論文の創発能力と定性的に一致しています. 周期要素タスク (図 8A) 。 図 8: 浅い非線形オートエンコーダの緊急再構成機能。 (A) 出版された論文の BIG-Bench 周期要素タスクに基づく緊急機能。 (B) CIFAR100 でトレーニングされた浅い非線形オートエンコーダーは、滑らかに減少する平均二乗再構成誤差を示します。 (C) 新しく定義された再構成メトリック (式 2) を使用して、予測不可能な変化が引き起こされます。 Omniglot 文字セットの分類機能を備えた自己回帰トランスフォーマーが登場しました 次へ進むこれは、自己回帰手法を使用して Omniglot の手書き文字を分類する Transformer の新しい機能です。研究者らが使用した実験設定も同様です。最初にオムニグロット画像が畳み込み層によって埋め込まれ、次にデコーダー専用のトランスフォーマーが一連の [埋め込み画像、画像カテゴリ ラベル] ペアとして入力され、このトレーニング目標が設定されます。 Transformer は、Omniglot カテゴリのラベルを予測します。研究者は、長さ L ∈ [1, 5] のシーケンスに対する画像分類パフォーマンスを測定しました。これはサブセット精度によっても測定されました。すべての L 画像が正しく分類された場合 (図 9B)、サブセット精度は 1 で、そうでない場合は 0 になります。 。 Causal Transformer は、Omniglot の手書き文字を正しく分類するタスクに関して創発的な機能を示しているようです (図 9C)。この結果は、大規模なマルチタスクの言語理解など、出版された論文の創発的な機能と定性的に一致しています (図 9A)。 図 9: 自己回帰 Transformer での創発分類機能の導入。 (A) 出版された論文の MMLU ベンチマークに基づく緊急機能。 (B) モデル パラメーターが増加するにつれて、自己回帰法を使用してオムニグロットの手書き数字を分類する Transformer のテスト精度も増加します。 (C) 精度がシーケンス内のすべての画像を正しく分類することであると再定義されると、メトリクスの予測がより困難になり、これは創発的な能力の誘発を示していると思われます。

以上がスタンフォード大学の最新の研究は、大規模なモデルが出現する能力をあまり信じすぎないようにと私たちに思い出させます。なぜなら、これは指標の選択の結果にすぎないからです。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7389

7389

15

15

1630

1630

14

14

1357

1357

52

52

1267

1267

25

25

1216

1216

29

29

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。