この記事は Lei Feng.com から転載されたものです。転載する必要がある場合は、Lei Feng.com の公式 Web サイトにアクセスして許可を申請してください。

世界最大のアクセラレータチップCS-2ウェーハスケールエンジンの開発で有名な企業であるCerebrasは、人工知能のトレーニングに「ジャイアントコア」を使用するという重要な一歩を踏み出したと昨日発表した。同社は、世界最大の NLP (自然言語処理) AI モデルを単一チップ上でトレーニングしました。

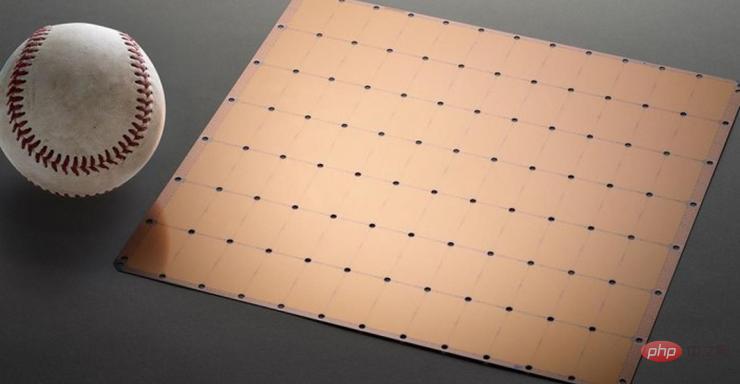

モデルには 20 億のパラメータがあり、CS-2 チップでトレーニングされています。世界最大の加速器チップは 7nm プロセスを使用し、正方形のウェハーからエッチングされます。主流のチップよりも数百倍大きく、15KWの電力があります。 2.6兆個の7nmトランジスタが統合され、85万個のコアと40GBのメモリがパッケージされています。

図 1 CS-2 ウェーハ スケール エンジン チップ

NLP モデルの開発は、人工知能の重要な分野です。 NLP モデルを使用すると、人工知能はテキストの意味を「理解」し、対応するアクションを実行できます。 OpenAI の DALL.E モデルは、典型的な NLP モデルです。このモデルは、ユーザーが入力したテキスト情報を画像出力に変換できます。

例えば、ユーザーが「アボカドの形をした肘掛け椅子」と入力すると、AIがこの文に対応する複数の画像を自動生成します。

写真: 情報を受け取ってAIが生成した「アボカドの形をした肘掛け椅子」の画像

それだけでなく、このモデルは、AIが種、幾何学、歴史的時代などの複雑な知識を理解できるようにすることもできます。等

しかし、これらすべてを実現するのは簡単ではありません。NLP モデルの従来の開発には、非常に高い計算能力コストと技術的閾値が伴います。

実際、数字だけを議論すると、Cerebras が開発したモデルの 20 億個のパラメータは、他のモデルと比較すると少し平凡に思えます。

前述の DALL.E モデルには 120 億のパラメータがありますが、現在最大のモデルは、DeepMind が昨年末に発表した Gopher で、2,800 億のパラメータがあります。

しかし、驚異的な数字とは別に、Cerebras が開発した NLP には大きな進歩があります。NLP モデルの開発の難しさを軽減します。

従来のプロセスによれば、NLP モデルを開発するには、開発者が巨大な NLP モデルをいくつかの機能部分に分割し、ワークロードを数百または数千のグラフィックス処理ユニットに分散する必要があります。

何千ものグラフィックス処理ユニットは、メーカーにとって莫大なコストを意味します。

技術的な問題もメーカーを悲惨にします。

モデルのスライスはカスタムの問題であり、各ニューラル ネットワーク、各 GPU、およびそれらを接続 (または相互接続) するネットワークの仕様は固有であり、システム間で移植可能ではありません。

メーカーは、最初のトレーニングの前に、これらすべての要素を明確に考慮する必要があります。

この作業は非常に複雑で、完了するまでに数か月かかる場合もあります。

セレブラス氏は、これが NLP モデル トレーニングの「最も苦痛な側面の 1 つ」であると述べました。 NLP を開発するために必要なリソースと専門知識を備えている企業はほんの一握りです。 AI 業界の他の企業にとって、NLP トレーニングは費用と時間がかかりすぎ、利用できません。

しかし、1 つのチップで 20 億のパラメーターを持つモデルをサポートできる場合、モデルのトレーニングのワークロードを分散するために大規模な GPU を使用する必要がないことを意味します。これにより、メーカーは何千もの GPU トレーニング コストと、関連するハードウェアおよびスケーリング要件を節約できます。また、ベンダーはモデルをスライスしてワークロードを数千の GPU に分散するという苦労をする必要がなくなります。

Cerebras は、モデルの品質を評価するために数値だけにこだわるわけではありません。パラメーターの数だけが基準ではありません。

セレブラスは、「巨大なコア」で生まれたモデルの「勤勉」を期待するのではなく、モデルが「賢い」ことを望んでいます。

Cerebras がパラメータ数の爆発的な増加を達成できる理由は、加重フロー技術を使用しているためです。このテクノロジーにより、計算量とメモリのフットプリントが分離され、AI ワークロードで増加する任意の数のパラメータを格納できる大きさにメモリを拡張できるようになります。

この画期的な進歩のおかげで、モデルのセットアップにかかる時間が数か月から数分に短縮されました。また、開発者は「数回のキーストローク」で GPT-J や GPT-Neo などのモデルを切り替えることができます。これにより、NLP 開発が容易になります。

これはNLPの分野に新たな変化をもたらしました。

Intersect360 Research の最高研究責任者である Dan Olds 氏は、Cerebras の成果について次のようにコメントしています。「費用対効果が高く、アクセスしやすい方法で大規模な言語モデルを大衆に提供する Cerebras の能力は、人工知能のエキサイティングな新時代を切り開きます。」

以上が世界最大の AI チップが大規模モデルの単一デバイス トレーニングの記録を破る、Cerebras は GPU を「抹殺」したいの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。