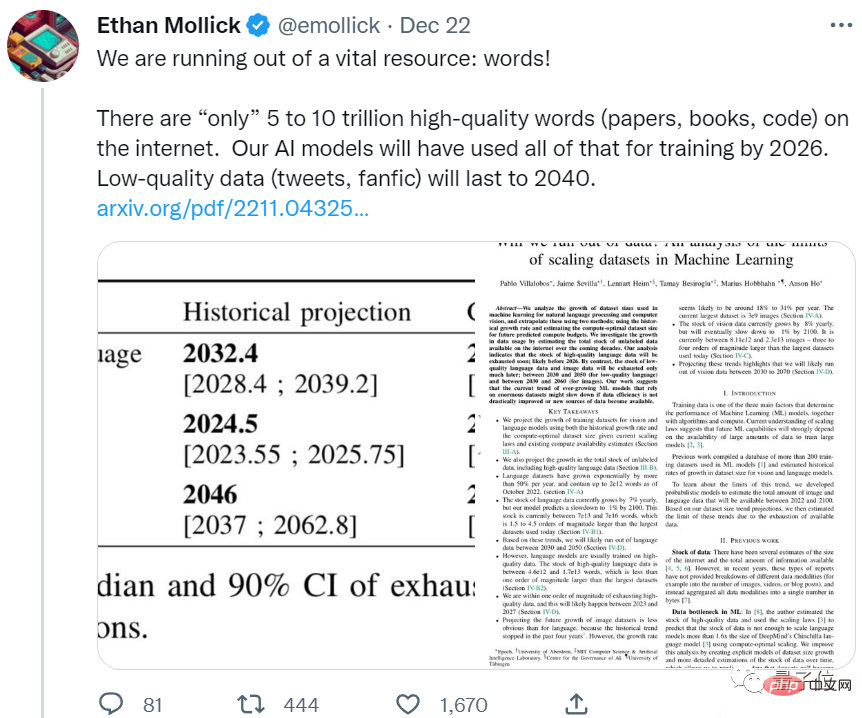

AI の食欲は大きすぎて、人間のコーパス データではもはや十分ではありません。

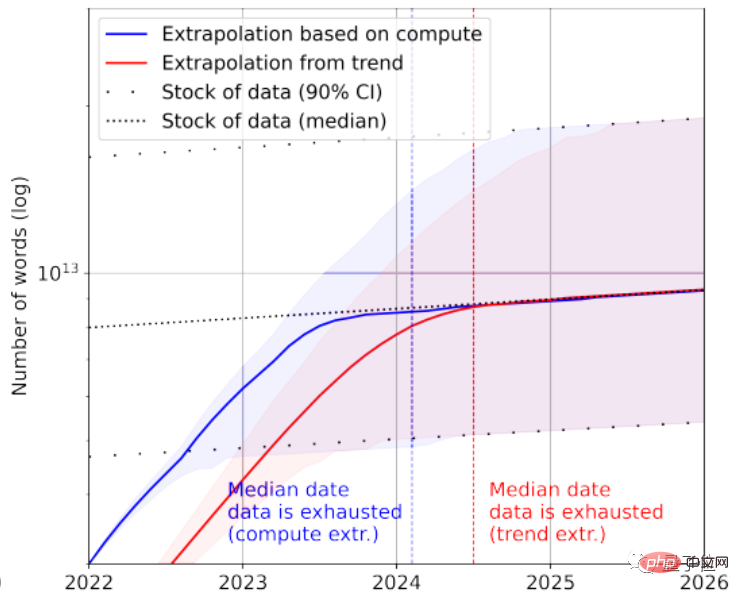

エポック社チームの新しい論文は、AI が 5 年以内に高品質のコーパスをすべて使い果たしてしまうことを示しています。

これは人間の言語データの増加率、つまり、新たに書かれた論文や新たに編集された書籍の数を考慮した予測結果であることを知っておく必要があります。近年の人間は、すべてのコードをAIに与えても十分ではありません。

この開発が続けば、高品質のデータに依存してレベルを向上させる大規模な言語モデルは、すぐにボトルネックに直面することになります。

一部のネチズンはじっと座っていられません:

これはばかげています。人間はインターネット上のすべてを読まなくても効果的に自分自身を訓練することができます。

私たちが必要としているのは、より多くのデータではなく、より優れたモデルです。

一部のネチズンは、AI に自分の嘔吐物を食べさせるほうが良いと嘲笑しました:

AI を生成することができますテキスト自体は低品質のデータとして AI に供給されます。

#見てみましょう。人間はどれくらいのデータを残しているでしょうか?

テキストや画像データの「在庫」はどうでしょうか?

この論文では主にテキストと画像データを予測します。

1つ目はテキストデータです。

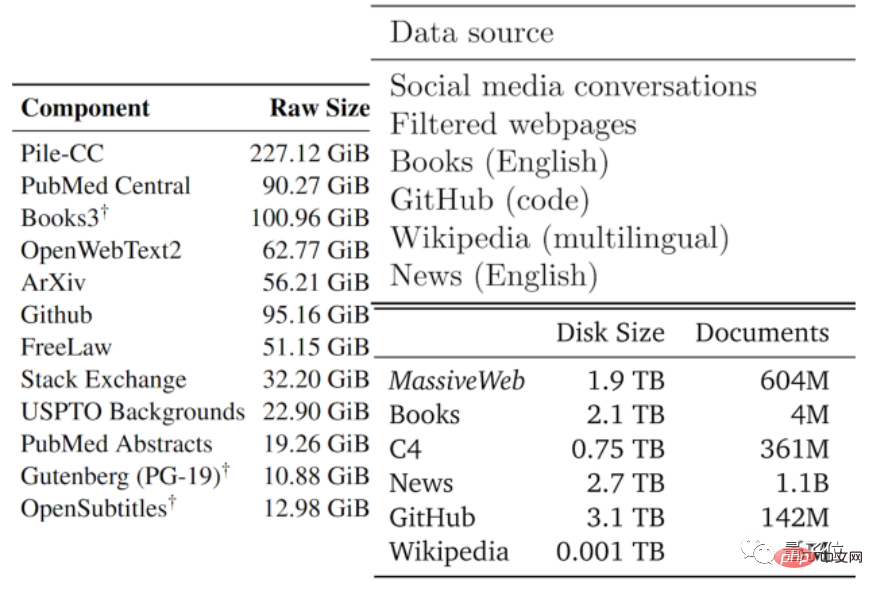

データの品質には通常、良いものから悪いものまで幅があります。作成者は、既存の大規模モデルやその他のデータで使用されるデータ タイプに基づいて、利用可能なテキスト データを低品質部分と高品質部分に分割しました。

高品質コーパスとは、Pile、PaLM、MassiveText などの大規模な言語モデルで使用されるトレーニング データ セットを指します。これには、Wikipedia、ニュース、GitHub 上のコード、出版された書籍などが含まれます。

低品質のコーパスは、Reddit などのソーシャル メディアのツイートや非公式のファン フィクション (ファンフィク) から得られます。

統計によると、高品質の言語データ ストックには約 4.6×10^12 ~ 1.7×10^13 ワードしか残っていないそうです。これは、現在の最大のテキストよりも 1 桁も大きくありません。データセット。

この論文は、成長率と組み合わせると、2023 年から 2027 年の間に高品質のテキスト データが AI によって使い果たされ、推定ノードは 2026 年頃になると予測しています。

少し早いようです...

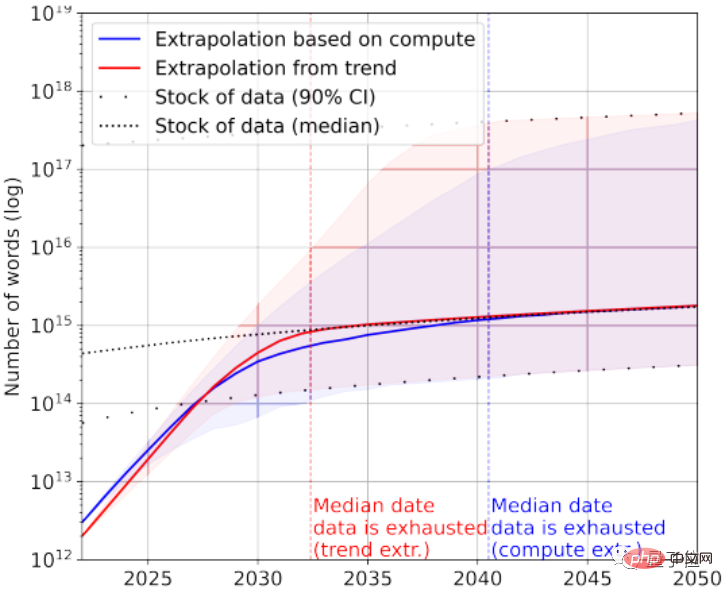

もちろん、低品質のテキスト データを追加することもできます。統計によると、テキスト データの全体的なストックには現在 7×10^13 ~ 7×10^16 ワードが残っており、これは最大のデータ セットよりも 1.5 ~ 4.5 桁大きいです。

データ品質の要件が高くない場合、2030 年から 2050 年の間に AI がすべてのテキスト データを使い果たしてしまうでしょう。

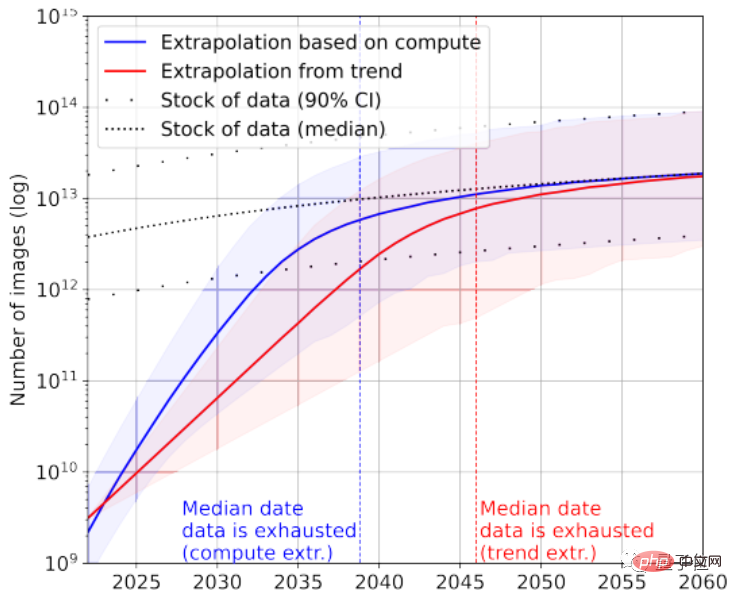

画像データを改めて見てみると、ここの論文では画質の区別はありません。

現在、最大の画像データ セットには 3×10^9 枚の画像が含まれています。

統計によると、現在の画像の総数は約 8.11×10^12 ~ 2.3×10^13 で、これは最大の画像データ セットより 3 ~ 4 桁大きいです。

この論文は、AI がこれらの画像を 2030 年から 2070 年の間に使い果たすだろうと予測しています。

明らかに、大規模な言語モデルは、画像モデルよりも深刻な「データ不足」状況に直面しています。

では、この結論はどのように導かれるのでしょうか?

ネチズンが投稿する 1 日の平均投稿数を計算して結果を取得する

この論文では、テキスト画像データの生成効率とトレーニング データセットの増加を 2 つの観点から分析しています。

論文の統計はすべてラベル付きデータではないことに注意してください。教師なし学習が比較的一般的であることを考慮して、ラベルなしデータも含まれています。

テキスト データを例に挙げると、ほとんどのデータはソーシャル プラットフォーム、ブログ、フォーラムから生成されます。

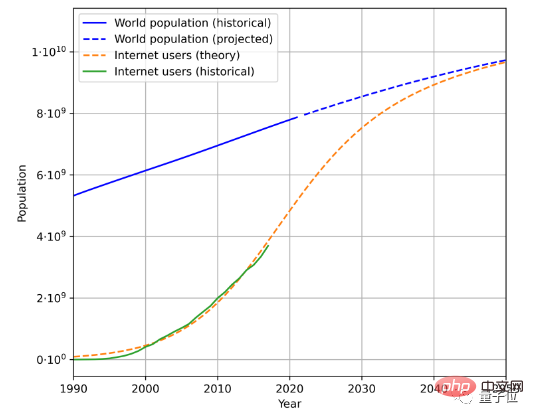

テキスト データの生成速度を見積もるには、総人口、インターネット普及率、インターネット ユーザーが生成する平均データ量という 3 つの要素を考慮する必要があります。

たとえば、これは過去の人口データとインターネット ユーザー数に基づいて推定される将来の人口とインターネット ユーザーの増加傾向です:

とユーザー数を組み合わせたもの-generated データ量を平均することで、データの生成速度を計算できます。 (複雑な地理的および時間的変化のため、本稿ではユーザーが生成する平均データ量の計算方法を簡略化しています)

この方法によると、言語データの増加率は約 7% と計算されます。ただし、この成長率は増加し、時間の経過とともに徐々に減少します。

2100 年までに、言語データの増加率は 1% に低下すると予想されています。

画像データも同様の手法で分析されており、現在は8%程度の増加率ですが、2100年には画像データの増加率も1%程度に鈍化すると予想されています。

この論文では、データの増加率が大幅に増加しない場合、または新しいデータ ソースが出現した場合、それが画像であろうと、高品質のデータでトレーニングされた大規模なテキスト モデルであろうと、ボトルネック期間が始まる可能性があると考えています。ある段階で。

一部のネチズンはこれについて冗談を言いましたが、SF ストーリーのようなことが将来起こるかもしれません:

AI を訓練するために、人間は大規模なテキスト生成プロジェクトを立ち上げ、誰もがAI 向けに何かを書くのに熱心に取り組んでいます。

彼はこれを「AI のための教育」と呼んでいます:

私たちは毎年 140,000 ~ 260 万の単語を AI に送ります。テキストデータだと、人間を電池として使うよりもクールに思えますか? ##################どう思いますか?

論文アドレス: https://arxiv.org/abs/2211.04325 参考リンク: https://twitter.com/emollick/status/1605756428941246466

参考リンク: https://twitter.com/emollick/status/1605756428941246466

以上が人間は AI が学習できる高品質のコーパスを十分に持っておらず、2026 年には枯渇するでしょう。 ネットユーザー: 大規模な人間によるテキスト生成プロジェクトが開始されました!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。