ChatGPT のショット数が少ないシナリオとショット数がゼロのシナリオにおける驚くべきパフォーマンスにより、研究者は「事前トレーニング」が正しい方法であるとの確信を深めました。

事前トレーニング済み基盤モデル (PFM) は、さまざまなデータ モード、つまり大規模データ、BERT、GPT-3、Pre に基づくさまざまなダウンストリーム タスクの基礎であると考えられています。 MAE、DALLE-E、ChatGPT などのトレーニング済みの基本モデルは、ダウンストリーム アプリケーションに適切なパラメーター初期化を提供するようにトレーニングされています。

PFM の背後にある事前トレーニングのアイデアは、大規模なモデルの適用において重要な役割を果たします。再帰的モジュールは特徴抽出にさまざまな方法を使用し、生成事前トレーニング (GPT) 方法では、Transformer を特徴抽出器として使用して、大規模なデータ セットに対して自己回帰トレーニングを実行します。

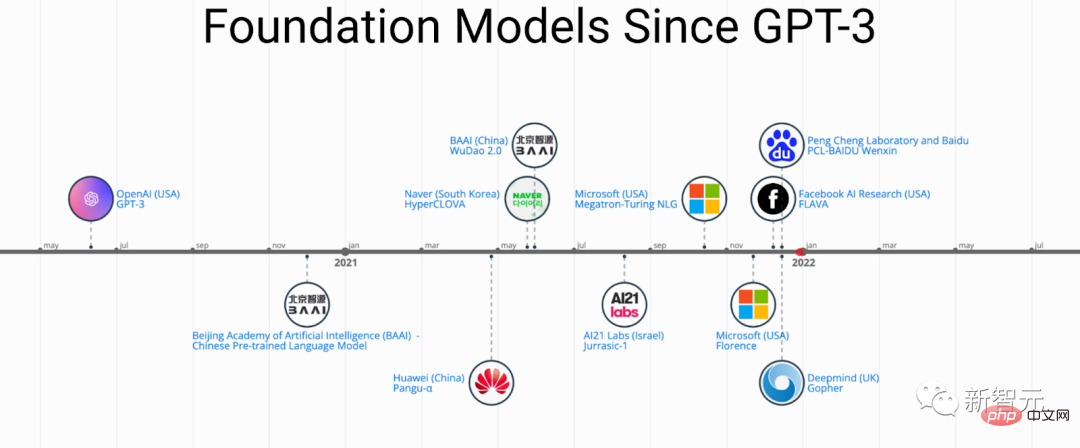

PFM はさまざまな分野で大きな成功を収めているため、近年発表された論文では多数の手法、データセット、評価指標が提案されています。 BERT: ChatGPT の開発プロセスを追跡する包括的なレビュー。

最近、北航大学、ミシガン州立大学、リーハイ大学、南洋工業大学、デューク大学、その他多くの国内外の有名な大学や企業の研究者が共同で、 -prediction 基本モデルのトレーニングに関するこのレビューでは、テキスト、画像、グラフの分野における最近の研究の進歩と、現在および将来の課題と機会を提供します。

論文リンク: https://arxiv.org/pdf/2302.09419.pdf

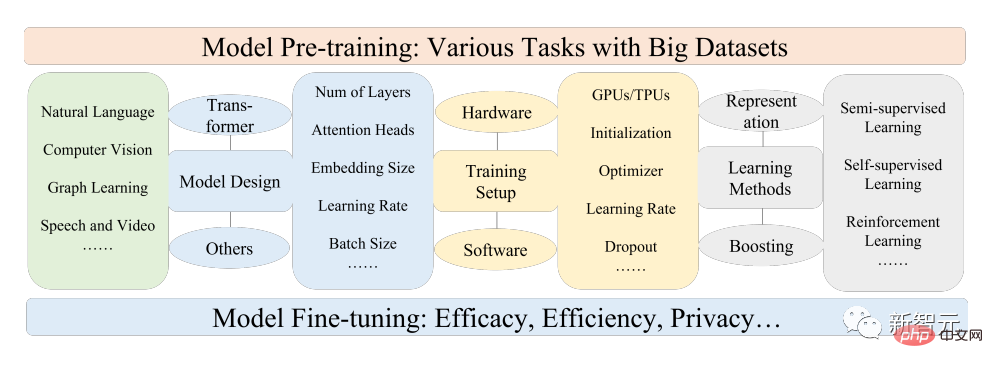

研究まず、自然言語処理、コンピューター ビジョン、グラフ学習の基本コンポーネントと既存の事前トレーニングを確認し、次に他のデータ モデル用の高度な PFM と、データの品質と量を考慮した統合 PFM について説明し、PFM の基本原理について説明します。 、モデルの効率と圧縮、セキュリティとプライバシーなど、この記事では最後に、将来の研究の方向性、課題、未解決の問題など、いくつかの重要な結論を列挙しています。

事前トレーニングされた基本モデル (PFM) は、ビッグデータ時代の人工知能システム構築の重要な部分です自然言語処理 (NLP)、コンピューター ビジョン (CV)、グラフ学習 (GL) の 3 つの主要な人工知能分野は、広く研究され、応用されています。

PFM は、さまざまな分野内またはクロスドメイン タスクで有効な一般的なモデルであり、テキスト分類、テキスト生成、画像などのさまざまな学習タスクにおける特徴表現の学習に大きな可能性を示します。分類、物体検出、グラフ分類など

PFM は、大規模なコーパスを使用して複数のタスクをトレーニングしたり、同様の小規模なタスクを微調整したりする際に優れたパフォーマンスを示し、迅速なデータ処理の開始を可能にします。

PFM は事前トレーニング テクノロジに基づいており、大量のデータとタスクを使用して、一般的なモデルをトレーニングします。これは、さまざまなダウンストリーム アプリケーションで簡単に微調整できます。

事前トレーニングのアイデアは、CV タスクにおける転移学習から生まれました。CV 分野での事前トレーニングの有効性を認識した後、人々は事前トレーニング テクニックを次の目的で使用し始めました。他のフィールドのモデルのパフォーマンスを向上させます。事前トレーニング手法を NLP 分野に適用すると、十分にトレーニングされた言語モデル (LM) によって、長期的な依存関係や階層関係など、下流のタスクに有益な豊富な知識を取得できます。

さらに、NLP の分野における事前トレーニングの大きな利点は、ラベルのないテキスト コーパスからトレーニング データを取得できること、つまり、データ量が無制限であることです。トレーニング前のプロセス データでのトレーニングの。

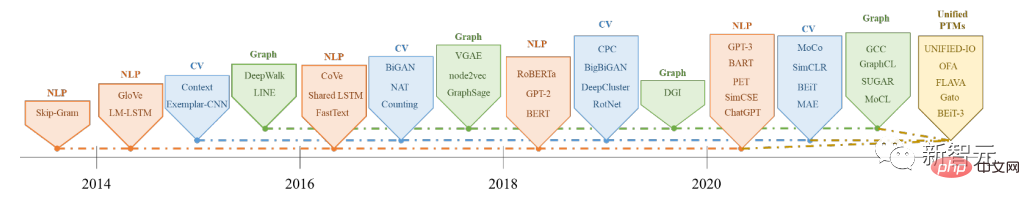

初期の事前トレーニングは、NNLM や Word2vec などの静的手法であり、異なるセマンティック環境に適応するのが困難でしたが、その後の研究者は、BERT や Word2vec などの動的な事前トレーニング テクノロジを提案しました。 XLネットは待ってください。

NLP、CV、GL の分野における PFM の歴史と進化

に基づく事前トレーニング テクノロジー PFM は大規模なコーパスを使用して一般的な意味表現を学習します。これらの先駆的な研究の導入により、さまざまな PFM が登場し、下流のタスクやアプリケーションに適用されています。

PFM アプリケーションのわかりやすい例は、最近人気のある ChatGPT です。

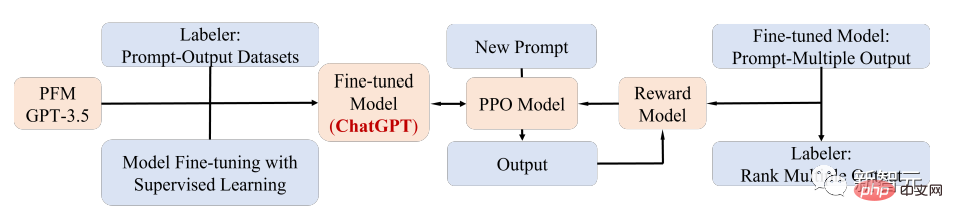

ChatGPT は、生成的な事前トレーニング済みの Transformer、つまり、テキストの混合コーパスでトレーニングした後の GPT-3.5 です。 ChatGPT は、大規模な LM と人間の意図を一致させるための現在最も有望な方法である、ヒューマン フィードバックによる強化学習 (RLHF) テクノロジーを使用します。

ChatGPT の優れたパフォーマンスは、各タイプの PFM のトレーニング パラダイムの変革、つまり、強化学習 ( RL)、迅速な調整と思考の連鎖、そして最終的には一般的な人工知能に向けて。

この記事では、研究者は主に、比較的成熟した研究分類方法でもあるテキスト、画像、グラフに関連する PFM をレビューします。

以上がBERT から ChatGPT まで、北杭大学を含む 9 つのトップ研究機関の包括的なレビュー: 私たちが長年にわたって一緒に追求してきた「事前トレーニング基本モデル」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。