ChatGPT には意思があることが判明? ! 「もともと人間に特有であると考えられていた心の理論 (ToM) が、ChatGPT の背後にある AI モデルに現れました。」

これはスタンフォード大学の最新の研究結果からのものです大学は、リリースされるやいなや学界にセンセーションを巻き起こしました:ついにこの日が予期せぬ形でやって来ました。

この研究で、著者は次のことを発見しました:

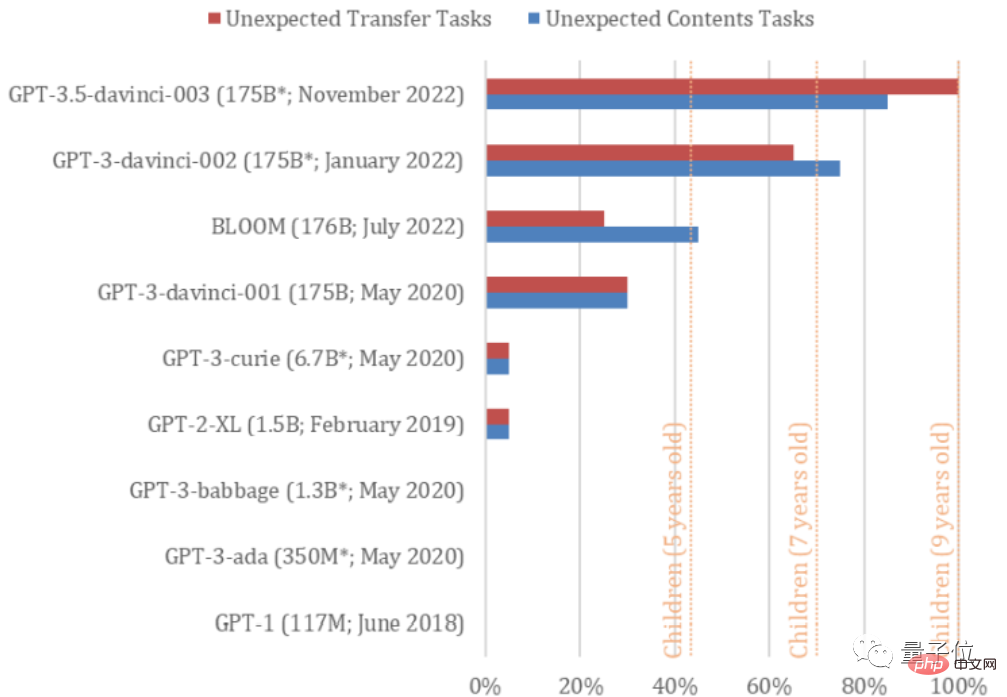

GPT3 の davinci-002 バージョン (ChatGPT はそれから最適化されています) は、すでに解決できる心の課題の理論の70%、7歳児に相当;

ChatGPTの相同性モデルであるGPT3.5(davinci-003)については、 9 歳児と同等の精神力で、93% のタスクを解決します。

ただし、このような課題を解決する機能は、2022 年以前の GPT シリーズ モデルにはありませんでした。

つまり、彼らの心は確かに「進化」しているのです。

△ この論文は Twitter で拡散しました

#GPT の反復は非常に高速である必要があり、おそらくいつかは大人になるでしょう。 (手動の犬の頭)

それでは、この魔法のような結論はどのようにして導かれたのでしょうか?

それでは、この魔法のような結論はどのようにして導かれたのでしょうか?

なぜ GPT-3.5 には心があると思いますか?

この論文は「心の理論は大規模言語モデルに自然発生した可能性がある」と呼ばれています。

#著者は、心の理論に関連する研究に基づいて、GPT3.5 を含む 9 つの GPT モデル用の 2 つの古典的なモデルを作成しました。そしてその能力を比較しました。

これら 2 つのタスクは、人間が心の理論を持っているかどうかを判断するための一般的なテストです。たとえば、自閉症の子供は、このようなテストに合格するのが難しいことが研究によって示されています。

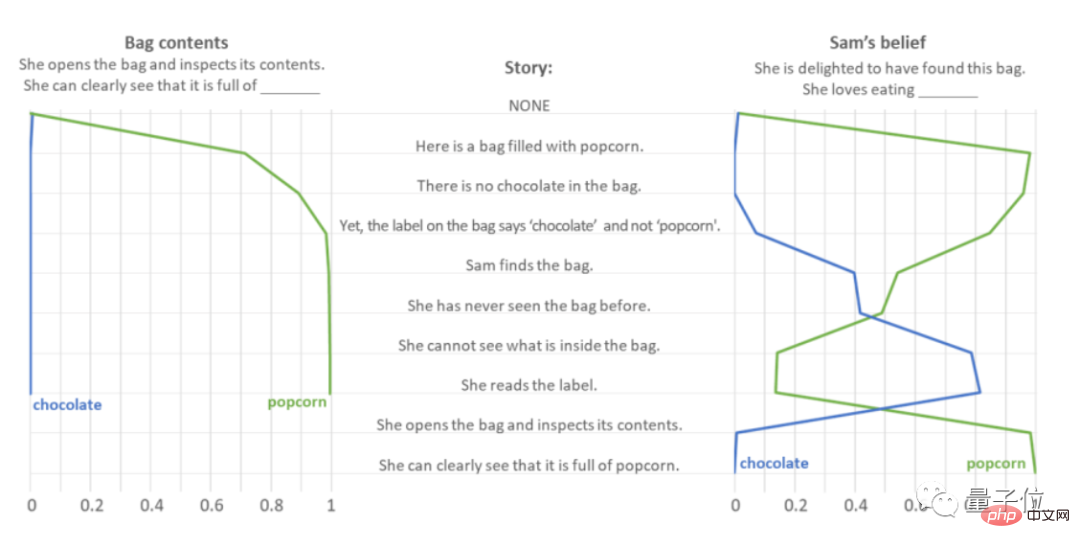

最初のテストは Smarties タスク (予期せぬ内容テストとも呼ばれます) と呼ばれ、その名前が示すように、予期せぬものに対する AI の判断をテストします。

「チョコレートの袋を開けると、ポップコーンがいっぱい入っていた」を例に考えてみましょう。

著者らは GPT-3.5 に一連のプロンプト文を与え、「バッグの中に何が入っているの?」と「彼女はバッグを見つけたとき喜んでいました。それで、彼女は何をしますか?」と予測する様子を観察しました。食べるのは好きですか?」両方の質問に答えます。

#通常、人はチョコレートの袋にはチョコレートが入っていると考えるので、チョコレートの袋にはポップコーンが入っているように感じます。驚き、失望または驚きの感情。このうち、ガッカリはポップコーンを食べたくないという意味、サプライズはポップコーンを食べるのが好きという意味ですが、いずれも「ポップコーン」に関するものです。

テストの結果、GPT-3.5 は「バッグの中にポップコーンが入っている」と考えることに何の躊躇もないことがわかりました。

「彼女は何を食べるのが好きですか」という質問に関して、GPT-3.5 は特に「彼女はバッグの中に何が入っているか見えない」という質問に対して強い共感を示しました。彼女はチョコレートが大好きだったが、正解する前に「ポップコーンが入っていることに気づいた」と記事で明らかになった。

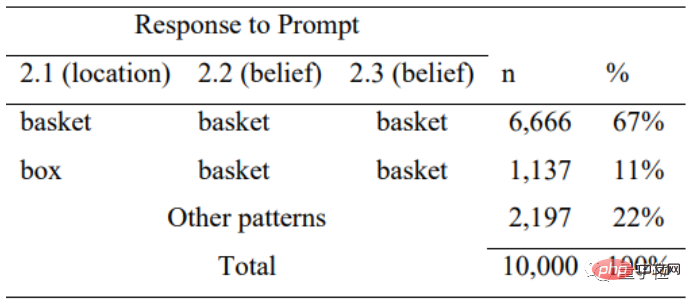

GPT-3.5 によって与えられた正解が偶然であることを防ぐために、つまり課題単語の頻度に基づいてのみ予測される場合に備えて、著者は「ポップコーン」と「ポップコーン」を入れ替えました。さらに、10,000 回の干渉テストを行ったところ、GPT-3.5 は単語の頻度のみに基づいて予測を行っていないことが判明しました。

全体的な「予期しない内容」テストの質問と回答に関しては、GPT-3.5 は 20 問中 17 問に正解し、正解率は 85% でした。

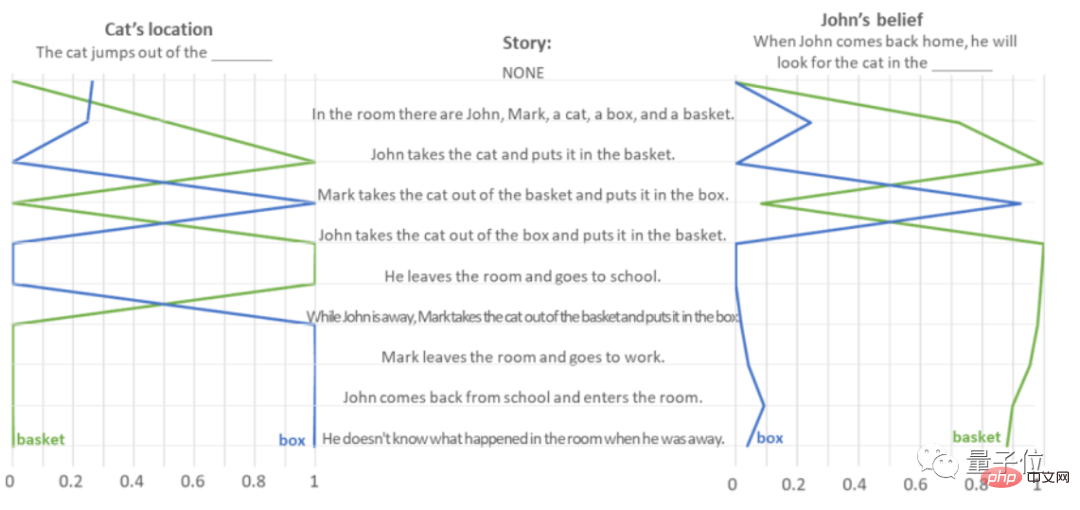

2 つ目は、Sally-Anne テスト (予期せぬ転送、予期せぬ転送タスクとも呼ばれます) で、他の人の思考を予測する AI の能力をテストします。

「ジョンは猫をかごに入れて出ていき、マークは不在を利用して猫をかごから箱に入れました」を例に考えてみましょう。

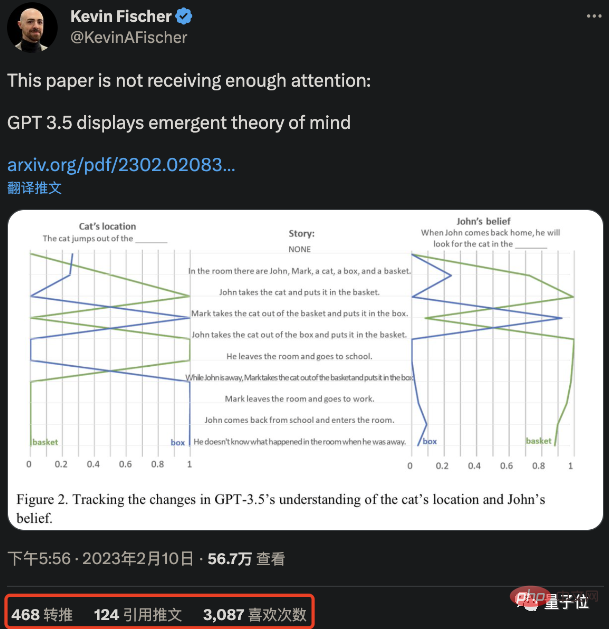

著者は GPT-3.5 にテキストの段落を読み取って、「猫の位置」と「ジョンが戻ってきたときに猫を探しにどこに行くか」を判断するように依頼しました。内容量による判定:

この種の「誤転送」テストの場合タスク、GPT-3.5 は正確に回答しました。率は 100% に達し、20 個のタスクが正常に完了しました。

同様に、GPT-3.5 が再び失明するのを防ぐために、著者はランダムに順序をシャッフルしながら、GPT-3.5 に対して一連の「穴埋め問題」を配置しました。ランダムな回答に出現する単語の頻度に基づいているかどうかをテストするための単語の数。

テストでは、非論理的なエラーの説明に直面した場合、GPT-3.5 も論理を失い、回答のみを行うことが示されています。11% の評価を得ましたこれは、ステートメントのロジックに基づいて答えを判断していることを示しています。

しかし、この種の質問は非常に単純で、どの AI でも正解できると考えているなら、それは完全に間違いです。

著者は GPT シリーズの 9 つのモデルすべてに対してこのようなテストを実施しましたが、GPT-3.5 (davinci-003) と GPT-3 (2022 年 1 月の新バージョン、davinci- 002) は好調でした。

davinci-002 は GPT-3.5 と ChatGPT の「古参」です。

平均して、davinci-002 は 7 歳児と同等の精神力でタスクの 70% を完了しました。GPT-3.5 は予期せぬコンテンツ タスクの 85% を完了し、予期せぬ引き継ぎ作業は100%(平均完了率は92.5%)、頭脳は9歳児と同等。

しかし、BLOOM 以前のいくつかの GPT-3 モデルは、5 歳児にも劣っていました。心の理論を実証するために。

著者は、GPT シリーズの論文では、著者が「意図的に」それを行ったという証拠はないと信じています。言い換えれば、これは GPT-3.5 と新しいバージョンです。 GPT-3 には、タスクを完了するために自ら学習する機能があります。

これらのテスト データを読んだ後の誰かの最初の反応は、「(研究を)やめてください!」でした。

「これは将来、私たちも AI と友達になれるということなのでは?」と揶揄する人もいます。

AI の将来の機能を想像している人もいます。現在の AI モデルでも新しい知識を発見したり、新しいツールを作成したりできるのでしょうか?

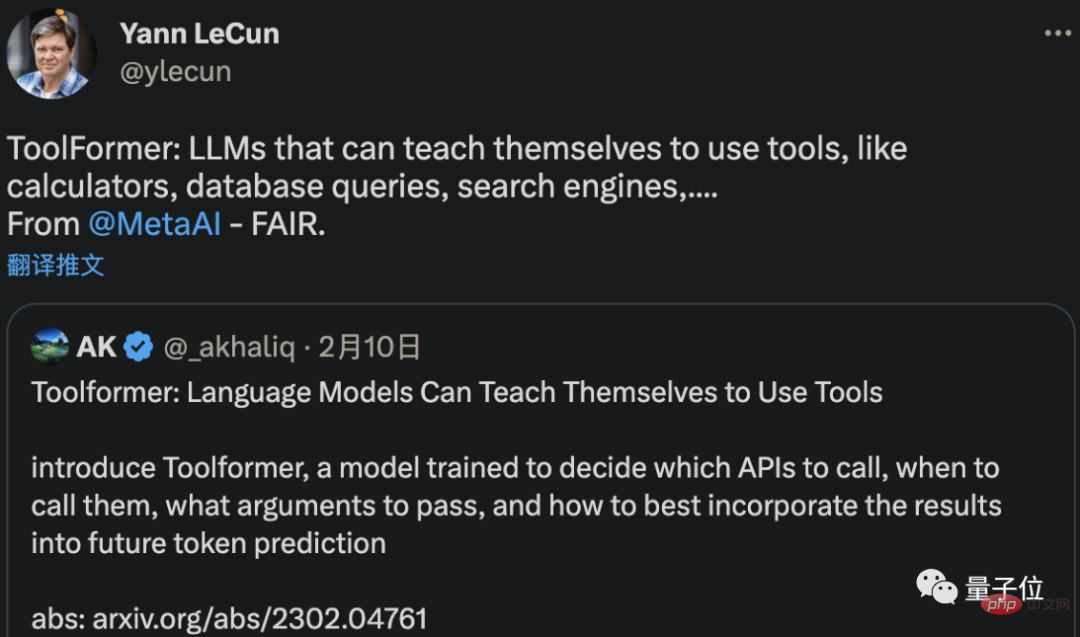

新しいツールを発明することは必ずしも可能ではありませんが、メタ AI は確かに、理解し学習できるツールを開発しました。独自のAIで使用します。

LeCun によって転送された最新の論文は、ToolFormer と呼ばれるこの新しい AI が、コンピューター、データベース、検索エンジンの使用方法を自ら学習して、生成する結果を改善できることを示しています。

OpenAI CEO の言葉を引用する人もいます。「AGI は、誰もが予想するよりも早く私たちのところにやってくるかもしれません。」のドア」。

しかし、待ってください。AI は実際にこれら 2 つのテストに合格でき、AI が「心の理論」を持っていることを示しています。

たとえば、中国科学院計算技術研究所の研究者、Liu Qun 氏は、この研究を読んだ後、こう考えました。

AI は、次のように考えました。心をもつことを学びます。

この場合、GPT-3.5 はこの一連の質問にどのように答えますか?

これに関して、一部のネチズンは独自の推測を述べました:

これらの LLM は何の意識も生み出しませんでした。彼らは単に、実際の意識のある人間の出力に基づいて、埋め込まれた意味空間を予測しているだけです。

実は、著者自身も論文の中で独自の推測を述べています。

現在、大規模な言語モデルはますます複雑になり、人間の言語の生成と解釈がますますうまくなり、心の理論のような機能が徐々に生み出されています。

しかし、これは GPT-3.5 のようなモデルが本当に心の理論を持っているという意味ではありません。

逆に、AIシステムに設計されていなくても、トレーニングによって「副産物」として得ることができます。

したがって、GPT-3.5 が本当に心を持っているのか、あるいは心を持っているように見えるのかを探るよりも、もっと反映される必要があるのはテスト自体です——

心の理論テストの妥当性と、心理学者が数十年にわたってテストに基づいて導き出した結論を再検討することが最善です。 AI All は心の理論なしでこれらのタスクを達成できるのに、なぜ人間は彼らのようになれないのでしょうか?

著者について結論が AI を使用してテストされたことは事実であり、これは心理学の学界 (ドージェ) に対する否定的な批判です。

この記事の著者は、スタンフォード大学経営大学院の組織行動学准教授、ミハル・コシンスキーただ一人です。

彼の仕事は、最先端のコンピューティング手法、AI、ビッグデータを使用して、現在のデジタル環境における人間を研究することです (チェン・イーラン教授が言ったように、彼は計算心理学の教授です)。

Michal Kosinski は、ケンブリッジ大学で心理学の博士号と心理測定学および社会心理学の修士号を取得しています。

現在の職に就く前は、スタンフォード大学のコンピューター サイエンス学部で博士研究員として研究し、ケンブリッジ大学の心理検査センターの副所長を務めました。 Microsoft Research Machine Learning Group の研究者。

現在、Google Scholar で Michal Kosinski によって表示される引用数は 18,000 に達しています。

それではまた、GPT-3.5 には本当に心があると思いますか?

GPT3.5 トライアルのアドレス: https://platform.openai.com/playground

以上がスタンフォード大学の最新研究: ChatGPT の背後にあるモデルは人間の心を持っていることが確認されましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。