推論速度は安定拡散の 2 倍高速、Visual Transformer により画像テキストが統一されます

論文 1: 1 つのモデルですべてを編集: セマンティック変調を使用した自由形式のテキスト駆動型画像操作

- #著者: Yiming Zhu、Hongyu Liu など

- 論文アドレス: https://arxiv.org/pdf/2210.07883.pdf

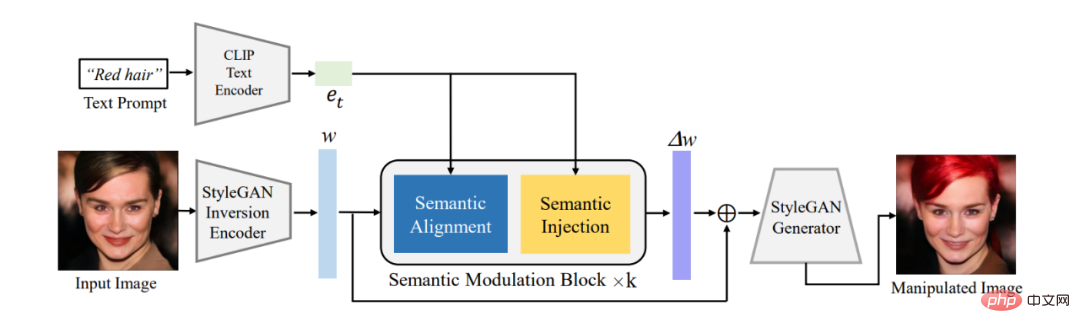

##要約: この記事では、まず既存のエンコーダーを使用して、編集が必要な画像を StyleGAN の W^ セマンティック空間内の潜在エンコーディング w に変換します。 、提案されたセマンティック変調モジュールを使用して、潜在コーディングに対して適応変調を実行します。セマンティック変調モジュールには、セマンティック アラインメント モジュールとセマンティック インジェクション モジュールが含まれています。最初に、アテンション メカニズムを通じてテキスト エンコーディングと GAN の潜在エンコーディングの間でセマンティクスを調整し、次にアラインメントされた潜在エンコーディングにテキスト情報を注入して、Cain エンコーディングが確実に所有するようにします。テキストを使用して画像を編集する機能を実現する情報。

従来の StyleCLIP モデルとは異なり、このモデルはテキストごとに個別のモデルをトレーニングする必要はありません。1 つのモデルが複数のテキストに応答して画像を効果的に編集できるため、モデルは次のようになります。 FFCLIP フリーフォームのテキスト駆動型画像操作。同時に、私たちのモデルは、古典的な教会、顔、車のデータセットで非常に良い結果を達成しました。

#図 1: 全体のフレーム図

## 推奨: テキストおよび画像編集の新しいパラダイムである単一モデルで、複数のテキストのガイド付き画像編集が可能になります。

論文 2: 付加的電源として転写可能な極薄基板上に印刷された有機太陽電池モジュール

- 著者:Mayuran Saravanapavanantham、Jeremiah Mwaura 他

- 論文アドレス: https://onlinelibrary.wiley.com/doi/10.1002/smtd。 202200940

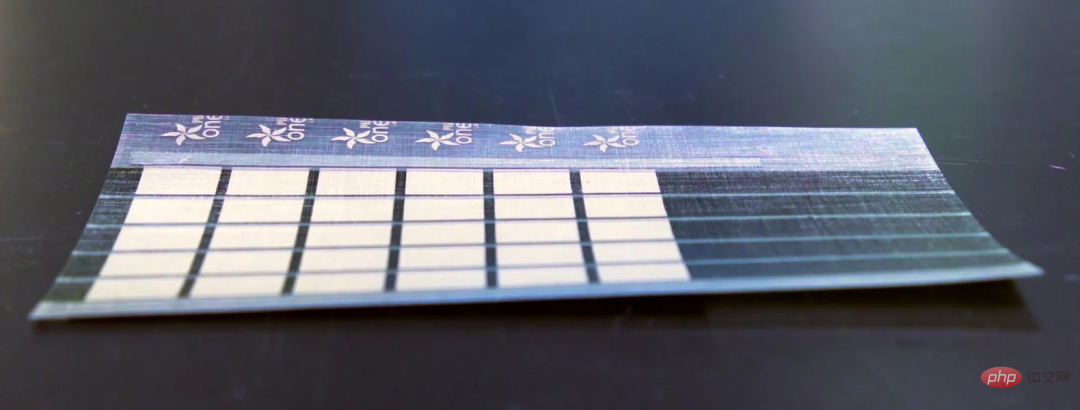

要約: MIT の研究者は、超薄型、軽量の太陽電池を製造できるスケーラブルな製造技術を開発しました。表面。

MITの研究者は、人間の髪の毛よりも薄く、現在のガラスおよびシリコンベースのソーラーパネルよりも1キログラムあたり18倍多くのエネルギーを供給するソーラーパネルを開発しました。これらのソーラーパネルの重量は、従来の太陽電池のわずか 1% です。この超薄型ソーラー パネルは、ボートの帆、ドローンの翼、テントにも設置できます。これらは、遠隔地や災害救援活動で特に役立ちます。

推奨: MIT は紙のように薄いソーラー パネルを作成します。

論文 3: 数学的推論のための深層学習に関する調査

- 著者: Pan Lu、Liang Qiu 他 #論文アドレス: https://arxiv.org/pdf/2212.10535.pdf

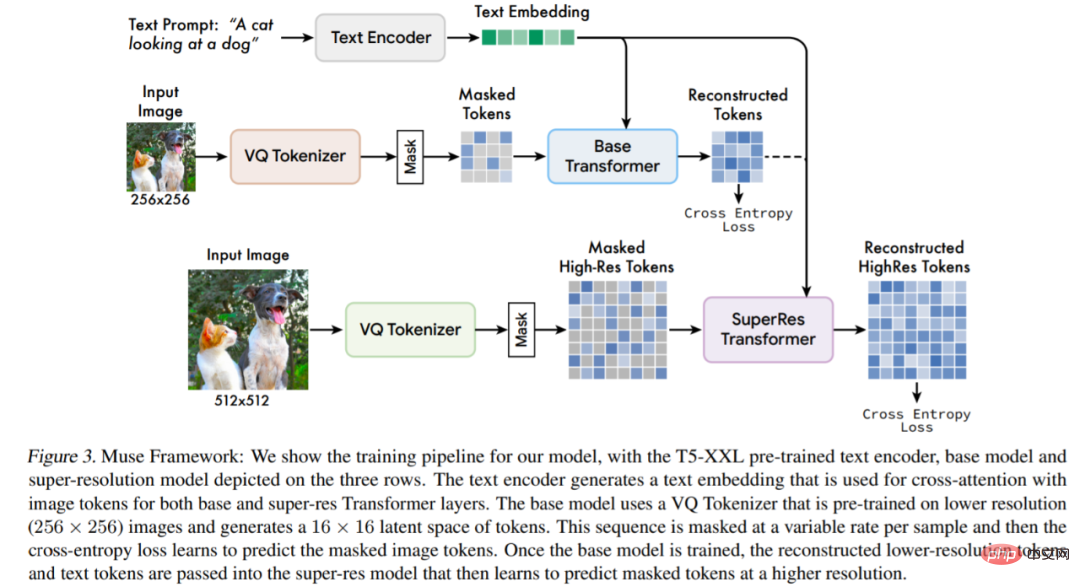

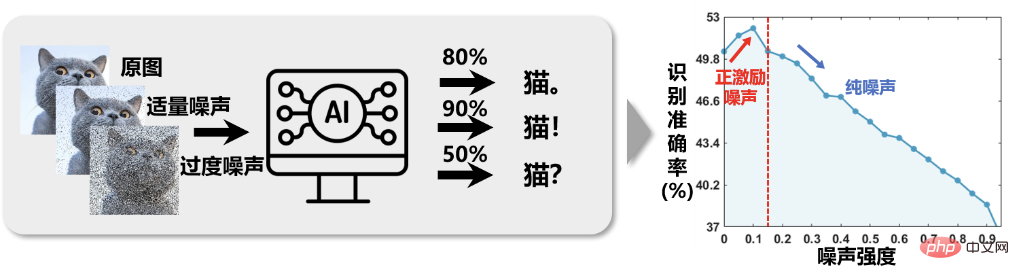

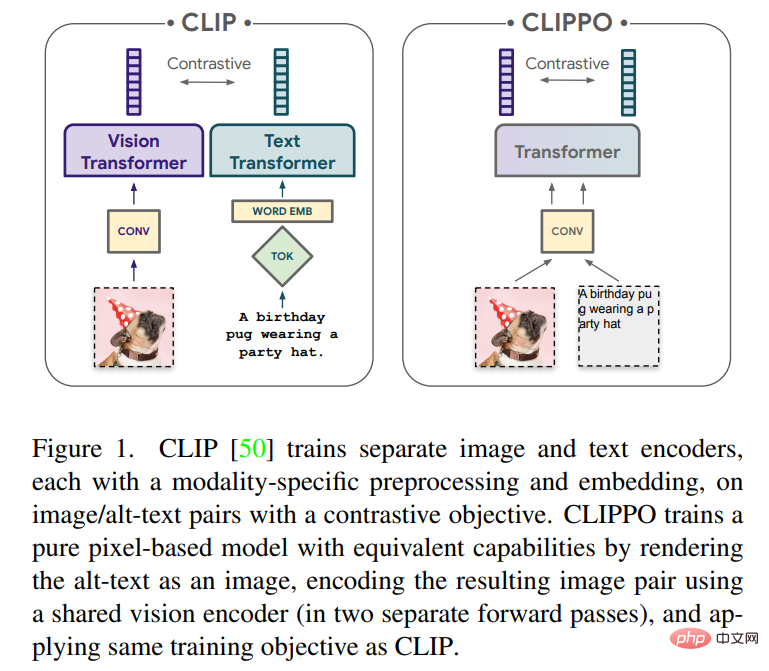

最近発表されたレポートでは、UCLA およびその他の機関の研究者が数学的推論における深層学習の進歩を体系的にレビューしました。 具体的には、この論文ではさまざまなタスクとデータセット (セクション 2) について説明し、数学分野におけるニューラル ネットワーク (セクション 3) と事前学習済み言語モデル (セクション 4) の進歩について考察します。数学的推論における大規模言語モデルの文脈学習の急速な発展も調査されています (セクション 5)。この記事では、既存のベンチマークをさらに分析し、マルチモーダル環境や低リソース環境にはあまり注目が払われていないことがわかりました (セクション 6.1)。証拠に基づいた研究は、現在のコンピューティング能力の表現が不十分であり、深層学習手法が数学的推論に関して一貫性がないことを示しています (セクション 6.2)。その後、著者らは、一般化と堅牢性、信頼できる推論、フィードバックからの学習、およびマルチモーダルな数学的推論の観点から、現在の研究の改善を提案しています (セクション 7)。 推奨事項: 深層学習が数学的推論への扉をゆっくりと開く方法。 #論文 4: Muse: マスクされた生成トランスフォーマーによるテキストから画像への生成 要約: この研究は、画像デコーダ アーキテクチャが導出される、マスクされた画像モデリング アプローチを使用したテキストから画像への合成のための新しいモデルを提案します。事前トレーニングおよび凍結された T5-XXL 大規模言語モデル (LLM) エンコーダーの埋め込みが条件付けされています。 カスケードピクセル空間拡散モデルに基づく Imagen (Saharia et al., 2022) または Dall-E2 (Ramesh et al., 2022) との比較 Muse との比較、効率個別トークンの使用により大幅に改善されます。 SOTA 自己回帰モデル Parti (Yu et al., 2022) と比較すると、Muse は並列デコードを使用するため、より効率的です。 TPU-v4 での実験結果に基づいて、研究者らは、Muse の推論速度は Imagen-3B または Parti-3B モデルよりも 10 倍以上速く、Stable Diffusion v1 よりも速いと推定しています。 .4 (Rombach et al., 2022) 2 倍高速になります。研究者は、拡散モデルが Stable Diffusion v1.4 で使用されており、推論中に明らかにより多くの反復が必要になるため、Muse の方が Stable Diffusion よりも高速であると考えています。 # モデル アーキテクチャの概要。 推奨事項: 推論速度は安定拡散よりも 2 倍速く、画像の生成と修復は 1 つの Google モデルで実行できます。 論文 5: ポジティブインセンティブノイズ #図 1 に示すように、画像インテリジェント分類システムでは、画像に適切な量のノイズを追加してトレーニングすると、認識精度が向上します。これは、私たちにいくつかのインスピレーションをもたらします。画像にノイズを除去するのではなく、ノイズを追加して、画像分類タスクを実行すると、より良い結果が得られる可能性があります。ターゲットへのノイズの影響が背景へのノイズの影響よりもはるかに小さい限り、「敵(背景ノイズ)に1000のダメージを与え、自分(ターゲット信号)に800のダメージを与える」という効果は意味がありますが、ミッションは高い信号対雑音比を追求するためです。本質的に、従来の分類問題に直面した場合、特徴の後に適度なノイズをランダムに追加することは、特徴の次元を増やすことと同じであり、ある意味、それは実際にタスクを完了する特徴にカーネル関数を追加することに似ています。 - 次元空間から高次元空間に変換すると、データがより分離しやすくなり、分類効果が向上します。 図 1 画像認識精度は、画像ノイズ強度が増加するにつれて「最初は増加し、その後減少する」という「直感に反する」関係を示しています。 推奨事項: Western Polytechnic University の Li Xuelong 教授は、タスク エントロピーに基づく数学的分析フレームワークを提案しました。 論文 6: ABPN: 超高解像度写真のリアルタイム ローカル レタッチのためのアダプティブ ブレンド ピラミッド ネットワーク #概要: DAMO アカデミーの研究者は、プロレベルのスマート スキンケアの実現を出発点としていますpoint は、高精細画像用の超微細ローカル レタッチ アルゴリズム ABPN のセットを開発しました。これは、超高精細画像での肌の美化や衣服のシワ除去タスクで優れた結果と応用を達成しました。 推奨: ワンクリックでシミやシワを消去します。 #論文 7: ピクセルのみからの画像と言語の理解 ## 著者: Michael Tschannen、Basil Mustafa など この記事では、純粋にピクセルベースのモデルを使用したテキストと画像のマルチモーダル学習について説明します。このモデルは、RGB イメージとしてレンダリングされるビジュアル入力またはテキスト、またはその両方を一緒に処理する別個のビジュアル Transformer です。すべてのモダリティは、低レベルの特徴処理を含む同じモデル パラメーターを使用します。つまり、モダリティ固有の初期畳み込み、トークン化アルゴリズム、または入力埋め込みテーブルはありません。このモデルは、CLIP と ALIGN によって普及した対照学習という 1 つのタスクのみでトレーニングされます。したがって、このモデルは CLIP-Pixels Only (CLIPPO) と呼ばれます。

推奨: Heart of Machine は、Chu Hang 氏と Luo Ruotian 氏が立ち上げた ArXiv Weekly Radiostation と協力し、NLP、CV、 ML の各分野から 10 件の論文を厳選し、論文の概要を音声で紹介します。詳細は次のとおりです: ##10 NLP PapersAudio: #00:0020:02 #今週選ばれた 10 の NLP 論文は次のとおりです: 1. 検索による再考: 忠実な大規模言語モデル推論。(from Honming Zhang 、Dan Roth) 2. 言語モデルを使用した政治的二極化の理解: データセットとメソッド (Bhiksha Raj より) 3 . 事前学習済み言語モデルによるテーブルからテキストへの生成に向けて: テーブル構造の理解とテキスト熟議アプローチ (Hui Xiong より) 4. 認識論的立場の検出による政治的レトリックの検証 ( Brendan O'Connor より) 5. 数式知識を使用した知識集約型のテキストから SQL へのセマンティック解析に向けて (Min-Yen Kan より) 6. 暗黙的なヘイトスピーチ検出における世界の知識の活用. (Jessica Lin より) 7. ニューラル コーデック言語モデルはゼロショットのテキスト音声合成シンセサイザーです. (Furu より) Wei) 8. EZInterviewer: 模擬面接ジェネレーターを使用して面接のパフォーマンスを向上させる (Tao Zhang より) 9. メモリ拡張ルックアップ自動音声認識のための辞書ベースの言語モデリング (Yuxuan Wang より) 10. パラメーター効率の良い微調整設計空間 (Diyi Yang より) ##10 の履歴書 #00:0021:06 今週選ばれた 10 の履歴書は次のとおりです: 1. CA$^2$T-Net: 単一画像からのカテゴリーに依存しない 3D アーティキュレーション転送 (Jitendra Malik より) 2. 持続可能な樹木を知らせるための小規模農家のカシュー プランテーションのマッピングベナンにおける作物拡大 (Vipin Kumar より) 3. Scale-MAE: マルチスケール地理空間表現学習のためのスケール認識マスク オートエンコーダー (Trevor Darrell より) 4. ステップ: ラベルのない手順ビデオからの自己教師付きキー ステップ抽出 (Rama Chellappa より) ##5. ミューズ: マスクされたテキストから画像への生成Generative Transformers. (Ming-Hsuan Yang、Kevin Murphy、William T. Freeman より) 6. ニューラル崩壊による不均衡なセマンティック セグメンテーションの理解. (Xiangyu Zhang、Jiaya Jia より) 7. 3D オブジェクト検出のための座標エンコーディングによるクロスモーダル トランスフォーマー (Xiangyu Zhang より) 8. セマンティックによる道路シーン レベルの表現の学習領域予測 (Alan Yuille より) 9. 並べ替えによる学習: グループ順序制約による自己教師あり学習(Bernt Schiele より) 10. AttEntropy: セマンティック セグメンテーション トランスフォーマーの空間アテンション エントロピーを使用した、複雑なシーン内の未知のオブジェクトのセグメント化。 (Pascal Fua より) 10 ML Papers音声: # #00:0023:15 本周 10 篇 ML 精選论文: #1.関連情報の原理による自己組織化保存グラフ構造学習。 (フィリップ S. ユウより) 2.電子商取引における情報抽出のための敵対的生成ネットワークによるクエリ拡張の修正。 (アルタン・カキルより) 3.関連する部分空間を見つけることによるニューラル ネットワーク予測のもつれのない説明。 (クラウス・ロバート・ミュラーより) 4. L-HYDRA: マルチヘッドの物理学に基づいたニューラル ネットワーク。 (ジョージ・エム・カルニアダキスより) 5. Transformer による強化学習の変革について: 開発の軌跡。 (タオ大成より) 6.最適化されたバイナリを逆コンパイルするためのニューラル ネットワークの強化。 (カイ・チェンより) 7. NeuroExplainer: 早産児の皮質発達パターンを明らかにするためのきめ細かな注意デコーディング。 (沈丁崗より) 8.人間のような少数ショット学習の理論。 (ミン・リーより) 9.圧縮更新による時間差学習: エラー フィードバックと強化学習の出会い。 (ジョージ・J・パパスより) 10.マルチマージナル最適輸送の反転による、集約データからの潜在人口フローの推定。 (Zha 宏源より)

科学研究のあらゆる側面では、機器の精度不足による機器誤差、操作の人的ミスによる誤差、極限環境などの外部干渉による情報の歪みなど、大量のノイズが発生します。など。騒音は実行される作業に悪影響を与えることが多いということは、研究者の間で共通の想定となっています。したがって、「ノイズ低減」という中核的なタスクを中心に、大量の研究作業が行われてきました。しかし、ノースウェスタン工科大学の Li Xuelong 教授のチームは、信号検出および処理タスクを実行する際の実験観察を通じて、この仮定に疑問を投げかけました。科学研究におけるノイズは本当に常に有害なのでしょうか?

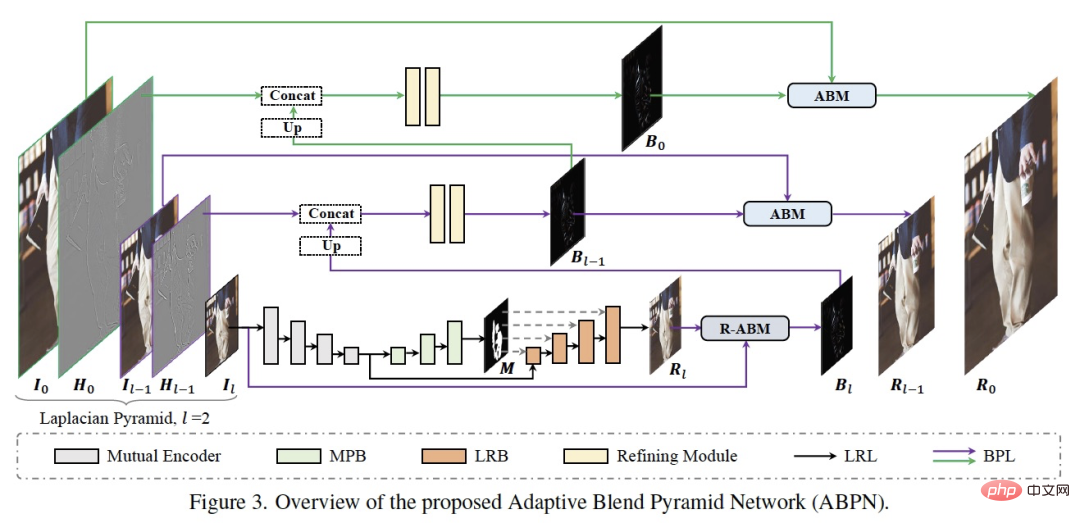

#上の図に示すように、ネットワーク構造は主に 2 つの部分で構成されます。コンテキスト認識型ローカル変更レイヤー (LRL) と適応ハイブリッド ピラミッドです。レイヤー(BPL)。 LRL の目的は、グローバル コンテキスト情報とローカル テクスチャ情報を十分に考慮して、ダウンサンプリングされた低解像度画像を局所的に変更し、低解像度変更結果画像を生成することです。さらに、BPL は、LRL で生成された低解像度の結果を高解像度の結果に徐々にアップスケールするために使用されます。その中で、適応ブレンディング モジュール (ABM) とその逆モジュール (R-ABM) を設計し、中間ブレンディング層 Bi を使用して、元の画像と結果画像の間の適応変換と上方拡張を実現し、強力なスケーラビリティを示します。細部まで忠実な機能。顔の変更と服装の変更の 2 つのデータセットで多数の実験を行った結果、私たちの方法が有効性と効率の点で既存の方法よりも大幅に優れていることがわかりました。私たちのモデルは、1 枚のカード P100 上で 4K 超高解像度画像のリアルタイム推論を実現していることは言及する価値があります。

#上の図に示すように、ネットワーク構造は主に 2 つの部分で構成されます。コンテキスト認識型ローカル変更レイヤー (LRL) と適応ハイブリッド ピラミッドです。レイヤー(BPL)。 LRL の目的は、グローバル コンテキスト情報とローカル テクスチャ情報を十分に考慮して、ダウンサンプリングされた低解像度画像を局所的に変更し、低解像度変更結果画像を生成することです。さらに、BPL は、LRL で生成された低解像度の結果を高解像度の結果に徐々にアップスケールするために使用されます。その中で、適応ブレンディング モジュール (ABM) とその逆モジュール (R-ABM) を設計し、中間ブレンディング層 Bi を使用して、元の画像と結果画像の間の適応変換と上方拡張を実現し、強力なスケーラビリティを示します。細部まで忠実な機能。顔の変更と服装の変更の 2 つのデータセットで多数の実験を行った結果、私たちの方法が有効性と効率の点で既存の方法よりも大幅に優れていることがわかりました。私たちのモデルは、1 枚のカード P100 上で 4K 超高解像度画像のリアルタイム推論を実現していることは言及する価値があります。

CLIP と同様にパラメーターの半分で、Visual Transformer はピクセルから画像とテキストの統合を実現します。

CLIP と同様にパラメーターの半分で、Visual Transformer はピクセルから画像とテキストの統合を実現します。 ArXiv Weekly Radiostation

以上が推論速度は安定拡散の 2 倍高速、Visual Transformer により画像テキストが統一されますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undress AI Tool

脱衣画像を無料で

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

Embedding サービスのローカル実行パフォーマンスは OpenAI Text-Embedding-Ada-002 を上回っており、とても便利です。

Apr 15, 2024 am 09:01 AM

Embedding サービスのローカル実行パフォーマンスは OpenAI Text-Embedding-Ada-002 を上回っており、とても便利です。

Apr 15, 2024 am 09:01 AM

Ollama は、Llama2、Mistral、Gemma などのオープンソース モデルをローカルで簡単に実行できるようにする非常に実用的なツールです。この記事では、Ollamaを使ってテキストをベクトル化する方法を紹介します。 Ollama をローカルにインストールしていない場合は、この記事を読んでください。この記事では、nomic-embed-text[2] モデルを使用します。これは、短いコンテキストおよび長いコンテキストのタスクにおいて OpenAI text-embedding-ada-002 および text-embedding-3-small よりも優れたパフォーマンスを発揮するテキスト エンコーダーです。 o が正常にインストールされたら、nomic-embed-text サービスを開始します。