Meta モデルに基づく ChatGPT の軽量バージョンはここにありますか?

Meta が LLaMA の立ち上げを発表してからわずか 3 日後、LLaMA を ChatGPT に変換したオープンソースのトレーニング手法が業界に登場し、トレーニング速度が ChatGPT よりも最大 15 倍速いと主張しました。

LLaMA は Meta 社が開発した超高速かつ超小型の GPT-3 で、パラメータ数は後者の 10% に過ぎず、実行に必要な GPU は 1 つだけです。

これを ChatGPT に変換する手法は ChatLLaMA と呼ばれ、RLHF (ヒューマン フィードバックに基づく強化学習) に基づいてトレーニングされ、インターネットで急速に普及しました。

Meta の ChatGPT のオープンソース バージョンは本当に登場するのでしょうか?

ちょっと待ってください、物事はそれほど単純ではありません。

ChatLLaMA プロジェクトのホームページをクリックすると、実際には 4 つの部分 (

DeepSpeed、RLHF メソッド、LLaMA) が統合されていることがわかります。 LangChain エージェントに基づいて生成されたデータ セット。

その中で、DeepSpeed はオープンソースの深層学習トレーニング最適化ライブラリであり、大規模モデルのトレーニング機能を向上させるために使用される Zero と呼ばれる既存の最適化技術が含まれており、具体的にはモデルのトレーニング向上を支援することを指します。速度、コストの削減、モデルの可用性の向上など。

RLHF は報酬モデルを使用して、事前トレーニングされたモデルを微調整します。報酬モデルは、最初に複数のモデルを使用して質問と回答を生成し、次に質問と回答の手動並べ替えに依存してスコアリングを学習します。次に、報酬学習に基づいてモデルによって生成された回答をスコアリングし、強化学習によるモデルの機能。

LangChain は、さまざまな大規模言語モデルを統合し、他の知識ソースやコンピューティング機能と組み合わせた実用的なアプリケーションを作成することを目的とした大規模言語モデル アプリケーション開発ライブラリです。 LangChainエージェントはGPT-3の思考プロセス全体を思考連鎖のように公開し、操作を記録します。

この時点で、最も重要なのはやはり LLaMA モデルの重みであることがわかります。それはどこから来たのですか?

ねえ、Meta にアクセスして自分で申請してください。ChatLLaMA はそれを提供しません。 (Meta は LLaMA をオープンソースだと主張していますが、それでも申請する必要があります)

したがって、本質的に、ChatLLaMA はオープンソースの ChatGPT プロジェクトではなく、LLaMA に基づく単なるトレーニング方法です。そのライブラリに統合されているいくつかのプロジェクトは、もともとオープンソースでした。

実際、ChatLLaMA は Meta によって構築されたものではなく、Nebuly AI という新興 AI 企業によって構築されました。

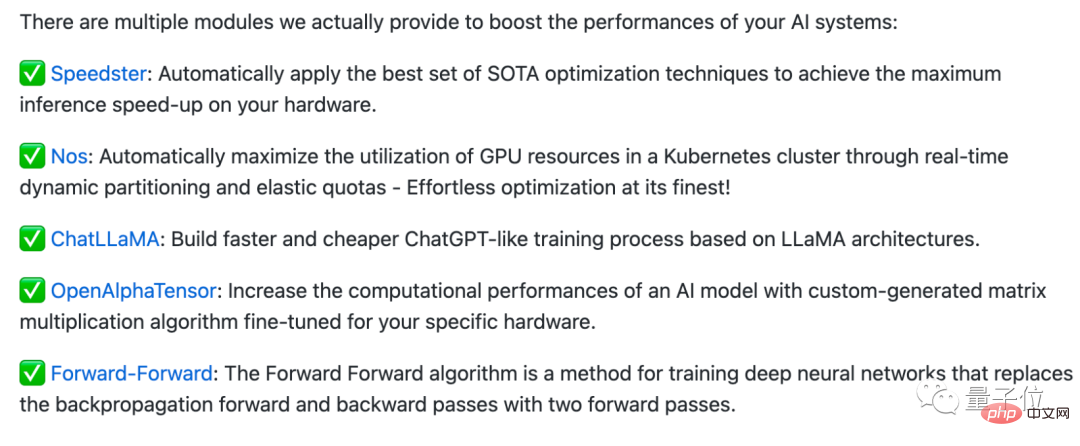

Nebuly AI は、AI システムのパフォーマンスを向上させるための一連のプラグ アンド プレイ最適化モジュールを統合する、Nebullvm と呼ばれるオープン ソース ライブラリを作成しました。

たとえば、現在 Nebullvm に含まれているモジュールには、DeepMind のオープン ソース AlphaTensor アルゴリズムに基づく OpenAlphaTensor、ハードウェアを自動的に感知して高速化する最適化モジュールなどがあります。

##ChatLLaMA もこのシリーズのモジュールに含まれていますが、そのオープンソース ライセンスは市販されていないことに注意してください。 したがって、「国内自社開発 ChatGPT」を直接使用したい場合は、それほど単純ではないかもしれません (doge)。

したがって、「国内自社開発 ChatGPT」を直接使用したい場合は、それほど単純ではないかもしれません (doge)。

このプロジェクトを読んだ後、一部のネチズンは、誰かが本当に LLaMA のモデル重み (コード) を取得できたら素晴らしいのにと言いました...

しかし、一部のネチズンは、「ChatGPT トレーニング メソッドより 15 倍速い」という記述はまったくの誤解を招くものであると指摘しました。

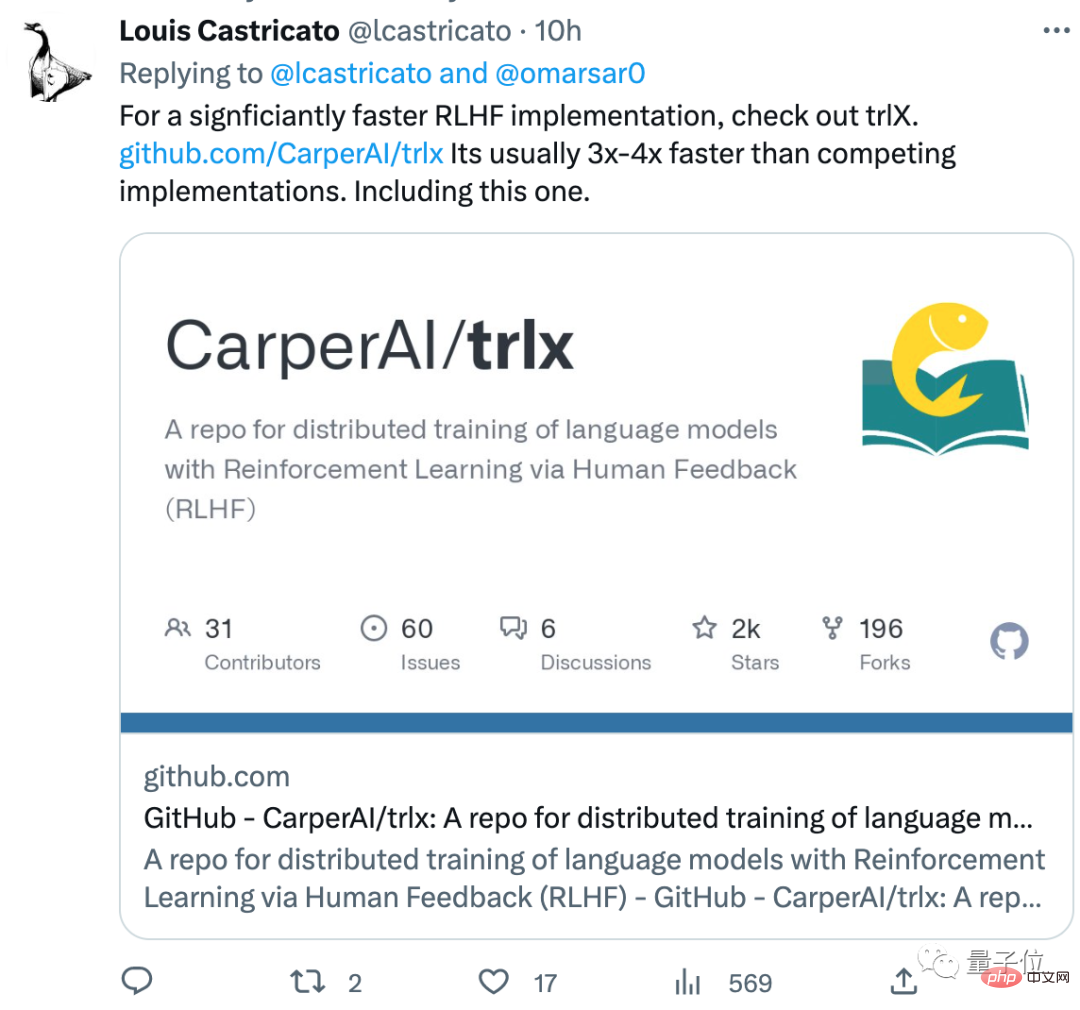

このネチズンは、ライブラリにある trlx と呼ばれる RLHF トレーニング方法よりも優れた RLHF トレーニング方法も推奨しています。トレーニング速度は通常の RLHF 方法よりも速いです。 . 3 ~ 4 回:

ChatLLaMA アドレス:

ChatLLaMA アドレス:

参考リンク: //m.sbmmt.com/link/fe27f92b1e3f4997567807f38d567a35

以上がChatGPT トレーニング メソッドの軽量バージョンはオープンソースです。 LLaMA を中心にわずか 3 日で構築され、トレーニング速度は OpenAI よりも 15 倍速いと言われていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。