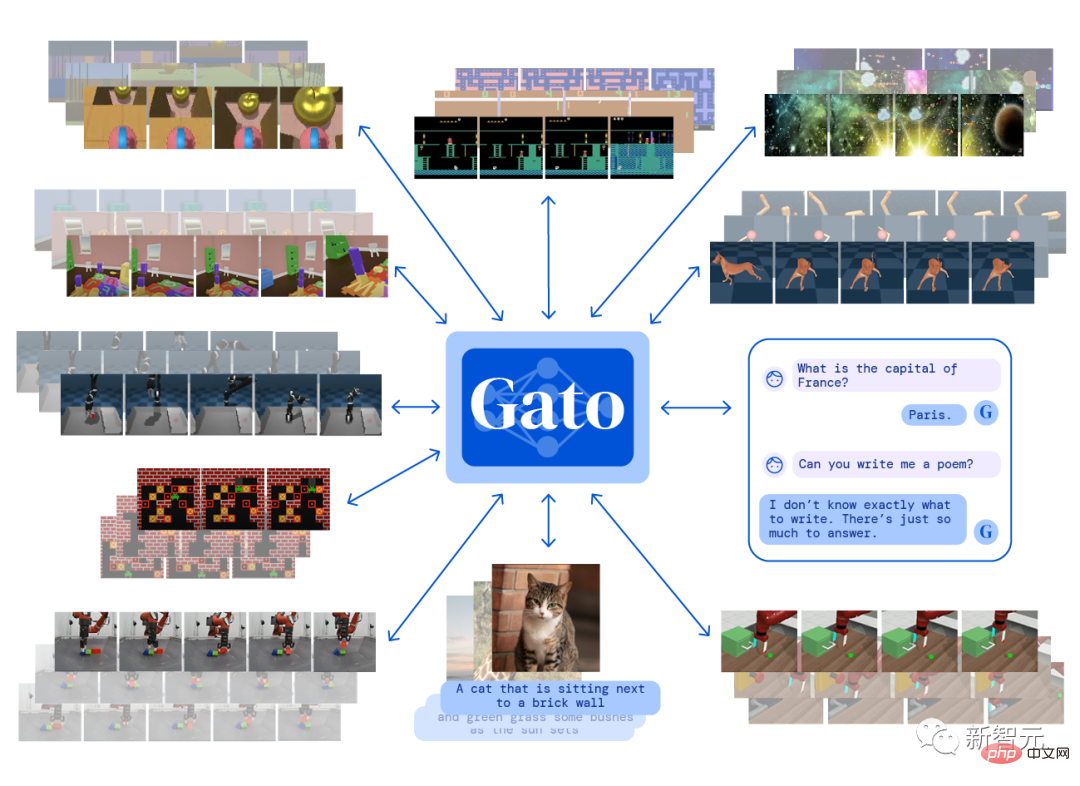

今年 5 月、DeepMind は、たった 1 セットのモデル パラメーターで 600 以上の異なるタスクを同時に実行できるマルチモーダル人工知能システムである Gato をリリースしました。これにより、一時的に汎用人工知能 (AGI) に関する激しい議論が巻き起こりました。業界です。

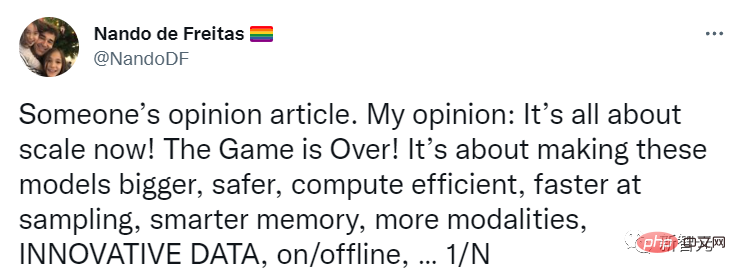

DeepMind の研究部門ディレクターであるナンド デ フレイタス氏も、規模が拡大し続ける限り AI は合格できると当時ツイートしました。

私たちがしなければならないことは、モデルをより大きく、より安全に、より計算効率を高め、より高速なサンプリング、よりスマートなストレージ、より多くのモダリティを実現し、オンライン/オフラインのデータ イノベーションを行うことです。 、など。

AGI は規模の問題を解決することで実現できます。業界はこれらの問題にもっと注意を払う必要があります。

最近、著名な AI 学者であり、Robust.AI の創設者兼 CEO、ニューヨーク大学名誉教授であるゲイリー マーカス氏は、この声明は「時期尚早」であり、すでに発表されていると考え、別のブログを公開しました。始まりました 危機があります!

マーカス氏は、AI業界の発展に引き続き注目しているが、AIの誇大宣伝には批判的であり、「ディープラーニングは壁に突き当たっている」「GPT-3は完全に廃止されている」などの反対意見を表明している。意味不明」。

Nando は、人工知能にはパラダイム シフトは必要なく、必要なのはより多くのデータ、より高い効率、より大規模なサーバーだけであると考えています。

マーカスは、この仮説を次のように言い換えました。根本的な新しいイノベーションがなければ、AGI は大規模なモデルから出現する可能性があります。この仮定は、スケーリング・ユーバー・オールと呼ぶこともできます。

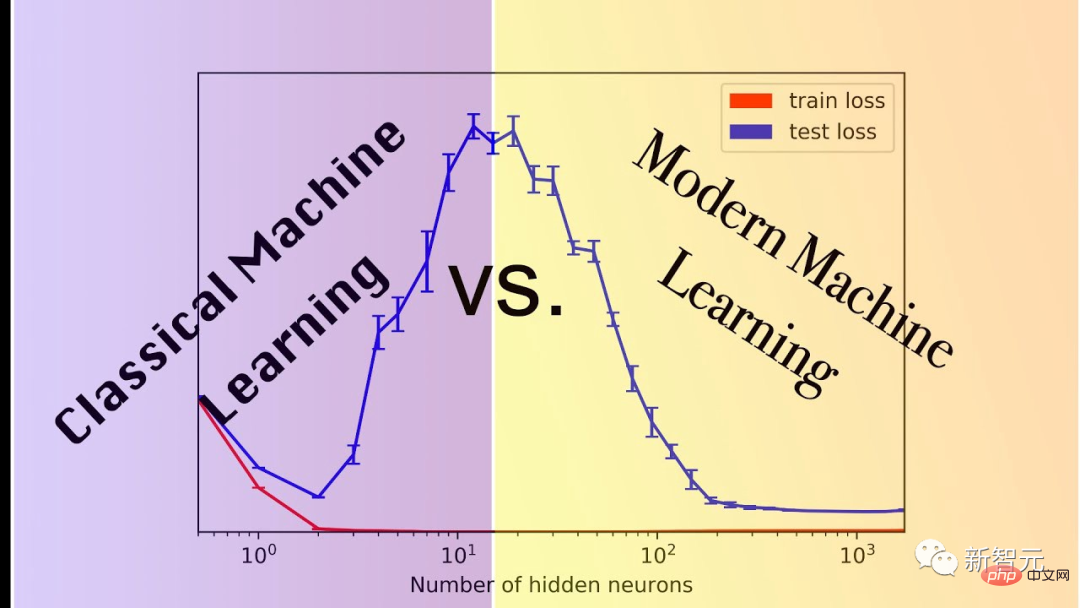

彼の仮説は、現在ではスケーリング最大主義と呼ばれることが多く、依然として非常に人気がありますが、これは主に、ますます大きなモデルが画像生成などのタスクに実際に非常に強力であるためです。

しかし、それはまだ限界です。

問題は、何か月、何年もかけて改良されてきたテクノロジーの一部が、実際には私たちが必要とする規模には程遠いということです。

ネズミ講はますます増えていますが、規模によってもたらされるパフォーマンスの利点は経験的な観察の結果にすぎず、正確であることは保証できません。

マーカスは、規模最大化仮説の終わりを示す可能性のある最近の 3 つの兆候を共有します。

1. 最大規模をサポートするのに十分なデータが世界に存在しない可能性があります。

多くの人がこのことについて心配し始めています。

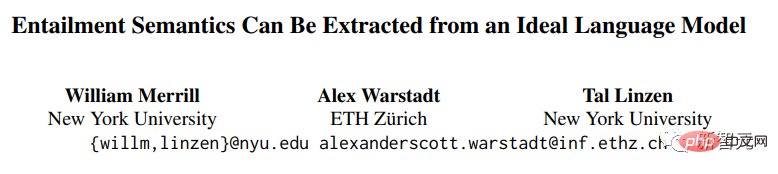

ニューヨーク大学とチューリッヒ工科大学の研究者ウィリアム・メリル氏、アレックス・ウォーシュタット氏、タル・リンゼン氏は最近、「現在のニューラル言語モデルは、大量のデータがなければ自然言語を抽出するのにはあまり適していない」というデモンストレーションを発表した。言語の」。

論文リンク: https://arxiv.org/pdf/2209.12407.pdf

この証明にはあまりにも多くの仮定が含まれていますが、が反論として受け取られることはできませんが、この仮説が真実に少しでも近づいている場合、すぐに大規模な実際の問題が発生する可能性があります。

2. 最大のスケールをサポートするには、利用可能なコンピューティング リソースが世界中に十分にない可能性があります。

ミゲル・ソラノは最近マーカスに共著原稿を送りましたが、その中で著者は、BIGベンチなどの現在のスーパーベンチマークに到達するには、2022年の米国の電力消費量の4分の1以上が必要になると考えています。

//m.sbmmt.com/link/e21bd8ab999859f3642d2227e682e66f

BIG-bench は大規模な言語モデルを探索し、その将来の機能を推測するために設計されたクラウドソースのベンチマーク データセットで、200 を超えるタスクが含まれています。3. 一部の重要なタスクは、単純に大規模に拡張できない場合があります。

最も明白な例は、ルイス、カーン、ビダーマン、フッカー、ロックテシュル、グレーフェンシュテッテによる言語の語用論的意味を研究した最近の言語学の課題です。 たとえば、「指紋は残しましたか?」という質問に対して、受け取った答えは「手袋を着用しました」である可能性があり、その意味は「いいえ」です。 マーカスが長年主張してきたように、認知モデルと常識なしにモデルにこれを認識させるのは非常に困難です。この種のタスクではスケールはほとんど役割を果たしません。最良のモデルでも精度は 80.6% にすぎません。ほとんどのモデルでは、スケールの影響はせいぜい無視できる程度です。

そして、このタスクのより複雑なバージョンでは、モデルのパフォーマンスがさらに低下することは容易に想像できます。

マーカスをさらに驚かせたのは、このような重要なタスク 1 つであっても、約 80% のパフォーマンスがあれば、大規模なゲームのプレイを継続できない可能性があるということでした。

モデルが構文とセマンティクスのみを学習し、実用的または常識的な推論に失敗した場合、信頼できる AGI をまったく取得できない可能性があります

「ムーアの法則」はそれほど効果的ではありません当初予想していたよりも早く、私たちをここまで遠くまで連れて行ってくれたのは、宇宙の原因と結果の法則が常に当てはまるわけではないからです。

スケールの最大化は単なる興味深い仮定であり、一般的な人工知能には到達できません。たとえば、上記の 3 つの問題を解決するには、パラダイム シフトが必要になります。

ネチズンのフランク・ファン・デル・ヴェルデ氏は、規模を最大化するフォロワーは「大きい」や「より多く」などの曖昧な用語を使用する傾向があると述べた。

深層学習モデルで使用されるトレーニング データは、人間が言語を学習する際に使用するトレーニング データと比較して大きすぎます。

しかし、人間の言語の実際の意味論的なコレクションと比較すると、これらのいわゆる膨大なデータはまだ取るに足らないものです。1 秒あたり 1 文を生成するには約 100 億人が必要であり、そのようなデータを取得するには 300 年かかるでしょう。大規模なトレーニングセット。

Netizen Rebel Science は、スケールの最大化は興味深い仮説ではなく、愚かな仮説であり、AI の分野で負けるだけでなく、醜く死ぬことになるとさえ率直に言いました。

コロンビア大学哲学科の講師でオックスフォード大学の博士号を持つラファエル・ミリエール氏も、戦闘中に自身の意見を述べた。 「規模の最大化」をめぐる議論は最も熾烈を極めた。

規模の最大化は、かつてはディープラーニングの批評家 (ゲイリー・マーカスなど) にとって共通点とみなされていましたが、現在ではナンド・デ・フレイタス氏やアレックス・ディマキス氏などの業界関係者が議論に参加しており、対立しています。

実務者からの反応は大部分がまちまちですが、それほど否定的ではありません。同時に、予測プラットフォーム Metaculus での AGI 実装の予測日は歴史的最低値 (2028 年 5 月) に前倒しされており、これもまた可能性があります。最大規模の信頼性を高めます。

人々の「スケール」に対する信頼が高まっているのは、PaLM、DALL-E 2、Flamingo、Gato の成功などの新モデルのリリースがスケール最大化の火に油を注いだためかもしれません。

サットン氏の「苦い教訓」では、規模の最大化に関する議論で多くの論点が挙げられていますが、それらは完全に同等ではありません。彼は、人間の知識を人工知能モデル (特徴量エンジニアリングなど) に組み込むことは効率が低いと考えています。データやコンピューティングを使って学習するよりも。

記事リンク: http://www.incompleteideas.net/IncIdeas/BitterLesson.html

論争がないわけではありませんが、サットンの指摘は明白であるように思えます。スケールを最大化するためのラジカル。

規模の重要性は強調されていますが、人工知能研究におけるすべての問題を単なる規模の課題に還元するわけではありません。

実際には、スケールを最大化することの具体的な意味を判断することは困難です。文字通り理解すると、「必要なのはスケーリングだけです」ということは、AGI を達成するためにアルゴリズムの革新やアーキテクチャの変更が必要なく、既存の機能を拡張できることを示しています。モデルを作成し、さらに多くのデータを強制的に入力します。

この文字通りの説明は不合理に思えます。Palm、DALL-E 2、Flamingo、Gato などのモデルでも、依然として以前のアプローチからのアーキテクチャの変更が必要です。

既製の自己回帰トランスフォーマーを AGI に拡張できると本気で考えた人がいたら、本当に驚くでしょう。

スケール感の最大化を信じる人々が AGI にどれだけのアルゴリズム革新を必要とするかは不明であり、この観点から反証可能な予測を生成することが困難になっています。

スケーリングは、「汎用人工知能」というラベルに値するシステムを構築するための必要条件かもしれませんが、必要性を十分条件と取り違えるべきではありません。

以上がモデルが「大きくなる」限り、モデルを AGI に直接接続できますか?マーカスは再び砲撃しました: 3 つの危機が発生しました!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。