大規模言語モデル (LLM) は、タスク固有のトレーニングや微調整を必要とせずに、コンテキスト内学習を通じて、さまざまな複雑なタスクで優れたパフォーマンスを実証してきました。プロンプトとデコードの最近の進歩により、LLM は、複雑な推論タスクを解決するための現実。

ただし、LLM には古い知識、不完全な知識、または不正確な知識が保存されている可能性があり、LLM を実際のアプリケーションにうまく導入するには、外部の知識ソース (Wikipedia など) が重要です。これまでにも、T5、BERT、RoBERTa などの小規模な言語モデル (LM) に知識を適用する試みが行われてきましたが、これらの方法は多くの場合、追加のトレーニングや微調整が必要であり、コストがかかり、LLM にとってはまったく実用的ではありません。

これに基づいて、ロチェスター大学、テンセント AI 研究所、ペンシルベニア大学の研究者は共同で、外部知識を活用するための検索による再思考 (RR) と呼ばれる後処理手法を提案しました。 LLM。

論文アドレス: https://arxiv.org/pdf/2301.00303v1.pdf

この研究のアイデアは、Wang らと同様に、まず思考連鎖 (CoT) プロンプト手法を使用して、一連の異なる推論パスを生成することです。 (2022) メソッド。次に、研究ではこれらのパスの各推論ステップを使用して関連する外部知識を取得し、RR 手法でより妥当な説明とより正確な予測を提供できるようにします。

この研究では、GPT-3 175B といくつかの一般的な外部知識ソース (Wikipedia、Wikidata、WordNet、Conceptnet) を使用して、以下を含む 3 つの複雑な推論タスクにおける RR 法のパフォーマンスを評価します。常識的推論、時間的推論、表による推論。実験結果は、追加のトレーニングや微調整を行わなくても、RR がこれら 3 つのタスクにおいて他の手法よりも一貫して優れていることを示しており、RR 手法が外部知識を活用して LLM のパフォーマンスを向上させる点で大きな利点があることを示しています。

検索による再考実際、LLM は質問に答えるために必要な要素を正確に捉えていますが、これらのモデルは時々誤った結果を生成することがあります。この現象は、LLM が知識を保存および取得する方法に次のようないくつかの問題があることを示しています。

思考連鎖 (CoT) プロンプト。標準的なプロンプトとは大きく異なり、CoT プロンプトには、推論プロセスをキャプチャする一連の短い文を生成するためのプロンプト内で、段階的な推論例のデモンストレーションが含まれます。

思考連鎖 (CoT) プロンプト。標準的なプロンプトとは大きく異なり、CoT プロンプトには、推論プロセスをキャプチャする一連の短い文を生成するためのプロンプト内で、段階的な推論例のデモンストレーションが含まれます。

CoT プロンプトの推論は、単に「いいえ」を出力するのではなく、「アリストテレスは紀元前 322 年に亡くなりました。最初のラップトップは 1980 年に発明されました。したがって、アリストテレスはラップトップを使用しませんでした。したがって、答えはノーです。」となります。

さまざまな推論パスをサンプリングします。 Wang et al. (2022) と同様に、この研究では、Wei et al. (2022) のパスのように最適な比例パス (貪欲) のみを考慮するのではなく、異なる推論パスのセット R_1、R_2、...、R_N をサンプリングしました。 。 「アリストテレスはラップトップを使用しましたか?」という質問に関して、考えられる推論経路は次のとおりです:

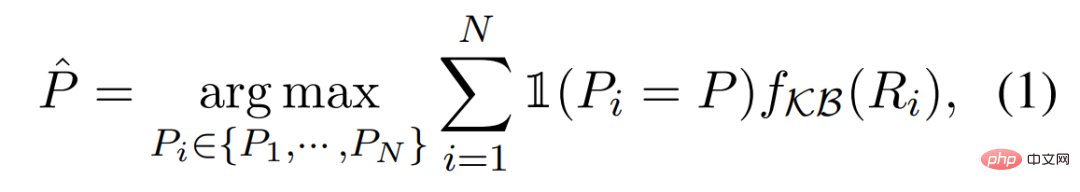

(R_1) アリストテレスは 2000 年に亡くなりました。最初のラップトップは 1980 年に発明されました。そこでアリストテレスはラップトップを使用しました。したがって、この質問に対する答えは「はい」です。 (R_2) アリストテレスは紀元前 322 年に亡くなりました。最初のラップトップは 2000 年に発明されました。したがって、アリストテレスはラップトップを使用しませんでした。したがって、答えはノーです。 知識の検索。さまざまな知識ベースを使用して、さまざまなタスクを処理できます。たとえば、「アリストテレスはラップトップを使用しましたか?」という質問に答えるために、Wikipedia を外部ナレッジ ベース KB として使用できます。情報検索技術を使用すると、分解された推論ステップに基づいて Wikipedia から関連する知識 K_1、...K_M を検索できます。理想的には、この質問について Wikipedia から次の 2 つの段落を取得することになります: (K_1) アリストテレス (紀元前 384 年から紀元前 322 年) は、古代ギリシャの古典期のギリシャの哲学者および博学者でした。 (K_2) 最初のラップトップ コンピューターである Epson HX-20 は 1980 年に発明されました... 忠実な推論。知識ベース KB から取得した関連知識 K_1,...,K_M に基づく関数 f_KB(R_i) を使用して、各推論パス R_i の信頼度を推定できます。最終的な予測は、次の推論プロセスを適用することで取得できます。

セクションでは、この研究では、常識的推論、時間的推論、表形式推論という 3 つの複雑な推論タスクに関する RR の評価を示しています。

実験的な設定。すべての実験では、特に明記されていない限り、この研究では GPT-3 text-davinci-002 を使用します。実験完了時に生成されるトークンの最大数は 256、ゼロショット、少数ショット、および思考連鎖プロンプトに設定され、温度パラメーター (温度) は 0 に固定されました。 ############結果。表 1 に示すように、私たちが提案した手法 RR は、追加のトレーニングや微調整を行わなくても、3 つの推論タスクすべてですべてのベースラインを常に上回っています。これらの結果は、LLM のパフォーマンスを向上させるために外部の知識を活用する際の RR の有効性を強調しています。

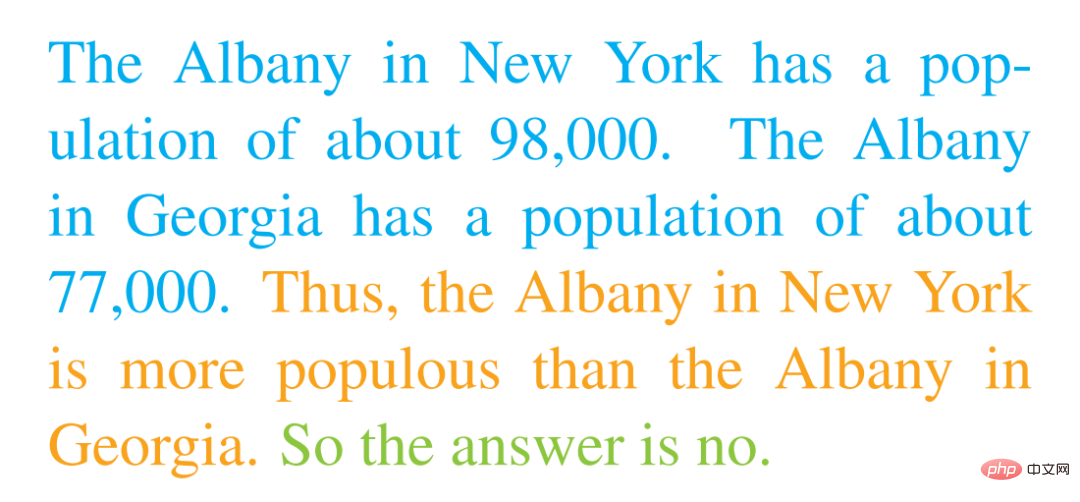

この研究では、StrategyQA データセットに対する CoT プロンプト手法を使用した GPT-3 の分析を示します。 GPT-3 の出力を注意深く調べた結果、研究では、RR が多くの問題に対して合理的な説明と正しい予測を提供できることがわかりました。たとえば、「ジョージア州アルバニーは、ニューヨーク州アルバニーよりも先に住民 100,000 人に到達しますか?」という質問が与えられた場合、GPT-3 は次の出力を生成しました。

この研究では、StrategyQA データセットに対する CoT プロンプト手法を使用した GPT-3 の分析を示します。 GPT-3 の出力を注意深く調べた結果、研究では、RR が多くの問題に対して合理的な説明と正しい予測を提供できることがわかりました。たとえば、「ジョージア州アルバニーは、ニューヨーク州アルバニーよりも先に住民 100,000 人に到達しますか?」という質問が与えられた場合、GPT-3 は次の出力を生成しました。

間違った裏付け事実。表 2 に示すように、GPT-3 はビルボード チャートでリル ジョンの最高チャートの曲について誤った事実裏付けを提供し、最高チャートの曲は正解の Yeah ではなく Get Low であると述べています。さらに、GPT-3 は、富士山の頂上が日本海より高くなることはあり得ないと誤って推論しました。正しい答えは日本海であるということではありません。

#技術的な詳細については、元の論文を参照してください。

以上が大規模な言語モデルを無作為に作成することは禁止されており、ある程度の外部知識があれば、推論は非常に信頼できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。