テキストが与えられると、人工知能は音楽、音声、さまざまな効果音、さらにはブラック ホールやレーザー銃などの想像上の音さえも生成できます。最近サリー大学とインペリアル・カレッジ・ロンドンが共同で立ち上げた AudioLDM は、リリース後すぐに海外で人気を博し、Twitter では 1 週間以内に 300 近くのリツイートと 1,500 件の「いいね!」を獲得しました。モデルがオープンソース化されてから 2 日目、AudioLDM は Hugging Face のホット検索リストのトップに躍進し、1 週間以内に Hugging Face の最も人気のあるアプリケーション リストのトップ 40 (合計約 25,000) に入り、すぐに多くのアプリケーションに表示されました。 AudioLDMに基づく二次創作物。

AudioLDM モデルには次のような特徴があります:

著者は 1 月 27 日にこのモデルのプレビューを初めてリリースし、非常に単純なテキストを表示しました。「A music made by by」 []」([]で生成された音楽)を使用して、さまざまな効果音を生成します。さまざまな楽器や蚊を使って作られた音楽を映したこのビデオは、すぐに Twitter で注目を集め、35.4,000 回以上再生され、130 回以上リツイートされました。

著者はその後、論文と新しいビデオを公開しました。このビデオでは、著者がモデルのほとんどの機能と、ChatGPT を使用してサウンドを生成する効果を示しています。 AudioLDM は宇宙から音を生成することもできます。

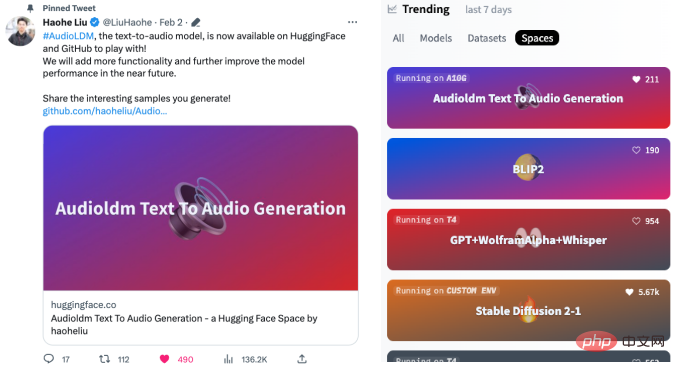

その後、著者は論文、事前トレーニング済みモデル、およびプレイアブル インターフェイスをリリースしたため、Twitter ネチズンの熱意に火がつき、翌日すぐに Hugging Face に掲載されました。ホット検索リスト:

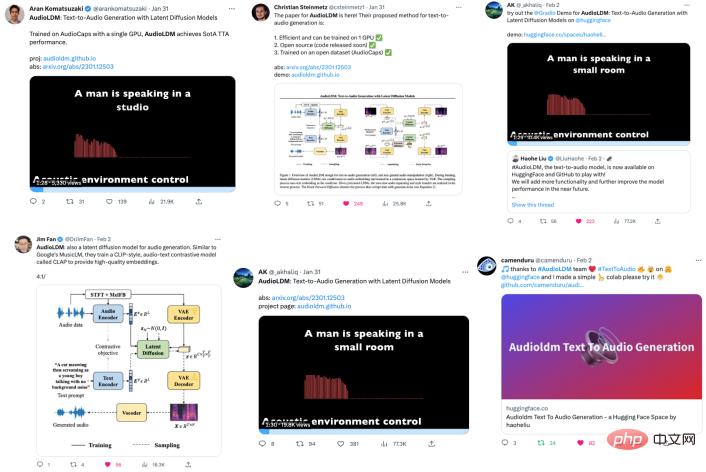

#この研究は Twitter 上で広く注目を集めており、業界の学者らはこの研究結果を転送しました。

ネチズンは AudioLDM を使用してさまざまなサウンドを生成しました。

#たとえば、2 次元の猫娘のいびき音が生成されます。

#

一部のネチズンは、「ミイラの音、低周波、痛みを伴ううめき声」と合成しました。

一部のネチズンは「メロディーのおなら音」を合成しました。

ネチズンの豊かな想像力を嘆かざるを得ません。

一部のネチズンは、AudioLDM を直接使用して、ジャズ、ファンク、エレクトロニック、クラシックなど、さまざまなスタイルの一連の音楽アルバムを生成しました。いくつかの音楽は非常に独創的です。

#例「宇宙と月をテーマにしたアンビエント音楽を作成する」:

# および「未来のサウンドを使用して音楽を作成する」:

興味があります読者はこの音楽アルバムの Web サイトにアクセスできます: https://www.latent.store/albums

一部のネチズンは、想像力を駆使して、画像で生成されたものを組み合わせて画像を作成しましたテキスト モデルと AudioLDM 効果音の生成をガイドするアプリケーション。

たとえば、AudioLDM に次のテキストを与えるとします: 「フリスビーを持って水中を走っている犬」 (フリスビーをくわえて水中を走っている犬):

は、犬が水を叩く次のような音を生成できます。

下の写真のような古い写真のサウンドを復元することもできます。

一部のネチズンは、AudioLDM を使用して燃える犬の音を生成しましたが、これは非常に興味深いものです。

著者は、サウンド効果を生成するモデルの機能を実証するビデオも作成し、AudioLDM で生成されたサンプルがサウンド効果ライブラリの効果にどのように近いかを示しました。

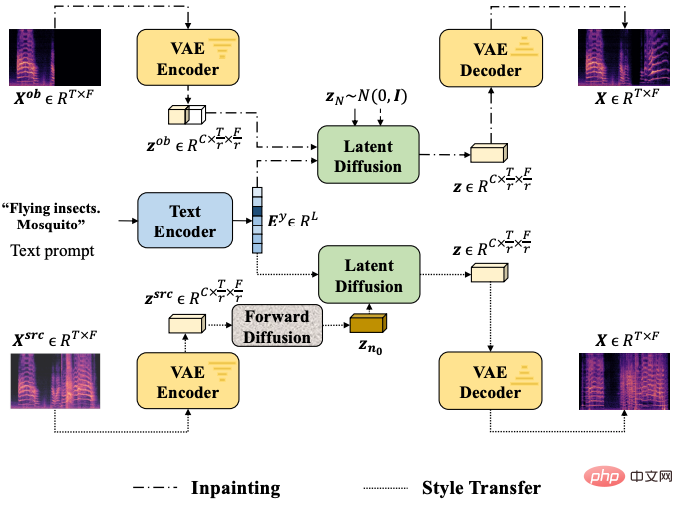

実際、テキスト オーディオの生成は AudioLDM の機能の一部にすぎません。AudioLDM は、音色変換、欠落充填、超解像度も実現できます。

下の 2 つの写真は、(1) パーカッションからアンビエント ミュージックへ、(2) トランペットから子供たちの歌への音色の変化を示しています。

トランペットの音は、子供の歌の音に変換されます(段階的な変換強度)。

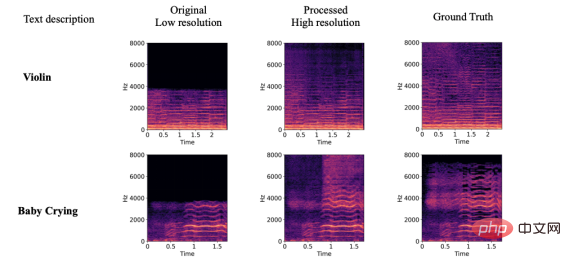

以下では、オーディオ超解像、オーディオ欠落充填、およびサウンドマテリアル制御に対するモデルの効果を示します。記事の長さに制限があるため、オーディオは主にスペクトログラムの形式で表示されます。興味のある読者は、AudioLDM プロジェクトのホームページにアクセスしてください: https://audioldm.github.io/

オーディオの超解像に関しても、AudioLDM の効果は非常に優れており、以前の超解像モデルと比較して、AudioLDM は音楽や音声の処理に限定されないユニバーサルな超解像モデルです。

音声の欠落を埋めるという点では、AudioLDM は指定されたテキストに従ってさまざまな音声コンテンツを埋めることができます。境界での移行は比較的自然です。

さらに、AudioLDM は、音響環境、音楽の雰囲気と速度、オブジェクトの素材、ピッチのピッチとシーケンスなどの強力な制御機能も示します。制御機能については、興味のある読者は確認してください。 AudioLDM の論文またはプロジェクトのホームページから出力します。

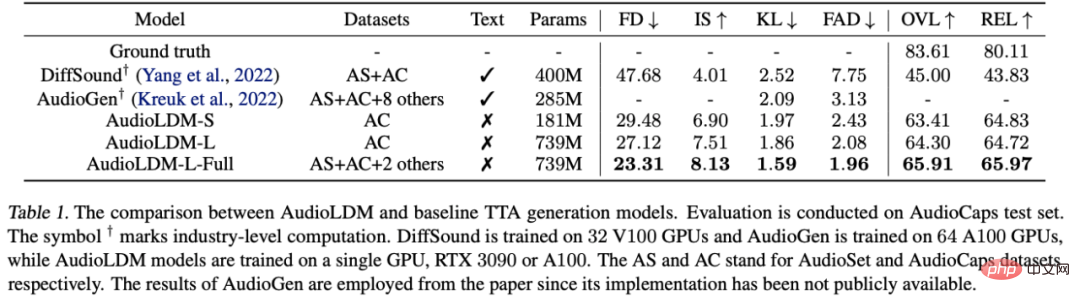

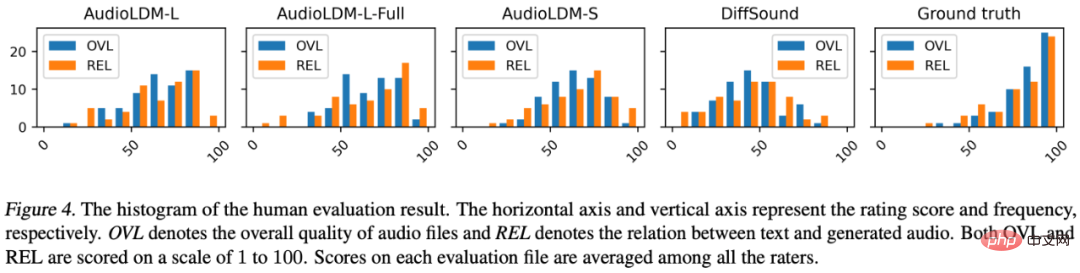

記事の中で、著者は AudioLDM モデルの主観的なスコアリングと客観的なインデックス評価を行いました。結果は、どちらも以前の最適なモデルを大幅に上回る可能性があることを示しています:

AudioGen は、2022 年 10 月に Facebook によって提案されたモデルで、10 個のデータセット、64 GPU、および 285 MB のパラメーターを使用します。比較すると、AudioLDM-S は、単一のデータ セット、1 GPU、および 181 MB のパラメーターでより良い結果を達成できます。

主観的なスコアでも、AudioLDM が以前のソリューション DiffSound よりも大幅に優れていることがわかります。では、AudioLDM はこのような優れたパフォーマンスを実現するためにどのような改良を加えたのでしょうか?

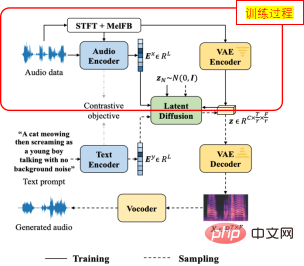

まず、テキストとオーディオのデータペアが少なすぎるという問題を解決するために、著者は AudioLDM をトレーニングするための自己教師あり手法を提案しました。

具体的には、コア モジュールの LDM をトレーニングするときに、作成者はオーディオ自体の埋め込みを条件として使用します。 LDM シグナルでは、プロセス全体にテキストの使用は含まれません (上の画像に示すように)。このスキームは、元の CLAP テキストで優れた一般化機能が実証されている、事前にトレーニングされた 1 対のオーディオ テキスト対比学習エンコーダー (CLAP) に基づいています。 AudioLDM は CLAP の優れた一般化機能を利用して、テキスト ラベルを必要とせずに大規模なオーディオ データでのモデル トレーニングを実現します。

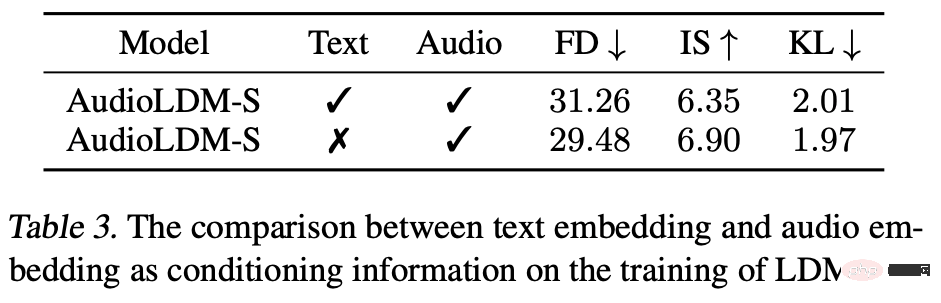

実際、著者らは、音声のみを使用したトレーニングのほうが、音声とテキストのデータのペアを使用するよりも優れていることを発見しました。

著者は、次の 2 つの理由を分析しました。 (1) テキスト アノテーション自体に、音響環境、周波数分布など、音声のすべての情報を含めることが難しく、埋め込みが発生する(2) テキスト自体の品質が完璧ではありません。たとえば、「ボート: 戦艦 - 5.25 コンベアスペース」という注釈は、人間ですら具体的な音が何であるかを想像するのが困難です。これは、モデルのトレーニングで問題を引き起こす可能性があります。対照的に、オーディオ自体を LDM の条件として使用すると、ターゲットのオーディオと条件の間に強い相関関係が確保され、より良い生成結果が得られます。

さらに、著者が採用した潜在拡散ソリューションでは、拡散モデルをより小さな空間で計算できるため、モデルの計算能力要件が大幅に削減されます。

モデルのトレーニングと構造における多くの詳細な調査も、AudioLDM が優れたパフォーマンスを達成するのに役立ちます。

#著者は、2 つの主要な下流タスクを紹介する簡単な構造図も作成しました。

著者は、さまざまなモデル構造、モデル サイズ、DDIM サンプリング ステップ、さまざまな分類子を使用しないガイダンス スケールを使用した詳細な実験も実施しました。

著者らは、モデルを公開すると同時に、将来このような問題に関する学術コミュニティの評価方法を統一するために、生成モデル評価システムのコードベースも公開し、それによって準備を容易にしました。質問された論文間の比較:

#著者のチームは、モデルが学術コミュニケーションのみに使用されることを保証するために、モデルの使用、特に商用利用を制限し、倫理的問題を防ぐために適切なライセンスと透かし保護を使用することを表明しました。

この論文の共著者は、Liu Haohe (英国サリー大学) と Chen Zehua (英国インペリアル カレッジ ロンドン) の 2 人です。

Liu Haohe は現在、マーク D 教授の指導の下、英国のサリー大学で博士号取得に向けて勉強しています。プランリー。そのオープンソース プロジェクトは、GitHub で何千ものスターを獲得しています。彼は主要な学術会議で 20 以上の論文を発表し、いくつかの世界機械音響コンテストでトップ 3 のランキングを獲得しました。企業の世界では、Microsoft、ByteDance、英国放送協会などと広範な協力関係を築いています。個人ホームページ: https://www.surrey.ac.uk/people/haohe-liu

Chen Zehua は、インペリアル カレッジ ロンドンの博士課程の学生で、ダニロ マンディック教授に師事しており、マイクロソフト音声合成研究グループと JD 人工知能研究所でインターンを行ってきました。彼の研究対象には、生成モデル、音声合成、生体電気信号生成などがあります。

以上がオープンソース モデル、シングル カード トレーニングにより、人気のあるテキストガイド付きオーディオ生成テクノロジ AudioLDM を理解できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。