近年、より複雑なタスクを処理するためにニューラルネットワークの大規模化が進んでおり、ニューラルネットワークをいかに効率的に記憶・伝送するかが非常に重要となっています。一方で、最近、宝くじ仮説 (LTH) の提案により、ランダム スパース ニューラル ネットワークが大きな可能性を示しており、この可能性を利用してネットワークの保存効率や伝送効率を向上させる方法も検討する価値があります。

ノースイースタン大学とロチェスター工科大学の研究者は、パラメーター効率の高いマスキング ネットワーク (PEMN) を提案しました。著者らはまず、限られた数の乱数によって生成されるランダム ネットワークの表現能力を調査します。実験によれば、ネットワークが限られた数の乱数から生成された場合でも、異なるサブネットワーク構造を選択することで優れた表現能力を維持できることがわかりました。

この探索的な実験を通じて、著者は必然的に、限られた数の乱数をプロトタイプとして使用し、一連のマスクと組み合わせてニューラル ネットワークを表現することを提案しました。限られた数の乱数とバイナリ マスクが占有するストレージ スペースはごくわずかであるため、著者はこれを使用してネットワーク圧縮の新しいアイデアを提案します。この論文は NeurIPS 2022 に採択されました。コードはオープンソース化されています。

2. 研究の動機/プロセス

上記の関連研究では、トレーニング可能性やユーザビリティなど、さまざまな角度からランダム スパース ネットワークの可能性を調査しました。表現力についても理解できます。この研究において、著者らは、乱数から生成されたニューラル ネットワークが重みをトレーニングせずにどの程度うまく表現できるかに興味を持っています。この問題の調査に続いて、著者らはパラメータ効率の高いマスキング ネットワーク (PEMN) を提案しました。当然のことながら、著者は PEMN を使用してネットワーク圧縮の新しいアイデアを提供し、PEMN の潜在的なアプリケーション シナリオを探索するための例として機能します。3. 乱数で構成されるニューラル ネットワークの表現能力を探索する

ランダム ネットワークが与えられた場合、著者はエッジ ポップアップ アルゴリズムを選択して、そのネットワークを探索するサブネットワークを選択します。表現力。違いは、ネットワーク全体をランダムに初期化する代わりに、プロトタイプを使用してランダム ネットワークを構築するための 3 つのパラメータ集約型ネットワーク生成戦略を著者が提案していることです。

上図は、ConvMixer と ViT ネットワークを使用した CIFAR10 画像分類の実験結果を示しています。 Y 軸は精度、X 軸はさまざまな戦略を使用して取得されたランダム ネットワークです。として

実験結果によると、ランダム ネットワークに非常に限られた数の非反復乱数 (PR_1e-3 など) しか含まれていない場合でも、依然としてネットワークを維持できることがわかりました。選択したサブネットワークの表現。これまでのところ、著者はさまざまなランダム ネットワーク生成戦略を通じて、限られた数の乱数で構成されるニューラル ネットワークの表現能力を調査し、非反復乱数が非常に限られている場合でも、対応するランダム ネットワークは依然として表現できることを観察しました。データもしっかり。

同時に、これらのランダム ネットワーク生成戦略に基づいて、得られたサブネットワーク マスクと組み合わせて、著者は、パラメーター効率的マスキング ネットワーク (PEMN) と呼ばれる新しいニューラル ネットワーク タイプを提案しました。

この記事では、PEMN の潜在的なアプリケーションを拡張する例としてニューラル ネットワーク圧縮を選択します。具体的には、この記事で提案するさまざまなランダム ネットワーク生成戦略では、プロトタイプを効率的に使用して、完全なランダム ネットワーク、特に最も粒度の細かいランダム ベクトル パディング (RP) 戦略を表現できます。

著者は、RP 戦略でランダム ベクトル プロトタイプと、対応するサブネット マスクのセットを使用して、ランダム ネットワークを表します。プロトタイプは浮動小数点形式で保存する必要がありますが、マスクはバイナリ形式でのみ保存する必要があります。 RP のプロトタイプの長さは非常に短くできるため (限られた数の非反復乱数には依然として強力な表現能力があるため)、ニューラル ネットワークを表現するオーバーヘッドは非常に小さくなります。つまり、浮動小数点数形式を次のように格納します。制限された長さ ランダムなベクトルとバイナリ形式のマスクのセット。サブネットワークの浮動小数点値を保存する従来のスパースネットワークと比較して、この論文はニューラルネットワークを効率的に保存および送信するための新しいネットワーク圧縮のアイデアを提案します。

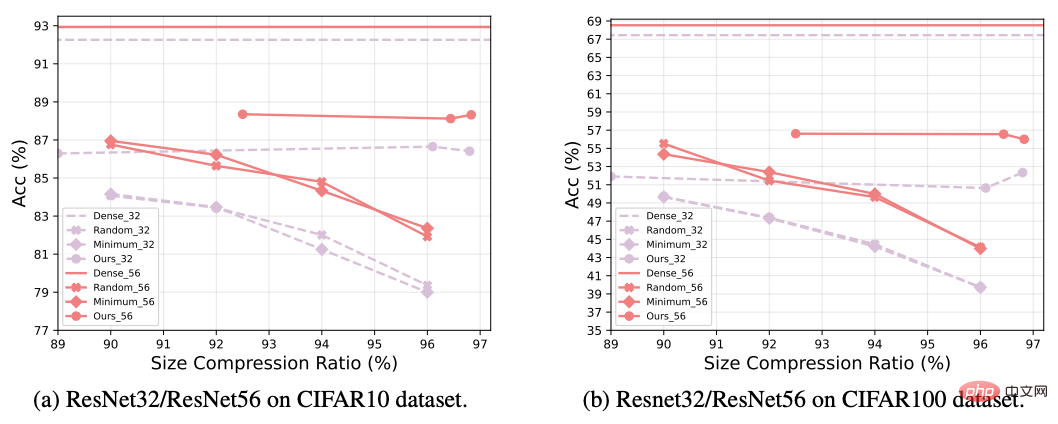

上の図では、著者は PEMN を使用してネットワークを圧縮し、従来のネットワーク プルーニング手法と比較しています。この実験では、ResNet ネットワークを使用して、CIFAR データ セットに対して画像分類タスクを実行します。一般に、新しい圧縮スキームは従来のネットワーク プルーニングよりも優れたパフォーマンスを示し、特に非常に高い圧縮率でも、PEMN は良好な精度を維持できることがわかりました。

最近ランダム ネットワークによって実証された可能性に触発されて、この論文では、ランダム ニューラル ネットワークを構築するためのさまざまなパラメーター集中戦略を提案し、次の問題を検討します。乱数を繰り返さずに生成されたランダム ニューラル ネットワークの表現可能性は限られており、パラメーター効率の良いマスキング ネットワーク (PEMN) が提案されています。著者は、PEMN をネットワーク圧縮シナリオに適用して、実際のアプリケーションでの可能性を探り、ネットワーク圧縮の新しいアイデアを提供します。著者らは、ランダム ネットワーク内に非常に限られた数の非反復乱数しか存在しない場合でも、サブネットワークの選択を通じて優れた表現能力を備えていることを示す広範な実験を提供しています。さらに、従来のプルーニング アルゴリズムと比較して、新しく提案された方法がより優れたネットワーク圧縮効果を達成できることを実験で示し、このシナリオにおける PEMN の応用可能性を検証しています。

以上がストレージと伝送効率を向上させるにはどうすればよいですか?パラメータを集中的に使用するマスク ネットワークは大きな効果を発揮しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。