画像生成は、現在の AIGC 分野で最も人気のある方向の 1 つです。最近リリースされた DALL・E 2、Imagen、Stable Diffusion などの画像生成モデルは、画像生成の新時代を到来させ、前例のないレベルの画質とモデルの柔軟性を実現しました。普及モデルも現在では主流のパラダイムとなっています。ただし、拡散モデルは反復推論に依存しています。これは両刃の剣です。反復手法は単純な目的で安定したトレーニングを達成できますが、推論プロセスには高い計算コストが必要となるからです。

拡散モデルが登場する前は、敵対的生成ネットワーク (GAN) が画像生成モデルで一般的に使用されていたインフラストラクチャでした。拡散モデルと比較して、GAN は単一の順方向パスを通じて画像を生成するため、本質的に効率が高くなりますが、GAN をスケーリングするには、トレーニング プロセスが不安定であるため、ネットワーク アーキテクチャとトレーニング係数を慎重に調整する必要があります。したがって、GAN は単一または複数のオブジェクト クラスのモデリングには優れていますが、(現実世界はもちろんのこと) 複雑なデータセットに拡張することは非常に困難です。その結果、非常に大規模なモデル、データ、計算リソースが拡散モデルと自己回帰モデルに専念するようになりました。

しかし、効率的な生成方法として、多くの研究者は GAN 方法を完全に放棄したわけではありません。たとえば、NVIDIA は最近 StyleGAN-T モデルを提案し、香港の中国人などが GAN ベースの手法を使用してスムーズなビデオを生成しましたが、これらは GAN に関する CV 研究者によるさらなる試みです。

今回、CVPR 2023 の論文で、POSTECH、カーネギーメロン大学、Adobe Research の研究者が共同で、GAN に関する次のような重要な問題を検討しました。

#GAN はスケールし続け、大規模なリソースから恩恵を受けることができますか? GAN はボトルネックに遭遇しましたか?

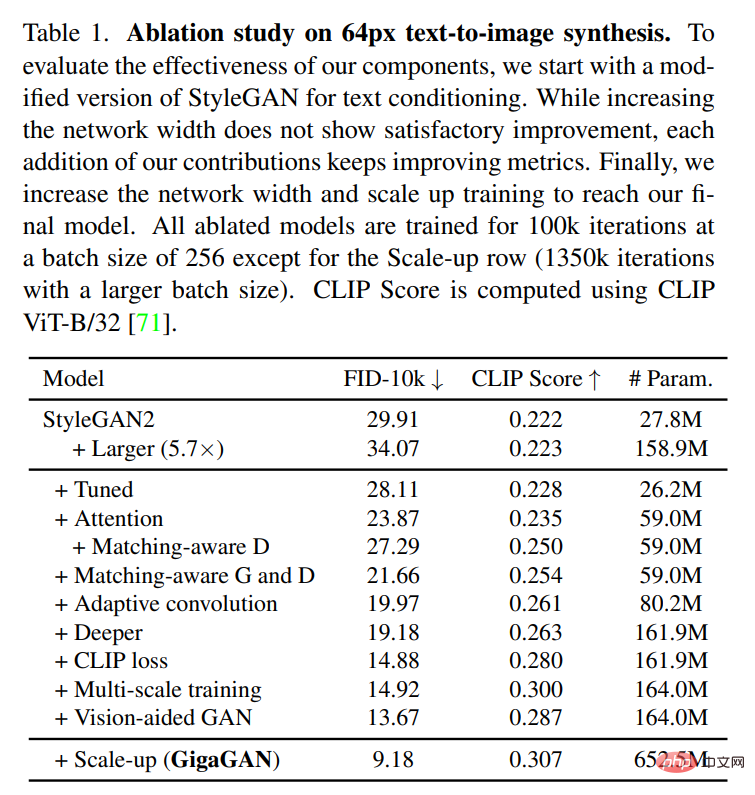

この研究では、最初に StyleGAN2 を使用した実験が行われ、バックボーン ネットワークを拡張するだけではトレーニングが不安定になることが観察されました。これに基づいて、研究者らはいくつかの重要な問題を特定し、モデルの能力を向上させながらトレーニングを安定させる手法を提案しました。

まず、この研究では、フィルターのセットを保持し、サンプル固有の線形結合を採用することで、ジェネレーターの容量を効果的に拡張します。この研究では、拡散の文脈で一般的に使用されるいくつかの技術も採用されており、それらが GAN に同様の利点をもたらすことも確認されました。たとえば、自己注意 (画像のみ) と相互注意 (画像とテキスト) を畳み込み層と組み合わせることで、モデルのパフォーマンスを向上させることができます。

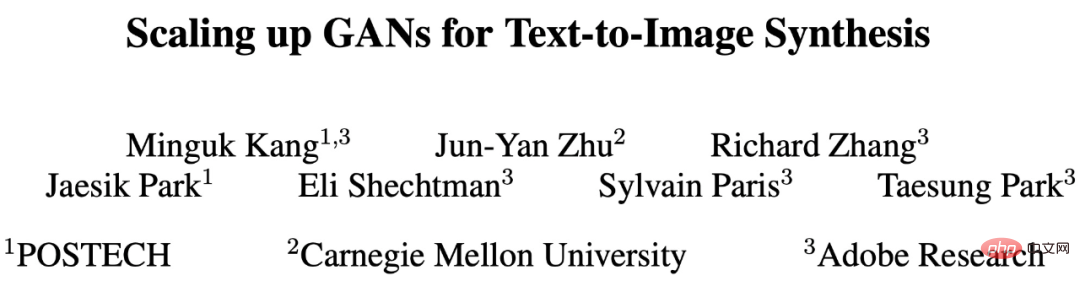

この研究では、マルチスケール トレーニングも再導入し、画像とテキストの位置合わせを改善し、出力の低周波の詳細を生成するための新しいスキームを提案しています。マルチスケール トレーニングにより、GAN ベースのジェネレーターは低解像度ブロックのパラメーターをより効率的に使用できるようになり、画像とテキストの位置合わせと画質が向上します。この研究では、慎重な調整を経て、10億個のパラメータを備えた新しいモデルGigaGANを提案し、大規模なデータセット(LAION2B-enなど)での安定かつスケーラブルなトレーニングを実現します。実験結果を以下の図1に示します。

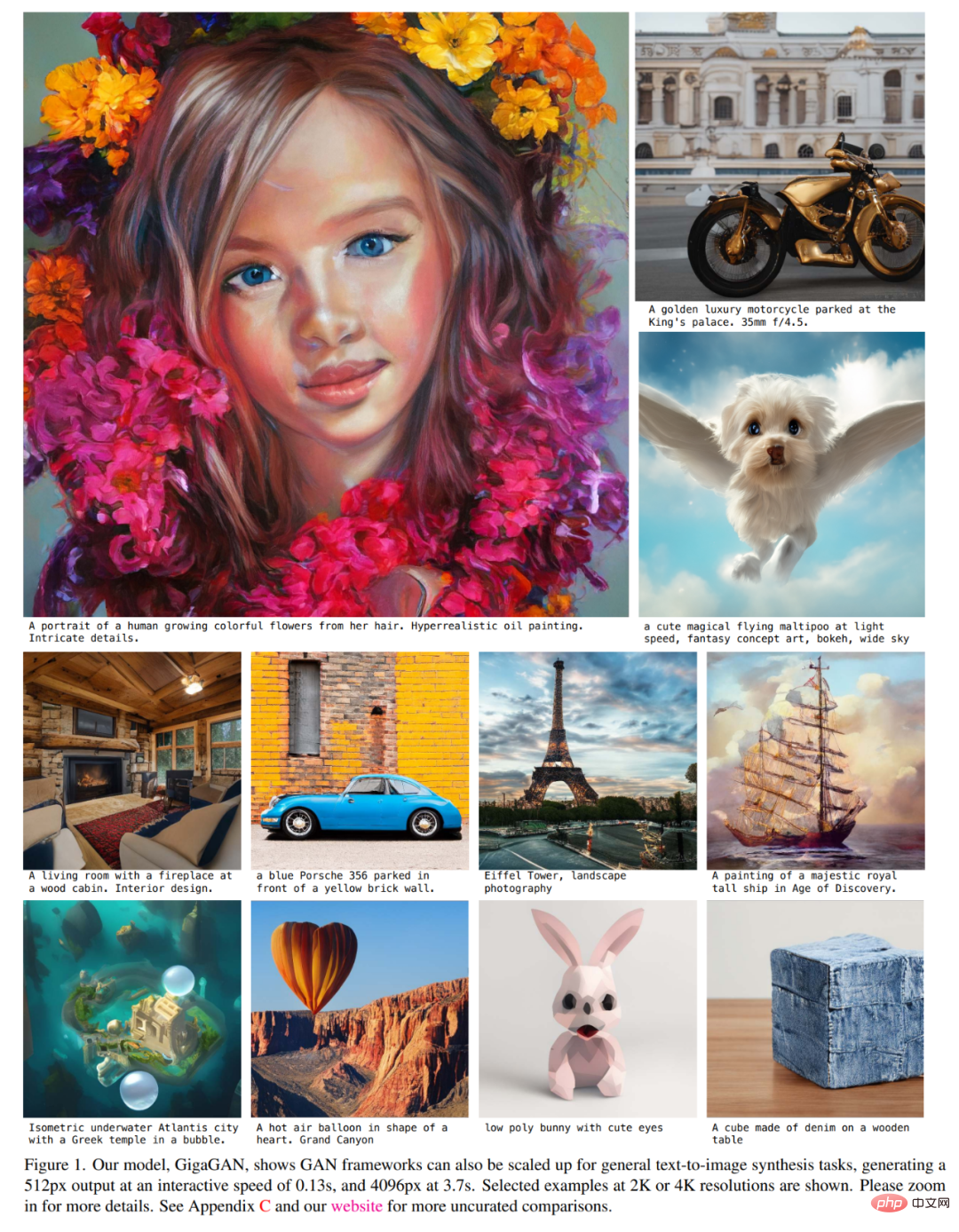

この研究は、以下の図 2 と 3 に示すように、テキスト条件付き GAN アップサンプリング ネットワークが基礎となる拡散モデルの効率的で高品質なアップサンプラーとして使用できることを示しています。

上記の改善により、GigaGAN は以前の GAN をはるかに超えており、StyleGAN2 の 36 倍、StyleGAN-XL および XMC-GAN の 6 倍となっています。 GigaGAN のパラメータ数 10 億 (1B) は、Imagen (3.0B)、DALL・E 2 (5.5B)、Parti (20B) などの最近の大規模合成モデルのパラメータ数よりもまだ低いものの、研究者らはまだ十分ではないと述べています。モデルのサイズに大きな変化が見られました。サイズの品質は飽和しています。

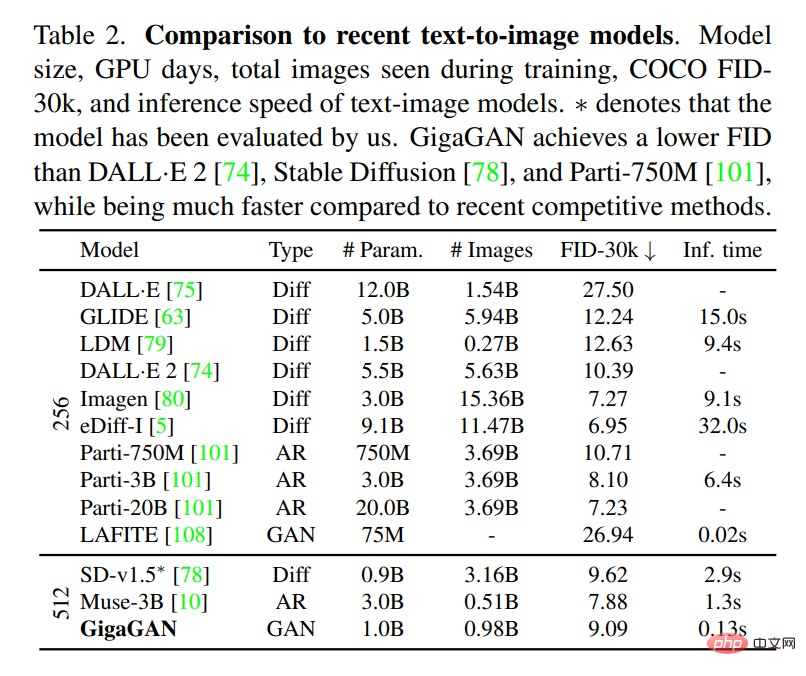

GigaGAN は、COCO2014 データセットでゼロサンプル FID 9.09 を達成しましたが、これは DALL・E 2、Parti-750M、安定拡散よりも低い値です。

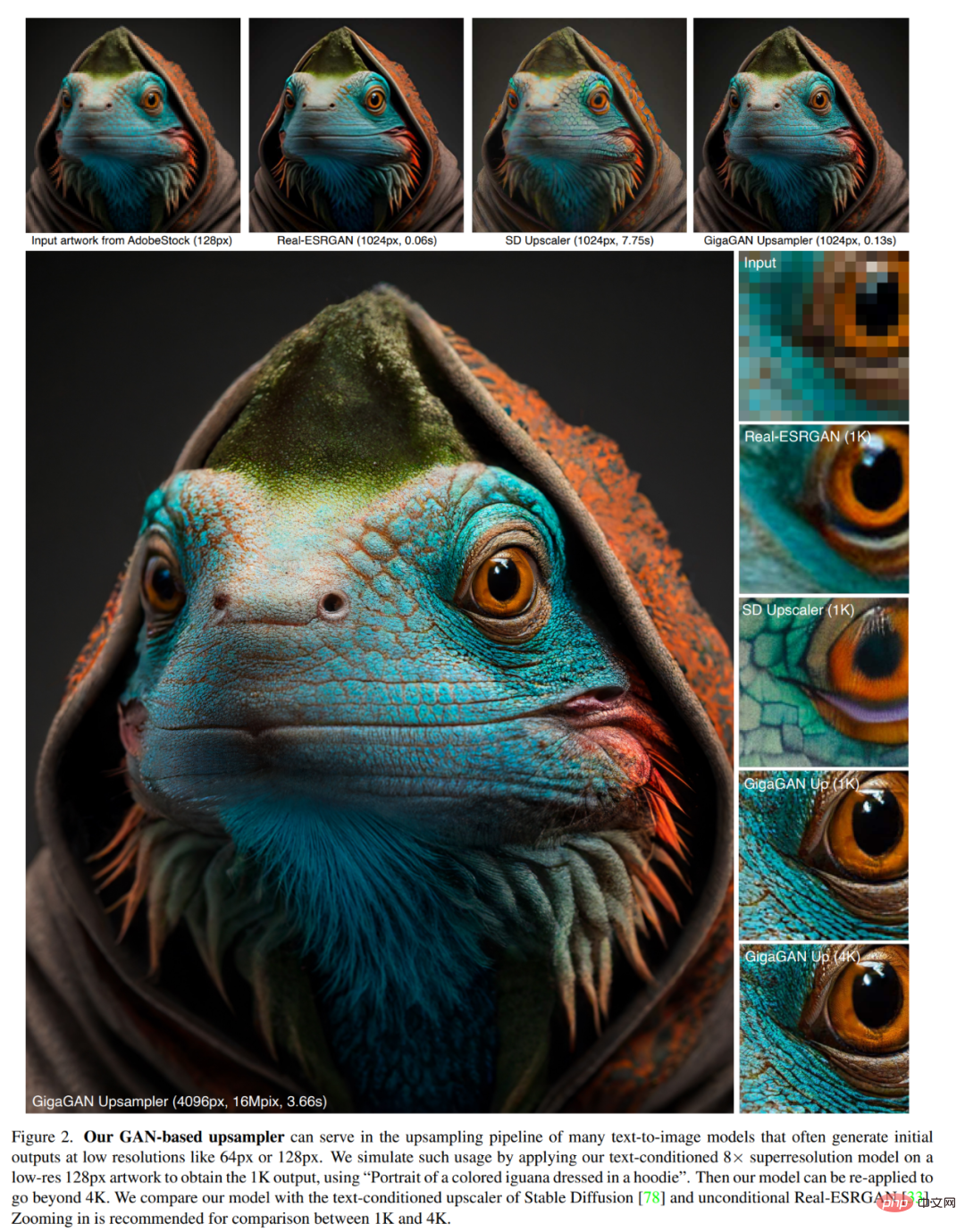

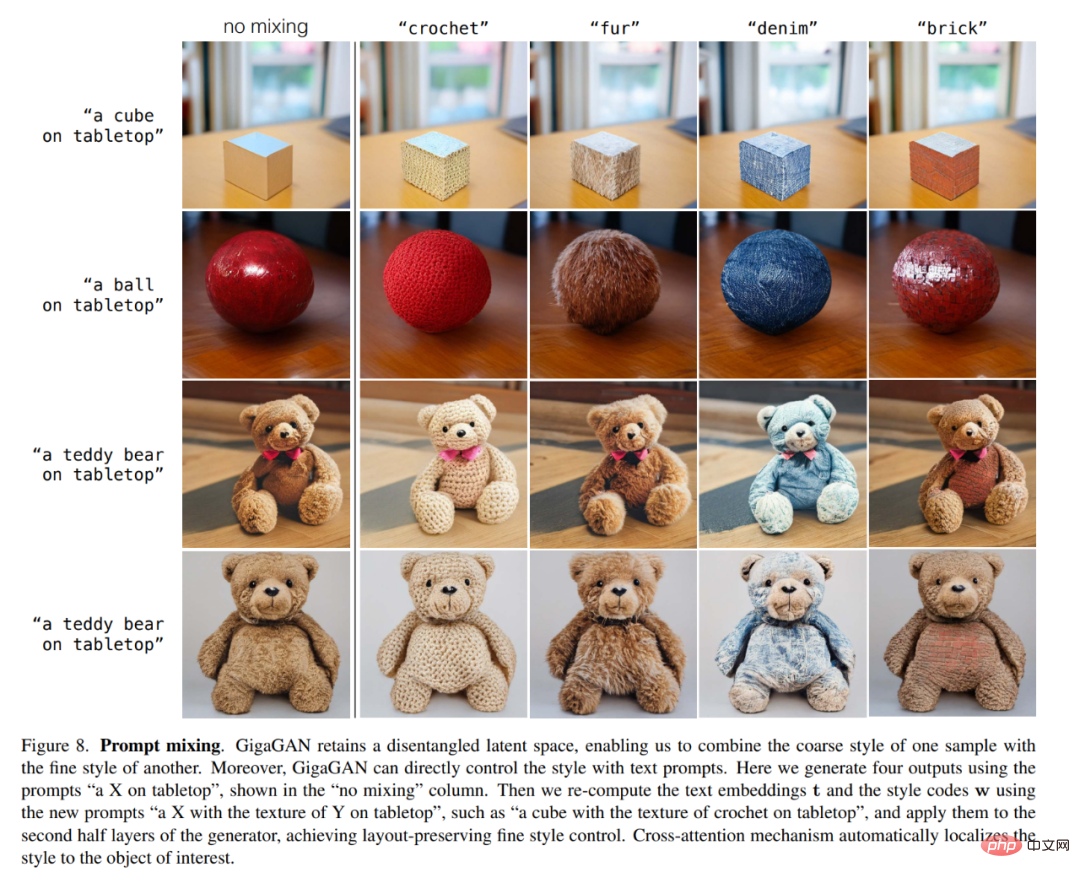

さらに、拡散モデルや自己回帰モデルと比較して、GigaGAN には 3 つの大きな実用的な利点があります。まず、数十倍高速であり、512 ピクセルの画像を 0.13 秒で生成します (図 1)。 2 番目に、わずか 3.66 秒で 4k 解像度の超高解像度画像を合成できます。第三に、スタイル ブレンディング (図 6)、プロンプト補間 (図 7)、プロンプト ブレンディング (図 8) など、よく研究された制御可能な画像合成アプリケーションに適した制御可能な潜在ベクトル空間を備えています。 ################################################ #これ研究では、GAN ベースの 10 億パラメータ スケール モデル GigaGAN を数十億の実世界の画像でトレーニングすることに成功しました。これは、GAN が依然としてテキストから画像への合成の実行可能な選択肢であり、研究者が将来の積極的な拡張のために GAN を検討する必要があることを示唆しています。

方法の概要

研究者は、可能性のあるエンコード z∼N (0, 1)∈R ^128 とテキストを与えて、ジェネレーター G (z, c) をトレーニングしました。条件付け信号 c は、画像 x∈R^(H×W×3) を予測します。彼らは、識別器 D(x, c) を使用して、画像とテキストのペアを含むトレーニング データベース D 内のサンプルと比較して、生成された画像の信頼性を判断します。

ジェネレーターは、中間特徴を RGB イメージに変換することにより、イメージ ピラミッドを出力します。より高い容量を実現するために、各スケールで複数のアテンション層と畳み込み層を使用します (付録 A2)。彼らはまた、この図には示されていない別のアップサンプラー モデルも使用しました。

識別子は、画像とテキストの条件付け t_D を処理するための 2 つの分岐で構成されます。テキスト ブランチは、ジェネレーターと同様にテキストを処理します (図 4)。画像ブランチは画像ピラミッドを受け取り、画像スケールごとに独立した予測を行います。さらに、ダウンサンプリング層の後続のすべてのスケールで予測が行われるため、マルチスケール入力、マルチスケール出力 (MS-I/O) 弁別器となります。

実験結果

論文では、著者は 5 つの異なる実験を記録しました。

#最初の実験では、各技術要素を 1 つずつ組み込むことで提案手法の有効性を実証しました。

2 番目の実験では、モデルのグラフ生成機能をテストし、結果は GigaGAN のパフォーマンスが優れていることを示しました。安定拡散 (SD-v1.5) は FID に匹敵しますが、拡散モデルや自己回帰モデルよりもはるかに高速に結果を生成します。

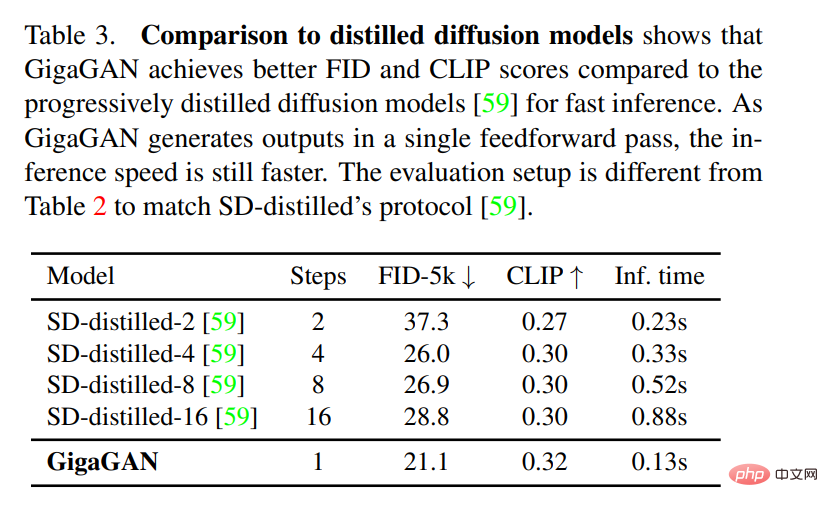

3 番目の実験では、GigaGAN と蒸留ベースの拡散モデルを比較しました。結果は、GigaGAN が蒸留ベースの拡散モデルより効率的であることを示しました。拡散: モデルは高品質の画像をより速く合成します。

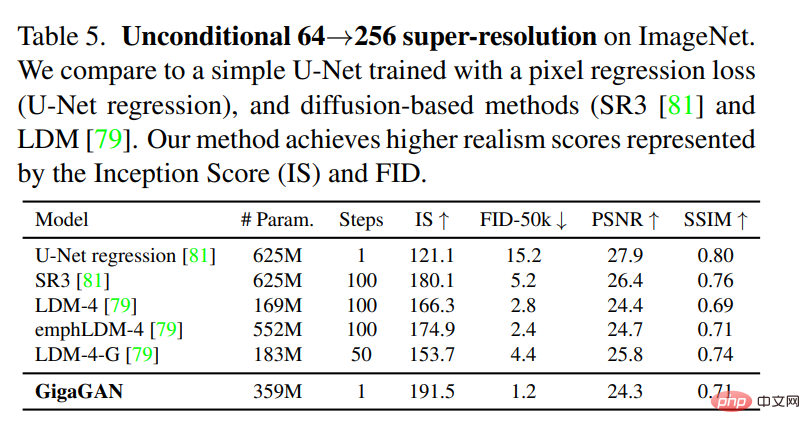

4 番目の実験では、GigaGAN のアップサンプラーが条件付きおよび無条件の超解像度を達成できることが検証されました。タスクを評価します。

以上がGANの逆襲:Zhu Junyan氏の新作CVPR作品「GigaGAN」、画像出力速度がStable Diffusionを上回るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。