ChatGPT はすぐに何百万もの人々の注目を集めましたが、多くの人はそれがどのように機能するかを理解していなかったために警戒していました。この記事では、それを理解しやすいように分解してみます。

ただし、ChatGPT は本質的には非常に複雑なシステムです。 ChatGPT を使って遊んでみたい、または ChatGPT が何であるかを理解したい場合、コア インターフェイスはチャット ウィンドウであり、そこで質問したりクエリを提供すると AI が応答します。覚えておくべき重要な点は、チャットではコンテキストが保持されるということです。つまり、メッセージは以前の情報を参照でき、ChatGPT はこれをコンテキスト的に理解できることになります。

クエリがチャット ボックスに入力されると何が起こりますか?

まず第一に、ChatGPT のフレームワークの下では発見すべきことがたくさんあります。機械学習は過去 10 年間で急速に発展しており、ChatGPT はその成果を達成するために多くの最先端テクノロジーを利用しています。

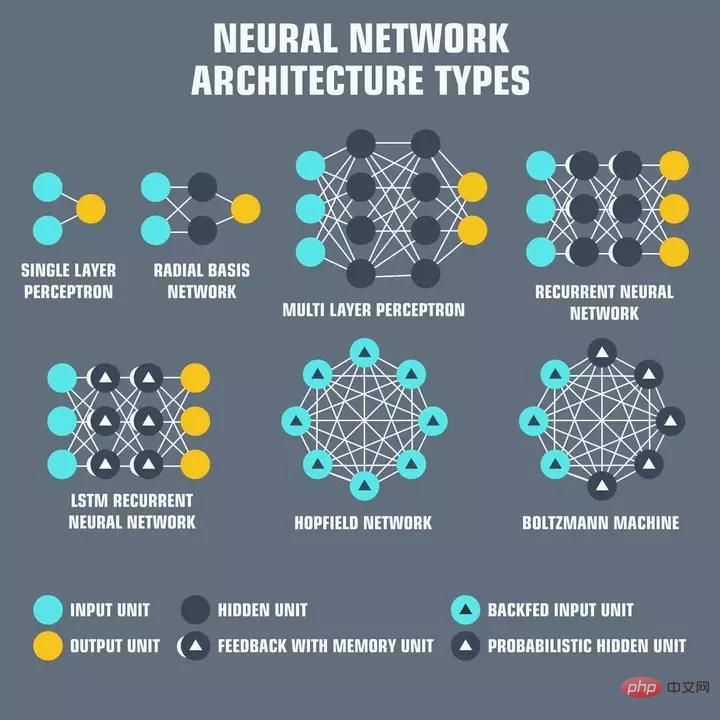

ニューラル ネットワークは相互接続された「ニューロン」の層であり、各ニューロンは入力の受信、処理、ネットワークへの受け渡しを担当します。の次のニューロン。ニューラル ネットワークは、今日の人工知能のバックボーンを形成しています。入力は通常、処理されるデータの何らかの側面を表す「特徴」と呼ばれる一連の数値です。たとえば、言語処理の場合、特徴は文内の各単語の意味を表す単語の埋め込みである可能性があります。

単語埋め込みは、ニューラル ネットワークがテキストの意味を理解するために使用する単純なテキストの数値表現であり、意味論的に論理的な方法で応答するなど、他の目的に使用できます!

ChatGPT で Enter キーを押すと、テキストはまず単語埋め込みに変換され、インターネット全体からのテキストでトレーニングされます。次に、入力単語の埋め込みが与えられた場合に、適切な応答単語の埋め込みのセットを出力するようにトレーニングされたニューラル ネットワークが存在します。これらの埋め込みは、入力クエリに適用される逆演算を使用して人間が読める単語に翻訳されます。このデコードされた出力は、ChatGPT が出力するものです。

変換と出力生成の計算コストは非常に高くなります。 ChatGPT は、1,750 億個のパラメータを持つ大規模な言語モデルである GPT-3 の上に位置します。これは、OpenAI が大規模なデータセットを使用して調整した広範なニューラル ネットワークには 1,750 億の重みがあることを意味します。

したがって、各クエリには少なくとも 2 回の 1,750 億の計算が必要となり、その計算はすぐに増加します。 OpenAI は、計算コストを削減するためにこれらの計算をキャッシュする方法を見つけた可能性がありますが、この情報がどこかで公開されているかどうかは不明です。さらに、今年初めにリリースされる予定の GPT-4 には、パラメーターが 1,000 倍あると言われています!

計算の複雑さの点で実際のコストが発生するでしょう! ChatGPT が有料になっても驚かないでください。現在、OpenAI を無料で実行するために何百万ドルも費やされているため、まもなく製品化されます。

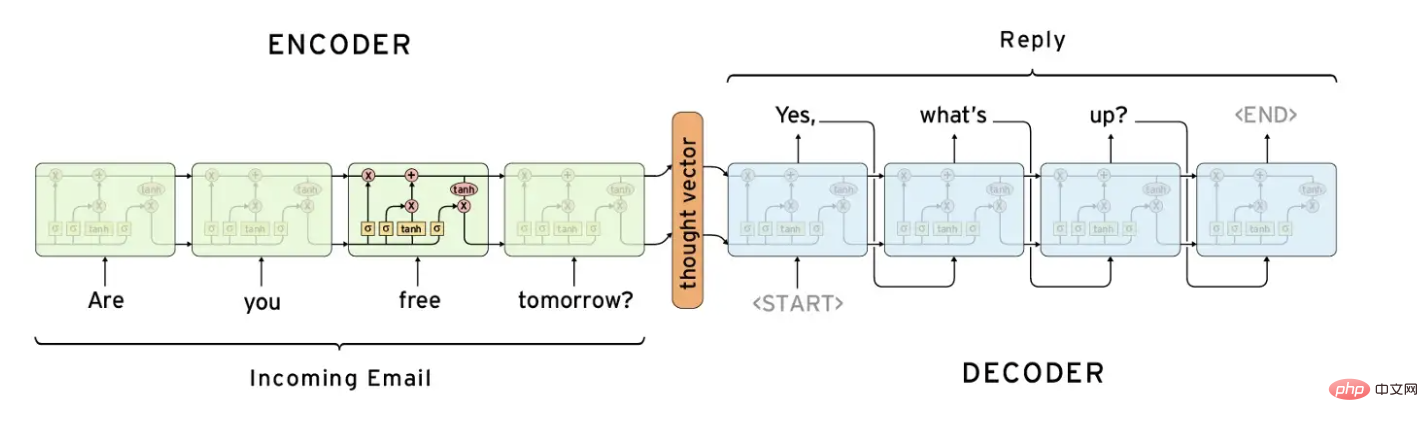

自然言語処理で一般的に使用されるニューラル ネットワーク構造は、エンコーダ/デコーダ ネットワークです。これらのネットワークは、入力シーケンスをコンパクトな表現に「エンコード」し、その表現を出力シーケンスに「デコード」するように設計されています。

伝統的に、エンコーダー/デコーダー ネットワークは、逐次データを処理するためにリカレント ニューラル ネットワーク (RNN) と組み合わせられてきました。エンコーダは入力シーケンスを処理して固定長ベクトル表現を生成し、それがデコーダに渡されます。デコーダはこのベクトルを処理し、出力シーケンスを生成します。

エンコーダ/デコーダ ネットワークは、機械翻訳などのタスクで広く使用されています。入力はある言語の文であり、出力はその文を別の言語に翻訳したものです。これらは、要約や画像キャプションの生成タスクにも適用されます。

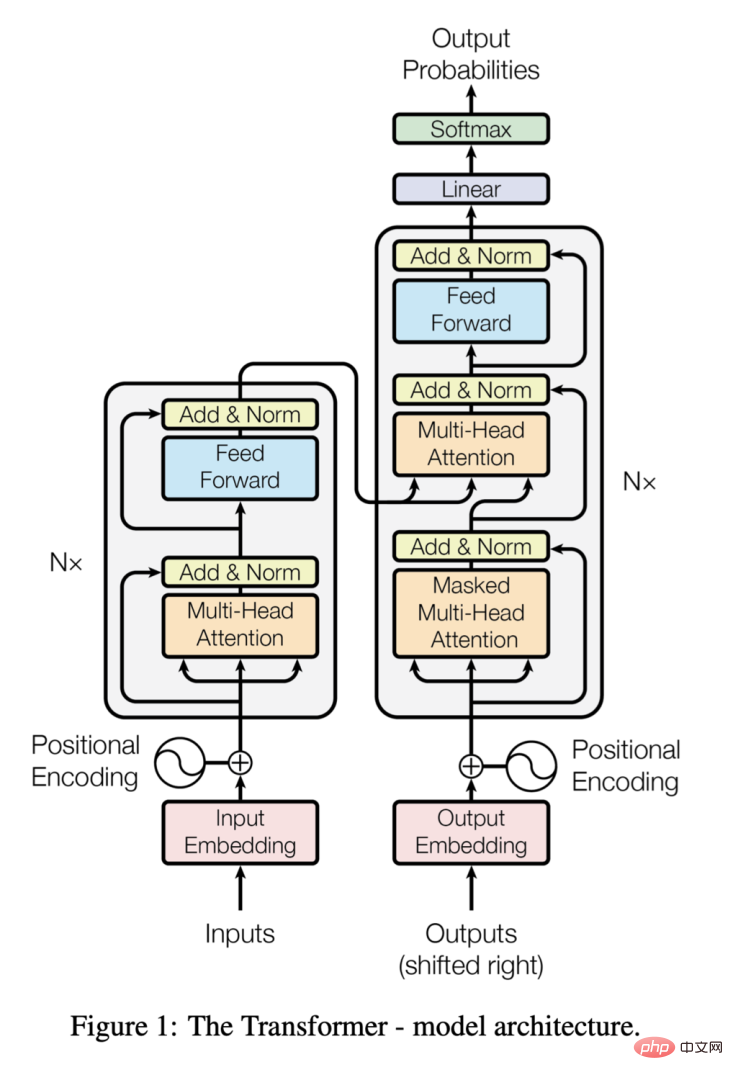

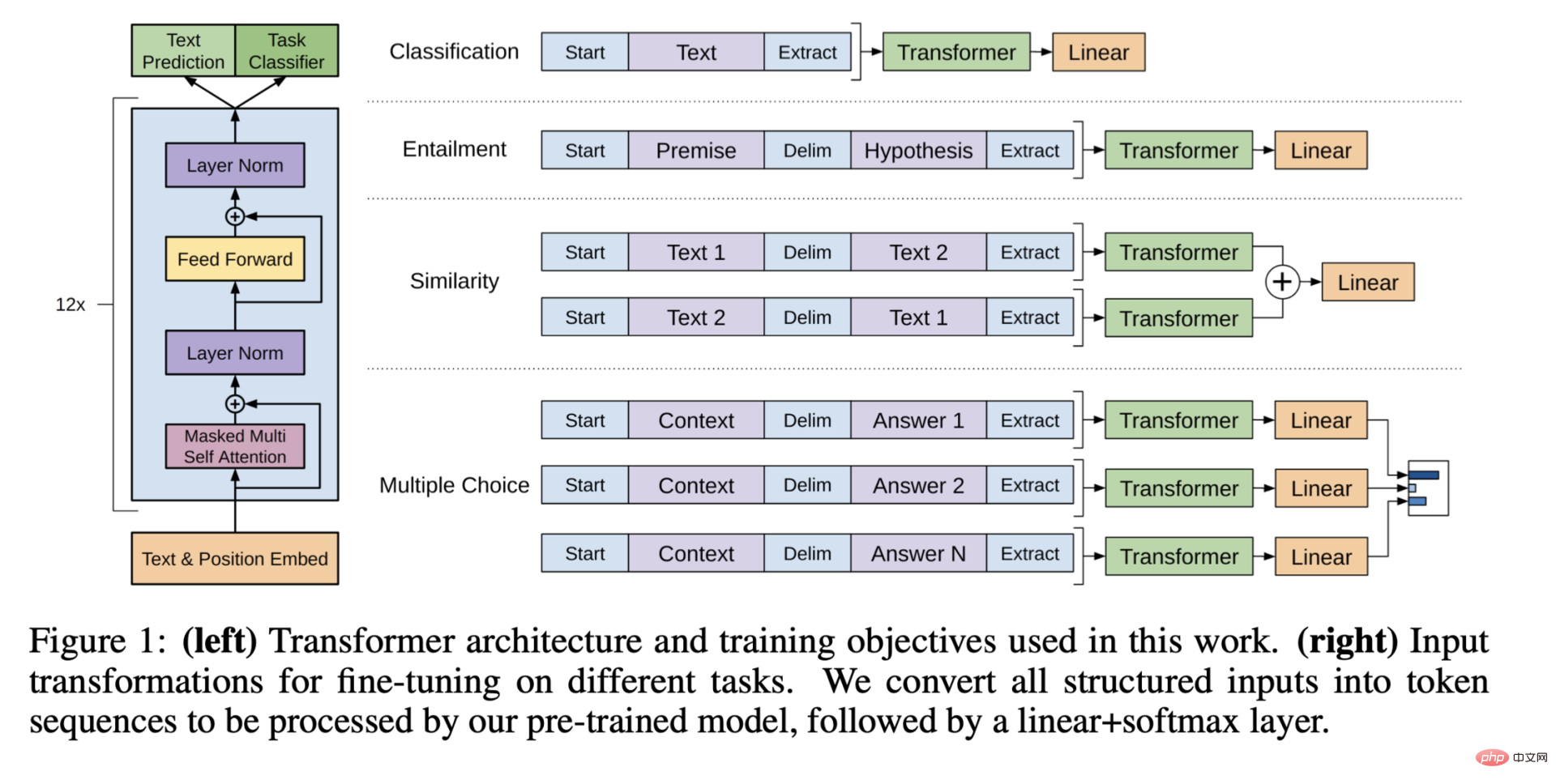

エンコーダー/デコーダー構造と同様に、トランスフォーマーは 2 つのコンポーネントで構成されますが、コンバーターはは、入力の各要素が他のすべての要素に焦点を合わせることができるセルフ アテンション メカニズムを使用し、要素間の距離に関係なく要素間の関係を捉えることができるという点で異なります。

Transformer はマルチヘッド アテンションも使用し、入力の複数の部分に同時に集中できるようにします。これにより、入力テキスト内の複雑な関係をキャプチャし、高精度の結果を生成できるようになります。

「必要なのは注意だけ」の論文が 2017 年に発表されたとき、トランスフォーマーは、より優れたパフォーマンスを達成できるため、自然言語処理の最先端のモデルとしてエンコーダー/デコーダー アーキテクチャに取って代わりました。長いテキスト、優れたパフォーマンス。

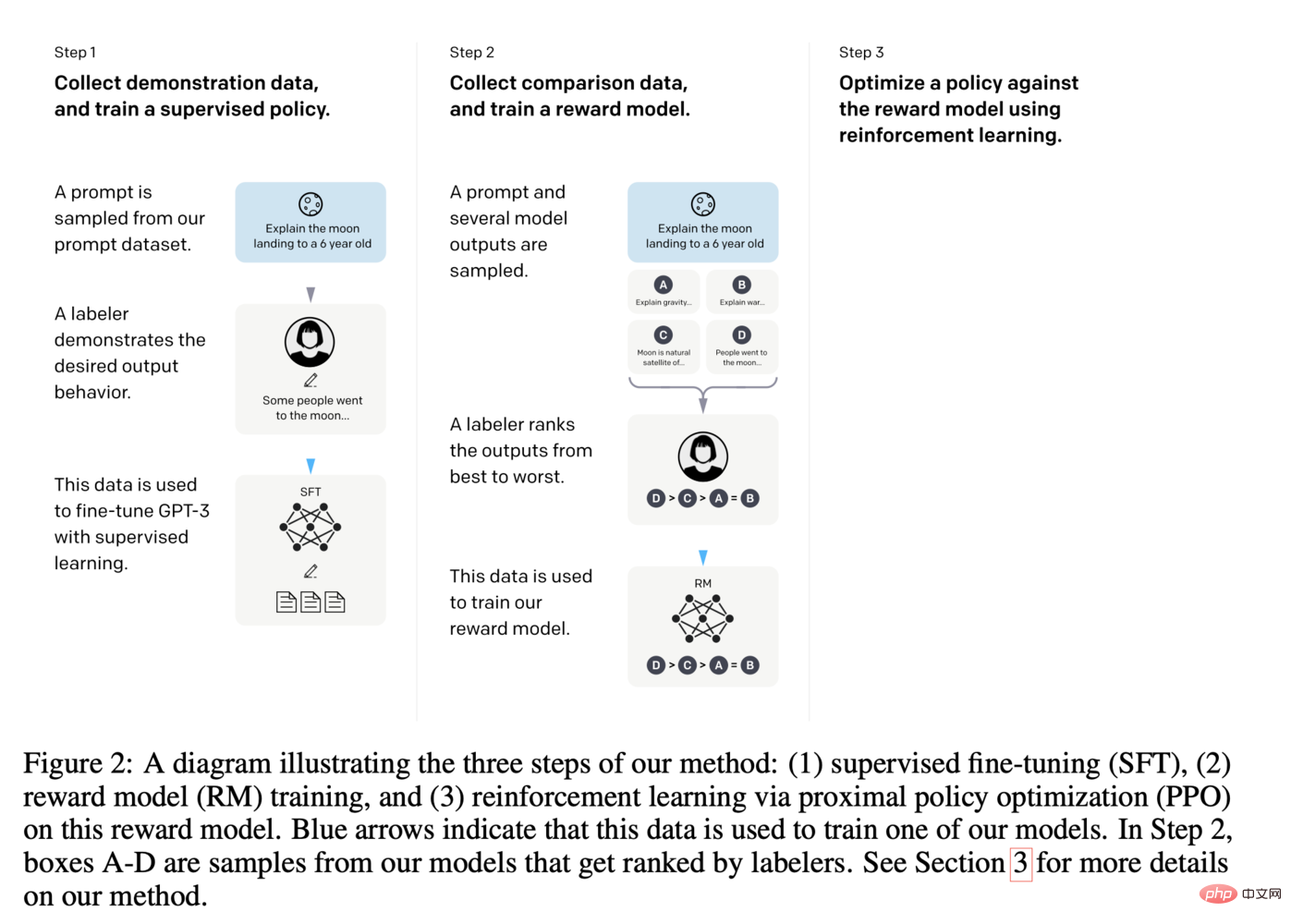

ChatGPT の例これは、チャットで質問に答えるというユースケースに合わせて GPT-3 モデルの最後の層を微調整することを意味し、人間によるタグ付けも活用しています。次の図は、ChatGPT の微調整をより詳細に理解するために役立ちます:

すべてをまとめる

今後 1 ~ 2 年で、この新しい実現テクノロジーによって大きな混乱が起こる可能性があります。

以上がAI 百科事典: ChatGPT の仕組みの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。