近年、敵対的生成ネットワーク (GAN) に基づく画像生成の研究が大きく進歩しました。高解像度でリアルな画像を生成できることに加えて、パーソナライズされた画像編集や画像アニメーションなど、多くの革新的なアプリケーションも登場しています。ただし、ビデオ生成に GAN を使用する方法は依然として難しい問題です。

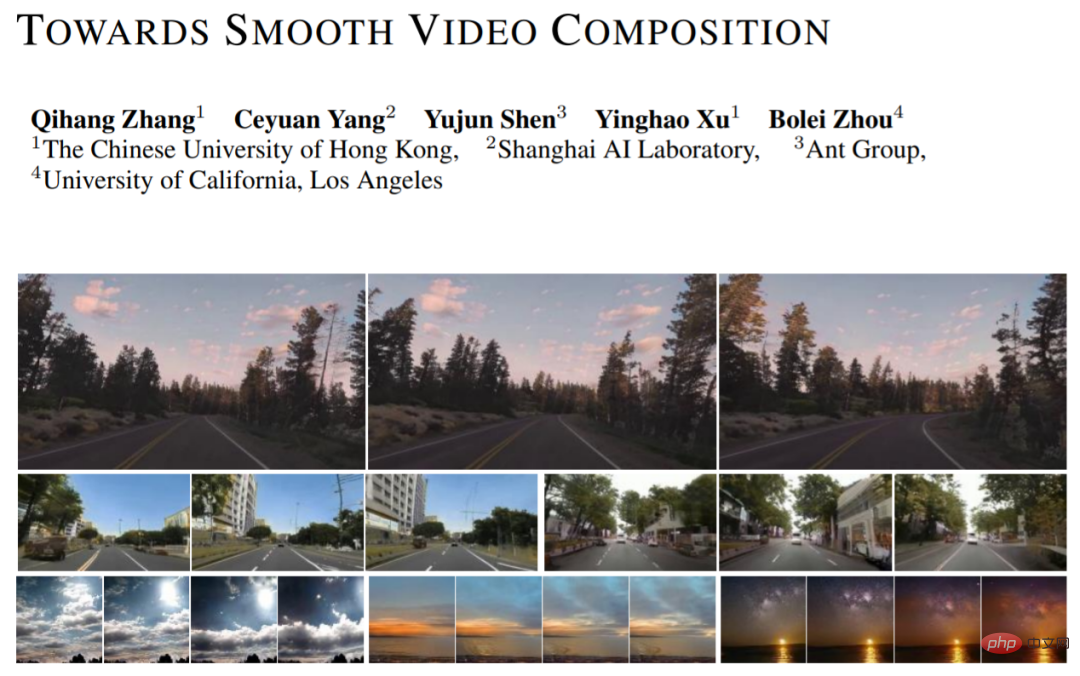

単一フレーム画像のモデリングに加えて、ビデオ生成では、複雑な時間的関係を学習する必要もあります。最近、香港中文大学、上海人工知能研究所、アントテクノロジー研究所、カリフォルニア大学ロサンゼルス校の研究者らは、新しいビデオ生成方法(スムーズなビデオ合成に向けて)を提案しました。この記事では、さまざまなスパン (短期範囲、中程度の範囲、長期範囲) のタイミング関係について詳細なモデリングと改善を実施し、以前の研究と比較して複数のデータセットで大幅な改善を達成しました。この研究は、GAN ベースのビデオ生成のためのシンプルかつ効果的な新しいベンチマークを提供します。

MoCoGAN、StyleGAN-V および他の作品は、これに基づいて分離された式を提案しています: I_i=G(u, v_i), i=[1,..., N],ここで、u はコンテンツを制御する確率変数を表し、v_i はアクションを制御する確率変数を表します。この表現では、すべてのフレームが同じコンテンツを共有し、独自のモーションを持つことがわかります。この分離された表現により、一貫したコンテンツ スタイルと変更可能なリアリズムを備えたアクション ビデオをより適切に生成できます。新作はStyleGAN-Vのデザインをベースラインとして採用しています。

ビデオ生成の難しさ: 時間的な関係を効果的かつ合理的にモデル化するにはどうすればよいでしょうか?

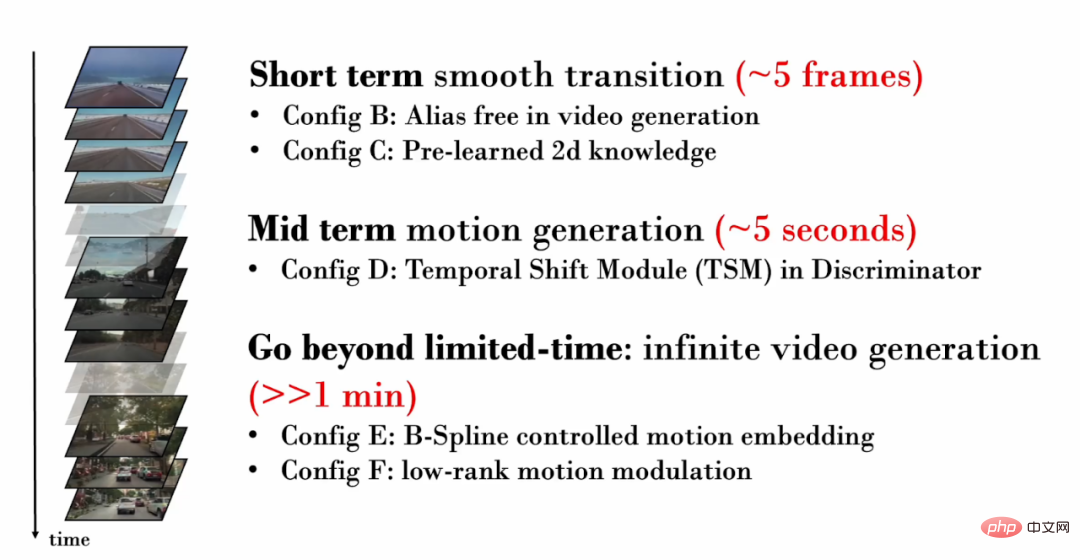

新しい作業では、さまざまなスパン (短距離、中距離、長距離) のタイミング関係に焦点を当て、それぞれ詳細なモデリングと改善を行っています。

1. 短期 (~5 フレーム) のタイミング関係

1. 短期 (~5 フレーム) のタイミング関係

#まず、フレームが少ない。これらの短いビデオ フレームには、非常に類似したコンテンツが含まれていることが多く、非常に微妙な動きしか表示されません。したがって、フレーム間の微妙な動きをリアルに生成することが重要です。ただし、StyleGAN-V で生成されたビデオでは深刻なテクスチャの固着が発生します。

#テクスチャの付着とは、生成されたコンテンツの一部が特定の座標に依存することを指します。一定の領域に「貼り付く」現象が発生します。画像生成の分野では、StyleGAN3 は詳細な信号処理やパディング範囲の拡大などにより、テクスチャの付着の問題を軽減します。この研究では、同じ技術がビデオ生成に依然として有効であることを検証しています。

#テクスチャの付着とは、生成されたコンテンツの一部が特定の座標に依存することを指します。一定の領域に「貼り付く」現象が発生します。画像生成の分野では、StyleGAN3 は詳細な信号処理やパディング範囲の拡大などにより、テクスチャの付着の問題を軽減します。この研究では、同じ技術がビデオ生成に依然として有効であることを検証しています。

以下の視覚化では、ビデオの各フレームの同じ位置にあるピクセルを追跡します。 StyleGAN-V ビデオでは、一部のコンテンツが固定座標に長時間「固定」され、時間が経っても動かず、そのため視覚化に「ブラシ現象」が発生していることが簡単にわかります。新しい作品によって生成されたビデオでは、すべてのピクセルが自然な動きを示します。

ただし、研究者らは、StyleGAN3 のバックボーンを参照すると画像生成の品質が低下することを発見しました。この問題を軽減するために、画像レベルの事前トレーニングが導入されました。事前トレーニング段階では、ネットワークはビデオ内の特定のフレームの生成品質を考慮するだけでよく、時間範囲のモデリングを学習する必要がないため、画像配信に関する知識を学習しやすくなります。

2. 中程度の長さ (約 5 秒) のタイミング関係

生成されたビデオにはより多くのフレームが含まれるため, より具体的なアクションを表示できるようになります。したがって、生成されたビデオに現実的な動きが含まれていることを確認することが重要です。たとえば、一人称運転ビデオを生成したい場合は、徐々に後退する地面と街路のシーンを生成し、近づいてくる車も自然な運転軌跡をたどる必要があります。

敵対的トレーニングでは、生成ネットワークが十分なトレーニング監視を受けることを保証するために、識別ネットワークが重要です。したがって、ビデオ生成では、生成ネットワークが現実的な動作を確実に生成できるようにするために、識別ネットワークは複数のフレームの時間的関係をモデル化し、生成された非現実的な動作をキャプチャする必要があります。ただし、以前の研究では、判別ネットワークは時間モデリングを実行するために単純な連結操作 (連結操作) のみを使用していました: y = cat (y_i)。ここで、y_i は単一フレームの特徴を表し、y は時間領域融合後の特徴を表します。

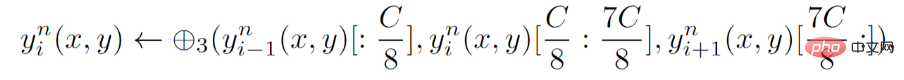

判別ネットワークについては、新しい研究では明示的なタイミング モデリング、つまり判別ネットワークの各層に時間シフト モジュール (TSM) を導入することを提案しています。 TSM は動作認識の分野に由来し、単純なシフト操作を通じて一時的な情報交換を実現します。

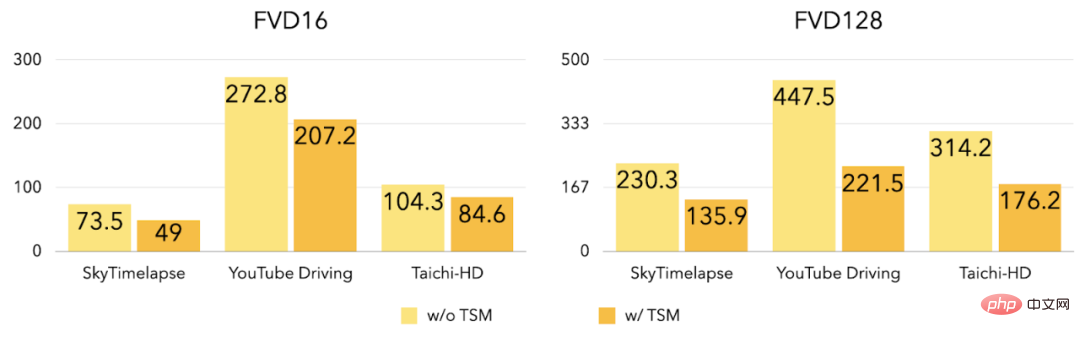

実験によると、TSM の導入後、3 つの FVD16 、データセット上の FVD128 は大幅に削減されました。

3. 無制限のビデオ生成

以前に導入された改良点は、短くて中程度の長さのビデオ生成に焦点を当てていましたが、新しい作業では、任意の長さ (無限長を含む) の高品質ビデオを生成する方法がさらに検討されています。以前の作業 (StyleGAN-V) は無限に長いビデオを生成できましたが、ビデオには非常に明らかな周期的なジッターが含まれていました:

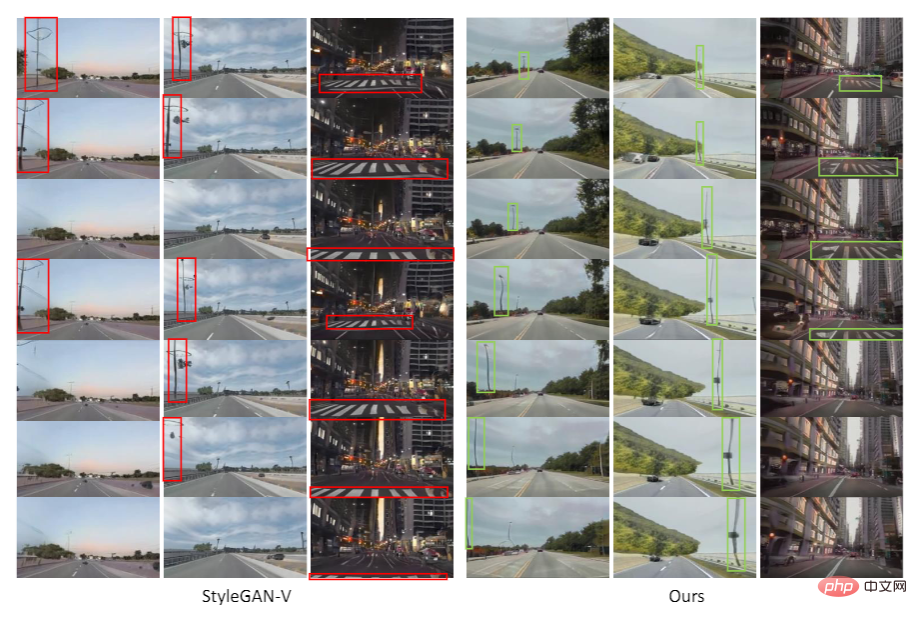

図に示すように、StyleGAN-V で生成されたビデオでは、車両が進行するにつれて、横断歩道は最初は正常に後退していましたが、突然前進するように変化しました。この研究では、モーション特徴の不連続性 (モーションの埋め込み) がこのジッター現象の原因であることが判明しました。

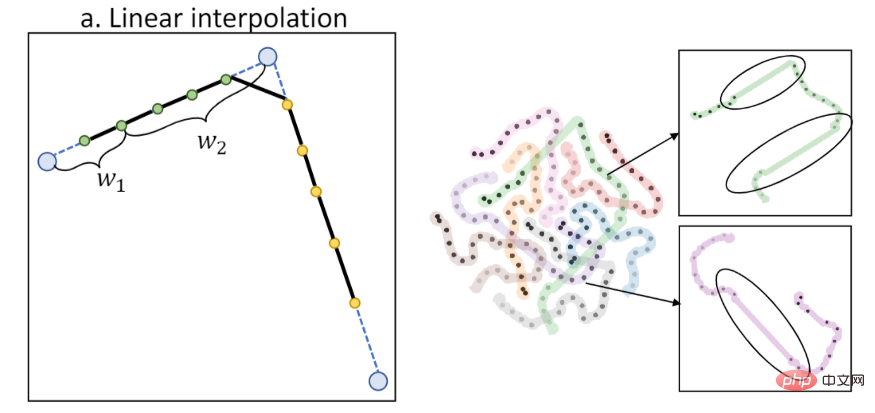

以前の研究では、アクション特徴を計算するために線形補間を使用していましたが、次の図に示すように、線形補間では一次不連続が生じます (左は補間図、左は補間図、右は T-SNE 機能) 可視化):

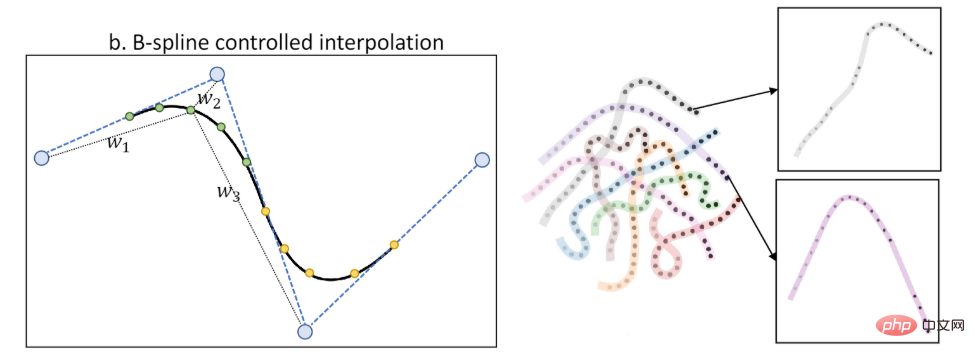

この研究は、B-スプライン制御のモーション特性を提案します (B-スプライン ベースのモーション埋め込み) )。 B スプラインによる補間により、図に示すように、時間に対してより滑らかなアクション特徴を得ることができます (左は補間図、右は T-SNE 特徴の視覚化):

B スプライン制御の動作特性を導入することにより、新しい作業ではジッター現象が軽減されます。

##図に示すように、StyleGAN-V で生成されたビデオでは、街路灯と地面が突然進行方向を変えます。新作によって生成されたビデオでは、動きの方向が一貫していて自然です。

同時に、新しい研究では、定期的に繰り返されるコンテンツの発生をさらに軽減するために、アクション機能に対する低ランクの制約も提案しています。

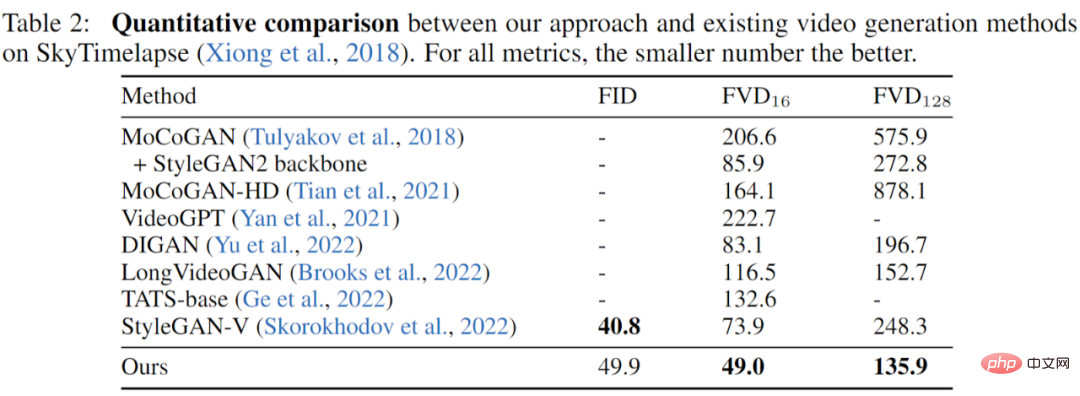

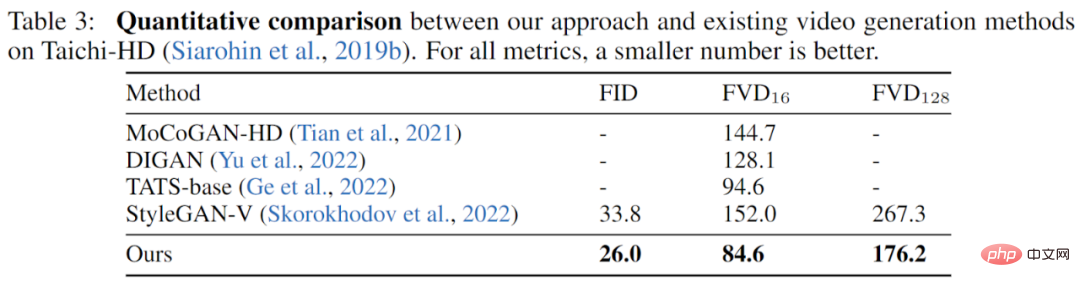

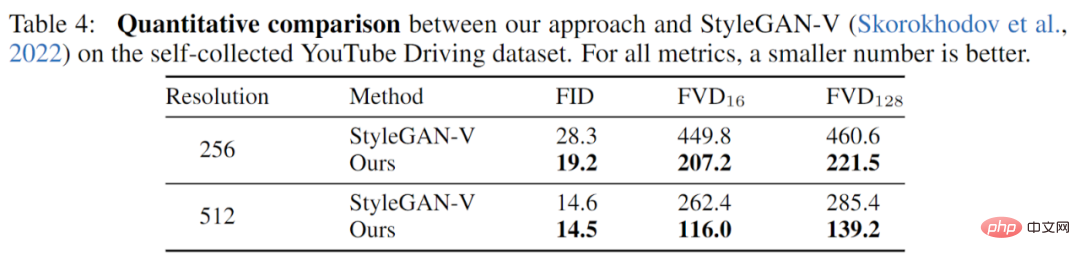

実験この作業は 3 つのデータセット (YouTube Driving、Timelapse、Taichi-HD) で完全に実験され、以前の研究と完全に比較されました。新しい作品では、画質 (FID) とビデオ品質 (FVD) が十分に向上しました。

#SkyTimelapse 実験結果:

#Taichi-HD 実験結果:

#Taichi-HD 実験結果:

##YouTube 走行実験結果:

##概要 新しい作品は GAN モデルに基づいています, 異なるスケールの時間的関係から出発して、新しいビデオ生成ベンチマークを提案し、斬新で効果的な改善を提案します。複数のデータセットでの実験により、新しい研究では以前の研究を大幅に上回るビデオ品質を達成することに成功したことが示されています。

新しい作品は GAN モデルに基づいています, 異なるスケールの時間的関係から出発して、新しいビデオ生成ベンチマークを提案し、斬新で効果的な改善を提案します。複数のデータセットでの実験により、新しい研究では以前の研究を大幅に上回るビデオ品質を達成することに成功したことが示されています。

以上がGAN に基づいて滑らかなビデオが生成され、その効果は非常に印象的です。テクスチャの付着がなく、ジッターが軽減されます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。