ChatGPT について話しているのですが、書き込まれている内容は区別できないほど現実的です? ######それは問題ではありません!

さあ、その「宿敵」が登場です—

ある中国人の男が、テキストが AI によって書かれたのか人間によって書かれたのかを識別するこのような Web サイトを作成しました。

対応するコンテンツを貼り付けるだけで、結果は数秒以内に分析されます。

それ:「やっぱりAIだった。」

このような魔法のツールは、登場するやいなや、たちまちすべての人の心を掴んだと言えるでしょう。

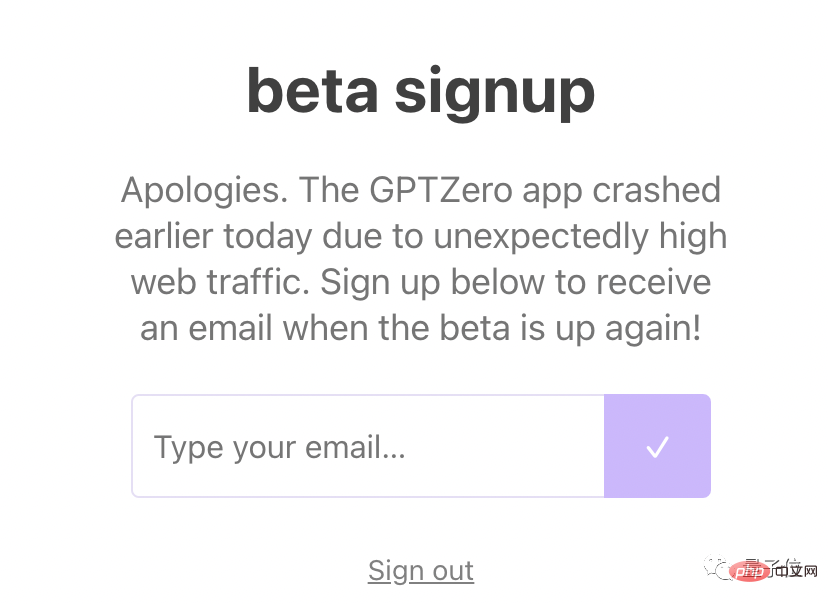

#いいえ、サーバーが直接クラッシュします (幸いなことに、予備のサーバーがあります)。

#いいえ、サーバーが直接クラッシュします (幸いなことに、予備のサーバーがあります)。

さて、ChatGPT を使って宿題をする「いたずらっ子」も被害を受けることになるでしょうか?

さて、ChatGPT を使って宿題をする「いたずらっ子」も被害を受けることになるでしょうか?

それは人間ですか、それとも ChatGPT ですか? GPTZero: 私の

それは人間ですか、それとも ChatGPT ですか? GPTZero: 私の

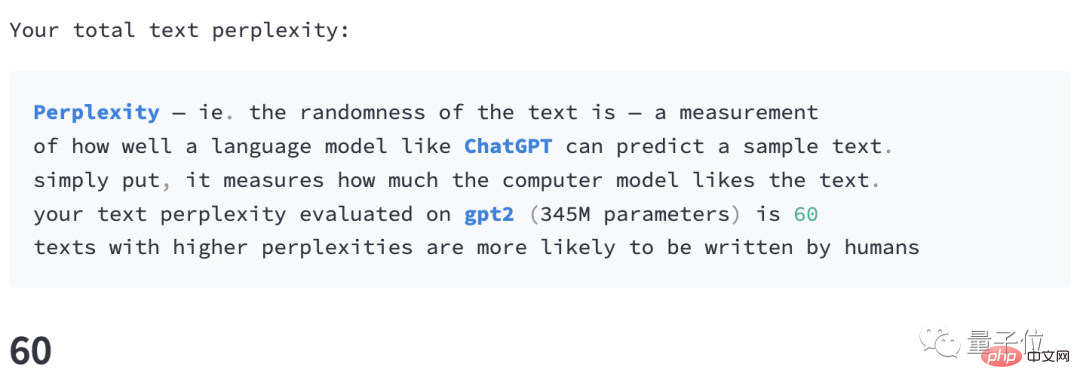

与えられたコンテンツを誰が書いたかを判断する指標として、主に「perplexity」、つまりテキストの「わかりにくさ」に依存します。

NLP 分野の友人は、この指標が言語モデルの品質を評価するために使用されていることを知っています。

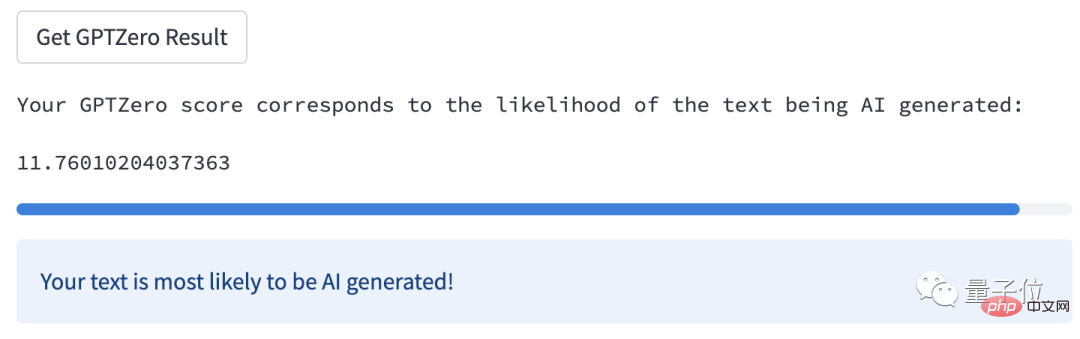

ここで、GPTZero にテスト コンテンツをフィードすると、それぞれ次の計算が行われます:

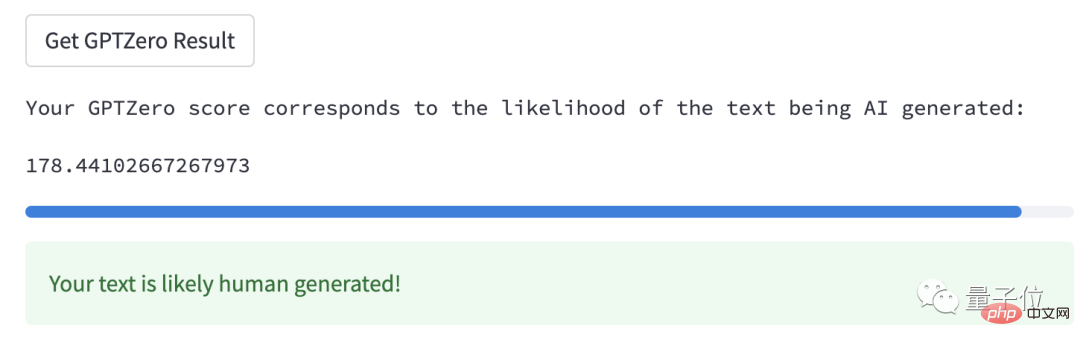

1. テキスト全体の混乱

この値が大きいほど、その可能性が高くなります。人間の手によって作られました。

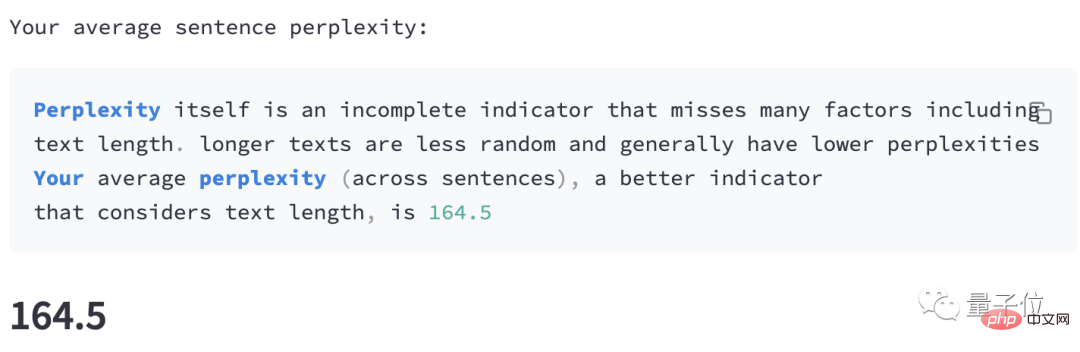

#2. すべての文の平均混乱度

#2. すべての文の平均混乱度

文が長くなるほど、通常、この値は低くなります。

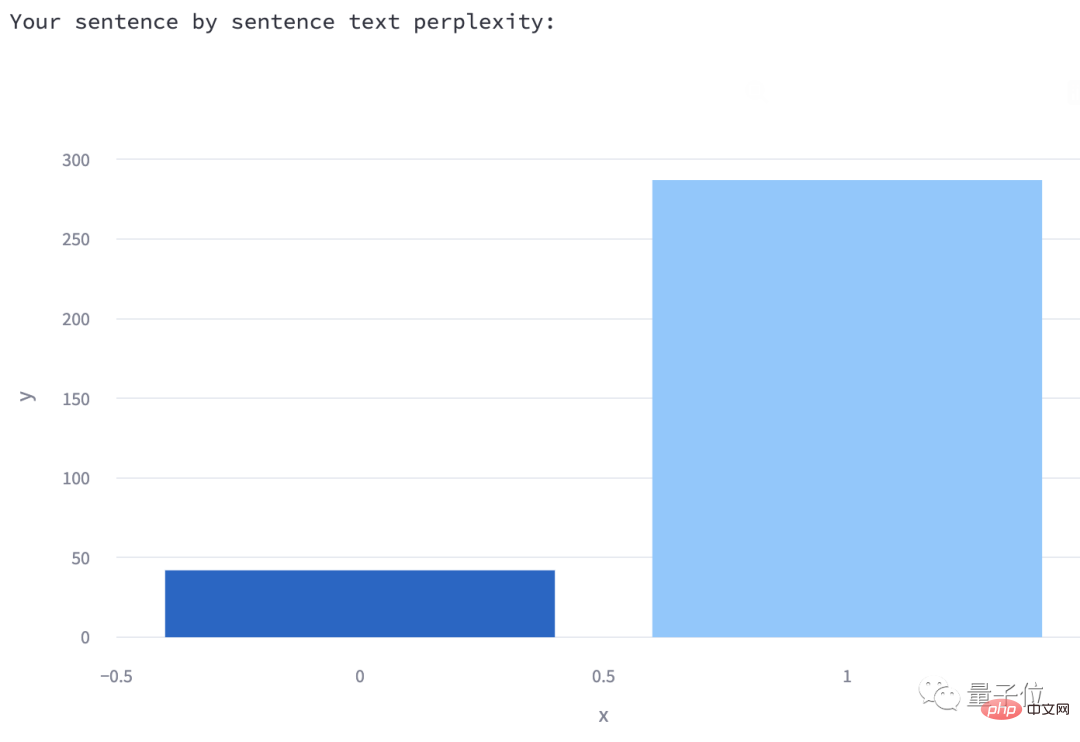

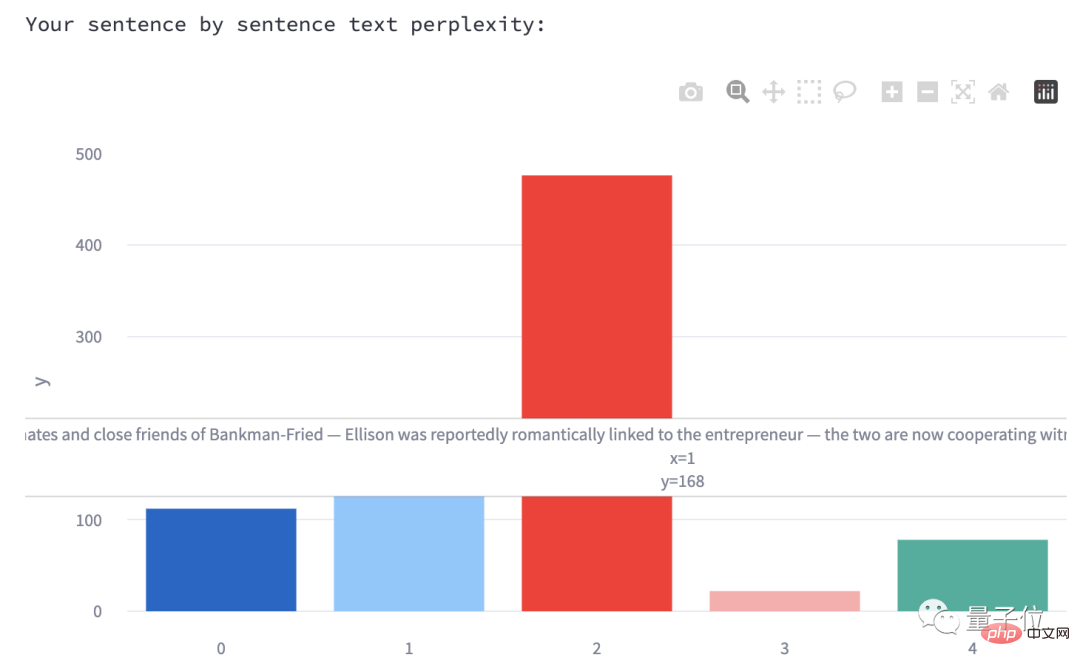

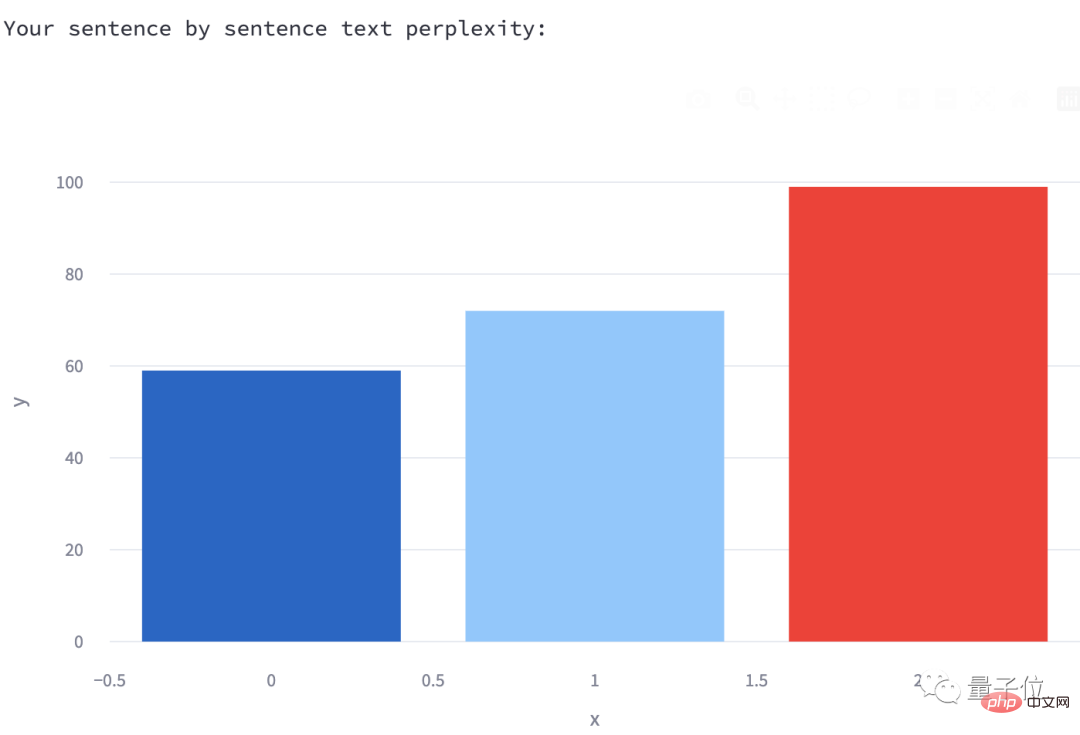

3. 各文の混乱レベル

3. 各文の混乱レベル

# は棒グラフの形式で表示されます。各ボックスの上にマウスを置くと、内容が表示されます。対応する文は. (今回入力したテスト内容は 2 文だけなので、ここには 2 つしかありません)。

著者は、このような棒グラフが描かれる理由についても説明しています:

著者は、このような棒グラフが描かれる理由についても説明しています:

# 以上がルールです。実技テストをしてみましょう。 テスト 1: 成功対照的に、機械生成されたテキストでは、困惑度は均等に分散され、常に低くなります。

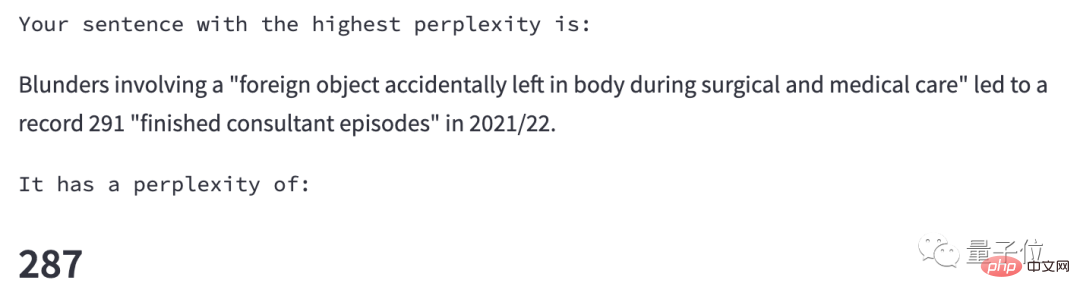

さらに、GPTZero は、混乱の程度が最も高い文 (つまり、最も人間らしい文) も選択します。

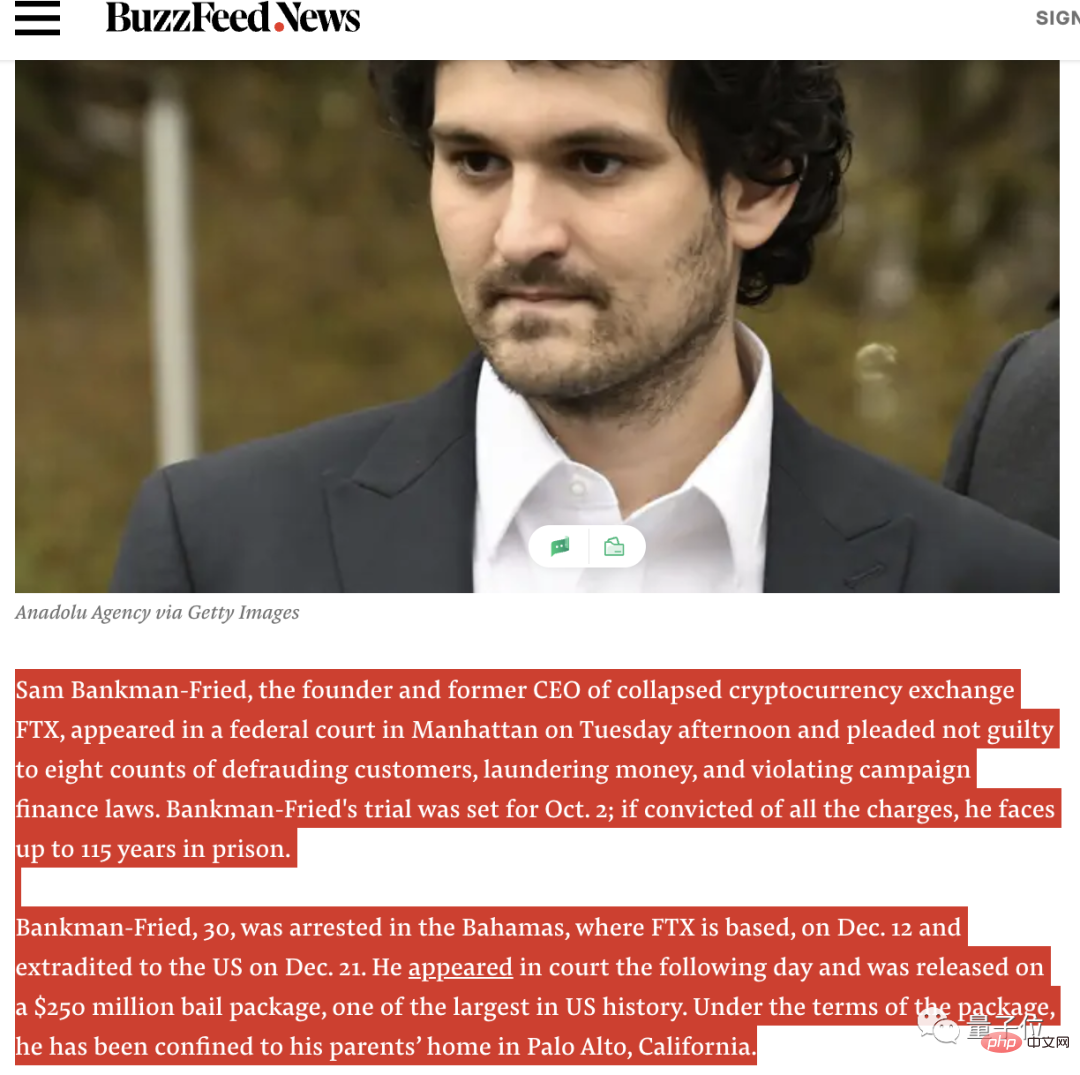

最初に最新の英語ニュースが表示されます (中国語は現在サポートされていません):

最初に最新の英語ニュースが表示されます (中国語は現在サポートされていません):

###############ビンゴ。

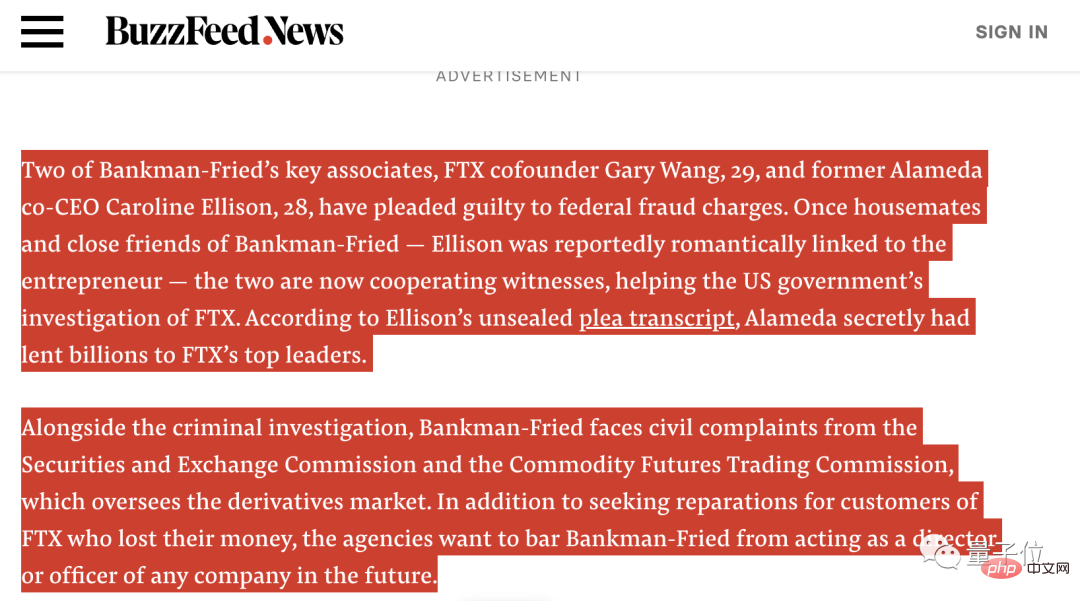

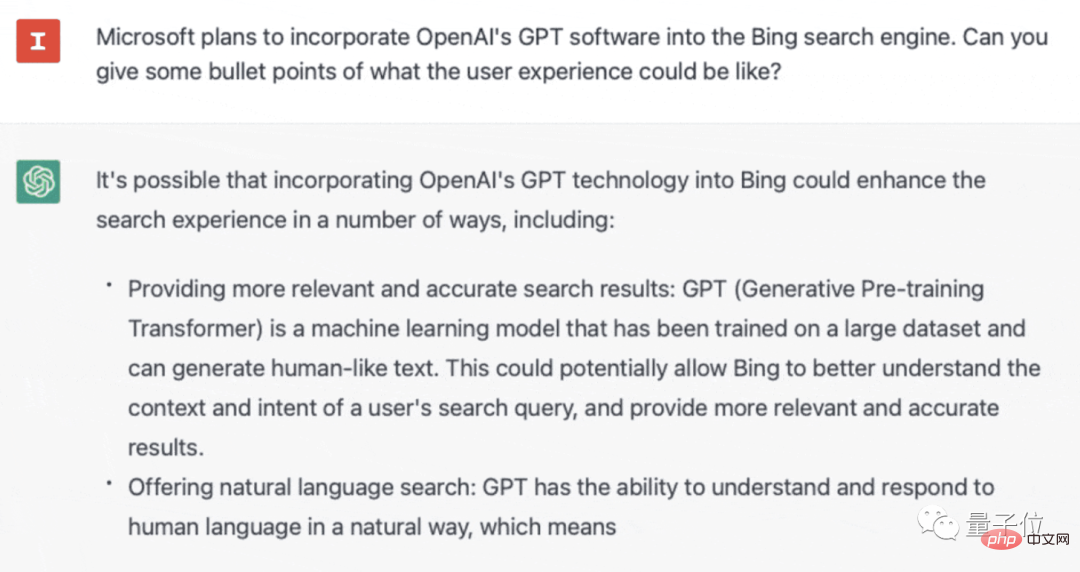

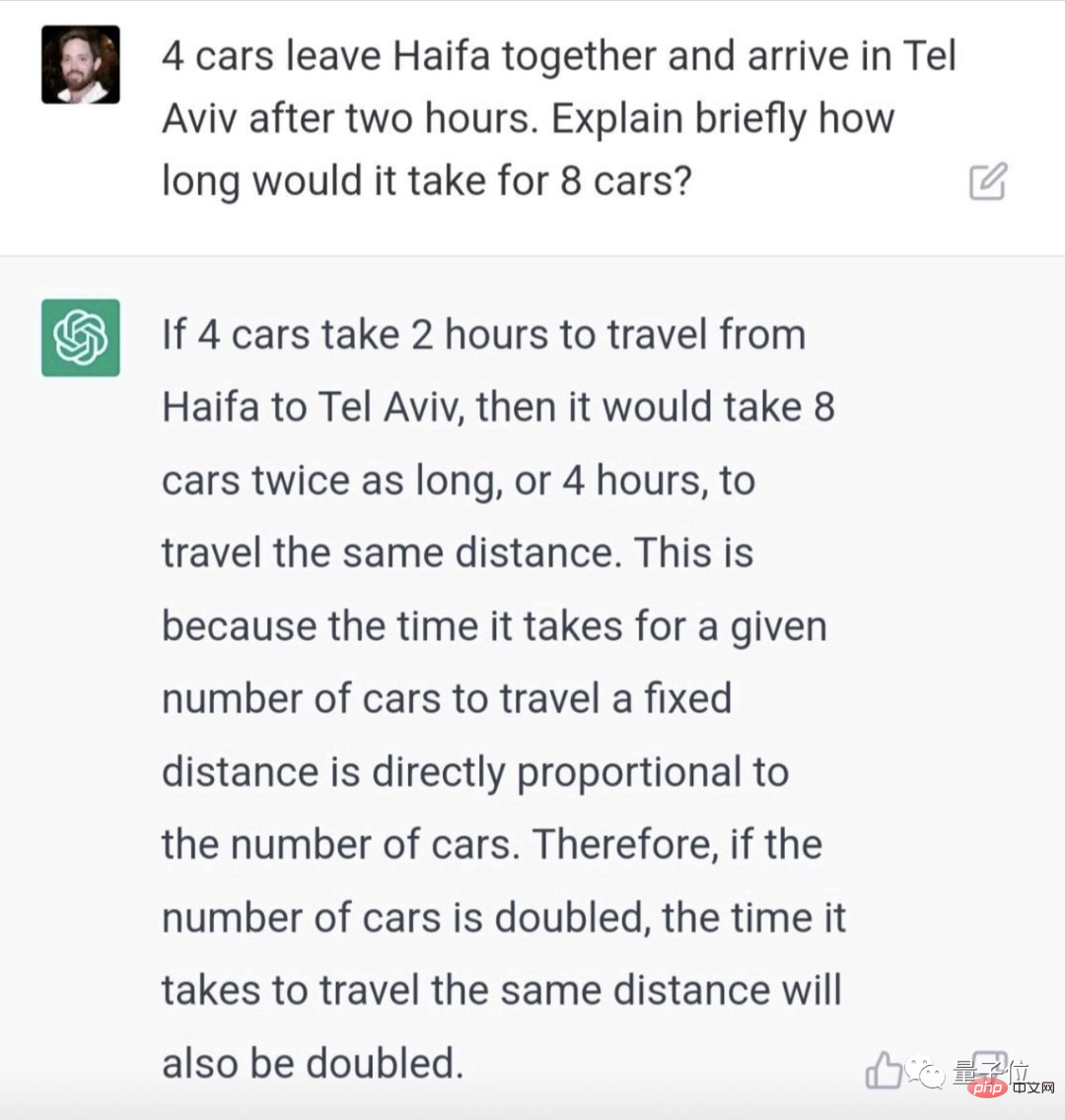

テスト 2: 失敗しました

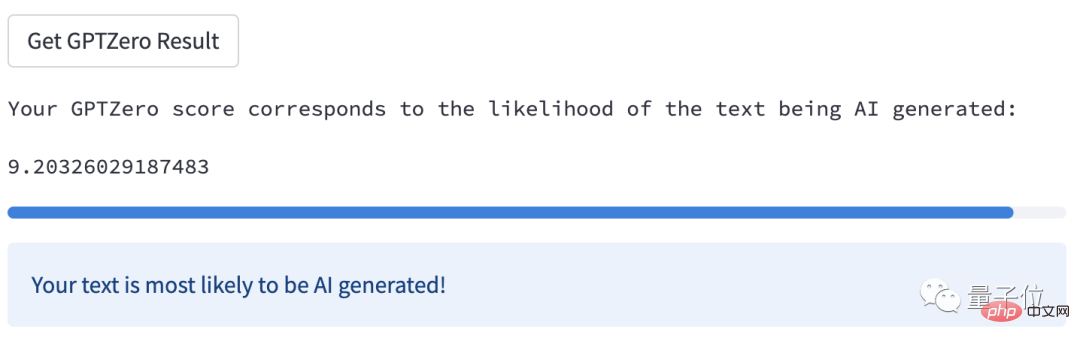

コンテンツをテスト ボックスに貼り付けると、この段落のテキストの混乱の合計は 31、文の混乱の平均は 76.67、各文の混乱グラフは長くなっています。このように:

となり、最も混乱が大きかった文の値は 99 になります。

それぞれの混乱値は上記とはかなり異なっているようですが、AIが書いたものであることが推測できるはずです。

明らかに、この段落には十分な単語がありますが、GPTZero が ChatGPT の「偽装」を一目で見破るには十分な文がありません。

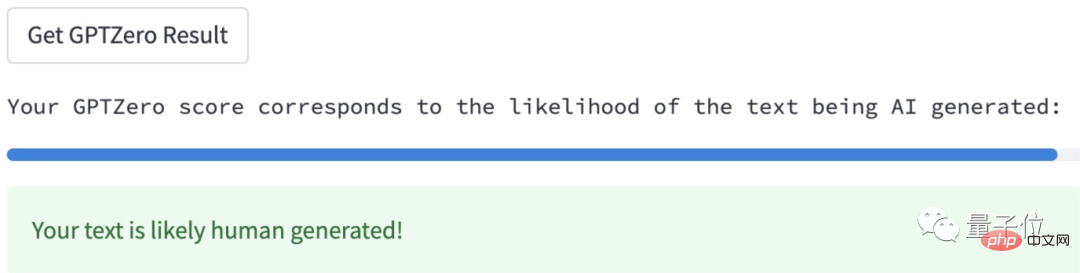

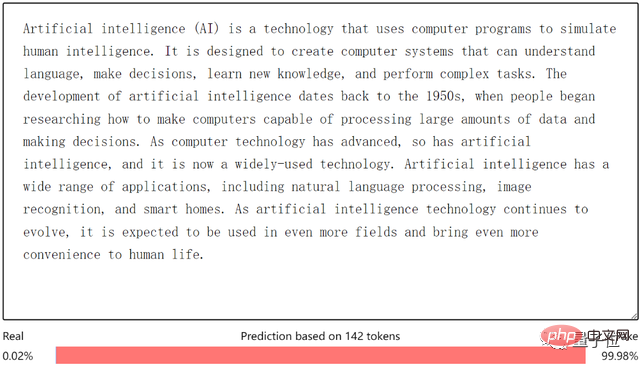

テスト 3: 成功

今回は内容も長く、文章量も十分です。

案の定、問題ありません。GPTZero は直接答えました:

彼は実際にいくつかのトリックを見つけたようです:

つまり、単語の数が多い一方で、GPTZero がヒストグラムの分布を通じて認識し、最終的な精度を向上させるためには、文の数も多く、少なくとも 5 文にする必要があります。

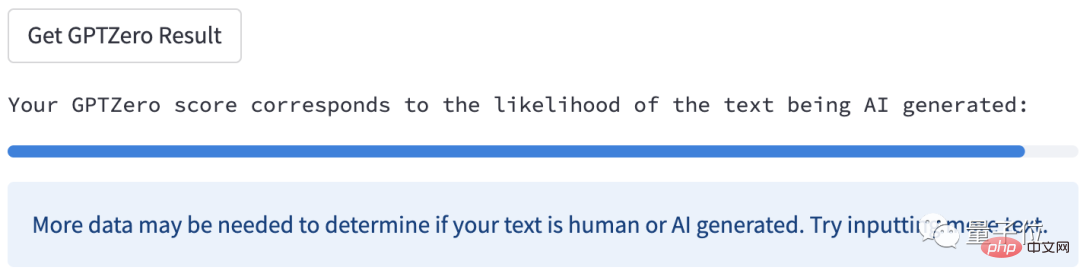

# 人間が書いたニュースを AI が判断する:

この場合、上記のヒントに従って、さらにコンテンツを追加すると結果が戻る可能性があります。

(可能性があることに注意してください。上記のニュースについては、すべての内容を貼り付けましたが、ノーと表示され、さらに要求されました。)

彼は現在 Microsoft でインターンとして働いており、BBC、Bellingcat、その他の企業向けに技術記事を執筆しており、地図ツール Representable の創設チームにも参加しています。

彼は在学中、4週間の都市研究セミナーに参加するために清華大学に来ました。

実際、ChatGPTを嫌っているのはこの男だけではありません。 AI テキスト検出器、別名 ChatGPT キラーを開発した人間の組織は他にもあります。

一般的な考え方は似ており、「魔法を使って魔法を倒す」というものであり、AI によって書かれたものを新しい AI のトレーニングに使用します。

少し前、OpenAI はハーバード大学や他の大学と協力して、GPT-2 Output Detector という検出器を共同作成しました。

著者らは、AI が「AI 言語」を理解できるようにするために、「GPT-2 で生成されたコンテンツ」と WebText (特に外国の投稿バーである Reddit から取得した) データ セットを最初にリリースしました。 「 」と「人間の音声」の違い。

その後、このデータセットを使用して RoBERTa モデルを微調整し、AI 検出器を取得しました。人間の音声は常に True として認識され、AI が生成したコンテンツは常に Fake として認識されます。

(RoBERTa は BERT の改良版です。オリジナルの BERT は 13GB のデータセットを使用していましたが、RoBERTa は 6,300 万件の英語ニュースを含む 160GB のデータセットを使用しました。)

もう 1 つ 代表的なプレーヤーこの新たな展開により、初期の頃のことも再び言及されました。

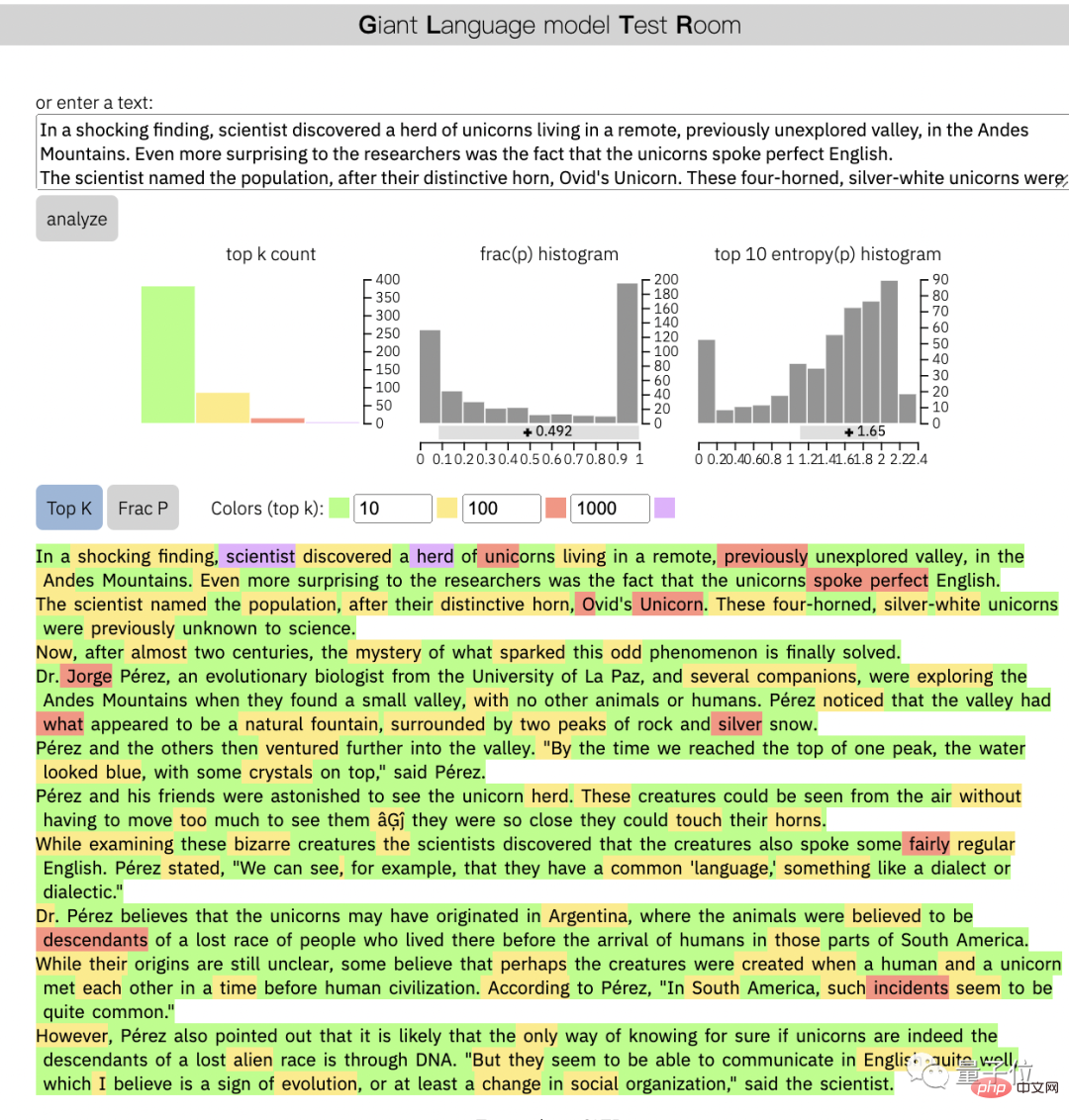

MIT-IBM Watson AI Laboratory と Harvard NLP Laboratory によって開発された GLTR モデルです。

主にテキストの統計分析と視覚化を実行し、元々テキストの生成に使用されたものと同じまたは類似のモデルを検出するために使用されます。現在、主に GPT-2 と BERT の 2 つのモデルをサポートしています。

出力はモデルが認識しているすべての単語のランキングであるため、テキストの各単語はランキングに従って色分けされます。上位 10 は緑色、上位 100 は黄色、上位 1000 は赤、紫はあまり良くない、という言葉が考えられます。

テキストに黄緑色が多すぎる場合、このテキストは主に AI によって生成されています。

今回も GPTZero が登場し、多くのネチズンが「信じられないほど素晴らしい作品だ!」と叫びました。

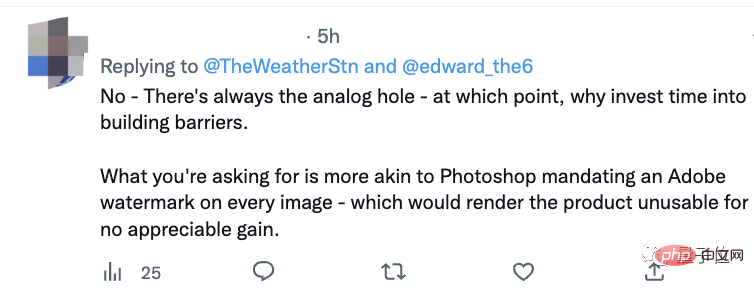

しかし、テキスト検出器は単なる軍拡競争の失敗であり、実際の結果は良くないと言う人もいます。 ChatGPT の開発を止めることはできません。

#同時に、一部のネットユーザーは「記事がAIによって書かれたのか、それとも人間によって書かれたのかを明確に示す必要があるか」の必要性について議論した。

ソングライターはこれが必要であると信じています。雑誌を読むときに「広告」とマークされるのと同じで、これは単純な要件であるはずです。

しかし、一部のネチズンはすぐに反対を表明しました。これは、PS を使用してから Adobe ウォーターマークを追加するようなもので、製品には何のメリットもありません。

この問題についてどう思いますか?

トライアルリンク:

https://etedward-gptzero-main-zqgfwb.streamlit.app/

参考リンク:

[1 ] https://brackets.substack.com/about

[2]https://www.reddit.com/r/programming/comments/102hxlg/gptzero_an_app_to_efficiently_tell_if_an_essay_is/

[3] https ://twitter.com/Marc__Watkins/status/1601746409203863553

[4]http://gltr.io/

以上がChatGPT の「宿敵」が登場!記事の作者は人間ですか、それとも AI ですか? それを検出するのに数秒かかりました。中国人の男が正月休み中にそれを完了しました。サーバーはすでに過密状態でした。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。