継続学習とは、以前のタスクから得た知識を忘れることなく、多数のタスクを順番に学習するモデルを指します。教師あり学習では、機械学習モデルが特定のデータセットまたはデータ分布に対して最適な関数になるようにトレーニングされるため、これは重要な概念です。実際の環境では、データが静的であることはほとんどなく、変化する可能性があります。一般的な ML モデルは、目に見えないデータに直面するとパフォーマンスが低下する可能性があります。この現象は壊滅的忘却と呼ばれます。

#このタイプの問題を解決する一般的な方法は、古いデータと新しいデータの両方を含む新しい、より大きなデータセットでモデル全体を再トレーニングすることです。しかし、このアプローチにはコストがかかることがよくあります。この問題を調査している ML 研究分野があり、この分野の研究に基づいて、この記事では、古いデータのパフォーマンスを維持しながらモデルを新しいデータに適応させ、データの劣化を回避する 6 つの方法について説明します。データセット全体でトレーニングする必要があります (古い新しい) 再トレーニング。

プロンプト このアイデアは、GPT 3 のヒント (短い単語のシーケンス) がモデルをより適切に推論し、回答するのに役立つという考えから生まれました。したがって、この記事では Prompt をプロンプトと訳します。ヒント チューニングとは、学習可能な小さなヒントを使用し、それらを実際の入力とともにモデルへの入力としてフィードすることを指します。これにより、モデルの重みを再トレーニングすることなく、新しいデータに関するヒントを提供する小さなモデルのみをトレーニングすることができます。

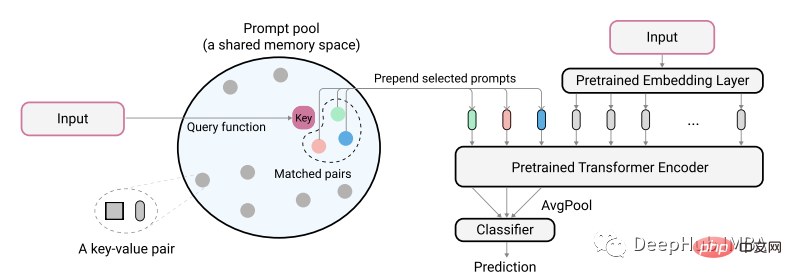

具体的には、Wang の記事「継続的学習のためのプロンプトの学習」から引用した、テキストベースの集中的な検索にプロンプトを使用する例を選択しました。

論文の著者は、次の図を使用して自分たちのアイデアを説明しています。

実際のエンコードされたテキスト入力は、プロンプトから最小一致ペアを識別するために使用されます。プールの鍵。これらの識別されたキューは、モデルにフィードされる前に、まずエンコードされていないテキスト埋め込みに追加されます。この目的は、古いモデルを変更せずに、新しいタスクを表すようにこれらのキューをトレーニングすることです。ここでのキューは非常に小さく、おそらくプロンプトあたりわずか 20 トークンです。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 |

|

次に、トレーニング済みの古いデータ モデルを使用して新しいデータをトレーニングします。ここでは、プロンプト部分の重みのみをトレーニングします。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 |

|

トレーニングが完了したら、後続の推論プロセスで入力と取得したヒントを組み合わせる必要があります。たとえば、この例のパフォーマンスは、新しいデータ ヒント プールでは -93%、完全な (新旧) トレーニングでは -94% でした。これは元の論文で言及されているパフォーマンスと同様です。ただし、注意点としては、結果はタスクによって異なる可能性があるため、何が最も効果的かを知るために実験を試みる必要があるということです。

この方法を検討する価値があるためには、古いデータで古いモデルのパフォーマンスの 80% を超えるパフォーマンスを維持できなければなりません。また、ヒントは、モデルが新しいデータで良好なパフォーマンスを達成するのにも役立つはずです。

この方法の欠点は、ヒント プールの使用が必要であり、余分な時間がかかることです。これは恒久的な解決策ではありませんが、現時点では実行可能であり、将来的には新しい方法が登場する可能性があります。

知識蒸留という用語を聞いたことがあるかもしれません。これは、教師モデルの重みを使用して、より小規模なモデルをガイドおよびトレーニングする手法です。データ蒸留も同様に機能し、実際のデータからの重みを使用してデータのより小さなサブセットをトレーニングします。データ セットの主要な信号は洗練され、より小さなデータ セットに凝縮されるため、新しいデータでのトレーニングには、古いパフォーマンスを維持するためにいくつかの洗練されたデータを提供するだけで済みます。

この例では、データ蒸留を高密度検索 (テキスト) タスクに適用します。現在、この分野でこの方法を使用している人は他にいないため、結果は最良ではない可能性がありますが、テキスト分類にこの方法を使用すると、良い結果が得られるはずです。

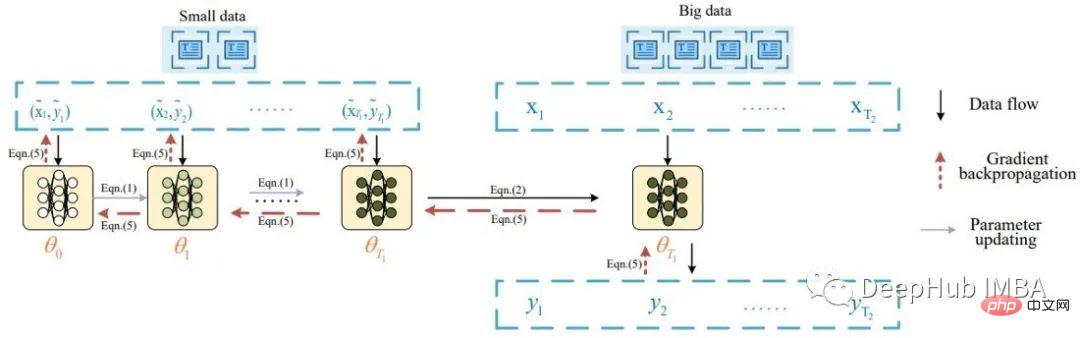

本質的に、テキスト データ蒸留のアイデアは、Li による「テキスト分類のためのデータ蒸留」という論文から生まれました。この論文は、Wang が画像データを蒸留したデータセット蒸留にインスピレーションを受けています。 Li は、テキスト データの蒸留のタスクを次の図で説明しています。

論文によると、最初に蒸留されたデータのバッチがモデルに供給され、その重みが更新されます。次に、更新されたモデルが実際のデータを使用して評価され、信号が蒸留されたデータセットに逆伝播されます。この論文では、8 つの公開ベンチマーク データセットに関する良好な分類結果 (精度 >80%) が報告されています。

提案されたアイデアに従って、いくつかの小さな変更を加え、抽出されたデータのバッチと複数の実データを使用しました。以下は、集中検索トレーニング用の抽出データを作成するコードです。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 |

|

これは、抽出データに信号を抽出するコードです。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 |

|

ここでは、データのロードなどのコードは省略しています。そして、抽出されたデータがトレーニングされます。最後に、その上で新しいモデルをトレーニングすることによって、たとえば新しいデータと一緒にトレーニングすることによって、それを使用できます。

私の実験によると、蒸留データ (ラベルあたり 4 つのサンプルのみを含む) でトレーニングされたモデルは 66% の最高のパフォーマンスを達成しましたが、完全に生データでトレーニングされたモデルも 66% の最高のパフォーマンスを達成しました。トレーニングされていない通常のモデルは 45% のパフォーマンスを達成しました。上で述べたように、これらの数値は集中的な検索タスクには適さない可能性がありますが、カテゴリ データでははるかに優れています。

新しいデータに合わせてモデルを調整するときにこの方法が役立つためには、元のデータよりもはるかに小さいデータセット (つまり、~1%) を抽出できる必要があります。洗練されたデータでは、アクティブ ラーニング手法と比較してわずかに低いか同等のパフォーマンスが得られる場合もあります。

この方法の利点は、永続的に使用できる抽出データを作成できることです。欠点は、抽出されたデータが解釈できないため、追加のトレーニング時間が必要になることです。

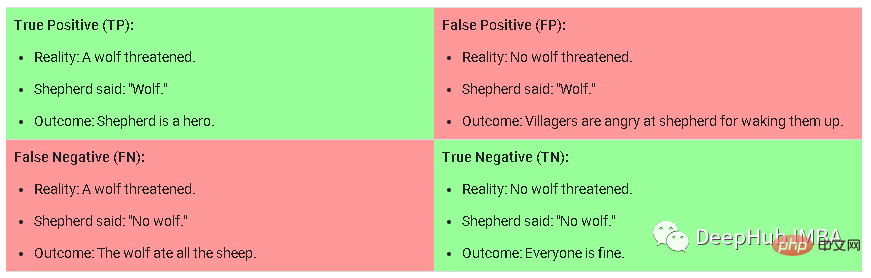

カリキュラム トレーニングは、トレーニング中にモデルにトレーニング サンプルを提供することがますます困難になる方法です。新しいデータでトレーニングする場合、この方法ではタスクに手動でラベルを付け、タスクを簡単、中程度、または困難に分類してからデータをサンプリングする必要があります。モデルが簡単、中程度、または難しいという意味を理解するために、次の図を例として取り上げます。

これは、分類タスクの混同行列です。ハード サンプルは偽陽性 (False Positive) とは、モデルが True である可能性が非常に高いと予測しているものの、実際には True ではないサンプルを指します。中サンプルとは、正しい確率が中から高であるものの、予測しきい値を下回る真陰性のサンプルです。単純なサンプルとは、真陽性/陰性の可能性が低いサンプルです。

これは、「最大干渉検索によるオンライン継続学習」というタイトルの論文 (1908.04742) で Rahaf によって紹介された方法です。主な考え方は、トレーニングされるデータの新しいバッチごとに、新しいデータのモデルの重みを更新する場合、損失値の点で最も影響を受ける古いサンプルを特定する必要があるということです。古いデータで構成される限られたサイズのメモリが保持され、最も問題となるサンプルが新しいデータ バッチごとに取得され、一緒にトレーニングされます。

この論文は継続学習の分野で定評のある論文であり、多くの引用があるため、あなたのケースにも当てはまるかもしれません。

検索拡張 (検索拡張) は、コレクションから項目を取得することによって入力やサンプルなどを拡張する技術を指します。これは、特定のテクノロジーではなく一般的な概念です。これまで説明してきたメソッドのほとんどは、ある程度の取得関連の操作です。 Izacard の論文「検索拡張言語モデルによる少数ショット学習」では、小規模なモデルを使用して少数ショット学習で優れたパフォーマンスを実現しています。検索の強化は、単語の生成や事実に関する質問への回答など、他の多くの状況でも使用されます。

モデルを拡張する最も一般的かつ簡単な方法は、トレーニング中に追加のレイヤーを使用することですが、必ずしも効果的であるとは限らないため、ここでは詳しく説明しません。ここでの例は、Lewis の Efficient Few-Shot です。プロンプトのない学習。多くの場合、追加のレイヤーを使用するのが、古いデータと新しいデータで優れたパフォーマンスを得る最も簡単ですが、十分に試行された方法です。主なアイデアは、モデルの重みを固定し、分類損失を伴う新しいデータで 1 つまたは複数のレイヤーをトレーニングすることです。

まとめ この記事では、新しいデータでモデルをトレーニングするときに使用できる 6 つの方法を紹介しました。いつものように、どの方法が最も効果的かを実験して決定する必要がありますが、上で説明した方法以外にも多くの方法があることに注意することが重要です。たとえば、データ蒸留はコンピューター ビジョンの活発な分野であり、それについては論文でたくさん見つけることができます。 。最後の注意: これらのメソッドが価値があるためには、古いデータと新しいデータの両方で良好なパフォーマンスを達成する必要があります。

以上が継続学習の 6 つの一般的な方法の概要: 古いデータのパフォーマンスを維持しながら、ML モデルを新しいデータに適応させるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。