最近、リー・フェイフェイ率いるスタンフォードHAI研究所は、「生成AI」に関する展望レポートを発表しました。

#レポートは、現在の生成人工知能のほとんどが基本モデルによって駆動されていると指摘しています。

これらのモデルが私たちの生活、コミュニティ、社会にもたらす機会は膨大ですが、リスクも同様です。

#一方、生成的AI は人間の生産性と創造性を高めることができます。その一方で、社会的な偏見を増幅させ、情報に対する私たちの信頼を損なうことさえあります。

#これらのテクノロジーが私たち全員に利益をもたらすためには、分野を超えたコラボレーションが不可欠であると信じています。 「生成人工知能」が自分たちの分野と私たちの世界にどのような影響を与えるかについて、医学、科学、工学、人文科学、社会科学の分野のリーダーが語るべきことを以下に示します。

#この記事では、現在の生成 AI に関する Li Feifei と Percy Liang の洞察を選択しました。

意見レポートの全文については、

## https://hai をご覧ください。 .stanford .edu/generative-ai-perspectives-stanford-hai リー フェイフェイ: 人工知能の大きな転換点

リースタンフォードHAIの共同所長であるフェイフェイ氏は、「人工知能の大きな転換点」というメッセージを投稿した。

1966 年、MIT の研究者たちは、テクノロジーを使用して視覚システムを効果的に構築することを目的とした「サマー ビジョン プロジェクト」を立ち上げました。これがコンピュータ ビジョンと画像生成の分野における研究の始まりでした。

最近、ディープラーニングとビッグデータの密接な関係のおかげで、人々は重要な転換点に達しているようです。それは、機械がデータを生成できるようになろうとしています。言語、画像、オーディオなどの機能。

コンピューター ビジョンは、人間が認識できることを認識できる AI の構築に触発されましたが、この分野の目標は現在、それをはるかに超えています。未来に建設されるものは、人間には見えないものを見る必要があります。

#生成人工知能を使用して人間の視覚を強化するにはどうすればよいですか?

##たとえば、医療過誤による死亡は米国では憂慮すべき問題です。生成 AI は、医療提供者が潜在的な問題を認識するのに役立ちます。

まれな状況でエラーが発生した場合、生成 AI は同様のデータのシミュレートされたバージョンを作成して、AI モデルをさらにトレーニングしたり、医療従事者にトレーニングを提供したりできます。

#

新しい生成ツールの開発を開始する前に、人々がそのツールから何を得たいかに焦点を当てる必要があります。

#ロボット タスクのベンチマークを行う最近のプロジェクトでは、研究チームは作業を開始する前に大規模なユーザー調査を実施し、人々に作業量がどのくらいか尋ねました。ロボットが特定のタスクを完了することで利益を得ることができ、人間に最も利益をもたらすタスクがプロジェクトの焦点になりました。

#生成 AI によって生み出される大きな機会をつかむには、関連するリスクも適切に評価する必要があります。

ジョイ・ブオラムウィニ氏は、「Shades of Gender」と呼ばれる研究を主導し、AIが女性と有色人種の識別に問題を抱えていることが多いことを発見しました。過小評価されているグループに対する同様の偏見は、生成 AI にも今後も現れ続けるでしょう。

#画像が AI を使用して生成されたかどうかを判断することも非常に重要な能力です。人間社会は市民権への信頼の上に成り立っており、この能力がなければ信頼感は低下してしまいます。

#機械生成機能の進歩は、人間には見えないものを AI が認識できる可能性と同様に、非常にエキサイティングです。

#ただし、これらの機能が私たちの日常生活、環境、地球市民としての役割をどのように混乱させる可能性があるかに注意を払う必要があります。

パーシー・リャン: 「新カンブリア紀: 科学の興奮と不安」人間中心人工知能研究所所長スタンフォード大学、コンピューターサイエンス准教授の Percy Liang 氏が「新カンブリア紀: 科学の興奮と不安」という記事を発表しました

# #人類の歴史において、新しいものを生み出すことは常に困難であり、その能力はほぼ専門家のみが持っています。

#しかし、最近の基礎モデルの進歩により、人工知能の「カンブリア爆発」が起こり、人工知能はあらゆるものを作り出すことができるようになります。ビデオからプロテイン、そしてコードまで。

#この能力は創造の敷居を下げますが、現実を識別する能力も奪います。

#ディープ ニューラル ネットワークと自己教師あり学習に基づく基本モデルは、何十年も前から存在しています。しかし、最近では、これらのモデルをトレーニングできる膨大な量のデータにより、モデルの機能が急速に進歩しています。

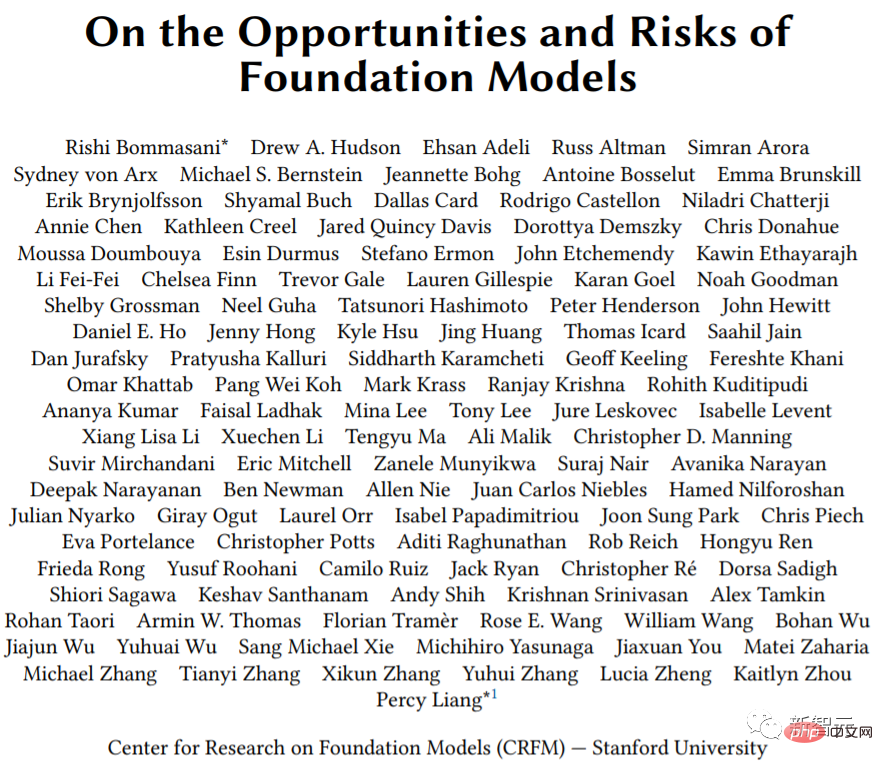

2021 年に発表された論文では、基礎となるモデルの機会とリスクが詳しく説明されており、これらの新たな機能は「科学コミュニティにとって興奮の源」となるでしょう。 「意図せぬ結果」を招く可能性もあります。

#

對基礎模型進行基準測試也是十分重要的,以便研究人員更了解其能力與缺陷,並制定更合理的發展策略。

HELM(語言模型的整體評估)的發展就是為了這個目的。 HELM以準確性、穩健性、公平性等多種指標,對30多個著名的語言模型在一系列場景中的表現做出了評估。

新的模型、新的應用程式場景和新的評價指標還會出現,我們歡迎大家為HELM的發展添磚加瓦。

#以上がAIGC|Stanford HAI Viewpoint Report について、Li Feifei は次のような見解を示していますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。