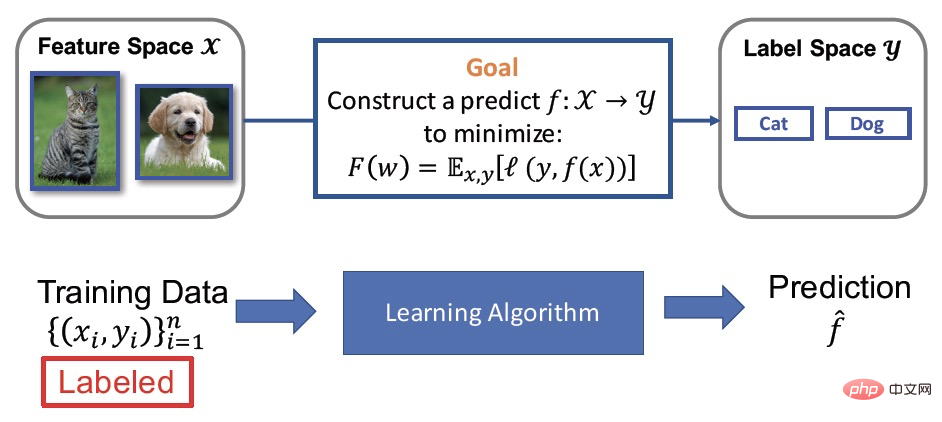

教師あり学習

私たちは、次のことを知っています。モデル トレーニングの実際の目的は、予測関数を学習することであり、数学的には、これはデータ (X) からラベル (y) へのマッピング関数の学習として説明できます。教師あり学習は最も一般的に使用されるモデルのトレーニング手法の 1 つであり、その効果の向上は、適切にラベル付けされた大量のトレーニング データ、いわゆる大量のラベル付きデータ ((X,y)) に依存します。しかし、データのラベル付けには多くの人手や物的資源等が必要となる場合が多く、効果は向上するもののコストが高くなるという問題がある。実際のアプリケーションでは、少量のラベル付きデータと大量のラベルなしデータが存在することがよくありますが、その結果得られる半教師あり学習も科学者からますます注目を集めています。

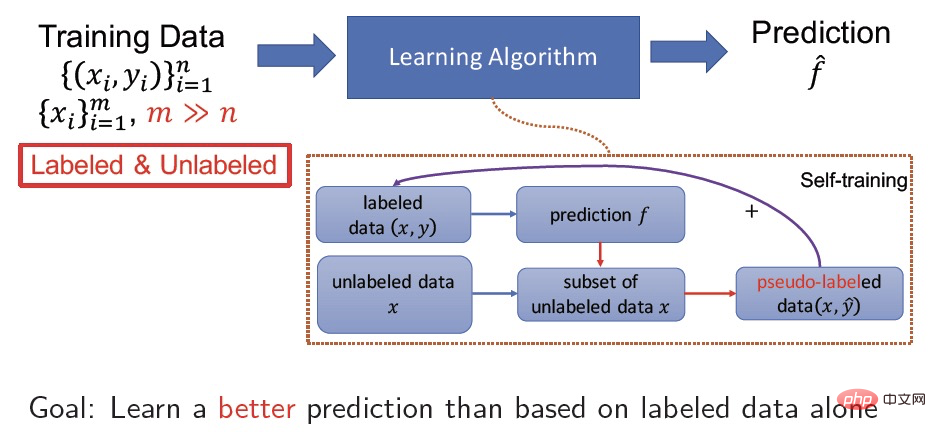

半教師あり学習

半分教師あり学習は、以下から同時に学習します。少量のラベル付きデータと大量のラベルなしデータがあり、その目的は、ラベルなしデータを利用してモデルの精度を向上させることです。たとえば、自己トレーニングは非常に一般的な半教師あり学習手法であり、その具体的なプロセスは、ラベル付きデータ (X, y) に対する X から y へのデータのマッピングを学習し、同時に学習したモデルを使用して予測を行うことです。ラベルなしデータ X 擬似ラベル  は、擬似ラベル データ (X,

は、擬似ラベル データ (X,  ) に対して教師あり学習をさらに実行することで、モデルの収束を向上させ、精度を向上させるのに役立ちます。

) に対して教師あり学習をさらに実行することで、モデルの収束を向上させ、精度を向上させるのに役立ちます。

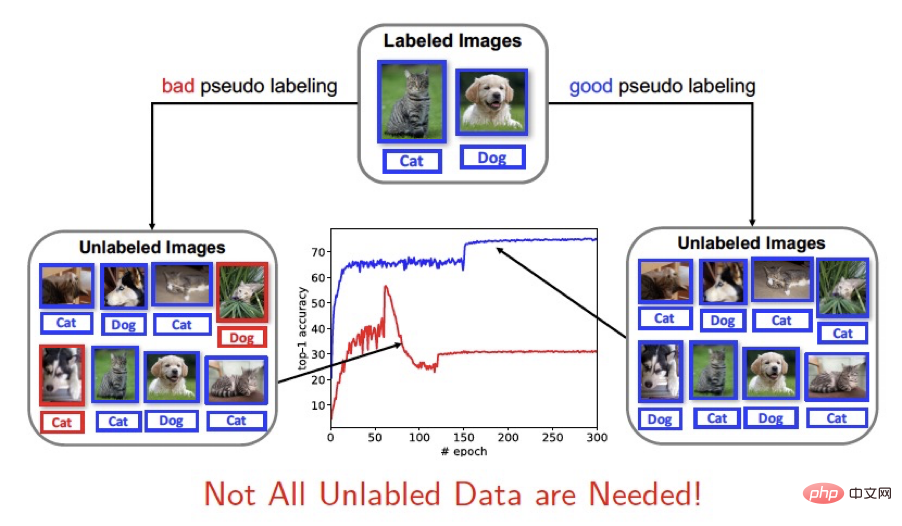

核心的な問題解決

既存の半教師あり学習フレームワークラベルなしデータの使用は、学習に完全に参加する方法と、固定のしきい値を使用してより信頼性の高いサンプルを選択して学習に使用する方法 (FixMatch など) に大別できます。半教師あり学習によるラベルなしデータの使用は、現在のモデルによって予測された擬似ラベルに依存するため、擬似ラベルの精度はモデルのトレーニングに大きな影響を与えます。良好な予測結果は、予測の収束と精度に役立ちます。新しいモデルの学習の場合、予測結果が不十分だとモデルのトレーニングが妨げられます。したがって、私たちはこう考えます: ラベルのないサンプルがすべて必要なわけではありません。

この論文は、動的しきい値 (動的しきい値) の使用を革新的に提案します。半教師あり学習 (SSL) のラベルのないサンプルをスクリーニングするために、半教師あり学習のトレーニング フレームワークを変革し、しきい値を動的に変更することでトレーニング プロセス中のラベルのないサンプルの選択戦略を改善しました。トレーニングのためにより効果的なラベルのないサンプルを選択します。ダッシュは、既存の半教師あり学習方法と簡単に統合できる一般的な戦略です。実験的には、CIFAR-10、CIFAR-100、STL-10、SVHN などの標準データセットでその有効性を完全に検証しました。理論的には、この論文は非凸最適化の観点から Dash アルゴリズムの収束特性を証明しています。

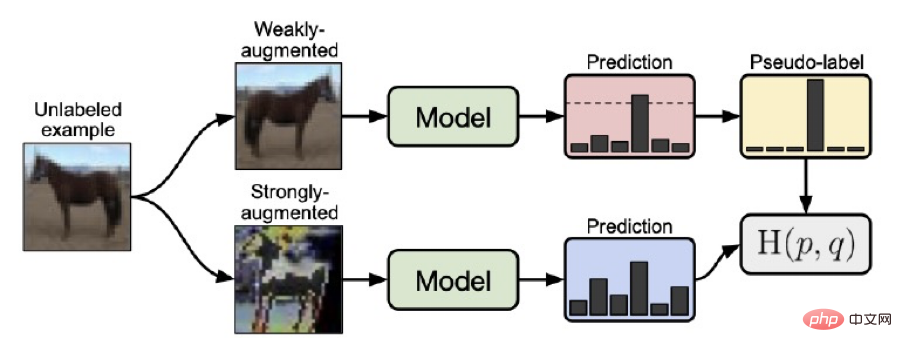

3. 方法Fixmatch トレーニング フレームワーク

Dash メソッドを紹介する前に、Google が提案する FixMatch アルゴリズムを紹介します。これは、固定しきい値を使用してラベルのないサンプルを選択する半教師あり学習メソッドです。 FixMatch トレーニング フレームワークは、以前の SOTA ソリューションでした。学習フレームワーク全体の重要な点は、次の点に要約できます:

1. ラベルなしデータの場合、弱いデータ強化 (水平反転、オフセットなど) によって取得されたサンプルは次のとおりです。現在のモデルを通じて取得された予測値

2. ラベルなしデータの強力なデータ拡張 (RA または CTA) によって取得されたサンプルの場合、予測値は現在のモデルを通じて取得されます

2. ラベルなしデータの強力なデータ拡張 (RA または CTA) によって取得されたサンプルの場合、予測値は現在のモデルを通じて取得されます

3. 弱いデータ拡張

3. 弱いデータ拡張  の結果を高い信頼度で使用して、ワン ホット メソッドで疑似ラベル

の結果を高い信頼度で使用して、ワン ホット メソッドで疑似ラベル  を形成し、

を形成し、 と X を使用します。強力なデータ拡張の結果を予測するための値 はモデルのトレーニングに使用されます。

と X を使用します。強力なデータ拡張の結果を予測するための値 はモデルのトレーニングに使用されます。

fixmatch の利点は、弱く強化されたデータを使用して擬似ラベルを予測することにより、擬似ラベル予測の精度が向上し、トレーニング プロセス中に 0.95 の固定しきい値を使用することです (対応する信頼性の高い予測サンプル (しきい値が 0.95 以上、つまり損失が 0.0513 以下) を選択して擬似ラベルを生成することで、トレーニング プロセスがさらに安定します。

#ダッシュ トレーニング フレームワーク

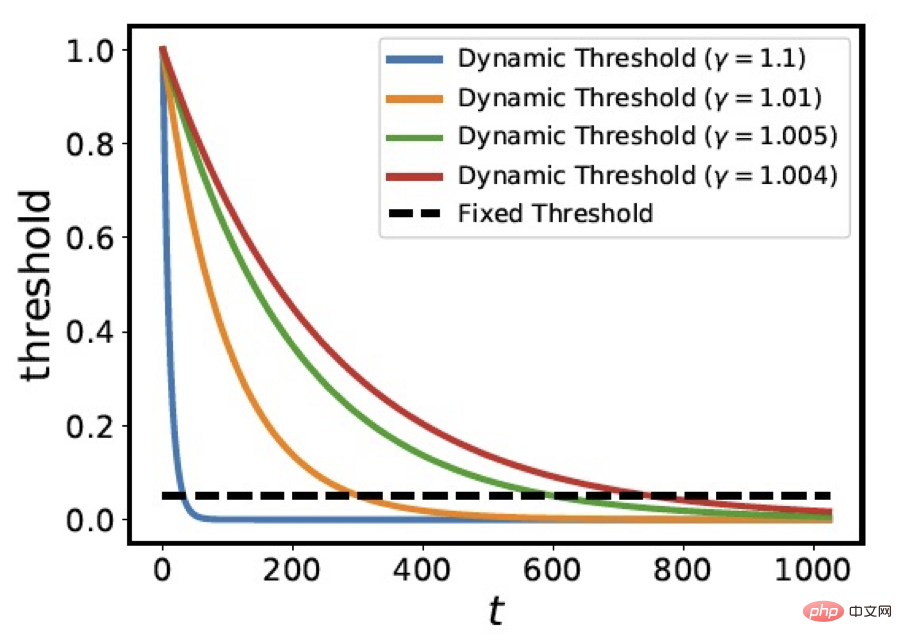

すべての疑似ラベルを選択する問題と、次の疑似ラベルを選択する問題については、固定閾値を使用する場合、私たちはサンプルのスクリーニングに動的閾値を使用する戦略を革新的に提案します。つまり、動的しきい値 は t

すべての疑似ラベルを選択する問題と、次の疑似ラベルを選択する問題については、固定閾値を使用する場合、私たちはサンプルのスクリーニングに動的閾値を使用する戦略を革新的に提案します。つまり、動的しきい値 は t

式では、C=1.0001、 は最初のエポック後のラベル付きデータの平均損失であり、勾配逆伝播に参加するためにこれらの

は最初のエポック後のラベル付きデータの平均損失であり、勾配逆伝播に参加するためにこれらの  ラベルなしサンプルを選択します。以下の図は、さまざまな

ラベルなしサンプルを選択します。以下の図は、さまざまな  値におけるしきい値

値におけるしきい値  の変化曲線を示しています。パラメーター

の変化曲線を示しています。パラメーター  がしきい値曲線の減少率を制御していることがわかります。

がしきい値曲線の減少率を制御していることがわかります。  の変化曲線は、トレーニング モデルをシミュレートするときの損失関数の下降傾向に似ています。

の変化曲線は、トレーニング モデルをシミュレートするときの損失関数の下降傾向に似ています。

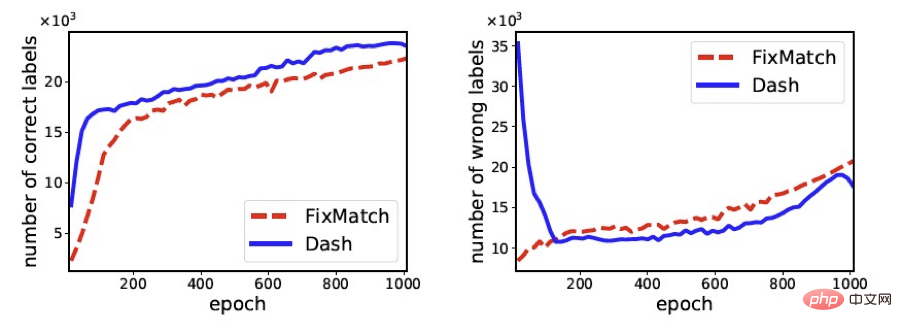

次の図は、トレーニング中に FixMath と Dash によって選択された正しいサンプルの数と誤ったサンプルの数を比較しています。トレーニングの進行に応じてプロセスが変化します (使用されるデータセットは cifar100 です)。この図から明らかなように、FixMatch と比較して、Dash は正しいラベルを持つサンプルをより多く選択し、間違ったラベルを持つサンプルをより少なく選択できるため、最終的にトレーニング モデルの精度を向上させることができます。

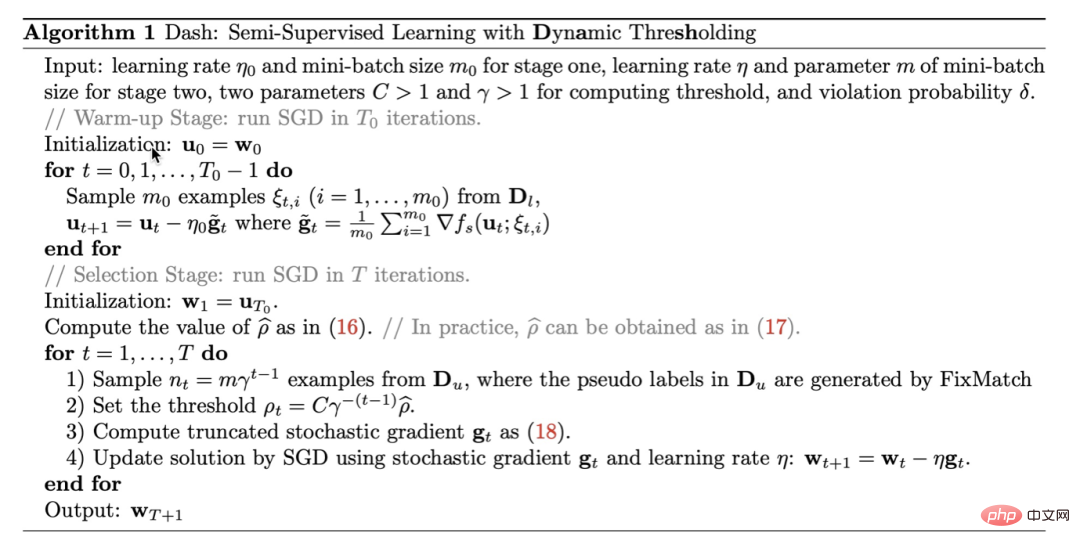

#私たちのアルゴリズムは次のように要約できます。 アルゴリズム 1.ダッシュは、既存の半教師あり学習方法と簡単に統合できる一般的な戦略です。便宜上、この記事の実験では主に Dash と FixMatch を統合します。理論的な証明の詳細については、論文を参照してください。

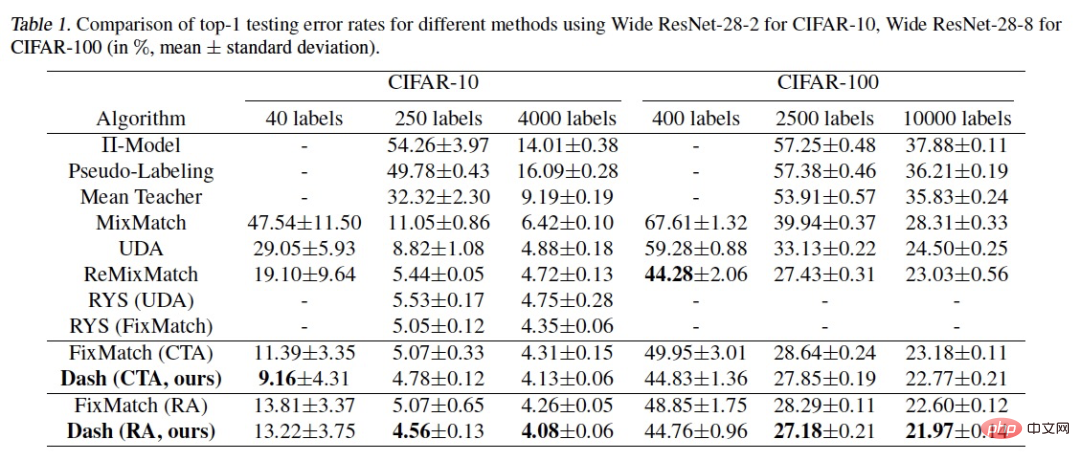

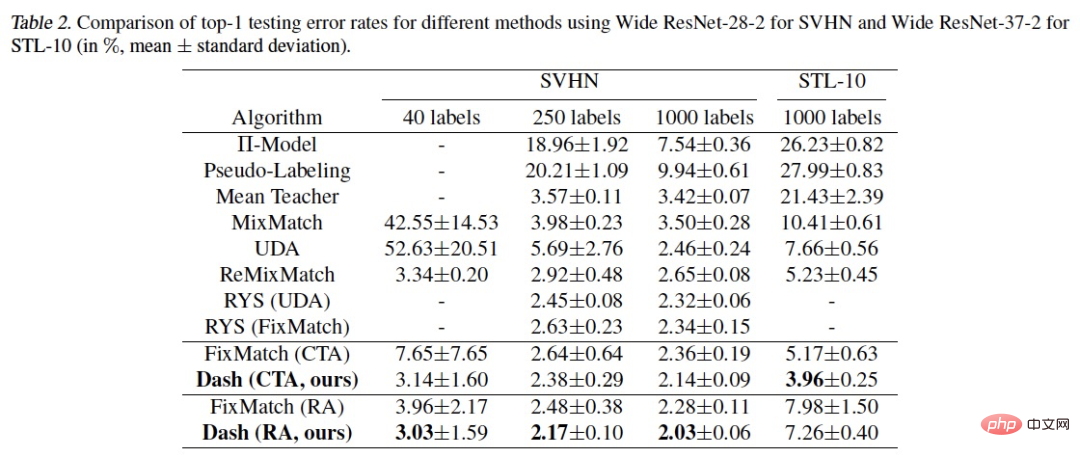

半教師あり学習で一般的に使用されるデータセット: CIFAR-10、CIFAR-100、 STL-10 アルゴリズムは SVHN で検証されました。結果は次のとおりです。

#私たちの方法が複数の実験でより良い結果を達成していることがわかります。 SOTA の方が良い結果が得られます。説明が必要なのは、CIFAR-100 400label での実験です。ReMixMatch は、より良い結果を達成するために、データ整列の追加トリックを使用しました。Dash にデータ整列のトリックを追加した後、エラー率は 43.31% でした。を達成できます。これは、ReMixMatch のエラー率 44.28% よりも低いです。

5. アプリケーションタスク ドメイン指向モデルの実際の研究開発プロセスでは、半教師あり Dash フレームワークが適用されることがよくあります。次に、私たちがさまざまな分野で開発したオープンソースの無料モデルを紹介しますので、ぜひ体験してダウンロードしてください (ほとんどの携帯電話で体験できます):

以上がDamo Academy のオープンソースの半教師あり学習フレームワーク Dash が多くの SOTA を更新の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。