人工知能分野におけるイノベーションのペースはますます速くなり、論文の数は爆発的に増加し、人間が読めないところまで達しています。

2022 年に出版された大量の論文の中で、どの機関が最も影響力を持っていますか?どの論文がより読む価値があるでしょうか?

海外メディア Zeta Alpha は最近、評価指標として古典的な 引用数 を使用し、## で最も引用された論文 100 件を収集してまとめました。 # in 2022 を実施し、過去 3 年間にさまざまな国や機関によって出版された、被引用数の高い論文の数を分析しました。

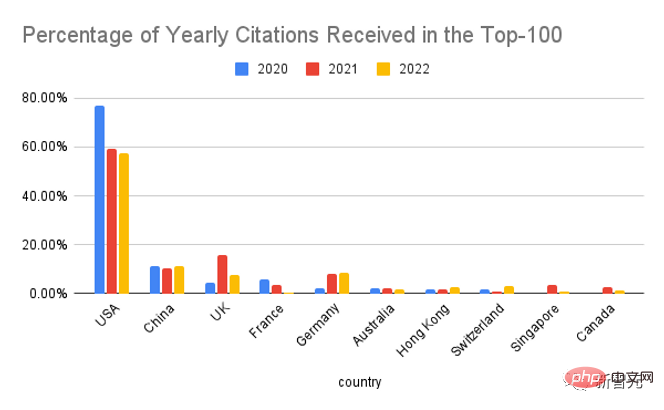

米国は依然として首位、中国は 2 位国別に分けると、依然として米国が首位の座を占めていますが、トップ 100 論文に占める割合は米国ですと比較すると2020年には大幅に下がります。

中国が昨年より若干高いデータで 2 位、3 位が英国で昨年の DeepMind の成果英国全体の69%を占め、前年の60%を超え、AI分野におけるシンガポールとオーストラリアの影響力もアナリストの予想を上回った。

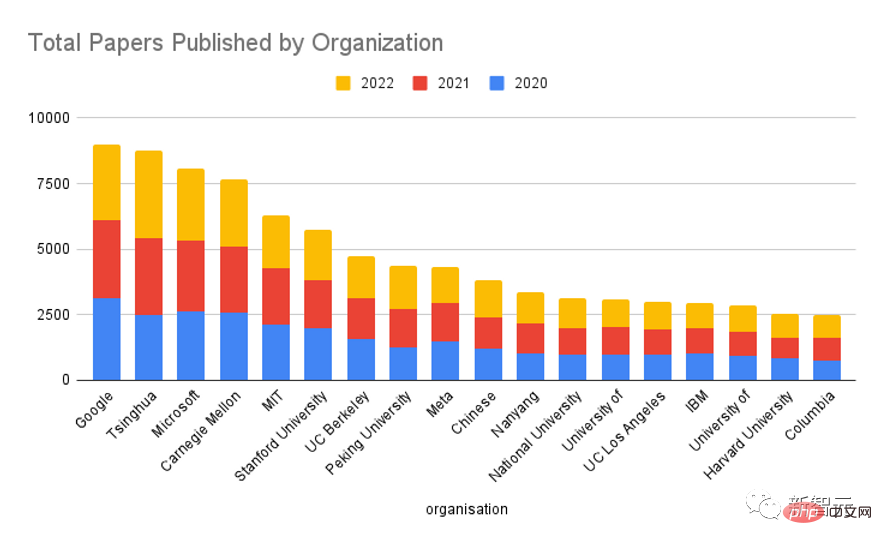

組織別に分けた場合、Google が常に AI 分野で最強のプレーヤーであり、メタ、マイクロソフト、カリフォルニア大学バークレー校、ディープマインド、スタンフォード大学がそれに続くことがわかります。 , 国内ランキング1位は清華大学です。

Meta AI のリーダーとして、Yann LeCun 氏は業界における Meta の影響力を誇りに思っており、Meta AI は出版物の量よりも出版物の質に注意を払っていると述べました。 。

今日の人工知能研究のほとんどは業界主導で行われており、単一の学術機関が与える影響はほとんどありませんが、ロングテール効果により、学術コミュニティ全体は依然として研究を続けています。データを組織の種類ごとに集計すると、両方の影響がほぼ等しいことがわかります。

過去 3 年間を振り返り、さまざまな機関の研究成果の総数を数えると、Google が依然として主導的な位置にあることがわかりますが、その差は大きくあります。他の大学に比べて規模が小さいので、チェックしてみる価値はありますが、清華大学が Google に次いで 2 位にランクされていることも言及する価値があります。

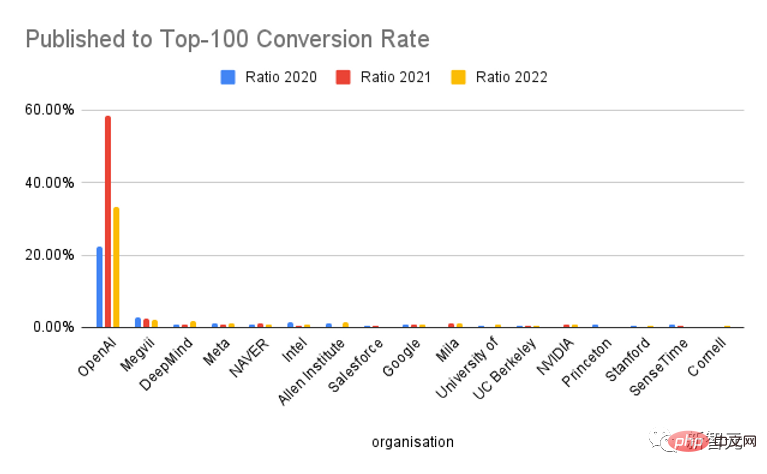

トップ 100 に入る出版物の割合を見ると、OpenAI はユニークであり、コンバージョン率の点で他の機関をはるかに上回っています。 「今年のトップ100『大論文』」。

もちろん、ChatGPT の人気を見る限り、OpenAI はマーケティングに非常に優れており、引用数の増加をある程度促進していることは否定できません。研究結果は非常に高いです。

このリストを補足するには、Semantic Scholar で引用度の高い人工知能論文をマイニングします。この論文は対象範囲が広く、主に影響力のあるクローズド ソース出版社 (「Nature」、「Elsevier」、「Springer」、その他のジャーナル) からのものであり、引用数によって並べ替えることができます。 ) 追加の論文については。

次に、Google Scholar における各論文の引用数を代表指標として使用し、この数に基づいて論文をソートし、1 年間の上位 100 論文を取得します。

これらの論文については、GPT-3 を使用して著者、その所属、および国を抽出し、これらの結果を手動で確認します (国が出版物に反映されていない場合は、組織の本社国)。

複数の機関に属する著者による論文は、所属ごとに 1 回としてカウントされます。

1. AlphaFold タンパク質構造データベース: 高精度でタンパク質配列空間の構造範囲を大幅に拡大モデル

論文リンク: https://academic.oup.com/nar/article/50/D1/D439/6430488

#発行機関: ヨーロッパ分子生物学研究所、DeepMind

##AlphaFold DB: https:// alphafold. ebi.ac.uk

Citations: 1331##AlphaFoldタンパク質構造データベースAlphaFold DB 公的にアクセス可能です。タンパク質構造予測に関する広範かつ高精度のデータベース。

DeepMind の AlphaFold v2.0 を利用したこのデータベースは、既知のタンパク質配列空間の構造範囲を前例のないほど拡大することを可能にします。

AlphaFold DB は、予測された原子座標、各残基とペアのモデル信頼性推定値、および予測されたアライメント エラーのプログラムによるアクセスとインタラクティブな視覚化を提供します。

AlphaFold DB の初期バージョンには、21 のモデル生物のプロテオームをカバーする 360,000 以上の予測構造が含まれており、UniRef90 データセット (1 億以上) のほとんどをカバーするように拡張される予定です。代表的な配列。

2. ColabFold: タンパク質のフォールディングを誰でも利用できるようにする

#コードリンク: https://github.com/sokrypton/colabfold

環境リンク: https://colabfold.mmseqs.com

引用: 1138

ColabFold は、MMSEQS2 の高速相同性検索と、タンパク質構造および複合体の AlphaFold2 または Rosettafold 予測を組み合わせることで高速化します。 。 ColabFold は、モデル利用において 40 ~ 60 倍の高速化された検索と最適化を実現し、グラフィックス処理ユニットが 1 つだけのサーバー上でほぼ 1,000 の構造を予測できます。

ColabFold は、Google Colaboratory に基づいたタンパク質フォールディングのための無料でアクセス可能なプラットフォームであり、オープンソース ソフトウェアとしても利用できます。

3. 2020 年代の ConvNet

紙のリンク: https://arxiv.org/pdf/ 2201.03545.pdf

Citations: 835

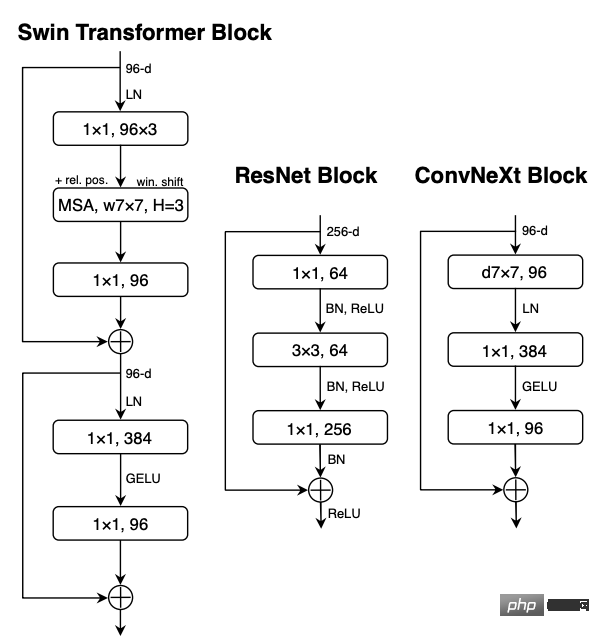

Visual Identity の「Roaring 20s」(Roaring 20s) はじめにVisual Transformers (ViTs) の導入により、すぐに ConvNets に代わって最も先進的な画像分類モデルとなりました。 一方で、最も単純な ViT であっても、オブジェクト検出やセマンティック セグメンテーションなどの一般的なコンピューター ビジョン タスクに適用すると、依然としていくつかの困難に直面します。

階層型トランスフォーマー (Swin トランスフォーマーなど) は、いくつかの ConvNet の以前のトランスフォーマーを再導入し、トランスフォーマーを一般的なビジョン モデルのバックボーンとして実際に実現可能にし、さまざまなビジョン タスクで優れたパフォーマンスを示します。

ただし、このハイブリッド アプローチの有効性は依然として、畳み込みの固有の誘導バイアスではなく、トランスフォーマーの固有の利点によるところが大きいです。

この研究では、研究者たちは設計空間を再考し、純粋な ConvNet が達成できる限界をテストしました。

標準 ResNet を ViT の設計に徐々に「最新化」し、その過程でパフォーマンスの違いのコンポーネントに寄与するいくつかの鍵を発見しました。調査により、 ConvNeXt と呼ばれる純粋な ConvNet モデルのファミリー。

ConvNeXt は完全に標準の ConvNet モジュールで構成されており、精度とスケーラビリティの点で Transformer と同等であり、COCO 検出と ADE20K セグメンテーションで ImageNet トップ 1 の 87.8% の精度を達成し、シンプルさを維持しながら Swin Transformers を超えています。標準 ConvNet の効率性。

4. CLIP 潜在を使用した階層的なテキスト条件付き画像生成

論文リンク: https://arxiv.org/abs/2204.06125

引用数: 718

CLIP のような対照モデルは、セマンティクスとスタイルを捕捉する堅牢な画像表現を学習することが示されています。

これらの表現を活用して画像を生成するために、研究者らは 2 段階のモデルを提案しています。テキスト キャプションが与えられた CLIP 画像埋め込みを生成する事前段階と、画像埋め込みに条件付けされた画像を生成するデコーダーです。

実験の結果、画像表現を明示的に生成すると、忠実度やタイトルの類似性の損失を最小限に抑えながら画像の多様性を向上させることができ、また、画像表現に条件付けされたデコーダは、重要でない部分を変更しながらセマンティクスとスタイルを維持しながら画像の変更を生成できることが示されました。画像表現には存在しない詳細。

さらに、CLIP の共同埋め込みスペースにより、言語ガイドに基づいた画像操作をゼロショットで実行できるようになります。

デコーダに拡散モデルを使用し、先験的自己回帰モデルと拡散モデルを実験すると、後者の方が計算効率が高く、高品質のサンプルを生成できることがわかります。

5. PaLM: パスウェイを使用した言語モデリングのスケーリング

論文リンク: https://arxiv.org/pdf/2204.02311.pdf

引用: 426

大規模な言語モデルは、少数ショット学習を使用してさまざまな自然言語タスクでより高いパフォーマンスを達成し、モデルを特定のアプリケーションに適応させるために必要なタスク固有のトレーニング インスタンスの数を大幅に削減することが示されています。

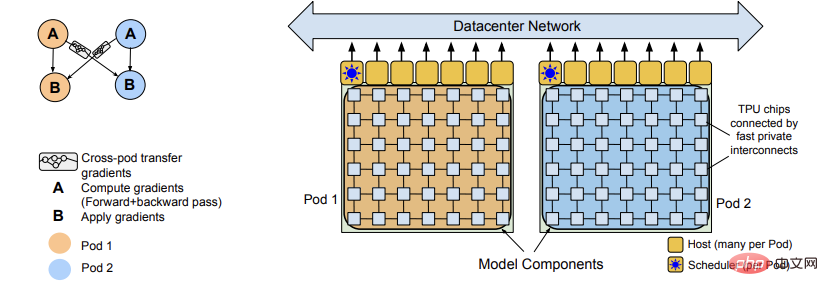

少数ショット学習に対するスケールの影響をさらに理解するために、研究者らは、5,400 億のパラメーターで高密度にアクティブ化された Transformer 言語モデル Pathways Language Model (PaLM) をトレーニングしました。

PaLM は、Pathways (複数の TPU ポッドで効率的にトレーニングできる新しい ML システム) を使用して 6144 TPU v4 チップでトレーニングされ、数百の言語理解および生成ベンチマークで結果を達成しました。 -shot 学習の結果は、スケーリングの利点を示しています。

これらのタスクの一部では、PaLM 540B は画期的なパフォーマンスを達成し、一連のマルチステップ推論タスクの微調整において最先端を上回り、最近リリースされた BIG ベンチでは人間を上回りました。ベンチマークの平均パフォーマンス。

多くの BIG ベンチ タスクでは、モデル サイズの不連続な改善が見られます。これは、スケールが最大のモデルに拡張されると、パフォーマンスが突然向上することも意味します。

PaLM は、多言語タスクとソース コード生成における強力な機能も備えており、これは一連のベンチマーク テストでも証明されています。

さらに、研究者らはバイアスと毒性の包括的な分析も実施し、モデルのサイズに関連したトレーニング データの記憶の程度を研究しました。最後に、大規模言語モデルに関連する倫理的考慮事項と、潜在的な緩和戦略について説明します。

1. Swin Transformer V2: 容量と解像度のスケールアップ

紙のリンク: https://arxiv.org/pdf/2111.09883.pdf

#コードリンク: https://github.com/microsoft/Swin-Transformer

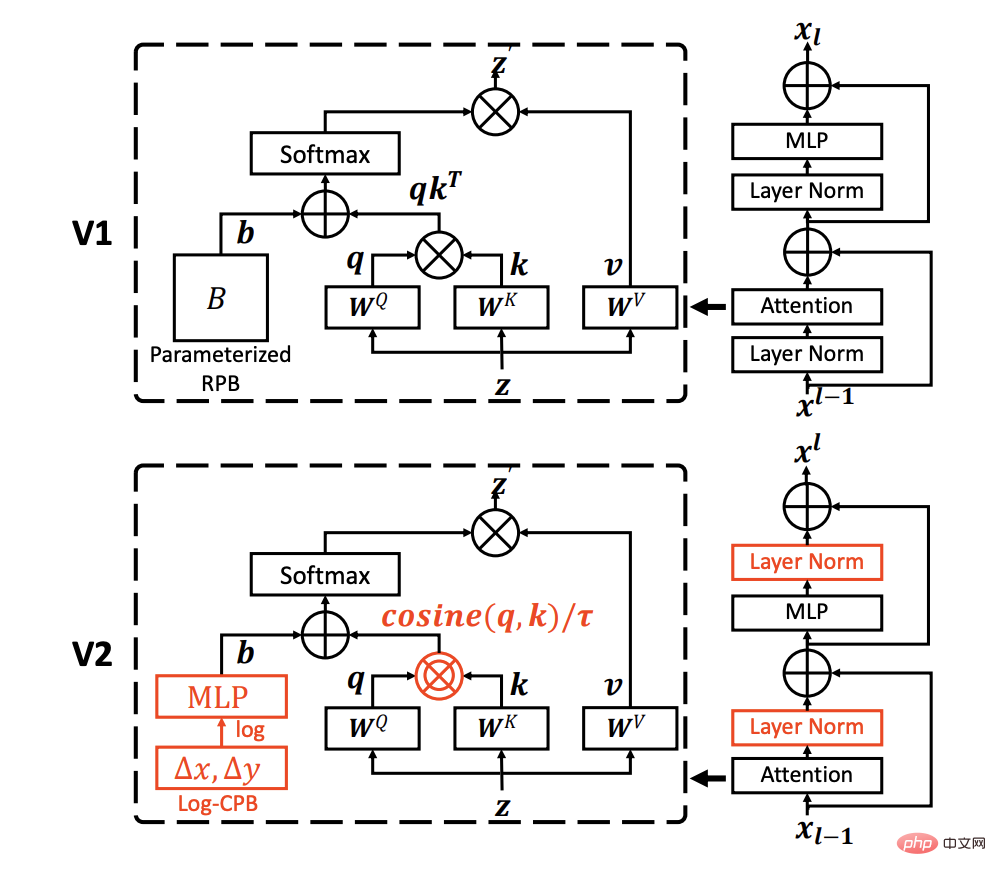

引用数: 266 大規模な NLP モデルは、飽和の兆候を示すことなく言語タスクのパフォーマンスを大幅に向上させると同時に、人間のような驚くべき少数ショット能力を実証することが示されています。

この論文は、コンピューター ビジョンにおける大規模モデルを調査することを目的としており、大規模ビジュアル モデルのトレーニングと適用における 3 つの主要な問題 (トレーニングの不安定性、事前トレーニングと詳細トレーニングの区別など) を解決します。チューニング、レートギャップ、ラベル付きデータの必要性などです。

1) コサイン アテンションと組み合わせた残差事後法。トレーニングの安定性;

2) 低解像度画像で事前トレーニングされたモデルを高解像度入力のモデルに効果的に転送するための対数間隔の連続位置偏差法 下流タスクの中で;

3) 自己-教師付き事前トレーニング手法 SimMIM により、多数のラベル付き画像の必要性が軽減されます。

これらの手法により、これまでで最大の高密度ビジョン モデルである 30 億パラメータの Swin Transformer V2 モデルのトレーニングに成功し、最大 1,536×1,536 解像度の画像でトレーニングできるようになりました。

ImageNet-V2 画像分類、COCO オブジェクト検出、ADE20K セマンティック セグメンテーション、Kinetics-400 ビデオ アクション分類を含む 4 つの代表的な視覚タスクで新しいパフォーマンス記録を樹立します。

同時に、このトレーニングは Google の 10 億レベルのビジョン モデルでのトレーニングよりもはるかに効率的であり、消費するラベル付きデータとトレーニング時間が 40 分の 1 であることにも注目できます。

2. サイバー攻撃検出のための教師なしオートエンコーダーと混合ガウス モデルのアンサンブル以前の研究では、次元削減機能を備えた教師なし機械学習をネットワーク検出に使用しました。これは、高次元の疎なデータに対する堅牢な異常検出に限定されます。

ほとんどのメソッドは通常、各フィールドのパラメーターが均一であり、特定のガウス分布を持つと仮定し、データの歪みの堅牢性テストを無視します。

論文リンク: https://www.sciencedirect.com/science/article/pii/S0306457321003162

##引用: 145この論文では、ガウス混合モデル (GMM) に接続された教師なしアンサンブル オートエンコーダーを使用して、各ドメインの一意性を考慮せずに複数のドメインに適応することを提案します。

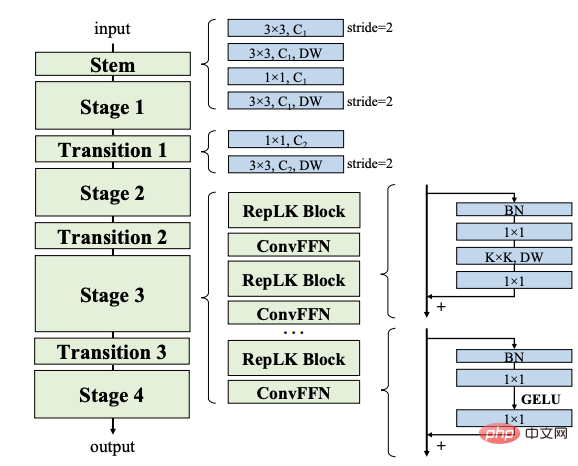

統合オートエンコーダの潜在空間では、注意ベースの潜在表現と再構築された最小誤差特徴が利用され、期待値最大化 (EM) アルゴリズムが GMM のサンプル密度の推定に使用されます。推定 サンプル密度がトレーニング段階で取得された学習しきい値を超えると、そのサンプルは異常に関連する外れ値として識別されます。 最後に、統合されたオートエンコーダと GMM が共同で最適化され、目的関数の最適化がラグランジュ双対問題に変換されます。3 つの公開データセットでの実験により、提案されたモデルのパフォーマンスが検証されます。パフォーマンスは、選択されたモデルと大幅に競合します異常検出のベースライン。 この論文の共著者は、寧波工業大学の An Peng 教授と同済大学の Zhiyuan Wang です。 アン ペン教授は現在、寧波工業大学電子情報工学部の副学部長であり、2000 年から 2009 年まで清華大学工学物理学科で学び、学士号と博士号を取得しています。工学博士; CERN、イタリアのパドバ国立大学およびドイツのハイデルベルク大学の客員研究員、中国オートメーション協会の認知コンピューティングおよびシステム専門委員会のメンバー、中国の認知システムおよび情報処理専門委員会のメンバー人工知能協会、中国指揮統制協会青少年作業委員会のメンバーであり、委員長を務める同氏は、国家重点基礎研究開発プログラム (973 プログラム)、国立自然科学財団などの多くの科学研究プロジェクトにも参加してきました。中国と国家火花計画。 3. カーネルを 31x31 にスケールアップ: CNN における大規模なカーネル設計の再検討

コードリンク: https://github.com/megvii-research/RepLKNet 引用数: 127

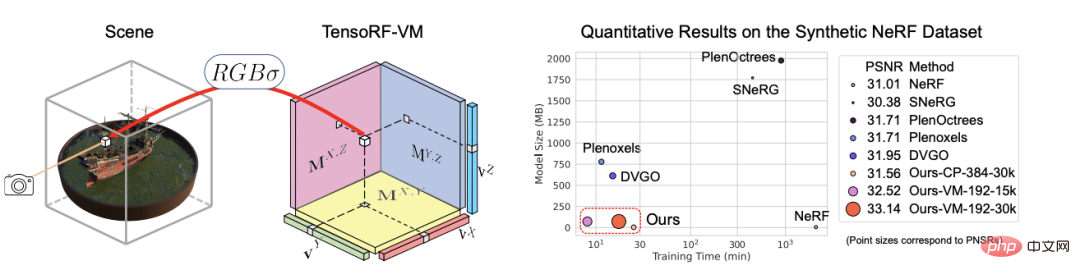

4. TensoRF: テンソル放射フィールド

論文リンク: https://arxiv.org/abs/ 2203.09517

引用数: 110

この記事では、放射線場を伝導する方法である TensoRF を提案しています。モデリングとリファクタリングのこと。 純粋に MLP を使用する NeRF とは異なり、研究者らはシーンの放射線場を 4D テンソルとしてモデル化し、ボクセルごとのマルチチャネル特徴を持つ 3 次元画像を表現します。ボクセル グリッドは、4D シーン テンソルを複数のコンパクトな低ランク テンソル コンポーネントに分解します。 このフレームワークで従来の CP 分解を適用し、テンソルをコンパクトなベクトルを持つランク 1 コンポーネントに分解すると、通常の NeRF よりも優れたパフォーマンスが達成されることが証明されています。

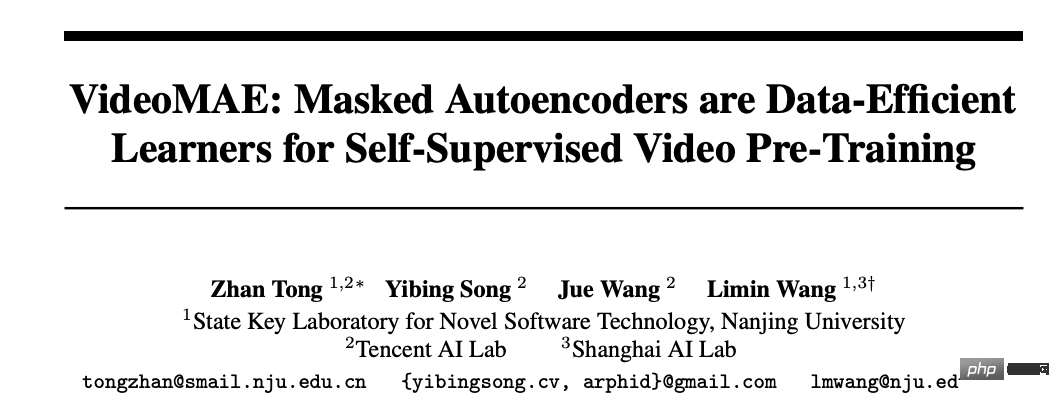

5. VideoMAE: マスクされたオートエンコーダーは自己教師付きビデオ事前トレーニングのためのデータ効率の高い学習者です

#紙のリンク: https://arxiv.org/abs/2203.12602

##コードリンク: https://github.com/MCG-NJU/VideoMAE

#引用数: 100比較的小さなデータセットでより高いパフォーマンスを達成するには、通常、追加の大規模データセットで Video Transformer を事前トレーニングする必要があります。

この論文では、ビデオ マスク オートエンコーダー (VideoMAE) が自己教師ありビデオ事前トレーニング (SSVP) 用のデータ効率の高い学習器であることを示します。 最近の ImageMAE に触発されて、研究者らはマスク率が非常に高いカスタム ビデオ チューブを提案しています。このシンプルな設計により、ビデオの再構成がより困難な自己教師タスクになります。これにより、研究中により効果的なビデオ表現の抽出が促進されます。この事前トレーニングのプロセス。

SSVP では 3 つの重要な発見が得られました:

(1) 非常に高い割合 マスキング率(つまり、90% ~ 95%) であっても、VideoMAE の良好なパフォーマンスを生み出すことができます。一時的に冗長なビデオ コンテンツは、画像よりもマスキング率が高くなります。

(2) VideoMAE は、追加のデータを使用せずに、非常に小さなデータセット (つまり、約 3k ~ 4k ビデオ) で非常に高いパフォーマンスを実現します。

(3) VideoMAE は、SSVP ではデータ量よりもデータ品質が重要であることを示しています。

トレーニング前データセットとターゲットデータセットの間のドメイン転送は重要な問題です。

VideoMAE と通常の ViT は、Kinetics-400 で 87.4%、Something-Something V2 で 75.4%、UCF101 で 91.3%、UCF101 で 91.3% を達成できることは注目に値します。 % は、追加データを使用せずに HMDB51 で達成されます。

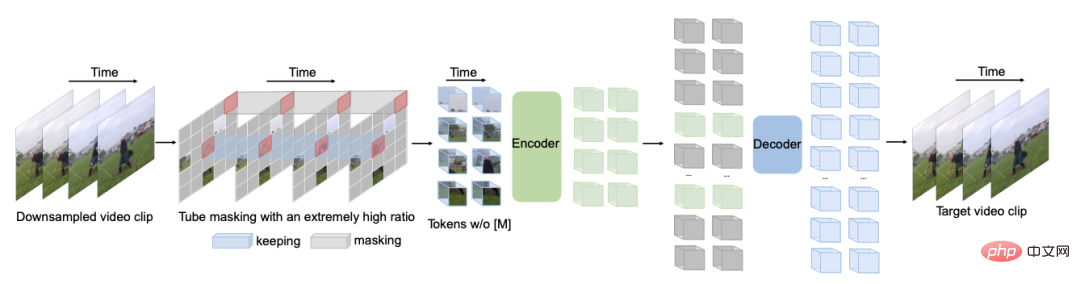

トップ 100 論文の完全なリスト

以上が2022年の「AI論文トップ100」発表:清華大学がGoogleに次ぐ2位、寧波理工大学が最大のダークホースにの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。