デコレーターは、Python コンテキスト マネージャーの特定の実装です。この記事では、pytorch GPU デバッグの例を通じてそれらの使用方法を説明します。すべての状況で機能するとは限りませんが、非常に便利であることがわかりました。

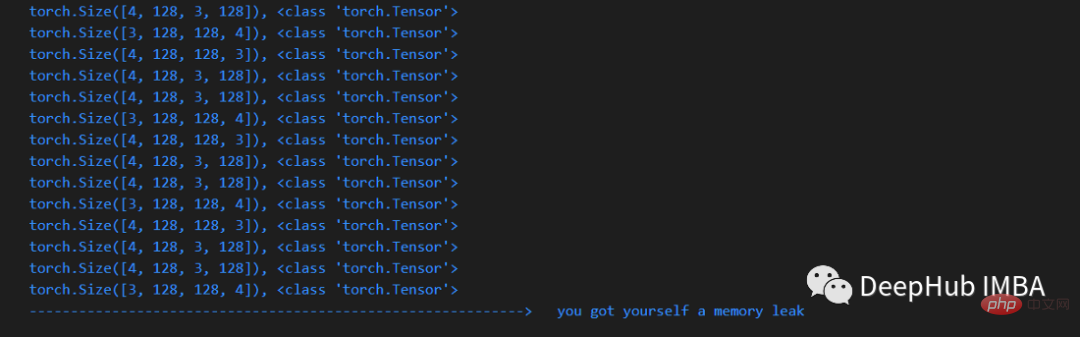

メモリ リークをデバッグするには、さまざまな方法があります。この記事では、コード内で問題のある行を特定するための便利な方法を紹介します。この方法は、特定の場所を簡潔な方法で見つけるのに役立ちます。

問題が発生した場合、一般的に使用される古典的な方法は、次の例のように、デバッガーを使用して行ごとにチェックすることです。

def memleak_wrapper(func):

def wrap(*args, **kwargs):

print("num tensors start is ...")

out = func(*args, **kwargs)

print("num tensors end is ...")

return out

return wrap@memleak_wrapper

def function_to_debug(x):

print(f"put line(s) of code here. Input is {x}")

out = x + 10

return outout = function_to_debug(x=1000)

print(f"out is {out}")

#输入类似这样

#num tensors start is ...

#put line(s) of code here. Input is 1000

#num tensors end is ...

#outis 1010with open("file") as f:

… from contextlib import ContextDecorator

class check_memory_leak_context(ContextDecorator):

def __enter__(self):

print('Starting')

return self

def __exit__(self, *exc):

print('Finishing')

return Falseclass check_memory_leak_context(ContextDecorator):

def __enter__(self):

self.start = get_n_tensors()

return self def __exit__(self, *exc):

self.end = get_n_tensors()

increase = self.end — self.start

if increase > 0:

print(f”num tensors increased with"

f"{self.end — self.start} !”)

else:

print(”no added tensors”)

return Falseimport gc def get_n_tensors(): tensors= [] for obj in gc.get_objects(): try: if (torch.is_tensor(obj) or (hasattr(obj, ‘data’) and torch.is_tensor(obj.data))): tensors.append(obj) except: pass return len(tensors)

x = arbitrary_operation(x) ... with check_memory_leak_context(): y = x[0].permute(1, 2, 0).cpu().detach().numpy() x = some_harmless_operation() ... x = another_arbitrary_operation(x)

以上がコンテキスト デコレータを使用した Pytorch のメモリ リーク問題のデバッグの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。