卓球愛好家とロボットを対戦させてみよう ロボットの開発動向から判断すると、誰が勝ち、誰が負けるかは非常にわかりません。

このロボットは、器用な操縦性、柔軟な脚の動き、優れた把握能力を備えており、さまざまな困難な作業に幅広く使用されています。しかし、ロボットは人間との密接な対話を伴うタスクをどのように実行するのでしょうか?卓球を例にとると、これには双方の高度な協力が必要であり、ボールの動きが非常に速いため、アルゴリズムに大きな課題が生じます。

卓球ではスピードと正確さが最優先され、学習アルゴリズムに高い要求が課せられます。同時に、このスポーツには 2 つの大きな特徴があります。それは高度に構造化された (固定された予測可能な環境) とマルチエージェントのコラボレーション (ロボットは人間または他のロボットと戦うことができる) であり、人間とコンピューターの相互作用を研究するのに理想的な場所となっています。強化学習: 問題に対する理想的な実験プラットフォーム。

Google のロボット研究チームは、複数人の動的でインタラクティブな環境で学習するロボットが直面する問題を研究するために、このようなプラットフォームを構築しました。 Google もこの目的のために特別なブログを書き、彼らが研究している 2 つのプロジェクト、Iterative-Sim2Real (i-S2R) と GoalsEye を紹介しました。 i-S2R により、ボットは人間のプレイヤーと 300 以上の試合を行うことができ、一方、GoalsEye により、ボットはアマチュアからいくつかの有用な戦略 (目標条件付き戦略) を学ぶことができました。

i-S2R 戦略により、ロボットは人間と競争できます。ロボットのグリップはあまりプロフェッショナルに見えませんが、ボールを逃すことはありません:

あなたが来ても私が去っても、それはほとんど同じで、質の高いボールをプレーしているように感じます。

#GoalsEye 戦略は、ボールをどこに向けても打つのと同じように、テーブル上の指定された位置にボールを戻すことができます。

このプロジェクトでは、ロボットが人間と協力すること、つまり人間とできるだけ長くスパーリングをすることを学ぶことを目指しています。 。人間のプレイヤーに対して直接トレーニングするのは退屈で時間がかかるため、Google はシミュレーション ベースのアプローチを採用しました。しかし、これには新たな問題があり、シミュレーションベースの手法では人間の行動や閉ループインタラクションタスクなどを正確にシミュレートすることが困難です。

i-S2R では、Google は人間とコンピューターの対話タスクで人間の行動を学習できるモデルを提案し、それをロボット卓球プラットフォーム上でインスタンス化しました。 Google は、アマチュアの人間プレーヤーで最大 340 回の打球投球を達成できるシステムを構築しました (以下を参照)。

# #人間の行動モデルの学習

下の図に示すように、i-S2R は単純な人間の行動モデルをおおよその開始点として使用し、シミュレーション トレーニングと現実世界の展開を交互に行います。各反復では、人間の行動モデルと戦略が適応されます。

i-S2R メソッド

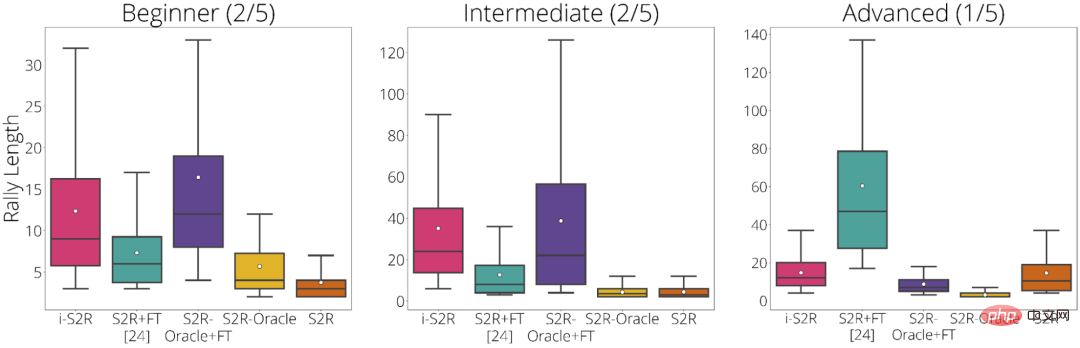

Google は、プレーヤーのタイプに基づいて実験結果を分類しています: 初心者 (プレーヤーの 40%)、中級者(プレイヤーの 40%) と上級者 (プレイヤーの 20%)。実験結果から、初心者と中級者の両方のプレーヤー (プレーヤーの 80%) にとって、i-S2R は S2R FT (シミュレーションからリアルと微調整) よりも大幅に優れたパフォーマンスを示します。

#i-S2R のプレイヤータイプ別の結果

GoalsEye では、Google は行動クローン技術を組み合わせて正確なターゲティング戦略を学習する方法も実証しました。

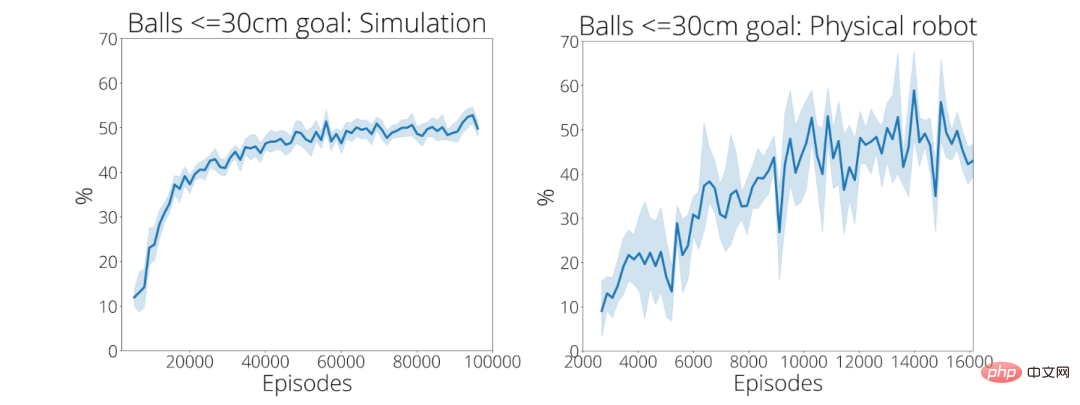

Google は卓球の精度に焦点を当てており、下の図に示すように、ロボットがテーブル上の指定された位置にボールを正確に返せることを期待しています。以下の効果を達成するために、LFP (Learning from Play) と GCSL (Goal-Conditioned Supervised Learning) も使用されました。

GoalsEye 戦略は、直径 20 cm の円 (左) をターゲットとしています。人間のプレイヤーは同じターゲットを狙うことができます (右)

最初の 2,480 のデモでは、Google のトレーニング戦略は 9% の確率でしか機能しませんでした半径30cmの円形の標的に正確に命中する。約 13,500 回のデモンストレーションの後、ボールが目標に到達する精度は 43 パーセントに向上しました (右下)。

これら 2 つのプロジェクトの詳細については、次のリンクを参照してください。

以上が4分間で300回以上プレーした後、Googleはロボットに卓球を教えたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。