複雑なアテンション メカニズムとモデル設計により、既存のビジュアル トランスフォーマー (ViT) のほとんどは、実際の産業展開シナリオでは畳み込みニューラル ネットワーク (CNN) ほど効率的に実行できません。ここで、ビジュアル ニューラル ネットワークは CNN と同じくらい速く、ViT と同じくらい強力な推論を行うことができるのかという疑問が生じます。

最近のいくつかの研究では、この問題を解決するために CNN と Transformer のハイブリッド アーキテクチャを設計しようとしていますが、これらの研究の全体的なパフォーマンスは満足のいくものとは程遠いです。これに基づいて、ByteDance の研究者は、現実の産業シナリオに効果的に導入できる次世代ビジュアル トランスフォーマー Next-ViT を提案しました。レイテンシと精度のトレードオフの観点から見ると、Next-ViT のパフォーマンスは優れた CNN や ViT に匹敵します。

論文アドレス: https://arxiv.org/pdf/2207.05501.pdf ##Next-ViT の研究チームは、新しい畳み込みブロック (NCB) とトランスフォーマー ブロック (NTB) を開発することで、ローカルおよびグローバルの情報を取得するフレンドリーなメカニズムを導入しました。次に、この研究では、効率的なハイブリッド パラダイムで NCB と NTB をスタックし、さまざまな下流タスクのパフォーマンスを向上させることを目的とした、新しいハイブリッド戦略 NHS を提案しています。

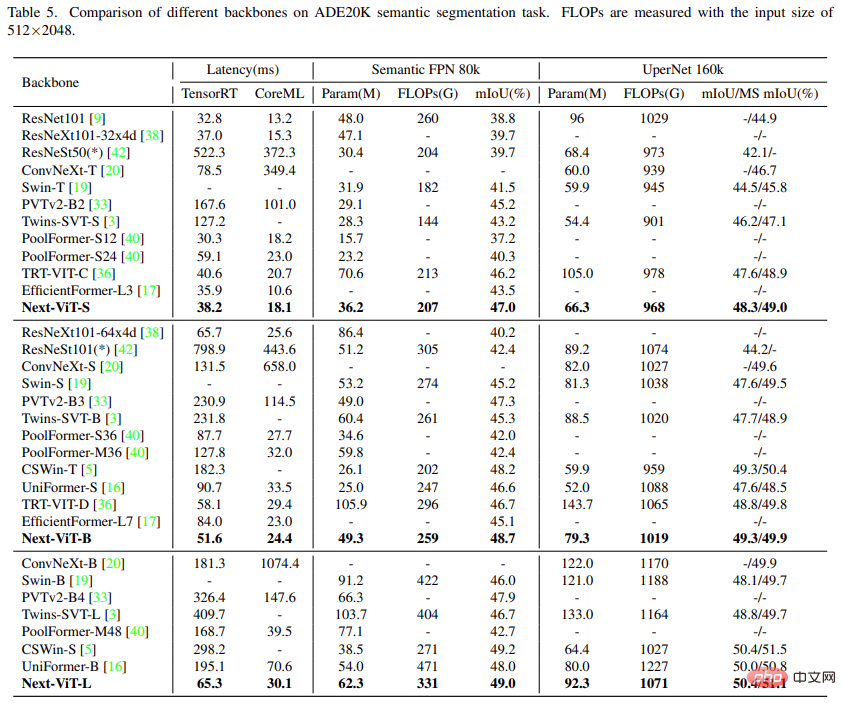

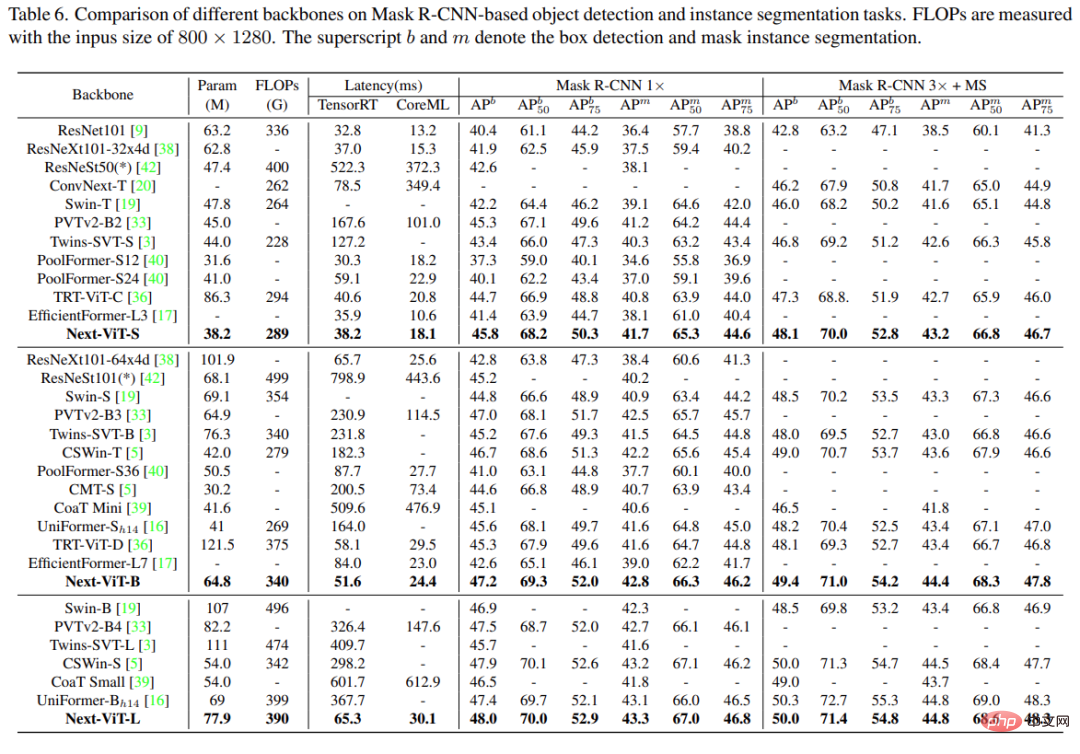

広範な実験により、Next-ViT は、さまざまな視覚タスクの遅延と精度のトレードオフの点で、既存の CNN、ViT、および CNN-Transformer ハイブリッド アーキテクチャよりも大幅に優れていることが示されています。 TensorRT では、Next-ViT は、COCO 検出タスクで 5.4 mAP (40.4 VS 45.8)、ADE20K セグメンテーションで 8.2% mIoU (38.8% VS 47.0%) で ResNet を上回ります。一方、Next-ViT は CSWin と同等のパフォーマンスを実現し、3.6 倍の高速推論を実現します。 CoreML では、Next-ViT は EfficientFormer よりも COCO 検出タスクで 4.6 mAP (42.6 VS 47.2)、ADE20K セグメンテーションで 3.5% mIoU (45.2% から 48.7%) 優れています。

方法

研究者らはまず、情報インタラクションのコアモジュールを徹底的に設計し、短期および長期のシミュレーションを行うための強力なNCBとNTBをそれぞれ開発しました。ビジュアルデータの -term 依存関係。ローカル情報とグローバル情報も NTB に融合され、モデリング機能がさらに向上します。最後に、既存の手法に固有の欠点を克服するために、この研究では畳み込みブロックと Transformer ブロックの統合を系統的に研究し、NCB と NTB をスタックして新しい CNN-Transformer ハイブリッド アーキテクチャを構築する NHS 戦略を提案します。

研究者らはまず、情報インタラクションのコアモジュールを徹底的に設計し、短期および長期のシミュレーションを行うための強力なNCBとNTBをそれぞれ開発しました。ビジュアルデータの -term 依存関係。ローカル情報とグローバル情報も NTB に融合され、モデリング機能がさらに向上します。最後に、既存の手法に固有の欠点を克服するために、この研究では畳み込みブロックと Transformer ブロックの統合を系統的に研究し、NCB と NTB をスタックして新しい CNN-Transformer ハイブリッド アーキテクチャを構築する NHS 戦略を提案します。

NCB

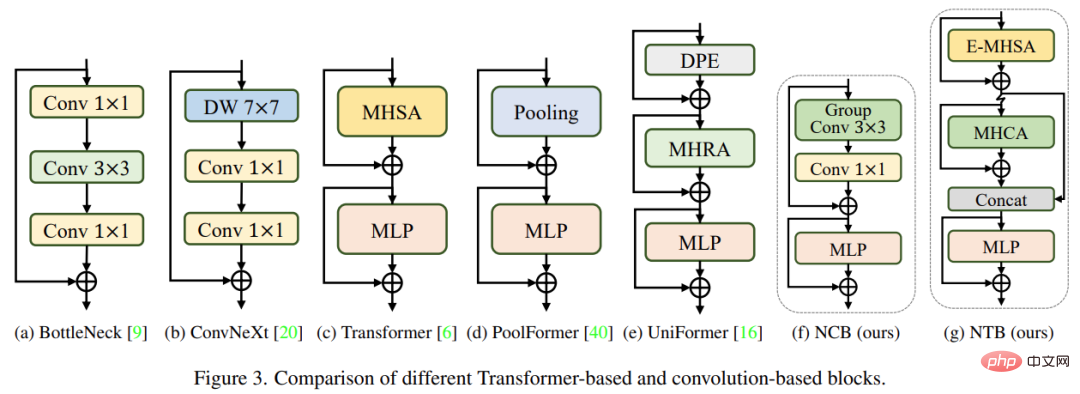

上記のブロックの問題を克服するために、この研究では、BottleNeck ブロックの展開上の利点を維持する Next Convolution Block (NCB) を提案しました。同時にトランスブロックの優れた性能も得られます。図 3(f) に示すように、NCB は MetaFormer の一般的なアーキテクチャに従っています (これは Transformer ブロックにとって重要であることが証明されています)。

上記のブロックの問題を克服するために、この研究では、BottleNeck ブロックの展開上の利点を維持する Next Convolution Block (NCB) を提案しました。同時にトランスブロックの優れた性能も得られます。図 3(f) に示すように、NCB は MetaFormer の一般的なアーキテクチャに従っています (これは Transformer ブロックにとって重要であることが証明されています)。

さらに、効率的なアテンションベースのトークンミキサーも同様に重要です。この研究では、畳み込み演算を展開する効率的なトークンミキサーとしてマルチヘッド畳み込みアテンション (MHCA) を設計し、MetaFormer のパラダイムで MHCA 層と MLP 層を使用して NCB を構築しました [40]。

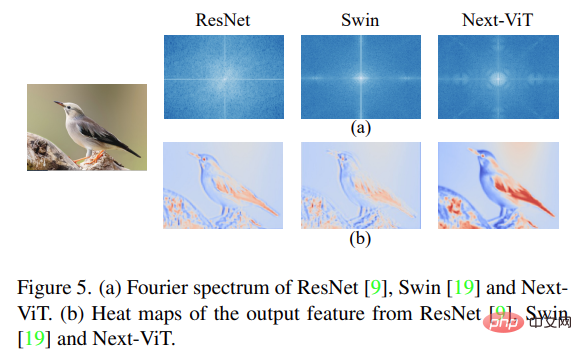

NCB はローカル表現を効果的に学習しました。次のステップでは、グローバル情報を取得する必要があります。 Transformer アーキテクチャは、グローバルな情報 (グローバルな形状や構造など) を提供する低周波信号をキャプチャする強力な機能を備えています。

しかし、関連する研究により、Transformer ブロックはローカル テクスチャ情報などの高周波情報をある程度劣化させる可能性があることが判明しています。さまざまな周波数帯域からの信号は人間の視覚システムに不可欠であり、それらはより本質的でユニークな特徴を抽出するために特定の方法で融合されます。

これらの既知の結果に影響されて、この研究では、軽量のメカニズムで複数周波数信号を捕捉する Next Transformer Block (NTB) を開発しました。さらに、NTB は効率的なマルチ周波数信号ミキサーとして使用でき、全体的なモデリング機能がさらに強化されます。

最近の研究では、CNN と Transformer を組み合わせて効率的に展開する試みが行われています。以下の図 4(b)(c) に示すように、ほとんどの場合、浅い段階では畳み込みブロックを使用し、最後の 1 つまたは 2 つの段階では Transformer ブロックのみをスタックしており、この組み合わせは分類タスクに効果的です。しかし、この調査では、これらのハイブリッド戦略は、セグメンテーションや検出などの下流タスクでパフォーマンスが簡単に飽和状態に達する可能性があることが判明しました。その理由は、分類タスクは予測に最終ステージの出力のみを使用するのに対し、下流タスク (セグメンテーションや検出など) は通常、より良い結果を得るために各ステージの機能に依存するためです。これは、従来のハイブリッド戦略では最後の数ステージで Transformer ブロックを積み重ねるだけであり、浅い層ではグローバルな情報を取得できないためです。

この研究では、畳み込みブロック (NCB) とトランスフォーマー ブロック (NTB) を創造的に組み合わせる新しいハイブリッド戦略 (NHS) を提案します。 (N 1) * L ハイブリッド パラダイム。 NHS は、ダウンストリーム タスクにおけるモデルのパフォーマンスを大幅に向上させ、Transformer ブロックの割合を制御しながら効率的な展開を実現します。

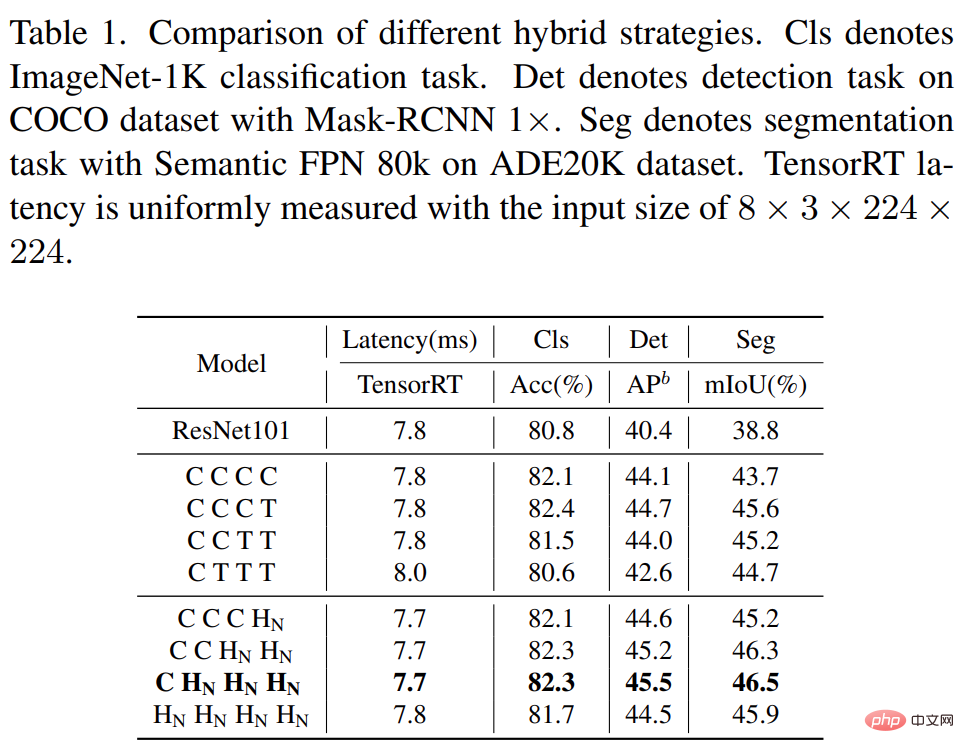

まず、浅い層にグローバルな情報をキャプチャする能力を与えるために、この研究では、各段階で N を順番に積み重ねる (NCB×N NTB×1) モード混合戦略を提案します。図 4(d) に示すように、NCB と NTB です。具体的には、トランスフォーマー ブロック (NTB) が各ステージの最後に配置され、モデルが浅いレイヤーでグローバル表現を学習できるようにします。この研究では、提案されたハイブリッド戦略の優位性を検証するために一連の実験を実施しました。さまざまなハイブリッド戦略のパフォーマンスを以下の表 1 に示します。

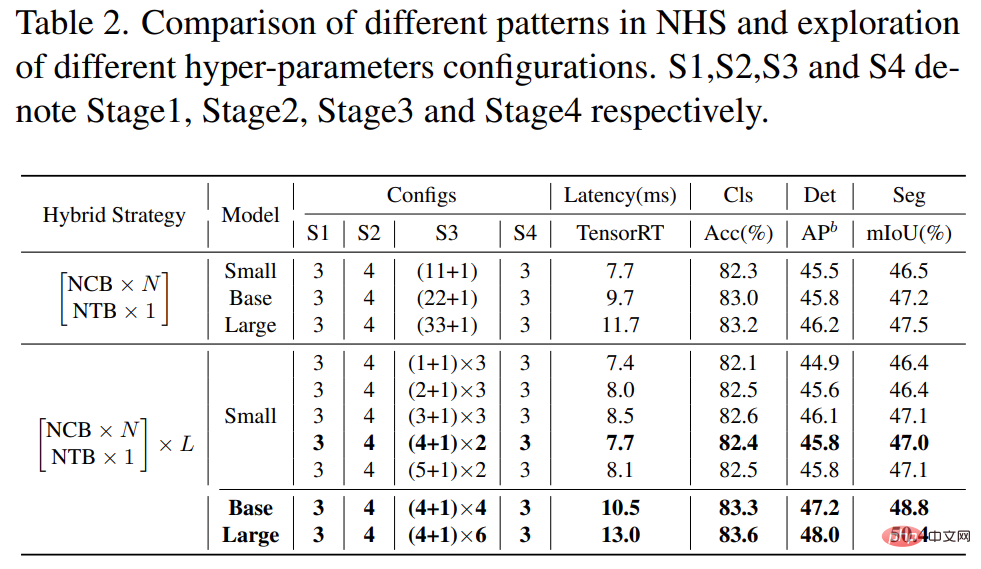

さらに、以下の表 2 に示すように、大規模モデルのパフォーマンスは徐々に飽和に達します。この現象は、(NCB × N NTB × 1) モードで N を拡大することによってモデル サイズを拡大すること、つまり、(NCB × N NTB × 1) モードでは単に畳み込みブロックを追加することが最適な選択ではないことを示しています。モデルのパフォーマンスに重大な影響を与えます。

したがって、研究者は、広範な実験を通じてモデルのパフォーマンスに対する N の値の影響を調査し始めました。表 2 (中) に示すように、研究では第 3 段階で異なる N 値を使用してモデルを構築しました。公平な比較のために同様のレイテンシを持つモデルを構築するために、この研究では、N の小さい値で (NCB × N NTB × 1) パターンの L セットをスタックします。

表 2 に示すように、第 3 段階の N = 4 のモデルは、パフォーマンスとレイテンシーの間で最適なトレードオフを実現します。さらに、第 3 段階では (NCB × 4 NTB × 1) × L モードの L を拡張することで、より大きなモデルを構築します。表 2 (下記) に示すように、Base (L = 4) および Large (L = 6) モデルのパフォーマンスは、小型モデルと比較して大幅に向上しており、提案された (NCB × N NTB × 1) × L モードが検証されています。 . 一般的な有効性。

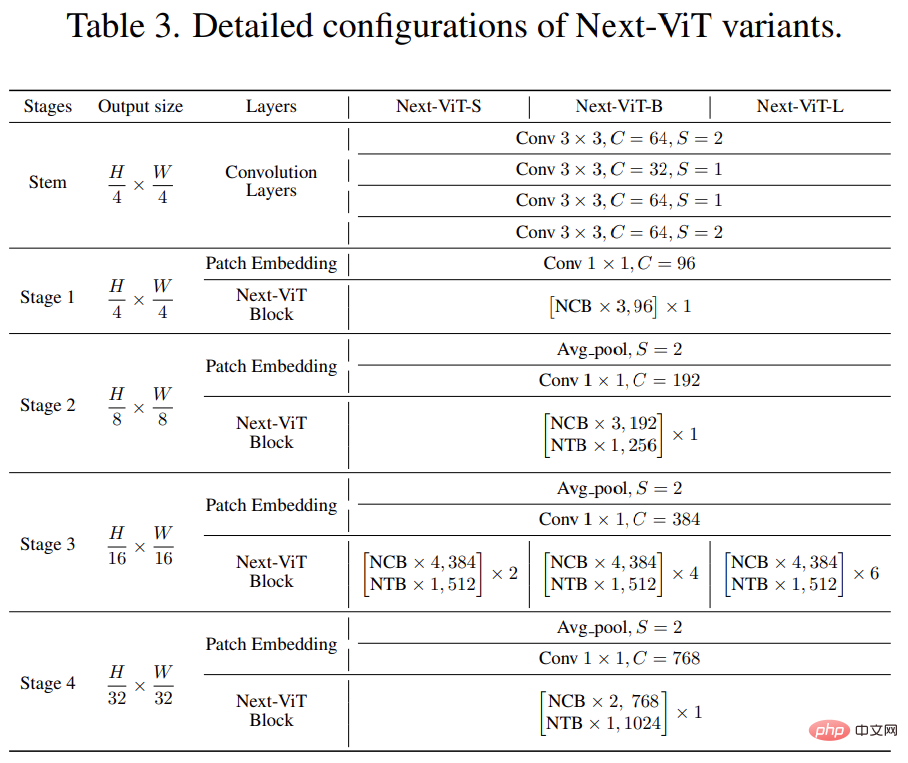

最後に、既存の SOTA ネットワークとの公正な比較を提供するために、研究者らは 3 つの典型的なバリアント、つまり Next-ViTS/B/L を提案しました。

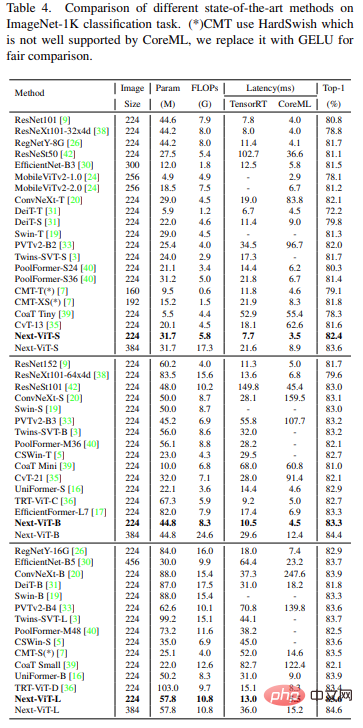

CNN、ViT、ハイブリッドネットワークなどの最新のSOTA手法と比較して、Next-ViTはより高い精度を実現します。 -off は待ち時間と待ち時間の間で達成され、結果は以下の表 4 に示されています。

この研究では、Next-ViT と CNN を組み合わせています。 ViT といくつかの最近のハイブリッド アーキテクチャが、セマンティック セグメンテーション タスクに関して比較されます。以下の表 5 に示すように、広範な実験により、Next-ViT がセグメンテーション タスクにおいて優れた可能性を秘めていることが示されています。

#オブジェクト検出とインスタンス セグメンテーション

アブレーション実験と視覚化

アブレーション実験と視覚化

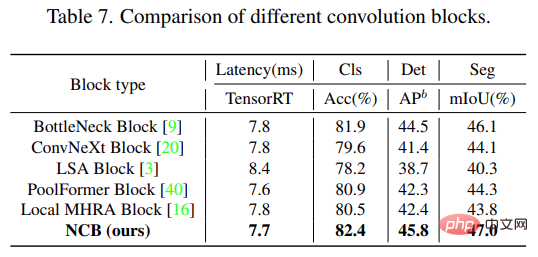

以下の表 7 に示すように、NCB は 3 つのタスクすべてで最適な遅延と精度のトレードオフを実現しています。

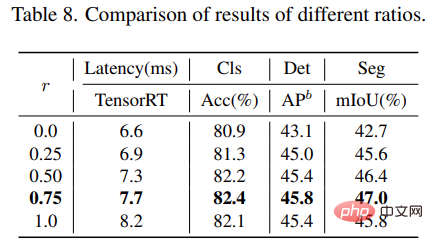

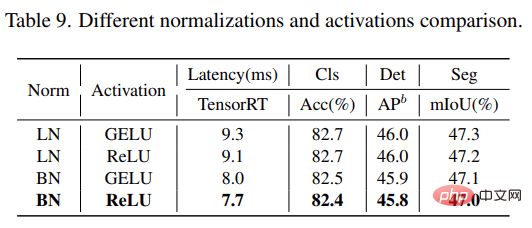

さらに、r = 0.75 および r = 0.5 のモデルは、純粋な Transformer (r = 1) を備えたモデルよりも優れたパフォーマンスを示します。 )。これは、複数周波数信号を適切な方法で融合すると、モデルの表現学習能力が強化されることを示しています。特に、r = 0.75 のモデルは、レイテンシと精度の最適なトレードオフを実現します。これらの結果は、NTB ブロックの有効性を示しています。 この研究では、Next-ViT のさまざまな正規化層と活性化関数の影響をさらに分析します。以下の表 9 に示すように、LN と GELU はパフォーマンスの向上をもたらしますが、TensorRT の推論レイテンシは大幅に高くなります。一方、BN と ReLU は、タスク全体で最適なレイテンシと精度のトレードオフを実現します。したがって、Next-ViT は BN と ReLU を均一に使用して、実際の産業シナリオでの効率的な展開を実現します。

以上がCNN と Transformer の正しい組み合わせを解き放ち、ByteDance は効果的な次世代ビジュアル Transformer を提案しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。